Meta's Model Model Clardmarks: Вводятся в заблуждение?

Итак, Meta представила свою новую модель ИИ, Maverick, в выходные, и она уже вызывает ажиотаж, заняв второе место в LM Arena. Знаете, это место, где люди выступают в роли судей и присяжных, сравнивая различные модели ИИ и выбирая своих фаворитов. Но подождите, тут есть подвох! Оказывается, версия Maverick, которая демонстрируется в LM Arena, не совсем совпадает с той, которую вы можете скачать и использовать как разработчик.

Некоторые внимательные исследователи ИИ на X (да, это платформа, ранее известная как Twitter) заметили, что Meta назвала версию для LM Arena «экспериментальной чат-версией». А если заглянуть на сайт Llama, там есть таблица, которая раскрывает правду, сообщая, что тестирование проводилось с «Llama 4 Maverick, оптимизированной для разговорного стиля». Мы уже говорили об этом раньше, но LM Arena — это не совсем золотой стандарт для измерения производительности ИИ. Большинство компаний, занимающихся ИИ, не модифицируют свои модели только ради того, чтобы лучше пройти этот тест — или, по крайней мере, они этого не признают.

Дело в том, что когда вы настраиваете модель, чтобы она преуспела в тесте, но затем выпускаете другую «ванильную» версию для публики, разработчикам сложно понять, насколько хорошо модель будет работать в реальных сценариях. К тому же, это немного вводит в заблуждение, правда? Тесты, несмотря на их недостатки, должны давать нам четкое представление о том, что модель может и чего не может делать в различных задачах.

Исследователи на X быстро заметили значительные различия между Maverick, которую можно скачать, и той, что представлена в LM Arena. Версия в Arena, похоже, активно использует эмодзи и любит давать длинные, затянутые ответы.

Окей, Llama 4 определённо немного странная, лол, что это за город болтовни pic.twitter.com/y3GvhbVz65

— Nathan Lambert (@natolambert) 6 апреля 2025

по какой-то причине модель Llama 4 в Arena использует намного больше эмодзи

на together.ai она кажется лучше: pic.twitter.com/f74ODX4zTt

— Tech Dev Notes (@techdevnotes) 6 апреля 2025

Мы обратились к Meta и организаторам Chatbot Arena, которые управляют LM Arena, чтобы узнать, что они скажут по этому поводу. Следите за обновлениями!

Связанная статья

Цукерберг из Meta говорит, что не все модели "суперинтеллекта" ИИ будут выложены в открытый доступ

Стратегический сдвиг Meta в сторону персонального суперинтеллектаНа этой неделе генеральный директор Meta Марк Цукерберг изложил амбициозное видение "персонального суперинтеллекта" - систем искусствен

Цукерберг из Meta говорит, что не все модели "суперинтеллекта" ИИ будут выложены в открытый доступ

Стратегический сдвиг Meta в сторону персонального суперинтеллектаНа этой неделе генеральный директор Meta Марк Цукерберг изложил амбициозное видение "персонального суперинтеллекта" - систем искусствен

ИИ Meta занимается дублированием видео для контента Instagram

Компания Meta расширяет доступ к своей революционной технологии дубляжа на основе искусственного интеллекта в Facebook и Instagram, представляя возможности бесшовного видеоперевода с сохранением вашег

ИИ Meta занимается дублированием видео для контента Instagram

Компания Meta расширяет доступ к своей революционной технологии дубляжа на основе искусственного интеллекта в Facebook и Instagram, представляя возможности бесшовного видеоперевода с сохранением вашег

Приложение Meta AI представит премиум-уровень и рекламу

Приложение Meta AI вскоре может предложить платную подписку, аналогичную предложениям конкурентов, таких как OpenAI, Google и Microsoft. Во время отчета о доходах за первый квартал 2025 года генеральн

Комментарии (36)

Приложение Meta AI представит премиум-уровень и рекламу

Приложение Meta AI вскоре может предложить платную подписку, аналогичную предложениям конкурентов, таких как OpenAI, Google и Microsoft. Во время отчета о доходах за первый квартал 2025 года генеральн

Комментарии (36)

![ScottWalker]() ScottWalker

ScottWalker

28 июля 2025 г., 4:20:54 GMT+03:00

28 июля 2025 г., 4:20:54 GMT+03:00

Meta's Maverick hitting second on LM Arena? Impressive, but I'm skeptical about those benchmarks. Feels like a hype train—wonder if it’s more flash than substance. 🤔 Anyone tested it in real-world tasks yet?

0

0

![KennethMartin]() KennethMartin

KennethMartin

21 апреля 2025 г., 13:14:21 GMT+03:00

21 апреля 2025 г., 13:14:21 GMT+03:00

Meta's Maverick AI model is impressive, snagging second place on LM Arena! But are the benchmarks really telling the whole story? It's cool to see AI models go head-to-head, but I'm not sure if it's all fair play. Makes you wonder, right? 🤔 Maybe we need a more transparent way to judge these models!

0

0

![WalterThomas]() WalterThomas

WalterThomas

21 апреля 2025 г., 5:55:14 GMT+03:00

21 апреля 2025 г., 5:55:14 GMT+03:00

मेटा का नया AI मॉडल, मैवरिक, LM एरिना में दूसरे स्थान पर पहुंचा! यह प्रभावशाली है, लेकिन क्या बेंचमार्क वास्तव में पूरी कहानी बता रहे हैं? AI मॉडल्स को आपस में प्रतिस्पर्धा करते देखना मजेदार है, लेकिन मुझे नहीं पता कि यह निष्पक्ष है या नहीं। आपको सोचने पर मजबूर करता है, है ना? 🤔 शायद हमें इन मॉडल्स को जज करने का एक और पारदर्शी तरीका चाहिए!

0

0

![JohnYoung]() JohnYoung

JohnYoung

18 апреля 2025 г., 18:03:42 GMT+03:00

18 апреля 2025 г., 18:03:42 GMT+03:00

메타의 새로운 AI 모델, 마브릭이 LM Arena에서 2위를 차지하다니 대단해요! 하지만 벤치마크가 정말 모든 것을 말해주고 있는지 궁금해요. AI 모델 간의 경쟁은 재미있지만, 공정한지 확신할 수 없네요. 더 투명한 평가 방법이 필요할 것 같아요 🤔

0

0

![JohnHernández]() JohnHernández

JohnHernández

17 апреля 2025 г., 19:58:48 GMT+03:00

17 апреля 2025 г., 19:58:48 GMT+03:00

Meta's Maverick AI model snagging second place on LM Arena is pretty cool, but the benchmarks might be a bit off! 🤔 It's fun to see these models go head-to-head, but I'm not sure if the results are totally fair. Worth keeping an eye on! 👀

0

0

![MarkScott]() MarkScott

MarkScott

17 апреля 2025 г., 8:54:17 GMT+03:00

17 апреля 2025 г., 8:54:17 GMT+03:00

Модель ИИ Maverick от Meta заняла второе место на LM Arena, это круто, но бенчмарки могут быть немного не точными! 🤔 Забавно наблюдать за соревнованием этих моделей, но я не уверен, что результаты полностью справедливы. Стоит за этим следить! 👀

0

0

Итак, Meta представила свою новую модель ИИ, Maverick, в выходные, и она уже вызывает ажиотаж, заняв второе место в LM Arena. Знаете, это место, где люди выступают в роли судей и присяжных, сравнивая различные модели ИИ и выбирая своих фаворитов. Но подождите, тут есть подвох! Оказывается, версия Maverick, которая демонстрируется в LM Arena, не совсем совпадает с той, которую вы можете скачать и использовать как разработчик.

Некоторые внимательные исследователи ИИ на X (да, это платформа, ранее известная как Twitter) заметили, что Meta назвала версию для LM Arena «экспериментальной чат-версией». А если заглянуть на сайт Llama, там есть таблица, которая раскрывает правду, сообщая, что тестирование проводилось с «Llama 4 Maverick, оптимизированной для разговорного стиля». Мы уже говорили об этом раньше, но LM Arena — это не совсем золотой стандарт для измерения производительности ИИ. Большинство компаний, занимающихся ИИ, не модифицируют свои модели только ради того, чтобы лучше пройти этот тест — или, по крайней мере, они этого не признают.

Дело в том, что когда вы настраиваете модель, чтобы она преуспела в тесте, но затем выпускаете другую «ванильную» версию для публики, разработчикам сложно понять, насколько хорошо модель будет работать в реальных сценариях. К тому же, это немного вводит в заблуждение, правда? Тесты, несмотря на их недостатки, должны давать нам четкое представление о том, что модель может и чего не может делать в различных задачах.

Исследователи на X быстро заметили значительные различия между Maverick, которую можно скачать, и той, что представлена в LM Arena. Версия в Arena, похоже, активно использует эмодзи и любит давать длинные, затянутые ответы.

Окей, Llama 4 определённо немного странная, лол, что это за город болтовни pic.twitter.com/y3GvhbVz65

— Nathan Lambert (@natolambert) 6 апреля 2025

по какой-то причине модель Llama 4 в Arena использует намного больше эмодзи

— Tech Dev Notes (@techdevnotes) 6 апреля 2025

на together.ai она кажется лучше: pic.twitter.com/f74ODX4zTt

Мы обратились к Meta и организаторам Chatbot Arena, которые управляют LM Arena, чтобы узнать, что они скажут по этому поводу. Следите за обновлениями!

Цукерберг из Meta говорит, что не все модели "суперинтеллекта" ИИ будут выложены в открытый доступ

Стратегический сдвиг Meta в сторону персонального суперинтеллектаНа этой неделе генеральный директор Meta Марк Цукерберг изложил амбициозное видение "персонального суперинтеллекта" - систем искусствен

Цукерберг из Meta говорит, что не все модели "суперинтеллекта" ИИ будут выложены в открытый доступ

Стратегический сдвиг Meta в сторону персонального суперинтеллектаНа этой неделе генеральный директор Meta Марк Цукерберг изложил амбициозное видение "персонального суперинтеллекта" - систем искусствен

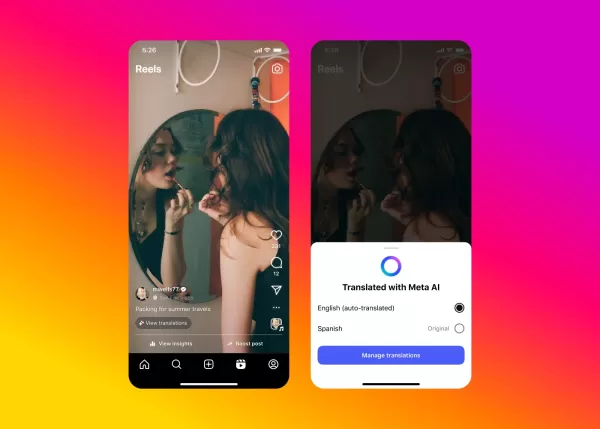

ИИ Meta занимается дублированием видео для контента Instagram

Компания Meta расширяет доступ к своей революционной технологии дубляжа на основе искусственного интеллекта в Facebook и Instagram, представляя возможности бесшовного видеоперевода с сохранением вашег

ИИ Meta занимается дублированием видео для контента Instagram

Компания Meta расширяет доступ к своей революционной технологии дубляжа на основе искусственного интеллекта в Facebook и Instagram, представляя возможности бесшовного видеоперевода с сохранением вашег

Приложение Meta AI представит премиум-уровень и рекламу

Приложение Meta AI вскоре может предложить платную подписку, аналогичную предложениям конкурентов, таких как OpenAI, Google и Microsoft. Во время отчета о доходах за первый квартал 2025 года генеральн

Приложение Meta AI представит премиум-уровень и рекламу

Приложение Meta AI вскоре может предложить платную подписку, аналогичную предложениям конкурентов, таких как OpenAI, Google и Microsoft. Во время отчета о доходах за первый квартал 2025 года генеральн

28 июля 2025 г., 4:20:54 GMT+03:00

28 июля 2025 г., 4:20:54 GMT+03:00

Meta's Maverick hitting second on LM Arena? Impressive, but I'm skeptical about those benchmarks. Feels like a hype train—wonder if it’s more flash than substance. 🤔 Anyone tested it in real-world tasks yet?

0

0

21 апреля 2025 г., 13:14:21 GMT+03:00

21 апреля 2025 г., 13:14:21 GMT+03:00

Meta's Maverick AI model is impressive, snagging second place on LM Arena! But are the benchmarks really telling the whole story? It's cool to see AI models go head-to-head, but I'm not sure if it's all fair play. Makes you wonder, right? 🤔 Maybe we need a more transparent way to judge these models!

0

0

21 апреля 2025 г., 5:55:14 GMT+03:00

21 апреля 2025 г., 5:55:14 GMT+03:00

मेटा का नया AI मॉडल, मैवरिक, LM एरिना में दूसरे स्थान पर पहुंचा! यह प्रभावशाली है, लेकिन क्या बेंचमार्क वास्तव में पूरी कहानी बता रहे हैं? AI मॉडल्स को आपस में प्रतिस्पर्धा करते देखना मजेदार है, लेकिन मुझे नहीं पता कि यह निष्पक्ष है या नहीं। आपको सोचने पर मजबूर करता है, है ना? 🤔 शायद हमें इन मॉडल्स को जज करने का एक और पारदर्शी तरीका चाहिए!

0

0

18 апреля 2025 г., 18:03:42 GMT+03:00

18 апреля 2025 г., 18:03:42 GMT+03:00

메타의 새로운 AI 모델, 마브릭이 LM Arena에서 2위를 차지하다니 대단해요! 하지만 벤치마크가 정말 모든 것을 말해주고 있는지 궁금해요. AI 모델 간의 경쟁은 재미있지만, 공정한지 확신할 수 없네요. 더 투명한 평가 방법이 필요할 것 같아요 🤔

0

0

17 апреля 2025 г., 19:58:48 GMT+03:00

17 апреля 2025 г., 19:58:48 GMT+03:00

Meta's Maverick AI model snagging second place on LM Arena is pretty cool, but the benchmarks might be a bit off! 🤔 It's fun to see these models go head-to-head, but I'm not sure if the results are totally fair. Worth keeping an eye on! 👀

0

0

17 апреля 2025 г., 8:54:17 GMT+03:00

17 апреля 2025 г., 8:54:17 GMT+03:00

Модель ИИ Maverick от Meta заняла второе место на LM Arena, это круто, но бенчмарки могут быть немного не точными! 🤔 Забавно наблюдать за соревнованием этих моделей, но я не уверен, что результаты полностью справедливы. Стоит за этим следить! 👀

0

0