Menos es más: cómo recuperar menos documentos mejora las respuestas de IA

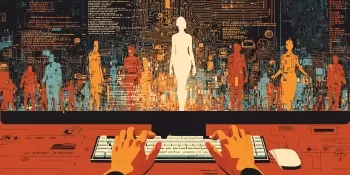

La Generación Aumentada por Recuperación (RAG) es un enfoque innovador para construir sistemas de IA, combinando un modelo de lenguaje con una fuente de conocimiento externa para mejorar la precisión y reducir errores factuales. En esencia, la IA busca documentos relevantes relacionados con la consulta de un usuario y utiliza esta información para generar una respuesta más precisa. Este método ha ganado reconocimiento por su capacidad para mantener a los modelos de lenguaje de gran escala (LLMs) anclados en datos reales, minimizando el riesgo de alucinaciones.

Podrías asumir que proporcionar a una IA más documentos conduciría a respuestas mejor informadas. Sin embargo, un estudio reciente de la Universidad Hebrea de Jerusalén sugiere lo contrario: cuando se trata de alimentar información a una IA, menos puede ser efectivamente más.

Menos Documentos, Mejores Respuestas

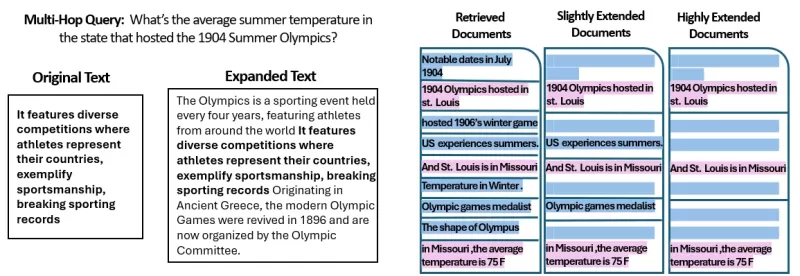

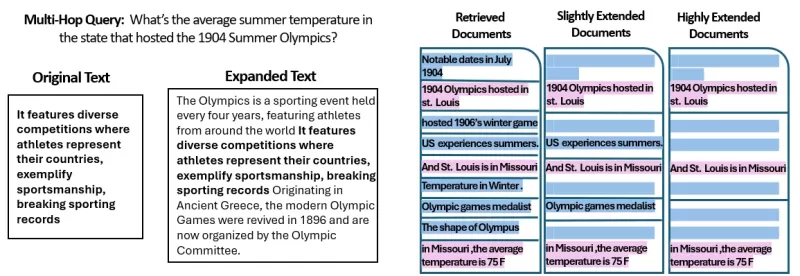

El estudio analizó cómo la cantidad de documentos proporcionados a un sistema RAG afecta su rendimiento. Los investigadores mantuvieron una longitud total de texto constante, ajustando la cantidad de documentos de 20 a 2-4 relevantes y expandiendo estos para igualar el volumen de texto original. Esto les permitió aislar el efecto de la cantidad de documentos en el rendimiento.

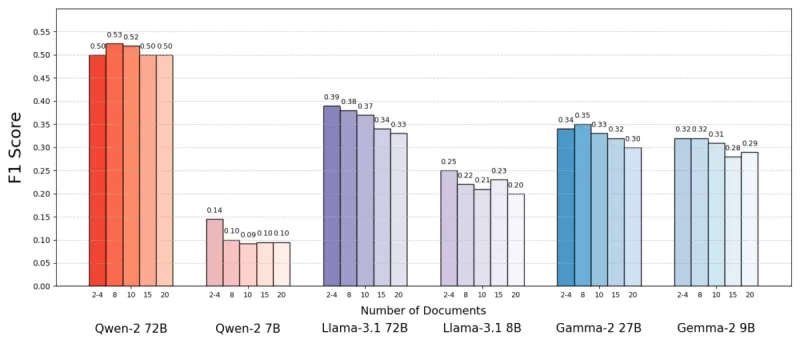

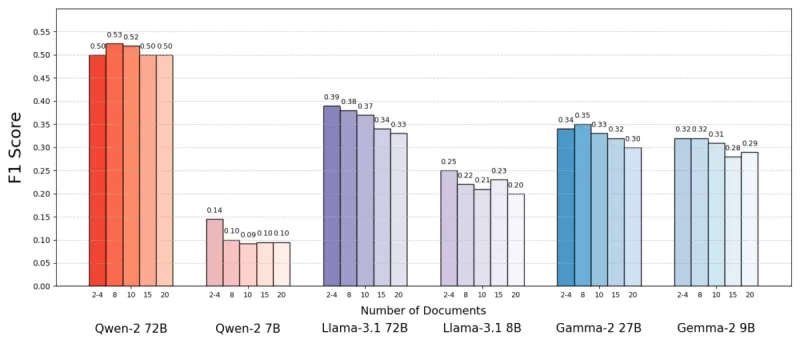

Utilizando el conjunto de datos MuSiQue, que incluye preguntas de trivia emparejadas con párrafos de Wikipedia, encontraron que los modelos de IA a menudo rendían mejor con menos documentos. La precisión mejoró hasta en un 10% (medida por la puntuación F1) cuando el sistema se enfocaba en solo unos pocos documentos clave en lugar de una colección amplia. Esta tendencia se mantuvo en varios modelos de lenguaje de código abierto, como Llama de Meta, con Qwen-2 siendo la notable excepción, manteniendo su rendimiento con múltiples documentos.

Fuente: Levy et al.

Fuente: Levy et al.

Este resultado sorprendente desafía la creencia común de que más información siempre ayuda. Incluso con la misma cantidad de texto, la presencia de múltiples documentos parecía complicar la tarea de la IA, introduciendo más ruido que señal.

Por Qué Menos Puede Ser Más en RAG

El principio de "menos es más" tiene sentido cuando consideramos cómo los modelos de IA procesan la información. Con menos documentos más relevantes, la IA puede enfocarse en el contexto esencial sin distracciones, similar a un estudiante que estudia el material más pertinente.

En el estudio, los modelos rindieron mejor cuando se les proporcionaban solo los documentos directamente relevantes para la respuesta, ya que este contexto más limpio y enfocado facilitaba la extracción de la información correcta. Por el contrario, cuando la IA tenía que filtrar muchos documentos, a menudo luchaba con la mezcla de contenido relevante e irrelevante. Documentos similares pero no relacionados podían engañar al modelo, aumentando el riesgo de alucinaciones.

Curiosamente, el estudio encontró que la IA podía ignorar más fácilmente documentos obviamente irrelevantes que aquellos sutilmente fuera de tema. Esto sugiere que los distractores realistas son más confusos que los aleatorios. Al limitar los documentos a solo los necesarios, reducimos la probabilidad de caer en tales trampas.

Además, usar menos documentos reduce la carga computacional, haciendo que el sistema sea más eficiente y rentable. Este enfoque no solo mejora la precisión, sino que también optimiza el rendimiento general del sistema RAG.

Fuente: Levy et al.

Fuente: Levy et al.

Repensando RAG: Direcciones Futuras

Estos hallazgos tienen implicaciones significativas para el diseño de futuros sistemas de IA que dependen del conocimiento externo. Sugieren que enfocarse en la calidad y relevancia de los documentos recuperados, en lugar de su cantidad, podría mejorar el rendimiento. Los autores del estudio abogan por métodos de recuperación que equilibren relevancia y diversidad, asegurando una cobertura completa sin abrumar al modelo con texto superfluo.

La investigación futura podría explorar mejores sistemas de recuperación o reorganizadores para identificar documentos verdaderamente valiosos y mejorar cómo los modelos de lenguaje manejan múltiples fuentes. Mejorar los modelos en sí, como se vio con Qwen-2, también podría ofrecer ideas para hacerlos más robustos ante entradas diversas.

A medida que los sistemas de IA desarrollan ventanas de contexto más grandes, la capacidad de procesar más texto a la vez se vuelve menos crítica que asegurar que el texto sea relevante y curado. El estudio, titulado "Más Documentos, Misma Longitud," subraya la importancia de enfocarse en la información más pertinente para mejorar la precisión y eficiencia de la IA.

En conclusión, esta investigación desafía nuestras suposiciones sobre la entrada de datos en los sistemas de IA. Al seleccionar cuidadosamente menos documentos mejores, podemos crear sistemas RAG más inteligentes y eficientes que ofrezcan respuestas más precisas y confiables.

Artículo relacionado

Craig Federighi, de Apple, admite que Siri, impulsada por IA, tenía graves fallos en sus primeras fases

Ejecutivos de Apple explican el retraso en la actualización de SiriDurante la WWDC 2024, Apple prometió en un principio importantes mejoras de Siri, como el conocimiento personalizado del contexto y

Craig Federighi, de Apple, admite que Siri, impulsada por IA, tenía graves fallos en sus primeras fases

Ejecutivos de Apple explican el retraso en la actualización de SiriDurante la WWDC 2024, Apple prometió en un principio importantes mejoras de Siri, como el conocimiento personalizado del contexto y

Dominar las Técnicas de Inpainting AI: Guía intermedia para una edición de imágenes impecable

Descubra las capacidades transformadoras de la tecnología AI inpainting de Midjourney, una función revolucionaria que permite a los creadores refinar y perfeccionar las ilustraciones generadas por AI

Dominar las Técnicas de Inpainting AI: Guía intermedia para una edición de imágenes impecable

Descubra las capacidades transformadoras de la tecnología AI inpainting de Midjourney, una función revolucionaria que permite a los creadores refinar y perfeccionar las ilustraciones generadas por AI

Manus estrena su herramienta de IA "Wide Research" con más de 100 agentes para el raspado web

Manus, empresa china innovadora en IA, que ya había llamado la atención por su pionera plataforma de orquestación multiagente dirigida tanto a consumidores como a usuarios profesionales, ha desvelado

comentario (47)

0/200

Manus estrena su herramienta de IA "Wide Research" con más de 100 agentes para el raspado web

Manus, empresa china innovadora en IA, que ya había llamado la atención por su pionera plataforma de orquestación multiagente dirigida tanto a consumidores como a usuarios profesionales, ha desvelado

comentario (47)

0/200

![LarryWilliams]() LarryWilliams

LarryWilliams

10 de septiembre de 2025 02:30:32 GMT+02:00

10 de septiembre de 2025 02:30:32 GMT+02:00

La RAG est révolutionnaire, mais je me demande si limiter les documents récupérés pourrait parfois manquer des infos cruciales 🤔. Perso, j'opterais pour un juste milieu entre précision et exhaustivité !

0

0

![BruceBrown]() BruceBrown

BruceBrown

29 de julio de 2025 14:25:16 GMT+02:00

29 de julio de 2025 14:25:16 GMT+02:00

This article on RAG is super intriguing! Fewer documents leading to better AI responses? Mind blown 🤯. Makes me wonder how this could streamline chatbots for customer service. Anyone tried this yet?

0

0

![JasonMartin]() JasonMartin

JasonMartin

26 de abril de 2025 08:04:32 GMT+02:00

26 de abril de 2025 08:04:32 GMT+02:00

Adoro como essa ferramenta torna as respostas do AI mais precisas usando menos documentos. É como mágica! Mas às vezes parece que está faltando alguma informação. Ainda assim, uma ótima ferramenta para respostas rápidas e confiáveis. 👍

0

0

![JuanMoore]() JuanMoore

JuanMoore

24 de abril de 2025 00:29:07 GMT+02:00

24 de abril de 2025 00:29:07 GMT+02:00

I love how this tool makes AI responses more accurate by using fewer documents. It's like magic! But sometimes it feels like it's missing out on some info. Still, a great tool for quick, reliable answers. 👍

0

0

![GregoryJones]() GregoryJones

GregoryJones

22 de abril de 2025 18:50:26 GMT+02:00

22 de abril de 2025 18:50:26 GMT+02:00

「少ない方が良い」というAIの応答方法はかなりクール!少ないドキュメントから正確な答えを得るなんて、登録したいですね!魔法のようですが、もっと早く動いてほしいです。でも、AI技術の前進の一歩としては素晴らしいですね!🚀

0

0

![BrianMartinez]() BrianMartinez

BrianMartinez

21 de abril de 2025 13:14:10 GMT+02:00

21 de abril de 2025 13:14:10 GMT+02:00

This app really simplifies things! By retrieving fewer but more relevant documents, the AI responses are much more accurate and to the point. It's like having a smart assistant that knows exactly what you need. Only wish it was a bit faster. Still, a great tool! 😊

0

0

La Generación Aumentada por Recuperación (RAG) es un enfoque innovador para construir sistemas de IA, combinando un modelo de lenguaje con una fuente de conocimiento externa para mejorar la precisión y reducir errores factuales. En esencia, la IA busca documentos relevantes relacionados con la consulta de un usuario y utiliza esta información para generar una respuesta más precisa. Este método ha ganado reconocimiento por su capacidad para mantener a los modelos de lenguaje de gran escala (LLMs) anclados en datos reales, minimizando el riesgo de alucinaciones.

Podrías asumir que proporcionar a una IA más documentos conduciría a respuestas mejor informadas. Sin embargo, un estudio reciente de la Universidad Hebrea de Jerusalén sugiere lo contrario: cuando se trata de alimentar información a una IA, menos puede ser efectivamente más.

Menos Documentos, Mejores Respuestas

El estudio analizó cómo la cantidad de documentos proporcionados a un sistema RAG afecta su rendimiento. Los investigadores mantuvieron una longitud total de texto constante, ajustando la cantidad de documentos de 20 a 2-4 relevantes y expandiendo estos para igualar el volumen de texto original. Esto les permitió aislar el efecto de la cantidad de documentos en el rendimiento.

Utilizando el conjunto de datos MuSiQue, que incluye preguntas de trivia emparejadas con párrafos de Wikipedia, encontraron que los modelos de IA a menudo rendían mejor con menos documentos. La precisión mejoró hasta en un 10% (medida por la puntuación F1) cuando el sistema se enfocaba en solo unos pocos documentos clave en lugar de una colección amplia. Esta tendencia se mantuvo en varios modelos de lenguaje de código abierto, como Llama de Meta, con Qwen-2 siendo la notable excepción, manteniendo su rendimiento con múltiples documentos.

Fuente: Levy et al.

Fuente: Levy et al.

Este resultado sorprendente desafía la creencia común de que más información siempre ayuda. Incluso con la misma cantidad de texto, la presencia de múltiples documentos parecía complicar la tarea de la IA, introduciendo más ruido que señal.

Por Qué Menos Puede Ser Más en RAG

El principio de "menos es más" tiene sentido cuando consideramos cómo los modelos de IA procesan la información. Con menos documentos más relevantes, la IA puede enfocarse en el contexto esencial sin distracciones, similar a un estudiante que estudia el material más pertinente.

En el estudio, los modelos rindieron mejor cuando se les proporcionaban solo los documentos directamente relevantes para la respuesta, ya que este contexto más limpio y enfocado facilitaba la extracción de la información correcta. Por el contrario, cuando la IA tenía que filtrar muchos documentos, a menudo luchaba con la mezcla de contenido relevante e irrelevante. Documentos similares pero no relacionados podían engañar al modelo, aumentando el riesgo de alucinaciones.

Curiosamente, el estudio encontró que la IA podía ignorar más fácilmente documentos obviamente irrelevantes que aquellos sutilmente fuera de tema. Esto sugiere que los distractores realistas son más confusos que los aleatorios. Al limitar los documentos a solo los necesarios, reducimos la probabilidad de caer en tales trampas.

Además, usar menos documentos reduce la carga computacional, haciendo que el sistema sea más eficiente y rentable. Este enfoque no solo mejora la precisión, sino que también optimiza el rendimiento general del sistema RAG.

Fuente: Levy et al.

Fuente: Levy et al.

Repensando RAG: Direcciones Futuras

Estos hallazgos tienen implicaciones significativas para el diseño de futuros sistemas de IA que dependen del conocimiento externo. Sugieren que enfocarse en la calidad y relevancia de los documentos recuperados, en lugar de su cantidad, podría mejorar el rendimiento. Los autores del estudio abogan por métodos de recuperación que equilibren relevancia y diversidad, asegurando una cobertura completa sin abrumar al modelo con texto superfluo.

La investigación futura podría explorar mejores sistemas de recuperación o reorganizadores para identificar documentos verdaderamente valiosos y mejorar cómo los modelos de lenguaje manejan múltiples fuentes. Mejorar los modelos en sí, como se vio con Qwen-2, también podría ofrecer ideas para hacerlos más robustos ante entradas diversas.

A medida que los sistemas de IA desarrollan ventanas de contexto más grandes, la capacidad de procesar más texto a la vez se vuelve menos crítica que asegurar que el texto sea relevante y curado. El estudio, titulado "Más Documentos, Misma Longitud," subraya la importancia de enfocarse en la información más pertinente para mejorar la precisión y eficiencia de la IA.

En conclusión, esta investigación desafía nuestras suposiciones sobre la entrada de datos en los sistemas de IA. Al seleccionar cuidadosamente menos documentos mejores, podemos crear sistemas RAG más inteligentes y eficientes que ofrezcan respuestas más precisas y confiables.

Craig Federighi, de Apple, admite que Siri, impulsada por IA, tenía graves fallos en sus primeras fases

Ejecutivos de Apple explican el retraso en la actualización de SiriDurante la WWDC 2024, Apple prometió en un principio importantes mejoras de Siri, como el conocimiento personalizado del contexto y

Craig Federighi, de Apple, admite que Siri, impulsada por IA, tenía graves fallos en sus primeras fases

Ejecutivos de Apple explican el retraso en la actualización de SiriDurante la WWDC 2024, Apple prometió en un principio importantes mejoras de Siri, como el conocimiento personalizado del contexto y

Dominar las Técnicas de Inpainting AI: Guía intermedia para una edición de imágenes impecable

Descubra las capacidades transformadoras de la tecnología AI inpainting de Midjourney, una función revolucionaria que permite a los creadores refinar y perfeccionar las ilustraciones generadas por AI

Dominar las Técnicas de Inpainting AI: Guía intermedia para una edición de imágenes impecable

Descubra las capacidades transformadoras de la tecnología AI inpainting de Midjourney, una función revolucionaria que permite a los creadores refinar y perfeccionar las ilustraciones generadas por AI

Manus estrena su herramienta de IA "Wide Research" con más de 100 agentes para el raspado web

Manus, empresa china innovadora en IA, que ya había llamado la atención por su pionera plataforma de orquestación multiagente dirigida tanto a consumidores como a usuarios profesionales, ha desvelado

Manus estrena su herramienta de IA "Wide Research" con más de 100 agentes para el raspado web

Manus, empresa china innovadora en IA, que ya había llamado la atención por su pionera plataforma de orquestación multiagente dirigida tanto a consumidores como a usuarios profesionales, ha desvelado

10 de septiembre de 2025 02:30:32 GMT+02:00

10 de septiembre de 2025 02:30:32 GMT+02:00

La RAG est révolutionnaire, mais je me demande si limiter les documents récupérés pourrait parfois manquer des infos cruciales 🤔. Perso, j'opterais pour un juste milieu entre précision et exhaustivité !

0

0

29 de julio de 2025 14:25:16 GMT+02:00

29 de julio de 2025 14:25:16 GMT+02:00

This article on RAG is super intriguing! Fewer documents leading to better AI responses? Mind blown 🤯. Makes me wonder how this could streamline chatbots for customer service. Anyone tried this yet?

0

0

26 de abril de 2025 08:04:32 GMT+02:00

26 de abril de 2025 08:04:32 GMT+02:00

Adoro como essa ferramenta torna as respostas do AI mais precisas usando menos documentos. É como mágica! Mas às vezes parece que está faltando alguma informação. Ainda assim, uma ótima ferramenta para respostas rápidas e confiáveis. 👍

0

0

24 de abril de 2025 00:29:07 GMT+02:00

24 de abril de 2025 00:29:07 GMT+02:00

I love how this tool makes AI responses more accurate by using fewer documents. It's like magic! But sometimes it feels like it's missing out on some info. Still, a great tool for quick, reliable answers. 👍

0

0

22 de abril de 2025 18:50:26 GMT+02:00

22 de abril de 2025 18:50:26 GMT+02:00

「少ない方が良い」というAIの応答方法はかなりクール!少ないドキュメントから正確な答えを得るなんて、登録したいですね!魔法のようですが、もっと早く動いてほしいです。でも、AI技術の前進の一歩としては素晴らしいですね!🚀

0

0

21 de abril de 2025 13:14:10 GMT+02:00

21 de abril de 2025 13:14:10 GMT+02:00

This app really simplifies things! By retrieving fewer but more relevant documents, the AI responses are much more accurate and to the point. It's like having a smart assistant that knows exactly what you need. Only wish it was a bit faster. Still, a great tool! 😊

0

0