Weniger ist mehr: Wie das Abrufen weniger Dokumente die KI -Antworten verbessert

Retrieval-Augmented Generation (RAG) ist ein innovativer Ansatz zum Aufbau von KI-Systemen, der ein Sprachmodell mit einer externen Wissensquelle kombiniert, um die Genauigkeit zu erhöhen und faktenbasierte Fehler zu reduzieren. Im Wesentlichen sucht die KI nach relevanten Dokumenten, die mit der Anfrage eines Nutzers in Verbindung stehen, und verwendet diese Informationen, um eine präzisere Antwort zu generieren. Diese Methode hat Anerkennung für ihre Fähigkeit gefunden, große Sprachmodelle (LLMs) an realen Daten zu orientieren und das Risiko von Halluzinationen zu minimieren.

Man könnte annehmen, dass die Bereitstellung von mehr Dokumenten einer KI zu besser informierten Antworten führen würde. Eine aktuelle Studie der Hebräischen Universität Jerusalem legt jedoch nahe, dass weniger tatsächlich mehr sein kann, wenn es darum geht, Informationen an eine KI zu liefern.

Weniger Dokumente, bessere Antworten

Die Studie untersuchte, wie die Anzahl der einem RAG-System bereitgestellten Dokumente dessen Leistung beeinflusst. Die Forscher hielten die gesamte Textlänge konstant, variierten die Anzahl der Dokumente von 20 auf 2-4 relevante und erweiterten diese, um das ursprüngliche Textvolumen zu erreichen. Dies ermöglichte es ihnen, den Einfluss der Dokumentenmenge auf die Leistung zu isolieren.

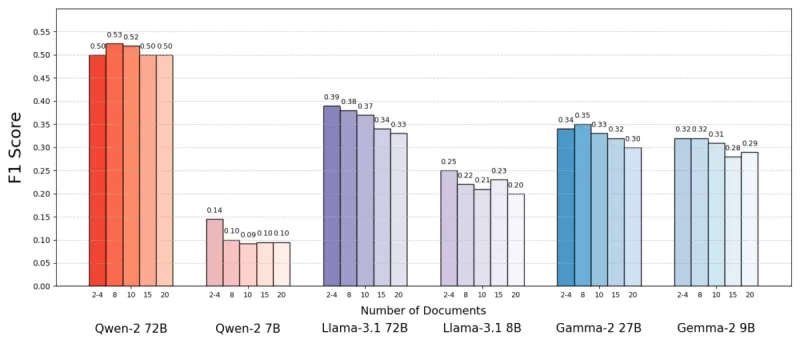

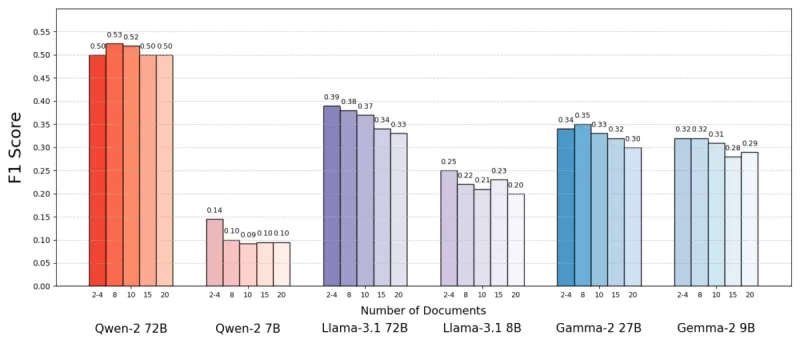

Mit dem MuSiQue-Datensatz, der Trivia-Fragen mit Wikipedia-Absätzen kombiniert, stellten sie fest, dass KI-Modelle oft besser mit weniger Dokumenten abschnitten. Die Genauigkeit verbesserte sich um bis zu 10 % (gemessen am F1-Score), wenn das System sich auf nur wenige Schlüsseldokumente konzentrierte, anstatt auf eine breite Sammlung. Dieser Trend zeigte sich bei verschiedenen Open-Source-Sprachmodellen, wie Metas Llama, mit der bemerkenswerten Ausnahme von Qwen-2, das seine Leistung auch bei mehreren Dokumenten beibehielt.

Quelle: Levy et al.

Quelle: Levy et al.

Dieses überraschende Ergebnis stellt die gängige Annahme infrage, dass mehr Informationen immer helfen. Selbst bei gleicher Textmenge schien die Vielzahl an Dokumenten die Aufgabe der KI zu erschweren, indem sie mehr Rauschen als Signal einführte.

Warum weniger in RAG mehr sein kann

Das Prinzip „weniger ist mehr“ ergibt Sinn, wenn man bedenkt, wie KI-Modelle Informationen verarbeiten. Mit weniger, aber relevanteren Dokumenten kann sich die KI auf den wesentlichen Kontext konzentrieren, ohne abgelenkt zu werden, ähnlich wie ein Schüler, der das relevanteste Material studiert.

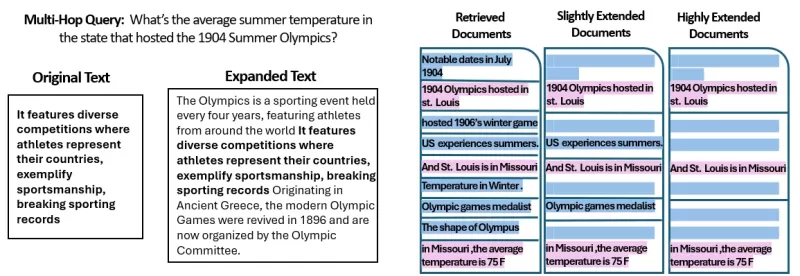

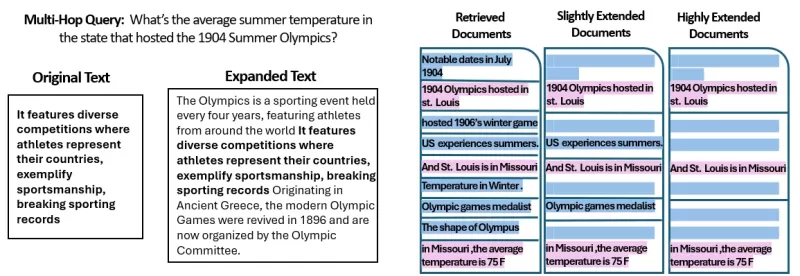

In der Studie schnitten Modelle besser ab, wenn ihnen nur die direkt relevanten Dokumente gegeben wurden, da dieser klarere, fokussierte Kontext das Extrahieren der korrekten Informationen erleichterte. Umgekehrt hatte die KI bei vielen Dokumenten oft Schwierigkeiten mit der Mischung aus relevantem und irrelevantem Inhalt. Ähnliche, aber nicht verwandte Dokumente konnten das Modell in die Irre führen und das Risiko von Halluzinationen erhöhen.

Interessanterweise stellte die Studie fest, dass die KI offensichtlich irrelevante Dokumente leichter ignorieren konnte als solche, die nur geringfügig vom Thema abwichen. Dies deutet darauf hin, dass realistische Ablenkungen verwirrender sind als zufällige. Durch die Begrenzung auf nur die notwendigen Dokumente wird die Wahrscheinlichkeit solcher Fallen reduziert.

Zusätzlich senkt die Verwendung weniger Dokumente den Rechenaufwand, was das System effizienter und kostengünstiger macht. Dieser Ansatz verbessert nicht nur die Genauigkeit, sondern steigert auch die Gesamtleistung des RAG-Systems.

Quelle: Levy et al.

Quelle: Levy et al.

RAG neu denken: Zukünftige Richtungen

Diese Erkenntnisse haben bedeutende Auswirkungen auf die Gestaltung zukünftiger KI-Systeme, die auf externem Wissen basieren. Sie deuten darauf hin, dass die Fokussierung auf die Qualität und Relevanz der abgerufenen Dokumente, anstatt auf deren Menge, die Leistung verbessern könnte. Die Autoren der Studie plädieren für Abrufmethoden, die Relevanz und Vielfalt ausbalancieren, um eine umfassende Abdeckung zu gewährleisten, ohne das Modell mit überflüssigem Text zu überfordern.

Zukünftige Forschung könnte bessere Abrufsysteme oder Re-Ranker untersuchen, um wirklich wertvolle Dokumente zu identifizieren und die Verarbeitung mehrerer Quellen durch Sprachmodelle zu verbessern. Die Verbesserung der Modelle selbst, wie bei Qwen-2 zu sehen, könnte auch Einblicke liefern, wie sie robuster gegenüber vielfältigen Eingaben gemacht werden können.

Da KI-Systeme größere Kontextfenster entwickeln, wird die Fähigkeit, mehr Text auf einmal zu verarbeiten, weniger wichtig als die Sicherstellung, dass der Text relevant und kuratiert ist. Die Studie mit dem Titel „Mehr Dokumente, gleiche Länge“ unterstreicht die Bedeutung, sich auf die relevantesten Informationen zu konzentrieren, um die Genauigkeit und Effizienz der KI zu verbessern.

Zusammenfassend stellt diese Forschung unsere Annahmen über die Dateneingabe in KI-Systeme infrage. Durch sorgfältige Auswahl weniger, besserer Dokumente können wir intelligentere, schlankere RAG-Systeme schaffen, die genauere und vertrauenswürdigere Antworten liefern.

Verwandter Artikel

Trump priorisiert KI-Wachstum vor Regulierung, um China auszustechen

Die Trump-Administration hat am Mittwoch ihren bahnbrechenden Aktionsplan für künstliche Intelligenz (KI) vorgestellt und damit einen entscheidenden Bruch mit der risikoscheuen KI-Politik der Biden-Ad

Trump priorisiert KI-Wachstum vor Regulierung, um China auszustechen

Die Trump-Administration hat am Mittwoch ihren bahnbrechenden Aktionsplan für künstliche Intelligenz (KI) vorgestellt und damit einen entscheidenden Bruch mit der risikoscheuen KI-Politik der Biden-Ad

Auf der Suche nach Glaube und Sinn in einem Zeitalter der Skepsis

In unserem modernen Zeitalter der wissenschaftlichen Forschung und des kritischen Denkens fühlt es sich oft so an, als würde man gegen den Strom schwimmen, wenn man seinen spirituellen Glauben aufrech

Auf der Suche nach Glaube und Sinn in einem Zeitalter der Skepsis

In unserem modernen Zeitalter der wissenschaftlichen Forschung und des kritischen Denkens fühlt es sich oft so an, als würde man gegen den Strom schwimmen, wenn man seinen spirituellen Glauben aufrech

Wie ChatGPT funktioniert: Fähigkeiten, Anwendungen und künftige Implikationen

Die rasante Entwicklung der künstlichen Intelligenz verändert die digitale Interaktion und Kommunikation. An der Spitze dieses Wandels steht ChatGPT, eine fortschrittliche Konversations-KI, die neue S

Kommentare (47)

0/200

Wie ChatGPT funktioniert: Fähigkeiten, Anwendungen und künftige Implikationen

Die rasante Entwicklung der künstlichen Intelligenz verändert die digitale Interaktion und Kommunikation. An der Spitze dieses Wandels steht ChatGPT, eine fortschrittliche Konversations-KI, die neue S

Kommentare (47)

0/200

![LarryWilliams]() LarryWilliams

LarryWilliams

10. September 2025 02:30:32 MESZ

10. September 2025 02:30:32 MESZ

La RAG est révolutionnaire, mais je me demande si limiter les documents récupérés pourrait parfois manquer des infos cruciales 🤔. Perso, j'opterais pour un juste milieu entre précision et exhaustivité !

0

0

![BruceBrown]() BruceBrown

BruceBrown

29. Juli 2025 14:25:16 MESZ

29. Juli 2025 14:25:16 MESZ

This article on RAG is super intriguing! Fewer documents leading to better AI responses? Mind blown 🤯. Makes me wonder how this could streamline chatbots for customer service. Anyone tried this yet?

0

0

![JasonMartin]() JasonMartin

JasonMartin

26. April 2025 08:04:32 MESZ

26. April 2025 08:04:32 MESZ

Adoro como essa ferramenta torna as respostas do AI mais precisas usando menos documentos. É como mágica! Mas às vezes parece que está faltando alguma informação. Ainda assim, uma ótima ferramenta para respostas rápidas e confiáveis. 👍

0

0

![JuanMoore]() JuanMoore

JuanMoore

24. April 2025 00:29:07 MESZ

24. April 2025 00:29:07 MESZ

I love how this tool makes AI responses more accurate by using fewer documents. It's like magic! But sometimes it feels like it's missing out on some info. Still, a great tool for quick, reliable answers. 👍

0

0

![GregoryJones]() GregoryJones

GregoryJones

22. April 2025 18:50:26 MESZ

22. April 2025 18:50:26 MESZ

「少ない方が良い」というAIの応答方法はかなりクール!少ないドキュメントから正確な答えを得るなんて、登録したいですね!魔法のようですが、もっと早く動いてほしいです。でも、AI技術の前進の一歩としては素晴らしいですね!🚀

0

0

![BrianMartinez]() BrianMartinez

BrianMartinez

21. April 2025 13:14:10 MESZ

21. April 2025 13:14:10 MESZ

This app really simplifies things! By retrieving fewer but more relevant documents, the AI responses are much more accurate and to the point. It's like having a smart assistant that knows exactly what you need. Only wish it was a bit faster. Still, a great tool! 😊

0

0

Retrieval-Augmented Generation (RAG) ist ein innovativer Ansatz zum Aufbau von KI-Systemen, der ein Sprachmodell mit einer externen Wissensquelle kombiniert, um die Genauigkeit zu erhöhen und faktenbasierte Fehler zu reduzieren. Im Wesentlichen sucht die KI nach relevanten Dokumenten, die mit der Anfrage eines Nutzers in Verbindung stehen, und verwendet diese Informationen, um eine präzisere Antwort zu generieren. Diese Methode hat Anerkennung für ihre Fähigkeit gefunden, große Sprachmodelle (LLMs) an realen Daten zu orientieren und das Risiko von Halluzinationen zu minimieren.

Man könnte annehmen, dass die Bereitstellung von mehr Dokumenten einer KI zu besser informierten Antworten führen würde. Eine aktuelle Studie der Hebräischen Universität Jerusalem legt jedoch nahe, dass weniger tatsächlich mehr sein kann, wenn es darum geht, Informationen an eine KI zu liefern.

Weniger Dokumente, bessere Antworten

Die Studie untersuchte, wie die Anzahl der einem RAG-System bereitgestellten Dokumente dessen Leistung beeinflusst. Die Forscher hielten die gesamte Textlänge konstant, variierten die Anzahl der Dokumente von 20 auf 2-4 relevante und erweiterten diese, um das ursprüngliche Textvolumen zu erreichen. Dies ermöglichte es ihnen, den Einfluss der Dokumentenmenge auf die Leistung zu isolieren.

Mit dem MuSiQue-Datensatz, der Trivia-Fragen mit Wikipedia-Absätzen kombiniert, stellten sie fest, dass KI-Modelle oft besser mit weniger Dokumenten abschnitten. Die Genauigkeit verbesserte sich um bis zu 10 % (gemessen am F1-Score), wenn das System sich auf nur wenige Schlüsseldokumente konzentrierte, anstatt auf eine breite Sammlung. Dieser Trend zeigte sich bei verschiedenen Open-Source-Sprachmodellen, wie Metas Llama, mit der bemerkenswerten Ausnahme von Qwen-2, das seine Leistung auch bei mehreren Dokumenten beibehielt.

Quelle: Levy et al.

Quelle: Levy et al.

Dieses überraschende Ergebnis stellt die gängige Annahme infrage, dass mehr Informationen immer helfen. Selbst bei gleicher Textmenge schien die Vielzahl an Dokumenten die Aufgabe der KI zu erschweren, indem sie mehr Rauschen als Signal einführte.

Warum weniger in RAG mehr sein kann

Das Prinzip „weniger ist mehr“ ergibt Sinn, wenn man bedenkt, wie KI-Modelle Informationen verarbeiten. Mit weniger, aber relevanteren Dokumenten kann sich die KI auf den wesentlichen Kontext konzentrieren, ohne abgelenkt zu werden, ähnlich wie ein Schüler, der das relevanteste Material studiert.

In der Studie schnitten Modelle besser ab, wenn ihnen nur die direkt relevanten Dokumente gegeben wurden, da dieser klarere, fokussierte Kontext das Extrahieren der korrekten Informationen erleichterte. Umgekehrt hatte die KI bei vielen Dokumenten oft Schwierigkeiten mit der Mischung aus relevantem und irrelevantem Inhalt. Ähnliche, aber nicht verwandte Dokumente konnten das Modell in die Irre führen und das Risiko von Halluzinationen erhöhen.

Interessanterweise stellte die Studie fest, dass die KI offensichtlich irrelevante Dokumente leichter ignorieren konnte als solche, die nur geringfügig vom Thema abwichen. Dies deutet darauf hin, dass realistische Ablenkungen verwirrender sind als zufällige. Durch die Begrenzung auf nur die notwendigen Dokumente wird die Wahrscheinlichkeit solcher Fallen reduziert.

Zusätzlich senkt die Verwendung weniger Dokumente den Rechenaufwand, was das System effizienter und kostengünstiger macht. Dieser Ansatz verbessert nicht nur die Genauigkeit, sondern steigert auch die Gesamtleistung des RAG-Systems.

Quelle: Levy et al.

Quelle: Levy et al.

RAG neu denken: Zukünftige Richtungen

Diese Erkenntnisse haben bedeutende Auswirkungen auf die Gestaltung zukünftiger KI-Systeme, die auf externem Wissen basieren. Sie deuten darauf hin, dass die Fokussierung auf die Qualität und Relevanz der abgerufenen Dokumente, anstatt auf deren Menge, die Leistung verbessern könnte. Die Autoren der Studie plädieren für Abrufmethoden, die Relevanz und Vielfalt ausbalancieren, um eine umfassende Abdeckung zu gewährleisten, ohne das Modell mit überflüssigem Text zu überfordern.

Zukünftige Forschung könnte bessere Abrufsysteme oder Re-Ranker untersuchen, um wirklich wertvolle Dokumente zu identifizieren und die Verarbeitung mehrerer Quellen durch Sprachmodelle zu verbessern. Die Verbesserung der Modelle selbst, wie bei Qwen-2 zu sehen, könnte auch Einblicke liefern, wie sie robuster gegenüber vielfältigen Eingaben gemacht werden können.

Da KI-Systeme größere Kontextfenster entwickeln, wird die Fähigkeit, mehr Text auf einmal zu verarbeiten, weniger wichtig als die Sicherstellung, dass der Text relevant und kuratiert ist. Die Studie mit dem Titel „Mehr Dokumente, gleiche Länge“ unterstreicht die Bedeutung, sich auf die relevantesten Informationen zu konzentrieren, um die Genauigkeit und Effizienz der KI zu verbessern.

Zusammenfassend stellt diese Forschung unsere Annahmen über die Dateneingabe in KI-Systeme infrage. Durch sorgfältige Auswahl weniger, besserer Dokumente können wir intelligentere, schlankere RAG-Systeme schaffen, die genauere und vertrauenswürdigere Antworten liefern.

Trump priorisiert KI-Wachstum vor Regulierung, um China auszustechen

Die Trump-Administration hat am Mittwoch ihren bahnbrechenden Aktionsplan für künstliche Intelligenz (KI) vorgestellt und damit einen entscheidenden Bruch mit der risikoscheuen KI-Politik der Biden-Ad

Trump priorisiert KI-Wachstum vor Regulierung, um China auszustechen

Die Trump-Administration hat am Mittwoch ihren bahnbrechenden Aktionsplan für künstliche Intelligenz (KI) vorgestellt und damit einen entscheidenden Bruch mit der risikoscheuen KI-Politik der Biden-Ad

Auf der Suche nach Glaube und Sinn in einem Zeitalter der Skepsis

In unserem modernen Zeitalter der wissenschaftlichen Forschung und des kritischen Denkens fühlt es sich oft so an, als würde man gegen den Strom schwimmen, wenn man seinen spirituellen Glauben aufrech

Auf der Suche nach Glaube und Sinn in einem Zeitalter der Skepsis

In unserem modernen Zeitalter der wissenschaftlichen Forschung und des kritischen Denkens fühlt es sich oft so an, als würde man gegen den Strom schwimmen, wenn man seinen spirituellen Glauben aufrech

Wie ChatGPT funktioniert: Fähigkeiten, Anwendungen und künftige Implikationen

Die rasante Entwicklung der künstlichen Intelligenz verändert die digitale Interaktion und Kommunikation. An der Spitze dieses Wandels steht ChatGPT, eine fortschrittliche Konversations-KI, die neue S

Wie ChatGPT funktioniert: Fähigkeiten, Anwendungen und künftige Implikationen

Die rasante Entwicklung der künstlichen Intelligenz verändert die digitale Interaktion und Kommunikation. An der Spitze dieses Wandels steht ChatGPT, eine fortschrittliche Konversations-KI, die neue S

10. September 2025 02:30:32 MESZ

10. September 2025 02:30:32 MESZ

La RAG est révolutionnaire, mais je me demande si limiter les documents récupérés pourrait parfois manquer des infos cruciales 🤔. Perso, j'opterais pour un juste milieu entre précision et exhaustivité !

0

0

29. Juli 2025 14:25:16 MESZ

29. Juli 2025 14:25:16 MESZ

This article on RAG is super intriguing! Fewer documents leading to better AI responses? Mind blown 🤯. Makes me wonder how this could streamline chatbots for customer service. Anyone tried this yet?

0

0

26. April 2025 08:04:32 MESZ

26. April 2025 08:04:32 MESZ

Adoro como essa ferramenta torna as respostas do AI mais precisas usando menos documentos. É como mágica! Mas às vezes parece que está faltando alguma informação. Ainda assim, uma ótima ferramenta para respostas rápidas e confiáveis. 👍

0

0

24. April 2025 00:29:07 MESZ

24. April 2025 00:29:07 MESZ

I love how this tool makes AI responses more accurate by using fewer documents. It's like magic! But sometimes it feels like it's missing out on some info. Still, a great tool for quick, reliable answers. 👍

0

0

22. April 2025 18:50:26 MESZ

22. April 2025 18:50:26 MESZ

「少ない方が良い」というAIの応答方法はかなりクール!少ないドキュメントから正確な答えを得るなんて、登録したいですね!魔法のようですが、もっと早く動いてほしいです。でも、AI技術の前進の一歩としては素晴らしいですね!🚀

0

0

21. April 2025 13:14:10 MESZ

21. April 2025 13:14:10 MESZ

This app really simplifies things! By retrieving fewer but more relevant documents, the AI responses are much more accurate and to the point. It's like having a smart assistant that knows exactly what you need. Only wish it was a bit faster. Still, a great tool! 😊

0

0