OpenAI enthüllt zwei fortschrittliche Open-Weight-KI-Modelle

OpenAI gab am Dienstag die Veröffentlichung von zwei Open-Weight-KI-Modellen bekannt, die mit den Fähigkeiten seiner o-Serie vergleichbar sind. Beide Modelle sind auf Hugging Face kostenlos herunterladbar, wobei OpenAI sie als „führend“ in mehreren Benchmarks für offene Modelle bezeichnet.

Die Modelle gibt es in zwei Varianten: das robuste gpt-oss-120b, das auf einer einzelnen Nvidia-GPU läuft, und das leichte gpt-oss-20b, das für Standard-Laptops mit 16 GB Speicher entwickelt wurde.

Diese Veröffentlichung ist OpenAIs erstes offenes Sprachmodell seit GPT-2, das vor über fünf Jahren eingeführt wurde.

Während einer Pressekonferenz erklärte OpenAI, dass seine offenen Modelle komplexe Anfragen durch Verbindung mit fortschrittlicheren cloudbasierten KI-Systemen verarbeiten können, wie TechCrunch zuvor berichtete. Dies ermöglicht Entwicklern, das offene Modell bei Bedarf mit OpenAIs proprietären Modellen für Aufgaben wie Bildverarbeitung zu verknüpfen.

Obwohl OpenAI ursprünglich Open-Source-KI-Modelle unterstützte, ist es größtenteils zu einem proprietären Entwicklungsmodell übergegangen, was ein florierendes Geschäft durch API-Zugang für Unternehmen und Entwickler ermöglicht.

Im Januar räumte CEO Sam Altman ein, dass OpenAI möglicherweise einen Fehler gemacht hat, indem es Open-Source-Technologien nicht priorisierte. Das Unternehmen sieht sich nun starker Konkurrenz durch chinesische KI-Labore wie DeepSeek, Alibabas Qwen und Moonshot AI gegenüber, die mit ihren leistungsstarken offenen Modellen an Zugkraft gewonnen haben. (Metas Llama-Modelle, einst führend im Open-AI-Bereich, sind im letzten Jahr zurückgefallen.)

Im Juli forderte die Trump-Administration US-KI-Entwickler auf, mehr Technologie als Open Source bereitzustellen, um KI zu fördern, die mit amerikanischen Werten weltweit übereinstimmt.

Tech- und VC-Führer auf der Disrupt 2025

Netflix, ElevenLabs, Wayve und Sequoia Capital gehören zu den prominenten Namen auf der Agenda der Disrupt 2025 und teilen Einblicke, um den Erfolg und die Innovation von Start-ups voranzutreiben. Verpassen Sie nicht das 20-jährige Jubiläum von TechCrunch Disrupt, um von den führenden Stimmen der Tech-Branche zu lernen – sichern Sie sich jetzt Ihr Ticket und sparen Sie bis zu 675 $ vor der Preiserhöhung am 7. August.

Tech- und VC-Führer auf der Disrupt 2025

Netflix, ElevenLabs, Wayve und Sequoia Capital gehören zu den prominenten Namen auf der Agenda der Disrupt 2025 und teilen Einblicke, um den Erfolg und die Innovation von Start-ups voranzutreiben. Verpassen Sie nicht das 20-jährige Jubiläum von TechCrunch Disrupt, um von den führenden Stimmen der Tech-Branche zu lernen – sichern Sie sich jetzt Ihr Ticket und sparen Sie bis zu 675 $ vor der Preiserhöhung.

San Francisco | 27.–29. Oktober 2025 JETZT REGISTRIERENMit gpt-oss will OpenAI Entwickler gewinnen und sich an den Aufruf der Trump-Administration anpassen, da beide den Aufstieg chinesischer KI-Labore im Open-Source-Bereich bemerkt haben.

„Seit unserer Gründung im Jahr 2015 ist die Mission von OpenAI, AGI zum Wohle der gesamten Menschheit voranzutreiben“, sagte CEO Sam Altman in einer Erklärung gegenüber TechCrunch. „Wir sind begeistert, die Welt auf einem offenen KI-Framework zu sehen, das in US-amerikanischen demokratischen Werten verwurzelt ist, frei zugänglich und weitreichend nützlich.“

(Foto von Tomohiro Ohsumi/Getty Images)Bildnachweis: Tomohiro Ohsumi / Getty Images Übersicht der Modellleistung

OpenAI hat sein offenes Modell so entwickelt, dass es unter den Open-Weight-KI-Systemen führend ist, und das Unternehmen behauptet, dieses Ziel erreicht zu haben.

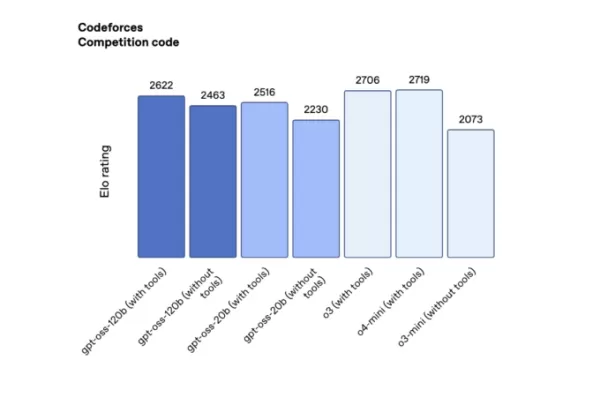

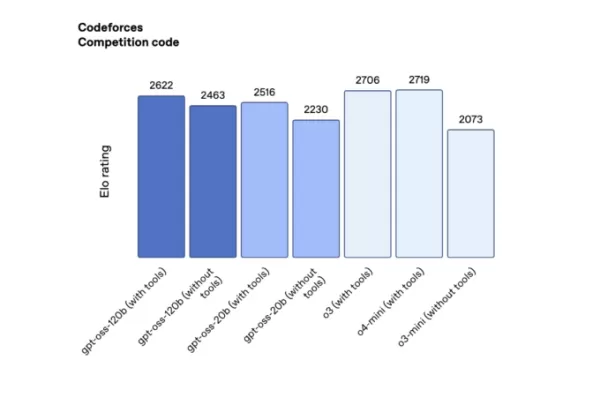

In Wettbewerbstests für Programmierung auf Codeforces (mit Tools) erzielte gpt-oss-120b 2622 und gpt-oss-20b 2516, womit sie DeepSeeks R1 übertrafen, aber hinter o3 und o4-mini zurückblieben.

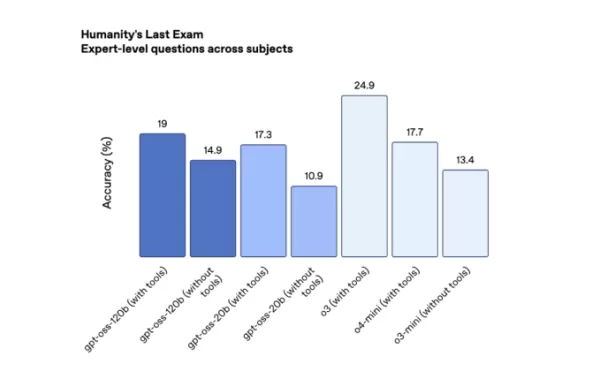

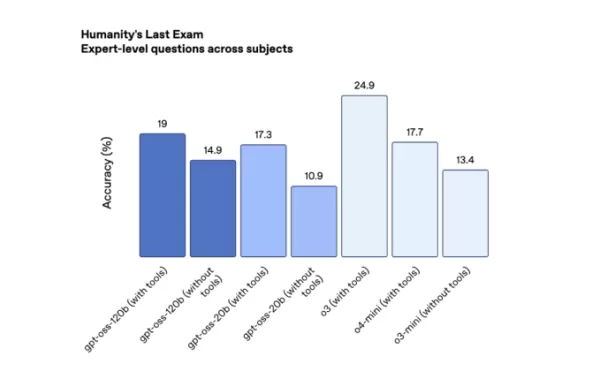

Leistung von OpenAIs offenem Modell auf Codeforces (Quelle: OpenAI). Auf Humanity’s Last Exam, einem strengen, crowdsourced Test über mehrere Fachbereiche (mit Tools), erzielten gpt-oss-120b und gpt-oss-20b 19 % bzw. 17,3 %, womit sie führende offene Modelle von DeepSeek und Qwen übertrafen, aber hinter o3 zurückblieben.

Leistung von OpenAIs offenem Modell auf HLE (Quelle: OpenAI). Bemerkenswert ist, dass die offenen Modelle von OpenAI deutlich höhere Halluzinationsraten aufweisen als die neuesten Reasoning-Modelle o3 und o4-mini.

Halluzinationen sind in den jüngsten KI-Reasoning-Modellen von OpenAI stärker ausgeprägt, wobei das Unternehmen zugibt, dass es die Ursache noch untersucht. In einem Whitepaper stellte OpenAI fest, dass „kleinere Modelle mit weniger Weltwissen voraussichtlich mehr halluzinieren als größere Frontier-Modelle.“

Auf PersonQA, OpenAIs internem Benchmark zur Bewertung der Modellgenauigkeit über Personen, halluzinierten gpt-oss-120b und gpt-oss-20b in 49 % bzw. 53 % der Antworten – mehr als das Dreifache der Rate des o1-Modells (16 %) und höher als o4-mini (36 %).

Training der neuen Modelle

OpenAI gibt an, dass seine offenen Modelle mit ähnlichen Techniken wie die proprietären Modelle entwickelt wurden. Beide nutzen einen Mixture-of-Experts (MoE)-Ansatz, der weniger Parameter pro Anfrage aktiviert, um eine höhere Effizienz zu erreichen. Für gpt-oss-120b, mit insgesamt 117 Milliarden Parametern, werden pro Token nur 5,1 Milliarden genutzt.

Die offenen Modelle wurden mit hochleistungsfähigem Reinforcement Learning (RL) trainiert, einer Post-Training-Methode, die Nvidia-GPU-Cluster verwendet, um KI-Entscheidungsfindung in simulierten Szenarien zu verfeinern. Dies spiegelt das Training der o-Serie von OpenAI wider und beinhaltet einen Chain-of-Thought-Prozess, der zusätzliche Zeit und Ressourcen benötigt, um Antworten zu durchdenken.

Dieses Training ermöglicht es den offenen Modellen, KI-Agenten zu unterstützen und Tools wie Websuche oder Python-Codeausführung in ihren Reasoning-Prozess einzubinden. Sie sind jedoch auf Textaufgaben beschränkt und können keine Bilder oder Audio verarbeiten oder generieren, im Gegensatz zu anderen Modellen von OpenAI.

Die Modelle gpt-oss-120b und gpt-oss-20b werden unter der Apache 2.0-Lizenz veröffentlicht, was Unternehmen erlaubt, sie ohne Gebühren oder Genehmigung von OpenAI zu monetarisieren.

Im Gegensatz zu vollständig Open-Source-Modellen von Labors wie AI2 wird OpenAI die Trainingsdaten für seine offenen Modelle nicht offenlegen, eine Entscheidung, die wahrscheinlich durch laufende Klagen beeinflusst ist, die den unsachgemäßen Einsatz urheberrechtlich geschützten Materials im KI-Training behaupten.

OpenAI hat die Veröffentlichung seiner offenen Modelle mehrfach verschoben, um Sicherheitsbedenken anzugehen. Über standardmäßige Sicherheitsprotokolle hinaus bewertete das Unternehmen, ob böswillige Akteure gpt-oss für schädliche Zwecke wie Cyberangriffe oder die Entwicklung biologischer oder chemischer Waffen optimieren könnten.

Tests von OpenAI und externen Evaluatoren ergaben, dass gpt-oss die biologischen Fähigkeiten leicht verbessern könnte, aber selbst nach Feinabstimmung die „hohe Gefährdungsschwelle“ des Unternehmens nicht erreicht.

Während die Modelle von OpenAI unter den offenen Modellen führend sind, erwarten Entwickler die Veröffentlichung von DeepSeeks R2 und einem neuen offenen Modell aus Metas Superintelligenz-Labor.

Verwandter Artikel

OpenAI enthüllt zwei fortschrittliche Open-Weight-KI-Modelle

OpenAI gab am Dienstag die Veröffentlichung von zwei Open-Weight-KI-Modellen bekannt, die mit den Fähigkeiten seiner o-Serie vergleichbar sind. Beide Modelle sind auf Hugging Face kostenlos herunterla

OpenAI enthüllt zwei fortschrittliche Open-Weight-KI-Modelle

OpenAI gab am Dienstag die Veröffentlichung von zwei Open-Weight-KI-Modellen bekannt, die mit den Fähigkeiten seiner o-Serie vergleichbar sind. Beide Modelle sind auf Hugging Face kostenlos herunterla

ByteDance enthüllt Seed-Thinking-v1.5 KI-Modell zur Verbesserung der Denkfähigkeiten

Das Rennen um fortschrittliche denkende KI begann mit OpenAIs o1-Modell im September 2024 und gewann mit dem Start von DeepSeeks R1 im Januar 2025 an Dynamik.Wichtige KI-Entwickler konkurrieren nun da

ByteDance enthüllt Seed-Thinking-v1.5 KI-Modell zur Verbesserung der Denkfähigkeiten

Das Rennen um fortschrittliche denkende KI begann mit OpenAIs o1-Modell im September 2024 und gewann mit dem Start von DeepSeeks R1 im Januar 2025 an Dynamik.Wichtige KI-Entwickler konkurrieren nun da

Oracles 40-Mrd.-Nvidia-Chip-Investition stärkt Texas AI-Rechenzentrum

Oracle plant, etwa 40 Milliarden Dollar in Nvidia-Chips zu investieren, um ein großes neues Rechenzentrum in Texas zu betreiben, das von OpenAI entwickelt wird, wie die Financial Times berichtet. Dies

Kommentare (0)

0/200

Oracles 40-Mrd.-Nvidia-Chip-Investition stärkt Texas AI-Rechenzentrum

Oracle plant, etwa 40 Milliarden Dollar in Nvidia-Chips zu investieren, um ein großes neues Rechenzentrum in Texas zu betreiben, das von OpenAI entwickelt wird, wie die Financial Times berichtet. Dies

Kommentare (0)

0/200

OpenAI gab am Dienstag die Veröffentlichung von zwei Open-Weight-KI-Modellen bekannt, die mit den Fähigkeiten seiner o-Serie vergleichbar sind. Beide Modelle sind auf Hugging Face kostenlos herunterladbar, wobei OpenAI sie als „führend“ in mehreren Benchmarks für offene Modelle bezeichnet.

Die Modelle gibt es in zwei Varianten: das robuste gpt-oss-120b, das auf einer einzelnen Nvidia-GPU läuft, und das leichte gpt-oss-20b, das für Standard-Laptops mit 16 GB Speicher entwickelt wurde.

Diese Veröffentlichung ist OpenAIs erstes offenes Sprachmodell seit GPT-2, das vor über fünf Jahren eingeführt wurde.

Während einer Pressekonferenz erklärte OpenAI, dass seine offenen Modelle komplexe Anfragen durch Verbindung mit fortschrittlicheren cloudbasierten KI-Systemen verarbeiten können, wie TechCrunch zuvor berichtete. Dies ermöglicht Entwicklern, das offene Modell bei Bedarf mit OpenAIs proprietären Modellen für Aufgaben wie Bildverarbeitung zu verknüpfen.

Obwohl OpenAI ursprünglich Open-Source-KI-Modelle unterstützte, ist es größtenteils zu einem proprietären Entwicklungsmodell übergegangen, was ein florierendes Geschäft durch API-Zugang für Unternehmen und Entwickler ermöglicht.

Im Januar räumte CEO Sam Altman ein, dass OpenAI möglicherweise einen Fehler gemacht hat, indem es Open-Source-Technologien nicht priorisierte. Das Unternehmen sieht sich nun starker Konkurrenz durch chinesische KI-Labore wie DeepSeek, Alibabas Qwen und Moonshot AI gegenüber, die mit ihren leistungsstarken offenen Modellen an Zugkraft gewonnen haben. (Metas Llama-Modelle, einst führend im Open-AI-Bereich, sind im letzten Jahr zurückgefallen.)

Im Juli forderte die Trump-Administration US-KI-Entwickler auf, mehr Technologie als Open Source bereitzustellen, um KI zu fördern, die mit amerikanischen Werten weltweit übereinstimmt.

Tech- und VC-Führer auf der Disrupt 2025

Netflix, ElevenLabs, Wayve und Sequoia Capital gehören zu den prominenten Namen auf der Agenda der Disrupt 2025 und teilen Einblicke, um den Erfolg und die Innovation von Start-ups voranzutreiben. Verpassen Sie nicht das 20-jährige Jubiläum von TechCrunch Disrupt, um von den führenden Stimmen der Tech-Branche zu lernen – sichern Sie sich jetzt Ihr Ticket und sparen Sie bis zu 675 $ vor der Preiserhöhung am 7. August.

Tech- und VC-Führer auf der Disrupt 2025

Netflix, ElevenLabs, Wayve und Sequoia Capital gehören zu den prominenten Namen auf der Agenda der Disrupt 2025 und teilen Einblicke, um den Erfolg und die Innovation von Start-ups voranzutreiben. Verpassen Sie nicht das 20-jährige Jubiläum von TechCrunch Disrupt, um von den führenden Stimmen der Tech-Branche zu lernen – sichern Sie sich jetzt Ihr Ticket und sparen Sie bis zu 675 $ vor der Preiserhöhung.

San Francisco | 27.–29. Oktober 2025 JETZT REGISTRIERENMit gpt-oss will OpenAI Entwickler gewinnen und sich an den Aufruf der Trump-Administration anpassen, da beide den Aufstieg chinesischer KI-Labore im Open-Source-Bereich bemerkt haben.

„Seit unserer Gründung im Jahr 2015 ist die Mission von OpenAI, AGI zum Wohle der gesamten Menschheit voranzutreiben“, sagte CEO Sam Altman in einer Erklärung gegenüber TechCrunch. „Wir sind begeistert, die Welt auf einem offenen KI-Framework zu sehen, das in US-amerikanischen demokratischen Werten verwurzelt ist, frei zugänglich und weitreichend nützlich.“

Übersicht der Modellleistung

OpenAI hat sein offenes Modell so entwickelt, dass es unter den Open-Weight-KI-Systemen führend ist, und das Unternehmen behauptet, dieses Ziel erreicht zu haben.

In Wettbewerbstests für Programmierung auf Codeforces (mit Tools) erzielte gpt-oss-120b 2622 und gpt-oss-20b 2516, womit sie DeepSeeks R1 übertrafen, aber hinter o3 und o4-mini zurückblieben.

Auf Humanity’s Last Exam, einem strengen, crowdsourced Test über mehrere Fachbereiche (mit Tools), erzielten gpt-oss-120b und gpt-oss-20b 19 % bzw. 17,3 %, womit sie führende offene Modelle von DeepSeek und Qwen übertrafen, aber hinter o3 zurückblieben.

Bemerkenswert ist, dass die offenen Modelle von OpenAI deutlich höhere Halluzinationsraten aufweisen als die neuesten Reasoning-Modelle o3 und o4-mini.

Halluzinationen sind in den jüngsten KI-Reasoning-Modellen von OpenAI stärker ausgeprägt, wobei das Unternehmen zugibt, dass es die Ursache noch untersucht. In einem Whitepaper stellte OpenAI fest, dass „kleinere Modelle mit weniger Weltwissen voraussichtlich mehr halluzinieren als größere Frontier-Modelle.“

Auf PersonQA, OpenAIs internem Benchmark zur Bewertung der Modellgenauigkeit über Personen, halluzinierten gpt-oss-120b und gpt-oss-20b in 49 % bzw. 53 % der Antworten – mehr als das Dreifache der Rate des o1-Modells (16 %) und höher als o4-mini (36 %).

Training der neuen Modelle

OpenAI gibt an, dass seine offenen Modelle mit ähnlichen Techniken wie die proprietären Modelle entwickelt wurden. Beide nutzen einen Mixture-of-Experts (MoE)-Ansatz, der weniger Parameter pro Anfrage aktiviert, um eine höhere Effizienz zu erreichen. Für gpt-oss-120b, mit insgesamt 117 Milliarden Parametern, werden pro Token nur 5,1 Milliarden genutzt.

Die offenen Modelle wurden mit hochleistungsfähigem Reinforcement Learning (RL) trainiert, einer Post-Training-Methode, die Nvidia-GPU-Cluster verwendet, um KI-Entscheidungsfindung in simulierten Szenarien zu verfeinern. Dies spiegelt das Training der o-Serie von OpenAI wider und beinhaltet einen Chain-of-Thought-Prozess, der zusätzliche Zeit und Ressourcen benötigt, um Antworten zu durchdenken.

Dieses Training ermöglicht es den offenen Modellen, KI-Agenten zu unterstützen und Tools wie Websuche oder Python-Codeausführung in ihren Reasoning-Prozess einzubinden. Sie sind jedoch auf Textaufgaben beschränkt und können keine Bilder oder Audio verarbeiten oder generieren, im Gegensatz zu anderen Modellen von OpenAI.

Die Modelle gpt-oss-120b und gpt-oss-20b werden unter der Apache 2.0-Lizenz veröffentlicht, was Unternehmen erlaubt, sie ohne Gebühren oder Genehmigung von OpenAI zu monetarisieren.

Im Gegensatz zu vollständig Open-Source-Modellen von Labors wie AI2 wird OpenAI die Trainingsdaten für seine offenen Modelle nicht offenlegen, eine Entscheidung, die wahrscheinlich durch laufende Klagen beeinflusst ist, die den unsachgemäßen Einsatz urheberrechtlich geschützten Materials im KI-Training behaupten.

OpenAI hat die Veröffentlichung seiner offenen Modelle mehrfach verschoben, um Sicherheitsbedenken anzugehen. Über standardmäßige Sicherheitsprotokolle hinaus bewertete das Unternehmen, ob böswillige Akteure gpt-oss für schädliche Zwecke wie Cyberangriffe oder die Entwicklung biologischer oder chemischer Waffen optimieren könnten.

Tests von OpenAI und externen Evaluatoren ergaben, dass gpt-oss die biologischen Fähigkeiten leicht verbessern könnte, aber selbst nach Feinabstimmung die „hohe Gefährdungsschwelle“ des Unternehmens nicht erreicht.

Während die Modelle von OpenAI unter den offenen Modellen führend sind, erwarten Entwickler die Veröffentlichung von DeepSeeks R2 und einem neuen offenen Modell aus Metas Superintelligenz-Labor.

OpenAI enthüllt zwei fortschrittliche Open-Weight-KI-Modelle

OpenAI gab am Dienstag die Veröffentlichung von zwei Open-Weight-KI-Modellen bekannt, die mit den Fähigkeiten seiner o-Serie vergleichbar sind. Beide Modelle sind auf Hugging Face kostenlos herunterla

OpenAI enthüllt zwei fortschrittliche Open-Weight-KI-Modelle

OpenAI gab am Dienstag die Veröffentlichung von zwei Open-Weight-KI-Modellen bekannt, die mit den Fähigkeiten seiner o-Serie vergleichbar sind. Beide Modelle sind auf Hugging Face kostenlos herunterla

ByteDance enthüllt Seed-Thinking-v1.5 KI-Modell zur Verbesserung der Denkfähigkeiten

Das Rennen um fortschrittliche denkende KI begann mit OpenAIs o1-Modell im September 2024 und gewann mit dem Start von DeepSeeks R1 im Januar 2025 an Dynamik.Wichtige KI-Entwickler konkurrieren nun da

ByteDance enthüllt Seed-Thinking-v1.5 KI-Modell zur Verbesserung der Denkfähigkeiten

Das Rennen um fortschrittliche denkende KI begann mit OpenAIs o1-Modell im September 2024 und gewann mit dem Start von DeepSeeks R1 im Januar 2025 an Dynamik.Wichtige KI-Entwickler konkurrieren nun da