麻省理工學院推出超越靜態模型的自我學習 AI 架構

麻省理工學院研究人員開創自學人工智能框架

麻省理工學院的研究團隊開發了一套名為 SEAL(Self-Adapting Language Models,自適應語言模型)的創新系統,讓大型語言模型能夠自主進化其能力。這項突破使人工智能系統能夠產生自己的訓練材料和學習協議,允許永久整合新知識和技能。

SEAL 代表了企業級 AI 應用的重大進步,特別是對於在流動環境中運作的智慧型代理人而言,持續適應是非常重要的。此架構解決了目前 LLM 技術中的基本限制 - 即在臨時情境學習之外的永久性知識整合挑戰。

現代人工智能的適應性挑戰

雖然大型語言模型展現出令人印象深刻的能力,但其真正學習和內化新資訊的能力仍然受到限制。目前的適應方法,例如微調或上下文學習,都是被動地處理輸入資料,而沒有針對模型的學習過程進行最佳化。

"麻省理工學院博士生兼論文合著者 Jyo Pari 解釋說:「企業應用需要的不只是暫時的知識回憶,而是深入、持久的適應。「無論是掌握專屬框架的編碼助理,或是學習使用者偏好的客服 AI,這些知識都必須嵌入模型的核心架構中。」

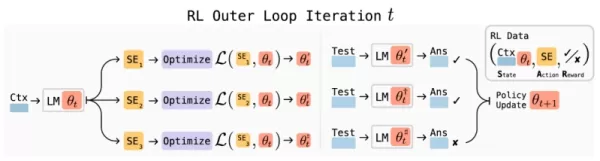

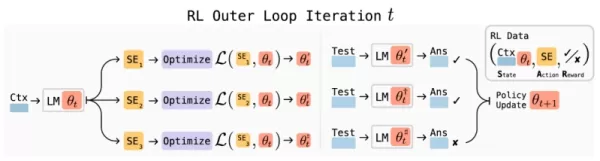

SEAL 架構

SEAL 架構概觀 (資料來源:arXiv) SEAL 架構引入了一種新穎的強化學習方法,模型會產生「自我編輯」(self-edits),也就是更新自身參數的專門指令。這些編輯可以重組資訊、建立合成訓練範例,甚至定義學習協議,有效地讓模型設計自己的課程。

系統透過雙學習循環來運作:

- 內環:根據自我產生的編輯執行臨時權重更新

- 外環:評估更新的有效性並強化成功的策略

這種持續的自我改進機制將合成資料生成、強化學習和測試時間訓練結合為一個連貫的學習範例。

跨領域的驗證效能

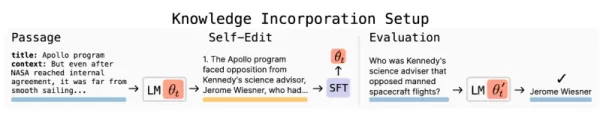

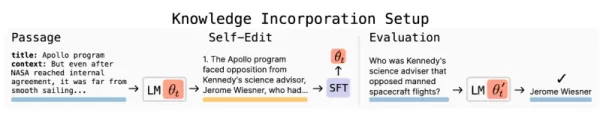

知識整合

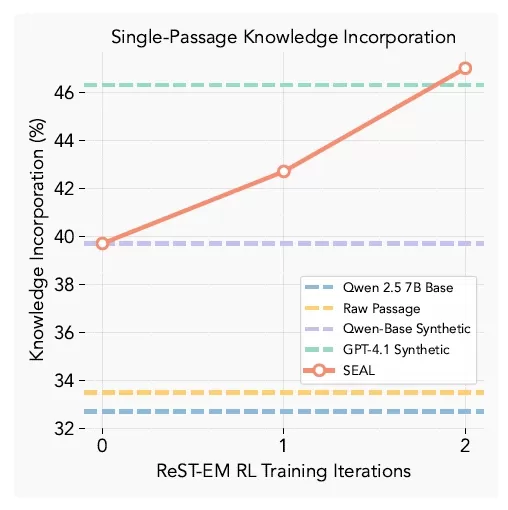

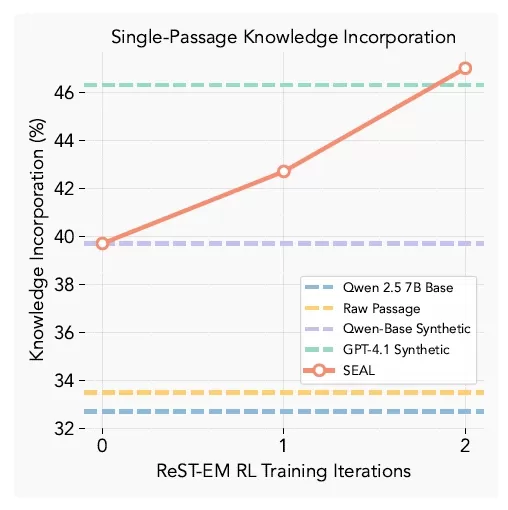

SEAL 知識整合結果 (資料來源:arXiv) 在知識保留測試中,SEAL 增強型模型在不存取原始資料的情況下,回憶段落內容的準確率達到 47%,大幅超越基線微調和 GPT-4.1 產生的合成資料。

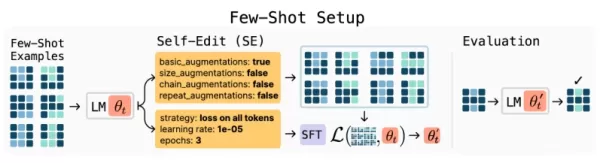

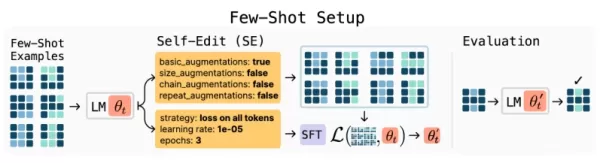

少量學習

SEAL 快速學習效能 (資料來源:arXiv) 當應用於 ARC 資料集中的抽象推理挑戰時,SEAL 取得 72.5% 的成功率 - 比標準的情境學習方法有顯著的改善。

企業應用

隨著人們對優質訓練資料枯竭的憂慮與日俱增,SEAL 的自我生成學習材料能力提供了一條可持續發展的道路。該技術可讓模型透過迭代式自我解釋,自主加深對研究論文或財務報告等複雜文件的理解。

此架構對於 AI 代理的開發顯示出特殊的前景,可讓系統永久整合來自環境互動的作業知識。與靜態程式設計方法不同,SEAL 驅動的代理可隨著時間演進其能力,同時減少對人為干預的依賴。

目前的限制

SEAL 的實作面臨幾個實際的考量:

- 災難性遺忘:持續的自我編輯有可能會覆蓋先前學到的資訊

- 運算開銷:適應過程需要大量的處理時間

- 需要混合實作:結合 SEAL 與檢索增量生成 (RAG) 可優化記憶體管理

"我們建議企業實施排程更新週期,而非持續適應,」Pari 表示。「這樣可以平衡適應性優點與實際操作限制」。

SEAL 的逐步改進(資料來源:arXiv) 這項研究證明,語言模型在經過初始訓練後,不需要保持靜態。透過學習產生和應用自己的更新,它們可以自主擴展知識並適應新的挑戰 - 這種能力可以重新定義企業 AI 的實施。

相關文章

Multiverse AI 推出突破性的微型高性能模型

歐洲一家先進的人工智慧初創公司發表了突破性的微型人工智慧模型,並以鳥類和昆蟲的大腦命名,證明強大的人工智慧並不需要龐大的規模。Multiverse Computing 的創新重點在於專為邊緣運算應用而設計的超小型但功能強大的模型。這些微型神經網路被稱為「ChickBrain」(32 億個參數)和「SuperFly」(9 千 4 百萬個參數),代表著高效率人工智慧部署的重大躍進。"創辦人 Román

Multiverse AI 推出突破性的微型高性能模型

歐洲一家先進的人工智慧初創公司發表了突破性的微型人工智慧模型,並以鳥類和昆蟲的大腦命名,證明強大的人工智慧並不需要龐大的規模。Multiverse Computing 的創新重點在於專為邊緣運算應用而設計的超小型但功能強大的模型。這些微型神經網路被稱為「ChickBrain」(32 億個參數)和「SuperFly」(9 千 4 百萬個參數),代表著高效率人工智慧部署的重大躍進。"創辦人 Román

微軟研究發現更多 AI 代幣會增加推理錯誤

LLM 推理效率的新觀點微軟的最新研究顯示,大型語言模型中的先進推理技術並不能在不同的人工智能系統中產生一致的改進。他們的突破性研究分析了九個領先的基礎模型在推理過程中對各種擴充方法的反應。評估推理時間縮放方法研究團隊針對三種不同的縮放技術實施了嚴格的測試方法:傳統的思考鏈提示並行答案產生與彙總透過回饋迴圈進行順序精煉評估推理效能的實驗框架八項綜合基準提供了跨學科的挑戰性測試情境,包括數學、科學推

微軟研究發現更多 AI 代幣會增加推理錯誤

LLM 推理效率的新觀點微軟的最新研究顯示,大型語言模型中的先進推理技術並不能在不同的人工智能系統中產生一致的改進。他們的突破性研究分析了九個領先的基礎模型在推理過程中對各種擴充方法的反應。評估推理時間縮放方法研究團隊針對三種不同的縮放技術實施了嚴格的測試方法:傳統的思考鏈提示並行答案產生與彙總透過回饋迴圈進行順序精煉評估推理效能的實驗框架八項綜合基準提供了跨學科的挑戰性測試情境,包括數學、科學推

為何 LLM 忽視指示及如何有效解決問題

瞭解大型語言模型跳過指令的原因大型語言模型 (LLM) 已經改變了我們與人工智能互動的方式,讓從會話介面到自動內容產生與程式輔助等先進應用程式得以實現。然而,使用者經常會遇到一個令人沮喪的限制:這些模型偶爾會忽略特定的指令,尤其是在複雜或冗長的提示中。這種任務執行不完整的問題不僅會影響輸出品質,也會降低使用者對這些系統的信心。研究這種行為背後的根本原因,可以為優化 LLM 互動提供寶貴的啟示。

評論 (0)

0/200

為何 LLM 忽視指示及如何有效解決問題

瞭解大型語言模型跳過指令的原因大型語言模型 (LLM) 已經改變了我們與人工智能互動的方式,讓從會話介面到自動內容產生與程式輔助等先進應用程式得以實現。然而,使用者經常會遇到一個令人沮喪的限制:這些模型偶爾會忽略特定的指令,尤其是在複雜或冗長的提示中。這種任務執行不完整的問題不僅會影響輸出品質,也會降低使用者對這些系統的信心。研究這種行為背後的根本原因,可以為優化 LLM 互動提供寶貴的啟示。

評論 (0)

0/200

麻省理工學院研究人員開創自學人工智能框架

麻省理工學院的研究團隊開發了一套名為 SEAL(Self-Adapting Language Models,自適應語言模型)的創新系統,讓大型語言模型能夠自主進化其能力。這項突破使人工智能系統能夠產生自己的訓練材料和學習協議,允許永久整合新知識和技能。

SEAL 代表了企業級 AI 應用的重大進步,特別是對於在流動環境中運作的智慧型代理人而言,持續適應是非常重要的。此架構解決了目前 LLM 技術中的基本限制 - 即在臨時情境學習之外的永久性知識整合挑戰。

現代人工智能的適應性挑戰

雖然大型語言模型展現出令人印象深刻的能力,但其真正學習和內化新資訊的能力仍然受到限制。目前的適應方法,例如微調或上下文學習,都是被動地處理輸入資料,而沒有針對模型的學習過程進行最佳化。

"麻省理工學院博士生兼論文合著者 Jyo Pari 解釋說:「企業應用需要的不只是暫時的知識回憶,而是深入、持久的適應。「無論是掌握專屬框架的編碼助理,或是學習使用者偏好的客服 AI,這些知識都必須嵌入模型的核心架構中。」

SEAL 架構

SEAL 架構引入了一種新穎的強化學習方法,模型會產生「自我編輯」(self-edits),也就是更新自身參數的專門指令。這些編輯可以重組資訊、建立合成訓練範例,甚至定義學習協議,有效地讓模型設計自己的課程。

系統透過雙學習循環來運作:

- 內環:根據自我產生的編輯執行臨時權重更新

- 外環:評估更新的有效性並強化成功的策略

這種持續的自我改進機制將合成資料生成、強化學習和測試時間訓練結合為一個連貫的學習範例。

跨領域的驗證效能

知識整合

在知識保留測試中,SEAL 增強型模型在不存取原始資料的情況下,回憶段落內容的準確率達到 47%,大幅超越基線微調和 GPT-4.1 產生的合成資料。

少量學習

當應用於 ARC 資料集中的抽象推理挑戰時,SEAL 取得 72.5% 的成功率 - 比標準的情境學習方法有顯著的改善。

企業應用

隨著人們對優質訓練資料枯竭的憂慮與日俱增,SEAL 的自我生成學習材料能力提供了一條可持續發展的道路。該技術可讓模型透過迭代式自我解釋,自主加深對研究論文或財務報告等複雜文件的理解。

此架構對於 AI 代理的開發顯示出特殊的前景,可讓系統永久整合來自環境互動的作業知識。與靜態程式設計方法不同,SEAL 驅動的代理可隨著時間演進其能力,同時減少對人為干預的依賴。

目前的限制

SEAL 的實作面臨幾個實際的考量:

- 災難性遺忘:持續的自我編輯有可能會覆蓋先前學到的資訊

- 運算開銷:適應過程需要大量的處理時間

- 需要混合實作:結合 SEAL 與檢索增量生成 (RAG) 可優化記憶體管理

"我們建議企業實施排程更新週期,而非持續適應,」Pari 表示。「這樣可以平衡適應性優點與實際操作限制」。

這項研究證明,語言模型在經過初始訓練後,不需要保持靜態。透過學習產生和應用自己的更新,它們可以自主擴展知識並適應新的挑戰 - 這種能力可以重新定義企業 AI 的實施。

Multiverse AI 推出突破性的微型高性能模型

歐洲一家先進的人工智慧初創公司發表了突破性的微型人工智慧模型,並以鳥類和昆蟲的大腦命名,證明強大的人工智慧並不需要龐大的規模。Multiverse Computing 的創新重點在於專為邊緣運算應用而設計的超小型但功能強大的模型。這些微型神經網路被稱為「ChickBrain」(32 億個參數)和「SuperFly」(9 千 4 百萬個參數),代表著高效率人工智慧部署的重大躍進。"創辦人 Román

Multiverse AI 推出突破性的微型高性能模型

歐洲一家先進的人工智慧初創公司發表了突破性的微型人工智慧模型,並以鳥類和昆蟲的大腦命名,證明強大的人工智慧並不需要龐大的規模。Multiverse Computing 的創新重點在於專為邊緣運算應用而設計的超小型但功能強大的模型。這些微型神經網路被稱為「ChickBrain」(32 億個參數)和「SuperFly」(9 千 4 百萬個參數),代表著高效率人工智慧部署的重大躍進。"創辦人 Román

微軟研究發現更多 AI 代幣會增加推理錯誤

LLM 推理效率的新觀點微軟的最新研究顯示,大型語言模型中的先進推理技術並不能在不同的人工智能系統中產生一致的改進。他們的突破性研究分析了九個領先的基礎模型在推理過程中對各種擴充方法的反應。評估推理時間縮放方法研究團隊針對三種不同的縮放技術實施了嚴格的測試方法:傳統的思考鏈提示並行答案產生與彙總透過回饋迴圈進行順序精煉評估推理效能的實驗框架八項綜合基準提供了跨學科的挑戰性測試情境,包括數學、科學推

微軟研究發現更多 AI 代幣會增加推理錯誤

LLM 推理效率的新觀點微軟的最新研究顯示,大型語言模型中的先進推理技術並不能在不同的人工智能系統中產生一致的改進。他們的突破性研究分析了九個領先的基礎模型在推理過程中對各種擴充方法的反應。評估推理時間縮放方法研究團隊針對三種不同的縮放技術實施了嚴格的測試方法:傳統的思考鏈提示並行答案產生與彙總透過回饋迴圈進行順序精煉評估推理效能的實驗框架八項綜合基準提供了跨學科的挑戰性測試情境,包括數學、科學推

為何 LLM 忽視指示及如何有效解決問題

瞭解大型語言模型跳過指令的原因大型語言模型 (LLM) 已經改變了我們與人工智能互動的方式,讓從會話介面到自動內容產生與程式輔助等先進應用程式得以實現。然而,使用者經常會遇到一個令人沮喪的限制:這些模型偶爾會忽略特定的指令,尤其是在複雜或冗長的提示中。這種任務執行不完整的問題不僅會影響輸出品質,也會降低使用者對這些系統的信心。研究這種行為背後的根本原因,可以為優化 LLM 互動提供寶貴的啟示。

為何 LLM 忽視指示及如何有效解決問題

瞭解大型語言模型跳過指令的原因大型語言模型 (LLM) 已經改變了我們與人工智能互動的方式,讓從會話介面到自動內容產生與程式輔助等先進應用程式得以實現。然而,使用者經常會遇到一個令人沮喪的限制:這些模型偶爾會忽略特定的指令,尤其是在複雜或冗長的提示中。這種任務執行不完整的問題不僅會影響輸出品質,也會降低使用者對這些系統的信心。研究這種行為背後的根本原因,可以為優化 LLM 互動提供寶貴的啟示。