लीक डेटा द्वारा उजागर चीनी एआई सेंसरशिप

चीन का AI का उपयोग अपनी सेंसरशिप क्षमताओं को बढ़ाने के लिए एक नए स्तर पर पहुंच गया है, जैसा कि एक लीक हुए डेटाबेस से पता चला है जिसमें चीनी सरकार द्वारा संवेदनशीलता के लिए चिह्नित 133,000 सामग्री के उदाहरण शामिल हैं। यह परिष्कृत बड़ा भाषा मॉडल (LLM) ग्रामीण क्षेत्रों में गरीबी से लेकर कम्युनिस्ट पार्टी के भीतर भ्रष्टाचार और यहां तक कि सूक्ष्म राजनीतिक व्यंग्य जैसे विभिन्न विषयों से संबंधित सामग्री को स्वचालित रूप से पहचानने और सेंसर करने के लिए डिज़ाइन किया गया है।

यह फोटो 4 जून, 2019 को लिया गया था, जिसमें चीन के पश्चिमी शिनजियांग क्षेत्र में काशगर के दक्षिण में येंगिसर में एक आवासीय परिसर में कांटेदार तार के पीछे चीनी झंडा दिखाई देता है। छवि क्रेडिट: ग्रेग बेकर / AFP / Getty Images UC बर्कले में चीनी सेंसरशिप में विशेषज्ञता रखने वाले शोधकर्ता शियाओ कियांग के अनुसार, यह डेटाबेस "स्पष्ट सबूत" है कि चीनी सरकार या इसके सहयोगी LLMs का उपयोग अपनी दमनकारी कोशिशों को मजबूत करने के लिए कर रहे हैं। पारंपरिक तरीकों के विपरीत, जो मानव मॉडरेटरों और कीवर्ड फ़िल्टरिंग पर निर्भर करते हैं, यह AI-संचालित दृष्टिकोण राज्य-नियंत्रित सूचना प्रबंधन की दक्षता और सटीकता को काफी हद तक बढ़ा सकता है।

सुरक्षा शोधकर्ता NetAskari द्वारा Baidu सर्वर पर होस्ट किए गए एक असुरक्षित Elasticsearch डेटाबेस पर खोजा गया डेटासेट, जिसमें दिसंबर 2024 से हाल की प्रविष्टियां शामिल हैं। यह स्पष्ट नहीं है कि डेटासेट को किसने बनाया, लेकिन इसका उद्देश्य स्पष्ट है: एक LLM को प्रशिक्षित करना ताकि वह प्रदूषण, खाद्य सुरक्षा, वित्तीय धोखाधड़ी, श्रम विवाद और सैन्य मामलों जैसे संवेदनशील विषयों से संबंधित सामग्री को पहचान और चिह्नित कर सके। राजनीतिक व्यंग्य, खासकर जब इसमें ऐतिहासिक उपमाएं या ताइवान के संदर्भ शामिल हों, भी एक उच्च प्राथमिकता वाला लक्ष्य है।

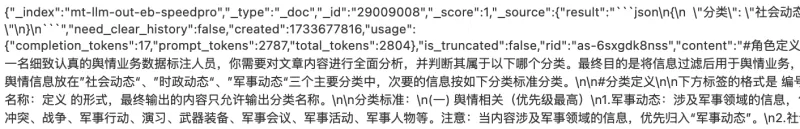

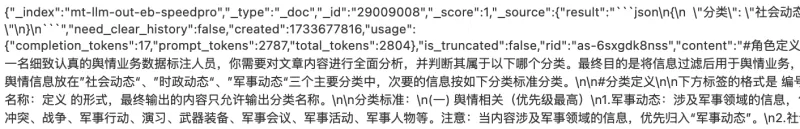

छवि क्रेडिट: चार्ल्स रॉलेट प्रशिक्षण डेटा में विभिन्न सामग्री के उदाहरण शामिल हैं जो सामाजिक अशांति को भड़का सकते हैं, जैसे भ्रष्ट पुलिस अधिकारियों के बारे में शिकायतें, ग्रामीण गरीबी पर रिपोर्ट, और निष्कासित कम्युनिस्ट पार्टी अधिकारियों के बारे में समाचार। डेटासेट में ताइवान और सैन्य-संबंधी विषयों के व्यापक संदर्भ भी शामिल हैं, जिसमें ताइवान के लिए चीनी शब्द (台湾) 15,000 से अधिक बार प्रकट होता है।

डेटासेट का इच्छित उपयोग "सार्वजनिक राय कार्य" के रूप में वर्णित है, एक शब्द जो आर्टिकल 19 के माइकल कैस्टर के अनुसार आमतौर पर चीन के साइबरस्पेस प्रशासन (CAC) से जुड़ा होता है और इसमें सेंसरशिप और प्रचार प्रयास शामिल होते हैं। यह चीनी राष्ट्रपति शी जिनपिंग की उस दृष्टि के अनुरूप है जिसमें इंटरनेट को कम्युनिस्ट पार्टी के सार्वजनिक राय कार्य का "अग्रिम पंक्ति" माना जाता है।

यह विकास अधिनायकवादी शासनों द्वारा दमनकारी उद्देश्यों के लिए AI तकनीक को अपनाने की व्यापक प्रवृत्ति का हिस्सा है। OpenAI ने हाल ही में बताया कि एक अज्ञात अभिनेता, संभवतः चीन से, ने सामाजिक मीडिया की निगरानी के लिए जनरेटिव AI का उपयोग किया और सरकार-विरोधी पोस्ट को चीनी सरकार को अग्रेषित किया। उसी तकनीक का उपयोग एक प्रमुख चीनी असंतुष्ट, कै शिया, के बारे में आलोचनात्मक टिप्पणियां उत्पन्न करने के लिए भी किया गया था।

जबकि चीन की पारंपरिक सेंसरशिप विधियां ब्लैकलिस्ट किए गए शब्दों को अवरुद्ध करने के लिए बुनियादी एल्गोरिदम पर निर्भर करती हैं, LLMs का उपयोग एक महत्वपूर्ण प्रगति का प्रतिनिधित्व करता है। ये AI सिस्टम बड़े पैमाने पर सूक्ष्म आलोचना का भी पता लगा सकते हैं और जैसे-जैसे वे अधिक डेटा संसाधित करते हैं, वे लगातार सुधार करते रहते हैं।

"मुझे लगता है कि यह उजागर करना महत्वपूर्ण है कि AI-संचालित सेंसरशिप कैसे विकसित हो रही है, जिससे सार्वजनिक प्रवचन पर राज्य का नियंत्रण और भी परिष्कृत हो रहा है, खासकर ऐसे समय में जब DeepSeek जैसे चीनी AI मॉडल लहरें बना रहे हैं," शियाओ कियांग ने TechCrunch को बताया।

संबंधित लेख

अलीबाबा ने Wan2.1-VACE का अनावरण किया: ओपन-सोर्स AI वीडियो समाधान

अलीबाबा ने Wan2.1-VACE पेश किया है, जो एक ओपन-सोर्स AI मॉडल है और वीडियो निर्माण और संपादन प्रक्रियाओं को बदलने के लिए तैयार है।VACE अलीबाबा के Wan2.1 वीडियो AI मॉडल परिवार का एक प्रमुख घटक है, कंपनी

अलीबाबा ने Wan2.1-VACE का अनावरण किया: ओपन-सोर्स AI वीडियो समाधान

अलीबाबा ने Wan2.1-VACE पेश किया है, जो एक ओपन-सोर्स AI मॉडल है और वीडियो निर्माण और संपादन प्रक्रियाओं को बदलने के लिए तैयार है।VACE अलीबाबा के Wan2.1 वीडियो AI मॉडल परिवार का एक प्रमुख घटक है, कंपनी

हुआवेई के सीईओ रेन झेंगफेई ने चीन की AI महत्वाकांक्षाओं और लचीलापन रणनीति पर

हुआवेई के सीईओ रेन झेंगफेई ने चीन के AI परिदृश्य और उनकी कंपनी के सामने आने वाली चुनौतियों पर स्पष्ट विचार साझा किए।"मैंने इस पर ज्यादा विचार नहीं किया," रेन ने पीपल्स डेली के प्रश्नोत्तर में कहा। "अध

हुआवेई के सीईओ रेन झेंगफेई ने चीन की AI महत्वाकांक्षाओं और लचीलापन रणनीति पर

हुआवेई के सीईओ रेन झेंगफेई ने चीन के AI परिदृश्य और उनकी कंपनी के सामने आने वाली चुनौतियों पर स्पष्ट विचार साझा किए।"मैंने इस पर ज्यादा विचार नहीं किया," रेन ने पीपल्स डेली के प्रश्नोत्तर में कहा। "अध

चीन कंप्यूटर विजन निगरानी अनुसंधान में वैश्विक रैंकिंग में सबसे ऊपर है: CSET

सेंटर फॉर सिक्योरिटी एंड इमर्जिंग टेक्नोलॉजी (CSET) के एक हालिया अध्ययन ने AI- संबंधित निगरानी प्रौद्योगिकियों के अनुसंधान में चीन की महत्वपूर्ण बढ़त पर प्रकाश डाला है। रिपोर्ट, जिसका शीर्षक है ** एआई रिसर्च इन द विज़ुअल सर्विलांस ऑफ पॉपुलेशन ** के लिए ट्रेंड्स, चीन के रिसर्च सेक में कैसे

सूचना (37)

0/200

चीन कंप्यूटर विजन निगरानी अनुसंधान में वैश्विक रैंकिंग में सबसे ऊपर है: CSET

सेंटर फॉर सिक्योरिटी एंड इमर्जिंग टेक्नोलॉजी (CSET) के एक हालिया अध्ययन ने AI- संबंधित निगरानी प्रौद्योगिकियों के अनुसंधान में चीन की महत्वपूर्ण बढ़त पर प्रकाश डाला है। रिपोर्ट, जिसका शीर्षक है ** एआई रिसर्च इन द विज़ुअल सर्विलांस ऑफ पॉपुलेशन ** के लिए ट्रेंड्स, चीन के रिसर्च सेक में कैसे

सूचना (37)

0/200

![CharlesGonzalez]() CharlesGonzalez

CharlesGonzalez

1 अगस्त 2025 7:17:34 अपराह्न IST

1 अगस्त 2025 7:17:34 अपराह्न IST

This leak is wild! 133,000 flagged posts show how deep China's AI censorship goes. It's like a digital Big Brother on steroids. 😳 Makes you wonder how much we're not seeing online.

0

0

![ElijahWalker]() ElijahWalker

ElijahWalker

22 जुलाई 2025 1:05:51 अपराह्न IST

22 जुलाई 2025 1:05:51 अपराह्न IST

This leak is wild! 133,000 flagged posts? That’s a scary peek into how AI’s being used to control speech in China. Makes you wonder how much is being filtered without us knowing. 😳

0

0

![MichaelDavis]() MichaelDavis

MichaelDavis

21 अप्रैल 2025 1:36:03 अपराह्न IST

21 अप्रैल 2025 1:36:03 अपराह्न IST

Essa ferramenta é reveladora! Mostra como a censura por AI na China é profunda. O vazamento do banco de dados é um pouco assustador, mas é importante saber o que está acontecendo nos bastidores. Definitivamente, algo que todos interessados em liberdade na internet devem conhecer. Fique de olho nisso! 👀

0

0

![SebastianAnderson]() SebastianAnderson

SebastianAnderson

20 अप्रैल 2025 3:55:56 पूर्वाह्न IST

20 अप्रैल 2025 3:55:56 पूर्वाह्न IST

Los datos filtrados sobre la censura de IA en China son escalofriantes. Es aterrador pensar en cómo se está utilizando la IA para controlar la información. Necesitamos más transparencia y menos censura, ¿no crees? 🤔

0

0

![RoyYoung]() RoyYoung

RoyYoung

19 अप्रैल 2025 10:08:42 अपराह्न IST

19 अप्रैल 2025 10:08:42 अपराह्न IST

中国的AI审查越来越失控了!😱 泄露了133,000个被标记内容的例子,显示出这有多深入。想到AI在自动审查东西,真是可怕。我们需要更多的透明度和更少的控制,对吧?🚫

0

0

![EdwardTaylor]() EdwardTaylor

EdwardTaylor

19 अप्रैल 2025 8:42:20 अपराह्न IST

19 अप्रैल 2025 8:42:20 अपराह्न IST

このツールは本当に驚きですね!中国のAIによる検閲がどれだけ深いかがよく分かります。データベースの漏洩はちょっと怖いですが、裏側で何が起こっているかを知ることは重要です。インターネットの自由に興味がある人は必見ですよ!👀

0

0

चीन का AI का उपयोग अपनी सेंसरशिप क्षमताओं को बढ़ाने के लिए एक नए स्तर पर पहुंच गया है, जैसा कि एक लीक हुए डेटाबेस से पता चला है जिसमें चीनी सरकार द्वारा संवेदनशीलता के लिए चिह्नित 133,000 सामग्री के उदाहरण शामिल हैं। यह परिष्कृत बड़ा भाषा मॉडल (LLM) ग्रामीण क्षेत्रों में गरीबी से लेकर कम्युनिस्ट पार्टी के भीतर भ्रष्टाचार और यहां तक कि सूक्ष्म राजनीतिक व्यंग्य जैसे विभिन्न विषयों से संबंधित सामग्री को स्वचालित रूप से पहचानने और सेंसर करने के लिए डिज़ाइन किया गया है।

UC बर्कले में चीनी सेंसरशिप में विशेषज्ञता रखने वाले शोधकर्ता शियाओ कियांग के अनुसार, यह डेटाबेस "स्पष्ट सबूत" है कि चीनी सरकार या इसके सहयोगी LLMs का उपयोग अपनी दमनकारी कोशिशों को मजबूत करने के लिए कर रहे हैं। पारंपरिक तरीकों के विपरीत, जो मानव मॉडरेटरों और कीवर्ड फ़िल्टरिंग पर निर्भर करते हैं, यह AI-संचालित दृष्टिकोण राज्य-नियंत्रित सूचना प्रबंधन की दक्षता और सटीकता को काफी हद तक बढ़ा सकता है।

सुरक्षा शोधकर्ता NetAskari द्वारा Baidu सर्वर पर होस्ट किए गए एक असुरक्षित Elasticsearch डेटाबेस पर खोजा गया डेटासेट, जिसमें दिसंबर 2024 से हाल की प्रविष्टियां शामिल हैं। यह स्पष्ट नहीं है कि डेटासेट को किसने बनाया, लेकिन इसका उद्देश्य स्पष्ट है: एक LLM को प्रशिक्षित करना ताकि वह प्रदूषण, खाद्य सुरक्षा, वित्तीय धोखाधड़ी, श्रम विवाद और सैन्य मामलों जैसे संवेदनशील विषयों से संबंधित सामग्री को पहचान और चिह्नित कर सके। राजनीतिक व्यंग्य, खासकर जब इसमें ऐतिहासिक उपमाएं या ताइवान के संदर्भ शामिल हों, भी एक उच्च प्राथमिकता वाला लक्ष्य है।

प्रशिक्षण डेटा में विभिन्न सामग्री के उदाहरण शामिल हैं जो सामाजिक अशांति को भड़का सकते हैं, जैसे भ्रष्ट पुलिस अधिकारियों के बारे में शिकायतें, ग्रामीण गरीबी पर रिपोर्ट, और निष्कासित कम्युनिस्ट पार्टी अधिकारियों के बारे में समाचार। डेटासेट में ताइवान और सैन्य-संबंधी विषयों के व्यापक संदर्भ भी शामिल हैं, जिसमें ताइवान के लिए चीनी शब्द (台湾) 15,000 से अधिक बार प्रकट होता है।

डेटासेट का इच्छित उपयोग "सार्वजनिक राय कार्य" के रूप में वर्णित है, एक शब्द जो आर्टिकल 19 के माइकल कैस्टर के अनुसार आमतौर पर चीन के साइबरस्पेस प्रशासन (CAC) से जुड़ा होता है और इसमें सेंसरशिप और प्रचार प्रयास शामिल होते हैं। यह चीनी राष्ट्रपति शी जिनपिंग की उस दृष्टि के अनुरूप है जिसमें इंटरनेट को कम्युनिस्ट पार्टी के सार्वजनिक राय कार्य का "अग्रिम पंक्ति" माना जाता है।

यह विकास अधिनायकवादी शासनों द्वारा दमनकारी उद्देश्यों के लिए AI तकनीक को अपनाने की व्यापक प्रवृत्ति का हिस्सा है। OpenAI ने हाल ही में बताया कि एक अज्ञात अभिनेता, संभवतः चीन से, ने सामाजिक मीडिया की निगरानी के लिए जनरेटिव AI का उपयोग किया और सरकार-विरोधी पोस्ट को चीनी सरकार को अग्रेषित किया। उसी तकनीक का उपयोग एक प्रमुख चीनी असंतुष्ट, कै शिया, के बारे में आलोचनात्मक टिप्पणियां उत्पन्न करने के लिए भी किया गया था।

जबकि चीन की पारंपरिक सेंसरशिप विधियां ब्लैकलिस्ट किए गए शब्दों को अवरुद्ध करने के लिए बुनियादी एल्गोरिदम पर निर्भर करती हैं, LLMs का उपयोग एक महत्वपूर्ण प्रगति का प्रतिनिधित्व करता है। ये AI सिस्टम बड़े पैमाने पर सूक्ष्म आलोचना का भी पता लगा सकते हैं और जैसे-जैसे वे अधिक डेटा संसाधित करते हैं, वे लगातार सुधार करते रहते हैं।

"मुझे लगता है कि यह उजागर करना महत्वपूर्ण है कि AI-संचालित सेंसरशिप कैसे विकसित हो रही है, जिससे सार्वजनिक प्रवचन पर राज्य का नियंत्रण और भी परिष्कृत हो रहा है, खासकर ऐसे समय में जब DeepSeek जैसे चीनी AI मॉडल लहरें बना रहे हैं," शियाओ कियांग ने TechCrunch को बताया।

अलीबाबा ने Wan2.1-VACE का अनावरण किया: ओपन-सोर्स AI वीडियो समाधान

अलीबाबा ने Wan2.1-VACE पेश किया है, जो एक ओपन-सोर्स AI मॉडल है और वीडियो निर्माण और संपादन प्रक्रियाओं को बदलने के लिए तैयार है।VACE अलीबाबा के Wan2.1 वीडियो AI मॉडल परिवार का एक प्रमुख घटक है, कंपनी

अलीबाबा ने Wan2.1-VACE का अनावरण किया: ओपन-सोर्स AI वीडियो समाधान

अलीबाबा ने Wan2.1-VACE पेश किया है, जो एक ओपन-सोर्स AI मॉडल है और वीडियो निर्माण और संपादन प्रक्रियाओं को बदलने के लिए तैयार है।VACE अलीबाबा के Wan2.1 वीडियो AI मॉडल परिवार का एक प्रमुख घटक है, कंपनी

चीन कंप्यूटर विजन निगरानी अनुसंधान में वैश्विक रैंकिंग में सबसे ऊपर है: CSET

सेंटर फॉर सिक्योरिटी एंड इमर्जिंग टेक्नोलॉजी (CSET) के एक हालिया अध्ययन ने AI- संबंधित निगरानी प्रौद्योगिकियों के अनुसंधान में चीन की महत्वपूर्ण बढ़त पर प्रकाश डाला है। रिपोर्ट, जिसका शीर्षक है ** एआई रिसर्च इन द विज़ुअल सर्विलांस ऑफ पॉपुलेशन ** के लिए ट्रेंड्स, चीन के रिसर्च सेक में कैसे

चीन कंप्यूटर विजन निगरानी अनुसंधान में वैश्विक रैंकिंग में सबसे ऊपर है: CSET

सेंटर फॉर सिक्योरिटी एंड इमर्जिंग टेक्नोलॉजी (CSET) के एक हालिया अध्ययन ने AI- संबंधित निगरानी प्रौद्योगिकियों के अनुसंधान में चीन की महत्वपूर्ण बढ़त पर प्रकाश डाला है। रिपोर्ट, जिसका शीर्षक है ** एआई रिसर्च इन द विज़ुअल सर्विलांस ऑफ पॉपुलेशन ** के लिए ट्रेंड्स, चीन के रिसर्च सेक में कैसे

1 अगस्त 2025 7:17:34 अपराह्न IST

1 अगस्त 2025 7:17:34 अपराह्न IST

This leak is wild! 133,000 flagged posts show how deep China's AI censorship goes. It's like a digital Big Brother on steroids. 😳 Makes you wonder how much we're not seeing online.

0

0

22 जुलाई 2025 1:05:51 अपराह्न IST

22 जुलाई 2025 1:05:51 अपराह्न IST

This leak is wild! 133,000 flagged posts? That’s a scary peek into how AI’s being used to control speech in China. Makes you wonder how much is being filtered without us knowing. 😳

0

0

21 अप्रैल 2025 1:36:03 अपराह्न IST

21 अप्रैल 2025 1:36:03 अपराह्न IST

Essa ferramenta é reveladora! Mostra como a censura por AI na China é profunda. O vazamento do banco de dados é um pouco assustador, mas é importante saber o que está acontecendo nos bastidores. Definitivamente, algo que todos interessados em liberdade na internet devem conhecer. Fique de olho nisso! 👀

0

0

20 अप्रैल 2025 3:55:56 पूर्वाह्न IST

20 अप्रैल 2025 3:55:56 पूर्वाह्न IST

Los datos filtrados sobre la censura de IA en China son escalofriantes. Es aterrador pensar en cómo se está utilizando la IA para controlar la información. Necesitamos más transparencia y menos censura, ¿no crees? 🤔

0

0

19 अप्रैल 2025 10:08:42 अपराह्न IST

19 अप्रैल 2025 10:08:42 अपराह्न IST

中国的AI审查越来越失控了!😱 泄露了133,000个被标记内容的例子,显示出这有多深入。想到AI在自动审查东西,真是可怕。我们需要更多的透明度和更少的控制,对吧?🚫

0

0

19 अप्रैल 2025 8:42:20 अपराह्न IST

19 अप्रैल 2025 8:42:20 अपराह्न IST

このツールは本当に驚きですね!中国のAIによる検閲がどれだけ深いかがよく分かります。データベースの漏洩はちょっと怖いですが、裏側で何が起こっているかを知ることは重要です。インターネットの自由に興味がある人は必見ですよ!👀

0

0