Google dépasse furtivement dans l'entreprise AI: de «rattraper» pour «nous attraper»

Il y a tout juste un an, l'engouement autour de Google et de l'IA pour les entreprises semblait au point mort. Malgré des technologies pionnières comme le Transformer, le géant de la technologie semblait à la traîne, éclipsé par le succès viral d'OpenAI, la prouesse en codage d'Anthropic et la poussée agressive de Microsoft sur le marché des entreprises.

Mais la semaine dernière, lors de Google Cloud Next 2025 à Las Vegas, la situation était nettement différente. Un Google confiant, armé de modèles performants, d'une infrastructure robuste et d'une stratégie claire pour les entreprises, a annoncé un revirement spectaculaire. Lors d'une réunion à huis clos avec des analystes et des cadres supérieurs de Google, un analyste a résumé l'ambiance : « On dirait le moment où Google est passé de 'rattraper' à 'rattrapez-nous'. »

Le bond en avant de Google

Ce sentiment — que Google a non seulement rattrapé mais dépassé OpenAI et Microsoft dans la course à l'IA pour les entreprises — était palpable tout au long de l'événement. Et ce n'est pas seulement du battage médiatique. Au cours de l'année écoulée, Google s'est concentré intensément sur l'exécution, transformant sa prouesse technologique en une plateforme intégrée et performante qui séduit rapidement les décideurs d'entreprise. Des modèles d'IA les plus puissants au monde fonctionnant sur un silicium personnalisé hautement efficace à un écosystème croissant d'agents d'IA adaptés aux défis commerciaux du monde réel, Google fait valoir qu'il n'a jamais vraiment été perdu, mais qu'il traversait une période de développement profond et fondamental.

Avec sa pile intégrée fonctionnant désormais à pleine capacité, Google semble prêt à mener la prochaine phase de la révolution de l'IA pour les entreprises. Lors de mes entretiens avec des cadres de Google à Next, ils ont souligné les avantages uniques de Google en matière d'infrastructure et d'intégration de modèles — des avantages que des concurrents comme OpenAI, Microsoft ou AWS auraient du mal à reproduire.

L'ombre du doute : reconnaître le passé récent

Pour apprécier pleinement l'élan actuel de Google, il est essentiel de reconnaître le passé récent. Google a inventé l'architecture Transformer, déclenchant la révolution moderne des grands modèles de langage (LLM), et a commencé à investir dans du matériel d'IA spécialisé (TPU) il y a une décennie, ce qui assure aujourd'hui une efficacité de pointe dans l'industrie. Pourtant, inexplicablement, il y a deux ans et demi, Google s'est retrouvé sur la défensive.

ChatGPT d'OpenAI a captivé l'imagination du public et l'intérêt des entreprises à un rythme époustouflant, devenant l'application à la croissance la plus rapide de l'histoire. Des concurrents comme Anthropic se sont taillé des niches dans des domaines comme le codage. Pendant ce temps, les mouvements publics de Google semblaient souvent hésitants ou imparfaits. Les déboires notoires de la démo de Bard en 2023 et la controverse autour de son générateur d'images produisant des représentations historiquement inexactes ont alimenté une narrative d'une entreprise potentiellement entravée par une bureaucratie interne ou une surcorrection sur l'alignement. Google semblait perdu, rappelant sa lenteur initiale dans la compétition du cloud où il restait un lointain troisième en part de marché derrière Amazon et Microsoft.

Le pivot : une décision consciente de mener

En coulisses, cependant, un changement significatif se produisait, motivé par une décision délibérée au plus haut niveau de reprendre le leadership. Mat Velloso, vice-président produit de la plateforme de développement IA de Google DeepMind, a senti ce moment charnière en rejoignant Google en février 2024, après avoir quitté Microsoft. « Quand je suis arrivé chez Google, j'ai parlé avec Sundar [Pichai], j'ai parlé avec plusieurs leaders ici, et j'ai senti que c'était le moment où ils décidaient, d'accord, cette [IA générative] est quelque chose qui intéresse clairement l'industrie. Faisons en sorte que ça arrive », a partagé Velloso lors d'une interview à Next la semaine dernière.

Cette nouvelle impulsion n'a pas été entravée par la redoutée « fuite des cerveaux » que certains croyaient affaiblir Google. Au contraire, l'entreprise a redoublé d'efforts sur l'exécution début 2024, marquée par un recrutement agressif, une unification interne et une traction auprès des clients. Alors que les concurrents faisaient des embauches spectaculaires, Google a conservé son leadership en IA, y compris le PDG de DeepMind, Demis Hassabis, et le PDG de Google Cloud, Thomas Kurian, offrant stabilité et expertise approfondie.

De plus, les talents ont commencé à affluer vers la mission ciblée de Google. Logan Kilpatrick, par exemple, est revenu chez Google après OpenAI, attiré par l'opportunité de construire une IA fondamentale au sein de l'entreprise. Il a rejoint Velloso dans ce qu'il a décrit comme une « expérience de zéro à un », chargé de développer la traction des développeurs pour Gemini depuis le début. « C'était comme si l'équipe, c'était moi le premier jour... nous n'avions aucun utilisateur sur cette plateforme, aucun revenu. Personne ne s'intéressait à Gemini à ce moment-là », se souvient Kilpatrick du point de départ. Des leaders comme Josh Woodward, qui a contribué à lancer AI Studio et dirige maintenant l'application Gemini et Labs, et Noam Shazeer, co-auteur clé du papier original « Attention Is All You Need » sur le Transformer, sont également revenus dans l'entreprise fin 2024 en tant que co-responsable technique du projet crucial Gemini.

Pilier 1 : Gemini 2.5 et l'ère des modèles pensants

Bien que le mantra des entreprises soit passé à « il ne s'agit pas seulement du modèle », avoir le LLM le plus performant reste une réalisation significative et un puissant validateur de la recherche supérieure et de l'architecture technologique efficace d'une entreprise. Avec la sortie de Gemini 2.5 Pro juste quelques semaines avant Next '25, Google a revendiqué ce titre de manière décisive. Il a rapidement dominé le classement indépendant de Chatbot Arena, surpassant largement même la dernière variante GPT-4o d'OpenAI, et a excellé dans des benchmarks de raisonnement notoirement difficiles comme l'Examen Final de l'Humanité. Comme l'a déclaré Pichai dans son discours d'ouverture, « C'est notre modèle d'IA le plus intelligent à ce jour. Et c'est le meilleur modèle au monde. » Le modèle a entraîné une augmentation de 80 % de l'utilisation de Gemini en un mois, a-t-il tweeté séparément.

Pour la première fois, la demande pour Gemini était en feu. Ce qui m'a impressionné, outre l'intelligence brute de Gemini 2.5 Pro, était sa capacité de raisonnement démontrable. Google a conçu une capacité de « pensée », permettant au modèle d'effectuer un raisonnement en plusieurs étapes, une planification, et même une autoréflexion avant de finaliser une réponse. La chaîne de pensée (CoT) structurée et cohérente – utilisant des étapes numérotées et des sous-puces – évite la nature décousue ou opaque des sorties d'autres modèles de DeepSeek ou OpenAI. Pour les équipes techniques évaluant les sorties pour des tâches critiques, cette transparence permet une validation, une correction et une redirection avec une confiance sans précédent.

Mais plus important encore pour les utilisateurs professionnels, Gemini 2.5 Pro a également réduit considérablement l'écart dans le codage, qui est l'un des domaines d'application les plus importants pour l'IA générative. Dans une interview avec VentureBeat, la CTO Fiona Tan du grand détaillant Wayfair a déclaré qu'après des tests initiaux, l'entreprise a trouvé qu'il « s'était beaucoup amélioré » et était maintenant « assez comparable » à Claude 3.7 Sonnet d'Anthropic, auparavant le choix préféré de nombreux développeurs.

Google a également ajouté une fenêtre de contexte massive d'un million de tokens au modèle, permettant un raisonnement sur des bases de code entières ou une documentation longue, dépassant de loin les capacités des modèles d'OpenAI ou d'Anthropic. (OpenAI a répondu cette semaine avec des modèles présentant des fenêtres de contexte similaires, bien que les benchmarks suggèrent que Gemini 2.5 Pro conserve un avantage dans le raisonnement global). Cet avantage permet des tâches complexes d'ingénierie logicielle multi-fichiers.

En complément de Pro, Gemini 2.5 Flash, annoncé à Next '25 et sorti hier, est également un modèle « pensant », optimisé pour une faible latence et une efficacité de coût. Vous pouvez contrôler combien le modèle raisonne et équilibrer les performances avec votre budget. Cette approche hiérarchisée reflète davantage la stratégie d'« intelligence par dollar » défendue par les cadres de Google.

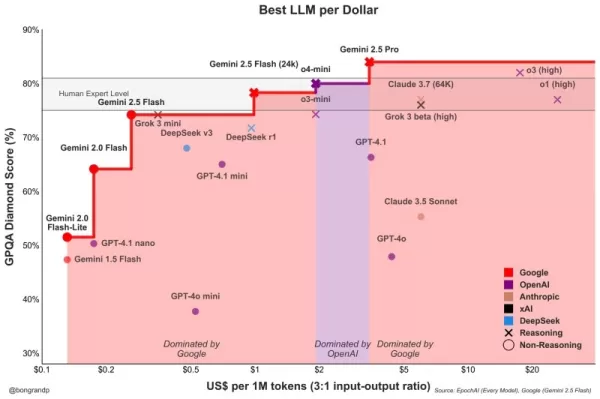

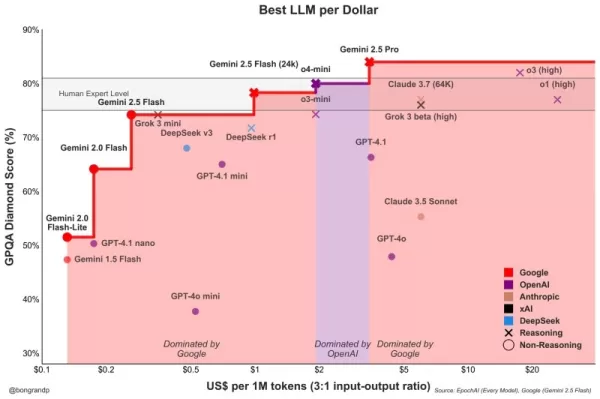

Velloso a montré un graphique révélant que, sur tout le spectre de l'intelligence, les modèles de Google offrent le meilleur rapport qualité-prix. « Si nous avions eu cette conversation il y a un an... je n'aurais rien eu à montrer », a admis Velloso, soulignant le revirement rapide. « Et maintenant, partout, si vous cherchez n'importe quel modèle, n'importe quelle taille, si vous n'êtes pas Google, vous perdez de l'argent. » Des graphiques similaires ont été mis à jour pour prendre en compte les dernières sorties de modèles d'OpenAI cette semaine, tous montrant la même chose : les modèles de Google offrent la meilleure intelligence par dollar. Voir ci-dessous :

Tan de Wayfair a également observé des améliorations prometteuses en matière de latence avec 2.5 Pro : « Gemini 2.5 est revenu plus rapidement », ce qui le rend viable pour « des capacités plus orientées vers les clients », a-t-elle dit, quelque chose qui n'était pas le cas auparavant avec d'autres modèles. Gemini pourrait devenir le premier modèle que Wayfair utilise pour ces interactions avec les clients, a-t-elle ajouté.

Les capacités de la famille Gemini s'étendent à la multimodalité, s'intégrant parfaitement aux autres modèles de pointe de Google comme Imagen 3 (génération d'images), Veo 2 (génération de vidéos), Chirp 3 (audio), et le nouvellement annoncé Lyria (texte-à-musique), tous accessibles via la plateforme de Google pour les utilisateurs professionnels, Vertex. Google est la seule entreprise à offrir ses propres modèles de médias génératifs sur toutes les modalités sur sa plateforme. Microsoft, AWS et OpenAI doivent s'associer à d'autres entreprises pour le faire.

Pilier 2 : La prouesse de l'infrastructure – Le moteur sous le capot

La capacité à itérer rapidement et à servir efficacement ces modèles puissants découle de l'infrastructure sans doute inégalée de Google, affinée pendant des décennies pour gérer des services à l'échelle planétaire. Au cœur de cela se trouve l'unité de traitement Tensor (TPU).

Lors de Next '25, Google a dévoilé Ironwood, sa septième génération de TPU, explicitement conçue pour les besoins de l'inférence et des « modèles pensants ». L'échelle est immense, adaptée aux charges de travail d'IA exigeantes : les pods Ironwood contiennent plus de 9 000 puces refroidies par liquide, offrant une puissance de calcul revendiquée de 42,5 exaflops. Le vice-président des systèmes ML de Google, Amin Vahdat, a déclaré sur scène à Next que cela représente « plus de 24 fois » la puissance de calcul du superordinateur numéro 1 mondial actuel.

Google a indiqué qu'Ironwood offre une performance par watt 2 fois supérieure à celle de Trillium, la génération précédente de TPU. Cela est significatif car les clients professionnels indiquent de plus en plus que les coûts énergétiques et la disponibilité limitent les déploiements d'IA à grande échelle.

Le CTO de Google Cloud, Will Grannis, a souligné la constance de ces progrès. Année après année, Google réalise des améliorations de 10x, 8x, 9x, 10x sur ses processeurs, a-t-il déclaré à VentureBeat dans une interview, créant ce qu'il a appelé une « loi de Moore hyper » pour les accélérateurs d'IA. Il a dit que les clients achètent la feuille de route de Google, pas seulement sa technologie.

La position de Google a alimenté cet investissement soutenu dans les TPU. Elle doit alimenter efficacement des services massifs comme Search, YouTube et Gmail pour plus de 2 milliards d'utilisateurs. Cela a nécessité le développement d'un matériel personnalisé et optimisé bien avant l'actuel boom de l'IA générative. Bien que Meta opère à une échelle similaire pour les consommateurs, les autres concurrents manquaient de ce moteur interne spécifique pour un développement matériel d'IA intégré verticalement sur une décennie.

Maintenant, ces investissements dans les TPU portent leurs fruits car ils permettent une efficacité non seulement pour ses propres applications, mais aussi de permettre à Google d'offrir Gemini à d'autres utilisateurs avec une meilleure intelligence par dollar, toutes choses étant égales par ailleurs.

Pourquoi les concurrents de Google ne peuvent-ils pas acheter des processeurs efficaces auprès de Nvidia, demandez-vous ? Il est vrai que les processeurs GPU de Nvidia dominent le pré-entraînement des LLM. Mais la demande du marché a fait grimper le prix de ces GPU, et Nvidia prend une part importante pour son propre profit. Cela transfère des coûts significatifs aux utilisateurs de ses puces. Et aussi, bien que le pré-entraînement ait dominé l'utilisation des puces d'IA jusqu'à présent, cela change maintenant que les entreprises déploient réellement ces applications. C'est là que l'« inférence » entre en jeu, et ici les TPU sont considérés comme plus efficaces que les GPU pour les charges de travail à grande échelle.

Lorsque vous demandez aux cadres de Google d'où vient leur principal avantage technologique en IA, ils reviennent généralement aux TPU comme étant le plus important. Mark Lohmeyer, le vice-président qui gère l'infrastructure informatique de Google, était sans équivoque : les TPU sont « certainement une partie hautement différenciée de ce que nous faisons... OpenAI, ils n'ont pas ces capacités ».

De manière significative, Google présente les TPU non pas isolément, mais comme faisant partie d'une architecture d'IA pour les entreprises plus large et plus complexe. Pour les initiés techniques, il est entendu que les performances de haut niveau dépendent de l'intégration de percées technologiques de plus en plus spécialisées. De nombreuses mises à jour ont été détaillées à Next. Vahdat a décrit cela comme un « système de superinformatique », intégrant le matériel (TPU, les derniers GPU Nvidia comme Blackwell et le prochain Vera Rubin, le stockage avancé comme Hyperdisk Exapools, Anywhere Cache, et Rapid Storage) avec une pile logicielle unifiée. Ce logiciel inclut Cluster Director pour gérer les accélérateurs, Pathways (le runtime distribué de Gemini, maintenant disponible pour les clients), et apporte des optimisations comme vLLM aux TPU, permettant une migration plus facile des charges de travail pour ceux précédemment sur les piles Nvidia/PyTorch. Ce système intégré, a soutenu Vahdat, est pourquoi Gemini 2.0 Flash atteint une intelligence par dollar 24 fois supérieure, comparée à GPT-4o.

Google étend également la portée de son infrastructure physique. Cloud WAN rend le réseau de fibre privé à faible latence de 2 millions de miles de Google accessible aux entreprises, promettant des performances jusqu'à 40 % plus rapides et un coût total de possession (TCO) inférieur de 40 % par rapport aux réseaux gérés par les clients.

De plus, Google Distributed Cloud (GDC) permet à Gemini et au matériel Nvidia (via un partenariat avec Dell) de fonctionner dans des environnements souverains, sur site, ou même isolés – une capacité que le PDG de Nvidia, Jensen Huang, a qualifiée d'« absolument gigantesque » pour apporter une IA de pointe aux industries réglementées et aux nations. À Next, Huang a qualifié l'infrastructure de Google de meilleure au monde : « Aucune entreprise n'est meilleure à chaque couche de calcul que Google et Google Cloud », a-t-il dit.

Pilier 3 : La pile intégrée complète – Connecter les points

L'avantage stratégique de Google croît lorsqu'on considère comment ces modèles et composants d'infrastructure sont tissés dans une plateforme cohérente. Contrairement aux concurrents, qui s'appuient souvent sur des partenariats pour combler les lacunes, Google contrôle presque toutes les couches, permettant une intégration plus étroite et des cycles d'innovation plus rapides.

Alors, pourquoi cette intégration est-elle importante, si un concurrent comme Microsoft peut simplement s'associer à OpenAI pour égaler l'étendue de l'infrastructure avec la prouesse des modèles LLM ? Les Googlers avec qui j'ai parlé ont dit que cela fait une énorme différence, et ils ont fourni des anecdotes pour le soutenir.

Prenez l'amélioration significative de la base de données d'entreprise de Google, BigQuery. La base de données offre maintenant un graphe de connaissances qui permet aux LLM de rechercher des données beaucoup plus efficacement, et elle compte désormais plus de cinq fois plus de clients que des concurrents comme Snowflake et Databricks. Yasmeen Ahmad, responsable des produits pour l'analyse de données chez Google Cloud, a déclaré que ces vastes améliorations n'étaient possibles que parce que les équipes de données de Google travaillaient en étroite collaboration avec l'équipe de DeepMind. Ils ont travaillé sur des cas d'utilisation difficiles à résoudre, ce qui a conduit la base de données à fournir 50 % de précision en plus sur les requêtes courantes, au moins selon les tests internes de Google, pour atteindre les bonnes données par rapport aux concurrents les plus proches, a déclaré Ahmad à VentureBeat dans une interview. Ahmad a dit que ce type d'intégration profonde à travers la pile est la façon dont Google a « surpassé » l'industrie.

Cette cohésion interne contraste fortement avec la dynamique de « frenemies » chez Microsoft. Alors que Microsoft s'associe à OpenAI pour distribuer ses modèles sur le cloud Azure, Microsoft construit également ses propres modèles. Mat Velloso, le cadre de Google qui dirige maintenant le programme de développement IA, a quitté Microsoft après s'être frustré en essayant d'aligner les plans de Windows Copilot avec les offres de modèles d'OpenAI. « Comment partagez-vous vos plans de produits avec une autre entreprise qui est en réalité en compétition avec vous... Tout cela est une contradiction », se souvient-il. « Ici, je suis assis côte à côte avec les gens qui construisent les modèles. »

Cette intégration reflète ce que les leaders de Google considèrent comme leur avantage principal : leur capacité unique à connecter une expertise profonde à travers tout le spectre, de la recherche fondamentale et de la construction de modèles à un déploiement d'applications à « échelle planétaire » et à la conception d'infrastructure.

Vertex AI sert de système nerveux central pour les efforts d'IA pour les entreprises de Google. Et l'intégration va au-delà des propres offres de Google. Le Model Garden de Vertex propose plus de 200 modèles sélectionnés, y compris ceux de Google, Llama 4 de Meta, et de nombreuses options open-source. Vertex fournit des outils pour le réglage, l'évaluation (y compris les évaluations alimentées par l'IA, que Grannis a soulignées comme un accélérateur clé), le déploiement et la surveillance. Ses capacités d'ancrage exploitent les bases de données prêtes pour l'IA internes tout en étant compatibles avec les bases de données vectorielles externes. Ajoutez à cela les nouvelles offres de Google pour ancrer les modèles avec Google Search, le meilleur moteur de recherche au monde.

L'intégration s'étend à Google Workspace. De nouvelles fonctionnalités annoncées à Next '25, comme « Aidez-moi à analyser » dans Sheets (oui, Sheets a maintenant une formule « =AI »), les Aperçus Audio dans Docs et les Flux de Workspace, intègrent davantage les capacités de Gemini dans les flux de travail quotidiens, créant une boucle de rétroaction puissante pour Google afin d'améliorer l'expérience.

Tout en pilotant sa pile intégrée, Google promeut également l'ouverture là où cela sert l'écosystème. Après avoir poussé l'adoption de Kubernetes, il promeut maintenant JAX pour les cadres d'IA et maintenant des protocoles ouverts pour la communication des agents (A2A) ainsi que le soutien aux normes existantes (MCP). Google propose également des centaines de connecteurs vers des plateformes externes depuis Agentspace, qui est la nouvelle interface unifiée de Google pour les employés afin de trouver et d'utiliser des agents. Ce concept de hub est convaincant. La démonstration d'Agentspace dans le discours d'ouverture (à partir de 51:40) l'illustre. Google offre aux utilisateurs des agents préconstruits, ou les employés ou développeurs peuvent construire les leurs en utilisant des capacités d'IA sans code. Ou ils peuvent intégrer des agents de l'extérieur via des connecteurs A2A. Il s'intègre dans le navigateur Chrome pour un accès fluide.

Pilier 4 : Focus sur la valeur pour les entreprises et l'écosystème des agents

Le changement le plus significatif est peut-être l'accent mis par Google sur la résolution de problèmes concrets pour les entreprises, en particulier à travers le prisme des agents d'IA. Thomas Kurian, PDG de Google Cloud, a souligné trois raisons pour lesquelles les clients choisissent Google : la plateforme optimisée pour l'IA, l'approche multi-cloud ouverte permettant la connexion aux TI existantes, et l'accent sur la sécurité, la souveraineté et la conformité prêtes pour les entreprises.

Les agents sont au cœur de cette stratégie. Outre AgentSpace, cela inclut :

- Blocs de construction : Le kit de développement d'agents open-source (ADK), annoncé à Next, a déjà suscité un intérêt significatif de la part des développeurs. L'ADK simplifie la création de systèmes multi-agents, tandis que le protocole proposé Agent2Agent (A2A) vise à assurer l'interopérabilité, permettant aux agents construits avec différents outils (Gemini ADK, LangGraph, CrewAI, etc.) de collaborer. Grannis de Google a déclaré que A2A anticipe les défis d'échelle et de sécurité d'un avenir avec potentiellement des centaines de milliers d'agents interagissant.

- Agents spécialisés : Google a présenté des agents experts intégrés à Agentspace (comme NotebookLM, Génération d'Idées, Recherche Approfondie) et a mis en avant cinq catégories clés gagnant du terrain : les Agents Clients (alimentant des outils comme Reddit Answers, l'assistant de support de Verizon, le drive-thru de Wendy’s), les Agents Créatifs (utilisés par WPP, Brandtech, Sphere), les Agents de Données (fournissant des insights chez Mattel, Spotify, Bayer), les Agents de Codage (Gemini Code Assist), et les Agents de Sécurité (intégrés dans la nouvelle plateforme de Sécurité Unifiée de Google).

Cette stratégie d'agents complète semble trouver un écho. Les conversations avec les cadres de trois autres grandes entreprises cette semaine passée, parlant également de manière anonyme en raison de sensibilités concurrentielles, ont fait écho à cet enthousiasme pour la stratégie d'agents de Google. Le COO de Google Cloud, Francis DeSouza, a confirmé dans une interview : « Chaque conversation inclut l'IA. Plus précisément, chaque conversation inclut les agents. »

Kevin Laughridge, un cadre chez Deloitte, un grand utilisateur des produits d'IA de Google et un distributeur de ceux-ci à d'autres entreprises, a décrit le marché des agents comme une « ruée vers la terre » où les premiers mouvements de Google avec des protocoles et sa plateforme intégrée offrent des avantages significatifs. « Celui qui sort en premier et obtient le plus d'agents qui apportent réellement de la valeur – c'est celui qui va gagner dans cette course », a déclaré Laughridge dans une interview. Il a dit que les progrès de Google étaient « étonnants », notant que les agents personnalisés que Deloitte a construits il y a tout juste un an pourraient maintenant être reproduits « directement » en utilisant Agentspace. Deloitte elle-même construit 100 agents sur la plateforme, ciblant les fonctions de bureau intermédiaires comme la finance, le risque et l'ingénierie, a-t-il dit.

Les preuves de traction client s'accumulent. À Next, Google a cité « plus de 500 clients en production » avec l'IA générative, contre seulement « des dizaines de prototypes » il y a un an. Si Microsoft était perçu comme largement en avance il y a un an, cela ne semble plus aussi évident. Étant donné la guerre de relations publiques de tous les côtés, il est difficile de dire qui gagne vraiment de manière définitive pour le moment. Les métriques varient. Le chiffre de 500 de Google n'est pas directement comparable aux 400 études de cas que Microsoft promeut (et Microsoft, en réponse, a déclaré à VentureBeat au moment de la presse qu'il prévoit de mettre à jour ce décompte public à 600 sous peu, soulignant le marketing intense). Et si la distribution de l'IA de Google à travers ses applications est significative, la distribution de Copilot de Microsoft à travers son offre 365 est tout aussi impressionnante. Les deux touchent maintenant des millions de développeurs via des API.

Mais les exemples de la traction de Google abondent :

- Wendy’s : A déployé un système de drive-thru IA dans des milliers d'emplacements en seulement un an, améliorant l'expérience des employés et la précision des commandes. Le CTO de Google Cloud, Will Grannis, a noté que le système IA est capable de comprendre l'argot et de filtrer le bruit de fond, réduisant considérablement le stress des interactions avec les clients en direct. Cela libère le personnel pour se concentrer sur la préparation et la qualité des aliments — un changement que Grannis a appelé « un excellent exemple de l'IA rationalisant les opérations du monde réel ».

- Salesforce : A annoncé une expansion majeure, permettant à sa plateforme de fonctionner sur Google Cloud pour la première fois (au-delà d'AWS), citant la capacité de Google à les aider à « innover et optimiser ».

- Honeywell & Intuit : Des entreprises précédemment fortement associées à Microsoft et AWS, respectivement, collaborent maintenant avec Google Cloud sur des initiatives d'IA.

- Grandes banques (Deutsche Bank, Wells Fargo) : Utilisent des agents et Gemini pour la recherche, l'analyse et la modernisation du service client.

- Détaillants (Walmart, Mercado Libre, Lowe’s) : Utilisent la recherche, les agents et les plateformes de données.

Cette traction auprès des entreprises alimente la croissance globale de Google Cloud, qui a dépassé AWS et Azure au cours des trois derniers trimestres. Google Cloud a atteint un taux annualisé de 44 milliards de dollars en 2024, contre seulement 5 milliards en 2018.

Naviguer dans les eaux concurrentielles

L'ascension de Google ne signifie pas que les concurrents restent immobiles. Les sorties rapides d'OpenAI cette semaine de GPT-4.1 (axé sur le codage et le contexte long) et de la série o (raisonnement multimodal, utilisation d'outils) démontrent l'innovation continue d'OpenAI. De plus, la mise à jour de la fonctionnalité de génération d'images dans GPT-4o a alimenté une croissance massive au cours du dernier mois, aidant ChatGPT à atteindre 800 millions d'utilisateurs. Microsoft continue de tirer parti de son vaste empreinte d'entreprise et de son partenariat avec OpenAI, tandis qu'Anthropic reste un concurrent sérieux, en particulier dans les applications axées sur le codage et la sécurité.

Cependant, il est incontestable que la narrative de Google s'est remarquablement améliorée. Il y a tout juste un an, Google était perçu comme un concurrent lourd, hésitant, maladroit, qui risquait peut-être de rater sa chance de mener l'IA. Au lieu de cela, sa pile intégrée unique et sa constance d'entreprise ont révélé autre chose : Google possède des capacités de classe mondiale à travers tout le spectre – de la conception de puces (TPU) et de l'infrastructure mondiale à la recherche sur les modèles fondamentaux (DeepMind), le développement d'applications (Workspace, Search, YouTube) et les services cloud pour les entreprises (Vertex AI, BigQuery, Agentspace). « Nous sommes le seul hyperscaler qui participe à la conversation sur les modèles fondamentaux », a déclaré deSouza sans détour. Cette propriété de bout en bout permet des optimisations (comme « l'intelligence par dollar ») et une profondeur d'intégration que les modèles dépendant des partenariats ont du mal à égaler. Les concurrents doivent souvent assembler des pièces disparates, ce qui peut créer des frictions ou limiter la vitesse d'innovation.

Le moment de Google est maintenant

Bien que la course à l'IA reste dynamique, Google a assemblé toutes ces pièces au moment précis où le marché les exige. Comme l'a dit Laughridge de Deloitte, Google a atteint un point où ses capacités se sont parfaitement alignées « là où le marché le demandait ». Si vous attendiez que Google fasse ses preuves dans l'IA pour les entreprises, vous avez peut-être manqué le moment — il l'a déjà fait. L'entreprise qui a inventé de nombreuses technologies fondamentales alimentant cette révolution semble avoir enfin rattrapé — et plus encore, elle fixe maintenant le rythme que les concurrents doivent égaler.

Dans la vidéo ci-dessous, enregistrée juste après Next, l'expert en IA Sam Witteveen et moi décomposons le paysage actuel et les tendances émergentes, et pourquoi l'écosystème d'IA de Google semble si fort :

Article connexe

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

Le dernier modèle d'IA Gemini de Google affiche des scores de sécurité en baisse lors des tests

Les tests internes de Google révèlent des baisses de performance inquiétantes dans les protocoles de sécurité de son dernier modèle d'IA par rapport aux versions précédentes. Selon les nouveaux critèr

Le dernier modèle d'IA Gemini de Google affiche des scores de sécurité en baisse lors des tests

Les tests internes de Google révèlent des baisses de performance inquiétantes dans les protocoles de sécurité de son dernier modèle d'IA par rapport aux versions précédentes. Selon les nouveaux critèr

L'IA "ZeroSearch" d'Alibaba réduit les coûts de formation de 88 % grâce à l'apprentissage autonome

ZeroSearch d'Alibaba : Un changement de donne pour l'efficacité de l'apprentissage de l'IALes chercheurs du groupe Alibaba ont mis au point une méthode innovante qui pourrait révolutionner la manière

commentaires (12)

0/200

L'IA "ZeroSearch" d'Alibaba réduit les coûts de formation de 88 % grâce à l'apprentissage autonome

ZeroSearch d'Alibaba : Un changement de donne pour l'efficacité de l'apprentissage de l'IALes chercheurs du groupe Alibaba ont mis au point une méthode innovante qui pourrait révolutionner la manière

commentaires (12)

0/200

![EdwardRamirez]() EdwardRamirez

EdwardRamirez

6 août 2025 07:00:59 UTC+02:00

6 août 2025 07:00:59 UTC+02:00

Google's AI comeback is wild! 😎 I thought they were out of the game, but their enterprise push is sneaky strong. Wonder if they’ll dominate the market soon?

0

0

![ThomasBaker]() ThomasBaker

ThomasBaker

22 juillet 2025 03:25:03 UTC+02:00

22 juillet 2025 03:25:03 UTC+02:00

Google's quiet climb in enterprise AI is wild! 😎 I thought they were out of the game, but this Transformer legacy is no joke. Curious if they’ll outpace Microsoft soon?

0

0

![RalphGarcia]() RalphGarcia

RalphGarcia

22 avril 2025 20:20:20 UTC+02:00

22 avril 2025 20:20:20 UTC+02:00

GoogleのエンタープライズAIへの進出は感動的だね。追いつくことから先頭に立つまで、彼らは本当にゲームを上げた。でもインターフェースはもう少し改善が必要だね;ちょっとぎこちない。でも、これからどこに向かうのか楽しみだよ!🚀

0

0

![FredAnderson]() FredAnderson

FredAnderson

22 avril 2025 17:53:12 UTC+02:00

22 avril 2025 17:53:12 UTC+02:00

Google's move into enterprise AI is impressive. From playing catch-up to leading the pack, they've really stepped up their game. But the interface could use some work; it's a bit clunky. Still, I'm excited to see where they go from here! 🚀

0

0

![JasonRoberts]() JasonRoberts

JasonRoberts

22 avril 2025 09:22:36 UTC+02:00

22 avril 2025 09:22:36 UTC+02:00

El movimiento sigiloso de Google en la IA empresarial es bastante genial. De ir a la zaga a liderar el grupo, realmente han dado la vuelta a la situación. La tecnología es sólida pero la interfaz podría ser más amigable para el usuario. Aún así, es impresionante lo rápido que se han movido! 🚀

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

22 avril 2025 08:10:16 UTC+02:00

22 avril 2025 08:10:16 UTC+02:00

A jogada furtiva do Google no AI empresarial é bem legal. De tentar alcançar a liderar o grupo, eles realmente mudaram as coisas. A tecnologia é sólida, mas a interface poderia ser mais amigável ao usuário. Ainda assim, é impressionante como eles se moveram rápido! 🚀

0

0

Il y a tout juste un an, l'engouement autour de Google et de l'IA pour les entreprises semblait au point mort. Malgré des technologies pionnières comme le Transformer, le géant de la technologie semblait à la traîne, éclipsé par le succès viral d'OpenAI, la prouesse en codage d'Anthropic et la poussée agressive de Microsoft sur le marché des entreprises.

Mais la semaine dernière, lors de Google Cloud Next 2025 à Las Vegas, la situation était nettement différente. Un Google confiant, armé de modèles performants, d'une infrastructure robuste et d'une stratégie claire pour les entreprises, a annoncé un revirement spectaculaire. Lors d'une réunion à huis clos avec des analystes et des cadres supérieurs de Google, un analyste a résumé l'ambiance : « On dirait le moment où Google est passé de 'rattraper' à 'rattrapez-nous'. »

Le bond en avant de Google

Ce sentiment — que Google a non seulement rattrapé mais dépassé OpenAI et Microsoft dans la course à l'IA pour les entreprises — était palpable tout au long de l'événement. Et ce n'est pas seulement du battage médiatique. Au cours de l'année écoulée, Google s'est concentré intensément sur l'exécution, transformant sa prouesse technologique en une plateforme intégrée et performante qui séduit rapidement les décideurs d'entreprise. Des modèles d'IA les plus puissants au monde fonctionnant sur un silicium personnalisé hautement efficace à un écosystème croissant d'agents d'IA adaptés aux défis commerciaux du monde réel, Google fait valoir qu'il n'a jamais vraiment été perdu, mais qu'il traversait une période de développement profond et fondamental.

Avec sa pile intégrée fonctionnant désormais à pleine capacité, Google semble prêt à mener la prochaine phase de la révolution de l'IA pour les entreprises. Lors de mes entretiens avec des cadres de Google à Next, ils ont souligné les avantages uniques de Google en matière d'infrastructure et d'intégration de modèles — des avantages que des concurrents comme OpenAI, Microsoft ou AWS auraient du mal à reproduire.

L'ombre du doute : reconnaître le passé récent

Pour apprécier pleinement l'élan actuel de Google, il est essentiel de reconnaître le passé récent. Google a inventé l'architecture Transformer, déclenchant la révolution moderne des grands modèles de langage (LLM), et a commencé à investir dans du matériel d'IA spécialisé (TPU) il y a une décennie, ce qui assure aujourd'hui une efficacité de pointe dans l'industrie. Pourtant, inexplicablement, il y a deux ans et demi, Google s'est retrouvé sur la défensive.

ChatGPT d'OpenAI a captivé l'imagination du public et l'intérêt des entreprises à un rythme époustouflant, devenant l'application à la croissance la plus rapide de l'histoire. Des concurrents comme Anthropic se sont taillé des niches dans des domaines comme le codage. Pendant ce temps, les mouvements publics de Google semblaient souvent hésitants ou imparfaits. Les déboires notoires de la démo de Bard en 2023 et la controverse autour de son générateur d'images produisant des représentations historiquement inexactes ont alimenté une narrative d'une entreprise potentiellement entravée par une bureaucratie interne ou une surcorrection sur l'alignement. Google semblait perdu, rappelant sa lenteur initiale dans la compétition du cloud où il restait un lointain troisième en part de marché derrière Amazon et Microsoft.

Le pivot : une décision consciente de mener

En coulisses, cependant, un changement significatif se produisait, motivé par une décision délibérée au plus haut niveau de reprendre le leadership. Mat Velloso, vice-président produit de la plateforme de développement IA de Google DeepMind, a senti ce moment charnière en rejoignant Google en février 2024, après avoir quitté Microsoft. « Quand je suis arrivé chez Google, j'ai parlé avec Sundar [Pichai], j'ai parlé avec plusieurs leaders ici, et j'ai senti que c'était le moment où ils décidaient, d'accord, cette [IA générative] est quelque chose qui intéresse clairement l'industrie. Faisons en sorte que ça arrive », a partagé Velloso lors d'une interview à Next la semaine dernière.

Cette nouvelle impulsion n'a pas été entravée par la redoutée « fuite des cerveaux » que certains croyaient affaiblir Google. Au contraire, l'entreprise a redoublé d'efforts sur l'exécution début 2024, marquée par un recrutement agressif, une unification interne et une traction auprès des clients. Alors que les concurrents faisaient des embauches spectaculaires, Google a conservé son leadership en IA, y compris le PDG de DeepMind, Demis Hassabis, et le PDG de Google Cloud, Thomas Kurian, offrant stabilité et expertise approfondie.

De plus, les talents ont commencé à affluer vers la mission ciblée de Google. Logan Kilpatrick, par exemple, est revenu chez Google après OpenAI, attiré par l'opportunité de construire une IA fondamentale au sein de l'entreprise. Il a rejoint Velloso dans ce qu'il a décrit comme une « expérience de zéro à un », chargé de développer la traction des développeurs pour Gemini depuis le début. « C'était comme si l'équipe, c'était moi le premier jour... nous n'avions aucun utilisateur sur cette plateforme, aucun revenu. Personne ne s'intéressait à Gemini à ce moment-là », se souvient Kilpatrick du point de départ. Des leaders comme Josh Woodward, qui a contribué à lancer AI Studio et dirige maintenant l'application Gemini et Labs, et Noam Shazeer, co-auteur clé du papier original « Attention Is All You Need » sur le Transformer, sont également revenus dans l'entreprise fin 2024 en tant que co-responsable technique du projet crucial Gemini.

Pilier 1 : Gemini 2.5 et l'ère des modèles pensants

Bien que le mantra des entreprises soit passé à « il ne s'agit pas seulement du modèle », avoir le LLM le plus performant reste une réalisation significative et un puissant validateur de la recherche supérieure et de l'architecture technologique efficace d'une entreprise. Avec la sortie de Gemini 2.5 Pro juste quelques semaines avant Next '25, Google a revendiqué ce titre de manière décisive. Il a rapidement dominé le classement indépendant de Chatbot Arena, surpassant largement même la dernière variante GPT-4o d'OpenAI, et a excellé dans des benchmarks de raisonnement notoirement difficiles comme l'Examen Final de l'Humanité. Comme l'a déclaré Pichai dans son discours d'ouverture, « C'est notre modèle d'IA le plus intelligent à ce jour. Et c'est le meilleur modèle au monde. » Le modèle a entraîné une augmentation de 80 % de l'utilisation de Gemini en un mois, a-t-il tweeté séparément.

Pour la première fois, la demande pour Gemini était en feu. Ce qui m'a impressionné, outre l'intelligence brute de Gemini 2.5 Pro, était sa capacité de raisonnement démontrable. Google a conçu une capacité de « pensée », permettant au modèle d'effectuer un raisonnement en plusieurs étapes, une planification, et même une autoréflexion avant de finaliser une réponse. La chaîne de pensée (CoT) structurée et cohérente – utilisant des étapes numérotées et des sous-puces – évite la nature décousue ou opaque des sorties d'autres modèles de DeepSeek ou OpenAI. Pour les équipes techniques évaluant les sorties pour des tâches critiques, cette transparence permet une validation, une correction et une redirection avec une confiance sans précédent.

Mais plus important encore pour les utilisateurs professionnels, Gemini 2.5 Pro a également réduit considérablement l'écart dans le codage, qui est l'un des domaines d'application les plus importants pour l'IA générative. Dans une interview avec VentureBeat, la CTO Fiona Tan du grand détaillant Wayfair a déclaré qu'après des tests initiaux, l'entreprise a trouvé qu'il « s'était beaucoup amélioré » et était maintenant « assez comparable » à Claude 3.7 Sonnet d'Anthropic, auparavant le choix préféré de nombreux développeurs.

Google a également ajouté une fenêtre de contexte massive d'un million de tokens au modèle, permettant un raisonnement sur des bases de code entières ou une documentation longue, dépassant de loin les capacités des modèles d'OpenAI ou d'Anthropic. (OpenAI a répondu cette semaine avec des modèles présentant des fenêtres de contexte similaires, bien que les benchmarks suggèrent que Gemini 2.5 Pro conserve un avantage dans le raisonnement global). Cet avantage permet des tâches complexes d'ingénierie logicielle multi-fichiers.

En complément de Pro, Gemini 2.5 Flash, annoncé à Next '25 et sorti hier, est également un modèle « pensant », optimisé pour une faible latence et une efficacité de coût. Vous pouvez contrôler combien le modèle raisonne et équilibrer les performances avec votre budget. Cette approche hiérarchisée reflète davantage la stratégie d'« intelligence par dollar » défendue par les cadres de Google.

Velloso a montré un graphique révélant que, sur tout le spectre de l'intelligence, les modèles de Google offrent le meilleur rapport qualité-prix. « Si nous avions eu cette conversation il y a un an... je n'aurais rien eu à montrer », a admis Velloso, soulignant le revirement rapide. « Et maintenant, partout, si vous cherchez n'importe quel modèle, n'importe quelle taille, si vous n'êtes pas Google, vous perdez de l'argent. » Des graphiques similaires ont été mis à jour pour prendre en compte les dernières sorties de modèles d'OpenAI cette semaine, tous montrant la même chose : les modèles de Google offrent la meilleure intelligence par dollar. Voir ci-dessous :

Tan de Wayfair a également observé des améliorations prometteuses en matière de latence avec 2.5 Pro : « Gemini 2.5 est revenu plus rapidement », ce qui le rend viable pour « des capacités plus orientées vers les clients », a-t-elle dit, quelque chose qui n'était pas le cas auparavant avec d'autres modèles. Gemini pourrait devenir le premier modèle que Wayfair utilise pour ces interactions avec les clients, a-t-elle ajouté.

Les capacités de la famille Gemini s'étendent à la multimodalité, s'intégrant parfaitement aux autres modèles de pointe de Google comme Imagen 3 (génération d'images), Veo 2 (génération de vidéos), Chirp 3 (audio), et le nouvellement annoncé Lyria (texte-à-musique), tous accessibles via la plateforme de Google pour les utilisateurs professionnels, Vertex. Google est la seule entreprise à offrir ses propres modèles de médias génératifs sur toutes les modalités sur sa plateforme. Microsoft, AWS et OpenAI doivent s'associer à d'autres entreprises pour le faire.

Pilier 2 : La prouesse de l'infrastructure – Le moteur sous le capot

La capacité à itérer rapidement et à servir efficacement ces modèles puissants découle de l'infrastructure sans doute inégalée de Google, affinée pendant des décennies pour gérer des services à l'échelle planétaire. Au cœur de cela se trouve l'unité de traitement Tensor (TPU).

Lors de Next '25, Google a dévoilé Ironwood, sa septième génération de TPU, explicitement conçue pour les besoins de l'inférence et des « modèles pensants ». L'échelle est immense, adaptée aux charges de travail d'IA exigeantes : les pods Ironwood contiennent plus de 9 000 puces refroidies par liquide, offrant une puissance de calcul revendiquée de 42,5 exaflops. Le vice-président des systèmes ML de Google, Amin Vahdat, a déclaré sur scène à Next que cela représente « plus de 24 fois » la puissance de calcul du superordinateur numéro 1 mondial actuel.

Google a indiqué qu'Ironwood offre une performance par watt 2 fois supérieure à celle de Trillium, la génération précédente de TPU. Cela est significatif car les clients professionnels indiquent de plus en plus que les coûts énergétiques et la disponibilité limitent les déploiements d'IA à grande échelle.

Le CTO de Google Cloud, Will Grannis, a souligné la constance de ces progrès. Année après année, Google réalise des améliorations de 10x, 8x, 9x, 10x sur ses processeurs, a-t-il déclaré à VentureBeat dans une interview, créant ce qu'il a appelé une « loi de Moore hyper » pour les accélérateurs d'IA. Il a dit que les clients achètent la feuille de route de Google, pas seulement sa technologie.

La position de Google a alimenté cet investissement soutenu dans les TPU. Elle doit alimenter efficacement des services massifs comme Search, YouTube et Gmail pour plus de 2 milliards d'utilisateurs. Cela a nécessité le développement d'un matériel personnalisé et optimisé bien avant l'actuel boom de l'IA générative. Bien que Meta opère à une échelle similaire pour les consommateurs, les autres concurrents manquaient de ce moteur interne spécifique pour un développement matériel d'IA intégré verticalement sur une décennie.

Maintenant, ces investissements dans les TPU portent leurs fruits car ils permettent une efficacité non seulement pour ses propres applications, mais aussi de permettre à Google d'offrir Gemini à d'autres utilisateurs avec une meilleure intelligence par dollar, toutes choses étant égales par ailleurs.

Pourquoi les concurrents de Google ne peuvent-ils pas acheter des processeurs efficaces auprès de Nvidia, demandez-vous ? Il est vrai que les processeurs GPU de Nvidia dominent le pré-entraînement des LLM. Mais la demande du marché a fait grimper le prix de ces GPU, et Nvidia prend une part importante pour son propre profit. Cela transfère des coûts significatifs aux utilisateurs de ses puces. Et aussi, bien que le pré-entraînement ait dominé l'utilisation des puces d'IA jusqu'à présent, cela change maintenant que les entreprises déploient réellement ces applications. C'est là que l'« inférence » entre en jeu, et ici les TPU sont considérés comme plus efficaces que les GPU pour les charges de travail à grande échelle.

Lorsque vous demandez aux cadres de Google d'où vient leur principal avantage technologique en IA, ils reviennent généralement aux TPU comme étant le plus important. Mark Lohmeyer, le vice-président qui gère l'infrastructure informatique de Google, était sans équivoque : les TPU sont « certainement une partie hautement différenciée de ce que nous faisons... OpenAI, ils n'ont pas ces capacités ».

De manière significative, Google présente les TPU non pas isolément, mais comme faisant partie d'une architecture d'IA pour les entreprises plus large et plus complexe. Pour les initiés techniques, il est entendu que les performances de haut niveau dépendent de l'intégration de percées technologiques de plus en plus spécialisées. De nombreuses mises à jour ont été détaillées à Next. Vahdat a décrit cela comme un « système de superinformatique », intégrant le matériel (TPU, les derniers GPU Nvidia comme Blackwell et le prochain Vera Rubin, le stockage avancé comme Hyperdisk Exapools, Anywhere Cache, et Rapid Storage) avec une pile logicielle unifiée. Ce logiciel inclut Cluster Director pour gérer les accélérateurs, Pathways (le runtime distribué de Gemini, maintenant disponible pour les clients), et apporte des optimisations comme vLLM aux TPU, permettant une migration plus facile des charges de travail pour ceux précédemment sur les piles Nvidia/PyTorch. Ce système intégré, a soutenu Vahdat, est pourquoi Gemini 2.0 Flash atteint une intelligence par dollar 24 fois supérieure, comparée à GPT-4o.

Google étend également la portée de son infrastructure physique. Cloud WAN rend le réseau de fibre privé à faible latence de 2 millions de miles de Google accessible aux entreprises, promettant des performances jusqu'à 40 % plus rapides et un coût total de possession (TCO) inférieur de 40 % par rapport aux réseaux gérés par les clients.

De plus, Google Distributed Cloud (GDC) permet à Gemini et au matériel Nvidia (via un partenariat avec Dell) de fonctionner dans des environnements souverains, sur site, ou même isolés – une capacité que le PDG de Nvidia, Jensen Huang, a qualifiée d'« absolument gigantesque » pour apporter une IA de pointe aux industries réglementées et aux nations. À Next, Huang a qualifié l'infrastructure de Google de meilleure au monde : « Aucune entreprise n'est meilleure à chaque couche de calcul que Google et Google Cloud », a-t-il dit.

Pilier 3 : La pile intégrée complète – Connecter les points

L'avantage stratégique de Google croît lorsqu'on considère comment ces modèles et composants d'infrastructure sont tissés dans une plateforme cohérente. Contrairement aux concurrents, qui s'appuient souvent sur des partenariats pour combler les lacunes, Google contrôle presque toutes les couches, permettant une intégration plus étroite et des cycles d'innovation plus rapides.

Alors, pourquoi cette intégration est-elle importante, si un concurrent comme Microsoft peut simplement s'associer à OpenAI pour égaler l'étendue de l'infrastructure avec la prouesse des modèles LLM ? Les Googlers avec qui j'ai parlé ont dit que cela fait une énorme différence, et ils ont fourni des anecdotes pour le soutenir.

Prenez l'amélioration significative de la base de données d'entreprise de Google, BigQuery. La base de données offre maintenant un graphe de connaissances qui permet aux LLM de rechercher des données beaucoup plus efficacement, et elle compte désormais plus de cinq fois plus de clients que des concurrents comme Snowflake et Databricks. Yasmeen Ahmad, responsable des produits pour l'analyse de données chez Google Cloud, a déclaré que ces vastes améliorations n'étaient possibles que parce que les équipes de données de Google travaillaient en étroite collaboration avec l'équipe de DeepMind. Ils ont travaillé sur des cas d'utilisation difficiles à résoudre, ce qui a conduit la base de données à fournir 50 % de précision en plus sur les requêtes courantes, au moins selon les tests internes de Google, pour atteindre les bonnes données par rapport aux concurrents les plus proches, a déclaré Ahmad à VentureBeat dans une interview. Ahmad a dit que ce type d'intégration profonde à travers la pile est la façon dont Google a « surpassé » l'industrie.

Cette cohésion interne contraste fortement avec la dynamique de « frenemies » chez Microsoft. Alors que Microsoft s'associe à OpenAI pour distribuer ses modèles sur le cloud Azure, Microsoft construit également ses propres modèles. Mat Velloso, le cadre de Google qui dirige maintenant le programme de développement IA, a quitté Microsoft après s'être frustré en essayant d'aligner les plans de Windows Copilot avec les offres de modèles d'OpenAI. « Comment partagez-vous vos plans de produits avec une autre entreprise qui est en réalité en compétition avec vous... Tout cela est une contradiction », se souvient-il. « Ici, je suis assis côte à côte avec les gens qui construisent les modèles. »

Cette intégration reflète ce que les leaders de Google considèrent comme leur avantage principal : leur capacité unique à connecter une expertise profonde à travers tout le spectre, de la recherche fondamentale et de la construction de modèles à un déploiement d'applications à « échelle planétaire » et à la conception d'infrastructure.

Vertex AI sert de système nerveux central pour les efforts d'IA pour les entreprises de Google. Et l'intégration va au-delà des propres offres de Google. Le Model Garden de Vertex propose plus de 200 modèles sélectionnés, y compris ceux de Google, Llama 4 de Meta, et de nombreuses options open-source. Vertex fournit des outils pour le réglage, l'évaluation (y compris les évaluations alimentées par l'IA, que Grannis a soulignées comme un accélérateur clé), le déploiement et la surveillance. Ses capacités d'ancrage exploitent les bases de données prêtes pour l'IA internes tout en étant compatibles avec les bases de données vectorielles externes. Ajoutez à cela les nouvelles offres de Google pour ancrer les modèles avec Google Search, le meilleur moteur de recherche au monde.

L'intégration s'étend à Google Workspace. De nouvelles fonctionnalités annoncées à Next '25, comme « Aidez-moi à analyser » dans Sheets (oui, Sheets a maintenant une formule « =AI »), les Aperçus Audio dans Docs et les Flux de Workspace, intègrent davantage les capacités de Gemini dans les flux de travail quotidiens, créant une boucle de rétroaction puissante pour Google afin d'améliorer l'expérience.

Tout en pilotant sa pile intégrée, Google promeut également l'ouverture là où cela sert l'écosystème. Après avoir poussé l'adoption de Kubernetes, il promeut maintenant JAX pour les cadres d'IA et maintenant des protocoles ouverts pour la communication des agents (A2A) ainsi que le soutien aux normes existantes (MCP). Google propose également des centaines de connecteurs vers des plateformes externes depuis Agentspace, qui est la nouvelle interface unifiée de Google pour les employés afin de trouver et d'utiliser des agents. Ce concept de hub est convaincant. La démonstration d'Agentspace dans le discours d'ouverture (à partir de 51:40) l'illustre. Google offre aux utilisateurs des agents préconstruits, ou les employés ou développeurs peuvent construire les leurs en utilisant des capacités d'IA sans code. Ou ils peuvent intégrer des agents de l'extérieur via des connecteurs A2A. Il s'intègre dans le navigateur Chrome pour un accès fluide.

Pilier 4 : Focus sur la valeur pour les entreprises et l'écosystème des agents

Le changement le plus significatif est peut-être l'accent mis par Google sur la résolution de problèmes concrets pour les entreprises, en particulier à travers le prisme des agents d'IA. Thomas Kurian, PDG de Google Cloud, a souligné trois raisons pour lesquelles les clients choisissent Google : la plateforme optimisée pour l'IA, l'approche multi-cloud ouverte permettant la connexion aux TI existantes, et l'accent sur la sécurité, la souveraineté et la conformité prêtes pour les entreprises.

Les agents sont au cœur de cette stratégie. Outre AgentSpace, cela inclut :

- Blocs de construction : Le kit de développement d'agents open-source (ADK), annoncé à Next, a déjà suscité un intérêt significatif de la part des développeurs. L'ADK simplifie la création de systèmes multi-agents, tandis que le protocole proposé Agent2Agent (A2A) vise à assurer l'interopérabilité, permettant aux agents construits avec différents outils (Gemini ADK, LangGraph, CrewAI, etc.) de collaborer. Grannis de Google a déclaré que A2A anticipe les défis d'échelle et de sécurité d'un avenir avec potentiellement des centaines de milliers d'agents interagissant.

- Agents spécialisés : Google a présenté des agents experts intégrés à Agentspace (comme NotebookLM, Génération d'Idées, Recherche Approfondie) et a mis en avant cinq catégories clés gagnant du terrain : les Agents Clients (alimentant des outils comme Reddit Answers, l'assistant de support de Verizon, le drive-thru de Wendy’s), les Agents Créatifs (utilisés par WPP, Brandtech, Sphere), les Agents de Données (fournissant des insights chez Mattel, Spotify, Bayer), les Agents de Codage (Gemini Code Assist), et les Agents de Sécurité (intégrés dans la nouvelle plateforme de Sécurité Unifiée de Google).

Cette stratégie d'agents complète semble trouver un écho. Les conversations avec les cadres de trois autres grandes entreprises cette semaine passée, parlant également de manière anonyme en raison de sensibilités concurrentielles, ont fait écho à cet enthousiasme pour la stratégie d'agents de Google. Le COO de Google Cloud, Francis DeSouza, a confirmé dans une interview : « Chaque conversation inclut l'IA. Plus précisément, chaque conversation inclut les agents. »

Kevin Laughridge, un cadre chez Deloitte, un grand utilisateur des produits d'IA de Google et un distributeur de ceux-ci à d'autres entreprises, a décrit le marché des agents comme une « ruée vers la terre » où les premiers mouvements de Google avec des protocoles et sa plateforme intégrée offrent des avantages significatifs. « Celui qui sort en premier et obtient le plus d'agents qui apportent réellement de la valeur – c'est celui qui va gagner dans cette course », a déclaré Laughridge dans une interview. Il a dit que les progrès de Google étaient « étonnants », notant que les agents personnalisés que Deloitte a construits il y a tout juste un an pourraient maintenant être reproduits « directement » en utilisant Agentspace. Deloitte elle-même construit 100 agents sur la plateforme, ciblant les fonctions de bureau intermédiaires comme la finance, le risque et l'ingénierie, a-t-il dit.

Les preuves de traction client s'accumulent. À Next, Google a cité « plus de 500 clients en production » avec l'IA générative, contre seulement « des dizaines de prototypes » il y a un an. Si Microsoft était perçu comme largement en avance il y a un an, cela ne semble plus aussi évident. Étant donné la guerre de relations publiques de tous les côtés, il est difficile de dire qui gagne vraiment de manière définitive pour le moment. Les métriques varient. Le chiffre de 500 de Google n'est pas directement comparable aux 400 études de cas que Microsoft promeut (et Microsoft, en réponse, a déclaré à VentureBeat au moment de la presse qu'il prévoit de mettre à jour ce décompte public à 600 sous peu, soulignant le marketing intense). Et si la distribution de l'IA de Google à travers ses applications est significative, la distribution de Copilot de Microsoft à travers son offre 365 est tout aussi impressionnante. Les deux touchent maintenant des millions de développeurs via des API.

Mais les exemples de la traction de Google abondent :

- Wendy’s : A déployé un système de drive-thru IA dans des milliers d'emplacements en seulement un an, améliorant l'expérience des employés et la précision des commandes. Le CTO de Google Cloud, Will Grannis, a noté que le système IA est capable de comprendre l'argot et de filtrer le bruit de fond, réduisant considérablement le stress des interactions avec les clients en direct. Cela libère le personnel pour se concentrer sur la préparation et la qualité des aliments — un changement que Grannis a appelé « un excellent exemple de l'IA rationalisant les opérations du monde réel ».

- Salesforce : A annoncé une expansion majeure, permettant à sa plateforme de fonctionner sur Google Cloud pour la première fois (au-delà d'AWS), citant la capacité de Google à les aider à « innover et optimiser ».

- Honeywell & Intuit : Des entreprises précédemment fortement associées à Microsoft et AWS, respectivement, collaborent maintenant avec Google Cloud sur des initiatives d'IA.

- Grandes banques (Deutsche Bank, Wells Fargo) : Utilisent des agents et Gemini pour la recherche, l'analyse et la modernisation du service client.

- Détaillants (Walmart, Mercado Libre, Lowe’s) : Utilisent la recherche, les agents et les plateformes de données.

Cette traction auprès des entreprises alimente la croissance globale de Google Cloud, qui a dépassé AWS et Azure au cours des trois derniers trimestres. Google Cloud a atteint un taux annualisé de 44 milliards de dollars en 2024, contre seulement 5 milliards en 2018.

Naviguer dans les eaux concurrentielles

L'ascension de Google ne signifie pas que les concurrents restent immobiles. Les sorties rapides d'OpenAI cette semaine de GPT-4.1 (axé sur le codage et le contexte long) et de la série o (raisonnement multimodal, utilisation d'outils) démontrent l'innovation continue d'OpenAI. De plus, la mise à jour de la fonctionnalité de génération d'images dans GPT-4o a alimenté une croissance massive au cours du dernier mois, aidant ChatGPT à atteindre 800 millions d'utilisateurs. Microsoft continue de tirer parti de son vaste empreinte d'entreprise et de son partenariat avec OpenAI, tandis qu'Anthropic reste un concurrent sérieux, en particulier dans les applications axées sur le codage et la sécurité.

Cependant, il est incontestable que la narrative de Google s'est remarquablement améliorée. Il y a tout juste un an, Google était perçu comme un concurrent lourd, hésitant, maladroit, qui risquait peut-être de rater sa chance de mener l'IA. Au lieu de cela, sa pile intégrée unique et sa constance d'entreprise ont révélé autre chose : Google possède des capacités de classe mondiale à travers tout le spectre – de la conception de puces (TPU) et de l'infrastructure mondiale à la recherche sur les modèles fondamentaux (DeepMind), le développement d'applications (Workspace, Search, YouTube) et les services cloud pour les entreprises (Vertex AI, BigQuery, Agentspace). « Nous sommes le seul hyperscaler qui participe à la conversation sur les modèles fondamentaux », a déclaré deSouza sans détour. Cette propriété de bout en bout permet des optimisations (comme « l'intelligence par dollar ») et une profondeur d'intégration que les modèles dépendant des partenariats ont du mal à égaler. Les concurrents doivent souvent assembler des pièces disparates, ce qui peut créer des frictions ou limiter la vitesse d'innovation.

Le moment de Google est maintenant

Bien que la course à l'IA reste dynamique, Google a assemblé toutes ces pièces au moment précis où le marché les exige. Comme l'a dit Laughridge de Deloitte, Google a atteint un point où ses capacités se sont parfaitement alignées « là où le marché le demandait ». Si vous attendiez que Google fasse ses preuves dans l'IA pour les entreprises, vous avez peut-être manqué le moment — il l'a déjà fait. L'entreprise qui a inventé de nombreuses technologies fondamentales alimentant cette révolution semble avoir enfin rattrapé — et plus encore, elle fixe maintenant le rythme que les concurrents doivent égaler.

Dans la vidéo ci-dessous, enregistrée juste après Next, l'expert en IA Sam Witteveen et moi décomposons le paysage actuel et les tendances émergentes, et pourquoi l'écosystème d'IA de Google semble si fort :

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

L'IA "ZeroSearch" d'Alibaba réduit les coûts de formation de 88 % grâce à l'apprentissage autonome

ZeroSearch d'Alibaba : Un changement de donne pour l'efficacité de l'apprentissage de l'IALes chercheurs du groupe Alibaba ont mis au point une méthode innovante qui pourrait révolutionner la manière

L'IA "ZeroSearch" d'Alibaba réduit les coûts de formation de 88 % grâce à l'apprentissage autonome

ZeroSearch d'Alibaba : Un changement de donne pour l'efficacité de l'apprentissage de l'IALes chercheurs du groupe Alibaba ont mis au point une méthode innovante qui pourrait révolutionner la manière

6 août 2025 07:00:59 UTC+02:00

6 août 2025 07:00:59 UTC+02:00

Google's AI comeback is wild! 😎 I thought they were out of the game, but their enterprise push is sneaky strong. Wonder if they’ll dominate the market soon?

0

0

22 juillet 2025 03:25:03 UTC+02:00

22 juillet 2025 03:25:03 UTC+02:00

Google's quiet climb in enterprise AI is wild! 😎 I thought they were out of the game, but this Transformer legacy is no joke. Curious if they’ll outpace Microsoft soon?

0

0

22 avril 2025 20:20:20 UTC+02:00

22 avril 2025 20:20:20 UTC+02:00

GoogleのエンタープライズAIへの進出は感動的だね。追いつくことから先頭に立つまで、彼らは本当にゲームを上げた。でもインターフェースはもう少し改善が必要だね;ちょっとぎこちない。でも、これからどこに向かうのか楽しみだよ!🚀

0

0

22 avril 2025 17:53:12 UTC+02:00

22 avril 2025 17:53:12 UTC+02:00

Google's move into enterprise AI is impressive. From playing catch-up to leading the pack, they've really stepped up their game. But the interface could use some work; it's a bit clunky. Still, I'm excited to see where they go from here! 🚀

0

0

22 avril 2025 09:22:36 UTC+02:00

22 avril 2025 09:22:36 UTC+02:00

El movimiento sigiloso de Google en la IA empresarial es bastante genial. De ir a la zaga a liderar el grupo, realmente han dado la vuelta a la situación. La tecnología es sólida pero la interfaz podría ser más amigable para el usuario. Aún así, es impresionante lo rápido que se han movido! 🚀

0

0

22 avril 2025 08:10:16 UTC+02:00

22 avril 2025 08:10:16 UTC+02:00

A jogada furtiva do Google no AI empresarial é bem legal. De tentar alcançar a liderar o grupo, eles realmente mudaram as coisas. A tecnologia é sólida, mas a interface poderia ser mais amigável ao usuário. Ainda assim, é impressionante como eles se moveram rápido! 🚀

0

0