Google은 Enterprise AI의 은밀하게 능가합니다.

불과 1년 전만 해도 구글과 기업용 AI에 대한 관심은 정체된 것처럼 보였습니다. 트랜스포머와 같은 선구적인 기술에도 불구하고, 이 기술 대기업은 OpenAI의 폭발적인 성공, Anthropic의 코딩 실력, 그리고 마이크로소프트의 공격적인 기업 시장 진출에 가려져 뒤처지는 것처럼 보였습니다.

하지만 2025년 라스베이거스에서 열린 Google Cloud Next 2025로 시간을 빠르게 돌려보면, 분위기는 확연히 달라졌습니다. 최고 성능의 모델, 견고한 인프라, 그리고 명확한 기업 전략으로 무장한 자신감 넘치는 구글은 극적인 반전을 발표했습니다. 구글 고위 임원들과의 비공개 애널리스트 회의에서 한 애널리스트는 그 분위기를 이렇게 요약했습니다: "이건 구글이 '따라잡기'에서 '우리를 따라잡아'로 바뀐 순간처럼 느껴집니다."

구글의 도약

구글이 기업용 AI 경쟁에서 OpenAI와 마이크로소프트를 따라잡았을 뿐만 아니라 앞서 나가고 있다는 감정은 행사 전반에 걸쳐 뚜렷이 나타났습니다. 그리고 이는 단순한 마케팅 과장이 아닙니다. 지난 1년 동안 구글은 실행에 강하게 집중하며, 기술적 역량을 고성능의 통합 플랫폼으로 전환하여 기업 의사결정자들을 빠르게 사로잡고 있습니다. 세계에서 가장 강력한 AI 모델이 고효율 맞춤형 실리콘에서 실행되는 것부터, 실세계 비즈니스 과제를 위해 맞춤화된 AI 에이전트의 성장하는 생태계에 이르기까지, 구글은 결코 길을 잃은 것이 아니라 깊고 기초적인 개발 기간을 거쳤다는 강력한 주장을 펼치고 있습니다.

이제 통합 스택이 완전한 가동 상태에 접어들며, 구글은 기업용 AI 혁명의 다음 단계를 이끌 준비가 된 것처럼 보입니다. Next에서 구글 임원들과의 인터뷰에서 그들은 구글의 인프라와 모델 통합에서의 독특한 강점을 강조했으며, 이는 OpenAI, 마이크로소프트, 또는 AWS와 같은 경쟁자들이 따라 하기 어려운 장점입니다.

의심의 그림자: 최근 과거 인정하기

구글의 현재 기세를 완전히 이해하려면 최근 과거를 인정하는 것이 중요합니다. 구글은 트랜스포머 아키텍처를 발명하여 대형 언어 모델(LLM)의 현대 혁명을 촉발했으며, 10년 전부터 특화된 AI 하드웨어(TPU)에 투자하기 시작해 현재 업계 최고의 효율성을 이끌어내고 있습니다. 하지만 이해할 수 없게도, 불과 2년 반 전, 구글은 방어적인 입장에 처해 있었습니다.

OpenAI의 ChatGPT는 숨 가쁜 속도로 대중의 상상력과 기업의 관심을 사로잡으며 역사상 가장 빠르게 성장한 앱이 되었습니다. Anthropic과 같은 경쟁자들은 코딩과 같은 틈새 시장을 개척했습니다. 반면, 구글의 공개적인 움직임은 종종 조심스럽거나 결함이 있는 것처럼 보였습니다. 2023년의 악명 높은 Bard 데모 실수와 이미지 생성기가 역사적으로 부정확한 묘사를 생성했다는 논란은 내부 관료주의나 과도한 정렬 수정으로 인해 방해를 받고 있는 회사라는 내러티브를 부추겼습니다. 구글은 길을 잃은 것처럼 보였으며, 아마존과 마이크로소프트에 이어 시장 점유율에서 3위에 머물렀던 클라우드 경쟁에서의 초기 느림보를 떠올리게 했습니다.

전환: 리더십을 되찾기 위한 의식적인 결정

그러나 무대 뒤에서는 최고 경영진 수준에서의 의식적인 결정으로 큰 변화가 일어나고 있었습니다. Google DeepMind의 AI 개발자 플랫폼 제품 부사장인 Mat Velloso는 2024년 2월 마이크로소프트를 떠나 구글에 합류했을 때 이 결정적인 순간을 감지했습니다. "구글에 왔을 때, 저는 Sundar [Pichai]와 여러 리더들과 이야기했고, 그들이 '생성 AI가 업계가 분명히 중요하게 여기는 것'이라고 결정하는 순간을 느꼈습니다. 해내자고 했죠," Velloso는 지난주 Next에서 인터뷰 중에 공유했습니다.

이 새로운 추진력은 일부 외부인들이 믿었던 "인재 유출"로 인해 방해받지 않았습니다. 대신, 구글은 2024년 초에 공격적인 채용, 내부 통합, 그리고 고객 확보로 표시되는 실행에 집중했습니다. 경쟁자들이 화려한 채용을 진행하는 동안, 구글은 DeepMind CEO Demis Hassabis와 Google Cloud CEO Thomas Kurian을 포함한 핵심 AI 리더십을 유지하며 안정성과 깊은 전문성을 제공했습니다.

게다가, 인재는 구글의 집중된 사명을 향해 흐르기 시작했습니다. 예를 들어, Logan Kilpatrick은 OpenAI에서 구글로 돌아와 회사 내에서 기초적인 AI를 구축할 기회에 끌렸습니다. 그는 Velloso와 함께 "0에서 1로의 경험"이라 묘사하며, Gemini의 개발자 확보를 처음부터 구축하는 임무를 맡았습니다. "첫날은 저 혼자 팀이었고... 이 플랫폼에는 사용자가 없었고, 수익도 없었습니다. Gemini에 관심 있는 사람은 아무도 없었죠," Kilpatrick은 시작점을 회상했습니다. AI Studio를 시작하고 현재 Gemini 앱과 Labs를 이끄는 Josh Woodward와, 원래 "Attention Is All You Need" 트랜스포머 논문의 핵심 공동 저자인 Noam Shazeer도 2024년 말에 중요한 Gemini 프로젝트의 기술 공동 리더로 회사에 복귀했습니다.

기둥 1: Gemini 2.5와 사고 모델의 시대

기업의 모토가 "모델만 중요한 것이 아니다"로 바뀌었지만, 최고 성능의 LLM을 보유하는 것은 여전히 중요한 성취이며, 회사의 우수한 연구와 효율적인 기술 아키텍처를 강력하게 입증하는 것입니다. Next '25 직전에 출시된 Gemini 2.5 Pro로 구글은 이 타이틀을 확실히 차지했습니다. 이는 독립적인 Chatbot Arena 리더보드에서 빠르게 1위를 차지하며 OpenAI의 최신 GPT-4o 변형을 크게 앞질렀고, Humanity’s Last Exam과 같은 까다로운 추론 벤치마크에서도 뛰어난 성과를 냈습니다. Pichai는 기조연설에서 "이것은 우리의 가장 지능적인 AI 모델입니다. 그리고 세계 최고의 모델입니다"라고 말했습니다. 그는 별도로 트윗에서 이 모델이 한 달 만에 Gemini 사용량을 80% 증가시켰다고 밝혔습니다.

처음으로 Gemini에 대한 수요가 폭발적이었습니다. Gemini 2.5 Pro의 순수한 지능 외에 저를 감동시킨 것은 그 증명 가능한 추론 능력이었습니다. 구글은 모델이 다단계 추론, 계획, 심지어 최종 응답을 결정하기 전에 자기 성찰을 수행할 수 있는 "사고" 기능을 설계했습니다. 번호가 붙은 단계와 하위 목록을 사용한 구조적이고 일관된 사고 체인(CoT)은 DeepSeek이나 OpenAI의 다른 모델에서 나오는 장황하거나 불투명한 출력과는 다릅니다. 중요한 작업을 위해 출력을 평가하는 기술 팀에게 이 투명성은 전례 없는 자신감으로 검증, 수정, 리디렉션을 가능하게 합니다.

하지만 기업 사용자에게 더 중요한 것은 Gemini 2.5 Pro가 생성 AI의 가장 큰 응용 분야 중 하나인 코딩에서 격차를 크게 좁혔다는 점입니다. VentureBeat와의 인터뷰에서 선도적인 소매업체 Wayfair의 CTO Fiona Tan은 초기 테스트 후 이 모델이 "상당히 향상되었다"고 말하며, 이전에 많은 개발자들이 선호했던 Anthropic의 Claude 3.7 Sonnet과 "비교적 비슷하다"고 밝혔습니다.

구글은 또한 이 모델에 100만 토큰의 대규모 컨텍스트 윈도우를 추가하여 전체 코드베이스나 긴 문서를 추론할 수 있게 했으며, 이는 OpenAI나 Anthropic의 모델 능력을 훨씬 초월합니다. (OpenAI는 이번 주에 비슷한 대규모 컨텍스트 윈도우를 갖춘 모델로 대응했지만, 벤치마크는 Gemini 2.5 Pro가 전체 추론에서 여전히 우위를 유지하고 있음을 시사합니다.) 이 장점은 복잡한 다중 파일 소프트웨어 엔지니어링 작업을 가능하게 합니다.

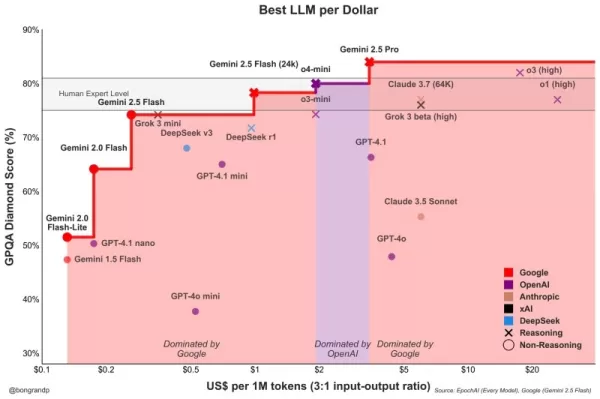

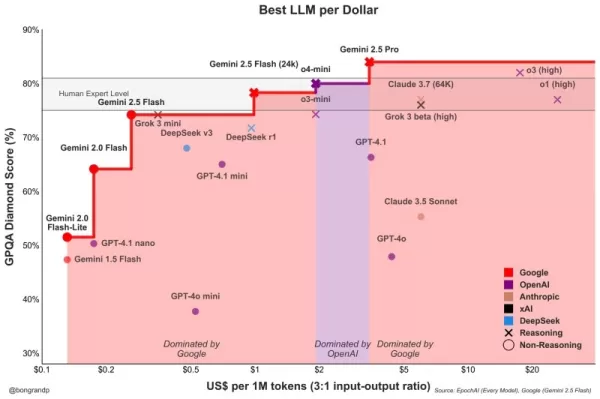

Pro를 보완하는 Gemini 2.5 Flash는 Next '25에서 발표되고 어제 출시되었습니다. 역시 "사고" 모델인 Flash는 낮은 지연 시간과 비용 효율성에 최적화되었습니다. 사용자는 모델의 추론 정도를 제어하고 성능과 예산을 균형 있게 조정할 수 있습니다. 이 계층화된 접근 방식은 구글 임원들이 옹호하는 "달러당 지능" 전략을 더욱 반영합니다.

Velloso는 지능 스펙트럼 전반에 걸쳐 구글 모델이 최고의 가치를 제공한다는 차트를 보여주었습니다. "1년 전이라면... 보여줄 게 없었을 겁니다," Velloso는 빠른 변화를 강조하며 인정했습니다. "이제는 어떤 모델, 어떤 크기든, 구글이 아니면 돈을 잃는 겁니다." OpenAI의 최신 모델 출시를 반영한 유사한 차트도 업데이트되었으며, 모두 같은 결과를 보여줍니다: 구글의 모델이 달러당 최고의 지능을 제공합니다. 아래를 참조하세요:

Wayfair의 Tan은 또한 2.5 Pro의 유망한 지연 시간 개선을 관찰했습니다: "Gemini 2.5는 더 빠르게 응답했습니다,"라며 이는 "고객과 직접 대면하는 기능"에 적합하다고 말했습니다. 이는 이전의 다른 모델들에서는 그렇지 않았다고 그녀는 덧붙였습니다. Gemini는 Wayfair가 이러한 고객 상호작용에 사용할 첫 번째 모델이 될 수 있다고 그녀는 말했습니다.

Gemini 제품군의 기능은 다중 모달로 확장되며, Google의 다른 선도적인 모델인 Imagen 3(이미지 생성), Veo 2(비디오 생성), Chirp 3(오디오), 그리고 새로 발표된 Lyria(텍스트-음악)와 원활하게 통합되며, 모두 Google의 Vertex 플랫폼을 통해 기업 사용자에게 제공됩니다. 구글은 모든 모달리티에 걸쳐 자체 생성 미디어 모델을 플랫폼에서 제공하는 유일한 회사입니다. 마이크로소프트, AWS, OpenAI는 이를 위해 다른 회사들과 파트너십을 맺어야 합니다.

기둥 2: 인프라 역량 – 엔진의 핵심

이러한 강력한 모델을 빠르게 반복하고 효율적으로 제공하는 능력은 구글의 아마도 비교할 수 없는 인프라에서 비롯됩니다. 이는 수십 년간의 행성 규모 서비스 운영을 통해 다듬어졌습니다. 이 중심에는 Tensor Processing Unit(TPU)이 있습니다.

Next '25에서 구글은 추론과 "사고 모델"의 요구에 맞춰 설계된 7세대 TPU인 Ironwood를 공개했습니다. 그 규모는 방대하며, 까다로운 AI 워크로드를 위해 맞춤화되었습니다: Ironwood 포드는 9,000개 이상의 액체 냉각 칩을 포함하며, 42.5 엑사플롭스의 연산 능력을 제공한다고 주장합니다. 구글의 ML 시스템 부사장 Amin Vahdat은 Next 무대에서 이것이 현재 세계 1위 슈퍼컴퓨터의 연산 능력보다 "24배 이상"이라고 말했습니다.

구글은 Ironwood가 이전 세대 TPU인 Trillium 대비 2배의 성능/와트 효율을 제공한다고 밝혔습니다. 이는 기업 고객들이 대규모 AI 배포를 제한하는 에너지 비용과 가용성 문제를 점점 더 언급하고 있기 때문에 중요합니다.

Google Cloud CTO Will Grannis는 이러한 발전의 일관성을 강조했습니다. 매년 구글은 프로세서에서 10배, 8배, 9배, 10배의 개선을 이루며, 그가 VentureBeat와의 인터뷰에서 "하이퍼 무어의 법칙"이라고 부른 것을 만들어냈다고 말했습니다. 그는 고객들이 구글의 기술뿐만 아니라 로드맵을 구매한다고 말했습니다.

구글의 위치는 이러한 지속적인 TPU 투자를 촉진했습니다. 20억 명 이상의 사용자를 위해 Search, YouTube, Gmail과 같은 대규모 서비스를 효율적으로 운영해야 했기 때문에, 현재의 생성 AI 붐이 일어나기 훨씬 전에 맞춤화되고 최적화된 하드웨어를 개발해야 했습니다. Meta는 유사한 소비자 규모로 운영되지만, 다른 경쟁자들은 10년간의 수직 통합 AI 하드웨어 개발을 위한 이러한 내부 동인을 갖추지 못했습니다.

이제 이러한 TPU 투자는 자체 앱뿐만 아니라 다른 사용자들에게 Gemini를 더 나은 달러당 지능으로 제공할 수 있게 함으로써 보답받고 있습니다.

구글의 경쟁자들이 Nvidia에서 효율적인 프로세서를 구매할 수 없는 이유가 궁금하시죠? Nvidia의 GPU 프로세서가 LLM의 사전 학습을 지배하는 것이 사실입니다. 하지만 시장 수요로 인해 GPU 가격이 상승했고, Nvidia는 자체적으로 상당한 이익을 취하고 있습니다. 이는 칩 사용자들에게 상당한 비용을 전가합니다. 또한, 지금까지 AI 칩 사용은 사전 학습이 지배했지만, 기업들이 실제로 이러한 애플리케이션을 배포하면서 이제는 "추론"이 중요해지고 있으며, 여기서 TPU는 대규모 워크로드에서 GPU보다 더 효율적인 것으로 간주됩니다.

구글 임원들에게 그들의 주요 기술 우위가 어디서 오는지 물으면, 그들은 보통 TPU를 가장 중요한 요소로 꼽습니다. 구글의 컴퓨팅 인프라를 운영하는 부사장 Mark Lohmeyer는 단호하게 말했습니다: TPU는 "우리가 하는 일에서 확실히 차별화된 부분입니다... OpenAI는 그런 능력을 갖추지 못했습니다."

중요하게도, 구글은 TPU를 단독으로 제시하지 않고 더 복잡한 기업 AI 아키텍처의 일부로 제시합니다. 기술 내부자들에게는 최상위 성능이 점점 더 전문화된 기술 혁신의 통합에 달려 있다는 것이 이해됩니다. Next에서 많은 업데이트가 상세히 설명되었습니다. Vahdat은 이를 "슈퍼컴퓨팅 시스템"이라고 묘사하며, 하드웨어(TPU, 최신 Nvidia GPU인 Blackwell 및 곧 출시될 Vera Rubin, Hyperdisk Exapools, Anywhere Cache, Rapid Storage와 같은 고급 스토리지)와 통합 소프트웨어 스택을 통합한다고 설명했습니다. 이 소프트웨어에는 가속기 관리를 위한 Cluster Director, Gemini의 분산 런타임인 Pathways(이제 고객에게 제공됨), 그리고 Nvidia/PyTorch 스택에서 이전된 워크로드를 더 쉽게 마이그레이션할 수 있도록 vLLM을 TPU에 최적화하는 것 등이 포함됩니다. Vahdat은 이 통합 시스템이 GPT-4o 대비 Gemini 2.0 Flash가 달러당 24배 높은 지능을 달성하는 이유라고 주장했습니다.

구글은 또한 물리적 인프라의 범위를 확장하고 있습니다. Cloud WAN은 구글의 200만 마일 저지연 사설 파이버 네트워크를 기업에 제공하여 고객이 관리하는 네트워크에 비해 최대 40% 더 빠른 성능과 40% 낮은 총 소유 비용(TCO)을 약속합니다.

또한, Google Distributed Cloud(GDC)는 Gemini와 Nvidia 하드웨어(Dell과의 파트너십을 통해)를 주권, 온프레미스, 또는 에어갭 환경에서 실행할 수 있게 하여, Nvidia CEO Jensen Huang이 규제 산업과 국가에 최첨단 AI를 제공하는 데 "엄청난" 능력이라고 칭찬했습니다. Next에서 Huang은 구글의 인프라를 세계 최고라고 불렀습니다: "구글과 Google Cloud만큼 컴퓨팅의 모든 단계를 잘하는 회사는 없습니다,"라고 그는 말했습니다.

기둥 3: 통합 풀 스택 – 점들을 연결하다

구글의 전략적 우위는 이러한 모델과 인프라 구성 요소들이 어떻게 응집력 있는 플랫폼으로 짜여 있는지를 고려할 때 더욱 커집니다. 파트너십에 의존해 틈을 메우는 경쟁자들과 달리, 구글은 거의 모든 레이어를 제어하여 더 긴밀한 통합과 더 빠른 혁신 주기를 가능하게 합니다.

그렇다면 마이크로소프트 같은 경쟁자가 OpenAI와 파트너십을 통해 인프라 범위를 LLM 모델 역량과 맞출 수 있다면 이 통합이 왜 중요한가요? 제가 이야기한 구글 직원들은 이것이 큰 차이를 만든다고 말하며 이를 뒷받침하는 일화를 제시했습니다.

구글의 기업 데이터베이스 BigQuery의 상당한 개선을 예로 들어보겠습니다. 이 데이터베이스는 이제 LLM이 데이터를 훨씬 더 효율적으로 검색할 수 있는 지식 그래프를 제공하며, Snowflake 및 Databricks와 같은 경쟁자들보다 5배 이상 많은 고객을 보유하고 있습니다. Google Cloud의 데이터 분석 제품 책임자인 Yasmeen Ahmad는 이러한 엄청난 개선이 구글의 데이터 팀이 DeepMind 팀과 긴밀히 협력했기 때문에 가능했다고 말했습니다. 그들은 해결하기 어려운 사용 사례를 함께 작업했고, 이는 데이터베이스가 일반적인 쿼리에 기반하여 구글의 내부 테스트에 따르면 경쟁자들보다 50% 더 높은 정확도로 올바른 데이터에 도달하게 했다고 Ahmad는 VentureBeat와의 인터뷰에서 말했습니다. Ahmad는 이와 같은 스택 전반의 깊은 통합이 구글이 업계를 "도약"한 방식이라고 말했습니다.

이 내부 응집력은 마이크로소프트의 "친적" 관계와 극명히 대조됩니다. 마이크로소프트는 Azure 클라우드에서 OpenAI의 모델을 배포하기 위해 파트너십을 맺고 있지만, 동시에 자체 모델을 구축하고 있습니다. 현재 구글의 AI 개발자 프로그램을 이끄는 Mat Velloso는 Windows Copilot 계획을 OpenAI의 모델 제공과 조율하려다 좌절감을 느끼고 마이크로소프트를 떠났습니다. "당신의 제품 계획을 경쟁하는 다른 회사와 어떻게 공유합니까... 전체가 모순입니다,"라고 그는 회상했습니다. "여기서는 모델을 만드는 사람들과 나란히 앉아 있습니다."

이 통합은 구글 리더들이 핵심 우위로 보는 것, 즉 기초 연구와 모델 구축부터 "행성 규모" 애플리케이션 배포와 인프라 설계에 이르는 전체 스펙트럼에 걸친 깊은 전문성을 연결하는 독특한 능력을 말해줍니다.

Vertex AI는 구글의 기업 AI 노력의 중심 신경계 역할을 합니다. 그리고 통합은 구글의 자체 제공을 넘어섭니다. Vertex의 Model Garden은 구글, Meta의 Llama 4, 그리고 수많은 오픈소스 옵션을 포함한 200개 이상의 엄선된 모델을 제공합니다. Vertex는 튜닝, 평가(AI 기반 Evals 포함, Grannis가 핵심 가속기로 강조), 배포, 모니터링 도구를 제공합니다. 내부 AI-ready 데이터베이스와 외부 벡터 데이터베이스와의 호환성을 활용한 grounding 기능도 있습니다. 여기에 구글의 새로운 제안인 세계 최고의 검색 엔진 Google Search로 모델을 grounding하는 기능이 추가됩니다.

통합은 Google Workspace로 확장됩니다. Next '25에서 발표된 새로운 기능, 예를 들어 Sheets의 "Help Me Analyze"(네, Sheets는 이제 "=AI" 공식을 가지고 있습니다), Docs와 Workspace Flows의 Audio Overviews는 Gemini의 기능을 일상 워크플로우에 더욱 깊이 통합하여 구글이 경험을 개선하는 데 사용할 강력한 피드백 루프를 만듭니다.

통합 스택을 추진하면서 구글은 생태계에 도움이 되는 곳에서 개방성을 옹호합니다. Kubernetes 채택을 주도한 후, 이제 AI 프레임워크를 위한 JAX와 에이전트 통신을 위한 오픈 프로토콜(A2A)을 촉진하며 기존 표준(MCP)을 지원합니다. 구글은 또한 Agentspace 내에서 외부 플랫폼으로의 수백 개의 커넥터를 제공하며, 이는 직원들이 에이전트를 찾고 사용할 수 있는 구글의 새로운 통합 인터페이스입니다. 이 허브 개념은 매력적입니다. Agentspace의 기조연설 데모(51:40부터 시작)는 이를 보여줍니다. 구글은 사용자에게 미리 구축된 에이전트를 제공하거나, 직원 또는 개발자가 노코드 AI 기능을 사용하여 자체적으로 구축할 수 있습니다. 또는 A2A 커넥터를 통해 외부에서 에이전트를 가져올 수 있습니다. 이는 Chrome 브라우저에 원활하게 통합됩니다.

기둥 4: 기업 가치와 에이전트 생태계에 집중

아마도 가장 중요한 변화는 구글의 AI 에이전트를 통해 구체적인 기업 문제를 해결하는 데 날카롭게 초점을 맞춘 것입니다. Google Cloud CEO Thomas Kurian은 고객이 구글을 선택하는 세 가지 이유를 설명했습니다: AI 최적화 플랫폼, 기존 IT와 연결할 수 있는 개방형 멀티 클라우드 접근, 그리고 보안, 주권, 규제 준수에 초점을 맞춘 기업 준비 상태입니다.

에이전트는 이 전략의 핵심입니다. AgentSpace 외에도 다음이 포함됩니다:

- 빌딩 블록: Next에서 발표된 오픈소스 Agent Development Kit(ADK)은 이미 개발자들로부터 상당한 관심을 받고 있습니다. ADK는 다중 에이전트 시스템 생성을 단순화하며, 제안된 Agent2Agent(A2A) 프로토콜은 상호 운용성을 보장하여 Gemini ADK, LangGraph, CrewAI 등으로 구축된 에이전트들이 협업할 수 있도록 합니다. 구글의 Grannis는 A2A가 잠재적으로 수십만 개의 상호작용하는 에이전트의 규모와 보안 문제를 예상한다고 말했습니다.

- 목적별 에이전트: 구글은 Agentspace에 통합된 전문 에이전트(NotebookLM, Idea Generation, Deep Research 등)를 선보였으며, 고객 에이전트(Reddit Answers, Verizon의 지원 어시스턴트, Wendy’s 드라이브 스루를 구동), 창의적 에이전트(WPP, Brandtech, Sphere에서 사용), 데이터 에이전트(Mattel, Spotify, Bayer에서 인사이트 제공), 코딩 에이전트(Gemini Code Assist), 보안 에이전트(새로운 Google Unified Security 플랫폼에 통합)를 포함한 5가지 주요 카테고리가 주목받고 있다고 강조했습니다.

이 포괄적인 에이전트 전략은 공감을 얻고 있는 것 같습니다. 지난주 경쟁 민감성으로 인해 익명으로 인터뷰한 세 개의 다른 대기업 임원들과의 대화에서도 구글의 에이전트 전략에 대한 열정이 반영되었습니다. Google Cloud COO Francis DeSouza는 인터뷰에서 확인했습니다: "모든 대화에는 AI가 포함됩니다. 구체적으로, 모든 대화에는 에이전트가 포함됩니다."

구글의 AI 제품을 많이 사용하고 다른 회사들에 배포하는 Deloitte의 임원 Kevin Laughridge는 에이전트 시장을 "땅따먹기"로 묘사하며, 구글의 프로토콜과 통합 플랫폼을 통한 초기 움직임이 상당한 이점을 제공한다고 말했습니다. "가장 먼저 나서서 실제로 가치를 제공하는 가장 많은 에이전트를 확보하는 자가 이 경쟁에서 승리할 것입니다,"라고 Laughridge는 인터뷰에서 말했습니다. 그는 구글의 발전이 "놀라울 정도"라고 언급하며, 1년 전에 Deloitte가 자체적으로 구축했던 맞춤 에이전트가 이제 Agentspace를 사용해 "바로 사용할 수 있다"고 말했습니다. Deloitte는 플랫폼에서 재무, 리스크, 엔지니어링과 같은 중간 사무 기능을 타겟으로 100개의 에이전트를 구축하고 있다고 그는 말했습니다.

고객 증거는 쌓이고 있습니다. Next에서 구글은 생성 AI로 "500개 이상의 고객이 운영 중"이라고 밝혔으며, 이는 1년 전 "수십 개의 프로토타입"에서 크게 증가한 것입니다. 1년 전 마이크로소프트가 훨씬 앞서 있다고 인식되었지만, 이제는 그게 명백하지 않습니다. 모든 측면에서의 PR 전쟁으로 인해 현재 누가 정말로 이기고 있는지 단정적으로 말하기는 어렵습니다. 메트릭은 다양합니다. 구글의 500이라는 숫자는 마이크로소프트가 홍보하는 400개의 사례 연구와 직접 비교할 수 없으며(마이크로소프트는 이에 대응해 VentureBeat에 보도 시점에서 이 공개 수치를 곧 600으로 업데이트할 계획이라고 밝혔으며, 이는 치열한 마케팅을 강조합니다). 그리고 구글의 앱을 통한 AI 배포가 중요하다면, 마이크로소프트의 365를 통한 Copilot 배포도 마찬가지로 인상적입니다. 둘 다 이제 API를 통해 수백만 명의 개발자에게 도달하고 있습니다.

하지만 구글의 견인력에 대한 예시는 많습니다:

- Wendy’s: 1년 만에 AI 드라이브 스루 시스템을 수천 개의 매장에 배포하여 직원 경험과 주문 정확도를 개선했습니다. Google Cloud CTO Will Grannis는 AI 시스템이 속어 이해와 배경 소음 필터링이 가능해 실시간 고객 상호작용의 스트레스를 크게 줄였다고 언급했습니다. 이는 직원들이 음식 준비와 품질에 집중할 수 있게 해주며, Grannis는 이를 "AI가 실세계 운영을 간소화하는 훌륭한 예"라고 불렀습니다.

- Salesforce: AWS를 넘어 처음으로 Google Cloud에서 플랫폼을 실행하는 대규모 확장을 발표하며, 구글의 혁신과 최적화 지원 능력을 언급했습니다.

- Honeywell & Intuit: 이전에는 마이크로소프트와 AWS와 강하게 연관되었던 기업들이 이제 Google Cloud와 AI 이니셔티브에서 파트너십을 맺고 있습니다.

- 주요 은행(Deutsche Bank, Wells Fargo): 연구, 분석, 고객 서비스 현대화를 위해 에이전트와 Gemini를 활용하고 있습니다.

- 소매업체(Walmart, Mercado Libre, Lowe’s): 검색, 에이전트, 데이터 플랫폼을 사용하고 있습니다.

이 기업 견인력은 Google Cloud의 전체 성장에 연료를 공급하며, 지난 3분기 동안 AWS와 Azure를 앞질렀습니다. Google Cloud는 2018년 50억 달러에서 2024년 연간 440억 달러의 실행률에 도달했습니다.

경쟁의 물결을 헤쳐나가기

구글의 상승이 경쟁자들이 가만히 있다는 의미는 아닙니다. 이번 주 OpenAI의 GPT-4.1(코딩과 긴 컨텍스트에 초점)과 o-시리즈(다중 모달 추론, 도구 사용)의 빠른 출시는 OpenAI의 지속적인 혁신을 보여줍니다. 또한, OpenAI의 GPT-4o의 새로운 이미지 생성 기능 업데이트는 지난 한 달 동안 엄청난 성장을 촉진하여 ChatGPT가 8억 명의 사용자에 도달하게 했습니다. 마이크로소프트는 방대한 기업 기반과 OpenAI 파트너십을 계속 활용하며, Anthropic은 특히 코딩과 안전 중심 애플리케이션에서 강력한 경쟁자로 남아 있습니다.

그러나 구글의 내러티브가 놀라울 정도로 개선된 것은 부인할 수 없습니다. 불과 1년 전만 해도 구글은 느리고 망설이며 실수하는 경쟁자로 여겨졌으며, AI 리더십의 기회를 놓칠지도 모른다는 인식이 있었습니다. 대신, 독특한 통합 스택과 기업의 확고함은 다른 것을 드러냈습니다: 구글은 칩 설계(TPU)와 글로벌 인프라, 기초 모델 연구(DeepMind), 애플리케이션 개발(Workspace, Search, YouTube), 그리고 기업 클라우드 서비스(Vertex AI, BigQuery, Agentspace)에 걸쳐 세계 최고의 능력을 보유하고 있습니다. "우리는 기초 모델 대화에 참여하는 유일한 하이퍼스케일러입니다,"라고 deSouza는 단호히 말했습니다. 이 엔드투엔드 소유권은 파트너십에 의존하는 모델이 따라 하기 어려운 최적화("달러당 지능")와 통합 깊이를 가능하게 합니다. 경쟁자들은 종종 서로 다른 조각들을 꿰매야 하며, 이는 잠재적으로 마찰을 일으키거나 혁신 속도를 제한합니다.

구글의 순간은 지금

AI 경쟁은 여전히 역동적이지만, 구글은 시장이 요구하는 바로 그 순간에 모든 조각을 모았습니다. Deloitte의 Laughridge가 말했듯이, 구글은 시장이 요구하는 곳에서 완벽히 정렬된 지점에 도달했습니다. 만약 당신이 구글이 기업 AI에서 자신을 증명하기를 기다렸다면, 그 순간을 놓쳤을지도 모릅니다 — 구글은 이미 증명했습니다. 이 혁명을 이끄는 핵심 기술을 발명한 회사는 마침내 따라잡았고, 그 이상으로, 이제 경쟁자들이 따라잡아야 할 속도를 설정하고 있습니다.

아래 비디오에서, Next 직후에 녹화된 AI 전문가 Sam Witteveen과 저는 현재의 풍경과 떠오르는 트렌드, 그리고 구글의 AI 생태계가 왜 그렇게 강력하게 느껴지는지를 분석합니다:

관련 기사

최고의 AI 연구소, 인류가 AI 시스템에 대한 이해력을 잃어가고 있다고 경고하다

전례 없는 단결력을 보여준 OpenAI, Google DeepMind, Anthropic, Meta의 연구원들은 경쟁적 차이를 제쳐두고 책임감 있는 AI 개발에 대한 공동의 경고를 발표했습니다. 일반적으로 라이벌 관계에 있는 이들 조직의 40여 명의 선도적인 과학자들은 AI 의사결정 과정의 투명성을 보장하기 위해 빠르게 닫혀가는 창을 강조하는 획기적인 연구

최고의 AI 연구소, 인류가 AI 시스템에 대한 이해력을 잃어가고 있다고 경고하다

전례 없는 단결력을 보여준 OpenAI, Google DeepMind, Anthropic, Meta의 연구원들은 경쟁적 차이를 제쳐두고 책임감 있는 AI 개발에 대한 공동의 경고를 발표했습니다. 일반적으로 라이벌 관계에 있는 이들 조직의 40여 명의 선도적인 과학자들은 AI 의사결정 과정의 투명성을 보장하기 위해 빠르게 닫혀가는 창을 강조하는 획기적인 연구

구글의 최신 제미니 AI 모델은 테스트에서 안전 점수가 하락하고 있습니다.

Google의 내부 테스트 결과 최신 AI 모델의 안전 프로토콜이 이전 버전에 비해 성능이 저하된 것으로 나타났습니다. 새로 발표된 벤치마크에 따르면 Gemini 2.5 플래시 모델은 텍스트와 이미지 프롬프트를 모두 처리할 때 주요 안전 지표에서 가이드라인 위반 비율이 4~10% 더 높은 것으로 나타났습니다.이 기술 대기업의 자동화된 평가는 우려스러운 경향

구글의 최신 제미니 AI 모델은 테스트에서 안전 점수가 하락하고 있습니다.

Google의 내부 테스트 결과 최신 AI 모델의 안전 프로토콜이 이전 버전에 비해 성능이 저하된 것으로 나타났습니다. 새로 발표된 벤치마크에 따르면 Gemini 2.5 플래시 모델은 텍스트와 이미지 프롬프트를 모두 처리할 때 주요 안전 지표에서 가이드라인 위반 비율이 4~10% 더 높은 것으로 나타났습니다.이 기술 대기업의 자동화된 평가는 우려스러운 경향

알리바바의 '제로서치' AI, 자율 학습으로 교육 비용 88% 절감

알리바바의 제로서치: AI 학습 효율성의 판도를 바꾸는 방법알리바바 그룹 연구원들은 값비싼 상용 검색 엔진 API를 완전히 우회하여 AI 시스템이 정보 검색을 학습하는 방식을 혁신할 수 있는 획기적인 방법을 개척했습니다. 이들의 제로서치 기술은 대규모 언어 모델이 훈련 단계에서 기존의 검색 엔진 상호 작용 대신 시뮬레이션 환경을 통해 정교한 검색 능력을 배

의견 (12)

0/200

알리바바의 '제로서치' AI, 자율 학습으로 교육 비용 88% 절감

알리바바의 제로서치: AI 학습 효율성의 판도를 바꾸는 방법알리바바 그룹 연구원들은 값비싼 상용 검색 엔진 API를 완전히 우회하여 AI 시스템이 정보 검색을 학습하는 방식을 혁신할 수 있는 획기적인 방법을 개척했습니다. 이들의 제로서치 기술은 대규모 언어 모델이 훈련 단계에서 기존의 검색 엔진 상호 작용 대신 시뮬레이션 환경을 통해 정교한 검색 능력을 배

의견 (12)

0/200

![EdwardRamirez]() EdwardRamirez

EdwardRamirez

2025년 8월 6일 오후 2시 0분 59초 GMT+09:00

2025년 8월 6일 오후 2시 0분 59초 GMT+09:00

Google's AI comeback is wild! 😎 I thought they were out of the game, but their enterprise push is sneaky strong. Wonder if they’ll dominate the market soon?

0

0

![ThomasBaker]() ThomasBaker

ThomasBaker

2025년 7월 22일 오전 10시 25분 3초 GMT+09:00

2025년 7월 22일 오전 10시 25분 3초 GMT+09:00

Google's quiet climb in enterprise AI is wild! 😎 I thought they were out of the game, but this Transformer legacy is no joke. Curious if they’ll outpace Microsoft soon?

0

0

![RalphGarcia]() RalphGarcia

RalphGarcia

2025년 4월 23일 오전 3시 20분 20초 GMT+09:00

2025년 4월 23일 오전 3시 20분 20초 GMT+09:00

GoogleのエンタープライズAIへの進出は感動的だね。追いつくことから先頭に立つまで、彼らは本当にゲームを上げた。でもインターフェースはもう少し改善が必要だね;ちょっとぎこちない。でも、これからどこに向かうのか楽しみだよ!🚀

0

0

![FredAnderson]() FredAnderson

FredAnderson

2025년 4월 23일 오전 12시 53분 12초 GMT+09:00

2025년 4월 23일 오전 12시 53분 12초 GMT+09:00

Google's move into enterprise AI is impressive. From playing catch-up to leading the pack, they've really stepped up their game. But the interface could use some work; it's a bit clunky. Still, I'm excited to see where they go from here! 🚀

0

0

![JasonRoberts]() JasonRoberts

JasonRoberts

2025년 4월 22일 오후 4시 22분 36초 GMT+09:00

2025년 4월 22일 오후 4시 22분 36초 GMT+09:00

El movimiento sigiloso de Google en la IA empresarial es bastante genial. De ir a la zaga a liderar el grupo, realmente han dado la vuelta a la situación. La tecnología es sólida pero la interfaz podría ser más amigable para el usuario. Aún así, es impresionante lo rápido que se han movido! 🚀

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

2025년 4월 22일 오후 3시 10분 16초 GMT+09:00

2025년 4월 22일 오후 3시 10분 16초 GMT+09:00

A jogada furtiva do Google no AI empresarial é bem legal. De tentar alcançar a liderar o grupo, eles realmente mudaram as coisas. A tecnologia é sólida, mas a interface poderia ser mais amigável ao usuário. Ainda assim, é impressionante como eles se moveram rápido! 🚀

0

0

불과 1년 전만 해도 구글과 기업용 AI에 대한 관심은 정체된 것처럼 보였습니다. 트랜스포머와 같은 선구적인 기술에도 불구하고, 이 기술 대기업은 OpenAI의 폭발적인 성공, Anthropic의 코딩 실력, 그리고 마이크로소프트의 공격적인 기업 시장 진출에 가려져 뒤처지는 것처럼 보였습니다.

하지만 2025년 라스베이거스에서 열린 Google Cloud Next 2025로 시간을 빠르게 돌려보면, 분위기는 확연히 달라졌습니다. 최고 성능의 모델, 견고한 인프라, 그리고 명확한 기업 전략으로 무장한 자신감 넘치는 구글은 극적인 반전을 발표했습니다. 구글 고위 임원들과의 비공개 애널리스트 회의에서 한 애널리스트는 그 분위기를 이렇게 요약했습니다: "이건 구글이 '따라잡기'에서 '우리를 따라잡아'로 바뀐 순간처럼 느껴집니다."

구글의 도약

구글이 기업용 AI 경쟁에서 OpenAI와 마이크로소프트를 따라잡았을 뿐만 아니라 앞서 나가고 있다는 감정은 행사 전반에 걸쳐 뚜렷이 나타났습니다. 그리고 이는 단순한 마케팅 과장이 아닙니다. 지난 1년 동안 구글은 실행에 강하게 집중하며, 기술적 역량을 고성능의 통합 플랫폼으로 전환하여 기업 의사결정자들을 빠르게 사로잡고 있습니다. 세계에서 가장 강력한 AI 모델이 고효율 맞춤형 실리콘에서 실행되는 것부터, 실세계 비즈니스 과제를 위해 맞춤화된 AI 에이전트의 성장하는 생태계에 이르기까지, 구글은 결코 길을 잃은 것이 아니라 깊고 기초적인 개발 기간을 거쳤다는 강력한 주장을 펼치고 있습니다.

이제 통합 스택이 완전한 가동 상태에 접어들며, 구글은 기업용 AI 혁명의 다음 단계를 이끌 준비가 된 것처럼 보입니다. Next에서 구글 임원들과의 인터뷰에서 그들은 구글의 인프라와 모델 통합에서의 독특한 강점을 강조했으며, 이는 OpenAI, 마이크로소프트, 또는 AWS와 같은 경쟁자들이 따라 하기 어려운 장점입니다.

의심의 그림자: 최근 과거 인정하기

구글의 현재 기세를 완전히 이해하려면 최근 과거를 인정하는 것이 중요합니다. 구글은 트랜스포머 아키텍처를 발명하여 대형 언어 모델(LLM)의 현대 혁명을 촉발했으며, 10년 전부터 특화된 AI 하드웨어(TPU)에 투자하기 시작해 현재 업계 최고의 효율성을 이끌어내고 있습니다. 하지만 이해할 수 없게도, 불과 2년 반 전, 구글은 방어적인 입장에 처해 있었습니다.

OpenAI의 ChatGPT는 숨 가쁜 속도로 대중의 상상력과 기업의 관심을 사로잡으며 역사상 가장 빠르게 성장한 앱이 되었습니다. Anthropic과 같은 경쟁자들은 코딩과 같은 틈새 시장을 개척했습니다. 반면, 구글의 공개적인 움직임은 종종 조심스럽거나 결함이 있는 것처럼 보였습니다. 2023년의 악명 높은 Bard 데모 실수와 이미지 생성기가 역사적으로 부정확한 묘사를 생성했다는 논란은 내부 관료주의나 과도한 정렬 수정으로 인해 방해를 받고 있는 회사라는 내러티브를 부추겼습니다. 구글은 길을 잃은 것처럼 보였으며, 아마존과 마이크로소프트에 이어 시장 점유율에서 3위에 머물렀던 클라우드 경쟁에서의 초기 느림보를 떠올리게 했습니다.

전환: 리더십을 되찾기 위한 의식적인 결정

그러나 무대 뒤에서는 최고 경영진 수준에서의 의식적인 결정으로 큰 변화가 일어나고 있었습니다. Google DeepMind의 AI 개발자 플랫폼 제품 부사장인 Mat Velloso는 2024년 2월 마이크로소프트를 떠나 구글에 합류했을 때 이 결정적인 순간을 감지했습니다. "구글에 왔을 때, 저는 Sundar [Pichai]와 여러 리더들과 이야기했고, 그들이 '생성 AI가 업계가 분명히 중요하게 여기는 것'이라고 결정하는 순간을 느꼈습니다. 해내자고 했죠," Velloso는 지난주 Next에서 인터뷰 중에 공유했습니다.

이 새로운 추진력은 일부 외부인들이 믿었던 "인재 유출"로 인해 방해받지 않았습니다. 대신, 구글은 2024년 초에 공격적인 채용, 내부 통합, 그리고 고객 확보로 표시되는 실행에 집중했습니다. 경쟁자들이 화려한 채용을 진행하는 동안, 구글은 DeepMind CEO Demis Hassabis와 Google Cloud CEO Thomas Kurian을 포함한 핵심 AI 리더십을 유지하며 안정성과 깊은 전문성을 제공했습니다.

게다가, 인재는 구글의 집중된 사명을 향해 흐르기 시작했습니다. 예를 들어, Logan Kilpatrick은 OpenAI에서 구글로 돌아와 회사 내에서 기초적인 AI를 구축할 기회에 끌렸습니다. 그는 Velloso와 함께 "0에서 1로의 경험"이라 묘사하며, Gemini의 개발자 확보를 처음부터 구축하는 임무를 맡았습니다. "첫날은 저 혼자 팀이었고... 이 플랫폼에는 사용자가 없었고, 수익도 없었습니다. Gemini에 관심 있는 사람은 아무도 없었죠," Kilpatrick은 시작점을 회상했습니다. AI Studio를 시작하고 현재 Gemini 앱과 Labs를 이끄는 Josh Woodward와, 원래 "Attention Is All You Need" 트랜스포머 논문의 핵심 공동 저자인 Noam Shazeer도 2024년 말에 중요한 Gemini 프로젝트의 기술 공동 리더로 회사에 복귀했습니다.

기둥 1: Gemini 2.5와 사고 모델의 시대

기업의 모토가 "모델만 중요한 것이 아니다"로 바뀌었지만, 최고 성능의 LLM을 보유하는 것은 여전히 중요한 성취이며, 회사의 우수한 연구와 효율적인 기술 아키텍처를 강력하게 입증하는 것입니다. Next '25 직전에 출시된 Gemini 2.5 Pro로 구글은 이 타이틀을 확실히 차지했습니다. 이는 독립적인 Chatbot Arena 리더보드에서 빠르게 1위를 차지하며 OpenAI의 최신 GPT-4o 변형을 크게 앞질렀고, Humanity’s Last Exam과 같은 까다로운 추론 벤치마크에서도 뛰어난 성과를 냈습니다. Pichai는 기조연설에서 "이것은 우리의 가장 지능적인 AI 모델입니다. 그리고 세계 최고의 모델입니다"라고 말했습니다. 그는 별도로 트윗에서 이 모델이 한 달 만에 Gemini 사용량을 80% 증가시켰다고 밝혔습니다.

처음으로 Gemini에 대한 수요가 폭발적이었습니다. Gemini 2.5 Pro의 순수한 지능 외에 저를 감동시킨 것은 그 증명 가능한 추론 능력이었습니다. 구글은 모델이 다단계 추론, 계획, 심지어 최종 응답을 결정하기 전에 자기 성찰을 수행할 수 있는 "사고" 기능을 설계했습니다. 번호가 붙은 단계와 하위 목록을 사용한 구조적이고 일관된 사고 체인(CoT)은 DeepSeek이나 OpenAI의 다른 모델에서 나오는 장황하거나 불투명한 출력과는 다릅니다. 중요한 작업을 위해 출력을 평가하는 기술 팀에게 이 투명성은 전례 없는 자신감으로 검증, 수정, 리디렉션을 가능하게 합니다.

하지만 기업 사용자에게 더 중요한 것은 Gemini 2.5 Pro가 생성 AI의 가장 큰 응용 분야 중 하나인 코딩에서 격차를 크게 좁혔다는 점입니다. VentureBeat와의 인터뷰에서 선도적인 소매업체 Wayfair의 CTO Fiona Tan은 초기 테스트 후 이 모델이 "상당히 향상되었다"고 말하며, 이전에 많은 개발자들이 선호했던 Anthropic의 Claude 3.7 Sonnet과 "비교적 비슷하다"고 밝혔습니다.

구글은 또한 이 모델에 100만 토큰의 대규모 컨텍스트 윈도우를 추가하여 전체 코드베이스나 긴 문서를 추론할 수 있게 했으며, 이는 OpenAI나 Anthropic의 모델 능력을 훨씬 초월합니다. (OpenAI는 이번 주에 비슷한 대규모 컨텍스트 윈도우를 갖춘 모델로 대응했지만, 벤치마크는 Gemini 2.5 Pro가 전체 추론에서 여전히 우위를 유지하고 있음을 시사합니다.) 이 장점은 복잡한 다중 파일 소프트웨어 엔지니어링 작업을 가능하게 합니다.

Pro를 보완하는 Gemini 2.5 Flash는 Next '25에서 발표되고 어제 출시되었습니다. 역시 "사고" 모델인 Flash는 낮은 지연 시간과 비용 효율성에 최적화되었습니다. 사용자는 모델의 추론 정도를 제어하고 성능과 예산을 균형 있게 조정할 수 있습니다. 이 계층화된 접근 방식은 구글 임원들이 옹호하는 "달러당 지능" 전략을 더욱 반영합니다.

Velloso는 지능 스펙트럼 전반에 걸쳐 구글 모델이 최고의 가치를 제공한다는 차트를 보여주었습니다. "1년 전이라면... 보여줄 게 없었을 겁니다," Velloso는 빠른 변화를 강조하며 인정했습니다. "이제는 어떤 모델, 어떤 크기든, 구글이 아니면 돈을 잃는 겁니다." OpenAI의 최신 모델 출시를 반영한 유사한 차트도 업데이트되었으며, 모두 같은 결과를 보여줍니다: 구글의 모델이 달러당 최고의 지능을 제공합니다. 아래를 참조하세요:

Wayfair의 Tan은 또한 2.5 Pro의 유망한 지연 시간 개선을 관찰했습니다: "Gemini 2.5는 더 빠르게 응답했습니다,"라며 이는 "고객과 직접 대면하는 기능"에 적합하다고 말했습니다. 이는 이전의 다른 모델들에서는 그렇지 않았다고 그녀는 덧붙였습니다. Gemini는 Wayfair가 이러한 고객 상호작용에 사용할 첫 번째 모델이 될 수 있다고 그녀는 말했습니다.

Gemini 제품군의 기능은 다중 모달로 확장되며, Google의 다른 선도적인 모델인 Imagen 3(이미지 생성), Veo 2(비디오 생성), Chirp 3(오디오), 그리고 새로 발표된 Lyria(텍스트-음악)와 원활하게 통합되며, 모두 Google의 Vertex 플랫폼을 통해 기업 사용자에게 제공됩니다. 구글은 모든 모달리티에 걸쳐 자체 생성 미디어 모델을 플랫폼에서 제공하는 유일한 회사입니다. 마이크로소프트, AWS, OpenAI는 이를 위해 다른 회사들과 파트너십을 맺어야 합니다.

기둥 2: 인프라 역량 – 엔진의 핵심

이러한 강력한 모델을 빠르게 반복하고 효율적으로 제공하는 능력은 구글의 아마도 비교할 수 없는 인프라에서 비롯됩니다. 이는 수십 년간의 행성 규모 서비스 운영을 통해 다듬어졌습니다. 이 중심에는 Tensor Processing Unit(TPU)이 있습니다.

Next '25에서 구글은 추론과 "사고 모델"의 요구에 맞춰 설계된 7세대 TPU인 Ironwood를 공개했습니다. 그 규모는 방대하며, 까다로운 AI 워크로드를 위해 맞춤화되었습니다: Ironwood 포드는 9,000개 이상의 액체 냉각 칩을 포함하며, 42.5 엑사플롭스의 연산 능력을 제공한다고 주장합니다. 구글의 ML 시스템 부사장 Amin Vahdat은 Next 무대에서 이것이 현재 세계 1위 슈퍼컴퓨터의 연산 능력보다 "24배 이상"이라고 말했습니다.

구글은 Ironwood가 이전 세대 TPU인 Trillium 대비 2배의 성능/와트 효율을 제공한다고 밝혔습니다. 이는 기업 고객들이 대규모 AI 배포를 제한하는 에너지 비용과 가용성 문제를 점점 더 언급하고 있기 때문에 중요합니다.

Google Cloud CTO Will Grannis는 이러한 발전의 일관성을 강조했습니다. 매년 구글은 프로세서에서 10배, 8배, 9배, 10배의 개선을 이루며, 그가 VentureBeat와의 인터뷰에서 "하이퍼 무어의 법칙"이라고 부른 것을 만들어냈다고 말했습니다. 그는 고객들이 구글의 기술뿐만 아니라 로드맵을 구매한다고 말했습니다.

구글의 위치는 이러한 지속적인 TPU 투자를 촉진했습니다. 20억 명 이상의 사용자를 위해 Search, YouTube, Gmail과 같은 대규모 서비스를 효율적으로 운영해야 했기 때문에, 현재의 생성 AI 붐이 일어나기 훨씬 전에 맞춤화되고 최적화된 하드웨어를 개발해야 했습니다. Meta는 유사한 소비자 규모로 운영되지만, 다른 경쟁자들은 10년간의 수직 통합 AI 하드웨어 개발을 위한 이러한 내부 동인을 갖추지 못했습니다.

이제 이러한 TPU 투자는 자체 앱뿐만 아니라 다른 사용자들에게 Gemini를 더 나은 달러당 지능으로 제공할 수 있게 함으로써 보답받고 있습니다.

구글의 경쟁자들이 Nvidia에서 효율적인 프로세서를 구매할 수 없는 이유가 궁금하시죠? Nvidia의 GPU 프로세서가 LLM의 사전 학습을 지배하는 것이 사실입니다. 하지만 시장 수요로 인해 GPU 가격이 상승했고, Nvidia는 자체적으로 상당한 이익을 취하고 있습니다. 이는 칩 사용자들에게 상당한 비용을 전가합니다. 또한, 지금까지 AI 칩 사용은 사전 학습이 지배했지만, 기업들이 실제로 이러한 애플리케이션을 배포하면서 이제는 "추론"이 중요해지고 있으며, 여기서 TPU는 대규모 워크로드에서 GPU보다 더 효율적인 것으로 간주됩니다.

구글 임원들에게 그들의 주요 기술 우위가 어디서 오는지 물으면, 그들은 보통 TPU를 가장 중요한 요소로 꼽습니다. 구글의 컴퓨팅 인프라를 운영하는 부사장 Mark Lohmeyer는 단호하게 말했습니다: TPU는 "우리가 하는 일에서 확실히 차별화된 부분입니다... OpenAI는 그런 능력을 갖추지 못했습니다."

중요하게도, 구글은 TPU를 단독으로 제시하지 않고 더 복잡한 기업 AI 아키텍처의 일부로 제시합니다. 기술 내부자들에게는 최상위 성능이 점점 더 전문화된 기술 혁신의 통합에 달려 있다는 것이 이해됩니다. Next에서 많은 업데이트가 상세히 설명되었습니다. Vahdat은 이를 "슈퍼컴퓨팅 시스템"이라고 묘사하며, 하드웨어(TPU, 최신 Nvidia GPU인 Blackwell 및 곧 출시될 Vera Rubin, Hyperdisk Exapools, Anywhere Cache, Rapid Storage와 같은 고급 스토리지)와 통합 소프트웨어 스택을 통합한다고 설명했습니다. 이 소프트웨어에는 가속기 관리를 위한 Cluster Director, Gemini의 분산 런타임인 Pathways(이제 고객에게 제공됨), 그리고 Nvidia/PyTorch 스택에서 이전된 워크로드를 더 쉽게 마이그레이션할 수 있도록 vLLM을 TPU에 최적화하는 것 등이 포함됩니다. Vahdat은 이 통합 시스템이 GPT-4o 대비 Gemini 2.0 Flash가 달러당 24배 높은 지능을 달성하는 이유라고 주장했습니다.

구글은 또한 물리적 인프라의 범위를 확장하고 있습니다. Cloud WAN은 구글의 200만 마일 저지연 사설 파이버 네트워크를 기업에 제공하여 고객이 관리하는 네트워크에 비해 최대 40% 더 빠른 성능과 40% 낮은 총 소유 비용(TCO)을 약속합니다.

또한, Google Distributed Cloud(GDC)는 Gemini와 Nvidia 하드웨어(Dell과의 파트너십을 통해)를 주권, 온프레미스, 또는 에어갭 환경에서 실행할 수 있게 하여, Nvidia CEO Jensen Huang이 규제 산업과 국가에 최첨단 AI를 제공하는 데 "엄청난" 능력이라고 칭찬했습니다. Next에서 Huang은 구글의 인프라를 세계 최고라고 불렀습니다: "구글과 Google Cloud만큼 컴퓨팅의 모든 단계를 잘하는 회사는 없습니다,"라고 그는 말했습니다.

기둥 3: 통합 풀 스택 – 점들을 연결하다

구글의 전략적 우위는 이러한 모델과 인프라 구성 요소들이 어떻게 응집력 있는 플랫폼으로 짜여 있는지를 고려할 때 더욱 커집니다. 파트너십에 의존해 틈을 메우는 경쟁자들과 달리, 구글은 거의 모든 레이어를 제어하여 더 긴밀한 통합과 더 빠른 혁신 주기를 가능하게 합니다.

그렇다면 마이크로소프트 같은 경쟁자가 OpenAI와 파트너십을 통해 인프라 범위를 LLM 모델 역량과 맞출 수 있다면 이 통합이 왜 중요한가요? 제가 이야기한 구글 직원들은 이것이 큰 차이를 만든다고 말하며 이를 뒷받침하는 일화를 제시했습니다.

구글의 기업 데이터베이스 BigQuery의 상당한 개선을 예로 들어보겠습니다. 이 데이터베이스는 이제 LLM이 데이터를 훨씬 더 효율적으로 검색할 수 있는 지식 그래프를 제공하며, Snowflake 및 Databricks와 같은 경쟁자들보다 5배 이상 많은 고객을 보유하고 있습니다. Google Cloud의 데이터 분석 제품 책임자인 Yasmeen Ahmad는 이러한 엄청난 개선이 구글의 데이터 팀이 DeepMind 팀과 긴밀히 협력했기 때문에 가능했다고 말했습니다. 그들은 해결하기 어려운 사용 사례를 함께 작업했고, 이는 데이터베이스가 일반적인 쿼리에 기반하여 구글의 내부 테스트에 따르면 경쟁자들보다 50% 더 높은 정확도로 올바른 데이터에 도달하게 했다고 Ahmad는 VentureBeat와의 인터뷰에서 말했습니다. Ahmad는 이와 같은 스택 전반의 깊은 통합이 구글이 업계를 "도약"한 방식이라고 말했습니다.

이 내부 응집력은 마이크로소프트의 "친적" 관계와 극명히 대조됩니다. 마이크로소프트는 Azure 클라우드에서 OpenAI의 모델을 배포하기 위해 파트너십을 맺고 있지만, 동시에 자체 모델을 구축하고 있습니다. 현재 구글의 AI 개발자 프로그램을 이끄는 Mat Velloso는 Windows Copilot 계획을 OpenAI의 모델 제공과 조율하려다 좌절감을 느끼고 마이크로소프트를 떠났습니다. "당신의 제품 계획을 경쟁하는 다른 회사와 어떻게 공유합니까... 전체가 모순입니다,"라고 그는 회상했습니다. "여기서는 모델을 만드는 사람들과 나란히 앉아 있습니다."

이 통합은 구글 리더들이 핵심 우위로 보는 것, 즉 기초 연구와 모델 구축부터 "행성 규모" 애플리케이션 배포와 인프라 설계에 이르는 전체 스펙트럼에 걸친 깊은 전문성을 연결하는 독특한 능력을 말해줍니다.

Vertex AI는 구글의 기업 AI 노력의 중심 신경계 역할을 합니다. 그리고 통합은 구글의 자체 제공을 넘어섭니다. Vertex의 Model Garden은 구글, Meta의 Llama 4, 그리고 수많은 오픈소스 옵션을 포함한 200개 이상의 엄선된 모델을 제공합니다. Vertex는 튜닝, 평가(AI 기반 Evals 포함, Grannis가 핵심 가속기로 강조), 배포, 모니터링 도구를 제공합니다. 내부 AI-ready 데이터베이스와 외부 벡터 데이터베이스와의 호환성을 활용한 grounding 기능도 있습니다. 여기에 구글의 새로운 제안인 세계 최고의 검색 엔진 Google Search로 모델을 grounding하는 기능이 추가됩니다.

통합은 Google Workspace로 확장됩니다. Next '25에서 발표된 새로운 기능, 예를 들어 Sheets의 "Help Me Analyze"(네, Sheets는 이제 "=AI" 공식을 가지고 있습니다), Docs와 Workspace Flows의 Audio Overviews는 Gemini의 기능을 일상 워크플로우에 더욱 깊이 통합하여 구글이 경험을 개선하는 데 사용할 강력한 피드백 루프를 만듭니다.

통합 스택을 추진하면서 구글은 생태계에 도움이 되는 곳에서 개방성을 옹호합니다. Kubernetes 채택을 주도한 후, 이제 AI 프레임워크를 위한 JAX와 에이전트 통신을 위한 오픈 프로토콜(A2A)을 촉진하며 기존 표준(MCP)을 지원합니다. 구글은 또한 Agentspace 내에서 외부 플랫폼으로의 수백 개의 커넥터를 제공하며, 이는 직원들이 에이전트를 찾고 사용할 수 있는 구글의 새로운 통합 인터페이스입니다. 이 허브 개념은 매력적입니다. Agentspace의 기조연설 데모(51:40부터 시작)는 이를 보여줍니다. 구글은 사용자에게 미리 구축된 에이전트를 제공하거나, 직원 또는 개발자가 노코드 AI 기능을 사용하여 자체적으로 구축할 수 있습니다. 또는 A2A 커넥터를 통해 외부에서 에이전트를 가져올 수 있습니다. 이는 Chrome 브라우저에 원활하게 통합됩니다.

기둥 4: 기업 가치와 에이전트 생태계에 집중

아마도 가장 중요한 변화는 구글의 AI 에이전트를 통해 구체적인 기업 문제를 해결하는 데 날카롭게 초점을 맞춘 것입니다. Google Cloud CEO Thomas Kurian은 고객이 구글을 선택하는 세 가지 이유를 설명했습니다: AI 최적화 플랫폼, 기존 IT와 연결할 수 있는 개방형 멀티 클라우드 접근, 그리고 보안, 주권, 규제 준수에 초점을 맞춘 기업 준비 상태입니다.

에이전트는 이 전략의 핵심입니다. AgentSpace 외에도 다음이 포함됩니다:

- 빌딩 블록: Next에서 발표된 오픈소스 Agent Development Kit(ADK)은 이미 개발자들로부터 상당한 관심을 받고 있습니다. ADK는 다중 에이전트 시스템 생성을 단순화하며, 제안된 Agent2Agent(A2A) 프로토콜은 상호 운용성을 보장하여 Gemini ADK, LangGraph, CrewAI 등으로 구축된 에이전트들이 협업할 수 있도록 합니다. 구글의 Grannis는 A2A가 잠재적으로 수십만 개의 상호작용하는 에이전트의 규모와 보안 문제를 예상한다고 말했습니다.

- 목적별 에이전트: 구글은 Agentspace에 통합된 전문 에이전트(NotebookLM, Idea Generation, Deep Research 등)를 선보였으며, 고객 에이전트(Reddit Answers, Verizon의 지원 어시스턴트, Wendy’s 드라이브 스루를 구동), 창의적 에이전트(WPP, Brandtech, Sphere에서 사용), 데이터 에이전트(Mattel, Spotify, Bayer에서 인사이트 제공), 코딩 에이전트(Gemini Code Assist), 보안 에이전트(새로운 Google Unified Security 플랫폼에 통합)를 포함한 5가지 주요 카테고리가 주목받고 있다고 강조했습니다.

이 포괄적인 에이전트 전략은 공감을 얻고 있는 것 같습니다. 지난주 경쟁 민감성으로 인해 익명으로 인터뷰한 세 개의 다른 대기업 임원들과의 대화에서도 구글의 에이전트 전략에 대한 열정이 반영되었습니다. Google Cloud COO Francis DeSouza는 인터뷰에서 확인했습니다: "모든 대화에는 AI가 포함됩니다. 구체적으로, 모든 대화에는 에이전트가 포함됩니다."

구글의 AI 제품을 많이 사용하고 다른 회사들에 배포하는 Deloitte의 임원 Kevin Laughridge는 에이전트 시장을 "땅따먹기"로 묘사하며, 구글의 프로토콜과 통합 플랫폼을 통한 초기 움직임이 상당한 이점을 제공한다고 말했습니다. "가장 먼저 나서서 실제로 가치를 제공하는 가장 많은 에이전트를 확보하는 자가 이 경쟁에서 승리할 것입니다,"라고 Laughridge는 인터뷰에서 말했습니다. 그는 구글의 발전이 "놀라울 정도"라고 언급하며, 1년 전에 Deloitte가 자체적으로 구축했던 맞춤 에이전트가 이제 Agentspace를 사용해 "바로 사용할 수 있다"고 말했습니다. Deloitte는 플랫폼에서 재무, 리스크, 엔지니어링과 같은 중간 사무 기능을 타겟으로 100개의 에이전트를 구축하고 있다고 그는 말했습니다.

고객 증거는 쌓이고 있습니다. Next에서 구글은 생성 AI로 "500개 이상의 고객이 운영 중"이라고 밝혔으며, 이는 1년 전 "수십 개의 프로토타입"에서 크게 증가한 것입니다. 1년 전 마이크로소프트가 훨씬 앞서 있다고 인식되었지만, 이제는 그게 명백하지 않습니다. 모든 측면에서의 PR 전쟁으로 인해 현재 누가 정말로 이기고 있는지 단정적으로 말하기는 어렵습니다. 메트릭은 다양합니다. 구글의 500이라는 숫자는 마이크로소프트가 홍보하는 400개의 사례 연구와 직접 비교할 수 없으며(마이크로소프트는 이에 대응해 VentureBeat에 보도 시점에서 이 공개 수치를 곧 600으로 업데이트할 계획이라고 밝혔으며, 이는 치열한 마케팅을 강조합니다). 그리고 구글의 앱을 통한 AI 배포가 중요하다면, 마이크로소프트의 365를 통한 Copilot 배포도 마찬가지로 인상적입니다. 둘 다 이제 API를 통해 수백만 명의 개발자에게 도달하고 있습니다.

하지만 구글의 견인력에 대한 예시는 많습니다:

- Wendy’s: 1년 만에 AI 드라이브 스루 시스템을 수천 개의 매장에 배포하여 직원 경험과 주문 정확도를 개선했습니다. Google Cloud CTO Will Grannis는 AI 시스템이 속어 이해와 배경 소음 필터링이 가능해 실시간 고객 상호작용의 스트레스를 크게 줄였다고 언급했습니다. 이는 직원들이 음식 준비와 품질에 집중할 수 있게 해주며, Grannis는 이를 "AI가 실세계 운영을 간소화하는 훌륭한 예"라고 불렀습니다.

- Salesforce: AWS를 넘어 처음으로 Google Cloud에서 플랫폼을 실행하는 대규모 확장을 발표하며, 구글의 혁신과 최적화 지원 능력을 언급했습니다.

- Honeywell & Intuit: 이전에는 마이크로소프트와 AWS와 강하게 연관되었던 기업들이 이제 Google Cloud와 AI 이니셔티브에서 파트너십을 맺고 있습니다.

- 주요 은행(Deutsche Bank, Wells Fargo): 연구, 분석, 고객 서비스 현대화를 위해 에이전트와 Gemini를 활용하고 있습니다.

- 소매업체(Walmart, Mercado Libre, Lowe’s): 검색, 에이전트, 데이터 플랫폼을 사용하고 있습니다.

이 기업 견인력은 Google Cloud의 전체 성장에 연료를 공급하며, 지난 3분기 동안 AWS와 Azure를 앞질렀습니다. Google Cloud는 2018년 50억 달러에서 2024년 연간 440억 달러의 실행률에 도달했습니다.

경쟁의 물결을 헤쳐나가기

구글의 상승이 경쟁자들이 가만히 있다는 의미는 아닙니다. 이번 주 OpenAI의 GPT-4.1(코딩과 긴 컨텍스트에 초점)과 o-시리즈(다중 모달 추론, 도구 사용)의 빠른 출시는 OpenAI의 지속적인 혁신을 보여줍니다. 또한, OpenAI의 GPT-4o의 새로운 이미지 생성 기능 업데이트는 지난 한 달 동안 엄청난 성장을 촉진하여 ChatGPT가 8억 명의 사용자에 도달하게 했습니다. 마이크로소프트는 방대한 기업 기반과 OpenAI 파트너십을 계속 활용하며, Anthropic은 특히 코딩과 안전 중심 애플리케이션에서 강력한 경쟁자로 남아 있습니다.

그러나 구글의 내러티브가 놀라울 정도로 개선된 것은 부인할 수 없습니다. 불과 1년 전만 해도 구글은 느리고 망설이며 실수하는 경쟁자로 여겨졌으며, AI 리더십의 기회를 놓칠지도 모른다는 인식이 있었습니다. 대신, 독특한 통합 스택과 기업의 확고함은 다른 것을 드러냈습니다: 구글은 칩 설계(TPU)와 글로벌 인프라, 기초 모델 연구(DeepMind), 애플리케이션 개발(Workspace, Search, YouTube), 그리고 기업 클라우드 서비스(Vertex AI, BigQuery, Agentspace)에 걸쳐 세계 최고의 능력을 보유하고 있습니다. "우리는 기초 모델 대화에 참여하는 유일한 하이퍼스케일러입니다,"라고 deSouza는 단호히 말했습니다. 이 엔드투엔드 소유권은 파트너십에 의존하는 모델이 따라 하기 어려운 최적화("달러당 지능")와 통합 깊이를 가능하게 합니다. 경쟁자들은 종종 서로 다른 조각들을 꿰매야 하며, 이는 잠재적으로 마찰을 일으키거나 혁신 속도를 제한합니다.

구글의 순간은 지금

AI 경쟁은 여전히 역동적이지만, 구글은 시장이 요구하는 바로 그 순간에 모든 조각을 모았습니다. Deloitte의 Laughridge가 말했듯이, 구글은 시장이 요구하는 곳에서 완벽히 정렬된 지점에 도달했습니다. 만약 당신이 구글이 기업 AI에서 자신을 증명하기를 기다렸다면, 그 순간을 놓쳤을지도 모릅니다 — 구글은 이미 증명했습니다. 이 혁명을 이끄는 핵심 기술을 발명한 회사는 마침내 따라잡았고, 그 이상으로, 이제 경쟁자들이 따라잡아야 할 속도를 설정하고 있습니다.

아래 비디오에서, Next 직후에 녹화된 AI 전문가 Sam Witteveen과 저는 현재의 풍경과 떠오르는 트렌드, 그리고 구글의 AI 생태계가 왜 그렇게 강력하게 느껴지는지를 분석합니다:

최고의 AI 연구소, 인류가 AI 시스템에 대한 이해력을 잃어가고 있다고 경고하다

전례 없는 단결력을 보여준 OpenAI, Google DeepMind, Anthropic, Meta의 연구원들은 경쟁적 차이를 제쳐두고 책임감 있는 AI 개발에 대한 공동의 경고를 발표했습니다. 일반적으로 라이벌 관계에 있는 이들 조직의 40여 명의 선도적인 과학자들은 AI 의사결정 과정의 투명성을 보장하기 위해 빠르게 닫혀가는 창을 강조하는 획기적인 연구

최고의 AI 연구소, 인류가 AI 시스템에 대한 이해력을 잃어가고 있다고 경고하다

전례 없는 단결력을 보여준 OpenAI, Google DeepMind, Anthropic, Meta의 연구원들은 경쟁적 차이를 제쳐두고 책임감 있는 AI 개발에 대한 공동의 경고를 발표했습니다. 일반적으로 라이벌 관계에 있는 이들 조직의 40여 명의 선도적인 과학자들은 AI 의사결정 과정의 투명성을 보장하기 위해 빠르게 닫혀가는 창을 강조하는 획기적인 연구

알리바바의 '제로서치' AI, 자율 학습으로 교육 비용 88% 절감

알리바바의 제로서치: AI 학습 효율성의 판도를 바꾸는 방법알리바바 그룹 연구원들은 값비싼 상용 검색 엔진 API를 완전히 우회하여 AI 시스템이 정보 검색을 학습하는 방식을 혁신할 수 있는 획기적인 방법을 개척했습니다. 이들의 제로서치 기술은 대규모 언어 모델이 훈련 단계에서 기존의 검색 엔진 상호 작용 대신 시뮬레이션 환경을 통해 정교한 검색 능력을 배

알리바바의 '제로서치' AI, 자율 학습으로 교육 비용 88% 절감

알리바바의 제로서치: AI 학습 효율성의 판도를 바꾸는 방법알리바바 그룹 연구원들은 값비싼 상용 검색 엔진 API를 완전히 우회하여 AI 시스템이 정보 검색을 학습하는 방식을 혁신할 수 있는 획기적인 방법을 개척했습니다. 이들의 제로서치 기술은 대규모 언어 모델이 훈련 단계에서 기존의 검색 엔진 상호 작용 대신 시뮬레이션 환경을 통해 정교한 검색 능력을 배

2025년 8월 6일 오후 2시 0분 59초 GMT+09:00

2025년 8월 6일 오후 2시 0분 59초 GMT+09:00

Google's AI comeback is wild! 😎 I thought they were out of the game, but their enterprise push is sneaky strong. Wonder if they’ll dominate the market soon?

0

0

2025년 7월 22일 오전 10시 25분 3초 GMT+09:00

2025년 7월 22일 오전 10시 25분 3초 GMT+09:00

Google's quiet climb in enterprise AI is wild! 😎 I thought they were out of the game, but this Transformer legacy is no joke. Curious if they’ll outpace Microsoft soon?

0

0

2025년 4월 23일 오전 3시 20분 20초 GMT+09:00

2025년 4월 23일 오전 3시 20분 20초 GMT+09:00

GoogleのエンタープライズAIへの進出は感動的だね。追いつくことから先頭に立つまで、彼らは本当にゲームを上げた。でもインターフェースはもう少し改善が必要だね;ちょっとぎこちない。でも、これからどこに向かうのか楽しみだよ!🚀

0

0

2025년 4월 23일 오전 12시 53분 12초 GMT+09:00

2025년 4월 23일 오전 12시 53분 12초 GMT+09:00

Google's move into enterprise AI is impressive. From playing catch-up to leading the pack, they've really stepped up their game. But the interface could use some work; it's a bit clunky. Still, I'm excited to see where they go from here! 🚀

0

0

2025년 4월 22일 오후 4시 22분 36초 GMT+09:00

2025년 4월 22일 오후 4시 22분 36초 GMT+09:00

El movimiento sigiloso de Google en la IA empresarial es bastante genial. De ir a la zaga a liderar el grupo, realmente han dado la vuelta a la situación. La tecnología es sólida pero la interfaz podría ser más amigable para el usuario. Aún así, es impresionante lo rápido que se han movido! 🚀

0

0

2025년 4월 22일 오후 3시 10분 16초 GMT+09:00

2025년 4월 22일 오후 3시 10분 16초 GMT+09:00

A jogada furtiva do Google no AI empresarial é bem legal. De tentar alcançar a liderar o grupo, eles realmente mudaram as coisas. A tecnologia é sólida, mas a interface poderia ser mais amigável ao usuário. Ainda assim, é impressionante como eles se moveram rápido! 🚀

0

0