Google supera sigilosamente en Enterprise AI: de 'Ponte al día' a 'Aprendernos'

Hace apenas un año, el revuelo en torno a Google y la IA empresarial parecía estar en punto muerto. A pesar de tecnologías pioneras como el Transformer, el gigante tecnológico parecía rezagado, eclipsado por el éxito viral de OpenAI, la destreza en codificación de Anthropic y el agresivo avance de Microsoft en el mercado empresarial.

Pero avanzando hasta la semana pasada en Google Cloud Next 2025 en Las Vegas, la escena era marcadamente diferente. Un Google confiado, armado con modelos de alto rendimiento, una infraestructura robusta y una estrategia empresarial clara, anunció un cambio drástico. En una reunión a puerta cerrada con analistas y altos ejecutivos de Google, un analista resumió el estado de ánimo: "Esto se siente como el momento en que Google pasó de 'alcanzar' a 'alcánzanos'."

El salto adelante de Google

La sensación de que Google no solo ha alcanzado sino que ha superado a OpenAI y Microsoft en la carrera por la IA empresarial fue palpable durante todo el evento. Y no es solo exageración publicitaria. En el último año, Google se ha enfocado intensamente en la ejecución, convirtiendo su destreza tecnológica en una plataforma integrada de alto rendimiento que está ganando rápidamente a los tomadores de decisiones empresariales. Desde los modelos de IA más potentes del mundo funcionando en silicio personalizado altamente eficiente hasta un ecosistema creciente de agentes de IA adaptados a desafíos empresariales del mundo real, Google está presentando un caso sólido de que nunca estuvo realmente perdido, sino que estaba pasando por un período de desarrollo profundo y fundacional.

Con su pila integrada ahora funcionando a plena capacidad, Google parece estar listo para liderar la próxima fase de la revolución de la IA empresarial. En mis entrevistas con ejecutivos de Google en Next, enfatizaron las ventajas únicas de Google en infraestructura e integración de modelos, ventajas que competidores como OpenAI, Microsoft o AWS encontrarían difícil de replicar.

La sombra de la duda: Reconociendo el pasado reciente

Para apreciar completamente el impulso actual de Google, es esencial reconocer el pasado reciente. Google inventó la arquitectura Transformer, desencadenando la revolución moderna en modelos de lenguaje de gran escala (LLMs), y comenzó a invertir en hardware especializado para IA (TPUs) hace una década, lo que ahora impulsa una eficiencia líder en la industria. Sin embargo, inexplicablemente, hace apenas dos años y medio, Google se encontraba a la defensiva.

ChatGPT de OpenAI capturó la imaginación del público y el interés empresarial a un ritmo impresionante, convirtiéndose en la aplicación de más rápido crecimiento en la historia. Competidores como Anthropic se hicieron con nichos en áreas como la codificación. Mientras tanto, los movimientos públicos de Google a menudo parecían tentativos o defectuosos. Los tropiezos en la demostración de Bard en 2023 y la controversia sobre su generador de imágenes que producía representaciones históricamente inexactas alimentaron una narrativa de una empresa posiblemente obstaculizada por la burocracia interna o una corrección excesiva en la alineación. Google parecía perdido, recordando su lentitud inicial en la competencia de la nube, donde permanecía en un distante tercer lugar en cuota de mercado detrás de Amazon y Microsoft.

El cambio: Una decisión consciente de liderar

Sin embargo, detrás de escena, estaba ocurriendo un cambio significativo, impulsado por una decisión deliberada en los niveles más altos para reclamar el liderazgo. Mat Velloso, VP de producto para la Plataforma de Desarrolladores de IA de Google DeepMind, percibió este momento crucial al unirse a Google en febrero de 2024, después de dejar Microsoft. "Cuando llegué a Google, hablé con Sundar [Pichai], hablé con varios líderes aquí, y sentí que ese era el momento en que estaban decidiendo, de acuerdo, esto [IA generativa] es algo que claramente importa a la industria. Hagamos que ocurra," compartió Velloso durante una entrevista en Next la semana pasada.

Este impulso renovado no se vio obstaculizado por el temido "drenaje de cerebros" que algunos creían que estaba agotando a Google. En cambio, la compañía redobló esfuerzos en la ejecución a principios de 2024, marcada por contrataciones agresivas, unificación interna y tracción con los clientes. Mientras los competidores hacían contrataciones llamativas, Google retuvo a su liderazgo central en IA, incluyendo al CEO de DeepMind, Demis Hassabis, y al CEO de Google Cloud, Thomas Kurian, proporcionando estabilidad y experiencia profunda.

Además, el talento comenzó a fluir hacia la misión enfocada de Google. Logan Kilpatrick, por ejemplo, regresó a Google desde OpenAI, atraído por la oportunidad de construir IA fundacional dentro de la empresa. Se unió a Velloso en lo que describió como una "experiencia de cero a uno," encargado de construir tracción para los desarrolladores con Gemini desde cero. "Era como si el equipo fuera solo yo el primer día... no tenemos usuarios en esta plataforma, no tenemos ingresos. Nadie está interesado en Gemini en este momento," recordó Kilpatrick sobre el punto de partida. Líderes como Josh Woodward, quien ayudó a iniciar AI Studio y ahora lidera la Aplicación y Laboratorios de Gemini, y Noam Shazeer, coautor clave del artículo original de Transformer "Attention Is All You Need", también regresaron a la empresa a finales de 2024 como colíder técnico para el crucial proyecto Gemini.

Pilar 1: Gemini 2.5 y la era de los modelos pensantes

Aunque el mantra empresarial ha cambiado a "no se trata solo del modelo," tener el LLM de mejor rendimiento sigue siendo un logro significativo y un poderoso validador de la investigación superior y la arquitectura tecnológica eficiente de una empresa. Con el lanzamiento de Gemini 2.5 Pro apenas unas semanas antes de Next '25, Google reclamó decisivamente este título. Rápidamente encabezó la tabla de clasificación independiente de Chatbot Arena, superando significativamente incluso a la última variante GPT-4o de OpenAI, y destacó en pruebas de razonamiento notoriamente difíciles como el Último Examen de la Humanidad. Como afirmó Pichai en el discurso principal, "Es nuestro modelo de IA más inteligente hasta ahora. Y es el mejor modelo del mundo." El modelo había impulsado un aumento del 80 por ciento en el uso de Gemini en un mes, tuiteó por separado.

Por primera vez, la demanda por Gemini estaba en llamas. Lo que me impresionó, además de la inteligencia cruda de Gemini 2.5 Pro, fue su capacidad de razonamiento demostrable. Google ha diseñado una capacidad de "pensamiento", que permite al modelo realizar razonamiento de múltiples pasos, planificación e incluso autorreflexión antes de finalizar una respuesta. La cadena de pensamiento (CoT) estructurada y coherente, usando pasos numerados y subpuntos, evita la naturaleza divagante u opaca de las salidas de otros modelos de DeepSeek o OpenAI. Para los equipos técnicos que evalúan salidas para tareas críticas, esta transparencia permite la validación, corrección y redirección con una confianza sin precedentes.

Pero más importante para los usuarios empresariales, Gemini 2.5 Pro también cerró drásticamente la brecha en codificación, que es una de las áreas de aplicación más grandes para la IA generativa. En una entrevista con VentureBeat, la CTO Fiona Tan de la principal minorista Wayfair dijo que después de pruebas iniciales, la empresa encontró que "dio un gran paso adelante" y ahora era "bastante comparable" a Claude 3.7 Sonnet de Anthropic, anteriormente la opción preferida para muchos desarrolladores.

Google también agregó una ventana de contexto masiva de 1 millón de tokens al modelo, permitiendo el razonamiento en bases de código completas o documentación extensa, superando con creces las capacidades de los modelos de OpenAI o Anthropic. (OpenAI respondió esta semana con modelos que presentan ventanas de contexto igualmente grandes, aunque los puntos de referencia sugieren que Gemini 2.5 Pro mantiene una ventaja en el razonamiento general). Esta ventaja permite tareas de ingeniería de software complejas de múltiples archivos.

Complementando a Pro está Gemini 2.5 Flash, anunciado en Next '25 y lanzado ayer. También un modelo "pensante", Flash está optimizado para baja latencia y eficiencia de costos. Puedes controlar cuánto razona el modelo y equilibrar el rendimiento con tu presupuesto. Este enfoque escalonado refleja aún más la estrategia de "inteligencia por dólar" promovida por los ejecutivos de Google.

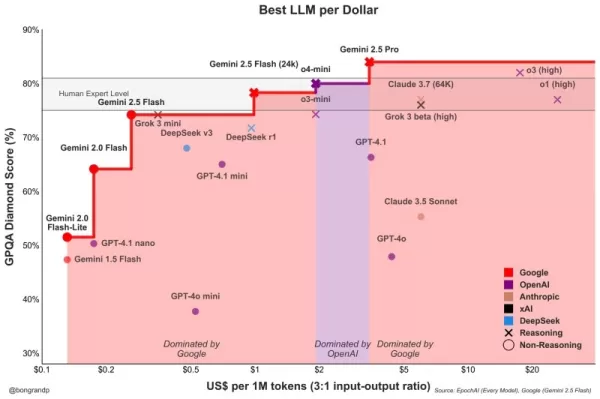

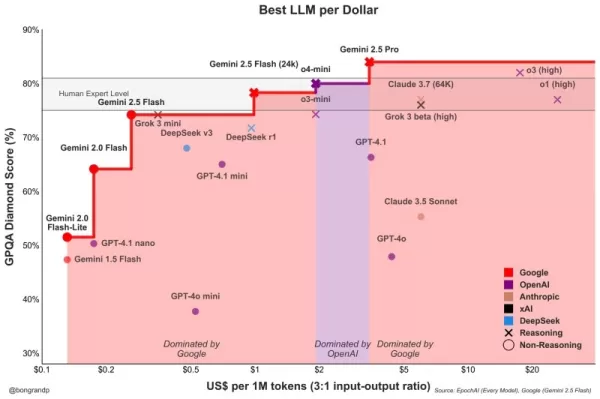

Velloso mostró un gráfico que revela que, en todo el espectro de inteligencia, los modelos de Google ofrecen el mejor valor. "Si hubiéramos tenido esta conversación hace un año... no tendría nada que mostrar," admitió Velloso, destacando el rápido cambio. "Y ahora, como, en todos los ámbitos, si buscas cualquier modelo, de cualquier tamaño, si no eres Google, estás perdiendo dinero." Gráficos similares han sido actualizados para tener en cuenta los últimos lanzamientos de modelos de OpenAI esta semana, todos mostrando lo mismo: los modelos de Google ofrecen la mejor inteligencia por dólar. Mira abajo:

Tan de Wayfair también observó mejoras prometedoras en la latencia con 2.5 Pro: "Gemini 2.5 volvió más rápido," haciendo viable su uso para "capacidades más orientadas al cliente," dijo, algo que no había sido el caso antes con otros modelos. Gemini podría convertirse en el primer modelo que Wayfair use para estas interacciones con clientes, afirmó.

Las capacidades de la familia Gemini se extienden a la multimodalidad, integrándose perfectamente con otros modelos líderes de Google como Imagen 3 (generación de imágenes), Veo 2 (generación de video), Chirp 3 (audio) y el recién anunciado Lyria (texto a música), todos accesibles a través de la plataforma de Google para usuarios empresariales, Vertex. Google es la única empresa que ofrece sus propios modelos de medios generativos en todas las modalidades en su plataforma. Microsoft, AWS y OpenAI tienen que asociarse con otras empresas para hacer esto.

Pilar 2: La destreza en infraestructura – El motor bajo el capó

La capacidad de iterar rápidamente y servir eficientemente estos modelos poderosos proviene de la infraestructura posiblemente sin igual de Google, perfeccionada durante décadas de operar servicios a escala planetaria. Central para esto es la Unidad de Procesamiento Tensorial (TPU).

En Next '25, Google presentó Ironwood, su TPU de séptima generación, diseñado explícitamente para las demandas de inferencia y "modelos pensantes." La escala es inmensa, adaptada a cargas de trabajo de IA exigentes: los pods de Ironwood incluyen más de 9,000 chips refrigerados por líquido, entregando un supuesto 42.5 exaflops de potencia de cómputo. El VP de Sistemas de ML de Google, Amin Vahdat, dijo en el escenario en Next que esto es "más de 24 veces" la potencia de cómputo del supercomputador número 1 actual del mundo.

Google afirmó que Ironwood ofrece un rendimiento por vatio 2x superior en comparación con Trillium, la generación anterior de TPU. Esto es significativo ya que los clientes empresariales dicen cada vez más que los costos y la disponibilidad de energía restringen los despliegues de IA a gran escala.

El CTO de Google Cloud, Will Grannis, enfatizó la consistencia de este progreso. Año tras año, Google está logrando mejoras de 10x, 8x, 9x, 10x en sus procesadores, dijo a VentureBeat en una entrevista, creando lo que llamó una "hiperley de Moore" para los aceleradores de IA. Dijo que los clientes están comprando el roadmap de Google, no solo su tecnología.

La posición de Google impulsó esta inversión sostenida en TPU. Necesita alimentar eficientemente servicios masivos como Search, YouTube y Gmail para más de 2 mil millones de usuarios. Esto requirió desarrollar hardware personalizado y optimizado mucho antes del actual auge de la IA generativa. Aunque Meta opera a una escala de consumidores similar, otros competidores carecían de este impulsor interno específico para el desarrollo de hardware de IA integrado verticalmente durante una década.

Ahora estas inversiones en TPU están dando frutos porque están impulsando la eficiencia no solo para sus propias aplicaciones, sino que también permiten a Google ofrecer Gemini a otros usuarios con una mejor inteligencia por dólar, todo lo demás igual.

¿Por qué no pueden los competidores de Google comprar procesadores eficientes de Nvidia, preguntas? Es cierto que los procesadores GPU de Nvidia dominan el pre-entrenamiento de LLMs. Pero la demanda del mercado ha elevado el precio de estos GPUs, y Nvidia toma una ganancia saludable para sí misma. Esto transfiere costos significativos a los usuarios de sus chips. Y también, aunque el pre-entrenamiento ha dominado el uso de chips de IA hasta ahora, esto está cambiando ahora que las empresas están realmente desplegando estas aplicaciones. Aquí es donde entra la "inferencia", y aquí los TPUs se consideran más eficientes que los GPUs para cargas de trabajo a escala.

Cuando preguntas a los ejecutivos de Google de dónde viene su principal ventaja tecnológica en IA, generalmente recurren al TPU como el más importante. Mark Lohmeyer, el VP que dirige la infraestructura de cómputo de Google, fue inequívoco: los TPUs son "ciertamente una parte altamente diferenciada de lo que hacemos... OpenAI, ellos no tienen esas capacidades."

Significativamente, Google presenta los TPUs no de forma aislada, sino como parte de la arquitectura de IA empresarial más amplia y compleja. Para los conocedores técnicos, se entiende que el rendimiento de primer nivel depende de integrar avances tecnológicos cada vez más especializados. Muchas actualizaciones fueron detalladas en Next. Vahdat describió esto como un "sistema de supercomputación," integrando hardware (TPUs, los últimos GPUs de Nvidia como Blackwell y el próximo Vera Rubin, almacenamiento avanzado como Hyperdisk Exapools, Anywhere Cache y Rapid Storage) con una pila de software unificada. Este software incluye Cluster Director para gestionar aceleradores, Pathways (el tiempo de ejecución distribuido de Gemini, ahora disponible para clientes), y llevando optimizaciones como vLLM a los TPUs, permitiendo una migración de cargas de trabajo más fácil para aquellos que previamente estaban en pilas Nvidia/PyTorch. Este sistema integrado, argumentó Vahdat, es por qué Gemini 2.0 Flash logra 24 veces mayor inteligencia por dólar, en comparación con GPT-4o.

Google también está extendiendo el alcance de su infraestructura física. Cloud WAN hace que la red de fibra privada de 2 millones de millas de baja latencia de Google esté disponible para las empresas, prometiendo un rendimiento hasta un 40% más rápido y un 40% menos de costo total de propiedad (TCO) en comparación con las redes gestionadas por los clientes.

Además, Google Distributed Cloud (GDC) permite que Gemini y el hardware de Nvidia (a través de una asociación con Dell) se ejecuten en entornos soberanos, locales o incluso aislados – una capacidad que el CEO de Nvidia, Jensen Huang, elogió como "absolutamente gigantesca" para llevar IA de vanguardia a industrias y naciones reguladas. En Next, Huang llamó a la infraestructura de Google la mejor del mundo: "Ninguna empresa es mejor en cada capa de cómputo que Google y Google Cloud," dijo.

Pilar 3: La pila completa integrada – Conectando los puntos

La ventaja estratégica de Google crece al considerar cómo estos modelos y componentes de infraestructura se tejen en una plataforma cohesiva. A diferencia de los competidores, que a menudo dependen de asociaciones para cerrar brechas, Google controla casi cada capa, permitiendo una integración más estrecha y ciclos de innovación más rápidos.

Entonces, ¿por qué importa esta integración, si un competidor como Microsoft puede simplemente asociarse con OpenAI para igualar la amplitud de infraestructura con la destreza de los modelos LLM? Los empleados de Google con los que hablé dijeron que hace una gran diferencia, y ofrecieron anécdotas para respaldarlo.

Toma la mejora significativa de la base de datos empresarial de Google, BigQuery. La base de datos ahora ofrece un grafo de conocimiento que permite a los LLMs buscar datos mucho más eficientemente, y ahora cuenta con más de cinco veces los clientes de competidores como Snowflake y Databricks. Yasmeen Ahmad, Jefa de Producto para Análisis de Datos en Google Cloud, dijo que las grandes mejoras solo fueron posibles porque los equipos de datos de Google estaban trabajando de cerca con el equipo de DeepMind. Trabajaron en casos de uso difíciles de resolver, y esto llevó a que la base de datos proporcionara un 50 por ciento más de precisión basada en consultas comunes, al menos según las pruebas internas de Google, para llegar a los datos correctos en comparación con los competidores más cercanos, dijo Ahmad a VentureBeat en una entrevista. Ahmad dijo que este tipo de integración profunda a través de la pila es cómo Google ha "superado" a la industria.

Esta cohesión interna contrasta marcadamente con la dinámica de "amigos-rivales" en Microsoft. Mientras Microsoft se asocia con OpenAI para distribuir sus modelos en la nube de Azure, Microsoft también está construyendo sus propios modelos. Mat Velloso, el ejecutivo de Google que ahora lidera el programa de desarrolladores de IA, dejó Microsoft después de frustrarse tratando de alinear los planes de Windows Copilot con las ofertas de modelos de OpenAI. "Cómo compartes tus planes de producto con otra empresa que en realidad está compitiendo contigo... Todo el asunto es una contradicción," recordó. "Aquí me siento lado a lado con las personas que están construyendo los modelos."

Esta integración habla de lo que los líderes de Google ven como su ventaja principal: su capacidad única para conectar experiencia profunda a través del espectro completo, desde la investigación fundacional y la construcción de modelos hasta el despliegue de aplicaciones a "escala planetaria" y el diseño de infraestructura.

Vertex AI sirve como el sistema nervioso central para los esfuerzos de IA empresarial de Google. Y la integración va más allá de solo las ofertas de Google. El Jardín de Modelos de Vertex ofrece más de 200 modelos curados, incluyendo los de Google, Llama 4 de Meta y numerosas opciones de código abierto. Vertex proporciona herramientas para ajuste, evaluación (incluyendo Evaluaciones impulsadas por IA, que Grannis destacó como un acelerador clave), despliegue y monitoreo. Sus capacidades de anclaje aprovechan bases de datos internas listas para IA junto con compatibilidad con bases de datos vectoriales externas. A esto se suma las nuevas ofertas de Google para anclar modelos con Google Search, el mejor motor de búsqueda del mundo.

La integración se extiende a Google Workspace. Las nuevas funciones anunciadas en Next '25, como "Ayúdame a Analizar" en Sheets (sí, Sheets ahora tiene una fórmula "=IA"), Resúmenes de Audio en Docs y Flujos de Workspace, integran aún más las capacidades de Gemini en los flujos de trabajo diarios, creando un poderoso ciclo de retroalimentación para que Google lo use para mejorar la experiencia.

Mientras impulsa su pila integrada, Google también defiende la apertura donde sirve al ecosistema. Habiendo impulsado la adopción de Kubernetes, ahora está promoviendo JAX para frameworks de IA y ahora protocolos abiertos para la comunicación entre agentes (A2A) junto con soporte para estándares existentes (MCP). Google también está ofreciendo cientos de conectores a plataformas externas desde dentro de Agentspace, que es la nueva interfaz unificada de Google para que los empleados encuentren y usen agentes. Este concepto de centro es convincente. La demostración del discurso principal de Agentspace (comenzando en 51:40) ilustra esto. Google ofrece a los usuarios agentes pre-construidos, o los empleados o desarrolladores pueden construir los suyos usando capacidades de IA sin código. O pueden incorporar agentes desde el exterior a través de conectores A2A. Se integra en el navegador Chrome para un acceso sin problemas.

Pilar 4: Enfoque en el valor empresarial y el ecosistema de agentes

Quizás el cambio más significativo es el enfoque afilado de Google en resolver problemas empresariales concretos, particularmente a través de la lente de los agentes de IA. Thomas Kurian, CEO de Google Cloud, describió tres razones por las que los clientes eligen a Google: la plataforma optimizada para IA, el enfoque multi-nube abierto que permite la conexión con TI existente, y el enfoque listo para empresas en seguridad, soberanía y cumplimiento.

Los agentes son clave para esta estrategia. Además de AgentSpace, esto también incluye:

- Bloques de construcción: El Kit de Desarrollo de Agentes (ADK) de código abierto, anunciado en Next, ya ha visto un interés significativo de los desarrolladores. El ADK simplifica la creación de sistemas multi-agente, mientras que el protocolo propuesto Agent2Agent (A2A) busca asegurar la interoperabilidad, permitiendo que los agentes construidos con diferentes herramientas (Gemini ADK, LangGraph, CrewAI, etc.) colaboren. Grannis de Google dijo que A2A anticipa los desafíos de escala y seguridad de un futuro con potencialmente cientos de miles de agentes interactuando.

- Agentes diseñados para propósitos específicos: Google mostró agentes expertos integrados en Agentspace (como NotebookLM, Generación de Ideas, Investigación Profunda) y destacó cinco categorías clave que están ganando tracción: Agentes de Clientes (impulsando herramientas como Reddit Answers, el asistente de soporte de Verizon, el drive-thru de Wendy’s), Agentes Creativos (usados por WPP, Brandtech, Sphere), Agentes de Datos (impulsando conocimientos en Mattel, Spotify, Bayer), Agentes de Codificación (Gemini Code Assist), y Agentes de Seguridad (integrados en la nueva plataforma de Seguridad Unificada de Google).

Esta estrategia integral de agentes parece estar resonando. Las conversaciones con ejecutivos de tres otras grandes empresas la semana pasada, también hablando de forma anónima debido a sensibilidades competitivas, reflejaron este entusiasmo por la estrategia de agentes de Google. El COO de Google Cloud, Francis DeSouza, confirmó en una entrevista: "Cada conversación incluye IA. Específicamente, cada conversación incluye agentes."

Kevin Laughridge, un ejecutivo en Deloitte, un gran usuario de los productos de IA de Google y distribuidor de ellos a otras empresas, describió el mercado de agentes como una "carrera por el territorio" donde los primeros movimientos de Google con protocolos y su plataforma integrada ofrecen ventajas significativas. "Quien sale primero y obtiene los agentes que realmente entregan valor – es quien va a ganar en esta carrera," dijo Laughridge en una entrevista. Dijo que el progreso de Google fue "asombroso," señalando que los agentes personalizados que Deloitte construyó hace solo un año ahora podrían replicarse "directamente desde la caja" usando Agentspace. Deloitte misma está construyendo 100 agentes en la plataforma, apuntando a funciones de oficina media como finanzas, riesgo e ingeniería, dijo.

Los puntos de prueba de los clientes están aumentando. En Next, Google citó "más de 500 clientes en producción" con IA generativa, frente a solo "docenas de prototipos" hace un año. Si Microsoft fue percibido como muy por delante hace un año, eso no parece tan obvio ahora. Dadas las guerras de relaciones públicas de todos los lados, es difícil decir quién está ganando realmente ahora de manera definitiva. Las métricas varían. El número de 500 de Google no es directamente comparable a los 400 casos de estudio que promueve Microsoft (y Microsoft, en respuesta, dijo a VentureBeat en el momento de la prensa que planea actualizar este conteo público a 600 en breve, subrayando el intenso marketing). Y si la distribución de IA de Google a través de sus aplicaciones es significativa, la distribución de Copilot de Microsoft a través de su oferta 365 es igualmente impresionante. Ambos están ahora alcanzando a millones de desarrolladores a través de APIs.

Pero los ejemplos de la tracción de Google abundan:

- Wendy’s: Desplegó un sistema de IA para drive-thru en miles de ubicaciones en solo un año, mejorando la experiencia de los empleados y la precisión de los pedidos. El CTO de Google Cloud, Will Grannis, señaló que el sistema de IA es capaz de entender jerga y filtrar el ruido de fondo, reduciendo significativamente el estrés de las interacciones con clientes en vivo. Esto libera al personal para enfocarse en la preparación y calidad de los alimentos — un cambio que Grannis llamó "un gran ejemplo de la IA optimizando operaciones del mundo real."

- Salesforce: Anunció una gran expansión, permitiendo que su plataforma se ejecute en Google Cloud por primera vez (más allá de AWS), citando la capacidad de Google para ayudarles a "innovar y optimizar."

- Honeywell & Intuit: Empresas anteriormente fuertemente asociadas con Microsoft y AWS, respectivamente, ahora asociándose con Google Cloud en iniciativas de IA.

- Bancos principales (Deutsche Bank, Wells Fargo): Aprovechando agentes y Gemini para investigación, análisis y modernización del servicio al cliente.

- Minoristas (Walmart, Mercado Libre, Lowe’s): Usando búsqueda, agentes y plataformas de datos.

Esta tracción empresarial impulsa el crecimiento general de Google Cloud, que ha superado a AWS y Azure durante los últimos tres trimestres. Google Cloud alcanzó una tasa de ejecución anualizada de $44 mil millones en 2024, frente a solo $5 mil millones en 2018.

Navegando las aguas competitivas

El ascenso de Google no significa que los competidores estén quietos. Los rápidos lanzamientos de OpenAI esta semana de GPT-4.1 (enfocado en codificación y contexto largo) y la serie o (razonamiento multimodal, uso de herramientas) demuestran la continua innovación de OpenAI. Además, la nueva actualización de la función de generación de imágenes en GPT-4o impulsó un crecimiento masivo en solo el último mes, ayudando a ChatGPT a alcanzar 800 millones de usuarios. Microsoft continúa aprovechando su vasta presencia empresarial y su asociación con OpenAI, mientras que Anthropic sigue siendo un contendiente fuerte, particularmente en aplicaciones de codificación y conscientes de la seguridad.

Sin embargo, es indiscutible que la narrativa de Google ha mejorado notablemente. Hace apenas un año, Google era visto como un competidor lento, titubeante y torpe que quizás estaba a punto de perder su oportunidad de liderar la IA en absoluto. En cambio, su pila integrada única y su firmeza corporativa han revelado algo más: Google posee capacidades de clase mundial en todo el espectro – desde el diseño de chips (TPUs) e infraestructura global hasta la investigación de modelos fundacionales (DeepMind), desarrollo de aplicaciones (Workspace, Search, YouTube) y servicios de nube empresarial (Vertex AI, BigQuery, Agentspace). "Somos el único hiperescalador que está en la conversación de modelos fundacionales," afirmó deSouza rotundamente. Esta propiedad de extremo a extremo permite optimizaciones (como "inteligencia por dólar") y una profundidad de integración que los modelos dependientes de asociaciones luchan por igualar. Los competidores a menudo necesitan unir piezas dispares, potencialmente creando fricción o limitando la velocidad de innovación.

El momento de Google es ahora

Mientras la carrera por la IA permanece dinámica, Google ha reunido todas estas piezas en el momento preciso en que el mercado las demanda. Como lo expresó Laughridge de Deloitte, Google alcanzó un punto donde sus capacidades se alinearon perfectamente "donde el mercado lo demandaba." Si estabas esperando que Google se probara en la IA empresarial, puede que hayas perdido el momento — ya lo ha hecho. La empresa que inventó muchas de las tecnologías centrales que impulsan esta revolución parece haber finalmente alcanzado – y más que eso, ahora está marcando el ritmo que los competidores necesitan igualar.

En el video a continuación, grabado justo después de Next, el experto en IA Sam Witteveen y yo desglosamos el panorama actual y las tendencias emergentes, y por qué el ecosistema de IA de Google se siente tan fuerte:

Artículo relacionado

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

El último modelo de inteligencia artificial Gemini de Google muestra un descenso en las puntuaciones de seguridad en las pruebas

Las pruebas internas de Google revelan preocupantes caídas de rendimiento en los protocolos de seguridad de su último modelo de IA en comparación con versiones anteriores. Según las pruebas comparativ

El último modelo de inteligencia artificial Gemini de Google muestra un descenso en las puntuaciones de seguridad en las pruebas

Las pruebas internas de Google revelan preocupantes caídas de rendimiento en los protocolos de seguridad de su último modelo de IA en comparación con versiones anteriores. Según las pruebas comparativ

La IA "ZeroSearch" de Alibaba reduce los costes de formación en un 88% gracias al aprendizaje autónomo

ZeroSearch de Alibaba: Un cambio en la eficiencia del entrenamiento de IALos investigadores del Grupo Alibaba han sido pioneros en un método innovador que podría revolucionar la forma en que los siste

comentario (12)

0/200

La IA "ZeroSearch" de Alibaba reduce los costes de formación en un 88% gracias al aprendizaje autónomo

ZeroSearch de Alibaba: Un cambio en la eficiencia del entrenamiento de IALos investigadores del Grupo Alibaba han sido pioneros en un método innovador que podría revolucionar la forma en que los siste

comentario (12)

0/200

![EdwardRamirez]() EdwardRamirez

EdwardRamirez

6 de agosto de 2025 07:00:59 GMT+02:00

6 de agosto de 2025 07:00:59 GMT+02:00

Google's AI comeback is wild! 😎 I thought they were out of the game, but their enterprise push is sneaky strong. Wonder if they’ll dominate the market soon?

0

0

![ThomasBaker]() ThomasBaker

ThomasBaker

22 de julio de 2025 03:25:03 GMT+02:00

22 de julio de 2025 03:25:03 GMT+02:00

Google's quiet climb in enterprise AI is wild! 😎 I thought they were out of the game, but this Transformer legacy is no joke. Curious if they’ll outpace Microsoft soon?

0

0

![RalphGarcia]() RalphGarcia

RalphGarcia

22 de abril de 2025 20:20:20 GMT+02:00

22 de abril de 2025 20:20:20 GMT+02:00

GoogleのエンタープライズAIへの進出は感動的だね。追いつくことから先頭に立つまで、彼らは本当にゲームを上げた。でもインターフェースはもう少し改善が必要だね;ちょっとぎこちない。でも、これからどこに向かうのか楽しみだよ!🚀

0

0

![FredAnderson]() FredAnderson

FredAnderson

22 de abril de 2025 17:53:12 GMT+02:00

22 de abril de 2025 17:53:12 GMT+02:00

Google's move into enterprise AI is impressive. From playing catch-up to leading the pack, they've really stepped up their game. But the interface could use some work; it's a bit clunky. Still, I'm excited to see where they go from here! 🚀

0

0

![JasonRoberts]() JasonRoberts

JasonRoberts

22 de abril de 2025 09:22:36 GMT+02:00

22 de abril de 2025 09:22:36 GMT+02:00

El movimiento sigiloso de Google en la IA empresarial es bastante genial. De ir a la zaga a liderar el grupo, realmente han dado la vuelta a la situación. La tecnología es sólida pero la interfaz podría ser más amigable para el usuario. Aún así, es impresionante lo rápido que se han movido! 🚀

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

22 de abril de 2025 08:10:16 GMT+02:00

22 de abril de 2025 08:10:16 GMT+02:00

A jogada furtiva do Google no AI empresarial é bem legal. De tentar alcançar a liderar o grupo, eles realmente mudaram as coisas. A tecnologia é sólida, mas a interface poderia ser mais amigável ao usuário. Ainda assim, é impressionante como eles se moveram rápido! 🚀

0

0

Hace apenas un año, el revuelo en torno a Google y la IA empresarial parecía estar en punto muerto. A pesar de tecnologías pioneras como el Transformer, el gigante tecnológico parecía rezagado, eclipsado por el éxito viral de OpenAI, la destreza en codificación de Anthropic y el agresivo avance de Microsoft en el mercado empresarial.

Pero avanzando hasta la semana pasada en Google Cloud Next 2025 en Las Vegas, la escena era marcadamente diferente. Un Google confiado, armado con modelos de alto rendimiento, una infraestructura robusta y una estrategia empresarial clara, anunció un cambio drástico. En una reunión a puerta cerrada con analistas y altos ejecutivos de Google, un analista resumió el estado de ánimo: "Esto se siente como el momento en que Google pasó de 'alcanzar' a 'alcánzanos'."

El salto adelante de Google

La sensación de que Google no solo ha alcanzado sino que ha superado a OpenAI y Microsoft en la carrera por la IA empresarial fue palpable durante todo el evento. Y no es solo exageración publicitaria. En el último año, Google se ha enfocado intensamente en la ejecución, convirtiendo su destreza tecnológica en una plataforma integrada de alto rendimiento que está ganando rápidamente a los tomadores de decisiones empresariales. Desde los modelos de IA más potentes del mundo funcionando en silicio personalizado altamente eficiente hasta un ecosistema creciente de agentes de IA adaptados a desafíos empresariales del mundo real, Google está presentando un caso sólido de que nunca estuvo realmente perdido, sino que estaba pasando por un período de desarrollo profundo y fundacional.

Con su pila integrada ahora funcionando a plena capacidad, Google parece estar listo para liderar la próxima fase de la revolución de la IA empresarial. En mis entrevistas con ejecutivos de Google en Next, enfatizaron las ventajas únicas de Google en infraestructura e integración de modelos, ventajas que competidores como OpenAI, Microsoft o AWS encontrarían difícil de replicar.

La sombra de la duda: Reconociendo el pasado reciente

Para apreciar completamente el impulso actual de Google, es esencial reconocer el pasado reciente. Google inventó la arquitectura Transformer, desencadenando la revolución moderna en modelos de lenguaje de gran escala (LLMs), y comenzó a invertir en hardware especializado para IA (TPUs) hace una década, lo que ahora impulsa una eficiencia líder en la industria. Sin embargo, inexplicablemente, hace apenas dos años y medio, Google se encontraba a la defensiva.

ChatGPT de OpenAI capturó la imaginación del público y el interés empresarial a un ritmo impresionante, convirtiéndose en la aplicación de más rápido crecimiento en la historia. Competidores como Anthropic se hicieron con nichos en áreas como la codificación. Mientras tanto, los movimientos públicos de Google a menudo parecían tentativos o defectuosos. Los tropiezos en la demostración de Bard en 2023 y la controversia sobre su generador de imágenes que producía representaciones históricamente inexactas alimentaron una narrativa de una empresa posiblemente obstaculizada por la burocracia interna o una corrección excesiva en la alineación. Google parecía perdido, recordando su lentitud inicial en la competencia de la nube, donde permanecía en un distante tercer lugar en cuota de mercado detrás de Amazon y Microsoft.

El cambio: Una decisión consciente de liderar

Sin embargo, detrás de escena, estaba ocurriendo un cambio significativo, impulsado por una decisión deliberada en los niveles más altos para reclamar el liderazgo. Mat Velloso, VP de producto para la Plataforma de Desarrolladores de IA de Google DeepMind, percibió este momento crucial al unirse a Google en febrero de 2024, después de dejar Microsoft. "Cuando llegué a Google, hablé con Sundar [Pichai], hablé con varios líderes aquí, y sentí que ese era el momento en que estaban decidiendo, de acuerdo, esto [IA generativa] es algo que claramente importa a la industria. Hagamos que ocurra," compartió Velloso durante una entrevista en Next la semana pasada.

Este impulso renovado no se vio obstaculizado por el temido "drenaje de cerebros" que algunos creían que estaba agotando a Google. En cambio, la compañía redobló esfuerzos en la ejecución a principios de 2024, marcada por contrataciones agresivas, unificación interna y tracción con los clientes. Mientras los competidores hacían contrataciones llamativas, Google retuvo a su liderazgo central en IA, incluyendo al CEO de DeepMind, Demis Hassabis, y al CEO de Google Cloud, Thomas Kurian, proporcionando estabilidad y experiencia profunda.

Además, el talento comenzó a fluir hacia la misión enfocada de Google. Logan Kilpatrick, por ejemplo, regresó a Google desde OpenAI, atraído por la oportunidad de construir IA fundacional dentro de la empresa. Se unió a Velloso en lo que describió como una "experiencia de cero a uno," encargado de construir tracción para los desarrolladores con Gemini desde cero. "Era como si el equipo fuera solo yo el primer día... no tenemos usuarios en esta plataforma, no tenemos ingresos. Nadie está interesado en Gemini en este momento," recordó Kilpatrick sobre el punto de partida. Líderes como Josh Woodward, quien ayudó a iniciar AI Studio y ahora lidera la Aplicación y Laboratorios de Gemini, y Noam Shazeer, coautor clave del artículo original de Transformer "Attention Is All You Need", también regresaron a la empresa a finales de 2024 como colíder técnico para el crucial proyecto Gemini.

Pilar 1: Gemini 2.5 y la era de los modelos pensantes

Aunque el mantra empresarial ha cambiado a "no se trata solo del modelo," tener el LLM de mejor rendimiento sigue siendo un logro significativo y un poderoso validador de la investigación superior y la arquitectura tecnológica eficiente de una empresa. Con el lanzamiento de Gemini 2.5 Pro apenas unas semanas antes de Next '25, Google reclamó decisivamente este título. Rápidamente encabezó la tabla de clasificación independiente de Chatbot Arena, superando significativamente incluso a la última variante GPT-4o de OpenAI, y destacó en pruebas de razonamiento notoriamente difíciles como el Último Examen de la Humanidad. Como afirmó Pichai en el discurso principal, "Es nuestro modelo de IA más inteligente hasta ahora. Y es el mejor modelo del mundo." El modelo había impulsado un aumento del 80 por ciento en el uso de Gemini en un mes, tuiteó por separado.

Por primera vez, la demanda por Gemini estaba en llamas. Lo que me impresionó, además de la inteligencia cruda de Gemini 2.5 Pro, fue su capacidad de razonamiento demostrable. Google ha diseñado una capacidad de "pensamiento", que permite al modelo realizar razonamiento de múltiples pasos, planificación e incluso autorreflexión antes de finalizar una respuesta. La cadena de pensamiento (CoT) estructurada y coherente, usando pasos numerados y subpuntos, evita la naturaleza divagante u opaca de las salidas de otros modelos de DeepSeek o OpenAI. Para los equipos técnicos que evalúan salidas para tareas críticas, esta transparencia permite la validación, corrección y redirección con una confianza sin precedentes.

Pero más importante para los usuarios empresariales, Gemini 2.5 Pro también cerró drásticamente la brecha en codificación, que es una de las áreas de aplicación más grandes para la IA generativa. En una entrevista con VentureBeat, la CTO Fiona Tan de la principal minorista Wayfair dijo que después de pruebas iniciales, la empresa encontró que "dio un gran paso adelante" y ahora era "bastante comparable" a Claude 3.7 Sonnet de Anthropic, anteriormente la opción preferida para muchos desarrolladores.

Google también agregó una ventana de contexto masiva de 1 millón de tokens al modelo, permitiendo el razonamiento en bases de código completas o documentación extensa, superando con creces las capacidades de los modelos de OpenAI o Anthropic. (OpenAI respondió esta semana con modelos que presentan ventanas de contexto igualmente grandes, aunque los puntos de referencia sugieren que Gemini 2.5 Pro mantiene una ventaja en el razonamiento general). Esta ventaja permite tareas de ingeniería de software complejas de múltiples archivos.

Complementando a Pro está Gemini 2.5 Flash, anunciado en Next '25 y lanzado ayer. También un modelo "pensante", Flash está optimizado para baja latencia y eficiencia de costos. Puedes controlar cuánto razona el modelo y equilibrar el rendimiento con tu presupuesto. Este enfoque escalonado refleja aún más la estrategia de "inteligencia por dólar" promovida por los ejecutivos de Google.

Velloso mostró un gráfico que revela que, en todo el espectro de inteligencia, los modelos de Google ofrecen el mejor valor. "Si hubiéramos tenido esta conversación hace un año... no tendría nada que mostrar," admitió Velloso, destacando el rápido cambio. "Y ahora, como, en todos los ámbitos, si buscas cualquier modelo, de cualquier tamaño, si no eres Google, estás perdiendo dinero." Gráficos similares han sido actualizados para tener en cuenta los últimos lanzamientos de modelos de OpenAI esta semana, todos mostrando lo mismo: los modelos de Google ofrecen la mejor inteligencia por dólar. Mira abajo:

Tan de Wayfair también observó mejoras prometedoras en la latencia con 2.5 Pro: "Gemini 2.5 volvió más rápido," haciendo viable su uso para "capacidades más orientadas al cliente," dijo, algo que no había sido el caso antes con otros modelos. Gemini podría convertirse en el primer modelo que Wayfair use para estas interacciones con clientes, afirmó.

Las capacidades de la familia Gemini se extienden a la multimodalidad, integrándose perfectamente con otros modelos líderes de Google como Imagen 3 (generación de imágenes), Veo 2 (generación de video), Chirp 3 (audio) y el recién anunciado Lyria (texto a música), todos accesibles a través de la plataforma de Google para usuarios empresariales, Vertex. Google es la única empresa que ofrece sus propios modelos de medios generativos en todas las modalidades en su plataforma. Microsoft, AWS y OpenAI tienen que asociarse con otras empresas para hacer esto.

Pilar 2: La destreza en infraestructura – El motor bajo el capó

La capacidad de iterar rápidamente y servir eficientemente estos modelos poderosos proviene de la infraestructura posiblemente sin igual de Google, perfeccionada durante décadas de operar servicios a escala planetaria. Central para esto es la Unidad de Procesamiento Tensorial (TPU).

En Next '25, Google presentó Ironwood, su TPU de séptima generación, diseñado explícitamente para las demandas de inferencia y "modelos pensantes." La escala es inmensa, adaptada a cargas de trabajo de IA exigentes: los pods de Ironwood incluyen más de 9,000 chips refrigerados por líquido, entregando un supuesto 42.5 exaflops de potencia de cómputo. El VP de Sistemas de ML de Google, Amin Vahdat, dijo en el escenario en Next que esto es "más de 24 veces" la potencia de cómputo del supercomputador número 1 actual del mundo.

Google afirmó que Ironwood ofrece un rendimiento por vatio 2x superior en comparación con Trillium, la generación anterior de TPU. Esto es significativo ya que los clientes empresariales dicen cada vez más que los costos y la disponibilidad de energía restringen los despliegues de IA a gran escala.

El CTO de Google Cloud, Will Grannis, enfatizó la consistencia de este progreso. Año tras año, Google está logrando mejoras de 10x, 8x, 9x, 10x en sus procesadores, dijo a VentureBeat en una entrevista, creando lo que llamó una "hiperley de Moore" para los aceleradores de IA. Dijo que los clientes están comprando el roadmap de Google, no solo su tecnología.

La posición de Google impulsó esta inversión sostenida en TPU. Necesita alimentar eficientemente servicios masivos como Search, YouTube y Gmail para más de 2 mil millones de usuarios. Esto requirió desarrollar hardware personalizado y optimizado mucho antes del actual auge de la IA generativa. Aunque Meta opera a una escala de consumidores similar, otros competidores carecían de este impulsor interno específico para el desarrollo de hardware de IA integrado verticalmente durante una década.

Ahora estas inversiones en TPU están dando frutos porque están impulsando la eficiencia no solo para sus propias aplicaciones, sino que también permiten a Google ofrecer Gemini a otros usuarios con una mejor inteligencia por dólar, todo lo demás igual.

¿Por qué no pueden los competidores de Google comprar procesadores eficientes de Nvidia, preguntas? Es cierto que los procesadores GPU de Nvidia dominan el pre-entrenamiento de LLMs. Pero la demanda del mercado ha elevado el precio de estos GPUs, y Nvidia toma una ganancia saludable para sí misma. Esto transfiere costos significativos a los usuarios de sus chips. Y también, aunque el pre-entrenamiento ha dominado el uso de chips de IA hasta ahora, esto está cambiando ahora que las empresas están realmente desplegando estas aplicaciones. Aquí es donde entra la "inferencia", y aquí los TPUs se consideran más eficientes que los GPUs para cargas de trabajo a escala.

Cuando preguntas a los ejecutivos de Google de dónde viene su principal ventaja tecnológica en IA, generalmente recurren al TPU como el más importante. Mark Lohmeyer, el VP que dirige la infraestructura de cómputo de Google, fue inequívoco: los TPUs son "ciertamente una parte altamente diferenciada de lo que hacemos... OpenAI, ellos no tienen esas capacidades."

Significativamente, Google presenta los TPUs no de forma aislada, sino como parte de la arquitectura de IA empresarial más amplia y compleja. Para los conocedores técnicos, se entiende que el rendimiento de primer nivel depende de integrar avances tecnológicos cada vez más especializados. Muchas actualizaciones fueron detalladas en Next. Vahdat describió esto como un "sistema de supercomputación," integrando hardware (TPUs, los últimos GPUs de Nvidia como Blackwell y el próximo Vera Rubin, almacenamiento avanzado como Hyperdisk Exapools, Anywhere Cache y Rapid Storage) con una pila de software unificada. Este software incluye Cluster Director para gestionar aceleradores, Pathways (el tiempo de ejecución distribuido de Gemini, ahora disponible para clientes), y llevando optimizaciones como vLLM a los TPUs, permitiendo una migración de cargas de trabajo más fácil para aquellos que previamente estaban en pilas Nvidia/PyTorch. Este sistema integrado, argumentó Vahdat, es por qué Gemini 2.0 Flash logra 24 veces mayor inteligencia por dólar, en comparación con GPT-4o.

Google también está extendiendo el alcance de su infraestructura física. Cloud WAN hace que la red de fibra privada de 2 millones de millas de baja latencia de Google esté disponible para las empresas, prometiendo un rendimiento hasta un 40% más rápido y un 40% menos de costo total de propiedad (TCO) en comparación con las redes gestionadas por los clientes.

Además, Google Distributed Cloud (GDC) permite que Gemini y el hardware de Nvidia (a través de una asociación con Dell) se ejecuten en entornos soberanos, locales o incluso aislados – una capacidad que el CEO de Nvidia, Jensen Huang, elogió como "absolutamente gigantesca" para llevar IA de vanguardia a industrias y naciones reguladas. En Next, Huang llamó a la infraestructura de Google la mejor del mundo: "Ninguna empresa es mejor en cada capa de cómputo que Google y Google Cloud," dijo.

Pilar 3: La pila completa integrada – Conectando los puntos

La ventaja estratégica de Google crece al considerar cómo estos modelos y componentes de infraestructura se tejen en una plataforma cohesiva. A diferencia de los competidores, que a menudo dependen de asociaciones para cerrar brechas, Google controla casi cada capa, permitiendo una integración más estrecha y ciclos de innovación más rápidos.

Entonces, ¿por qué importa esta integración, si un competidor como Microsoft puede simplemente asociarse con OpenAI para igualar la amplitud de infraestructura con la destreza de los modelos LLM? Los empleados de Google con los que hablé dijeron que hace una gran diferencia, y ofrecieron anécdotas para respaldarlo.

Toma la mejora significativa de la base de datos empresarial de Google, BigQuery. La base de datos ahora ofrece un grafo de conocimiento que permite a los LLMs buscar datos mucho más eficientemente, y ahora cuenta con más de cinco veces los clientes de competidores como Snowflake y Databricks. Yasmeen Ahmad, Jefa de Producto para Análisis de Datos en Google Cloud, dijo que las grandes mejoras solo fueron posibles porque los equipos de datos de Google estaban trabajando de cerca con el equipo de DeepMind. Trabajaron en casos de uso difíciles de resolver, y esto llevó a que la base de datos proporcionara un 50 por ciento más de precisión basada en consultas comunes, al menos según las pruebas internas de Google, para llegar a los datos correctos en comparación con los competidores más cercanos, dijo Ahmad a VentureBeat en una entrevista. Ahmad dijo que este tipo de integración profunda a través de la pila es cómo Google ha "superado" a la industria.

Esta cohesión interna contrasta marcadamente con la dinámica de "amigos-rivales" en Microsoft. Mientras Microsoft se asocia con OpenAI para distribuir sus modelos en la nube de Azure, Microsoft también está construyendo sus propios modelos. Mat Velloso, el ejecutivo de Google que ahora lidera el programa de desarrolladores de IA, dejó Microsoft después de frustrarse tratando de alinear los planes de Windows Copilot con las ofertas de modelos de OpenAI. "Cómo compartes tus planes de producto con otra empresa que en realidad está compitiendo contigo... Todo el asunto es una contradicción," recordó. "Aquí me siento lado a lado con las personas que están construyendo los modelos."

Esta integración habla de lo que los líderes de Google ven como su ventaja principal: su capacidad única para conectar experiencia profunda a través del espectro completo, desde la investigación fundacional y la construcción de modelos hasta el despliegue de aplicaciones a "escala planetaria" y el diseño de infraestructura.

Vertex AI sirve como el sistema nervioso central para los esfuerzos de IA empresarial de Google. Y la integración va más allá de solo las ofertas de Google. El Jardín de Modelos de Vertex ofrece más de 200 modelos curados, incluyendo los de Google, Llama 4 de Meta y numerosas opciones de código abierto. Vertex proporciona herramientas para ajuste, evaluación (incluyendo Evaluaciones impulsadas por IA, que Grannis destacó como un acelerador clave), despliegue y monitoreo. Sus capacidades de anclaje aprovechan bases de datos internas listas para IA junto con compatibilidad con bases de datos vectoriales externas. A esto se suma las nuevas ofertas de Google para anclar modelos con Google Search, el mejor motor de búsqueda del mundo.

La integración se extiende a Google Workspace. Las nuevas funciones anunciadas en Next '25, como "Ayúdame a Analizar" en Sheets (sí, Sheets ahora tiene una fórmula "=IA"), Resúmenes de Audio en Docs y Flujos de Workspace, integran aún más las capacidades de Gemini en los flujos de trabajo diarios, creando un poderoso ciclo de retroalimentación para que Google lo use para mejorar la experiencia.

Mientras impulsa su pila integrada, Google también defiende la apertura donde sirve al ecosistema. Habiendo impulsado la adopción de Kubernetes, ahora está promoviendo JAX para frameworks de IA y ahora protocolos abiertos para la comunicación entre agentes (A2A) junto con soporte para estándares existentes (MCP). Google también está ofreciendo cientos de conectores a plataformas externas desde dentro de Agentspace, que es la nueva interfaz unificada de Google para que los empleados encuentren y usen agentes. Este concepto de centro es convincente. La demostración del discurso principal de Agentspace (comenzando en 51:40) ilustra esto. Google ofrece a los usuarios agentes pre-construidos, o los empleados o desarrolladores pueden construir los suyos usando capacidades de IA sin código. O pueden incorporar agentes desde el exterior a través de conectores A2A. Se integra en el navegador Chrome para un acceso sin problemas.

Pilar 4: Enfoque en el valor empresarial y el ecosistema de agentes

Quizás el cambio más significativo es el enfoque afilado de Google en resolver problemas empresariales concretos, particularmente a través de la lente de los agentes de IA. Thomas Kurian, CEO de Google Cloud, describió tres razones por las que los clientes eligen a Google: la plataforma optimizada para IA, el enfoque multi-nube abierto que permite la conexión con TI existente, y el enfoque listo para empresas en seguridad, soberanía y cumplimiento.

Los agentes son clave para esta estrategia. Además de AgentSpace, esto también incluye:

- Bloques de construcción: El Kit de Desarrollo de Agentes (ADK) de código abierto, anunciado en Next, ya ha visto un interés significativo de los desarrolladores. El ADK simplifica la creación de sistemas multi-agente, mientras que el protocolo propuesto Agent2Agent (A2A) busca asegurar la interoperabilidad, permitiendo que los agentes construidos con diferentes herramientas (Gemini ADK, LangGraph, CrewAI, etc.) colaboren. Grannis de Google dijo que A2A anticipa los desafíos de escala y seguridad de un futuro con potencialmente cientos de miles de agentes interactuando.

- Agentes diseñados para propósitos específicos: Google mostró agentes expertos integrados en Agentspace (como NotebookLM, Generación de Ideas, Investigación Profunda) y destacó cinco categorías clave que están ganando tracción: Agentes de Clientes (impulsando herramientas como Reddit Answers, el asistente de soporte de Verizon, el drive-thru de Wendy’s), Agentes Creativos (usados por WPP, Brandtech, Sphere), Agentes de Datos (impulsando conocimientos en Mattel, Spotify, Bayer), Agentes de Codificación (Gemini Code Assist), y Agentes de Seguridad (integrados en la nueva plataforma de Seguridad Unificada de Google).

Esta estrategia integral de agentes parece estar resonando. Las conversaciones con ejecutivos de tres otras grandes empresas la semana pasada, también hablando de forma anónima debido a sensibilidades competitivas, reflejaron este entusiasmo por la estrategia de agentes de Google. El COO de Google Cloud, Francis DeSouza, confirmó en una entrevista: "Cada conversación incluye IA. Específicamente, cada conversación incluye agentes."

Kevin Laughridge, un ejecutivo en Deloitte, un gran usuario de los productos de IA de Google y distribuidor de ellos a otras empresas, describió el mercado de agentes como una "carrera por el territorio" donde los primeros movimientos de Google con protocolos y su plataforma integrada ofrecen ventajas significativas. "Quien sale primero y obtiene los agentes que realmente entregan valor – es quien va a ganar en esta carrera," dijo Laughridge en una entrevista. Dijo que el progreso de Google fue "asombroso," señalando que los agentes personalizados que Deloitte construyó hace solo un año ahora podrían replicarse "directamente desde la caja" usando Agentspace. Deloitte misma está construyendo 100 agentes en la plataforma, apuntando a funciones de oficina media como finanzas, riesgo e ingeniería, dijo.

Los puntos de prueba de los clientes están aumentando. En Next, Google citó "más de 500 clientes en producción" con IA generativa, frente a solo "docenas de prototipos" hace un año. Si Microsoft fue percibido como muy por delante hace un año, eso no parece tan obvio ahora. Dadas las guerras de relaciones públicas de todos los lados, es difícil decir quién está ganando realmente ahora de manera definitiva. Las métricas varían. El número de 500 de Google no es directamente comparable a los 400 casos de estudio que promueve Microsoft (y Microsoft, en respuesta, dijo a VentureBeat en el momento de la prensa que planea actualizar este conteo público a 600 en breve, subrayando el intenso marketing). Y si la distribución de IA de Google a través de sus aplicaciones es significativa, la distribución de Copilot de Microsoft a través de su oferta 365 es igualmente impresionante. Ambos están ahora alcanzando a millones de desarrolladores a través de APIs.

Pero los ejemplos de la tracción de Google abundan:

- Wendy’s: Desplegó un sistema de IA para drive-thru en miles de ubicaciones en solo un año, mejorando la experiencia de los empleados y la precisión de los pedidos. El CTO de Google Cloud, Will Grannis, señaló que el sistema de IA es capaz de entender jerga y filtrar el ruido de fondo, reduciendo significativamente el estrés de las interacciones con clientes en vivo. Esto libera al personal para enfocarse en la preparación y calidad de los alimentos — un cambio que Grannis llamó "un gran ejemplo de la IA optimizando operaciones del mundo real."

- Salesforce: Anunció una gran expansión, permitiendo que su plataforma se ejecute en Google Cloud por primera vez (más allá de AWS), citando la capacidad de Google para ayudarles a "innovar y optimizar."

- Honeywell & Intuit: Empresas anteriormente fuertemente asociadas con Microsoft y AWS, respectivamente, ahora asociándose con Google Cloud en iniciativas de IA.

- Bancos principales (Deutsche Bank, Wells Fargo): Aprovechando agentes y Gemini para investigación, análisis y modernización del servicio al cliente.

- Minoristas (Walmart, Mercado Libre, Lowe’s): Usando búsqueda, agentes y plataformas de datos.

Esta tracción empresarial impulsa el crecimiento general de Google Cloud, que ha superado a AWS y Azure durante los últimos tres trimestres. Google Cloud alcanzó una tasa de ejecución anualizada de $44 mil millones en 2024, frente a solo $5 mil millones en 2018.

Navegando las aguas competitivas

El ascenso de Google no significa que los competidores estén quietos. Los rápidos lanzamientos de OpenAI esta semana de GPT-4.1 (enfocado en codificación y contexto largo) y la serie o (razonamiento multimodal, uso de herramientas) demuestran la continua innovación de OpenAI. Además, la nueva actualización de la función de generación de imágenes en GPT-4o impulsó un crecimiento masivo en solo el último mes, ayudando a ChatGPT a alcanzar 800 millones de usuarios. Microsoft continúa aprovechando su vasta presencia empresarial y su asociación con OpenAI, mientras que Anthropic sigue siendo un contendiente fuerte, particularmente en aplicaciones de codificación y conscientes de la seguridad.

Sin embargo, es indiscutible que la narrativa de Google ha mejorado notablemente. Hace apenas un año, Google era visto como un competidor lento, titubeante y torpe que quizás estaba a punto de perder su oportunidad de liderar la IA en absoluto. En cambio, su pila integrada única y su firmeza corporativa han revelado algo más: Google posee capacidades de clase mundial en todo el espectro – desde el diseño de chips (TPUs) e infraestructura global hasta la investigación de modelos fundacionales (DeepMind), desarrollo de aplicaciones (Workspace, Search, YouTube) y servicios de nube empresarial (Vertex AI, BigQuery, Agentspace). "Somos el único hiperescalador que está en la conversación de modelos fundacionales," afirmó deSouza rotundamente. Esta propiedad de extremo a extremo permite optimizaciones (como "inteligencia por dólar") y una profundidad de integración que los modelos dependientes de asociaciones luchan por igualar. Los competidores a menudo necesitan unir piezas dispares, potencialmente creando fricción o limitando la velocidad de innovación.

El momento de Google es ahora

Mientras la carrera por la IA permanece dinámica, Google ha reunido todas estas piezas en el momento preciso en que el mercado las demanda. Como lo expresó Laughridge de Deloitte, Google alcanzó un punto donde sus capacidades se alinearon perfectamente "donde el mercado lo demandaba." Si estabas esperando que Google se probara en la IA empresarial, puede que hayas perdido el momento — ya lo ha hecho. La empresa que inventó muchas de las tecnologías centrales que impulsan esta revolución parece haber finalmente alcanzado – y más que eso, ahora está marcando el ritmo que los competidores necesitan igualar.

En el video a continuación, grabado justo después de Next, el experto en IA Sam Witteveen y yo desglosamos el panorama actual y las tendencias emergentes, y por qué el ecosistema de IA de Google se siente tan fuerte:

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

La IA "ZeroSearch" de Alibaba reduce los costes de formación en un 88% gracias al aprendizaje autónomo

ZeroSearch de Alibaba: Un cambio en la eficiencia del entrenamiento de IALos investigadores del Grupo Alibaba han sido pioneros en un método innovador que podría revolucionar la forma en que los siste

La IA "ZeroSearch" de Alibaba reduce los costes de formación en un 88% gracias al aprendizaje autónomo

ZeroSearch de Alibaba: Un cambio en la eficiencia del entrenamiento de IALos investigadores del Grupo Alibaba han sido pioneros en un método innovador que podría revolucionar la forma en que los siste

6 de agosto de 2025 07:00:59 GMT+02:00

6 de agosto de 2025 07:00:59 GMT+02:00

Google's AI comeback is wild! 😎 I thought they were out of the game, but their enterprise push is sneaky strong. Wonder if they’ll dominate the market soon?

0

0

22 de julio de 2025 03:25:03 GMT+02:00

22 de julio de 2025 03:25:03 GMT+02:00

Google's quiet climb in enterprise AI is wild! 😎 I thought they were out of the game, but this Transformer legacy is no joke. Curious if they’ll outpace Microsoft soon?

0

0

22 de abril de 2025 20:20:20 GMT+02:00

22 de abril de 2025 20:20:20 GMT+02:00

GoogleのエンタープライズAIへの進出は感動的だね。追いつくことから先頭に立つまで、彼らは本当にゲームを上げた。でもインターフェースはもう少し改善が必要だね;ちょっとぎこちない。でも、これからどこに向かうのか楽しみだよ!🚀

0

0

22 de abril de 2025 17:53:12 GMT+02:00

22 de abril de 2025 17:53:12 GMT+02:00

Google's move into enterprise AI is impressive. From playing catch-up to leading the pack, they've really stepped up their game. But the interface could use some work; it's a bit clunky. Still, I'm excited to see where they go from here! 🚀

0

0

22 de abril de 2025 09:22:36 GMT+02:00

22 de abril de 2025 09:22:36 GMT+02:00

El movimiento sigiloso de Google en la IA empresarial es bastante genial. De ir a la zaga a liderar el grupo, realmente han dado la vuelta a la situación. La tecnología es sólida pero la interfaz podría ser más amigable para el usuario. Aún así, es impresionante lo rápido que se han movido! 🚀

0

0

22 de abril de 2025 08:10:16 GMT+02:00

22 de abril de 2025 08:10:16 GMT+02:00

A jogada furtiva do Google no AI empresarial é bem legal. De tentar alcançar a liderar o grupo, eles realmente mudaram as coisas. A tecnologia é sólida, mas a interface poderia ser mais amigável ao usuário. Ainda assim, é impressionante como eles se moveram rápido! 🚀

0

0