Google lén lút vượt qua doanh nghiệp AI: Từ 'bắt kịp' đến 'bắt chúng tôi'

Chỉ một năm trước, sự chú ý xung quanh Google và AI doanh nghiệp dường như đang bị kẹt ở trạng thái trung lập. Mặc dù sở hữu những công nghệ tiên phong như Transformer, gã khổng lồ công nghệ này dường như bị tụt hậu, bị lu mờ bởi thành công lan truyền của OpenAI, năng lực lập trình của Anthropic và sự thúc đẩy mạnh mẽ của Microsoft vào thị trường doanh nghiệp.

Nhưng tại Google Cloud Next 2025 ở Las Vegas tuần trước, khung cảnh đã hoàn toàn khác. Một Google tự tin, được trang bị các mô hình hàng đầu, cơ sở hạ tầng mạnh mẽ và chiến lược doanh nghiệp rõ ràng, đã công bố một sự lội ngược dòng ngoạn mục. Trong một cuộc họp kín với các nhà phân tích cấp cao của Google, một nhà phân tích đã tóm tắt tâm trạng: "Cảm giác như đây là khoảnh khắc Google chuyển từ 'đuổi theo' sang 'hãy đuổi kịp chúng tôi.'"

Bước Nhảy Vọt của Google

Cảm nhận rằng Google không chỉ bắt kịp mà còn vượt qua OpenAI và Microsoft trong cuộc đua AI doanh nghiệp đã lan tỏa khắp sự kiện. Và đó không chỉ là chiêu trò tiếp thị. Trong năm qua, Google đã tập trung mạnh mẽ vào việc thực thi, biến năng lực công nghệ của mình thành một nền tảng tích hợp hiệu suất cao, nhanh chóng thu phục các nhà ra quyết định doanh nghiệp. Từ các mô hình AI mạnh mẽ nhất thế giới chạy trên silicon tùy chỉnh hiệu quả cao đến một hệ sinh thái đang phát triển của các tác nhân AI được thiết kế cho các thách thức kinh doanh thực tế, Google đang đưa ra một lập luận thuyết phục rằng họ chưa bao giờ thực sự lạc lối mà chỉ đang trải qua một giai đoạn phát triển nền tảng sâu sắc.

Với nền tảng tích hợp giờ đây hoạt động hết công suất, Google dường như đã sẵn sàng dẫn đầu giai đoạn tiếp theo của cuộc cách mạng AI doanh nghiệp. Trong các cuộc phỏng vấn với các giám đốc điều hành Google tại Next, họ nhấn mạnh lợi thế độc đáo của Google về cơ sở hạ tầng và tích hợp mô hình—những lợi thế mà các đối thủ như OpenAI, Microsoft hay AWS khó có thể sao chép.

Bóng Ma Nghi Ngờ: Nhìn Lại Gần Đây

Để đánh giá đầy đủ động lực hiện tại của Google, cần phải nhìn nhận quá khứ gần đây. Google đã phát minh ra kiến trúc Transformer, khởi nguồn cho cuộc cách mạng hiện đại trong các mô hình ngôn ngữ lớn (LLMs), và bắt đầu đầu tư vào phần cứng AI chuyên dụng (TPUs) từ một thập kỷ trước, giờ đây mang lại hiệu quả hàng đầu trong ngành. Tuy nhiên, thật khó hiểu, chỉ hai năm rưỡi trước, Google đã thấy mình phải phòng thủ.

ChatGPT của OpenAI đã thu hút trí tưởng tượng của công chúng và sự quan tâm của doanh nghiệp với tốc độ chóng mặt, trở thành ứng dụng phát triển nhanh nhất trong lịch sử. Các đối thủ như Anthropic đã chiếm lĩnh các ngách như lập trình. Trong khi đó, các động thái công khai của Google thường dường như do dự hoặc sai lầm. Những thất bại trong demo Bard khét tiếng vào năm 2023 và tranh cãi về trình tạo hình ảnh của họ tạo ra các mô tả lịch sử không chính xác đã nuôi dưỡng một câu chuyện về một công ty có thể bị cản trở bởi bộ máy quan liêu nội bộ hoặc điều chỉnh quá mức về định hướng. Google dường như lạc lối, giống như sự chậm trễ ban đầu trong cuộc cạnh tranh đám mây, nơi họ vẫn đứng thứ ba xa vời về thị phần sau Amazon và Microsoft.

Bước Ngoặt: Quyết Định Có Ý Thức Để Dẫn Đầu

Tuy nhiên, đằng sau hậu trường, một sự thay đổi đáng kể đang diễn ra, được thúc đẩy bởi quyết định có chủ ý ở cấp cao nhất nhằm giành lại vị trí dẫn đầu. Mat Velloso, Phó Chủ tịch sản phẩm của Google DeepMind’s AI Developer Platform, đã cảm nhận được khoảnh khắc then chốt này khi gia nhập Google vào tháng 2 năm 2024, sau khi rời Microsoft. "Khi tôi đến Google, tôi đã nói chuyện với Sundar [Pichai], tôi đã nói chuyện với một vài lãnh đạo ở đây, và tôi cảm thấy như đó là khoảnh khắc họ quyết định, được rồi, [AI tạo sinh] là một thứ mà ngành công nghiệp rõ ràng quan tâm. Hãy biến nó thành hiện thực," Velloso chia sẻ trong một cuộc phỏng vấn tại Next tuần trước.

Động lực mới này không bị cản trở bởi "chảy máu chất xám" mà một số người ngoài cuộc lo ngại đang làm suy yếu Google. Thay vào đó, công ty đã tăng gấp đôi nỗ lực thực thi vào đầu năm 2024, được đánh dấu bởi việc tuyển dụng tích cực, thống nhất nội bộ và thu hút khách hàng. Trong khi các đối thủ thực hiện các vụ tuyển dụng đình đám, Google đã giữ lại đội ngũ lãnh đạo AI cốt lõi, bao gồm CEO DeepMind Demis Hassabis và CEO Google Cloud Thomas Kurian, mang lại sự ổn định và chuyên môn sâu sắc.

Hơn nữa, nhân tài bắt đầu đổ về sứ mệnh tập trung của Google. Logan Kilpatrick, chẳng hạn, đã quay lại Google từ OpenAI, bị thu hút bởi cơ hội xây dựng AI nền tảng trong công ty. Anh ấy cùng Velloso trong cái mà anh mô tả là một "trải nghiệm từ con số không," được giao nhiệm vụ xây dựng sức hút cho nhà phát triển đối với Gemini từ đầu. "Cảm giác như đội ngũ chỉ có tôi vào ngày đầu tiên... chúng tôi thực sự không có người dùng trên nền tảng này, chúng tôi không có doanh thu. Không ai quan tâm đến Gemini vào lúc này," Kilpatrick nhớ lại về điểm khởi đầu. Các lãnh đạo như Josh Woodward, người đã giúp khởi động AI Studio và hiện dẫn đầu Gemini App và Labs, và Noam Shazeer, đồng tác giả chính của bài báo Transformer "Attention Is All You Need", cũng quay lại công ty vào cuối năm 2024 với vai trò đồng lãnh đạo kỹ thuật cho dự án Gemini quan trọng.

Trụ Cột 1: Gemini 2.5 và Kỷ Nguyên của Các Mô Hình Tư Duy

Dù khẩu hiệu doanh nghiệp đã chuyển sang "không chỉ là về mô hình," việc sở hữu LLM hiệu suất tốt nhất vẫn là một thành tựu lớn và là một minh chứng mạnh mẽ cho nghiên cứu vượt trội và kiến trúc công nghệ hiệu quả của một công ty. Với việc phát hành Gemini 2.5 Pro chỉ vài tuần trước Next '25, Google đã quyết liệt giành lấy vị trí này. Nó nhanh chóng dẫn đầu bảng xếp hạng độc lập Chatbot Arena, vượt xa biến thể GPT-4o mới nhất của OpenAI, và xuất sắc trong các bài kiểm tra lý luận khó khăn như Humanity’s Last Exam. Như Pichai phát biểu trong bài phát biểu chính, "Đây là mô hình AI thông minh nhất của chúng tôi từ trước đến nay. Và nó là mô hình tốt nhất trên thế giới." Mô hình này đã thúc đẩy sự tăng 80% trong việc sử dụng Gemini chỉ trong một tháng, ông ấy đã đăng trên X riêng.

Lần đầu tiên, nhu cầu về Gemini bùng nổ. Điều khiến tôi ấn tượng, ngoài trí thông minh vượt trội của Gemini 2.5 Pro, là khả năng lý luận được chứng minh của nó. Google đã thiết kế một khả năng "tư duy", cho phép mô hình thực hiện lý luận nhiều bước, lập kế hoạch và thậm chí tự phản ánh trước khi đưa ra phản hồi cuối cùng. Chuỗi tư duy (CoT) có cấu trúc, mạch lạc – sử dụng các bước được đánh số và các dấu đầu dòng phụ – tránh được tính chất lan man hoặc không rõ ràng của đầu ra từ các mô hình khác như DeepSeek hoặc OpenAI. Đối với các đội kỹ thuật đánh giá đầu ra cho các nhiệm vụ quan trọng, sự minh bạch này cho phép xác nhận, sửa chữa và định hướng lại với sự tự tin chưa từng có.

Nhưng quan trọng hơn đối với người dùng doanh nghiệp, Gemini 2.5 Pro cũng đã thu hẹp đáng kể khoảng cách trong lập trình, một trong những lĩnh vực ứng dụng lớn nhất cho AI tạo sinh. Trong một cuộc phỏng vấn với VentureBeat, CTO Fiona Tan của nhà bán lẻ hàng đầu Wayfair cho biết sau các thử nghiệm ban đầu, công ty nhận thấy nó "đã tiến bộ khá nhiều" và giờ đây "khá tương đương" với Claude 3.7 Sonnet của Anthropic, trước đây là lựa chọn ưu tiên của nhiều nhà phát triển.

Google cũng đã thêm một cửa sổ ngữ cảnh khổng lồ 1 triệu token vào mô hình, cho phép lý luận trên toàn bộ cơ sở mã hoặc tài liệu dài, vượt xa khả năng của các mô hình từ OpenAI hoặc Anthropic. (OpenAI đã phản hồi tuần này với các mô hình có cửa sổ ngữ cảnh lớn tương tự, mặc dù các điểm chuẩn cho thấy Gemini 2.5 Pro vẫn giữ lợi thế trong lý luận tổng thể). Lợi thế này cho phép thực hiện các nhiệm vụ kỹ thuật phần mềm phức tạp, đa tệp.

Bổ sung cho Pro là Gemini 2.5 Flash, được công bố tại Next '25 và phát hành ngay hôm qua. Cũng là một mô hình "tư duy", Flash được tối ưu hóa cho độ trễ thấp và hiệu quả chi phí. Bạn có thể kiểm soát mức độ lý luận của mô hình và cân bằng hiệu suất với ngân sách của mình. Cách tiếp cận phân cấp này phản ánh thêm chiến lược "trí thông minh trên mỗi đô la" được các giám đốc điều hành Google ủng hộ.

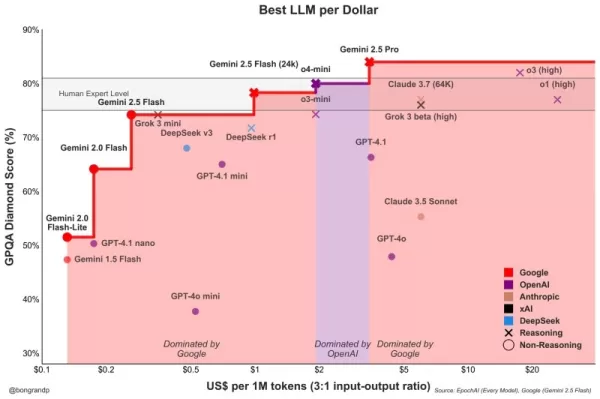

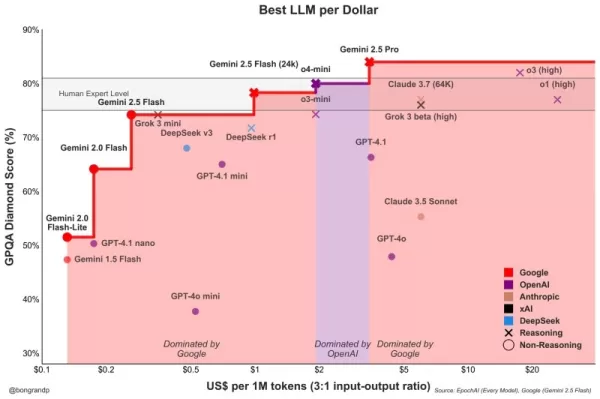

Velloso đã trình bày một biểu đồ cho thấy trên toàn phổ trí thông minh, các mô hình Google mang lại giá trị tốt nhất. "Nếu chúng ta có cuộc trò chuyện này một năm trước… tôi sẽ chẳng có gì để trình bày," Velloso thừa nhận, nhấn mạnh sự lội ngược dòng nhanh chóng. "Và giờ đây, trên mọi phương diện, nếu bạn đang tìm kiếm bất kỳ mô hình nào, bất kỳ kích thước nào, nếu bạn không phải là Google, bạn đang mất tiền." Các biểu đồ tương tự đã được cập nhật để tính đến các bản phát hành mô hình mới nhất của OpenAI tuần này, tất cả đều cho thấy điều tương tự: các mô hình của Google cung cấp trí thông minh tốt nhất trên mỗi đô la. Xem bên dưới:

Tan của Wayfair cũng nhận thấy những cải tiến đầy hứa hẹn về độ trễ với 2.5 Pro: "Gemini 2.5 phản hồi nhanh hơn," khiến nó khả thi cho "các khả năng hướng tới khách hàng hơn," cô ấy nói, điều mà cô cho biết trước đây chưa từng có với các mô hình khác. Gemini có thể trở thành mô hình đầu tiên Wayfair sử dụng cho các tương tác với khách hàng này, cô ấy nói.

Khả năng của gia đình Gemini mở rộng sang đa phương thức, tích hợp liền mạch với các mô hình hàng đầu khác của Google như Imagen 3 (tạo hình ảnh), Veo 2 (tạo video), Chirp 3 (âm thanh), và mới công bố Lyria (chuyển văn bản thành nhạc), tất cả đều có thể truy cập qua nền tảng Vertex của Google dành cho người dùng Doanh nghiệp. Google là công ty duy nhất cung cấp các mô hình truyền thông tạo sinh của riêng mình trên tất cả các phương thức trên nền tảng của họ. Microsoft, AWS và OpenAI phải hợp tác với các công ty khác để làm điều này.

Trụ Cột 2: Sức Mạnh Cơ Sở Hạ Tầng – Động Cơ Dưới Nắp Capo

Khả năng lặp lại nhanh chóng và phục vụ hiệu quả các mô hình mạnh mẽ này bắt nguồn từ cơ sở hạ tầng có lẽ là vô song của Google, được mài giũa qua hàng thập kỷ vận hành các dịch vụ quy mô toàn cầu. Trung tâm của điều này là Đơn vị Xử lý Tensor (TPU).

Tại Next '25, Google đã công bố Ironwood, TPU thế hệ thứ bảy, được thiết kế rõ ràng cho các nhu cầu suy luận và "mô hình tư duy." Quy mô là khổng lồ, được thiết kế cho các khối lượng công việc AI đòi hỏi cao: các pod Ironwood chứa hơn 9.000 chip làm mát bằng chất lỏng, mang lại sức mạnh tính toán được tuyên bố là 42.5 exaflops. Phó Chủ tịch Hệ thống ML của Google, Amin Vahdat, cho biết trên sân khấu tại Next rằng điều này "hơn 24 lần" sức mạnh tính toán của siêu máy tính số 1 thế giới hiện tại.

Google tuyên bố rằng Ironwood cung cấp hiệu suất trên mỗi watt gấp đôi so với Trillium, thế hệ TPU trước đó. Điều này rất quan trọng vì khách hàng doanh nghiệp ngày càng cho rằng chi phí năng lượng và tính sẵn có hạn chế các triển khai AI quy mô lớn.

CTO Google Cloud Will Grannis nhấn mạnh sự nhất quán của tiến trình này. Hàng năm, Google đạt được các cải tiến 10x, 8x, 9x, 10x trong các bộ xử lý của mình, ông nói với VentureBeat trong một cuộc phỏng vấn, tạo ra cái mà ông gọi là "luật Moore siêu tốc" cho các bộ tăng tốc AI. Ông nói khách hàng đang mua lộ trình của Google, không chỉ công nghệ của họ.

Vị thế của Google đã thúc đẩy đầu tư TPU bền vững này. Họ cần cung cấp năng lượng hiệu quả cho các dịch vụ khổng lồ như Search, YouTube và Gmail cho hơn 2 tỷ người dùng. Điều này đòi hỏi phát triển phần cứng tùy chỉnh, tối ưu hóa từ lâu trước khi bùng nổ AI tạo sinh hiện tại. Trong khi Meta hoạt động ở quy mô người dùng tương tự, các đối thủ khác thiếu động lực nội bộ cụ thể này cho việc phát triển phần cứng AI tích hợp dọc trong suốt một thập kỷ.

Giờ đây, những khoản đầu tư TPU này đang được đền đáp vì chúng mang lại hiệu quả không chỉ cho các ứng dụng của chính Google mà còn cho phép Google cung cấp Gemini cho người dùng khác với trí thông minh tốt hơn trên mỗi đô la, tất cả đều bình đẳng.

Tại sao các đối thủ của Google không thể mua bộ xử lý hiệu quả từ Nvidia, bạn hỏi? Đúng là các bộ xử lý GPU của Nvidia thống trị quá trình huấn luyện trước của LLMs. Nhưng nhu cầu thị trường đã đẩy giá các GPU này lên, và Nvidia lấy một phần lợi nhuận đáng kể cho chính mình. Điều này chuyển chi phí đáng kể cho người dùng chip của họ. Và cũng vậy, trong khi huấn luyện trước đã thống trị việc sử dụng chip AI cho đến nay, điều này đang thay đổi khi các doanh nghiệp thực sự triển khai các ứng dụng này. Đây là nơi "suy luận" xuất hiện, và ở đây TPUs được coi là hiệu quả hơn GPU cho các khối lượng công việc quy mô lớn.

Khi bạn hỏi các giám đốc điều hành Google lợi thế công nghệ chính của họ trong AI đến từ đâu, họ thường quay lại với TPU như yếu tố quan trọng nhất. Mark Lohmeyer, Phó Chủ tịch phụ trách cơ sở hạ tầng tính toán của Google, thẳng thắn: TPUs là "chắc chắn một phần rất khác biệt trong những gì chúng tôi làm… OpenAI, họ không có những khả năng đó."

Đáng chú ý, Google trình bày TPUs không phải riêng lẻ, mà là một phần của kiến trúc AI doanh nghiệp phức tạp hơn. Đối với những người trong ngành kỹ thuật, hiểu rằng hiệu suất hàng đầu phụ thuộc vào việc tích hợp các đột phá công nghệ ngày càng chuyên biệt. Nhiều cập nhật đã được trình bày chi tiết tại Next. Vahdat mô tả đây là một "hệ thống siêu tính toán," tích hợp phần cứng (TPUs, GPU mới nhất của Nvidia như Blackwell và sắp tới Vera Rubin, lưu trữ tiên tiến như Hyperdisk Exapools, Anywhere Cache, và Rapid Storage) với một ngăn xếp phần mềm thống nhất. Phần mềm này bao gồm Cluster Director để quản lý các bộ tăng tốc, Pathways (thời gian chạy phân tán của Gemini, giờ đây có sẵn cho khách hàng), và mang các tối ưu hóa như vLLM đến TPUs, cho phép di chuyển khối lượng công việc dễ dàng hơn cho những người trước đây sử dụng ngăn xếp Nvidia/PyTorch. Hệ thống tích hợp này, Vahdat lập luận, là lý do Gemini 2.0 Flash đạt được trí thông minh cao hơn 24 lần trên mỗi đô la, so với GPT-4o.

Google cũng đang mở rộng phạm vi cơ sở hạ tầng vật lý của mình. Cloud WAN khiến mạng cáp quang riêng dài 2 triệu dặm, độ trễ thấp của Google trở nên доступ cho các doanh nghiệp, hứa hẹn hiệu suất nhanh hơn tới 40% và tổng chi phí sở hữu (TCO) thấp hơn 40% so với các mạng do khách hàng quản lý.

Hơn nữa, Google Distributed Cloud (GDC) cho phép Gemini và phần cứng Nvidia (thông qua quan hệ đối tác với Dell) chạy trong các môi trường chủ quyền, tại chỗ, hoặc thậm chí cách ly – một khả năng mà CEO Nvidia Jensen Huang ca ngợi là "vô cùng lớn lao" trong việc mang AI hiện đại đến các ngành công nghiệp và quốc gia có quy định chặt chẽ. Tại Next, Huang gọi cơ sở hạ tầng của Google là tốt nhất thế giới: "Không công ty nào giỏi ở mọi tầng tính toán như Google và Google Cloud," ông nói.

Trụ Cột 3: Ngăn Xếp Tích Hợp Toàn Diện – Kết Nối Các Điểm

Lợi thế chiến lược của Google tăng lên khi xem xét cách các mô hình và thành phần cơ sở hạ tầng này được đan xen vào một nền tảng gắn kết. Không giống như các đối thủ, thường dựa vào quan hệ đối tác để lấp các khoảng trống, Google kiểm soát gần như mọi tầng, cho phép tích hợp chặt chẽ hơn và chu kỳ đổi mới nhanh hơn.

Vậy tại sao tích hợp này lại quan trọng, nếu một đối thủ như Microsoft có thể đơn giản hợp tác với OpenAI để kết hợp chiều rộng cơ sở hạ tầng với năng lực mô hình LLM? Những người Google mà tôi nói chuyện cho biết điều này tạo ra sự khác biệt lớn, và họ đưa ra các câu chuyện để chứng minh.

Hãy xem xét sự cải tiến đáng kể của cơ sở dữ liệu doanh nghiệp BigQuery của Google. Cơ sở dữ liệu này giờ đây cung cấp một đồ thị tri thức cho phép LLMs tìm kiếm dữ liệu hiệu quả hơn nhiều, và hiện tự hào có số lượng khách hàng gấp hơn năm lần so với các đối thủ như Snowflake và Databricks. Yasmeen Ahmad, Trưởng phòng Sản phẩm Phân tích Dữ liệu tại Google Cloud, cho biết những cải tiến lớn chỉ có thể đạt được vì các đội dữ liệu của Google làm việc chặt chẽ với đội DeepMind. Họ đã giải quyết các trường hợp sử dụng khó, và điều này dẫn đến cơ sở dữ liệu cung cấp độ chính xác cao hơn 50% dựa trên các truy vấn phổ biến, ít nhất theo thử nghiệm nội bộ của Google, trong việc truy xuất dữ liệu đúng so với đối thủ gần nhất, Ahmad nói với VentureBeat trong một cuộc phỏng vấn. Ahmad cho biết sự tích hợp sâu sắc này trên toàn ngăn xếp là cách Google đã "vượt mặt" ngành công nghiệp.

Sự gắn kết nội bộ này tương phản rõ rệt với động lực "bạn-thù" tại Microsoft. Trong khi Microsoft hợp tác với OpenAI để phân phối các mô hình của họ trên đám mây Azure, Microsoft cũng đang xây dựng các mô hình riêng. Mat Velloso, giám đốc điều hành Google hiện dẫn đầu chương trình nhà phát triển AI, đã rời Microsoft sau khi thất vọng khi cố gắng điều chỉnh kế hoạch Windows Copilot với các sản phẩm mô hình của OpenAI. "Làm sao bạn chia sẻ kế hoạch sản phẩm của mình với một công ty khác thực sự đang cạnh tranh với bạn… Toàn bộ chuyện này là một mâu thuẫn," ông nhớ lại. "Ở đây tôi ngồi cạnh những người đang xây dựng các mô hình."

Sự tích hợp này nói lên điều mà các lãnh đạo Google coi là lợi thế cốt lõi của họ: khả năng độc đáo trong việc kết nối chuyên môn sâu sắc trên toàn phổ, từ nghiên cứu nền tảng và xây dựng mô hình đến triển khai ứng dụng và thiết kế cơ sở hạ tầng quy mô toàn cầu.

Vertex AI đóng vai trò như hệ thần kinh trung ương cho các nỗ lực AI doanh nghiệp của Google. Và sự tích hợp không chỉ dừng ở các sản phẩm của chính Google. Model Garden của Vertex cung cấp hơn 200 mô hình được tuyển chọn, bao gồm của Google, Llama 4 của Meta, và nhiều tùy chọn mã nguồn mở. Vertex cung cấp các công cụ để điều chỉnh, đánh giá (bao gồm Đánh giá do AI cung cấp, mà Grannis nhấn mạnh là một bộ tăng tốc quan trọng), triển khai và giám sát. Khả năng căn cứ của nó tận dụng các cơ sở dữ liệu sẵn sàng AI nội bộ cùng với khả năng tương thích với các cơ sở dữ liệu vector bên ngoài. Thêm vào đó là các sản phẩm mới của Google để căn cứ các mô hình với Google Search, công cụ tìm kiếm tốt nhất thế giới.

Sự tích hợp mở rộng đến Google Workspace. Các tính năng mới được công bố tại Next '25, như "Help Me Analyze" trong Sheets (vâng, Sheets giờ có công thức "=AI"), Tổng quan Âm thanh trong Docs và Workspace Flows, tiếp tục nhúng khả năng của Gemini vào các luồng công việc hàng ngày, tạo ra một vòng phản hồi mạnh mẽ để Google sử dụng nhằm cải thiện trải nghiệm.

Trong khi thúc đẩy ngăn xếp tích hợp của mình, Google cũng ủng hộ tính mở nơi nó phục vụ hệ sinh thái. Sau khi thúc đẩy việc áp dụng Kubernetes, giờ đây họ đang quảng bá JAX cho các khung AI và các giao thức mở cho giao tiếp giữa các tác nhân (A2A) cùng với hỗ trợ cho các tiêu chuẩn hiện có (MCP). Google cũng cung cấp hàng trăm đầu nối đến các nền tảng bên ngoài từ trong Agentspace, giao diện thống nhất mới của Google để nhân viên tìm và sử dụng các tác nhân. Khái niệm trung tâm này rất hấp dẫn. Phần trình diễn chính của Agentspace (bắt đầu từ 51:40) minh họa điều này. Google cung cấp cho người dùng các tác nhân được xây dựng sẵn, hoặc nhân viên hoặc nhà phát triển có thể tự xây dựng bằng khả năng AI không mã. Hoặc họ có thể kéo các tác nhân từ bên ngoài thông qua các đầu nối A2A. Nó tích hợp vào trình duyệt Chrome để truy cập liền mạch.

Trụ Cột 4: Tập Trung vào Giá Trị Doanh Nghiệp và Hệ Sinh Thái Tác Nhân

Có lẽ sự thay đổi quan trọng nhất là sự tập trung sắc bén của Google vào giải quyết các vấn đề doanh nghiệp cụ thể, đặc biệt thông qua lăng kính của các tác nhân AI. Thomas Kurian, CEO Google Cloud, đã nêu ra ba lý do khách hàng chọn Google: nền tảng tối ưu hóa AI, cách tiếp cận đa đám mây mở cho phép kết nối với CNTT hiện có, và sự tập trung sẵn sàng cho doanh nghiệp vào bảo mật, chủ quyền và tuân thủ.

Các tác nhân là chìa khóa cho chiến lược này. Ngoài AgentSpace, điều này còn bao gồm:

- Khối Xây Dựng: Bộ Phát triển Tác nhân mã nguồn mở (ADK), được công bố tại Next, đã thu hút sự quan tâm đáng kể từ các nhà phát triển. ADK đơn giản hóa việc tạo ra các hệ thống đa tác nhân, trong khi giao thức Agent2Agent (A2A) được đề xuất nhằm đảm bảo khả năng tương tác, cho phép các tác nhân được xây dựng với các công cụ khác nhau (Gemini ADK, LangGraph, CrewAI, v.v.) hợp tác. Grannis của Google cho biết A2A dự đoán các thách thức về quy mô và bảo mật của một tương lai với tiềm năng hàng trăm ngàn tác nhân tương tác.

- Tác Nhân Chuyên Dụng: Google đã giới thiệu các tác nhân chuyên gia tích hợp vào Agentspace (như NotebookLM, Tạo Ý tưởng, Nghiên cứu Sâu) và nhấn mạnh năm danh mục đang thu hút: Tác nhân Khách hàng (cung cấp sức mạnh cho các công cụ như Reddit Answers, trợ lý hỗ trợ của Verizon, quầy drive-thru của Wendy’s), Tác nhân Sáng tạo (được WPP, Brandtech, Sphere sử dụng), Tác nhân Dữ liệu (đưa ra thông tin tại Mattel, Spotify, Bayer), Tác nhân Lập trình (Gemini Code Assist), và Tác nhân Bảo mật (tích hợp vào nền tảng Bảo mật Thống nhất mới của Google).

Chiến lược tác nhân toàn diện này dường như đang gây tiếng vang. Các cuộc trò chuyện với các giám đốc điều hành tại ba doanh nghiệp lớn khác trong tuần qua, cũng nói chuyện ẩn danh do nhạy cảm cạnh tranh, đã lặp lại sự hào hứng với chiến lược tác nhân của Google. COO Google Cloud Francis DeSouza xác nhận trong một cuộc phỏng vấn: "Mọi cuộc trò chuyện đều bao gồm AI. Cụ thể, mọi cuộc trò chuyện đều bao gồm các tác nhân."

Kevin Laughridge, một giám đốc điều hành tại Deloitte, một người dùng lớn các sản phẩm AI của Google và phân phối chúng cho các công ty khác, mô tả thị trường tác nhân như một "cuộc chạy đua chiếm đất" nơi các động thái sớm của Google với các giao thức và nền tảng tích hợp mang lại lợi thế đáng kể. "Ai ra trước và có được nhiều tác nhân thực sự mang lại giá trị – sẽ là người chiến thắng trong cuộc đua này," Laughridge nói trong một cuộc phỏng vấn. Ông nói tiến bộ của Google là "đáng kinh ngạc," lưu ý rằng các tác nhân tùy chỉnh mà Deloitte xây dựng chỉ một năm trước giờ có thể được tái tạo "sẵn có" bằng Agentspace. Bản thân Deloitte đang xây dựng 100 tác nhân trên nền tảng này, nhắm đến các chức năng văn phòng trung gian như tài chính, rủi ro và kỹ thuật, ông nói.

Các điểm chứng minh từ khách hàng đang gia tăng. Tại Next, Google đã trích dẫn "hơn 500 khách hàng đang sản xuất" với AI tạo sinh, tăng từ chỉ "hàng chục nguyên mẫu" một năm trước. Nếu Microsoft được coi là vượt xa một năm trước, điều đó dường như không còn hiển nhiên nữa. Với cuộc chiến PR từ mọi phía, thật khó để nói ai thực sự đang thắng hiện nay một cách rõ ràng. Các số liệu khác nhau. Con số 500 của Google không trực tiếp so sánh với 400 nghiên cứu trường hợp mà Microsoft quảng bá (và Microsoft, đáp lại, nói với VentureBeat vào thời điểm báo chí rằng họ dự định cập nhật số liệu công khai này lên 600 sớm, nhấn mạnh sự cạnh tranh tiếp thị gay gắt). Và nếu phân phối AI của Google qua các ứng dụng của họ là đáng kể, thì phân phối Copilot của Microsoft qua gói 365 cũng ấn tượng không kém. Cả hai hiện đang tiếp cận hàng triệu nhà phát triển qua API.

Nhưng các ví dụ về sức hút của Google rất nhiều:

- Wendy’s: Đã triển khai hệ thống AI drive-thru cho hàng ngàn địa điểm chỉ trong một năm, cải thiện trải nghiệm nhân viên và độ chính xác đơn hàng. CTO Google Cloud Will Grannis lưu ý rằng hệ thống AI có khả năng hiểu tiếng lóng và lọc tiếng ồn nền, giảm đáng kể căng thẳng từ các tương tác khách hàng trực tiếp. Điều đó giải phóng nhân viên tập trung vào chuẩn bị thực phẩm và chất lượng — một sự thay đổi mà Grannis gọi là "một ví dụ tuyệt vời về AI đơn giản hóa các hoạt động thực tế."

- Salesforce: Công bố một mở rộng lớn, cho phép nền tảng của họ chạy trên Google Cloud lần đầu tiên (ngoài AWS), trích dẫn khả năng của Google giúp họ "đổi mới và tối ưu hóa."

- Honeywell & Intuit: Các công ty trước đây liên kết chặt chẽ với Microsoft và AWS, tương ứng, giờ hợp tác với Google Cloud trong các sáng kiến AI.

- Các Ngân Hàng Lớn (Deutsche Bank, Wells Fargo): Tận dụng các tác nhân và Gemini cho nghiên cứu, phân tích và hiện đại hóa dịch vụ khách hàng.

- Các Nhà Bán Lẻ (Walmart, Mercado Libre, Lowe’s): Sử dụng tìm kiếm, tác nhân và nền tảng dữ liệu.

Sức hút doanh nghiệp này thúc đẩy tăng trưởng chung của Google Cloud, đã vượt qua AWS và Azure trong ba quý vừa qua. Google Cloud đạt mức doanh thu hàng năm hóa 44 tỷ đô la vào năm 2024, tăng từ chỉ 5 tỷ đô la vào năm 2018.

Điều Hướng Dòng Nước Cạnh Tranh

Sự thăng tiến của Google không có nghĩa là các đối thủ đang đứng yên. Các bản phát hành nhanh chóng của OpenAI tuần này với GPT-4.1 (tập trung vào lập trình và ngữ cảnh dài) và dòng o-series (lý luận đa phương thức, sử dụng công cụ) thể hiện sự đổi mới liên tục của OpenAI. Hơn nữa, cập nhật tính năng tạo hình ảnh mới của OpenAI trong GPT-4o đã thúc đẩy tăng trưởng lớn chỉ trong tháng qua, giúp ChatGPT đạt 800 triệu người dùng. Microsoft tiếp tục tận dụng dấu ấn doanh nghiệp rộng lớn và quan hệ đối tác với OpenAI, trong khi Anthropic vẫn là một đối thủ mạnh, đặc biệt trong lập trình và các ứng dụng chú trọng an toàn.

Tuy nhiên, không thể phủ nhận rằng câu chuyện của Google đã cải thiện đáng kể. Chỉ một năm trước, Google bị xem là một đối thủ chậm chạp, lúng túng, có lẽ sắp đánh mất cơ hội dẫn đầu AI hoàn toàn. Thay vào đó, ngăn xếp tích hợp độc đáo và sự kiên định của công ty đã tiết lộ điều khác: Google sở hữu khả năng đẳng cấp thế giới trên toàn phổ – từ thiết kế chip (TPUs) và cơ sở hạ tầng toàn cầu đến nghiên cứu mô hình nền tảng (DeepMind), phát triển ứng dụng (Workspace, Search, YouTube), và dịch vụ đám mây doanh nghiệp (Vertex AI, BigQuery, Agentspace). "Chúng tôi là siêu quy mô duy nhất tham gia vào cuộc trò chuyện mô hình nền tảng," deSouza nói thẳng. Sở hữu toàn diện này cho phép tối ưu hóa (như "trí thông minh trên mỗi đô la") và độ sâu tích hợp mà các mô hình dựa vào quan hệ đối tác khó có thể sánh kịp. Các đối thủ thường phải ghép các mảnh ghép khác nhau, có khả năng tạo ra ma sát hoặc hạn chế tốc độ đổi mới.

Khoảnh Khắc của Google là Bây Giờ

Dù cuộc đua AI vẫn năng động, Google đã tập hợp tất cả các mảnh ghép này đúng vào thời điểm thị trường đòi hỏi chúng. Như Laughridge của Deloitte đã nói, Google đã đạt đến điểm mà khả năng của họ căn chỉnh hoàn hảo "nơi thị trường yêu cầu." Nếu bạn đang chờ Google chứng minh mình trong AI doanh nghiệp, bạn có thể đã bỏ lỡ khoảnh khắc — họ đã làm được. Công ty đã phát minh ra nhiều công nghệ cốt lõi cung cấp sức mạnh cho cuộc cách mạng này dường như cuối cùng đã bắt kịp – và hơn thế nữa, giờ đây họ đang đặt nhịp độ mà các đối thủ cần phải đuổi theo.

Trong video dưới đây, được ghi lại ngay sau Next, chuyên gia AI Sam Witteveen và tôi phân tích bối cảnh hiện tại và các xu hướng mới nổi, và tại sao hệ sinh thái AI của Google cảm thấy mạnh mẽ đến vậy:

Bài viết liên quan

Google Ra Mắt Các Mô Hình AI Gemini 2.5 Sẵn Sàng Sản Xuất để Cạnh Tranh với OpenAI trên Thị Trường Doanh Nghiệp

Google tăng cường chiến lược AI vào thứ Hai, ra mắt các mô hình Gemini 2.5 tiên tiến cho doanh nghiệp và giới thiệu biến thể tiết kiệm chi phí để cạnh tranh về giá và hiệu suất.Công ty thuộc sở hữu củ

Google Ra Mắt Các Mô Hình AI Gemini 2.5 Sẵn Sàng Sản Xuất để Cạnh Tranh với OpenAI trên Thị Trường Doanh Nghiệp

Google tăng cường chiến lược AI vào thứ Hai, ra mắt các mô hình Gemini 2.5 tiên tiến cho doanh nghiệp và giới thiệu biến thể tiết kiệm chi phí để cạnh tranh về giá và hiệu suất.Công ty thuộc sở hữu củ

Meta cung cấp lương cao cho nhân tài AI, phủ nhận tiền thưởng ký hợp đồng 100 triệu USD

Meta đang thu hút các nhà nghiên cứu AI đến phòng thí nghiệm siêu trí tuệ mới của mình với các gói lương thưởng trị giá hàng triệu USD. Tuy nhiên, các tuyên bố về tiền thưởng ký hợp đồng 100 triệu USD

Meta cung cấp lương cao cho nhân tài AI, phủ nhận tiền thưởng ký hợp đồng 100 triệu USD

Meta đang thu hút các nhà nghiên cứu AI đến phòng thí nghiệm siêu trí tuệ mới của mình với các gói lương thưởng trị giá hàng triệu USD. Tuy nhiên, các tuyên bố về tiền thưởng ký hợp đồng 100 triệu USD

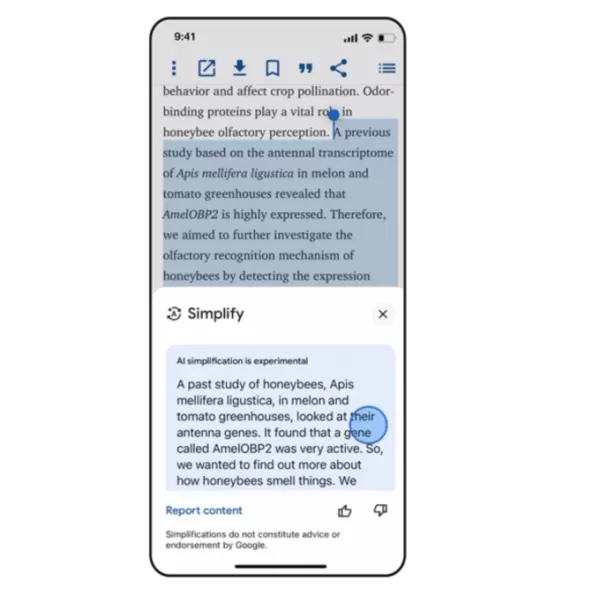

Google Ra Mắt Công Cụ Simplify Dựa Trên AI Để Đọc Web Dễ Dàng Hơn

Ứng dụng iOS của Google giờ đây bao gồm tính năng “Simplify”, sử dụng AI để chuyển đổi văn bản web phức tạp thành nội dung rõ ràng, dễ hiểu mà không cần rời khỏi trang.Công cụ Simplify, được phát triể

Nhận xét (12)

0/200

Google Ra Mắt Công Cụ Simplify Dựa Trên AI Để Đọc Web Dễ Dàng Hơn

Ứng dụng iOS của Google giờ đây bao gồm tính năng “Simplify”, sử dụng AI để chuyển đổi văn bản web phức tạp thành nội dung rõ ràng, dễ hiểu mà không cần rời khỏi trang.Công cụ Simplify, được phát triể

Nhận xét (12)

0/200

![EdwardRamirez]() EdwardRamirez

EdwardRamirez

12:00:59 GMT+07:00 Ngày 06 tháng 8 năm 2025

12:00:59 GMT+07:00 Ngày 06 tháng 8 năm 2025

Google's AI comeback is wild! 😎 I thought they were out of the game, but their enterprise push is sneaky strong. Wonder if they’ll dominate the market soon?

0

0

![ThomasBaker]() ThomasBaker

ThomasBaker

08:25:03 GMT+07:00 Ngày 22 tháng 7 năm 2025

08:25:03 GMT+07:00 Ngày 22 tháng 7 năm 2025

Google's quiet climb in enterprise AI is wild! 😎 I thought they were out of the game, but this Transformer legacy is no joke. Curious if they’ll outpace Microsoft soon?

0

0

![RalphGarcia]() RalphGarcia

RalphGarcia

01:20:20 GMT+07:00 Ngày 23 tháng 4 năm 2025

01:20:20 GMT+07:00 Ngày 23 tháng 4 năm 2025

GoogleのエンタープライズAIへの進出は感動的だね。追いつくことから先頭に立つまで、彼らは本当にゲームを上げた。でもインターフェースはもう少し改善が必要だね;ちょっとぎこちない。でも、これからどこに向かうのか楽しみだよ!🚀

0

0

![FredAnderson]() FredAnderson

FredAnderson

22:53:12 GMT+07:00 Ngày 22 tháng 4 năm 2025

22:53:12 GMT+07:00 Ngày 22 tháng 4 năm 2025

Google's move into enterprise AI is impressive. From playing catch-up to leading the pack, they've really stepped up their game. But the interface could use some work; it's a bit clunky. Still, I'm excited to see where they go from here! 🚀

0

0

![JasonRoberts]() JasonRoberts

JasonRoberts

14:22:36 GMT+07:00 Ngày 22 tháng 4 năm 2025

14:22:36 GMT+07:00 Ngày 22 tháng 4 năm 2025

El movimiento sigiloso de Google en la IA empresarial es bastante genial. De ir a la zaga a liderar el grupo, realmente han dado la vuelta a la situación. La tecnología es sólida pero la interfaz podría ser más amigable para el usuario. Aún así, es impresionante lo rápido que se han movido! 🚀

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

13:10:16 GMT+07:00 Ngày 22 tháng 4 năm 2025

13:10:16 GMT+07:00 Ngày 22 tháng 4 năm 2025

A jogada furtiva do Google no AI empresarial é bem legal. De tentar alcançar a liderar o grupo, eles realmente mudaram as coisas. A tecnologia é sólida, mas a interface poderia ser mais amigável ao usuário. Ainda assim, é impressionante como eles se moveram rápido! 🚀

0

0

Chỉ một năm trước, sự chú ý xung quanh Google và AI doanh nghiệp dường như đang bị kẹt ở trạng thái trung lập. Mặc dù sở hữu những công nghệ tiên phong như Transformer, gã khổng lồ công nghệ này dường như bị tụt hậu, bị lu mờ bởi thành công lan truyền của OpenAI, năng lực lập trình của Anthropic và sự thúc đẩy mạnh mẽ của Microsoft vào thị trường doanh nghiệp.

Nhưng tại Google Cloud Next 2025 ở Las Vegas tuần trước, khung cảnh đã hoàn toàn khác. Một Google tự tin, được trang bị các mô hình hàng đầu, cơ sở hạ tầng mạnh mẽ và chiến lược doanh nghiệp rõ ràng, đã công bố một sự lội ngược dòng ngoạn mục. Trong một cuộc họp kín với các nhà phân tích cấp cao của Google, một nhà phân tích đã tóm tắt tâm trạng: "Cảm giác như đây là khoảnh khắc Google chuyển từ 'đuổi theo' sang 'hãy đuổi kịp chúng tôi.'"

Bước Nhảy Vọt của Google

Cảm nhận rằng Google không chỉ bắt kịp mà còn vượt qua OpenAI và Microsoft trong cuộc đua AI doanh nghiệp đã lan tỏa khắp sự kiện. Và đó không chỉ là chiêu trò tiếp thị. Trong năm qua, Google đã tập trung mạnh mẽ vào việc thực thi, biến năng lực công nghệ của mình thành một nền tảng tích hợp hiệu suất cao, nhanh chóng thu phục các nhà ra quyết định doanh nghiệp. Từ các mô hình AI mạnh mẽ nhất thế giới chạy trên silicon tùy chỉnh hiệu quả cao đến một hệ sinh thái đang phát triển của các tác nhân AI được thiết kế cho các thách thức kinh doanh thực tế, Google đang đưa ra một lập luận thuyết phục rằng họ chưa bao giờ thực sự lạc lối mà chỉ đang trải qua một giai đoạn phát triển nền tảng sâu sắc.

Với nền tảng tích hợp giờ đây hoạt động hết công suất, Google dường như đã sẵn sàng dẫn đầu giai đoạn tiếp theo của cuộc cách mạng AI doanh nghiệp. Trong các cuộc phỏng vấn với các giám đốc điều hành Google tại Next, họ nhấn mạnh lợi thế độc đáo của Google về cơ sở hạ tầng và tích hợp mô hình—những lợi thế mà các đối thủ như OpenAI, Microsoft hay AWS khó có thể sao chép.

Bóng Ma Nghi Ngờ: Nhìn Lại Gần Đây

Để đánh giá đầy đủ động lực hiện tại của Google, cần phải nhìn nhận quá khứ gần đây. Google đã phát minh ra kiến trúc Transformer, khởi nguồn cho cuộc cách mạng hiện đại trong các mô hình ngôn ngữ lớn (LLMs), và bắt đầu đầu tư vào phần cứng AI chuyên dụng (TPUs) từ một thập kỷ trước, giờ đây mang lại hiệu quả hàng đầu trong ngành. Tuy nhiên, thật khó hiểu, chỉ hai năm rưỡi trước, Google đã thấy mình phải phòng thủ.

ChatGPT của OpenAI đã thu hút trí tưởng tượng của công chúng và sự quan tâm của doanh nghiệp với tốc độ chóng mặt, trở thành ứng dụng phát triển nhanh nhất trong lịch sử. Các đối thủ như Anthropic đã chiếm lĩnh các ngách như lập trình. Trong khi đó, các động thái công khai của Google thường dường như do dự hoặc sai lầm. Những thất bại trong demo Bard khét tiếng vào năm 2023 và tranh cãi về trình tạo hình ảnh của họ tạo ra các mô tả lịch sử không chính xác đã nuôi dưỡng một câu chuyện về một công ty có thể bị cản trở bởi bộ máy quan liêu nội bộ hoặc điều chỉnh quá mức về định hướng. Google dường như lạc lối, giống như sự chậm trễ ban đầu trong cuộc cạnh tranh đám mây, nơi họ vẫn đứng thứ ba xa vời về thị phần sau Amazon và Microsoft.

Bước Ngoặt: Quyết Định Có Ý Thức Để Dẫn Đầu

Tuy nhiên, đằng sau hậu trường, một sự thay đổi đáng kể đang diễn ra, được thúc đẩy bởi quyết định có chủ ý ở cấp cao nhất nhằm giành lại vị trí dẫn đầu. Mat Velloso, Phó Chủ tịch sản phẩm của Google DeepMind’s AI Developer Platform, đã cảm nhận được khoảnh khắc then chốt này khi gia nhập Google vào tháng 2 năm 2024, sau khi rời Microsoft. "Khi tôi đến Google, tôi đã nói chuyện với Sundar [Pichai], tôi đã nói chuyện với một vài lãnh đạo ở đây, và tôi cảm thấy như đó là khoảnh khắc họ quyết định, được rồi, [AI tạo sinh] là một thứ mà ngành công nghiệp rõ ràng quan tâm. Hãy biến nó thành hiện thực," Velloso chia sẻ trong một cuộc phỏng vấn tại Next tuần trước.

Động lực mới này không bị cản trở bởi "chảy máu chất xám" mà một số người ngoài cuộc lo ngại đang làm suy yếu Google. Thay vào đó, công ty đã tăng gấp đôi nỗ lực thực thi vào đầu năm 2024, được đánh dấu bởi việc tuyển dụng tích cực, thống nhất nội bộ và thu hút khách hàng. Trong khi các đối thủ thực hiện các vụ tuyển dụng đình đám, Google đã giữ lại đội ngũ lãnh đạo AI cốt lõi, bao gồm CEO DeepMind Demis Hassabis và CEO Google Cloud Thomas Kurian, mang lại sự ổn định và chuyên môn sâu sắc.

Hơn nữa, nhân tài bắt đầu đổ về sứ mệnh tập trung của Google. Logan Kilpatrick, chẳng hạn, đã quay lại Google từ OpenAI, bị thu hút bởi cơ hội xây dựng AI nền tảng trong công ty. Anh ấy cùng Velloso trong cái mà anh mô tả là một "trải nghiệm từ con số không," được giao nhiệm vụ xây dựng sức hút cho nhà phát triển đối với Gemini từ đầu. "Cảm giác như đội ngũ chỉ có tôi vào ngày đầu tiên... chúng tôi thực sự không có người dùng trên nền tảng này, chúng tôi không có doanh thu. Không ai quan tâm đến Gemini vào lúc này," Kilpatrick nhớ lại về điểm khởi đầu. Các lãnh đạo như Josh Woodward, người đã giúp khởi động AI Studio và hiện dẫn đầu Gemini App và Labs, và Noam Shazeer, đồng tác giả chính của bài báo Transformer "Attention Is All You Need", cũng quay lại công ty vào cuối năm 2024 với vai trò đồng lãnh đạo kỹ thuật cho dự án Gemini quan trọng.

Trụ Cột 1: Gemini 2.5 và Kỷ Nguyên của Các Mô Hình Tư Duy

Dù khẩu hiệu doanh nghiệp đã chuyển sang "không chỉ là về mô hình," việc sở hữu LLM hiệu suất tốt nhất vẫn là một thành tựu lớn và là một minh chứng mạnh mẽ cho nghiên cứu vượt trội và kiến trúc công nghệ hiệu quả của một công ty. Với việc phát hành Gemini 2.5 Pro chỉ vài tuần trước Next '25, Google đã quyết liệt giành lấy vị trí này. Nó nhanh chóng dẫn đầu bảng xếp hạng độc lập Chatbot Arena, vượt xa biến thể GPT-4o mới nhất của OpenAI, và xuất sắc trong các bài kiểm tra lý luận khó khăn như Humanity’s Last Exam. Như Pichai phát biểu trong bài phát biểu chính, "Đây là mô hình AI thông minh nhất của chúng tôi từ trước đến nay. Và nó là mô hình tốt nhất trên thế giới." Mô hình này đã thúc đẩy sự tăng 80% trong việc sử dụng Gemini chỉ trong một tháng, ông ấy đã đăng trên X riêng.

Lần đầu tiên, nhu cầu về Gemini bùng nổ. Điều khiến tôi ấn tượng, ngoài trí thông minh vượt trội của Gemini 2.5 Pro, là khả năng lý luận được chứng minh của nó. Google đã thiết kế một khả năng "tư duy", cho phép mô hình thực hiện lý luận nhiều bước, lập kế hoạch và thậm chí tự phản ánh trước khi đưa ra phản hồi cuối cùng. Chuỗi tư duy (CoT) có cấu trúc, mạch lạc – sử dụng các bước được đánh số và các dấu đầu dòng phụ – tránh được tính chất lan man hoặc không rõ ràng của đầu ra từ các mô hình khác như DeepSeek hoặc OpenAI. Đối với các đội kỹ thuật đánh giá đầu ra cho các nhiệm vụ quan trọng, sự minh bạch này cho phép xác nhận, sửa chữa và định hướng lại với sự tự tin chưa từng có.

Nhưng quan trọng hơn đối với người dùng doanh nghiệp, Gemini 2.5 Pro cũng đã thu hẹp đáng kể khoảng cách trong lập trình, một trong những lĩnh vực ứng dụng lớn nhất cho AI tạo sinh. Trong một cuộc phỏng vấn với VentureBeat, CTO Fiona Tan của nhà bán lẻ hàng đầu Wayfair cho biết sau các thử nghiệm ban đầu, công ty nhận thấy nó "đã tiến bộ khá nhiều" và giờ đây "khá tương đương" với Claude 3.7 Sonnet của Anthropic, trước đây là lựa chọn ưu tiên của nhiều nhà phát triển.

Google cũng đã thêm một cửa sổ ngữ cảnh khổng lồ 1 triệu token vào mô hình, cho phép lý luận trên toàn bộ cơ sở mã hoặc tài liệu dài, vượt xa khả năng của các mô hình từ OpenAI hoặc Anthropic. (OpenAI đã phản hồi tuần này với các mô hình có cửa sổ ngữ cảnh lớn tương tự, mặc dù các điểm chuẩn cho thấy Gemini 2.5 Pro vẫn giữ lợi thế trong lý luận tổng thể). Lợi thế này cho phép thực hiện các nhiệm vụ kỹ thuật phần mềm phức tạp, đa tệp.

Bổ sung cho Pro là Gemini 2.5 Flash, được công bố tại Next '25 và phát hành ngay hôm qua. Cũng là một mô hình "tư duy", Flash được tối ưu hóa cho độ trễ thấp và hiệu quả chi phí. Bạn có thể kiểm soát mức độ lý luận của mô hình và cân bằng hiệu suất với ngân sách của mình. Cách tiếp cận phân cấp này phản ánh thêm chiến lược "trí thông minh trên mỗi đô la" được các giám đốc điều hành Google ủng hộ.

Velloso đã trình bày một biểu đồ cho thấy trên toàn phổ trí thông minh, các mô hình Google mang lại giá trị tốt nhất. "Nếu chúng ta có cuộc trò chuyện này một năm trước… tôi sẽ chẳng có gì để trình bày," Velloso thừa nhận, nhấn mạnh sự lội ngược dòng nhanh chóng. "Và giờ đây, trên mọi phương diện, nếu bạn đang tìm kiếm bất kỳ mô hình nào, bất kỳ kích thước nào, nếu bạn không phải là Google, bạn đang mất tiền." Các biểu đồ tương tự đã được cập nhật để tính đến các bản phát hành mô hình mới nhất của OpenAI tuần này, tất cả đều cho thấy điều tương tự: các mô hình của Google cung cấp trí thông minh tốt nhất trên mỗi đô la. Xem bên dưới:

Tan của Wayfair cũng nhận thấy những cải tiến đầy hứa hẹn về độ trễ với 2.5 Pro: "Gemini 2.5 phản hồi nhanh hơn," khiến nó khả thi cho "các khả năng hướng tới khách hàng hơn," cô ấy nói, điều mà cô cho biết trước đây chưa từng có với các mô hình khác. Gemini có thể trở thành mô hình đầu tiên Wayfair sử dụng cho các tương tác với khách hàng này, cô ấy nói.

Khả năng của gia đình Gemini mở rộng sang đa phương thức, tích hợp liền mạch với các mô hình hàng đầu khác của Google như Imagen 3 (tạo hình ảnh), Veo 2 (tạo video), Chirp 3 (âm thanh), và mới công bố Lyria (chuyển văn bản thành nhạc), tất cả đều có thể truy cập qua nền tảng Vertex của Google dành cho người dùng Doanh nghiệp. Google là công ty duy nhất cung cấp các mô hình truyền thông tạo sinh của riêng mình trên tất cả các phương thức trên nền tảng của họ. Microsoft, AWS và OpenAI phải hợp tác với các công ty khác để làm điều này.

Trụ Cột 2: Sức Mạnh Cơ Sở Hạ Tầng – Động Cơ Dưới Nắp Capo

Khả năng lặp lại nhanh chóng và phục vụ hiệu quả các mô hình mạnh mẽ này bắt nguồn từ cơ sở hạ tầng có lẽ là vô song của Google, được mài giũa qua hàng thập kỷ vận hành các dịch vụ quy mô toàn cầu. Trung tâm của điều này là Đơn vị Xử lý Tensor (TPU).

Tại Next '25, Google đã công bố Ironwood, TPU thế hệ thứ bảy, được thiết kế rõ ràng cho các nhu cầu suy luận và "mô hình tư duy." Quy mô là khổng lồ, được thiết kế cho các khối lượng công việc AI đòi hỏi cao: các pod Ironwood chứa hơn 9.000 chip làm mát bằng chất lỏng, mang lại sức mạnh tính toán được tuyên bố là 42.5 exaflops. Phó Chủ tịch Hệ thống ML của Google, Amin Vahdat, cho biết trên sân khấu tại Next rằng điều này "hơn 24 lần" sức mạnh tính toán của siêu máy tính số 1 thế giới hiện tại.

Google tuyên bố rằng Ironwood cung cấp hiệu suất trên mỗi watt gấp đôi so với Trillium, thế hệ TPU trước đó. Điều này rất quan trọng vì khách hàng doanh nghiệp ngày càng cho rằng chi phí năng lượng và tính sẵn có hạn chế các triển khai AI quy mô lớn.

CTO Google Cloud Will Grannis nhấn mạnh sự nhất quán của tiến trình này. Hàng năm, Google đạt được các cải tiến 10x, 8x, 9x, 10x trong các bộ xử lý của mình, ông nói với VentureBeat trong một cuộc phỏng vấn, tạo ra cái mà ông gọi là "luật Moore siêu tốc" cho các bộ tăng tốc AI. Ông nói khách hàng đang mua lộ trình của Google, không chỉ công nghệ của họ.

Vị thế của Google đã thúc đẩy đầu tư TPU bền vững này. Họ cần cung cấp năng lượng hiệu quả cho các dịch vụ khổng lồ như Search, YouTube và Gmail cho hơn 2 tỷ người dùng. Điều này đòi hỏi phát triển phần cứng tùy chỉnh, tối ưu hóa từ lâu trước khi bùng nổ AI tạo sinh hiện tại. Trong khi Meta hoạt động ở quy mô người dùng tương tự, các đối thủ khác thiếu động lực nội bộ cụ thể này cho việc phát triển phần cứng AI tích hợp dọc trong suốt một thập kỷ.

Giờ đây, những khoản đầu tư TPU này đang được đền đáp vì chúng mang lại hiệu quả không chỉ cho các ứng dụng của chính Google mà còn cho phép Google cung cấp Gemini cho người dùng khác với trí thông minh tốt hơn trên mỗi đô la, tất cả đều bình đẳng.

Tại sao các đối thủ của Google không thể mua bộ xử lý hiệu quả từ Nvidia, bạn hỏi? Đúng là các bộ xử lý GPU của Nvidia thống trị quá trình huấn luyện trước của LLMs. Nhưng nhu cầu thị trường đã đẩy giá các GPU này lên, và Nvidia lấy một phần lợi nhuận đáng kể cho chính mình. Điều này chuyển chi phí đáng kể cho người dùng chip của họ. Và cũng vậy, trong khi huấn luyện trước đã thống trị việc sử dụng chip AI cho đến nay, điều này đang thay đổi khi các doanh nghiệp thực sự triển khai các ứng dụng này. Đây là nơi "suy luận" xuất hiện, và ở đây TPUs được coi là hiệu quả hơn GPU cho các khối lượng công việc quy mô lớn.

Khi bạn hỏi các giám đốc điều hành Google lợi thế công nghệ chính của họ trong AI đến từ đâu, họ thường quay lại với TPU như yếu tố quan trọng nhất. Mark Lohmeyer, Phó Chủ tịch phụ trách cơ sở hạ tầng tính toán của Google, thẳng thắn: TPUs là "chắc chắn một phần rất khác biệt trong những gì chúng tôi làm… OpenAI, họ không có những khả năng đó."

Đáng chú ý, Google trình bày TPUs không phải riêng lẻ, mà là một phần của kiến trúc AI doanh nghiệp phức tạp hơn. Đối với những người trong ngành kỹ thuật, hiểu rằng hiệu suất hàng đầu phụ thuộc vào việc tích hợp các đột phá công nghệ ngày càng chuyên biệt. Nhiều cập nhật đã được trình bày chi tiết tại Next. Vahdat mô tả đây là một "hệ thống siêu tính toán," tích hợp phần cứng (TPUs, GPU mới nhất của Nvidia như Blackwell và sắp tới Vera Rubin, lưu trữ tiên tiến như Hyperdisk Exapools, Anywhere Cache, và Rapid Storage) với một ngăn xếp phần mềm thống nhất. Phần mềm này bao gồm Cluster Director để quản lý các bộ tăng tốc, Pathways (thời gian chạy phân tán của Gemini, giờ đây có sẵn cho khách hàng), và mang các tối ưu hóa như vLLM đến TPUs, cho phép di chuyển khối lượng công việc dễ dàng hơn cho những người trước đây sử dụng ngăn xếp Nvidia/PyTorch. Hệ thống tích hợp này, Vahdat lập luận, là lý do Gemini 2.0 Flash đạt được trí thông minh cao hơn 24 lần trên mỗi đô la, so với GPT-4o.

Google cũng đang mở rộng phạm vi cơ sở hạ tầng vật lý của mình. Cloud WAN khiến mạng cáp quang riêng dài 2 triệu dặm, độ trễ thấp của Google trở nên доступ cho các doanh nghiệp, hứa hẹn hiệu suất nhanh hơn tới 40% và tổng chi phí sở hữu (TCO) thấp hơn 40% so với các mạng do khách hàng quản lý.

Hơn nữa, Google Distributed Cloud (GDC) cho phép Gemini và phần cứng Nvidia (thông qua quan hệ đối tác với Dell) chạy trong các môi trường chủ quyền, tại chỗ, hoặc thậm chí cách ly – một khả năng mà CEO Nvidia Jensen Huang ca ngợi là "vô cùng lớn lao" trong việc mang AI hiện đại đến các ngành công nghiệp và quốc gia có quy định chặt chẽ. Tại Next, Huang gọi cơ sở hạ tầng của Google là tốt nhất thế giới: "Không công ty nào giỏi ở mọi tầng tính toán như Google và Google Cloud," ông nói.

Trụ Cột 3: Ngăn Xếp Tích Hợp Toàn Diện – Kết Nối Các Điểm

Lợi thế chiến lược của Google tăng lên khi xem xét cách các mô hình và thành phần cơ sở hạ tầng này được đan xen vào một nền tảng gắn kết. Không giống như các đối thủ, thường dựa vào quan hệ đối tác để lấp các khoảng trống, Google kiểm soát gần như mọi tầng, cho phép tích hợp chặt chẽ hơn và chu kỳ đổi mới nhanh hơn.

Vậy tại sao tích hợp này lại quan trọng, nếu một đối thủ như Microsoft có thể đơn giản hợp tác với OpenAI để kết hợp chiều rộng cơ sở hạ tầng với năng lực mô hình LLM? Những người Google mà tôi nói chuyện cho biết điều này tạo ra sự khác biệt lớn, và họ đưa ra các câu chuyện để chứng minh.

Hãy xem xét sự cải tiến đáng kể của cơ sở dữ liệu doanh nghiệp BigQuery của Google. Cơ sở dữ liệu này giờ đây cung cấp một đồ thị tri thức cho phép LLMs tìm kiếm dữ liệu hiệu quả hơn nhiều, và hiện tự hào có số lượng khách hàng gấp hơn năm lần so với các đối thủ như Snowflake và Databricks. Yasmeen Ahmad, Trưởng phòng Sản phẩm Phân tích Dữ liệu tại Google Cloud, cho biết những cải tiến lớn chỉ có thể đạt được vì các đội dữ liệu của Google làm việc chặt chẽ với đội DeepMind. Họ đã giải quyết các trường hợp sử dụng khó, và điều này dẫn đến cơ sở dữ liệu cung cấp độ chính xác cao hơn 50% dựa trên các truy vấn phổ biến, ít nhất theo thử nghiệm nội bộ của Google, trong việc truy xuất dữ liệu đúng so với đối thủ gần nhất, Ahmad nói với VentureBeat trong một cuộc phỏng vấn. Ahmad cho biết sự tích hợp sâu sắc này trên toàn ngăn xếp là cách Google đã "vượt mặt" ngành công nghiệp.

Sự gắn kết nội bộ này tương phản rõ rệt với động lực "bạn-thù" tại Microsoft. Trong khi Microsoft hợp tác với OpenAI để phân phối các mô hình của họ trên đám mây Azure, Microsoft cũng đang xây dựng các mô hình riêng. Mat Velloso, giám đốc điều hành Google hiện dẫn đầu chương trình nhà phát triển AI, đã rời Microsoft sau khi thất vọng khi cố gắng điều chỉnh kế hoạch Windows Copilot với các sản phẩm mô hình của OpenAI. "Làm sao bạn chia sẻ kế hoạch sản phẩm của mình với một công ty khác thực sự đang cạnh tranh với bạn… Toàn bộ chuyện này là một mâu thuẫn," ông nhớ lại. "Ở đây tôi ngồi cạnh những người đang xây dựng các mô hình."

Sự tích hợp này nói lên điều mà các lãnh đạo Google coi là lợi thế cốt lõi của họ: khả năng độc đáo trong việc kết nối chuyên môn sâu sắc trên toàn phổ, từ nghiên cứu nền tảng và xây dựng mô hình đến triển khai ứng dụng và thiết kế cơ sở hạ tầng quy mô toàn cầu.

Vertex AI đóng vai trò như hệ thần kinh trung ương cho các nỗ lực AI doanh nghiệp của Google. Và sự tích hợp không chỉ dừng ở các sản phẩm của chính Google. Model Garden của Vertex cung cấp hơn 200 mô hình được tuyển chọn, bao gồm của Google, Llama 4 của Meta, và nhiều tùy chọn mã nguồn mở. Vertex cung cấp các công cụ để điều chỉnh, đánh giá (bao gồm Đánh giá do AI cung cấp, mà Grannis nhấn mạnh là một bộ tăng tốc quan trọng), triển khai và giám sát. Khả năng căn cứ của nó tận dụng các cơ sở dữ liệu sẵn sàng AI nội bộ cùng với khả năng tương thích với các cơ sở dữ liệu vector bên ngoài. Thêm vào đó là các sản phẩm mới của Google để căn cứ các mô hình với Google Search, công cụ tìm kiếm tốt nhất thế giới.

Sự tích hợp mở rộng đến Google Workspace. Các tính năng mới được công bố tại Next '25, như "Help Me Analyze" trong Sheets (vâng, Sheets giờ có công thức "=AI"), Tổng quan Âm thanh trong Docs và Workspace Flows, tiếp tục nhúng khả năng của Gemini vào các luồng công việc hàng ngày, tạo ra một vòng phản hồi mạnh mẽ để Google sử dụng nhằm cải thiện trải nghiệm.

Trong khi thúc đẩy ngăn xếp tích hợp của mình, Google cũng ủng hộ tính mở nơi nó phục vụ hệ sinh thái. Sau khi thúc đẩy việc áp dụng Kubernetes, giờ đây họ đang quảng bá JAX cho các khung AI và các giao thức mở cho giao tiếp giữa các tác nhân (A2A) cùng với hỗ trợ cho các tiêu chuẩn hiện có (MCP). Google cũng cung cấp hàng trăm đầu nối đến các nền tảng bên ngoài từ trong Agentspace, giao diện thống nhất mới của Google để nhân viên tìm và sử dụng các tác nhân. Khái niệm trung tâm này rất hấp dẫn. Phần trình diễn chính của Agentspace (bắt đầu từ 51:40) minh họa điều này. Google cung cấp cho người dùng các tác nhân được xây dựng sẵn, hoặc nhân viên hoặc nhà phát triển có thể tự xây dựng bằng khả năng AI không mã. Hoặc họ có thể kéo các tác nhân từ bên ngoài thông qua các đầu nối A2A. Nó tích hợp vào trình duyệt Chrome để truy cập liền mạch.

Trụ Cột 4: Tập Trung vào Giá Trị Doanh Nghiệp và Hệ Sinh Thái Tác Nhân

Có lẽ sự thay đổi quan trọng nhất là sự tập trung sắc bén của Google vào giải quyết các vấn đề doanh nghiệp cụ thể, đặc biệt thông qua lăng kính của các tác nhân AI. Thomas Kurian, CEO Google Cloud, đã nêu ra ba lý do khách hàng chọn Google: nền tảng tối ưu hóa AI, cách tiếp cận đa đám mây mở cho phép kết nối với CNTT hiện có, và sự tập trung sẵn sàng cho doanh nghiệp vào bảo mật, chủ quyền và tuân thủ.

Các tác nhân là chìa khóa cho chiến lược này. Ngoài AgentSpace, điều này còn bao gồm:

- Khối Xây Dựng: Bộ Phát triển Tác nhân mã nguồn mở (ADK), được công bố tại Next, đã thu hút sự quan tâm đáng kể từ các nhà phát triển. ADK đơn giản hóa việc tạo ra các hệ thống đa tác nhân, trong khi giao thức Agent2Agent (A2A) được đề xuất nhằm đảm bảo khả năng tương tác, cho phép các tác nhân được xây dựng với các công cụ khác nhau (Gemini ADK, LangGraph, CrewAI, v.v.) hợp tác. Grannis của Google cho biết A2A dự đoán các thách thức về quy mô và bảo mật của một tương lai với tiềm năng hàng trăm ngàn tác nhân tương tác.

- Tác Nhân Chuyên Dụng: Google đã giới thiệu các tác nhân chuyên gia tích hợp vào Agentspace (như NotebookLM, Tạo Ý tưởng, Nghiên cứu Sâu) và nhấn mạnh năm danh mục đang thu hút: Tác nhân Khách hàng (cung cấp sức mạnh cho các công cụ như Reddit Answers, trợ lý hỗ trợ của Verizon, quầy drive-thru của Wendy’s), Tác nhân Sáng tạo (được WPP, Brandtech, Sphere sử dụng), Tác nhân Dữ liệu (đưa ra thông tin tại Mattel, Spotify, Bayer), Tác nhân Lập trình (Gemini Code Assist), và Tác nhân Bảo mật (tích hợp vào nền tảng Bảo mật Thống nhất mới của Google).

Chiến lược tác nhân toàn diện này dường như đang gây tiếng vang. Các cuộc trò chuyện với các giám đốc điều hành tại ba doanh nghiệp lớn khác trong tuần qua, cũng nói chuyện ẩn danh do nhạy cảm cạnh tranh, đã lặp lại sự hào hứng với chiến lược tác nhân của Google. COO Google Cloud Francis DeSouza xác nhận trong một cuộc phỏng vấn: "Mọi cuộc trò chuyện đều bao gồm AI. Cụ thể, mọi cuộc trò chuyện đều bao gồm các tác nhân."

Kevin Laughridge, một giám đốc điều hành tại Deloitte, một người dùng lớn các sản phẩm AI của Google và phân phối chúng cho các công ty khác, mô tả thị trường tác nhân như một "cuộc chạy đua chiếm đất" nơi các động thái sớm của Google với các giao thức và nền tảng tích hợp mang lại lợi thế đáng kể. "Ai ra trước và có được nhiều tác nhân thực sự mang lại giá trị – sẽ là người chiến thắng trong cuộc đua này," Laughridge nói trong một cuộc phỏng vấn. Ông nói tiến bộ của Google là "đáng kinh ngạc," lưu ý rằng các tác nhân tùy chỉnh mà Deloitte xây dựng chỉ một năm trước giờ có thể được tái tạo "sẵn có" bằng Agentspace. Bản thân Deloitte đang xây dựng 100 tác nhân trên nền tảng này, nhắm đến các chức năng văn phòng trung gian như tài chính, rủi ro và kỹ thuật, ông nói.

Các điểm chứng minh từ khách hàng đang gia tăng. Tại Next, Google đã trích dẫn "hơn 500 khách hàng đang sản xuất" với AI tạo sinh, tăng từ chỉ "hàng chục nguyên mẫu" một năm trước. Nếu Microsoft được coi là vượt xa một năm trước, điều đó dường như không còn hiển nhiên nữa. Với cuộc chiến PR từ mọi phía, thật khó để nói ai thực sự đang thắng hiện nay một cách rõ ràng. Các số liệu khác nhau. Con số 500 của Google không trực tiếp so sánh với 400 nghiên cứu trường hợp mà Microsoft quảng bá (và Microsoft, đáp lại, nói với VentureBeat vào thời điểm báo chí rằng họ dự định cập nhật số liệu công khai này lên 600 sớm, nhấn mạnh sự cạnh tranh tiếp thị gay gắt). Và nếu phân phối AI của Google qua các ứng dụng của họ là đáng kể, thì phân phối Copilot của Microsoft qua gói 365 cũng ấn tượng không kém. Cả hai hiện đang tiếp cận hàng triệu nhà phát triển qua API.

Nhưng các ví dụ về sức hút của Google rất nhiều:

- Wendy’s: Đã triển khai hệ thống AI drive-thru cho hàng ngàn địa điểm chỉ trong một năm, cải thiện trải nghiệm nhân viên và độ chính xác đơn hàng. CTO Google Cloud Will Grannis lưu ý rằng hệ thống AI có khả năng hiểu tiếng lóng và lọc tiếng ồn nền, giảm đáng kể căng thẳng từ các tương tác khách hàng trực tiếp. Điều đó giải phóng nhân viên tập trung vào chuẩn bị thực phẩm và chất lượng — một sự thay đổi mà Grannis gọi là "một ví dụ tuyệt vời về AI đơn giản hóa các hoạt động thực tế."

- Salesforce: Công bố một mở rộng lớn, cho phép nền tảng của họ chạy trên Google Cloud lần đầu tiên (ngoài AWS), trích dẫn khả năng của Google giúp họ "đổi mới và tối ưu hóa."

- Honeywell & Intuit: Các công ty trước đây liên kết chặt chẽ với Microsoft và AWS, tương ứng, giờ hợp tác với Google Cloud trong các sáng kiến AI.

- Các Ngân Hàng Lớn (Deutsche Bank, Wells Fargo): Tận dụng các tác nhân và Gemini cho nghiên cứu, phân tích và hiện đại hóa dịch vụ khách hàng.

- Các Nhà Bán Lẻ (Walmart, Mercado Libre, Lowe’s): Sử dụng tìm kiếm, tác nhân và nền tảng dữ liệu.

Sức hút doanh nghiệp này thúc đẩy tăng trưởng chung của Google Cloud, đã vượt qua AWS và Azure trong ba quý vừa qua. Google Cloud đạt mức doanh thu hàng năm hóa 44 tỷ đô la vào năm 2024, tăng từ chỉ 5 tỷ đô la vào năm 2018.

Điều Hướng Dòng Nước Cạnh Tranh

Sự thăng tiến của Google không có nghĩa là các đối thủ đang đứng yên. Các bản phát hành nhanh chóng của OpenAI tuần này với GPT-4.1 (tập trung vào lập trình và ngữ cảnh dài) và dòng o-series (lý luận đa phương thức, sử dụng công cụ) thể hiện sự đổi mới liên tục của OpenAI. Hơn nữa, cập nhật tính năng tạo hình ảnh mới của OpenAI trong GPT-4o đã thúc đẩy tăng trưởng lớn chỉ trong tháng qua, giúp ChatGPT đạt 800 triệu người dùng. Microsoft tiếp tục tận dụng dấu ấn doanh nghiệp rộng lớn và quan hệ đối tác với OpenAI, trong khi Anthropic vẫn là một đối thủ mạnh, đặc biệt trong lập trình và các ứng dụng chú trọng an toàn.

Tuy nhiên, không thể phủ nhận rằng câu chuyện của Google đã cải thiện đáng kể. Chỉ một năm trước, Google bị xem là một đối thủ chậm chạp, lúng túng, có lẽ sắp đánh mất cơ hội dẫn đầu AI hoàn toàn. Thay vào đó, ngăn xếp tích hợp độc đáo và sự kiên định của công ty đã tiết lộ điều khác: Google sở hữu khả năng đẳng cấp thế giới trên toàn phổ – từ thiết kế chip (TPUs) và cơ sở hạ tầng toàn cầu đến nghiên cứu mô hình nền tảng (DeepMind), phát triển ứng dụng (Workspace, Search, YouTube), và dịch vụ đám mây doanh nghiệp (Vertex AI, BigQuery, Agentspace). "Chúng tôi là siêu quy mô duy nhất tham gia vào cuộc trò chuyện mô hình nền tảng," deSouza nói thẳng. Sở hữu toàn diện này cho phép tối ưu hóa (như "trí thông minh trên mỗi đô la") và độ sâu tích hợp mà các mô hình dựa vào quan hệ đối tác khó có thể sánh kịp. Các đối thủ thường phải ghép các mảnh ghép khác nhau, có khả năng tạo ra ma sát hoặc hạn chế tốc độ đổi mới.

Khoảnh Khắc của Google là Bây Giờ

Dù cuộc đua AI vẫn năng động, Google đã tập hợp tất cả các mảnh ghép này đúng vào thời điểm thị trường đòi hỏi chúng. Như Laughridge của Deloitte đã nói, Google đã đạt đến điểm mà khả năng của họ căn chỉnh hoàn hảo "nơi thị trường yêu cầu." Nếu bạn đang chờ Google chứng minh mình trong AI doanh nghiệp, bạn có thể đã bỏ lỡ khoảnh khắc — họ đã làm được. Công ty đã phát minh ra nhiều công nghệ cốt lõi cung cấp sức mạnh cho cuộc cách mạng này dường như cuối cùng đã bắt kịp – và hơn thế nữa, giờ đây họ đang đặt nhịp độ mà các đối thủ cần phải đuổi theo.

Trong video dưới đây, được ghi lại ngay sau Next, chuyên gia AI Sam Witteveen và tôi phân tích bối cảnh hiện tại và các xu hướng mới nổi, và tại sao hệ sinh thái AI của Google cảm thấy mạnh mẽ đến vậy:

Google Ra Mắt Các Mô Hình AI Gemini 2.5 Sẵn Sàng Sản Xuất để Cạnh Tranh với OpenAI trên Thị Trường Doanh Nghiệp

Google tăng cường chiến lược AI vào thứ Hai, ra mắt các mô hình Gemini 2.5 tiên tiến cho doanh nghiệp và giới thiệu biến thể tiết kiệm chi phí để cạnh tranh về giá và hiệu suất.Công ty thuộc sở hữu củ

Google Ra Mắt Các Mô Hình AI Gemini 2.5 Sẵn Sàng Sản Xuất để Cạnh Tranh với OpenAI trên Thị Trường Doanh Nghiệp

Google tăng cường chiến lược AI vào thứ Hai, ra mắt các mô hình Gemini 2.5 tiên tiến cho doanh nghiệp và giới thiệu biến thể tiết kiệm chi phí để cạnh tranh về giá và hiệu suất.Công ty thuộc sở hữu củ

Meta cung cấp lương cao cho nhân tài AI, phủ nhận tiền thưởng ký hợp đồng 100 triệu USD

Meta đang thu hút các nhà nghiên cứu AI đến phòng thí nghiệm siêu trí tuệ mới của mình với các gói lương thưởng trị giá hàng triệu USD. Tuy nhiên, các tuyên bố về tiền thưởng ký hợp đồng 100 triệu USD

Meta cung cấp lương cao cho nhân tài AI, phủ nhận tiền thưởng ký hợp đồng 100 triệu USD

Meta đang thu hút các nhà nghiên cứu AI đến phòng thí nghiệm siêu trí tuệ mới của mình với các gói lương thưởng trị giá hàng triệu USD. Tuy nhiên, các tuyên bố về tiền thưởng ký hợp đồng 100 triệu USD

Google Ra Mắt Công Cụ Simplify Dựa Trên AI Để Đọc Web Dễ Dàng Hơn

Ứng dụng iOS của Google giờ đây bao gồm tính năng “Simplify”, sử dụng AI để chuyển đổi văn bản web phức tạp thành nội dung rõ ràng, dễ hiểu mà không cần rời khỏi trang.Công cụ Simplify, được phát triể

Google Ra Mắt Công Cụ Simplify Dựa Trên AI Để Đọc Web Dễ Dàng Hơn

Ứng dụng iOS của Google giờ đây bao gồm tính năng “Simplify”, sử dụng AI để chuyển đổi văn bản web phức tạp thành nội dung rõ ràng, dễ hiểu mà không cần rời khỏi trang.Công cụ Simplify, được phát triể

12:00:59 GMT+07:00 Ngày 06 tháng 8 năm 2025

12:00:59 GMT+07:00 Ngày 06 tháng 8 năm 2025

Google's AI comeback is wild! 😎 I thought they were out of the game, but their enterprise push is sneaky strong. Wonder if they’ll dominate the market soon?

0

0

08:25:03 GMT+07:00 Ngày 22 tháng 7 năm 2025

08:25:03 GMT+07:00 Ngày 22 tháng 7 năm 2025

Google's quiet climb in enterprise AI is wild! 😎 I thought they were out of the game, but this Transformer legacy is no joke. Curious if they’ll outpace Microsoft soon?

0

0

01:20:20 GMT+07:00 Ngày 23 tháng 4 năm 2025

01:20:20 GMT+07:00 Ngày 23 tháng 4 năm 2025

GoogleのエンタープライズAIへの進出は感動的だね。追いつくことから先頭に立つまで、彼らは本当にゲームを上げた。でもインターフェースはもう少し改善が必要だね;ちょっとぎこちない。でも、これからどこに向かうのか楽しみだよ!🚀

0

0

22:53:12 GMT+07:00 Ngày 22 tháng 4 năm 2025

22:53:12 GMT+07:00 Ngày 22 tháng 4 năm 2025

Google's move into enterprise AI is impressive. From playing catch-up to leading the pack, they've really stepped up their game. But the interface could use some work; it's a bit clunky. Still, I'm excited to see where they go from here! 🚀

0

0

14:22:36 GMT+07:00 Ngày 22 tháng 4 năm 2025

14:22:36 GMT+07:00 Ngày 22 tháng 4 năm 2025

El movimiento sigiloso de Google en la IA empresarial es bastante genial. De ir a la zaga a liderar el grupo, realmente han dado la vuelta a la situación. La tecnología es sólida pero la interfaz podría ser más amigable para el usuario. Aún así, es impresionante lo rápido que se han movido! 🚀

0

0

13:10:16 GMT+07:00 Ngày 22 tháng 4 năm 2025

13:10:16 GMT+07:00 Ngày 22 tháng 4 năm 2025

A jogada furtiva do Google no AI empresarial é bem legal. De tentar alcançar a liderar o grupo, eles realmente mudaram as coisas. A tecnologia é sólida, mas a interface poderia ser mais amigável ao usuário. Ainda assim, é impressionante como eles se moveram rápido! 🚀

0

0