Google übertrifft heimlich in Enterprise AI: Von 'Aufhole', um uns zu fangen

Vor nur einem Jahr schien die Begeisterung um Google und Unternehmens-KI auf neutral festzustecken. Trotz bahnbrechender Technologien wie dem Transformer wirkte der Tech-Gigant zurückgefallen, überschattet vom viralen Erfolg von OpenAI, der Programmierkompetenz von Anthropic und Microsofts aggressivem Vorstoß in den Unternehmensmarkt.

Doch einen Sprung nach vorne zur letzten Woche bei Google Cloud Next 2025 in Las Vegas, und die Szenerie war deutlich anders. Ein selbstbewusstes Google, ausgestattet mit leistungsstarken Modellen, robuster Infrastruktur und einer klaren Unternehmensstrategie, verkündete eine dramatische Wende. In einem vertraulichen Analystentreffen mit hochrangigen Google-Führungskräften fasste ein Analyst die Stimmung zusammen: „Das fühlt sich an wie der Moment, in dem Google von ‚aufholen‘ zu ‚fangt uns ein‘ gewechselt ist.“

Googles Sprung nach vorn

Diese Stimmung – dass Google nicht nur aufgeholt, sondern OpenAI und Microsoft im Rennen um Unternehmens-KI überholt hat – war während der gesamten Veranstaltung spürbar. Und es ist nicht nur Marketing-Hype. Im vergangenen Jahr hat Google intensiv an der Umsetzung gearbeitet und seine technologische Stärke in eine hochleistungsfähige, integrierte Plattform verwandelt, die schnell die Entscheidungsträger in Unternehmen überzeugt. Von den weltweit leistungsstärksten KI-Modellen, die auf hocheffizientem, maßgeschneidertem Silizium laufen, bis hin zu einem wachsenden Ökosystem von KI-Agenten, die auf reale geschäftliche Herausforderungen zugeschnitten sind, macht Google deutlich, dass es nie wirklich verloren war, sondern eine Phase tiefer, grundlegender Entwicklung durchlaufen hat.

Mit seinem nun voll funktionsfähigen integrierten Stack scheint Google bereit, die nächste Phase der Unternehmens-KI-Revolution anzuführen. In meinen Interviews mit Google-Führungskräften bei Next betonten sie die einzigartigen Vorteile von Google in Infrastruktur und Modellintegration – Vorteile, die Konkurrenten wie OpenAI, Microsoft oder AWS nur schwer nachahmen können.

Der Schatten des Zweifels: Die jüngste Vergangenheit anerkennen

Um Googles aktuelle Dynamik vollständig zu würdigen, ist es wichtig, die jüngste Vergangenheit anzuerkennen. Google hat die Transformer-Architektur erfunden, die die moderne Revolution bei großen Sprachmodellen (LLMs) ausgelöst hat, und begann vor einem Jahrzehnt in spezialisierte KI-Hardware (TPUs) zu investieren, die heute branchenführende Effizienz bietet. Doch unerklärlicherweise fand sich Google vor nur zweieinhalb Jahren in der Defensive wieder.

OpenAIs ChatGPT eroberte die Fantasie der Öffentlichkeit und das Interesse von Unternehmen in atemberaubendem Tempo und wurde zur am schnellsten wachsenden App der Geschichte. Konkurrenten wie Anthropic eroberten Nischen in Bereichen wie Programmierung. Währenddessen wirkten Googles öffentliche Schritte oft zögerlich oder fehlerhaft. Die berüchtigten Patzer bei der Bard-Demo 2023 und die Kontroverse um den Bildgenerator, der historisch ungenaue Darstellungen produzierte, nährten die Erzählung eines Unternehmens, das möglicherweise durch interne Bürokratie oder übermäßige Korrekturen bei der Ausrichtung behindert wurde. Google wirkte verloren, ähnlich wie bei seinem anfänglichen Zögern im Cloud-Wettbewerb, wo es hinter Amazon und Microsoft nur den dritten Platz in der Marktanteil belegte.

Die Wende: Eine bewusste Entscheidung zur Führung

Hinter den Kulissen vollzog sich jedoch ein bedeutender Wandel, angetrieben von einer bewussten Entscheidung auf höchster Ebene, die Führung zurückzugewinnen. Mat Velloso, VP für Produkte bei Googles DeepMind AI Developer Platform, spürte diesen entscheidenden Moment, als er im Februar 2024 zu Google kam, nachdem er Microsoft verlassen hatte. „Als ich zu Google kam, sprach ich mit Sundar [Pichai], ich sprach mit mehreren Führungskräften hier, und ich hatte das Gefühl, dass dies der Moment war, in dem sie entschieden, okay, diese [generative KI] ist etwas, das die Branche eindeutig interessiert. Lass es uns verwirklichen“, teilte Velloso während eines Interviews bei Next letzte Woche mit.

Dieser erneuerte Vorstoß wurde nicht durch den gefürchteten „Brain Drain“ behindert, den einige Außenstehende befürchteten, dass er Google entvölkern würde. Stattdessen verdoppelte das Unternehmen Anfang 2024 seine Bemühungen um Umsetzung, geprägt von aggressiven Einstellungen, interner Vereinheitlichung und Kundenakzeptanz. Während Konkurrenten spektakuläre Neueinstellungen machten, behielt Google seine zentrale KI-Führung, einschließlich DeepMind-CEO Demis Hassabis und Google Cloud-CEO Thomas Kurian, was Stabilität und tiefes Fachwissen bot.

Darüber hinaus begann Talent in Richtung von Googles fokussierter Mission zu strömen. Logan Kilpatrick kehrte beispielsweise von OpenAI zu Google zurück, angezogen von der Möglichkeit, grundlegende KI innerhalb des Unternehmens aufzubauen. Er trat Velloso bei in dem, was er als „Zero-to-One-Erlebnis“ beschrieb, mit der Aufgabe, die Entwicklerakzeptanz für Gemini von Grund auf aufzubauen. „Es war, als wäre das Team am ersten Tag nur ich... wir haben keine Nutzer auf dieser Plattform, wir haben keine Einnahmen. Niemand interessiert sich im Moment für Gemini“, erinnerte sich Kilpatrick an den Ausgangspunkt. Führungskräfte wie Josh Woodward, der AI Studio mitbegründete und nun die Gemini App und Labs leitet, und Noam Shazeer, ein maßgeblicher Mitautor des ursprünglichen „Attention Is All You Need“ Transformer-Papiers, kehrten ebenfalls Ende 2024 als technischer Co-Leiter für das entscheidende Gemini-Projekt zurück.

Säule 1: Gemini 2.5 und die Ära der denkenden Modelle

Während das Unternehmensmantra sich auf „es geht nicht nur um das Modell“ verlagert hat, bleibt es eine bedeutende Errungenschaft und ein starker Validierer der überlegenen Forschung und effizienten Technologiearchitektur eines Unternehmens, das leistungsstärkste LLM zu haben. Mit der Veröffentlichung von Gemini 2.5 Pro wenige Wochen vor Next '25 hat Google diesen Titel entschieden für sich beansprucht. Es führte schnell die unabhängige Chatbot Arena-Rangliste an, übertraf deutlich selbst OpenAIs neueste GPT-4o-Variante und meisterte notorisch schwierige Denkbenchmarks wie Humanity’s Last Exam. Wie Pichai in der Keynote erklärte: „Es ist unser intelligentestes KI-Modell aller Zeiten. Und es ist das beste Modell der Welt.“ Das Modell habe innerhalb eines Monats zu einem Anstieg der Gemini-Nutzung um 80 Prozent geführt, twitterte er separat.

Zum ersten Mal war die Nachfrage nach Gemini entfacht. Was mich beeindruckte, abgesehen von der rohen Intelligenz von Gemini 2.5 Pro, war seine nachweisbare Denkfähigkeit. Google hat eine „denkende“ Fähigkeit entwickelt, die es dem Modell ermöglicht, mehrstufiges Denken, Planung und sogar Selbstreflexion durchzuführen, bevor es eine endgültige Antwort liefert. Der strukturierte, kohärente Gedankengang (CoT) – mit nummerierten Schritten und Unterpunkten – vermeidet die weitschweifige oder undurchsichtige Natur der Ausgaben anderer Modelle von DeepSeek oder OpenAI. Für technische Teams, die Ausgaben für kritische Aufgaben bewerten, ermöglicht diese Transparenz Validierung, Korrektur und Umleitung mit beispiellosem Vertrauen.

Wichtiger für Unternehmensnutzer ist, dass Gemini 2.5 Pro auch die Lücke beim Programmieren erheblich geschlossen hat, einem der größten Anwendungsbereiche für generative KI. In einem Interview mit VentureBeat sagte CTO Fiona Tan des führenden Einzelhändlers Wayfair, dass das Unternehmen nach ersten Tests festgestellt habe, dass es „einen erheblichen Sprung gemacht“ habe und nun „ziemlich vergleichbar“ mit Anthropics Claude 3.7 Sonnet sei, das zuvor die bevorzugte Wahl vieler Entwickler war.

Google fügte dem Modell auch ein massives Kontextfenster von 1 Million Token hinzu, das Denken über gesamte Codebasen oder umfangreiche Dokumentationen ermöglicht und die Fähigkeiten der Modelle von OpenAI oder Anthropic weit übertrifft. (OpenAI reagierte diese Woche mit Modellen mit ähnlich großen Kontextfenstern, obwohl Benchmarks darauf hindeuten, dass Gemini 2.5 Pro einen Vorteil im Gesamtdenken behält). Dieser Vorteil ermöglicht komplexe, mehrdateilige Softwareentwicklungsaufgaben.

Ergänzend zu Pro ist Gemini 2.5 Flash, das bei Next '25 angekündigt und gestern veröffentlicht wurde. Ebenfalls ein „denkendes“ Modell, ist Flash für niedrige Latenz und Kosteneffizienz optimiert. Sie können steuern, wie viel das Modell denkt, und Leistung mit Ihrem Budget abwägen. Dieser gestaffelte Ansatz spiegelt die von Google-Führungskräften geförderte „Intelligenz pro Dollar“-Strategie wider.

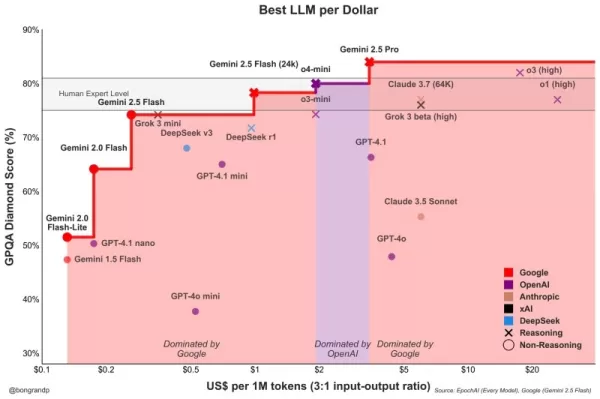

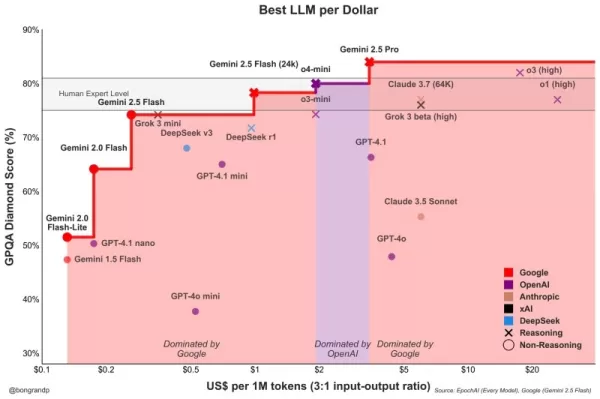

Velloso zeigte ein Diagramm, das zeigte, dass Google-Modelle über das gesamte Intelligenzspektrum hinweg den besten Wert bieten. „Hätten wir dieses Gespräch vor einem Jahr geführt... hätte ich nichts vorzuzeigen gehabt“, gab Velloso zu und betonte die schnelle Wende. „Und jetzt, wie, flächendeckend, wenn Sie nach irgendeinem Modell suchen, egal welcher Größe, wenn Sie nicht Google sind, verlieren Sie Geld.“ Ähnliche Diagramme wurden aktualisiert, um die neuesten Modellveröffentlichungen von OpenAI diese Woche zu berücksichtigen, und zeigen alle dasselbe: Googles Modelle bieten die beste Intelligenz pro Dollar. Siehe unten:

Wayfairs Tan bemerkte auch vielversprechende Latenzverbesserungen bei 2.5 Pro: „Gemini 2.5 kam schneller zurück“, was es für „mehr kundenorientierte Fähigkeiten“ geeignet macht, sagte sie, etwas, das bei anderen Modellen zuvor nicht der Fall war. Gemini könnte das erste Modell sein, das Wayfair für diese Kundeninteraktionen verwendet, sagte sie.

Die Fähigkeiten der Gemini-Familie erstrecken sich auf Multimodalität und integrieren sich nahtlos mit Googles anderen führenden Modellen wie Imagen 3 (Bildgenerierung), Veo 2 (Videogenerierung), Chirp 3 (Audio) und dem neu angekündigten Lyria (Text-zu-Musik), die alle über Googles Plattform für Unternehmensnutzer, Vertex, zugänglich sind. Google ist das einzige Unternehmen, das seine eigenen generativen Medienmodelle über alle Modalitäten auf seiner Plattform anbietet. Microsoft, AWS und OpenAI müssen mit anderen Unternehmen zusammenarbeiten, um dies zu erreichen.

Säule 2: Infrastrukturkompetenz – Die Maschine unter der Haube

Die Fähigkeit, diese leistungsstarken Modelle schnell zu iterieren und effizient bereitzustellen, resultiert aus Googles wohl einzigartiger Infrastruktur, die über Jahrzehnte des Betriebs planetenweiter Dienste verfeinert wurde. Zentral dafür ist die Tensor Processing Unit (TPU).

Bei Next '25 stellte Google Ironwood vor, seine siebte Generation von TPUs, die explizit für die Anforderungen von Inferenz und „denkenden Modellen“ entwickelt wurde. Der Umfang ist enorm, zugeschnitten auf anspruchsvolle KI-Arbeitslasten: Ironwood-Pods enthalten über 9.000 flüssigkeitsgekühlte Chips und liefern angeblich 42,5 Exaflops Rechenleistung. Googles VP für ML-Systeme Amin Vahdat sagte auf der Bühne bei Next, dass dies „mehr als 24 Mal“ die Rechenleistung des derzeit weltweit führenden Supercomputers sei.

Google erklärte, dass Ironwood im Vergleich zu Trillium, der vorherigen TPU-Generation, eine doppelte Leistung pro Watt bietet. Dies ist bedeutend, da Unternehmenskunden zunehmend sagen, dass Energiekosten und Verfügbarkeit groß angelegte KI-Bereitstellungen einschränken.

Google Cloud CTO Will Grannis betonte die Konstanz dieses Fortschritts. Jahr für Jahr erzielt Google 10-fache, 8-fache, 9-fache, 10-fache Verbesserungen bei seinen Prozessoren, sagte er in einem Interview mit VentureBeat und schuf, was er ein „Hyper-Moore’sches Gesetz“ für KI-Beschleuniger nannte. Er sagte, dass Kunden Googles Roadmap kaufen, nicht nur seine Technologie.

Googles Position hat diese nachhaltige TPU-Investition befeuert. Es muss massive Dienste wie Search, YouTube und Gmail für mehr als 2 Milliarden Nutzer effizient betreiben. Dies erforderte die Entwicklung maßgeschneiderter, optimierter Hardware lange vor dem aktuellen generativen KI-Boom. Während Meta auf ähnlicher Konsumentenskala operiert, fehlte anderen Konkurrenten dieser spezifische interne Antrieb für eine jahrzehntelange, vertikal integrierte KI-Hardwareentwicklung.

Jetzt zahlen sich diese TPU-Investitionen aus, da sie nicht nur die Effizienz für Googles eigene Apps steigern, sondern es Google auch ermöglichen, Gemini anderen Nutzern zu einem besseren Intelligenz-pro-Dollar-Verhältnis anzubieten, alles andere gleich.

Warum können Googles Konkurrenten keine effizienten Prozessoren von Nvidia kaufen, fragen Sie? Es stimmt, dass Nvidias GPU-Prozessoren die Prozessvorverarbeitung von LLMs dominieren. Aber die Marktnachfrage hat die Preise dieser GPUs in die Höhe getrieben, und Nvidia nimmt einen gesunden Gewinnanteil für sich selbst. Dies führt zu erheblichen Kosten für die Nutzer seiner Chips. Und während die Vorverarbeitung bisher die Nutzung von KI-Chips dominiert hat, ändert sich dies nun, da Unternehmen diese Anwendungen tatsächlich einsetzen. Hier kommt die „Inferenz“ ins Spiel, und hier gelten TPUs als effizienter als GPUs für Arbeitslasten im großen Maßstab.

Wenn Sie Google-Führungskräfte fragen, woher ihr Hauptechnologievorteil in der KI kommt, verweisen sie meist auf die TPU als das Wichtigste. Mark Lohmeyer, der VP, der Googles Recheninfrastruktur leitet, war eindeutig: TPUs sind „sicherlich ein stark differenzierter Teil dessen, was wir tun... OpenAI, sie haben diese Fähigkeiten nicht.“

Bedeutsam ist, dass Google TPUs nicht isoliert präsentiert, sondern als Teil der umfassenderen, komplexeren Unternehmens-KI-Architektur. Für technische Insider ist klar, dass Spitzenleistungen von der Integration immer spezialisierterer technologischer Durchbrüche abhängen. Viele Updates wurden bei Next detailliert beschrieben. Vahdat beschrieb dies als ein „Supercomputing-System“, das Hardware (TPUs, die neuesten Nvidia-GPUs wie Blackwell und die kommende Vera Rubin, fortschrittliche Speicher wie Hyperdisk Exapools, Anywhere Cache und Rapid Storage) mit einem einheitlichen Software-Stack integriert. Dieser Software-Stack umfasst Cluster Director zur Verwaltung von Beschleunigern, Pathways (Gemini’s verteilter Laufzeit, jetzt für Kunden verfügbar) und bringt Optimierungen wie vLLM auf TPUs, was eine einfachere Arbeitslastmigration für diejenigen ermöglicht, die zuvor auf Nvidia/PyTorch-Stacks waren. Dieses integrierte System, argumentierte Vahdat, ist der Grund, warum Gemini 2.0 Flash eine 24-fache höhere Intelligenz pro Dollar im Vergleich zu GPT-4o erreicht.

Google erweitert auch seine physische Infrastruktur. Cloud WAN macht Googles latenzarmes 2-Millionen-Meilen-Privates Glasfasernetz für Unternehmen verfügbar und verspricht bis zu 40 % schnellere Leistung und 40 % niedrigere Gesamtbetriebskosten (TCO) im Vergleich zu kundenverwalteten Netzwerken.

Darüber hinaus ermöglicht Google Distributed Cloud (GDC) Gemini und Nvidia-Hardware (über eine Partnerschaft mit Dell) in souveränen, lokalen oder sogar luftgekoppelten Umgebungen zu betreiben – eine Fähigkeit, die Nvidia-CEO Jensen Huang als „absolut gigantisch“ für die Bereitstellung modernster KI in regulierten Industrien und Nationen lobte. Bei Next nannte Huang Googles Infrastruktur die beste der Welt: „Kein Unternehmen ist in jeder einzelnen Schicht des Computings besser als Google und Google Cloud“, sagte er.

Säule 3: Der integrierte Full Stack – Die Punkte verbinden

Googles strategischer Vorteil wächst, wenn man bedenkt, wie diese Modelle und Infrastrukturkomponenten zu einer kohärenten Plattform verwoben sind. Im Gegensatz zu Konkurrenten, die oft auf Partnerschaften angewiesen sind, um Lücken zu schließen, kontrolliert Google nahezu jede Schicht, was eine engere Integration und schnellere Innovationszyklen ermöglicht.

Warum ist diese Integration wichtig, wenn ein Konkurrent wie Microsoft einfach mit OpenAI zusammenarbeiten kann, um die Infrastrukturbreite mit der Modellstärke von LLMs zu kombinieren? Die Googler, mit denen ich sprach, sagten, dass es einen großen Unterschied macht, und sie brachten Anekdoten, um dies zu untermauern.

Nehmen Sie die erhebliche Verbesserung der Unternehmensdatenbank BigQuery von Google. Die Datenbank bietet jetzt einen Wissensgraphen, der LLMs ermöglicht, Daten viel effizienter zu durchsuchen, und sie hat nun mehr als fünfmal so viele Kunden wie Konkurrenten wie Snowflake und Databricks. Yasmeen Ahmad, Leiterin für Produkt-Datenanalytik bei Google Cloud, sagte, dass die enormen Verbesserungen nur möglich waren, weil Googles Datenteams eng mit dem DeepMind-Team zusammenarbeiteten. Sie arbeiteten an Anwendungsfällen, die schwer zu lösen waren, und dies führte dazu, dass die Datenbank basierend auf gängigen Anfragen laut Googles internen Tests 50 Prozent mehr Genauigkeit bei der Bereitstellung der richtigen Daten als die nächstgelegenen Konkurrenten bietet, sagte Ahmad in einem Interview mit VentureBeat. Ahmad sagte, dass diese Art der tiefen Integration über den gesamten Stack hinweg der Grund ist, warum Google die Branche „überholt“ hat.

Diese interne Kohäsion steht in scharfem Kontrast zur „Frenemies“-Dynamik bei Microsoft. Während Microsoft mit OpenAI zusammenarbeitet, um seine Modelle auf der Azure-Cloud zu verteilen, baut Microsoft auch eigene Modelle. Mat Velloso, der Google-Führungskraft, die jetzt das KI-Entwicklerprogramm leitet, verließ Microsoft, nachdem er frustriert war, die Pläne für Windows Copilot mit OpenAIs Modellangeboten abzustimmen. „Wie teilt man seine Produktpläne mit einem anderen Unternehmen, das tatsächlich mit Ihnen konkurriert... Das Ganze ist ein Widerspruch“, erinnerte er sich. „Hier sitze ich Seite an Seite mit den Leuten, die die Modelle bauen.“

Diese Integration spricht für das, was Google-Führungskräfte als ihren Kernvorteil sehen: ihre einzigartige Fähigkeit, tiefes Fachwissen über das gesamte Spektrum zu verbinden, von der Grundlagenforschung und dem Modellbau bis hin zur „planetenskalierten“ Anwendungsbereitstellung und Infrastrukturdesign.

Vertex AI dient als zentrales Nervensystem für Googles Unternehmens-KI-Bemühungen. Und die Integration geht über Googles eigene Angebote hinaus. Vertex’s Model Garden bietet über 200 kuratierte Modelle, einschließlich Googles, Metas Llama 4 und zahlreicher Open-Source-Optionen. Vertex bietet Werkzeuge für Tuning, Evaluierung (einschließlich KI-gestützter Evals, die Grannis als entscheidenden Beschleuniger hervorhob), Bereitstellung und Überwachung. Seine Grounding-Fähigkeiten nutzen interne KI-fähige Datenbanken neben der Kompatibilität mit externen Vektordatenbanken. Hinzu kommen Googles neue Angebote, um Modelle mit Google Search, der weltweit besten Suchmaschine, zu verankern.

Die Integration erstreckt sich auf Google Workspace. Neue Funktionen, die bei Next '25 angekündigt wurden, wie „Help Me Analyze“ in Sheets (ja, Sheets hat jetzt eine „=AI“-Formel), Audio Overviews in Docs und Workspace Flows, betten die Fähigkeiten von Gemini weiter in tägliche Arbeitsabläufe ein und schaffen eine leistungsstarke Feedback-Schleife, die Google nutzt, um die Erfahrung zu verbessern.

Während Google seinen integrierten Stack vorantreibt, setzt es auch auf Offenheit, wo es dem Ökosystem dient. Nachdem es die Kubernetes-Adoption vorangetrieben hat, fördert es jetzt JAX für KI-Frameworks und nun offene Protokolle für die Agentenkommunikation (A2A) neben der Unterstützung bestehender Standards (MCP). Google bietet auch Hunderte von Konnektoren zu externen Plattformen innerhalb von Agentspace, Googles neuem einheitlichem Interface für Mitarbeiter, um Agenten zu finden und zu nutzen. Dieses Hub-Konzept ist überzeugend. Die Keynote-Demonstration von Agentspace (ab 51:40) veranschaulicht dies. Google bietet Nutzern vorgefertigte Agenten, oder Mitarbeiter oder Entwickler können ihre eigenen mit No-Code-KI-Fähigkeiten erstellen. Oder sie können Agenten von außen über A2A-Konnektoren einbinden. Es integriert sich nahtlos in den Chrome-Browser.

Säule 4: Fokus auf Unternehmenswert und das Agenten-Ökosystem

Die vielleicht bedeutendste Veränderung ist Googles geschärfter Fokus auf die Lösung konkreter Unternehmensprobleme, insbesondere durch die Linse der KI-Agenten. Thomas Kurian, CEO von Google Cloud, nannte drei Gründe, warum Kunden Google wählen: die KI-optimierte Plattform, den offenen Multi-Cloud-Ansatz, der die Verbindung zu bestehenden IT-Systemen ermöglicht, und den unternehmensgerechten Fokus auf Sicherheit, Souveränität und Compliance.

Agenten sind der Schlüssel zu dieser Strategie. Neben AgentSpace umfasst dies auch:

- Bausteine: Das Open-Source-Agent Development Kit (ADK), das bei Next angekündigt wurde, hat bereits erhebliches Interesse bei Entwicklern geweckt. Das ADK vereinfacht die Erstellung von Multi-Agenten-Systemen, während das vorgeschlagene Agent2Agent (A2A)-Protokoll die Interoperabilität sicherstellen soll, sodass Agenten, die mit verschiedenen Tools (Gemini ADK, LangGraph, CrewAI usw.) erstellt wurden, zusammenarbeiten können. Googles Grannis sagte, dass A2A die Skalierungs- und Sicherheitsherausforderungen einer Zukunft mit potenziell Hunderttausenden interagierender Agenten antizipiert.

- Maßgeschneiderte Agenten: Google präsentierte Expertenagenten, die in Agentspace integriert sind (wie NotebookLM, Ideengenerierung, Tiefenforschung) und hob fünf Schlüsselkategorien hervor, die an Zugkraft gewinnen: Kundenagenten (die Tools wie Reddit Answers, Verizons Support-Assistent, Wendys Drive-Thru antreiben), Kreative Agenten (genutzt von WPP, Brandtech, Sphere), Datenagenten (die Erkenntnisse bei Mattel, Spotify, Bayer liefern), Programmieragenten (Gemini Code Assist) und Sicherheitsagenten (integriert in die neue Google Unified Security-Plattform).

Diese umfassende Agentenstrategie scheint Anklang zu finden. Gespräche mit Führungskräften von drei weiteren großen Unternehmen in der letzten Woche, die aufgrund wettbewerblicher Sensibilitäten anonym sprachen, spiegelten diese Begeisterung für Googles Agentenstrategie wider. Google Cloud COO Francis DeSouza bestätigte in einem Interview: „Jedes Gespräch beinhaltet KI. Insbesondere jedes Gespräch beinhaltet Agenten.“

Kevin Laughridge, ein Führungskraft bei Deloitte, ein großer Nutzer von Googles KI-Produkten und ein Distributor davon an andere Unternehmen, beschrieb den Agentenmarkt als ein „Landgrab“, bei dem Googles frühe Schritte mit Protokollen und seiner integrierten Plattform erhebliche Vorteile bieten. „Wer zuerst herauskommt und die meisten Agenten liefert, die tatsächlich Mehrwert bieten – der wird dieses Rennen gewinnen“, sagte Laughridge in einem Interview. Er sagte, Googles Fortschritt sei „erstaunlich“ und stellte fest, dass benutzerdefinierte Agenten, die Deloitte vor nur einem Jahr gebaut hat, jetzt „aus der Box“ mit Agentspace repliziert werden könnten. Deloitte selbst baut 100 Agenten auf der Plattform, die auf mittlere Bürofunkktionen wie Finanzen, Risiko und Ingenieurwesen abzielen, sagte er.

Die Kundenbelege häufen sich. Bei Next nannte Google „über 500 Kunden in Produktion“ mit generativer KI, gegenüber nur „Dutzenden von Prototypen“ vor einem Jahr. Wenn Microsoft vor einem Jahr als weit voraus wahrgenommen wurde, scheint das nicht mehr so offensichtlich zu sein. Angesichts des PR-Kriegs von allen Seiten ist es schwer zu sagen, wer derzeit definitiv gewinnt. Die Metriken variieren. Googles 500er-Zahl ist nicht direkt vergleichbar mit den 400 Fallstudien, die Microsoft bewirbt (und Microsoft erklärte gegenüber VentureBeat zum Zeitpunkt der Berichterstattung, dass es plant, diese öffentliche Zählung bald auf 600 zu aktualisieren, was die intensive Vermarktung unterstreicht). Und wenn Googles Verteilung von KI durch seine Apps bedeutend ist, ist Microsofts Copilot-Verteilung durch sein 365-Angebot ebenso beeindruckend. Beide erreichen jetzt Millionen von Entwicklern durch APIs.

Aber Beispiele für Googles Zugkraft gibt es reichlich:

- Wendy’s: Hat ein KI-Drive-Thru-System in Tausenden von Standorten in nur einem Jahr eingeführt, was die Mitarbeitererfahrung und die Bestellgenauigkeit verbessert. Google Cloud CTO Will Grannis bemerkte, dass das KI-System in der Lage ist, Slang zu verstehen und Hintergrundgeräusche herauszufiltern, was den Stress von Live-Kundeninteraktionen erheblich reduziert. Das befreit das Personal, sich auf die Zubereitung und Qualität der Speisen zu konzentrieren – eine Veränderung, die Grannis als „ein großartiges Beispiel für KI, die reale Abläufe rationalisiert“ bezeichnete.

- Salesforce: Kündigte eine große Expansion an, die es seiner Plattform ermöglicht, erstmals auf Google Cloud zu laufen (über AWS hinaus), und verwies auf Googles Fähigkeit, ihnen zu helfen, „zu innovieren und zu optimieren“.

- Honeywell & Intuit: Unternehmen, die zuvor stark mit Microsoft bzw. AWS verbunden waren, arbeiten nun mit Google Cloud an KI-Initiativen.

- Große Banken (Deutsche Bank, Wells Fargo): Nutzen Agenten und Gemini für Forschung, Analyse und Modernisierung des Kundenservices.

- Einzelhändler (Walmart, Mercado Libre, Lowe’s): Verwenden Suche, Agenten und Datenplattformen.

Diese Unternehmenstraktion befeuert das Gesamtwachstum von Google Cloud, das in den letzten drei Quartalen AWS und Azure übertroffen hat. Google Cloud erreichte 2024 eine annualisierte Umsatzrate von 44 Milliarden Dollar, gegenüber nur 5 Milliarden Dollar im Jahr 2018.

Navigieren in den Wettbewerbsgewässern

Googles Aufstieg bedeutet nicht, dass die Konkurrenten stillstehen. OpenAIs schnelle Veröffentlichungen diese Woche von GPT-4.1 (fokussiert auf Programmierung und langen Kontext) und der o-Serie (multimodales Denken, Werkzeugnutzung) zeigen OpenAIs fortgesetzte Innovation. Darüber hinaus hat OpenAIs neues Update für die Bildgenerierungsfunktion in GPT-4o im letzten Monat ein massives Wachstum angeheizt und ChatGPT geholfen, 800 Millionen Nutzer zu erreichen. Microsoft nutzt weiterhin seine riesige Unternehmenspräsenz und die Partnerschaft mit OpenAI, während Anthropic ein starker Konkurrent bleibt, insbesondere in Programmierung und sicherheitsbewussten Anwendungen.

Dennoch ist unbestreitbar, dass Googles Erzählung sich bemerkenswert verbessert hat. Vor nur einem Jahr wurde Google als schwerfälliger, zögerlicher, stolpernder Konkurrent angesehen, der vielleicht kurz davor stand, seine Chance auf die Führung in der KI zu verspielen. Stattdessen haben sein einzigartiger, integrierter Stack und seine unternehmerische Standhaftigkeit etwas anderes offenbart: Google verfügt über erstklassige Fähigkeiten über das gesamte Spektrum – vom Chipdesign (TPUs) und globaler Infrastruktur bis hin zur Grundlagenforschung (DeepMind), Anwendungsentwicklung (Workspace, Search, YouTube) und Unternehmens-Cloud-Diensten (Vertex AI, BigQuery, Agentspace). „Wir sind der einzige Hyperscaler, der im Gespräch über grundlegende Modelle ist“, erklärte deSouza schlicht. Diese End-to-End-Kontrolle ermöglicht Optimierungen (wie „Intelligenz pro Dollar“) und eine Integrationstiefe, die partnerschaftsabhängige Modelle schwer erreichen können. Konkurrenten müssen oft disparate Teile zusammenfügen, was potenziell Reibung erzeugt oder die Innovationsgeschwindigkeit einschränkt.

Googles Moment ist jetzt

Während das KI-Rennen dynamisch bleibt, hat Google all diese Teile genau in dem Moment zusammengesetzt, in dem der Markt sie verlangt. Wie Deloittes Laughridge es ausdrückte, hat Google einen Punkt erreicht, an dem seine Fähigkeiten perfekt mit den Marktanforderungen übereinstimmen. Wenn Sie darauf gewartet haben, dass Google sich in der Unternehmens-KI beweist, haben Sie den Moment vielleicht verpasst – es hat es bereits getan. Das Unternehmen, das viele der Kerntechnologien erfunden hat, die diese Revolution antreiben, scheint endlich aufgeholt zu haben – und mehr als das, es setzt nun das Tempo, das die Konkurrenten einholen müssen.

Im Video unten, aufgenommen direkt nach Next, analysieren KI-Experte Sam Witteveen und ich die aktuelle Landschaft und aufkommende Trends und warum Googles KI-Ökosystem so stark wirkt:

Verwandter Artikel

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Googles neuestes KI-Modell Gemini zeigt sinkende Sicherheitswerte in Tests

Interne Tests von Google zeigen, dass die Sicherheitsprotokolle des neuesten KI-Modells im Vergleich zu den Vorgängerversionen bedenkliche Leistungseinbußen aufweisen. Nach neu veröffentlichten Benchm

Googles neuestes KI-Modell Gemini zeigt sinkende Sicherheitswerte in Tests

Interne Tests von Google zeigen, dass die Sicherheitsprotokolle des neuesten KI-Modells im Vergleich zu den Vorgängerversionen bedenkliche Leistungseinbußen aufweisen. Nach neu veröffentlichten Benchm

Alibabas "ZeroSearch" KI senkt Trainingskosten um 88% durch autonomes Lernen

Alibabas ZeroSearch: Ein Wendepunkt für die Effizienz des KI-TrainingsForscher der Alibaba Group haben eine bahnbrechende Methode entwickelt, die möglicherweise die Art und Weise revolutioniert, wie K

Kommentare (12)

0/200

Alibabas "ZeroSearch" KI senkt Trainingskosten um 88% durch autonomes Lernen

Alibabas ZeroSearch: Ein Wendepunkt für die Effizienz des KI-TrainingsForscher der Alibaba Group haben eine bahnbrechende Methode entwickelt, die möglicherweise die Art und Weise revolutioniert, wie K

Kommentare (12)

0/200

![EdwardRamirez]() EdwardRamirez

EdwardRamirez

6. August 2025 07:00:59 MESZ

6. August 2025 07:00:59 MESZ

Google's AI comeback is wild! 😎 I thought they were out of the game, but their enterprise push is sneaky strong. Wonder if they’ll dominate the market soon?

0

0

![ThomasBaker]() ThomasBaker

ThomasBaker

22. Juli 2025 03:25:03 MESZ

22. Juli 2025 03:25:03 MESZ

Google's quiet climb in enterprise AI is wild! 😎 I thought they were out of the game, but this Transformer legacy is no joke. Curious if they’ll outpace Microsoft soon?

0

0

![RalphGarcia]() RalphGarcia

RalphGarcia

22. April 2025 20:20:20 MESZ

22. April 2025 20:20:20 MESZ

GoogleのエンタープライズAIへの進出は感動的だね。追いつくことから先頭に立つまで、彼らは本当にゲームを上げた。でもインターフェースはもう少し改善が必要だね;ちょっとぎこちない。でも、これからどこに向かうのか楽しみだよ!🚀

0

0

![FredAnderson]() FredAnderson

FredAnderson

22. April 2025 17:53:12 MESZ

22. April 2025 17:53:12 MESZ

Google's move into enterprise AI is impressive. From playing catch-up to leading the pack, they've really stepped up their game. But the interface could use some work; it's a bit clunky. Still, I'm excited to see where they go from here! 🚀

0

0

![JasonRoberts]() JasonRoberts

JasonRoberts

22. April 2025 09:22:36 MESZ

22. April 2025 09:22:36 MESZ

El movimiento sigiloso de Google en la IA empresarial es bastante genial. De ir a la zaga a liderar el grupo, realmente han dado la vuelta a la situación. La tecnología es sólida pero la interfaz podría ser más amigable para el usuario. Aún así, es impresionante lo rápido que se han movido! 🚀

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

22. April 2025 08:10:16 MESZ

22. April 2025 08:10:16 MESZ

A jogada furtiva do Google no AI empresarial é bem legal. De tentar alcançar a liderar o grupo, eles realmente mudaram as coisas. A tecnologia é sólida, mas a interface poderia ser mais amigável ao usuário. Ainda assim, é impressionante como eles se moveram rápido! 🚀

0

0

Vor nur einem Jahr schien die Begeisterung um Google und Unternehmens-KI auf neutral festzustecken. Trotz bahnbrechender Technologien wie dem Transformer wirkte der Tech-Gigant zurückgefallen, überschattet vom viralen Erfolg von OpenAI, der Programmierkompetenz von Anthropic und Microsofts aggressivem Vorstoß in den Unternehmensmarkt.

Doch einen Sprung nach vorne zur letzten Woche bei Google Cloud Next 2025 in Las Vegas, und die Szenerie war deutlich anders. Ein selbstbewusstes Google, ausgestattet mit leistungsstarken Modellen, robuster Infrastruktur und einer klaren Unternehmensstrategie, verkündete eine dramatische Wende. In einem vertraulichen Analystentreffen mit hochrangigen Google-Führungskräften fasste ein Analyst die Stimmung zusammen: „Das fühlt sich an wie der Moment, in dem Google von ‚aufholen‘ zu ‚fangt uns ein‘ gewechselt ist.“

Googles Sprung nach vorn

Diese Stimmung – dass Google nicht nur aufgeholt, sondern OpenAI und Microsoft im Rennen um Unternehmens-KI überholt hat – war während der gesamten Veranstaltung spürbar. Und es ist nicht nur Marketing-Hype. Im vergangenen Jahr hat Google intensiv an der Umsetzung gearbeitet und seine technologische Stärke in eine hochleistungsfähige, integrierte Plattform verwandelt, die schnell die Entscheidungsträger in Unternehmen überzeugt. Von den weltweit leistungsstärksten KI-Modellen, die auf hocheffizientem, maßgeschneidertem Silizium laufen, bis hin zu einem wachsenden Ökosystem von KI-Agenten, die auf reale geschäftliche Herausforderungen zugeschnitten sind, macht Google deutlich, dass es nie wirklich verloren war, sondern eine Phase tiefer, grundlegender Entwicklung durchlaufen hat.

Mit seinem nun voll funktionsfähigen integrierten Stack scheint Google bereit, die nächste Phase der Unternehmens-KI-Revolution anzuführen. In meinen Interviews mit Google-Führungskräften bei Next betonten sie die einzigartigen Vorteile von Google in Infrastruktur und Modellintegration – Vorteile, die Konkurrenten wie OpenAI, Microsoft oder AWS nur schwer nachahmen können.

Der Schatten des Zweifels: Die jüngste Vergangenheit anerkennen

Um Googles aktuelle Dynamik vollständig zu würdigen, ist es wichtig, die jüngste Vergangenheit anzuerkennen. Google hat die Transformer-Architektur erfunden, die die moderne Revolution bei großen Sprachmodellen (LLMs) ausgelöst hat, und begann vor einem Jahrzehnt in spezialisierte KI-Hardware (TPUs) zu investieren, die heute branchenführende Effizienz bietet. Doch unerklärlicherweise fand sich Google vor nur zweieinhalb Jahren in der Defensive wieder.

OpenAIs ChatGPT eroberte die Fantasie der Öffentlichkeit und das Interesse von Unternehmen in atemberaubendem Tempo und wurde zur am schnellsten wachsenden App der Geschichte. Konkurrenten wie Anthropic eroberten Nischen in Bereichen wie Programmierung. Währenddessen wirkten Googles öffentliche Schritte oft zögerlich oder fehlerhaft. Die berüchtigten Patzer bei der Bard-Demo 2023 und die Kontroverse um den Bildgenerator, der historisch ungenaue Darstellungen produzierte, nährten die Erzählung eines Unternehmens, das möglicherweise durch interne Bürokratie oder übermäßige Korrekturen bei der Ausrichtung behindert wurde. Google wirkte verloren, ähnlich wie bei seinem anfänglichen Zögern im Cloud-Wettbewerb, wo es hinter Amazon und Microsoft nur den dritten Platz in der Marktanteil belegte.

Die Wende: Eine bewusste Entscheidung zur Führung

Hinter den Kulissen vollzog sich jedoch ein bedeutender Wandel, angetrieben von einer bewussten Entscheidung auf höchster Ebene, die Führung zurückzugewinnen. Mat Velloso, VP für Produkte bei Googles DeepMind AI Developer Platform, spürte diesen entscheidenden Moment, als er im Februar 2024 zu Google kam, nachdem er Microsoft verlassen hatte. „Als ich zu Google kam, sprach ich mit Sundar [Pichai], ich sprach mit mehreren Führungskräften hier, und ich hatte das Gefühl, dass dies der Moment war, in dem sie entschieden, okay, diese [generative KI] ist etwas, das die Branche eindeutig interessiert. Lass es uns verwirklichen“, teilte Velloso während eines Interviews bei Next letzte Woche mit.

Dieser erneuerte Vorstoß wurde nicht durch den gefürchteten „Brain Drain“ behindert, den einige Außenstehende befürchteten, dass er Google entvölkern würde. Stattdessen verdoppelte das Unternehmen Anfang 2024 seine Bemühungen um Umsetzung, geprägt von aggressiven Einstellungen, interner Vereinheitlichung und Kundenakzeptanz. Während Konkurrenten spektakuläre Neueinstellungen machten, behielt Google seine zentrale KI-Führung, einschließlich DeepMind-CEO Demis Hassabis und Google Cloud-CEO Thomas Kurian, was Stabilität und tiefes Fachwissen bot.

Darüber hinaus begann Talent in Richtung von Googles fokussierter Mission zu strömen. Logan Kilpatrick kehrte beispielsweise von OpenAI zu Google zurück, angezogen von der Möglichkeit, grundlegende KI innerhalb des Unternehmens aufzubauen. Er trat Velloso bei in dem, was er als „Zero-to-One-Erlebnis“ beschrieb, mit der Aufgabe, die Entwicklerakzeptanz für Gemini von Grund auf aufzubauen. „Es war, als wäre das Team am ersten Tag nur ich... wir haben keine Nutzer auf dieser Plattform, wir haben keine Einnahmen. Niemand interessiert sich im Moment für Gemini“, erinnerte sich Kilpatrick an den Ausgangspunkt. Führungskräfte wie Josh Woodward, der AI Studio mitbegründete und nun die Gemini App und Labs leitet, und Noam Shazeer, ein maßgeblicher Mitautor des ursprünglichen „Attention Is All You Need“ Transformer-Papiers, kehrten ebenfalls Ende 2024 als technischer Co-Leiter für das entscheidende Gemini-Projekt zurück.

Säule 1: Gemini 2.5 und die Ära der denkenden Modelle

Während das Unternehmensmantra sich auf „es geht nicht nur um das Modell“ verlagert hat, bleibt es eine bedeutende Errungenschaft und ein starker Validierer der überlegenen Forschung und effizienten Technologiearchitektur eines Unternehmens, das leistungsstärkste LLM zu haben. Mit der Veröffentlichung von Gemini 2.5 Pro wenige Wochen vor Next '25 hat Google diesen Titel entschieden für sich beansprucht. Es führte schnell die unabhängige Chatbot Arena-Rangliste an, übertraf deutlich selbst OpenAIs neueste GPT-4o-Variante und meisterte notorisch schwierige Denkbenchmarks wie Humanity’s Last Exam. Wie Pichai in der Keynote erklärte: „Es ist unser intelligentestes KI-Modell aller Zeiten. Und es ist das beste Modell der Welt.“ Das Modell habe innerhalb eines Monats zu einem Anstieg der Gemini-Nutzung um 80 Prozent geführt, twitterte er separat.

Zum ersten Mal war die Nachfrage nach Gemini entfacht. Was mich beeindruckte, abgesehen von der rohen Intelligenz von Gemini 2.5 Pro, war seine nachweisbare Denkfähigkeit. Google hat eine „denkende“ Fähigkeit entwickelt, die es dem Modell ermöglicht, mehrstufiges Denken, Planung und sogar Selbstreflexion durchzuführen, bevor es eine endgültige Antwort liefert. Der strukturierte, kohärente Gedankengang (CoT) – mit nummerierten Schritten und Unterpunkten – vermeidet die weitschweifige oder undurchsichtige Natur der Ausgaben anderer Modelle von DeepSeek oder OpenAI. Für technische Teams, die Ausgaben für kritische Aufgaben bewerten, ermöglicht diese Transparenz Validierung, Korrektur und Umleitung mit beispiellosem Vertrauen.

Wichtiger für Unternehmensnutzer ist, dass Gemini 2.5 Pro auch die Lücke beim Programmieren erheblich geschlossen hat, einem der größten Anwendungsbereiche für generative KI. In einem Interview mit VentureBeat sagte CTO Fiona Tan des führenden Einzelhändlers Wayfair, dass das Unternehmen nach ersten Tests festgestellt habe, dass es „einen erheblichen Sprung gemacht“ habe und nun „ziemlich vergleichbar“ mit Anthropics Claude 3.7 Sonnet sei, das zuvor die bevorzugte Wahl vieler Entwickler war.

Google fügte dem Modell auch ein massives Kontextfenster von 1 Million Token hinzu, das Denken über gesamte Codebasen oder umfangreiche Dokumentationen ermöglicht und die Fähigkeiten der Modelle von OpenAI oder Anthropic weit übertrifft. (OpenAI reagierte diese Woche mit Modellen mit ähnlich großen Kontextfenstern, obwohl Benchmarks darauf hindeuten, dass Gemini 2.5 Pro einen Vorteil im Gesamtdenken behält). Dieser Vorteil ermöglicht komplexe, mehrdateilige Softwareentwicklungsaufgaben.

Ergänzend zu Pro ist Gemini 2.5 Flash, das bei Next '25 angekündigt und gestern veröffentlicht wurde. Ebenfalls ein „denkendes“ Modell, ist Flash für niedrige Latenz und Kosteneffizienz optimiert. Sie können steuern, wie viel das Modell denkt, und Leistung mit Ihrem Budget abwägen. Dieser gestaffelte Ansatz spiegelt die von Google-Führungskräften geförderte „Intelligenz pro Dollar“-Strategie wider.

Velloso zeigte ein Diagramm, das zeigte, dass Google-Modelle über das gesamte Intelligenzspektrum hinweg den besten Wert bieten. „Hätten wir dieses Gespräch vor einem Jahr geführt... hätte ich nichts vorzuzeigen gehabt“, gab Velloso zu und betonte die schnelle Wende. „Und jetzt, wie, flächendeckend, wenn Sie nach irgendeinem Modell suchen, egal welcher Größe, wenn Sie nicht Google sind, verlieren Sie Geld.“ Ähnliche Diagramme wurden aktualisiert, um die neuesten Modellveröffentlichungen von OpenAI diese Woche zu berücksichtigen, und zeigen alle dasselbe: Googles Modelle bieten die beste Intelligenz pro Dollar. Siehe unten:

Wayfairs Tan bemerkte auch vielversprechende Latenzverbesserungen bei 2.5 Pro: „Gemini 2.5 kam schneller zurück“, was es für „mehr kundenorientierte Fähigkeiten“ geeignet macht, sagte sie, etwas, das bei anderen Modellen zuvor nicht der Fall war. Gemini könnte das erste Modell sein, das Wayfair für diese Kundeninteraktionen verwendet, sagte sie.

Die Fähigkeiten der Gemini-Familie erstrecken sich auf Multimodalität und integrieren sich nahtlos mit Googles anderen führenden Modellen wie Imagen 3 (Bildgenerierung), Veo 2 (Videogenerierung), Chirp 3 (Audio) und dem neu angekündigten Lyria (Text-zu-Musik), die alle über Googles Plattform für Unternehmensnutzer, Vertex, zugänglich sind. Google ist das einzige Unternehmen, das seine eigenen generativen Medienmodelle über alle Modalitäten auf seiner Plattform anbietet. Microsoft, AWS und OpenAI müssen mit anderen Unternehmen zusammenarbeiten, um dies zu erreichen.

Säule 2: Infrastrukturkompetenz – Die Maschine unter der Haube

Die Fähigkeit, diese leistungsstarken Modelle schnell zu iterieren und effizient bereitzustellen, resultiert aus Googles wohl einzigartiger Infrastruktur, die über Jahrzehnte des Betriebs planetenweiter Dienste verfeinert wurde. Zentral dafür ist die Tensor Processing Unit (TPU).

Bei Next '25 stellte Google Ironwood vor, seine siebte Generation von TPUs, die explizit für die Anforderungen von Inferenz und „denkenden Modellen“ entwickelt wurde. Der Umfang ist enorm, zugeschnitten auf anspruchsvolle KI-Arbeitslasten: Ironwood-Pods enthalten über 9.000 flüssigkeitsgekühlte Chips und liefern angeblich 42,5 Exaflops Rechenleistung. Googles VP für ML-Systeme Amin Vahdat sagte auf der Bühne bei Next, dass dies „mehr als 24 Mal“ die Rechenleistung des derzeit weltweit führenden Supercomputers sei.

Google erklärte, dass Ironwood im Vergleich zu Trillium, der vorherigen TPU-Generation, eine doppelte Leistung pro Watt bietet. Dies ist bedeutend, da Unternehmenskunden zunehmend sagen, dass Energiekosten und Verfügbarkeit groß angelegte KI-Bereitstellungen einschränken.

Google Cloud CTO Will Grannis betonte die Konstanz dieses Fortschritts. Jahr für Jahr erzielt Google 10-fache, 8-fache, 9-fache, 10-fache Verbesserungen bei seinen Prozessoren, sagte er in einem Interview mit VentureBeat und schuf, was er ein „Hyper-Moore’sches Gesetz“ für KI-Beschleuniger nannte. Er sagte, dass Kunden Googles Roadmap kaufen, nicht nur seine Technologie.

Googles Position hat diese nachhaltige TPU-Investition befeuert. Es muss massive Dienste wie Search, YouTube und Gmail für mehr als 2 Milliarden Nutzer effizient betreiben. Dies erforderte die Entwicklung maßgeschneiderter, optimierter Hardware lange vor dem aktuellen generativen KI-Boom. Während Meta auf ähnlicher Konsumentenskala operiert, fehlte anderen Konkurrenten dieser spezifische interne Antrieb für eine jahrzehntelange, vertikal integrierte KI-Hardwareentwicklung.

Jetzt zahlen sich diese TPU-Investitionen aus, da sie nicht nur die Effizienz für Googles eigene Apps steigern, sondern es Google auch ermöglichen, Gemini anderen Nutzern zu einem besseren Intelligenz-pro-Dollar-Verhältnis anzubieten, alles andere gleich.

Warum können Googles Konkurrenten keine effizienten Prozessoren von Nvidia kaufen, fragen Sie? Es stimmt, dass Nvidias GPU-Prozessoren die Prozessvorverarbeitung von LLMs dominieren. Aber die Marktnachfrage hat die Preise dieser GPUs in die Höhe getrieben, und Nvidia nimmt einen gesunden Gewinnanteil für sich selbst. Dies führt zu erheblichen Kosten für die Nutzer seiner Chips. Und während die Vorverarbeitung bisher die Nutzung von KI-Chips dominiert hat, ändert sich dies nun, da Unternehmen diese Anwendungen tatsächlich einsetzen. Hier kommt die „Inferenz“ ins Spiel, und hier gelten TPUs als effizienter als GPUs für Arbeitslasten im großen Maßstab.

Wenn Sie Google-Führungskräfte fragen, woher ihr Hauptechnologievorteil in der KI kommt, verweisen sie meist auf die TPU als das Wichtigste. Mark Lohmeyer, der VP, der Googles Recheninfrastruktur leitet, war eindeutig: TPUs sind „sicherlich ein stark differenzierter Teil dessen, was wir tun... OpenAI, sie haben diese Fähigkeiten nicht.“

Bedeutsam ist, dass Google TPUs nicht isoliert präsentiert, sondern als Teil der umfassenderen, komplexeren Unternehmens-KI-Architektur. Für technische Insider ist klar, dass Spitzenleistungen von der Integration immer spezialisierterer technologischer Durchbrüche abhängen. Viele Updates wurden bei Next detailliert beschrieben. Vahdat beschrieb dies als ein „Supercomputing-System“, das Hardware (TPUs, die neuesten Nvidia-GPUs wie Blackwell und die kommende Vera Rubin, fortschrittliche Speicher wie Hyperdisk Exapools, Anywhere Cache und Rapid Storage) mit einem einheitlichen Software-Stack integriert. Dieser Software-Stack umfasst Cluster Director zur Verwaltung von Beschleunigern, Pathways (Gemini’s verteilter Laufzeit, jetzt für Kunden verfügbar) und bringt Optimierungen wie vLLM auf TPUs, was eine einfachere Arbeitslastmigration für diejenigen ermöglicht, die zuvor auf Nvidia/PyTorch-Stacks waren. Dieses integrierte System, argumentierte Vahdat, ist der Grund, warum Gemini 2.0 Flash eine 24-fache höhere Intelligenz pro Dollar im Vergleich zu GPT-4o erreicht.

Google erweitert auch seine physische Infrastruktur. Cloud WAN macht Googles latenzarmes 2-Millionen-Meilen-Privates Glasfasernetz für Unternehmen verfügbar und verspricht bis zu 40 % schnellere Leistung und 40 % niedrigere Gesamtbetriebskosten (TCO) im Vergleich zu kundenverwalteten Netzwerken.

Darüber hinaus ermöglicht Google Distributed Cloud (GDC) Gemini und Nvidia-Hardware (über eine Partnerschaft mit Dell) in souveränen, lokalen oder sogar luftgekoppelten Umgebungen zu betreiben – eine Fähigkeit, die Nvidia-CEO Jensen Huang als „absolut gigantisch“ für die Bereitstellung modernster KI in regulierten Industrien und Nationen lobte. Bei Next nannte Huang Googles Infrastruktur die beste der Welt: „Kein Unternehmen ist in jeder einzelnen Schicht des Computings besser als Google und Google Cloud“, sagte er.

Säule 3: Der integrierte Full Stack – Die Punkte verbinden

Googles strategischer Vorteil wächst, wenn man bedenkt, wie diese Modelle und Infrastrukturkomponenten zu einer kohärenten Plattform verwoben sind. Im Gegensatz zu Konkurrenten, die oft auf Partnerschaften angewiesen sind, um Lücken zu schließen, kontrolliert Google nahezu jede Schicht, was eine engere Integration und schnellere Innovationszyklen ermöglicht.

Warum ist diese Integration wichtig, wenn ein Konkurrent wie Microsoft einfach mit OpenAI zusammenarbeiten kann, um die Infrastrukturbreite mit der Modellstärke von LLMs zu kombinieren? Die Googler, mit denen ich sprach, sagten, dass es einen großen Unterschied macht, und sie brachten Anekdoten, um dies zu untermauern.

Nehmen Sie die erhebliche Verbesserung der Unternehmensdatenbank BigQuery von Google. Die Datenbank bietet jetzt einen Wissensgraphen, der LLMs ermöglicht, Daten viel effizienter zu durchsuchen, und sie hat nun mehr als fünfmal so viele Kunden wie Konkurrenten wie Snowflake und Databricks. Yasmeen Ahmad, Leiterin für Produkt-Datenanalytik bei Google Cloud, sagte, dass die enormen Verbesserungen nur möglich waren, weil Googles Datenteams eng mit dem DeepMind-Team zusammenarbeiteten. Sie arbeiteten an Anwendungsfällen, die schwer zu lösen waren, und dies führte dazu, dass die Datenbank basierend auf gängigen Anfragen laut Googles internen Tests 50 Prozent mehr Genauigkeit bei der Bereitstellung der richtigen Daten als die nächstgelegenen Konkurrenten bietet, sagte Ahmad in einem Interview mit VentureBeat. Ahmad sagte, dass diese Art der tiefen Integration über den gesamten Stack hinweg der Grund ist, warum Google die Branche „überholt“ hat.

Diese interne Kohäsion steht in scharfem Kontrast zur „Frenemies“-Dynamik bei Microsoft. Während Microsoft mit OpenAI zusammenarbeitet, um seine Modelle auf der Azure-Cloud zu verteilen, baut Microsoft auch eigene Modelle. Mat Velloso, der Google-Führungskraft, die jetzt das KI-Entwicklerprogramm leitet, verließ Microsoft, nachdem er frustriert war, die Pläne für Windows Copilot mit OpenAIs Modellangeboten abzustimmen. „Wie teilt man seine Produktpläne mit einem anderen Unternehmen, das tatsächlich mit Ihnen konkurriert... Das Ganze ist ein Widerspruch“, erinnerte er sich. „Hier sitze ich Seite an Seite mit den Leuten, die die Modelle bauen.“

Diese Integration spricht für das, was Google-Führungskräfte als ihren Kernvorteil sehen: ihre einzigartige Fähigkeit, tiefes Fachwissen über das gesamte Spektrum zu verbinden, von der Grundlagenforschung und dem Modellbau bis hin zur „planetenskalierten“ Anwendungsbereitstellung und Infrastrukturdesign.

Vertex AI dient als zentrales Nervensystem für Googles Unternehmens-KI-Bemühungen. Und die Integration geht über Googles eigene Angebote hinaus. Vertex’s Model Garden bietet über 200 kuratierte Modelle, einschließlich Googles, Metas Llama 4 und zahlreicher Open-Source-Optionen. Vertex bietet Werkzeuge für Tuning, Evaluierung (einschließlich KI-gestützter Evals, die Grannis als entscheidenden Beschleuniger hervorhob), Bereitstellung und Überwachung. Seine Grounding-Fähigkeiten nutzen interne KI-fähige Datenbanken neben der Kompatibilität mit externen Vektordatenbanken. Hinzu kommen Googles neue Angebote, um Modelle mit Google Search, der weltweit besten Suchmaschine, zu verankern.

Die Integration erstreckt sich auf Google Workspace. Neue Funktionen, die bei Next '25 angekündigt wurden, wie „Help Me Analyze“ in Sheets (ja, Sheets hat jetzt eine „=AI“-Formel), Audio Overviews in Docs und Workspace Flows, betten die Fähigkeiten von Gemini weiter in tägliche Arbeitsabläufe ein und schaffen eine leistungsstarke Feedback-Schleife, die Google nutzt, um die Erfahrung zu verbessern.

Während Google seinen integrierten Stack vorantreibt, setzt es auch auf Offenheit, wo es dem Ökosystem dient. Nachdem es die Kubernetes-Adoption vorangetrieben hat, fördert es jetzt JAX für KI-Frameworks und nun offene Protokolle für die Agentenkommunikation (A2A) neben der Unterstützung bestehender Standards (MCP). Google bietet auch Hunderte von Konnektoren zu externen Plattformen innerhalb von Agentspace, Googles neuem einheitlichem Interface für Mitarbeiter, um Agenten zu finden und zu nutzen. Dieses Hub-Konzept ist überzeugend. Die Keynote-Demonstration von Agentspace (ab 51:40) veranschaulicht dies. Google bietet Nutzern vorgefertigte Agenten, oder Mitarbeiter oder Entwickler können ihre eigenen mit No-Code-KI-Fähigkeiten erstellen. Oder sie können Agenten von außen über A2A-Konnektoren einbinden. Es integriert sich nahtlos in den Chrome-Browser.

Säule 4: Fokus auf Unternehmenswert und das Agenten-Ökosystem

Die vielleicht bedeutendste Veränderung ist Googles geschärfter Fokus auf die Lösung konkreter Unternehmensprobleme, insbesondere durch die Linse der KI-Agenten. Thomas Kurian, CEO von Google Cloud, nannte drei Gründe, warum Kunden Google wählen: die KI-optimierte Plattform, den offenen Multi-Cloud-Ansatz, der die Verbindung zu bestehenden IT-Systemen ermöglicht, und den unternehmensgerechten Fokus auf Sicherheit, Souveränität und Compliance.

Agenten sind der Schlüssel zu dieser Strategie. Neben AgentSpace umfasst dies auch:

- Bausteine: Das Open-Source-Agent Development Kit (ADK), das bei Next angekündigt wurde, hat bereits erhebliches Interesse bei Entwicklern geweckt. Das ADK vereinfacht die Erstellung von Multi-Agenten-Systemen, während das vorgeschlagene Agent2Agent (A2A)-Protokoll die Interoperabilität sicherstellen soll, sodass Agenten, die mit verschiedenen Tools (Gemini ADK, LangGraph, CrewAI usw.) erstellt wurden, zusammenarbeiten können. Googles Grannis sagte, dass A2A die Skalierungs- und Sicherheitsherausforderungen einer Zukunft mit potenziell Hunderttausenden interagierender Agenten antizipiert.

- Maßgeschneiderte Agenten: Google präsentierte Expertenagenten, die in Agentspace integriert sind (wie NotebookLM, Ideengenerierung, Tiefenforschung) und hob fünf Schlüsselkategorien hervor, die an Zugkraft gewinnen: Kundenagenten (die Tools wie Reddit Answers, Verizons Support-Assistent, Wendys Drive-Thru antreiben), Kreative Agenten (genutzt von WPP, Brandtech, Sphere), Datenagenten (die Erkenntnisse bei Mattel, Spotify, Bayer liefern), Programmieragenten (Gemini Code Assist) und Sicherheitsagenten (integriert in die neue Google Unified Security-Plattform).

Diese umfassende Agentenstrategie scheint Anklang zu finden. Gespräche mit Führungskräften von drei weiteren großen Unternehmen in der letzten Woche, die aufgrund wettbewerblicher Sensibilitäten anonym sprachen, spiegelten diese Begeisterung für Googles Agentenstrategie wider. Google Cloud COO Francis DeSouza bestätigte in einem Interview: „Jedes Gespräch beinhaltet KI. Insbesondere jedes Gespräch beinhaltet Agenten.“

Kevin Laughridge, ein Führungskraft bei Deloitte, ein großer Nutzer von Googles KI-Produkten und ein Distributor davon an andere Unternehmen, beschrieb den Agentenmarkt als ein „Landgrab“, bei dem Googles frühe Schritte mit Protokollen und seiner integrierten Plattform erhebliche Vorteile bieten. „Wer zuerst herauskommt und die meisten Agenten liefert, die tatsächlich Mehrwert bieten – der wird dieses Rennen gewinnen“, sagte Laughridge in einem Interview. Er sagte, Googles Fortschritt sei „erstaunlich“ und stellte fest, dass benutzerdefinierte Agenten, die Deloitte vor nur einem Jahr gebaut hat, jetzt „aus der Box“ mit Agentspace repliziert werden könnten. Deloitte selbst baut 100 Agenten auf der Plattform, die auf mittlere Bürofunkktionen wie Finanzen, Risiko und Ingenieurwesen abzielen, sagte er.

Die Kundenbelege häufen sich. Bei Next nannte Google „über 500 Kunden in Produktion“ mit generativer KI, gegenüber nur „Dutzenden von Prototypen“ vor einem Jahr. Wenn Microsoft vor einem Jahr als weit voraus wahrgenommen wurde, scheint das nicht mehr so offensichtlich zu sein. Angesichts des PR-Kriegs von allen Seiten ist es schwer zu sagen, wer derzeit definitiv gewinnt. Die Metriken variieren. Googles 500er-Zahl ist nicht direkt vergleichbar mit den 400 Fallstudien, die Microsoft bewirbt (und Microsoft erklärte gegenüber VentureBeat zum Zeitpunkt der Berichterstattung, dass es plant, diese öffentliche Zählung bald auf 600 zu aktualisieren, was die intensive Vermarktung unterstreicht). Und wenn Googles Verteilung von KI durch seine Apps bedeutend ist, ist Microsofts Copilot-Verteilung durch sein 365-Angebot ebenso beeindruckend. Beide erreichen jetzt Millionen von Entwicklern durch APIs.

Aber Beispiele für Googles Zugkraft gibt es reichlich:

- Wendy’s: Hat ein KI-Drive-Thru-System in Tausenden von Standorten in nur einem Jahr eingeführt, was die Mitarbeitererfahrung und die Bestellgenauigkeit verbessert. Google Cloud CTO Will Grannis bemerkte, dass das KI-System in der Lage ist, Slang zu verstehen und Hintergrundgeräusche herauszufiltern, was den Stress von Live-Kundeninteraktionen erheblich reduziert. Das befreit das Personal, sich auf die Zubereitung und Qualität der Speisen zu konzentrieren – eine Veränderung, die Grannis als „ein großartiges Beispiel für KI, die reale Abläufe rationalisiert“ bezeichnete.

- Salesforce: Kündigte eine große Expansion an, die es seiner Plattform ermöglicht, erstmals auf Google Cloud zu laufen (über AWS hinaus), und verwies auf Googles Fähigkeit, ihnen zu helfen, „zu innovieren und zu optimieren“.

- Honeywell & Intuit: Unternehmen, die zuvor stark mit Microsoft bzw. AWS verbunden waren, arbeiten nun mit Google Cloud an KI-Initiativen.

- Große Banken (Deutsche Bank, Wells Fargo): Nutzen Agenten und Gemini für Forschung, Analyse und Modernisierung des Kundenservices.

- Einzelhändler (Walmart, Mercado Libre, Lowe’s): Verwenden Suche, Agenten und Datenplattformen.

Diese Unternehmenstraktion befeuert das Gesamtwachstum von Google Cloud, das in den letzten drei Quartalen AWS und Azure übertroffen hat. Google Cloud erreichte 2024 eine annualisierte Umsatzrate von 44 Milliarden Dollar, gegenüber nur 5 Milliarden Dollar im Jahr 2018.

Navigieren in den Wettbewerbsgewässern

Googles Aufstieg bedeutet nicht, dass die Konkurrenten stillstehen. OpenAIs schnelle Veröffentlichungen diese Woche von GPT-4.1 (fokussiert auf Programmierung und langen Kontext) und der o-Serie (multimodales Denken, Werkzeugnutzung) zeigen OpenAIs fortgesetzte Innovation. Darüber hinaus hat OpenAIs neues Update für die Bildgenerierungsfunktion in GPT-4o im letzten Monat ein massives Wachstum angeheizt und ChatGPT geholfen, 800 Millionen Nutzer zu erreichen. Microsoft nutzt weiterhin seine riesige Unternehmenspräsenz und die Partnerschaft mit OpenAI, während Anthropic ein starker Konkurrent bleibt, insbesondere in Programmierung und sicherheitsbewussten Anwendungen.

Dennoch ist unbestreitbar, dass Googles Erzählung sich bemerkenswert verbessert hat. Vor nur einem Jahr wurde Google als schwerfälliger, zögerlicher, stolpernder Konkurrent angesehen, der vielleicht kurz davor stand, seine Chance auf die Führung in der KI zu verspielen. Stattdessen haben sein einzigartiger, integrierter Stack und seine unternehmerische Standhaftigkeit etwas anderes offenbart: Google verfügt über erstklassige Fähigkeiten über das gesamte Spektrum – vom Chipdesign (TPUs) und globaler Infrastruktur bis hin zur Grundlagenforschung (DeepMind), Anwendungsentwicklung (Workspace, Search, YouTube) und Unternehmens-Cloud-Diensten (Vertex AI, BigQuery, Agentspace). „Wir sind der einzige Hyperscaler, der im Gespräch über grundlegende Modelle ist“, erklärte deSouza schlicht. Diese End-to-End-Kontrolle ermöglicht Optimierungen (wie „Intelligenz pro Dollar“) und eine Integrationstiefe, die partnerschaftsabhängige Modelle schwer erreichen können. Konkurrenten müssen oft disparate Teile zusammenfügen, was potenziell Reibung erzeugt oder die Innovationsgeschwindigkeit einschränkt.

Googles Moment ist jetzt

Während das KI-Rennen dynamisch bleibt, hat Google all diese Teile genau in dem Moment zusammengesetzt, in dem der Markt sie verlangt. Wie Deloittes Laughridge es ausdrückte, hat Google einen Punkt erreicht, an dem seine Fähigkeiten perfekt mit den Marktanforderungen übereinstimmen. Wenn Sie darauf gewartet haben, dass Google sich in der Unternehmens-KI beweist, haben Sie den Moment vielleicht verpasst – es hat es bereits getan. Das Unternehmen, das viele der Kerntechnologien erfunden hat, die diese Revolution antreiben, scheint endlich aufgeholt zu haben – und mehr als das, es setzt nun das Tempo, das die Konkurrenten einholen müssen.

Im Video unten, aufgenommen direkt nach Next, analysieren KI-Experte Sam Witteveen und ich die aktuelle Landschaft und aufkommende Trends und warum Googles KI-Ökosystem so stark wirkt:

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Alibabas "ZeroSearch" KI senkt Trainingskosten um 88% durch autonomes Lernen

Alibabas ZeroSearch: Ein Wendepunkt für die Effizienz des KI-TrainingsForscher der Alibaba Group haben eine bahnbrechende Methode entwickelt, die möglicherweise die Art und Weise revolutioniert, wie K

Alibabas "ZeroSearch" KI senkt Trainingskosten um 88% durch autonomes Lernen

Alibabas ZeroSearch: Ein Wendepunkt für die Effizienz des KI-TrainingsForscher der Alibaba Group haben eine bahnbrechende Methode entwickelt, die möglicherweise die Art und Weise revolutioniert, wie K

6. August 2025 07:00:59 MESZ

6. August 2025 07:00:59 MESZ

Google's AI comeback is wild! 😎 I thought they were out of the game, but their enterprise push is sneaky strong. Wonder if they’ll dominate the market soon?

0

0

22. Juli 2025 03:25:03 MESZ

22. Juli 2025 03:25:03 MESZ

Google's quiet climb in enterprise AI is wild! 😎 I thought they were out of the game, but this Transformer legacy is no joke. Curious if they’ll outpace Microsoft soon?

0

0

22. April 2025 20:20:20 MESZ

22. April 2025 20:20:20 MESZ

GoogleのエンタープライズAIへの進出は感動的だね。追いつくことから先頭に立つまで、彼らは本当にゲームを上げた。でもインターフェースはもう少し改善が必要だね;ちょっとぎこちない。でも、これからどこに向かうのか楽しみだよ!🚀

0

0

22. April 2025 17:53:12 MESZ

22. April 2025 17:53:12 MESZ

Google's move into enterprise AI is impressive. From playing catch-up to leading the pack, they've really stepped up their game. But the interface could use some work; it's a bit clunky. Still, I'm excited to see where they go from here! 🚀

0

0

22. April 2025 09:22:36 MESZ

22. April 2025 09:22:36 MESZ

El movimiento sigiloso de Google en la IA empresarial es bastante genial. De ir a la zaga a liderar el grupo, realmente han dado la vuelta a la situación. La tecnología es sólida pero la interfaz podría ser más amigable para el usuario. Aún así, es impresionante lo rápido que se han movido! 🚀

0

0

22. April 2025 08:10:16 MESZ

22. April 2025 08:10:16 MESZ

A jogada furtiva do Google no AI empresarial é bem legal. De tentar alcançar a liderar o grupo, eles realmente mudaram as coisas. A tecnologia é sólida, mas a interface poderia ser mais amigável ao usuário. Ainda assim, é impressionante como eles se moveram rápido! 🚀

0

0