Google supera furtivamente a IA da empresa: de 'Catch Up' para 'Catch Us'

Há apenas um ano, o burburinho em torno do Google e da IA empresarial parecia estar em ponto morto. Apesar de tecnologias pioneiras como o Transformer, o gigante da tecnologia parecia estar ficando para trás, ofuscado pelo sucesso viral da OpenAI, pela habilidade em codificação da Anthropic e pela agressiva investida da Microsoft no mercado empresarial.

Mas avançando para a semana passada no Google Cloud Next 2025 em Las Vegas, a cena era marcadamente diferente. Um Google confiante, armado com modelos de alto desempenho, infraestrutura robusta e uma estratégia empresarial clara, anunciou uma reviravolta dramática. Em uma reunião a portas fechadas com analistas e executivos sêniores do Google, um analista resumiu o clima: "Este parece o momento em que o Google passou de 'correr atrás' para 'nos alcance'."

O Salto Adiante do Google

Esse sentimento — de que o Google não apenas alcançou, mas superou a OpenAI e a Microsoft na corrida pela IA empresarial — era palpável durante todo o evento. E não é apenas propaganda de marketing. No último ano, o Google focou intensamente na execução, transformando sua proeza tecnológica em uma plataforma integrada de alto desempenho que está rapidamente conquistando os tomadores de decisão empresariais. Dos modelos de IA mais poderosos do mundo rodando em silício personalizado altamente eficiente a um ecossistema crescente de agentes de IA adaptados para desafios empresariais do mundo real, o Google está fazendo um forte argumento de que nunca esteve verdadeiramente perdido, mas sim passando por um período de desenvolvimento profundo e fundamental.

Com sua pilha integrada agora operando em plena capacidade, o Google parece estar posicionado para liderar a próxima fase da revolução da IA empresarial. Em minhas entrevistas com executivos do Google no Next, eles enfatizaram as vantagens únicas do Google em infraestrutura e integração de modelos — vantagens que competidores como OpenAI, Microsoft ou AWS teriam dificuldade em replicar.

A Sombra da Dúvida: Reconhecendo o Passado Recente

Para apreciar plenamente o momento atual do Google, é essencial reconhecer o passado recente. O Google inventou a arquitetura Transformer, desencadeando a revolução moderna em modelos de linguagem de grande escala (LLMs), e começou a investir em hardware especializado para IA (TPUs) há uma década, o que agora impulsiona uma eficiência líder na indústria. No entanto, inexplicavelmente, há apenas dois anos e meio, o Google se viu na defensiva.

O ChatGPT da OpenAI capturou a imaginação do público e o interesse empresarial em um ritmo impressionante, tornando-se o aplicativo de crescimento mais rápido da história. Competidores como a Anthropic conquistaram nichos em áreas como codificação. Enquanto isso, os movimentos públicos do Google muitas vezes pareciam hesitantes ou falhos. As famosas falhas na demonstração do Bard em 2023 e a controvérsia sobre seu gerador de imagens produzindo representações historicamente imprecisas alimentaram uma narrativa de uma empresa potencialmente prejudicada por burocracia interna ou excesso de correção em alinhamento. O Google parecia perdido, ecoando sua lentidão inicial na competição de nuvem, onde permaneceu em terceiro lugar em participação de mercado, atrás da Amazon e da Microsoft.

A Virada: Uma Decisão Consciente de Liderar

Nos bastidores, no entanto, uma mudança significativa estava ocorrendo, impulsionada por uma decisão deliberada nos mais altos níveis para recuperar a liderança. Mat Velloso, VP de produto da Plataforma de Desenvolvedores de IA do Google DeepMind, sentiu esse momento crucial ao ingressar no Google em fevereiro de 2024, após deixar a Microsoft. "Quando cheguei ao Google, conversei com Sundar [Pichai], conversei com vários líderes aqui, e senti que aquele era o momento em que eles estavam decidindo, ok, isso [IA generativa] é algo que a indústria claramente valoriza. Vamos fazer isso acontecer", compartilhou Velloso durante uma entrevista no Next na semana passada.

Esse impulso renovado não foi prejudicado pelo temido "drenagem de cérebros" que alguns de fora acreditavam estar esgotando o Google. Em vez disso, a empresa redobrou a execução no início de 2024, marcada por contratações agressivas, unificação interna e tração com clientes. Enquanto competidores faziam contratações chamativas, o Google reteve sua liderança central em IA, incluindo o CEO da DeepMind, Demis Hassabis, e o CEO da Google Cloud, Thomas Kurian, proporcionando estabilidade e profunda expertise.

Além disso, talentos começaram a fluir para a missão focada do Google. Logan Kilpatrick, por exemplo, retornou ao Google vindo da OpenAI, atraído pela oportunidade de construir IA fundamental dentro da empresa. Ele se juntou a Velloso no que descreveu como uma "experiência do zero ao um", encarregado de construir tração para desenvolvedores com o Gemini do zero. "Era como se a equipe fosse eu no primeiro dia... nós não temos usuários nesta plataforma, não temos receita. Ninguém está interessado no Gemini neste momento", lembrou Kilpatrick do ponto de partida. Líderes como Josh Woodward, que ajudou a iniciar o AI Studio e agora lidera o Gemini App e Labs, e Noam Shazeer, coautor principal do artigo original do Transformer "Attention Is All You Need", também retornaram à empresa no final de 2024 como co-líder técnico do crucial projeto Gemini.

Pilar 1: Gemini 2.5 e a Era dos Modelos Pensantes

Embora o mantra empresarial tenha mudado para "não se trata apenas do modelo", ter o LLM de melhor desempenho continua sendo uma conquista significativa e um poderoso validador da pesquisa superior e da arquitetura tecnológica eficiente de uma empresa. Com o lançamento do Gemini 2.5 Pro semanas antes do Next '25, o Google reivindicou decisivamente essa posição. Ele rapidamente liderou o ranking independente do Chatbot Arena, superando significativamente até mesmo a mais recente variante GPT-4o da OpenAI, e obteve sucesso em benchmarks de raciocínio notoriamente difíceis como o Humanity’s Last Exam. Como Pichai afirmou no discurso principal, "É o nosso modelo de IA mais inteligente até agora. E é o melhor modelo do mundo." O modelo gerou um aumento de 80 por cento no uso do Gemini em um mês, ele tuitou separadamente.

Pela primeira vez, a demanda pelo Gemini estava em alta. O que me impressionou, além da inteligência bruta do Gemini 2.5 Pro, foi seu raciocínio demonstrável. O Google projetou uma capacidade de "pensamento", permitindo que o modelo realize raciocínio em várias etapas, planejamento e até autorreflexão antes de finalizar uma resposta. A cadeia de pensamento (CoT) estruturada e coerente – usando etapas numeradas e subitens – evita a natureza prolixa ou opaca das saídas de outros modelos da DeepSeek ou OpenAI. Para equipes técnicas avaliando saídas para tarefas críticas, essa transparência permite validação, correção e redirecionamento com confiança sem precedentes.

Mas, mais importante para os usuários empresariais, o Gemini 2.5 Pro também reduziu drasticamente a lacuna em codificação, que é uma das maiores áreas de aplicação para IA generativa. Em uma entrevista com a VentureBeat, a CTO Fiona Tan da varejista líder Wayfair disse que, após testes iniciais, a empresa descobriu que ele "melhorou bastante" e agora era "bem comparável" ao Claude 3.7 Sonnet da Anthropic, anteriormente a escolha preferida de muitos desenvolvedores.

O Google também adicionou uma janela de contexto de 1 milhão de tokens ao modelo, permitindo raciocínio em bases de código inteiras ou documentação extensa, superando em muito as capacidades dos modelos da OpenAI ou Anthropic. (A OpenAI respondeu esta semana com modelos com janelas de contexto igualmente grandes, embora os benchmarks sugiram que o Gemini 2.5 Pro mantém uma vantagem no raciocínio geral). Essa vantagem permite tarefas complexas de engenharia de software em múltiplos arquivos.

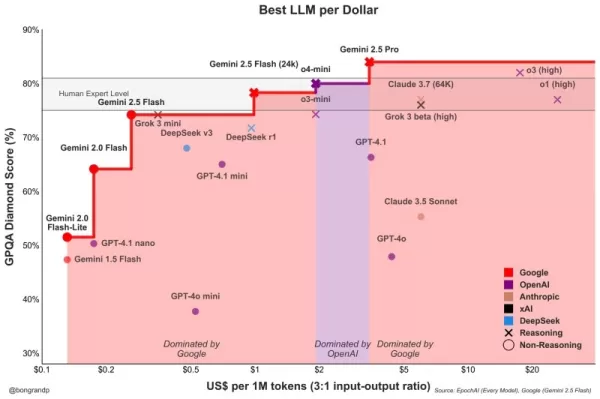

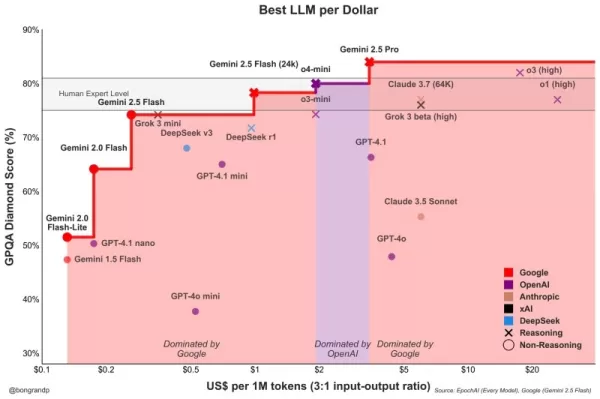

Complementando o Pro está o Gemini 2.5 Flash, anunciado no Next '25 e lançado ontem. Também um modelo "pensante", o Flash é otimizado para baixa latência e eficiência de custo. Você pode controlar o quanto o modelo raciocina e equilibrar o desempenho com seu orçamento. Essa abordagem em camadas reflete ainda mais a estratégia de "inteligência por dólar" defendida pelos executivos do Google.

Velloso mostrou um gráfico revelando que, em todo o espectro de inteligência, os modelos do Google oferecem o melhor valor. "Se tivéssemos essa conversa há um ano... eu não teria nada para mostrar", admitiu Velloso, destacando a rápida reviravolta. "E agora, tipo, em todos os aspectos, se você está procurando qualquer modelo, qualquer tamanho, se você não é o Google, está perdendo dinheiro." Gráficos semelhantes foram atualizados para levar em conta os últimos lançamentos de modelos da OpenAI esta semana, todos mostrando a mesma coisa: os modelos do Google oferecem a melhor inteligência por dólar. Veja abaixo:

Tan, da Wayfair, também observou melhorias promissoras na latência com o 2.5 Pro: "O Gemini 2.5 voltou mais rápido", tornando-o viável para "capacidades mais voltadas para o cliente", disse ela, algo que ela disse não ser o caso antes com outros modelos. O Gemini poderia se tornar o primeiro modelo que a Wayfair usa para essas interações com clientes, disse ela.

As capacidades da família Gemini se estendem à multimodalidade, integrando-se perfeitamente com outros modelos líderes do Google como Imagen 3 (geração de imagens), Veo 2 (geração de vídeos), Chirp 3 (áudio) e o recém-anunciado Lyria (texto para música), todos acessíveis por meio da plataforma do Google para usuários empresariais, Vertex. O Google é a única empresa que oferece seus próprios modelos de mídia generativa em todas as modalidades em sua plataforma. Microsoft, AWS e OpenAI precisam fazer parcerias com outras empresas para isso.

Pilar 2: Proeza de Infraestrutura – O Motor Sob o Capô

A capacidade de iterar rapidamente e servir esses modelos poderosos de forma eficiente vem da infraestrutura provavelmente incomparável do Google, aprimorada ao longo de décadas de operação de serviços em escala planetária. Central para isso é a Unidade de Processamento de Tensor (TPU).

No Next '25, o Google revelou o Ironwood, sua TPU de sétima geração, projetada explicitamente para as demandas de inferência e "modelos pensantes". A escala é imensa, adaptada para cargas de trabalho de IA exigentes: os pods Ironwood contêm mais de 9.000 chips resfriados a líquido, entregando um poder de computação declarado de 42,5 exaflops. O VP de Sistemas de ML do Google, Amin Vahdat, disse no palco no Next que isso é "mais de 24 vezes" o poder de computação do supercomputador número 1 atual do mundo.

O Google afirmou que o Ironwood oferece 2x de desempenho por watt em relação ao Trillium, a geração anterior de TPU. Isso é significativo, já que os clientes empresariais dizem cada vez mais que os custos e a disponibilidade de energia restringem implantações de IA em grande escala.

O CTO da Google Cloud, Will Grannis, enfatizou a consistência desse progresso. Ano após ano, o Google está fazendo melhorias de 10x, 8x, 9x, 10x em seus processadores, disse ele à VentureBeat em uma entrevista, criando o que ele chamou de uma "lei de Moore hiper" para aceleradores de IA. Ele disse que os clientes estão comprando o roteiro do Google, não apenas sua tecnologia.

A posição do Google alimentou esse investimento sustentado em TPU. Ele precisa alimentar eficientemente serviços massivos como Search, YouTube e Gmail para mais de 2 bilhões de usuários. Isso exigiu o desenvolvimento de hardware personalizado e otimizado muito antes do atual boom de IA generativa. Embora o Meta opere em uma escala de consumidor semelhante, outros competidores não tinham esse impulsionador interno específico para um desenvolvimento de hardware de IA verticalmente integrado por uma década.

Agora, esses investimentos em TPU estão rendendo frutos porque estão impulsionando a eficiência não apenas para seus próprios aplicativos, mas também permitindo que o Google ofereça o Gemini a outros usuários com uma melhor inteligência por dólar, considerando todas as coisas iguais.

Por que os competidores do Google não podem comprar processadores eficientes da Nvidia, você pergunta? É verdade que os processadores GPU da Nvidia dominam o pré-treinamento de LLMs. Mas a demanda do mercado elevou o preço desses GPUs, e a Nvidia fica com uma margem saudável de lucro. Isso transfere custos significativos para os usuários de seus chips. Além disso, enquanto o pré-treinamento dominou o uso de chips de IA até agora, isso está mudando agora que as empresas estão realmente implantando essas aplicações. É aqui que entra a "inferência", e aqui os TPUs são considerados mais eficientes do que os GPUs para cargas de trabalho em escala.

Quando você pergunta aos executivos do Google de onde vem sua principal vantagem tecnológica em IA, eles geralmente recorrem ao TPU como o mais importante. Mark Lohmeyer, o VP que gerencia a infraestrutura de computação do Google, foi inequívoco: os TPUs são "certamente uma parte altamente diferenciada do que fazemos... a OpenAI, eles não têm essas capacidades."

Significativamente, o Google apresenta os TPUs não isoladamente, mas como parte da arquitetura de IA empresarial mais ampla e complexa. Para insiders técnicos, entende-se que o desempenho de alto nível depende da integração de avanços tecnológicos cada vez mais especializados. Muitas atualizações foram detalhadas no Next. Vahdat descreveu isso como um "sistema de supercomputação", integrando hardware (TPUs, os mais recentes GPUs da Nvidia como Blackwell e o próximo Vera Rubin, armazenamento avançado como Hyperdisk Exapools, Anywhere Cache e Rapid Storage) com uma pilha de software unificada. Esse software inclui o Cluster Director para gerenciar aceleradores, Pathways (o runtime distribuído do Gemini, agora disponível para clientes) e traz otimizações como vLLM para TPUs, permitindo uma migração de carga de trabalho mais fácil para aqueles anteriormente em pilhas Nvidia/PyTorch. Esse sistema integrado, argumentou Vahdat, é por que o Gemini 2.0 Flash alcança 24 vezes mais inteligência por dólar, em comparação com o GPT-4o.

O Google também está expandindo seu alcance de infraestrutura física. O Cloud WAN torna a rede de fibra privada de baixa latência de 2 milhões de milhas do Google disponível para empresas, prometendo até 40% de desempenho mais rápido e 40% de custo total de propriedade (TCO) mais baixo em comparação com redes gerenciadas por clientes.

Além disso, o Google Distributed Cloud (GDC) permite que o Gemini e o hardware da Nvidia (por meio de uma parceria com a Dell) sejam executados em ambientes soberanos, locais ou até mesmo isolados – uma capacidade que o CEO da Nvidia, Jensen Huang, elogiou como "absolutamente gigantesca" para levar IA de ponta a indústrias e nações regulamentadas. No Next, Huang chamou a infraestrutura do Google de a melhor do mundo: "Nenhuma empresa é melhor em cada camada de computação do que o Google e o Google Cloud", disse ele.

Pilar 3: A Pilha Integrada Completa – Conectando os Pontos

A vantagem estratégica do Google cresce quando se considera como esses modelos e componentes de infraestrutura são entrelaçados em uma plataforma coesa. Diferentemente dos competidores, que muitas vezes dependem de parcerias para preencher lacunas, o Google controla quase todas as camadas, permitindo uma integração mais estreita e ciclos de inovação mais rápidos.

Então, por que essa integração importa, se um competidor como a Microsoft pode simplesmente fazer parceria com a OpenAI para combinar a amplitude da infraestrutura com a proeza do modelo LLM? Os Googlers com quem conversei disseram que faz uma enorme diferença, e eles trouxeram anedotas para respaldar isso.

Veja a melhoria significativa do banco de dados empresarial do Google, BigQuery. O banco de dados agora oferece um grafo de conhecimento que permite aos LLMs pesquisar dados de forma muito mais eficiente, e agora possui mais de cinco vezes o número de clientes de competidores como Snowflake e Databricks. Yasmeen Ahmad, chefe de produto para análise de dados na Google Cloud, disse que as grandes melhorias só foram possíveis porque as equipes de dados do Google estavam trabalhando de perto com a equipe da DeepMind. Eles trabalharam em casos de uso difíceis de resolver, e isso levou o banco de dados a fornecer 50 por cento mais precisão com base em consultas comuns, pelo menos de acordo com os testes internos do Google, para chegar aos dados corretos do que os competidores mais próximos, disse Ahmad à VentureBeat em uma entrevista. Ahmad disse que esse tipo de integração profunda em toda a pilha é como o Google "ultrapassou" a indústria.

Essa coesão interna contrasta fortemente com a dinâmica de "frenemies" na Microsoft. Enquanto a Microsoft faz parceria com a OpenAI para distribuir seus modelos na nuvem Azure, a Microsoft também está construindo seus próprios modelos. Mat Velloso, o executivo do Google que agora lidera o programa de desenvolvedores de IA, deixou a Microsoft após se frustrar tentando alinhar os planos do Windows Copilot com as ofertas de modelos da OpenAI. "Como você compartilha seus planos de produto com outra empresa que na verdade está competindo com você... A coisa toda é uma contradição", ele lembrou. "Aqui eu me sento lado a lado com as pessoas que estão construindo os modelos."

Essa integração fala ao que os líderes do Google veem como sua principal vantagem: sua capacidade única de conectar profunda expertise em todo o espectro, desde pesquisa fundamental e construção de modelos até implantação de aplicações em "escala planetária" e design de infraestrutura.

O Vertex AI serve como o sistema nervoso central dos esforços de IA empresarial do Google. E a integração vai além das próprias ofertas do Google. O Model Garden do Vertex oferece mais de 200 modelos selecionados, incluindo os do Google, o Llama 4 da Meta e inúmeras opções de código aberto. O Vertex fornece ferramentas para ajuste, avaliação (incluindo Evals alimentados por IA, que Grannis destacou como um acelerador chave), implantação e monitoramento. Suas capacidades de ancoragem aproveitam bancos de dados internos prontos para IA, além de compatibilidade com bancos de dados vetoriais externos. Adicione a isso as novas ofertas do Google para ancorar modelos com o Google Search, o melhor motor de busca do mundo.

A integração se estende ao Google Workspace. Novos recursos anunciados no Next '25, como "Me Ajude a Analisar" no Sheets (sim, o Sheets agora tem uma fórmula "=AI"), Resumos de Áudio no Docs e Fluxos do Workspace, incorporam ainda mais as capacidades do Gemini nos fluxos de trabalho diários, criando um poderoso ciclo de feedback para o Google usar para melhorar a experiência.

Enquanto impulsiona sua pilha integrada, o Google também defende a abertura onde isso serve ao ecossistema. Tendo impulsionado a adoção do Kubernetes, agora está promovendo o JAX para frameworks de IA e agora protocolos abertos para comunicação de agentes (A2A) ao lado do suporte a padrões existentes (MCP). O Google também está oferecendo centenas de conectores para plataformas externas a partir do Agentspace, que é a nova interface unificada do Google para funcionários encontrarem e usarem agentes. Esse conceito de hub é atraente. A demonstração do Agentspace no keynote (começando em 51:40) ilustra isso. O Google oferece aos usuários agentes pré-construídos, ou funcionários ou desenvolvedores podem construir os seus próprios usando capacidades de IA sem código. Ou eles podem trazer agentes de fora por meio de conectores A2A. Ele se integra ao navegador Chrome para acesso contínuo.

Pilar 4: Foco no Valor Empresarial e no Ecossistema de Agentes

Talvez a mudança mais significativa seja o foco aprimorado do Google em resolver problemas empresariais concretos, particularmente através da lente dos agentes de IA. Thomas Kurian, CEO da Google Cloud, destacou três razões pelas quais os clientes escolhem o Google: a plataforma otimizada para IA, a abordagem de multi-nuvem aberta permitindo conexão com TI existente e o foco pronto para empresas em segurança, soberania e conformidade.

Os agentes são a chave para essa estratégia. Além do AgentSpace, isso também inclui:

- Blocos de Construção: O Kit de Desenvolvimento de Agentes (ADK) de código aberto, anunciado no Next, já viu interesse significativo dos desenvolvedores. O ADK simplifica a criação de sistemas multi-agentes, enquanto o protocolo proposto Agent2Agent (A2A) visa garantir interoperabilidade, permitindo que agentes construídos com diferentes ferramentas (Gemini ADK, LangGraph, CrewAI, etc.) colaborem. Grannis, do Google, disse que o A2A antecipa os desafios de escala e segurança de um futuro com potencialmente centenas de milhares de agentes interagindo.

- Agentes Específicos: O Google apresentou agentes especialistas integrados ao Agentspace (como NotebookLM, Geração de Ideias, Pesquisa Profunda) e destacou cinco categorias-chave ganhando tração: Agentes de Clientes (alimentando ferramentas como Reddit Answers, assistente de suporte da Verizon, drive-thru da Wendy’s), Agentes Criativos (usados por WPP, Brandtech, Sphere), Agentes de Dados (gerando insights na Mattel, Spotify, Bayer), Agentes de Codificação (Gemini Code Assist) e Agentes de Segurança (integrados à nova plataforma de Segurança Unificada do Google).

Essa estratégia de agentes abrangente parece estar ressoando. Conversas com executivos de três outras grandes empresas na última semana, também falando anonimamente devido a sensibilidades competitivas, ecoaram esse entusiasmo pela estratégia de agentes do Google. O COO da Google Cloud, Francis DeSouza, confirmou em uma entrevista: "Toda conversa inclui IA. Especificamente, toda conversa inclui agentes."

Kevin Laughridge, um executivo da Deloitte, um grande usuário dos produtos de IA do Google e distribuidor deles para outras empresas, descreveu o mercado de agentes como uma "corrida por terras" onde os primeiros movimentos do Google com protocolos e sua plataforma integrada oferecem vantagens significativas. "Quem sair primeiro e conseguir os agentes que realmente entregam valor – é quem vai vencer nessa corrida", disse Laughridge em uma entrevista. Ele disse que o progresso do Google foi "surpreendente", observando que agentes personalizados que a Deloitte construiu há apenas um ano agora poderiam ser replicados "prontos para uso" usando o Agentspace. A própria Deloitte está construindo 100 agentes na plataforma, visando funções de meio de escritório como finanças, risco e engenharia, disse ele.

Os pontos de prova dos clientes estão se acumulando. No Next, o Google citou "mais de 500 clientes em produção" com IA generativa, contra apenas "dezenas de protótipos" há um ano. Se a Microsoft era percebida como muito à frente há um ano, isso não parece mais tão óbvio. Dadas as guerras de relações públicas de todos os lados, é difícil dizer quem está realmente vencendo agora de forma definitiva. As métricas variam. O número de 500 do Google não é diretamente comparável aos 400 estudos de caso que a Microsoft promove (e a Microsoft, em resposta, disse à VentureBeat no momento da imprensa que planeja atualizar essa contagem pública para 600 em breve, destacando o marketing intenso). E se a distribuição de IA do Google por meio de seus aplicativos é significativa, a distribuição do Copilot da Microsoft por meio de sua oferta 365 é igualmente impressionante. Ambos estão agora atingindo milhões de desenvolvedores por meio de APIs.

Mas exemplos da tração do Google abundam:

- Wendy’s: Implantou um sistema de drive-thru de IA em milhares de locais em apenas um ano, melhorando a experiência dos funcionários e a precisão dos pedidos. O CTO da Google Cloud, Will Grannis, observou que o sistema de IA é capaz de entender gírias e filtrar ruídos de fundo, reduzindo significativamente o estresse das interações ao vivo com clientes. Isso libera a equipe para se concentrar na preparação e qualidade dos alimentos — uma mudança que Grannis chamou de "um ótimo exemplo de IA simplificando operações do mundo real."

- Salesforce: Anunciou uma grande expansão, permitindo que sua plataforma rode na Google Cloud pela primeira vez (além da AWS), citando a capacidade do Google de ajudá-los a "inovar e otimizar."

- Honeywell & Intuit: Empresas anteriormente fortemente associadas à Microsoft e AWS, respectivamente, agora fazendo parceria com a Google Cloud em iniciativas de IA.

- Grandes Bancos (Deutsche Bank, Wells Fargo): Aproveitando agentes e Gemini para pesquisa, análise e modernização do atendimento ao cliente.

- Varejistas (Walmart, Mercado Libre, Lowe’s): Usando busca, agentes e plataformas de dados.

Essa tração empresarial alimenta o crescimento geral da Google Cloud, que superou a AWS e a Azure nos últimos três trimestres. A Google Cloud atingiu uma taxa de execução anualizada de 44 bilhões de dólares em 2024, contra apenas 5 bilhões em 2018.

Navegando nas Águas Competitivas

A ascensão do Google não significa que os competidores estão parados. Os lançamentos rápidos da OpenAI esta semana do GPT-4.1 (focado em codificação e contexto longo) e da série o (raciocínio multimodal, uso de ferramentas) demonstram a inovação contínua da OpenAI. Além disso, a nova atualização de recurso de geração de imagens no GPT-4o impulsionou um crescimento maciço em apenas o último mês, ajudando o ChatGPT a alcançar 800 milhões de usuários. A Microsoft continua a aproveitar sua vasta presença empresarial e parceria com a OpenAI, enquanto a Anthropic permanece uma forte concorrente, particularmente em aplicações de codificação e segurança.

No entanto, é indiscutível que a narrativa do Google melhorou notavelmente. Há apenas um ano, o Google era visto como um competidor hesitante, atrapalhado, que talvez estivesse prestes a perder sua chance de liderar a IA. Em vez disso, sua pilha integrada única e sua firmeza corporativa revelaram algo mais: o Google possui capacidades de classe mundial em todo o espectro – do design de chips (TPUs) e infraestrutura global à pesquisa de modelos fundamentais (DeepMind), desenvolvimento de aplicações (Workspace, Search, YouTube) e serviços de nuvem empresarial (Vertex AI, BigQuery, Agentspace). "Somos o único hiperescalador que está na conversa de modelos fundamentais", afirmou deSouza categoricamente. Essa posse de ponta a ponta permite otimizações (como "inteligência por dólar") e profundidade de integração que modelos dependentes de parcerias têm dificuldade em igualar. Competidores muitas vezes precisam costurar peças díspares, potencialmente criando atrito ou limitando a velocidade de inovação.

O Momento do Google é Agora

Embora a corrida da IA permaneça dinâmica, o Google reuniu todas essas peças no momento exato em que o mercado as exige. Como Laughridge, da Deloitte, colocou, o Google atingiu um ponto em que suas capacidades se alinharam perfeitamente "onde o mercado exigia". Se você estava esperando que o Google se provasse na IA empresarial, pode ter perdido o momento — ele já o fez. A empresa que inventou muitas das tecnologias centrais que impulsionam essa revolução parece finalmente ter alcançado – e mais do que isso, agora está definindo o ritmo que os competidores precisam igualar.

No vídeo abaixo, gravado logo após o Next, o especialista em IA Sam Witteveen e eu analisamos o cenário atual e as tendências emergentes, e por que o ecossistema de IA do Google parece tão forte:

Artigo relacionado

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

O mais recente modelo de IA Gemini do Google mostra queda nas pontuações de segurança nos testes

Os testes internos do Google revelam quedas de desempenho preocupantes nos protocolos de segurança de seu modelo de IA mais recente em comparação com as versões anteriores. De acordo com os benchmarks

O mais recente modelo de IA Gemini do Google mostra queda nas pontuações de segurança nos testes

Os testes internos do Google revelam quedas de desempenho preocupantes nos protocolos de segurança de seu modelo de IA mais recente em comparação com as versões anteriores. De acordo com os benchmarks

A IA 'ZeroSearch' da Alibaba reduz os custos de treinamento em 88% por meio da aprendizagem autônoma

ZeroSearch da Alibaba: Um divisor de águas para a eficiência do treinamento em IAOs pesquisadores do Alibaba Group foram pioneiros em um método inovador que pode revolucionar a forma como os sistemas

Comentários (12)

0/200

A IA 'ZeroSearch' da Alibaba reduz os custos de treinamento em 88% por meio da aprendizagem autônoma

ZeroSearch da Alibaba: Um divisor de águas para a eficiência do treinamento em IAOs pesquisadores do Alibaba Group foram pioneiros em um método inovador que pode revolucionar a forma como os sistemas

Comentários (12)

0/200

![EdwardRamirez]() EdwardRamirez

EdwardRamirez

6 de Agosto de 2025 à59 06:00:59 WEST

6 de Agosto de 2025 à59 06:00:59 WEST

Google's AI comeback is wild! 😎 I thought they were out of the game, but their enterprise push is sneaky strong. Wonder if they’ll dominate the market soon?

0

0

![ThomasBaker]() ThomasBaker

ThomasBaker

22 de Julho de 2025 à3 02:25:03 WEST

22 de Julho de 2025 à3 02:25:03 WEST

Google's quiet climb in enterprise AI is wild! 😎 I thought they were out of the game, but this Transformer legacy is no joke. Curious if they’ll outpace Microsoft soon?

0

0

![RalphGarcia]() RalphGarcia

RalphGarcia

22 de Abril de 2025 à20 19:20:20 WEST

22 de Abril de 2025 à20 19:20:20 WEST

GoogleのエンタープライズAIへの進出は感動的だね。追いつくことから先頭に立つまで、彼らは本当にゲームを上げた。でもインターフェースはもう少し改善が必要だね;ちょっとぎこちない。でも、これからどこに向かうのか楽しみだよ!🚀

0

0

![FredAnderson]() FredAnderson

FredAnderson

22 de Abril de 2025 à12 16:53:12 WEST

22 de Abril de 2025 à12 16:53:12 WEST

Google's move into enterprise AI is impressive. From playing catch-up to leading the pack, they've really stepped up their game. But the interface could use some work; it's a bit clunky. Still, I'm excited to see where they go from here! 🚀

0

0

![JasonRoberts]() JasonRoberts

JasonRoberts

22 de Abril de 2025 à36 08:22:36 WEST

22 de Abril de 2025 à36 08:22:36 WEST

El movimiento sigiloso de Google en la IA empresarial es bastante genial. De ir a la zaga a liderar el grupo, realmente han dado la vuelta a la situación. La tecnología es sólida pero la interfaz podría ser más amigable para el usuario. Aún así, es impresionante lo rápido que se han movido! 🚀

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

22 de Abril de 2025 à16 07:10:16 WEST

22 de Abril de 2025 à16 07:10:16 WEST

A jogada furtiva do Google no AI empresarial é bem legal. De tentar alcançar a liderar o grupo, eles realmente mudaram as coisas. A tecnologia é sólida, mas a interface poderia ser mais amigável ao usuário. Ainda assim, é impressionante como eles se moveram rápido! 🚀

0

0

Há apenas um ano, o burburinho em torno do Google e da IA empresarial parecia estar em ponto morto. Apesar de tecnologias pioneiras como o Transformer, o gigante da tecnologia parecia estar ficando para trás, ofuscado pelo sucesso viral da OpenAI, pela habilidade em codificação da Anthropic e pela agressiva investida da Microsoft no mercado empresarial.

Mas avançando para a semana passada no Google Cloud Next 2025 em Las Vegas, a cena era marcadamente diferente. Um Google confiante, armado com modelos de alto desempenho, infraestrutura robusta e uma estratégia empresarial clara, anunciou uma reviravolta dramática. Em uma reunião a portas fechadas com analistas e executivos sêniores do Google, um analista resumiu o clima: "Este parece o momento em que o Google passou de 'correr atrás' para 'nos alcance'."

O Salto Adiante do Google

Esse sentimento — de que o Google não apenas alcançou, mas superou a OpenAI e a Microsoft na corrida pela IA empresarial — era palpável durante todo o evento. E não é apenas propaganda de marketing. No último ano, o Google focou intensamente na execução, transformando sua proeza tecnológica em uma plataforma integrada de alto desempenho que está rapidamente conquistando os tomadores de decisão empresariais. Dos modelos de IA mais poderosos do mundo rodando em silício personalizado altamente eficiente a um ecossistema crescente de agentes de IA adaptados para desafios empresariais do mundo real, o Google está fazendo um forte argumento de que nunca esteve verdadeiramente perdido, mas sim passando por um período de desenvolvimento profundo e fundamental.

Com sua pilha integrada agora operando em plena capacidade, o Google parece estar posicionado para liderar a próxima fase da revolução da IA empresarial. Em minhas entrevistas com executivos do Google no Next, eles enfatizaram as vantagens únicas do Google em infraestrutura e integração de modelos — vantagens que competidores como OpenAI, Microsoft ou AWS teriam dificuldade em replicar.

A Sombra da Dúvida: Reconhecendo o Passado Recente

Para apreciar plenamente o momento atual do Google, é essencial reconhecer o passado recente. O Google inventou a arquitetura Transformer, desencadeando a revolução moderna em modelos de linguagem de grande escala (LLMs), e começou a investir em hardware especializado para IA (TPUs) há uma década, o que agora impulsiona uma eficiência líder na indústria. No entanto, inexplicavelmente, há apenas dois anos e meio, o Google se viu na defensiva.

O ChatGPT da OpenAI capturou a imaginação do público e o interesse empresarial em um ritmo impressionante, tornando-se o aplicativo de crescimento mais rápido da história. Competidores como a Anthropic conquistaram nichos em áreas como codificação. Enquanto isso, os movimentos públicos do Google muitas vezes pareciam hesitantes ou falhos. As famosas falhas na demonstração do Bard em 2023 e a controvérsia sobre seu gerador de imagens produzindo representações historicamente imprecisas alimentaram uma narrativa de uma empresa potencialmente prejudicada por burocracia interna ou excesso de correção em alinhamento. O Google parecia perdido, ecoando sua lentidão inicial na competição de nuvem, onde permaneceu em terceiro lugar em participação de mercado, atrás da Amazon e da Microsoft.

A Virada: Uma Decisão Consciente de Liderar

Nos bastidores, no entanto, uma mudança significativa estava ocorrendo, impulsionada por uma decisão deliberada nos mais altos níveis para recuperar a liderança. Mat Velloso, VP de produto da Plataforma de Desenvolvedores de IA do Google DeepMind, sentiu esse momento crucial ao ingressar no Google em fevereiro de 2024, após deixar a Microsoft. "Quando cheguei ao Google, conversei com Sundar [Pichai], conversei com vários líderes aqui, e senti que aquele era o momento em que eles estavam decidindo, ok, isso [IA generativa] é algo que a indústria claramente valoriza. Vamos fazer isso acontecer", compartilhou Velloso durante uma entrevista no Next na semana passada.

Esse impulso renovado não foi prejudicado pelo temido "drenagem de cérebros" que alguns de fora acreditavam estar esgotando o Google. Em vez disso, a empresa redobrou a execução no início de 2024, marcada por contratações agressivas, unificação interna e tração com clientes. Enquanto competidores faziam contratações chamativas, o Google reteve sua liderança central em IA, incluindo o CEO da DeepMind, Demis Hassabis, e o CEO da Google Cloud, Thomas Kurian, proporcionando estabilidade e profunda expertise.

Além disso, talentos começaram a fluir para a missão focada do Google. Logan Kilpatrick, por exemplo, retornou ao Google vindo da OpenAI, atraído pela oportunidade de construir IA fundamental dentro da empresa. Ele se juntou a Velloso no que descreveu como uma "experiência do zero ao um", encarregado de construir tração para desenvolvedores com o Gemini do zero. "Era como se a equipe fosse eu no primeiro dia... nós não temos usuários nesta plataforma, não temos receita. Ninguém está interessado no Gemini neste momento", lembrou Kilpatrick do ponto de partida. Líderes como Josh Woodward, que ajudou a iniciar o AI Studio e agora lidera o Gemini App e Labs, e Noam Shazeer, coautor principal do artigo original do Transformer "Attention Is All You Need", também retornaram à empresa no final de 2024 como co-líder técnico do crucial projeto Gemini.

Pilar 1: Gemini 2.5 e a Era dos Modelos Pensantes

Embora o mantra empresarial tenha mudado para "não se trata apenas do modelo", ter o LLM de melhor desempenho continua sendo uma conquista significativa e um poderoso validador da pesquisa superior e da arquitetura tecnológica eficiente de uma empresa. Com o lançamento do Gemini 2.5 Pro semanas antes do Next '25, o Google reivindicou decisivamente essa posição. Ele rapidamente liderou o ranking independente do Chatbot Arena, superando significativamente até mesmo a mais recente variante GPT-4o da OpenAI, e obteve sucesso em benchmarks de raciocínio notoriamente difíceis como o Humanity’s Last Exam. Como Pichai afirmou no discurso principal, "É o nosso modelo de IA mais inteligente até agora. E é o melhor modelo do mundo." O modelo gerou um aumento de 80 por cento no uso do Gemini em um mês, ele tuitou separadamente.

Pela primeira vez, a demanda pelo Gemini estava em alta. O que me impressionou, além da inteligência bruta do Gemini 2.5 Pro, foi seu raciocínio demonstrável. O Google projetou uma capacidade de "pensamento", permitindo que o modelo realize raciocínio em várias etapas, planejamento e até autorreflexão antes de finalizar uma resposta. A cadeia de pensamento (CoT) estruturada e coerente – usando etapas numeradas e subitens – evita a natureza prolixa ou opaca das saídas de outros modelos da DeepSeek ou OpenAI. Para equipes técnicas avaliando saídas para tarefas críticas, essa transparência permite validação, correção e redirecionamento com confiança sem precedentes.

Mas, mais importante para os usuários empresariais, o Gemini 2.5 Pro também reduziu drasticamente a lacuna em codificação, que é uma das maiores áreas de aplicação para IA generativa. Em uma entrevista com a VentureBeat, a CTO Fiona Tan da varejista líder Wayfair disse que, após testes iniciais, a empresa descobriu que ele "melhorou bastante" e agora era "bem comparável" ao Claude 3.7 Sonnet da Anthropic, anteriormente a escolha preferida de muitos desenvolvedores.

O Google também adicionou uma janela de contexto de 1 milhão de tokens ao modelo, permitindo raciocínio em bases de código inteiras ou documentação extensa, superando em muito as capacidades dos modelos da OpenAI ou Anthropic. (A OpenAI respondeu esta semana com modelos com janelas de contexto igualmente grandes, embora os benchmarks sugiram que o Gemini 2.5 Pro mantém uma vantagem no raciocínio geral). Essa vantagem permite tarefas complexas de engenharia de software em múltiplos arquivos.

Complementando o Pro está o Gemini 2.5 Flash, anunciado no Next '25 e lançado ontem. Também um modelo "pensante", o Flash é otimizado para baixa latência e eficiência de custo. Você pode controlar o quanto o modelo raciocina e equilibrar o desempenho com seu orçamento. Essa abordagem em camadas reflete ainda mais a estratégia de "inteligência por dólar" defendida pelos executivos do Google.

Velloso mostrou um gráfico revelando que, em todo o espectro de inteligência, os modelos do Google oferecem o melhor valor. "Se tivéssemos essa conversa há um ano... eu não teria nada para mostrar", admitiu Velloso, destacando a rápida reviravolta. "E agora, tipo, em todos os aspectos, se você está procurando qualquer modelo, qualquer tamanho, se você não é o Google, está perdendo dinheiro." Gráficos semelhantes foram atualizados para levar em conta os últimos lançamentos de modelos da OpenAI esta semana, todos mostrando a mesma coisa: os modelos do Google oferecem a melhor inteligência por dólar. Veja abaixo:

Tan, da Wayfair, também observou melhorias promissoras na latência com o 2.5 Pro: "O Gemini 2.5 voltou mais rápido", tornando-o viável para "capacidades mais voltadas para o cliente", disse ela, algo que ela disse não ser o caso antes com outros modelos. O Gemini poderia se tornar o primeiro modelo que a Wayfair usa para essas interações com clientes, disse ela.

As capacidades da família Gemini se estendem à multimodalidade, integrando-se perfeitamente com outros modelos líderes do Google como Imagen 3 (geração de imagens), Veo 2 (geração de vídeos), Chirp 3 (áudio) e o recém-anunciado Lyria (texto para música), todos acessíveis por meio da plataforma do Google para usuários empresariais, Vertex. O Google é a única empresa que oferece seus próprios modelos de mídia generativa em todas as modalidades em sua plataforma. Microsoft, AWS e OpenAI precisam fazer parcerias com outras empresas para isso.

Pilar 2: Proeza de Infraestrutura – O Motor Sob o Capô

A capacidade de iterar rapidamente e servir esses modelos poderosos de forma eficiente vem da infraestrutura provavelmente incomparável do Google, aprimorada ao longo de décadas de operação de serviços em escala planetária. Central para isso é a Unidade de Processamento de Tensor (TPU).

No Next '25, o Google revelou o Ironwood, sua TPU de sétima geração, projetada explicitamente para as demandas de inferência e "modelos pensantes". A escala é imensa, adaptada para cargas de trabalho de IA exigentes: os pods Ironwood contêm mais de 9.000 chips resfriados a líquido, entregando um poder de computação declarado de 42,5 exaflops. O VP de Sistemas de ML do Google, Amin Vahdat, disse no palco no Next que isso é "mais de 24 vezes" o poder de computação do supercomputador número 1 atual do mundo.

O Google afirmou que o Ironwood oferece 2x de desempenho por watt em relação ao Trillium, a geração anterior de TPU. Isso é significativo, já que os clientes empresariais dizem cada vez mais que os custos e a disponibilidade de energia restringem implantações de IA em grande escala.

O CTO da Google Cloud, Will Grannis, enfatizou a consistência desse progresso. Ano após ano, o Google está fazendo melhorias de 10x, 8x, 9x, 10x em seus processadores, disse ele à VentureBeat em uma entrevista, criando o que ele chamou de uma "lei de Moore hiper" para aceleradores de IA. Ele disse que os clientes estão comprando o roteiro do Google, não apenas sua tecnologia.

A posição do Google alimentou esse investimento sustentado em TPU. Ele precisa alimentar eficientemente serviços massivos como Search, YouTube e Gmail para mais de 2 bilhões de usuários. Isso exigiu o desenvolvimento de hardware personalizado e otimizado muito antes do atual boom de IA generativa. Embora o Meta opere em uma escala de consumidor semelhante, outros competidores não tinham esse impulsionador interno específico para um desenvolvimento de hardware de IA verticalmente integrado por uma década.

Agora, esses investimentos em TPU estão rendendo frutos porque estão impulsionando a eficiência não apenas para seus próprios aplicativos, mas também permitindo que o Google ofereça o Gemini a outros usuários com uma melhor inteligência por dólar, considerando todas as coisas iguais.

Por que os competidores do Google não podem comprar processadores eficientes da Nvidia, você pergunta? É verdade que os processadores GPU da Nvidia dominam o pré-treinamento de LLMs. Mas a demanda do mercado elevou o preço desses GPUs, e a Nvidia fica com uma margem saudável de lucro. Isso transfere custos significativos para os usuários de seus chips. Além disso, enquanto o pré-treinamento dominou o uso de chips de IA até agora, isso está mudando agora que as empresas estão realmente implantando essas aplicações. É aqui que entra a "inferência", e aqui os TPUs são considerados mais eficientes do que os GPUs para cargas de trabalho em escala.

Quando você pergunta aos executivos do Google de onde vem sua principal vantagem tecnológica em IA, eles geralmente recorrem ao TPU como o mais importante. Mark Lohmeyer, o VP que gerencia a infraestrutura de computação do Google, foi inequívoco: os TPUs são "certamente uma parte altamente diferenciada do que fazemos... a OpenAI, eles não têm essas capacidades."

Significativamente, o Google apresenta os TPUs não isoladamente, mas como parte da arquitetura de IA empresarial mais ampla e complexa. Para insiders técnicos, entende-se que o desempenho de alto nível depende da integração de avanços tecnológicos cada vez mais especializados. Muitas atualizações foram detalhadas no Next. Vahdat descreveu isso como um "sistema de supercomputação", integrando hardware (TPUs, os mais recentes GPUs da Nvidia como Blackwell e o próximo Vera Rubin, armazenamento avançado como Hyperdisk Exapools, Anywhere Cache e Rapid Storage) com uma pilha de software unificada. Esse software inclui o Cluster Director para gerenciar aceleradores, Pathways (o runtime distribuído do Gemini, agora disponível para clientes) e traz otimizações como vLLM para TPUs, permitindo uma migração de carga de trabalho mais fácil para aqueles anteriormente em pilhas Nvidia/PyTorch. Esse sistema integrado, argumentou Vahdat, é por que o Gemini 2.0 Flash alcança 24 vezes mais inteligência por dólar, em comparação com o GPT-4o.

O Google também está expandindo seu alcance de infraestrutura física. O Cloud WAN torna a rede de fibra privada de baixa latência de 2 milhões de milhas do Google disponível para empresas, prometendo até 40% de desempenho mais rápido e 40% de custo total de propriedade (TCO) mais baixo em comparação com redes gerenciadas por clientes.

Além disso, o Google Distributed Cloud (GDC) permite que o Gemini e o hardware da Nvidia (por meio de uma parceria com a Dell) sejam executados em ambientes soberanos, locais ou até mesmo isolados – uma capacidade que o CEO da Nvidia, Jensen Huang, elogiou como "absolutamente gigantesca" para levar IA de ponta a indústrias e nações regulamentadas. No Next, Huang chamou a infraestrutura do Google de a melhor do mundo: "Nenhuma empresa é melhor em cada camada de computação do que o Google e o Google Cloud", disse ele.

Pilar 3: A Pilha Integrada Completa – Conectando os Pontos

A vantagem estratégica do Google cresce quando se considera como esses modelos e componentes de infraestrutura são entrelaçados em uma plataforma coesa. Diferentemente dos competidores, que muitas vezes dependem de parcerias para preencher lacunas, o Google controla quase todas as camadas, permitindo uma integração mais estreita e ciclos de inovação mais rápidos.

Então, por que essa integração importa, se um competidor como a Microsoft pode simplesmente fazer parceria com a OpenAI para combinar a amplitude da infraestrutura com a proeza do modelo LLM? Os Googlers com quem conversei disseram que faz uma enorme diferença, e eles trouxeram anedotas para respaldar isso.

Veja a melhoria significativa do banco de dados empresarial do Google, BigQuery. O banco de dados agora oferece um grafo de conhecimento que permite aos LLMs pesquisar dados de forma muito mais eficiente, e agora possui mais de cinco vezes o número de clientes de competidores como Snowflake e Databricks. Yasmeen Ahmad, chefe de produto para análise de dados na Google Cloud, disse que as grandes melhorias só foram possíveis porque as equipes de dados do Google estavam trabalhando de perto com a equipe da DeepMind. Eles trabalharam em casos de uso difíceis de resolver, e isso levou o banco de dados a fornecer 50 por cento mais precisão com base em consultas comuns, pelo menos de acordo com os testes internos do Google, para chegar aos dados corretos do que os competidores mais próximos, disse Ahmad à VentureBeat em uma entrevista. Ahmad disse que esse tipo de integração profunda em toda a pilha é como o Google "ultrapassou" a indústria.

Essa coesão interna contrasta fortemente com a dinâmica de "frenemies" na Microsoft. Enquanto a Microsoft faz parceria com a OpenAI para distribuir seus modelos na nuvem Azure, a Microsoft também está construindo seus próprios modelos. Mat Velloso, o executivo do Google que agora lidera o programa de desenvolvedores de IA, deixou a Microsoft após se frustrar tentando alinhar os planos do Windows Copilot com as ofertas de modelos da OpenAI. "Como você compartilha seus planos de produto com outra empresa que na verdade está competindo com você... A coisa toda é uma contradição", ele lembrou. "Aqui eu me sento lado a lado com as pessoas que estão construindo os modelos."

Essa integração fala ao que os líderes do Google veem como sua principal vantagem: sua capacidade única de conectar profunda expertise em todo o espectro, desde pesquisa fundamental e construção de modelos até implantação de aplicações em "escala planetária" e design de infraestrutura.

O Vertex AI serve como o sistema nervoso central dos esforços de IA empresarial do Google. E a integração vai além das próprias ofertas do Google. O Model Garden do Vertex oferece mais de 200 modelos selecionados, incluindo os do Google, o Llama 4 da Meta e inúmeras opções de código aberto. O Vertex fornece ferramentas para ajuste, avaliação (incluindo Evals alimentados por IA, que Grannis destacou como um acelerador chave), implantação e monitoramento. Suas capacidades de ancoragem aproveitam bancos de dados internos prontos para IA, além de compatibilidade com bancos de dados vetoriais externos. Adicione a isso as novas ofertas do Google para ancorar modelos com o Google Search, o melhor motor de busca do mundo.

A integração se estende ao Google Workspace. Novos recursos anunciados no Next '25, como "Me Ajude a Analisar" no Sheets (sim, o Sheets agora tem uma fórmula "=AI"), Resumos de Áudio no Docs e Fluxos do Workspace, incorporam ainda mais as capacidades do Gemini nos fluxos de trabalho diários, criando um poderoso ciclo de feedback para o Google usar para melhorar a experiência.

Enquanto impulsiona sua pilha integrada, o Google também defende a abertura onde isso serve ao ecossistema. Tendo impulsionado a adoção do Kubernetes, agora está promovendo o JAX para frameworks de IA e agora protocolos abertos para comunicação de agentes (A2A) ao lado do suporte a padrões existentes (MCP). O Google também está oferecendo centenas de conectores para plataformas externas a partir do Agentspace, que é a nova interface unificada do Google para funcionários encontrarem e usarem agentes. Esse conceito de hub é atraente. A demonstração do Agentspace no keynote (começando em 51:40) ilustra isso. O Google oferece aos usuários agentes pré-construídos, ou funcionários ou desenvolvedores podem construir os seus próprios usando capacidades de IA sem código. Ou eles podem trazer agentes de fora por meio de conectores A2A. Ele se integra ao navegador Chrome para acesso contínuo.

Pilar 4: Foco no Valor Empresarial e no Ecossistema de Agentes

Talvez a mudança mais significativa seja o foco aprimorado do Google em resolver problemas empresariais concretos, particularmente através da lente dos agentes de IA. Thomas Kurian, CEO da Google Cloud, destacou três razões pelas quais os clientes escolhem o Google: a plataforma otimizada para IA, a abordagem de multi-nuvem aberta permitindo conexão com TI existente e o foco pronto para empresas em segurança, soberania e conformidade.

Os agentes são a chave para essa estratégia. Além do AgentSpace, isso também inclui:

- Blocos de Construção: O Kit de Desenvolvimento de Agentes (ADK) de código aberto, anunciado no Next, já viu interesse significativo dos desenvolvedores. O ADK simplifica a criação de sistemas multi-agentes, enquanto o protocolo proposto Agent2Agent (A2A) visa garantir interoperabilidade, permitindo que agentes construídos com diferentes ferramentas (Gemini ADK, LangGraph, CrewAI, etc.) colaborem. Grannis, do Google, disse que o A2A antecipa os desafios de escala e segurança de um futuro com potencialmente centenas de milhares de agentes interagindo.

- Agentes Específicos: O Google apresentou agentes especialistas integrados ao Agentspace (como NotebookLM, Geração de Ideias, Pesquisa Profunda) e destacou cinco categorias-chave ganhando tração: Agentes de Clientes (alimentando ferramentas como Reddit Answers, assistente de suporte da Verizon, drive-thru da Wendy’s), Agentes Criativos (usados por WPP, Brandtech, Sphere), Agentes de Dados (gerando insights na Mattel, Spotify, Bayer), Agentes de Codificação (Gemini Code Assist) e Agentes de Segurança (integrados à nova plataforma de Segurança Unificada do Google).

Essa estratégia de agentes abrangente parece estar ressoando. Conversas com executivos de três outras grandes empresas na última semana, também falando anonimamente devido a sensibilidades competitivas, ecoaram esse entusiasmo pela estratégia de agentes do Google. O COO da Google Cloud, Francis DeSouza, confirmou em uma entrevista: "Toda conversa inclui IA. Especificamente, toda conversa inclui agentes."

Kevin Laughridge, um executivo da Deloitte, um grande usuário dos produtos de IA do Google e distribuidor deles para outras empresas, descreveu o mercado de agentes como uma "corrida por terras" onde os primeiros movimentos do Google com protocolos e sua plataforma integrada oferecem vantagens significativas. "Quem sair primeiro e conseguir os agentes que realmente entregam valor – é quem vai vencer nessa corrida", disse Laughridge em uma entrevista. Ele disse que o progresso do Google foi "surpreendente", observando que agentes personalizados que a Deloitte construiu há apenas um ano agora poderiam ser replicados "prontos para uso" usando o Agentspace. A própria Deloitte está construindo 100 agentes na plataforma, visando funções de meio de escritório como finanças, risco e engenharia, disse ele.

Os pontos de prova dos clientes estão se acumulando. No Next, o Google citou "mais de 500 clientes em produção" com IA generativa, contra apenas "dezenas de protótipos" há um ano. Se a Microsoft era percebida como muito à frente há um ano, isso não parece mais tão óbvio. Dadas as guerras de relações públicas de todos os lados, é difícil dizer quem está realmente vencendo agora de forma definitiva. As métricas variam. O número de 500 do Google não é diretamente comparável aos 400 estudos de caso que a Microsoft promove (e a Microsoft, em resposta, disse à VentureBeat no momento da imprensa que planeja atualizar essa contagem pública para 600 em breve, destacando o marketing intenso). E se a distribuição de IA do Google por meio de seus aplicativos é significativa, a distribuição do Copilot da Microsoft por meio de sua oferta 365 é igualmente impressionante. Ambos estão agora atingindo milhões de desenvolvedores por meio de APIs.

Mas exemplos da tração do Google abundam:

- Wendy’s: Implantou um sistema de drive-thru de IA em milhares de locais em apenas um ano, melhorando a experiência dos funcionários e a precisão dos pedidos. O CTO da Google Cloud, Will Grannis, observou que o sistema de IA é capaz de entender gírias e filtrar ruídos de fundo, reduzindo significativamente o estresse das interações ao vivo com clientes. Isso libera a equipe para se concentrar na preparação e qualidade dos alimentos — uma mudança que Grannis chamou de "um ótimo exemplo de IA simplificando operações do mundo real."

- Salesforce: Anunciou uma grande expansão, permitindo que sua plataforma rode na Google Cloud pela primeira vez (além da AWS), citando a capacidade do Google de ajudá-los a "inovar e otimizar."

- Honeywell & Intuit: Empresas anteriormente fortemente associadas à Microsoft e AWS, respectivamente, agora fazendo parceria com a Google Cloud em iniciativas de IA.

- Grandes Bancos (Deutsche Bank, Wells Fargo): Aproveitando agentes e Gemini para pesquisa, análise e modernização do atendimento ao cliente.

- Varejistas (Walmart, Mercado Libre, Lowe’s): Usando busca, agentes e plataformas de dados.

Essa tração empresarial alimenta o crescimento geral da Google Cloud, que superou a AWS e a Azure nos últimos três trimestres. A Google Cloud atingiu uma taxa de execução anualizada de 44 bilhões de dólares em 2024, contra apenas 5 bilhões em 2018.

Navegando nas Águas Competitivas

A ascensão do Google não significa que os competidores estão parados. Os lançamentos rápidos da OpenAI esta semana do GPT-4.1 (focado em codificação e contexto longo) e da série o (raciocínio multimodal, uso de ferramentas) demonstram a inovação contínua da OpenAI. Além disso, a nova atualização de recurso de geração de imagens no GPT-4o impulsionou um crescimento maciço em apenas o último mês, ajudando o ChatGPT a alcançar 800 milhões de usuários. A Microsoft continua a aproveitar sua vasta presença empresarial e parceria com a OpenAI, enquanto a Anthropic permanece uma forte concorrente, particularmente em aplicações de codificação e segurança.

No entanto, é indiscutível que a narrativa do Google melhorou notavelmente. Há apenas um ano, o Google era visto como um competidor hesitante, atrapalhado, que talvez estivesse prestes a perder sua chance de liderar a IA. Em vez disso, sua pilha integrada única e sua firmeza corporativa revelaram algo mais: o Google possui capacidades de classe mundial em todo o espectro – do design de chips (TPUs) e infraestrutura global à pesquisa de modelos fundamentais (DeepMind), desenvolvimento de aplicações (Workspace, Search, YouTube) e serviços de nuvem empresarial (Vertex AI, BigQuery, Agentspace). "Somos o único hiperescalador que está na conversa de modelos fundamentais", afirmou deSouza categoricamente. Essa posse de ponta a ponta permite otimizações (como "inteligência por dólar") e profundidade de integração que modelos dependentes de parcerias têm dificuldade em igualar. Competidores muitas vezes precisam costurar peças díspares, potencialmente criando atrito ou limitando a velocidade de inovação.

O Momento do Google é Agora

Embora a corrida da IA permaneça dinâmica, o Google reuniu todas essas peças no momento exato em que o mercado as exige. Como Laughridge, da Deloitte, colocou, o Google atingiu um ponto em que suas capacidades se alinharam perfeitamente "onde o mercado exigia". Se você estava esperando que o Google se provasse na IA empresarial, pode ter perdido o momento — ele já o fez. A empresa que inventou muitas das tecnologias centrais que impulsionam essa revolução parece finalmente ter alcançado – e mais do que isso, agora está definindo o ritmo que os competidores precisam igualar.

No vídeo abaixo, gravado logo após o Next, o especialista em IA Sam Witteveen e eu analisamos o cenário atual e as tendências emergentes, e por que o ecossistema de IA do Google parece tão forte:

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

A IA 'ZeroSearch' da Alibaba reduz os custos de treinamento em 88% por meio da aprendizagem autônoma

ZeroSearch da Alibaba: Um divisor de águas para a eficiência do treinamento em IAOs pesquisadores do Alibaba Group foram pioneiros em um método inovador que pode revolucionar a forma como os sistemas

A IA 'ZeroSearch' da Alibaba reduz os custos de treinamento em 88% por meio da aprendizagem autônoma

ZeroSearch da Alibaba: Um divisor de águas para a eficiência do treinamento em IAOs pesquisadores do Alibaba Group foram pioneiros em um método inovador que pode revolucionar a forma como os sistemas

6 de Agosto de 2025 à59 06:00:59 WEST

6 de Agosto de 2025 à59 06:00:59 WEST

Google's AI comeback is wild! 😎 I thought they were out of the game, but their enterprise push is sneaky strong. Wonder if they’ll dominate the market soon?

0

0

22 de Julho de 2025 à3 02:25:03 WEST

22 de Julho de 2025 à3 02:25:03 WEST

Google's quiet climb in enterprise AI is wild! 😎 I thought they were out of the game, but this Transformer legacy is no joke. Curious if they’ll outpace Microsoft soon?

0

0

22 de Abril de 2025 à20 19:20:20 WEST

22 de Abril de 2025 à20 19:20:20 WEST

GoogleのエンタープライズAIへの進出は感動的だね。追いつくことから先頭に立つまで、彼らは本当にゲームを上げた。でもインターフェースはもう少し改善が必要だね;ちょっとぎこちない。でも、これからどこに向かうのか楽しみだよ!🚀

0

0

22 de Abril de 2025 à12 16:53:12 WEST

22 de Abril de 2025 à12 16:53:12 WEST

Google's move into enterprise AI is impressive. From playing catch-up to leading the pack, they've really stepped up their game. But the interface could use some work; it's a bit clunky. Still, I'm excited to see where they go from here! 🚀

0

0

22 de Abril de 2025 à36 08:22:36 WEST

22 de Abril de 2025 à36 08:22:36 WEST

El movimiento sigiloso de Google en la IA empresarial es bastante genial. De ir a la zaga a liderar el grupo, realmente han dado la vuelta a la situación. La tecnología es sólida pero la interfaz podría ser más amigable para el usuario. Aún así, es impresionante lo rápido que se han movido! 🚀

0

0

22 de Abril de 2025 à16 07:10:16 WEST

22 de Abril de 2025 à16 07:10:16 WEST

A jogada furtiva do Google no AI empresarial é bem legal. De tentar alcançar a liderar o grupo, eles realmente mudaram as coisas. A tecnologia é sólida, mas a interface poderia ser mais amigável ao usuário. Ainda assim, é impressionante como eles se moveram rápido! 🚀

0

0