Amélioration des performances de l'IA avec un raisonnement concis dans les grands modèles de langage

Les grands modèles de langage (LLMs) ont révolutionné l'intelligence artificielle (AI), produisant des textes proches de ceux des humains et relevant des défis complexes dans diverses industries. Auparavant, les experts supposaient que des chaînes de raisonnement étendues amélioraient la précision, avec plus d'étapes conduisant à des résultats fiables.

Une étude de 2025 menée par l'équipe FAIR de Meta et l'Université hébraïque de Jérusalem remet en question cette idée. Elle révèle que des chaînes de raisonnement plus courtes peuvent augmenter la précision des LLMs jusqu'à 34,5 % tout en réduisant les coûts de calcul de 40 %. Un raisonnement concis accélère le traitement, promettant de transformer l'entraînement, le déploiement et l'évolutivité des LLMs.

Pourquoi un raisonnement concis améliore l'efficacité de l'IA

Traditionnellement, on pensait que des chaînes de raisonnement plus longues amélioraient les résultats de l'IA en traitant davantage de données. La logique était simple : plus d'étapes signifiaient une analyse plus approfondie, augmentant la précision. Par conséquent, les systèmes d'IA privilégiaient un raisonnement étendu pour améliorer les performances.

Cependant, cette approche présente des inconvénients. Les chaînes plus longues exigent une puissance de calcul importante, ralentissant le traitement et augmentant les coûts, en particulier dans les applications en temps réel nécessitant des réponses rapides. De plus, des chaînes complexes augmentent les risques d'erreurs, réduisant l'efficacité et l'évolutivité dans les industries nécessitant à la fois vitesse et précision.

L'étude menée par Meta met en lumière ces défauts, montrant que des chaînes de raisonnement plus courtes améliorent la précision tout en réduisant les besoins en calcul. Cela permet un traitement plus rapide des tâches sans sacrifier la fiabilité.

Ces idées réorientent le développement de l'IA de la maximisation des étapes de raisonnement vers l'optimisation des processus. Des chaînes plus courtes améliorent l'efficacité, fournissent des résultats fiables et réduisent le temps de traitement.

Optimisation du raisonnement avec le cadre short-m@k

L'étude introduit le cadre d'inférence short-m@k, conçu pour rationaliser le raisonnement en plusieurs étapes dans les LLMs. Contrairement aux méthodes traditionnelles séquentielles ou de vote majoritaire, il utilise un traitement parallèle et une terminaison anticipée pour augmenter l'efficacité et réduire les coûts.

Dans l'approche short-m@k, k chaînes de raisonnement parallèles s'exécutent simultanément, s'arrêtant dès que les m premières chaînes sont terminées. La prédiction finale utilise un vote majoritaire à partir de ces résultats précoces, minimisant les calculs inutiles tout en préservant la précision.

Le cadre propose deux variantes :

short-1@k : Sélectionne la première chaîne terminée parmi k tentatives parallèles, idéale pour les environnements à faibles ressources et sensibles à la latence, offrant une haute précision avec un coût de calcul minimal.

short-3@k : Combine les résultats des trois premières chaînes terminées, surpassant les méthodes traditionnelles en précision et en débit, adaptée aux environnements à haute performance et à grande échelle.

Le cadre short-m@k améliore également l'ajustement fin des modèles. L'entraînement avec des séquences de raisonnement concises accélère la convergence, améliorant la précision de l'inférence et l'efficacité des ressources lors de l'entraînement et du déploiement.

Impact sur le développement de l'IA et son utilisation dans l'industrie

Des chaînes de raisonnement plus courtes influencent significativement le développement, le déploiement et la durabilité des modèles d'IA.

Dans l'entraînement, des chaînes concises réduisent la complexité computationnelle, abaissant les coûts et accélérant les mises à jour sans nécessiter d'infrastructure supplémentaire.

Pour le déploiement, en particulier dans les applications sensibles au temps comme les chatbots ou les plateformes de trading, des chaînes plus courtes améliorent la vitesse de traitement, permettant aux systèmes de gérer plus de requêtes efficacement et de s'adapter à une forte demande.

L'efficacité énergétique est un autre avantage. Moins de calculs pendant l'entraînement et l'inférence réduisent la consommation d'énergie, diminuant les coûts et soutenant les objectifs environnementaux alors que les centres de données font face à des besoins énergétiques croissants.

Dans l'ensemble, ces efficacités accélèrent le développement de l'IA, permettant une mise sur le marché plus rapide des solutions d'IA, aidant les organisations à rester compétitives dans un paysage technologique dynamique.

Relever les défis de l'adoption d'un raisonnement concis

Bien que les chaînes de raisonnement plus courtes offrent des avantages clairs, leur mise en œuvre pose des défis.

Les systèmes d'IA traditionnels, conçus pour un raisonnement plus long, nécessitent une refonte des architectures de modèles, des méthodes d'entraînement et des stratégies d'optimisation, exigeant une expertise technique et une adaptabilité organisationnelle.

La qualité et la structure des données sont cruciales. Les modèles entraînés sur des ensembles de données pour un raisonnement étendu peuvent échouer avec des chemins plus courts. La curation d'ensembles de données pour un raisonnement concis et ciblé est essentielle pour maintenir la précision.

L'évolutivité est un autre obstacle. Bien qu'efficace dans des contextes contrôlés, les applications à grande échelle comme le commerce électronique ou le support client exigent une infrastructure robuste pour gérer de grands volumes de requêtes sans compromettre les performances.

Les stratégies pour relever ces défis incluent :

- Mettre en œuvre le cadre short-m@k : Exploite le traitement parallèle et la terminaison anticipée pour un équilibre entre vitesse et précision dans les applications en temps réel.

- Se concentrer sur un raisonnement concis dans l'entraînement : Utiliser des méthodes mettant l'accent sur des chaînes plus courtes pour optimiser les ressources et la vitesse.

- Suivre les métriques de raisonnement : Surveiller la longueur des chaînes et les performances du modèle en temps réel pour une efficacité et une précision continues.

Ces stratégies permettent aux développeurs d'adopter des chaînes de raisonnement plus courtes, créant des systèmes d'IA plus rapides, plus précis et évolutifs qui répondent aux objectifs opérationnels et d'efficacité des coûts.

En conclusion

La recherche sur les chaînes de raisonnement concises redéfinit le développement de l'IA. Des chaînes plus courtes améliorent la vitesse, la précision et l'efficacité des coûts, essentielles pour les industries privilégiant les performances.

En adoptant un raisonnement concis, les systèmes d'IA s'améliorent sans ressources supplémentaires, permettant un développement et un déploiement efficaces. Cette approche positionne l'IA pour répondre à divers besoins, maintenant les développeurs et les entreprises compétitifs dans un paysage technologique en rapide évolution.

Article connexe

Magi-1 Dévoilé : Technologie Pionnière de Génération de Vidéo par IA

Explorez notre analyse détaillée de Magi-1, une plateforme IA innovante qui révolutionne la création vidéo autorégressive. Cet article explore ses fonctionnalités uniques, sa structure de tarification

Magi-1 Dévoilé : Technologie Pionnière de Génération de Vidéo par IA

Explorez notre analyse détaillée de Magi-1, une plateforme IA innovante qui révolutionne la création vidéo autorégressive. Cet article explore ses fonctionnalités uniques, sa structure de tarification

Conception Graphique Alimentée par l'IA : Meilleurs Outils et Techniques pour 2025

En 2025, l'intelligence artificielle (IA) remodèle les industries, avec la conception graphique en tête de cette transformation. Les outils IA habilitent les concepteurs en stimulant la créativité, en

Conception Graphique Alimentée par l'IA : Meilleurs Outils et Techniques pour 2025

En 2025, l'intelligence artificielle (IA) remodèle les industries, avec la conception graphique en tête de cette transformation. Les outils IA habilitent les concepteurs en stimulant la créativité, en

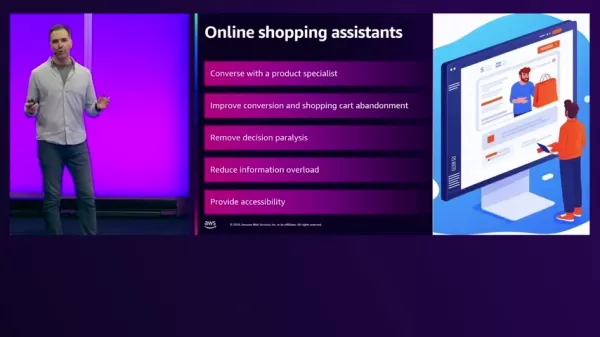

Assistants d'achat propulsés par l'IA transforment le commerce électronique sur AWS

Dans l'environnement rapide du commerce électronique d'aujourd'hui, les détaillants s'efforcent d'améliorer les expériences des clients et de stimuler les ventes. L'IA générative offre des solutions i

commentaires (0)

0/200

Assistants d'achat propulsés par l'IA transforment le commerce électronique sur AWS

Dans l'environnement rapide du commerce électronique d'aujourd'hui, les détaillants s'efforcent d'améliorer les expériences des clients et de stimuler les ventes. L'IA générative offre des solutions i

commentaires (0)

0/200

Les grands modèles de langage (LLMs) ont révolutionné l'intelligence artificielle (AI), produisant des textes proches de ceux des humains et relevant des défis complexes dans diverses industries. Auparavant, les experts supposaient que des chaînes de raisonnement étendues amélioraient la précision, avec plus d'étapes conduisant à des résultats fiables.

Une étude de 2025 menée par l'équipe FAIR de Meta et l'Université hébraïque de Jérusalem remet en question cette idée. Elle révèle que des chaînes de raisonnement plus courtes peuvent augmenter la précision des LLMs jusqu'à 34,5 % tout en réduisant les coûts de calcul de 40 %. Un raisonnement concis accélère le traitement, promettant de transformer l'entraînement, le déploiement et l'évolutivité des LLMs.

Pourquoi un raisonnement concis améliore l'efficacité de l'IA

Traditionnellement, on pensait que des chaînes de raisonnement plus longues amélioraient les résultats de l'IA en traitant davantage de données. La logique était simple : plus d'étapes signifiaient une analyse plus approfondie, augmentant la précision. Par conséquent, les systèmes d'IA privilégiaient un raisonnement étendu pour améliorer les performances.

Cependant, cette approche présente des inconvénients. Les chaînes plus longues exigent une puissance de calcul importante, ralentissant le traitement et augmentant les coûts, en particulier dans les applications en temps réel nécessitant des réponses rapides. De plus, des chaînes complexes augmentent les risques d'erreurs, réduisant l'efficacité et l'évolutivité dans les industries nécessitant à la fois vitesse et précision.

L'étude menée par Meta met en lumière ces défauts, montrant que des chaînes de raisonnement plus courtes améliorent la précision tout en réduisant les besoins en calcul. Cela permet un traitement plus rapide des tâches sans sacrifier la fiabilité.

Ces idées réorientent le développement de l'IA de la maximisation des étapes de raisonnement vers l'optimisation des processus. Des chaînes plus courtes améliorent l'efficacité, fournissent des résultats fiables et réduisent le temps de traitement.

Optimisation du raisonnement avec le cadre short-m@k

L'étude introduit le cadre d'inférence short-m@k, conçu pour rationaliser le raisonnement en plusieurs étapes dans les LLMs. Contrairement aux méthodes traditionnelles séquentielles ou de vote majoritaire, il utilise un traitement parallèle et une terminaison anticipée pour augmenter l'efficacité et réduire les coûts.

Dans l'approche short-m@k, k chaînes de raisonnement parallèles s'exécutent simultanément, s'arrêtant dès que les m premières chaînes sont terminées. La prédiction finale utilise un vote majoritaire à partir de ces résultats précoces, minimisant les calculs inutiles tout en préservant la précision.

Le cadre propose deux variantes :

short-1@k : Sélectionne la première chaîne terminée parmi k tentatives parallèles, idéale pour les environnements à faibles ressources et sensibles à la latence, offrant une haute précision avec un coût de calcul minimal.

short-3@k : Combine les résultats des trois premières chaînes terminées, surpassant les méthodes traditionnelles en précision et en débit, adaptée aux environnements à haute performance et à grande échelle.

Le cadre short-m@k améliore également l'ajustement fin des modèles. L'entraînement avec des séquences de raisonnement concises accélère la convergence, améliorant la précision de l'inférence et l'efficacité des ressources lors de l'entraînement et du déploiement.

Impact sur le développement de l'IA et son utilisation dans l'industrie

Des chaînes de raisonnement plus courtes influencent significativement le développement, le déploiement et la durabilité des modèles d'IA.

Dans l'entraînement, des chaînes concises réduisent la complexité computationnelle, abaissant les coûts et accélérant les mises à jour sans nécessiter d'infrastructure supplémentaire.

Pour le déploiement, en particulier dans les applications sensibles au temps comme les chatbots ou les plateformes de trading, des chaînes plus courtes améliorent la vitesse de traitement, permettant aux systèmes de gérer plus de requêtes efficacement et de s'adapter à une forte demande.

L'efficacité énergétique est un autre avantage. Moins de calculs pendant l'entraînement et l'inférence réduisent la consommation d'énergie, diminuant les coûts et soutenant les objectifs environnementaux alors que les centres de données font face à des besoins énergétiques croissants.

Dans l'ensemble, ces efficacités accélèrent le développement de l'IA, permettant une mise sur le marché plus rapide des solutions d'IA, aidant les organisations à rester compétitives dans un paysage technologique dynamique.

Relever les défis de l'adoption d'un raisonnement concis

Bien que les chaînes de raisonnement plus courtes offrent des avantages clairs, leur mise en œuvre pose des défis.

Les systèmes d'IA traditionnels, conçus pour un raisonnement plus long, nécessitent une refonte des architectures de modèles, des méthodes d'entraînement et des stratégies d'optimisation, exigeant une expertise technique et une adaptabilité organisationnelle.

La qualité et la structure des données sont cruciales. Les modèles entraînés sur des ensembles de données pour un raisonnement étendu peuvent échouer avec des chemins plus courts. La curation d'ensembles de données pour un raisonnement concis et ciblé est essentielle pour maintenir la précision.

L'évolutivité est un autre obstacle. Bien qu'efficace dans des contextes contrôlés, les applications à grande échelle comme le commerce électronique ou le support client exigent une infrastructure robuste pour gérer de grands volumes de requêtes sans compromettre les performances.

Les stratégies pour relever ces défis incluent :

- Mettre en œuvre le cadre short-m@k : Exploite le traitement parallèle et la terminaison anticipée pour un équilibre entre vitesse et précision dans les applications en temps réel.

- Se concentrer sur un raisonnement concis dans l'entraînement : Utiliser des méthodes mettant l'accent sur des chaînes plus courtes pour optimiser les ressources et la vitesse.

- Suivre les métriques de raisonnement : Surveiller la longueur des chaînes et les performances du modèle en temps réel pour une efficacité et une précision continues.

Ces stratégies permettent aux développeurs d'adopter des chaînes de raisonnement plus courtes, créant des systèmes d'IA plus rapides, plus précis et évolutifs qui répondent aux objectifs opérationnels et d'efficacité des coûts.

En conclusion

La recherche sur les chaînes de raisonnement concises redéfinit le développement de l'IA. Des chaînes plus courtes améliorent la vitesse, la précision et l'efficacité des coûts, essentielles pour les industries privilégiant les performances.

En adoptant un raisonnement concis, les systèmes d'IA s'améliorent sans ressources supplémentaires, permettant un développement et un déploiement efficaces. Cette approche positionne l'IA pour répondre à divers besoins, maintenant les développeurs et les entreprises compétitifs dans un paysage technologique en rapide évolution.

Magi-1 Dévoilé : Technologie Pionnière de Génération de Vidéo par IA

Explorez notre analyse détaillée de Magi-1, une plateforme IA innovante qui révolutionne la création vidéo autorégressive. Cet article explore ses fonctionnalités uniques, sa structure de tarification

Magi-1 Dévoilé : Technologie Pionnière de Génération de Vidéo par IA

Explorez notre analyse détaillée de Magi-1, une plateforme IA innovante qui révolutionne la création vidéo autorégressive. Cet article explore ses fonctionnalités uniques, sa structure de tarification

Conception Graphique Alimentée par l'IA : Meilleurs Outils et Techniques pour 2025

En 2025, l'intelligence artificielle (IA) remodèle les industries, avec la conception graphique en tête de cette transformation. Les outils IA habilitent les concepteurs en stimulant la créativité, en

Conception Graphique Alimentée par l'IA : Meilleurs Outils et Techniques pour 2025

En 2025, l'intelligence artificielle (IA) remodèle les industries, avec la conception graphique en tête de cette transformation. Les outils IA habilitent les concepteurs en stimulant la créativité, en

Assistants d'achat propulsés par l'IA transforment le commerce électronique sur AWS

Dans l'environnement rapide du commerce électronique d'aujourd'hui, les détaillants s'efforcent d'améliorer les expériences des clients et de stimuler les ventes. L'IA générative offre des solutions i

Assistants d'achat propulsés par l'IA transforment le commerce électronique sur AWS

Dans l'environnement rapide du commerce électronique d'aujourd'hui, les détaillants s'efforcent d'améliorer les expériences des clients et de stimuler les ventes. L'IA générative offre des solutions i