Aumentando o Desempenho de IA com Raciocínio Conciso em Modelos de Linguagem de Grande Escala

Modelos de Linguagem de Grande Escala (LLMs) revolucionaram a Inteligência Artificial (AI), produzindo textos semelhantes aos humanos e enfrentando desafios complexos em várias indústrias. Anteriormente, especialistas presumiam que cadeias de raciocínio extensas aumentavam a precisão, com mais etapas gerando resultados confiáveis.

Um estudo de 2025 da equipe FAIR da Meta e da Universidade Hebraica de Jerusalém desafia essa noção. Ele revela que cadeias de raciocínio mais curtas podem aumentar a precisão dos LLMs em até 34,5% enquanto reduzem os custos computacionais em 40%. O raciocínio conciso acelera o processamento, prometendo reformular o treinamento, implantação e escalabilidade dos LLMs.

Por que o Raciocínio Conciso Melhora a Eficiência da IA

Tradicionalmente, cadeias de raciocínio mais longas eram consideradas melhores para os resultados de IA, processando mais dados. A lógica era simples: mais etapas significavam análises mais profundas, aumentando a precisão. Consequentemente, os sistemas de IA priorizavam raciocínios extensos para melhorar o desempenho.

No entanto, essa abordagem tem desvantagens. Cadeias mais longas exigem poder computacional significativo, diminuindo a velocidade de processamento e aumentando os custos, especialmente em aplicações em tempo real que exigem respostas rápidas. Além disso, cadeias complexas aumentam os riscos de erro, reduzindo a eficiência e a escalabilidade em indústrias que precisam de velocidade e precisão.

O estudo liderado pela Meta destaca essas falhas, mostrando que cadeias de raciocínio mais curtas melhoram a precisão enquanto reduzem as demandas computacionais. Isso permite um processamento de tarefas mais rápido sem sacrificar a confiabilidade.

Essas descobertas mudam o foco do desenvolvimento de IA, de maximizar as etapas de raciocínio para otimizar processos. Cadeias mais curtas aumentam a eficiência, entregam resultados confiáveis e reduzem o tempo de processamento.

Otimizando o Raciocínio com o Framework short-m@k

O estudo apresenta o framework de inferência short-m@k, projetado para simplificar o raciocínio em várias etapas nos LLMs. Diferentemente dos métodos tradicionais sequenciais ou de votação majoritária, ele usa processamento paralelo e término precoce para aumentar a eficiência e reduzir custos.

Na abordagem short-m@k, k cadeias de raciocínio paralelas são executadas simultaneamente, parando assim que as primeiras m cadeias são concluídas. A previsão final usa votação majoritária desses resultados iniciais, minimizando cálculos desnecessários enquanto preserva a precisão.

O framework oferece duas variantes:

short-1@k: Seleciona a primeira cadeia concluída de k tentativas paralelas, ideal para configurações sensíveis à latência e com poucos recursos, entregando alta precisão com custo computacional mínimo.

short-3@k: Combina resultados das três primeiras cadeias concluídas, superando métodos tradicionais em precisão e vazão, adequado para ambientes de alto desempenho e grande escala.

O framework short-m@k também melhora o ajuste fino do modelo. Treinar com sequências de raciocínio concisas acelera a convergência, melhorando a precisão da inferência e a eficiência de recursos durante o treinamento e a implantação.

Impacto no Desenvolvimento de IA e Uso na Indústria

Cadeias de raciocínio mais curtas influenciam significativamente o desenvolvimento, implantação e sustentabilidade de modelos de IA.

No treinamento, cadeias concisas reduzem a complexidade computacional, diminuindo custos e acelerando atualizações sem exigir infraestrutura adicional.

Para a implantação, especialmente em aplicações sensíveis ao tempo, como chatbots ou plataformas de negociação, cadeias mais curtas aumentam a velocidade de processamento, permitindo que os sistemas lidem com mais solicitações de forma eficiente e escalem eficazmente sob alta demanda.

A eficiência energética é outra vantagem. Menos cálculos durante o treinamento e a inferência reduzem o consumo de energia, cortando custos e apoiando metas ambientais, à medida que os data centers enfrentam demandas energéticas crescentes.

No geral, essas eficiências aceleram o desenvolvimento de IA, permitindo uma entrega mais rápida de soluções de IA ao mercado, ajudando as organizações a permanecerem competitivas em um cenário tecnológico dinâmico.

Enfrentando Desafios na Adoção do Raciocínio Conciso

Embora cadeias de raciocínio mais curtas ofereçam benefícios claros, a implementação apresenta desafios.

Sistemas de IA tradicionais, construídos para raciocínios mais longos, exigem reestruturação das arquiteturas de modelo, métodos de treinamento e estratégias de otimização, demandando expertise técnica e adaptabilidade organizacional.

A qualidade e a estrutura dos dados são cruciais. Modelos treinados em conjuntos de dados para raciocínios extensos podem falhar com caminhos mais curtos. A curadoria de conjuntos de dados para raciocínios concisos e direcionados é essencial para manter a precisão.

A escalabilidade é outro obstáculo. Embora eficaz em configurações controladas, aplicações em grande escala, como comércio eletrônico ou suporte ao cliente, exigem uma infraestrutura robusta para gerenciar altos volumes de solicitações sem comprometer o desempenho.

Estratégias para enfrentar esses desafios incluem:

- Implementar o framework short-m@k: Aproveita o processamento paralelo e o término precoce para equilibrar velocidade e precisão em aplicações em tempo real.

- Foco no raciocínio conciso no treinamento: Use métodos que enfatizam cadeias mais curtas para otimizar recursos e velocidade.

- Acompanhar métricas de raciocínio: Monitorar o comprimento da cadeia e o desempenho do modelo em tempo real para eficiência e precisão contínuas.

Essas estratégias permitem que os desenvolvedores adotem cadeias de raciocínio mais curtas, criando sistemas de IA mais rápidos, precisos e escaláveis que atendem às metas operacionais e de eficiência de custos.

A Conclusão

A pesquisa sobre cadeias de raciocínio concisas redefine o desenvolvimento de IA. Cadeias mais curtas aumentam a velocidade, a precisão e a eficiência de custos, cruciais para indústrias que priorizam o desempenho.

Ao adotar o raciocínio conciso, os sistemas de IA melhoram sem recursos adicionais, permitindo um desenvolvimento e implantação eficientes. Essa abordagem posiciona a IA para atender a diversas necessidades, mantendo desenvolvedores e empresas competitivos em um cenário tecnológico em rápida evolução.

Artigo relacionado

Design Gráfico Impulsionado por IA: Principais Ferramentas e Técnicas para 2025

Em 2025, a inteligência artificial (IA) está remodelando indústrias, com o design gráfico na vanguarda dessa transformação. Ferramentas de IA estão capacitando designers ao impulsionar a criatividade,

Design Gráfico Impulsionado por IA: Principais Ferramentas e Técnicas para 2025

Em 2025, a inteligência artificial (IA) está remodelando indústrias, com o design gráfico na vanguarda dessa transformação. Ferramentas de IA estão capacitando designers ao impulsionar a criatividade,

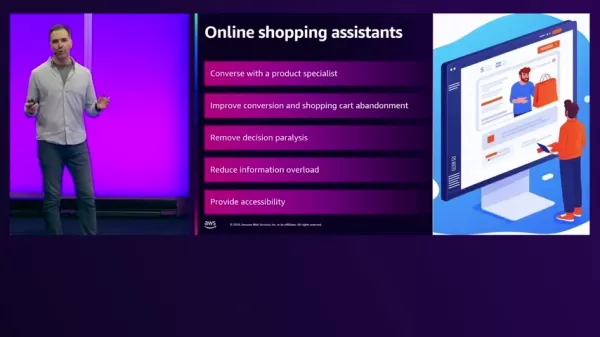

Assistentes de Compras Impulsionados por IA Transformam o Comércio Eletrônico na AWS

No ambiente acelerado do comércio eletrônico atual, os varejistas buscam elevar as experiências dos clientes e aumentar as vendas. A IA generativa oferece soluções inovadoras ao impulsionar assistente

Assistentes de Compras Impulsionados por IA Transformam o Comércio Eletrônico na AWS

No ambiente acelerado do comércio eletrônico atual, os varejistas buscam elevar as experiências dos clientes e aumentar as vendas. A IA generativa oferece soluções inovadoras ao impulsionar assistente

Bing AI vs. ChatGPT: Comparação Detalhada e Guia de Miniaturas Grátis

No campo em rápida evolução da inteligência artificial, Bing AI e ChatGPT emergem como principais concorrentes. Ambos são ferramentas robustas para gerar texto, responder perguntas e suportar diversas

Comentários (0)

0/200

Bing AI vs. ChatGPT: Comparação Detalhada e Guia de Miniaturas Grátis

No campo em rápida evolução da inteligência artificial, Bing AI e ChatGPT emergem como principais concorrentes. Ambos são ferramentas robustas para gerar texto, responder perguntas e suportar diversas

Comentários (0)

0/200

Modelos de Linguagem de Grande Escala (LLMs) revolucionaram a Inteligência Artificial (AI), produzindo textos semelhantes aos humanos e enfrentando desafios complexos em várias indústrias. Anteriormente, especialistas presumiam que cadeias de raciocínio extensas aumentavam a precisão, com mais etapas gerando resultados confiáveis.

Um estudo de 2025 da equipe FAIR da Meta e da Universidade Hebraica de Jerusalém desafia essa noção. Ele revela que cadeias de raciocínio mais curtas podem aumentar a precisão dos LLMs em até 34,5% enquanto reduzem os custos computacionais em 40%. O raciocínio conciso acelera o processamento, prometendo reformular o treinamento, implantação e escalabilidade dos LLMs.

Por que o Raciocínio Conciso Melhora a Eficiência da IA

Tradicionalmente, cadeias de raciocínio mais longas eram consideradas melhores para os resultados de IA, processando mais dados. A lógica era simples: mais etapas significavam análises mais profundas, aumentando a precisão. Consequentemente, os sistemas de IA priorizavam raciocínios extensos para melhorar o desempenho.

No entanto, essa abordagem tem desvantagens. Cadeias mais longas exigem poder computacional significativo, diminuindo a velocidade de processamento e aumentando os custos, especialmente em aplicações em tempo real que exigem respostas rápidas. Além disso, cadeias complexas aumentam os riscos de erro, reduzindo a eficiência e a escalabilidade em indústrias que precisam de velocidade e precisão.

O estudo liderado pela Meta destaca essas falhas, mostrando que cadeias de raciocínio mais curtas melhoram a precisão enquanto reduzem as demandas computacionais. Isso permite um processamento de tarefas mais rápido sem sacrificar a confiabilidade.

Essas descobertas mudam o foco do desenvolvimento de IA, de maximizar as etapas de raciocínio para otimizar processos. Cadeias mais curtas aumentam a eficiência, entregam resultados confiáveis e reduzem o tempo de processamento.

Otimizando o Raciocínio com o Framework short-m@k

O estudo apresenta o framework de inferência short-m@k, projetado para simplificar o raciocínio em várias etapas nos LLMs. Diferentemente dos métodos tradicionais sequenciais ou de votação majoritária, ele usa processamento paralelo e término precoce para aumentar a eficiência e reduzir custos.

Na abordagem short-m@k, k cadeias de raciocínio paralelas são executadas simultaneamente, parando assim que as primeiras m cadeias são concluídas. A previsão final usa votação majoritária desses resultados iniciais, minimizando cálculos desnecessários enquanto preserva a precisão.

O framework oferece duas variantes:

short-1@k: Seleciona a primeira cadeia concluída de k tentativas paralelas, ideal para configurações sensíveis à latência e com poucos recursos, entregando alta precisão com custo computacional mínimo.

short-3@k: Combina resultados das três primeiras cadeias concluídas, superando métodos tradicionais em precisão e vazão, adequado para ambientes de alto desempenho e grande escala.

O framework short-m@k também melhora o ajuste fino do modelo. Treinar com sequências de raciocínio concisas acelera a convergência, melhorando a precisão da inferência e a eficiência de recursos durante o treinamento e a implantação.

Impacto no Desenvolvimento de IA e Uso na Indústria

Cadeias de raciocínio mais curtas influenciam significativamente o desenvolvimento, implantação e sustentabilidade de modelos de IA.

No treinamento, cadeias concisas reduzem a complexidade computacional, diminuindo custos e acelerando atualizações sem exigir infraestrutura adicional.

Para a implantação, especialmente em aplicações sensíveis ao tempo, como chatbots ou plataformas de negociação, cadeias mais curtas aumentam a velocidade de processamento, permitindo que os sistemas lidem com mais solicitações de forma eficiente e escalem eficazmente sob alta demanda.

A eficiência energética é outra vantagem. Menos cálculos durante o treinamento e a inferência reduzem o consumo de energia, cortando custos e apoiando metas ambientais, à medida que os data centers enfrentam demandas energéticas crescentes.

No geral, essas eficiências aceleram o desenvolvimento de IA, permitindo uma entrega mais rápida de soluções de IA ao mercado, ajudando as organizações a permanecerem competitivas em um cenário tecnológico dinâmico.

Enfrentando Desafios na Adoção do Raciocínio Conciso

Embora cadeias de raciocínio mais curtas ofereçam benefícios claros, a implementação apresenta desafios.

Sistemas de IA tradicionais, construídos para raciocínios mais longos, exigem reestruturação das arquiteturas de modelo, métodos de treinamento e estratégias de otimização, demandando expertise técnica e adaptabilidade organizacional.

A qualidade e a estrutura dos dados são cruciais. Modelos treinados em conjuntos de dados para raciocínios extensos podem falhar com caminhos mais curtos. A curadoria de conjuntos de dados para raciocínios concisos e direcionados é essencial para manter a precisão.

A escalabilidade é outro obstáculo. Embora eficaz em configurações controladas, aplicações em grande escala, como comércio eletrônico ou suporte ao cliente, exigem uma infraestrutura robusta para gerenciar altos volumes de solicitações sem comprometer o desempenho.

Estratégias para enfrentar esses desafios incluem:

- Implementar o framework short-m@k: Aproveita o processamento paralelo e o término precoce para equilibrar velocidade e precisão em aplicações em tempo real.

- Foco no raciocínio conciso no treinamento: Use métodos que enfatizam cadeias mais curtas para otimizar recursos e velocidade.

- Acompanhar métricas de raciocínio: Monitorar o comprimento da cadeia e o desempenho do modelo em tempo real para eficiência e precisão contínuas.

Essas estratégias permitem que os desenvolvedores adotem cadeias de raciocínio mais curtas, criando sistemas de IA mais rápidos, precisos e escaláveis que atendem às metas operacionais e de eficiência de custos.

A Conclusão

A pesquisa sobre cadeias de raciocínio concisas redefine o desenvolvimento de IA. Cadeias mais curtas aumentam a velocidade, a precisão e a eficiência de custos, cruciais para indústrias que priorizam o desempenho.

Ao adotar o raciocínio conciso, os sistemas de IA melhoram sem recursos adicionais, permitindo um desenvolvimento e implantação eficientes. Essa abordagem posiciona a IA para atender a diversas necessidades, mantendo desenvolvedores e empresas competitivos em um cenário tecnológico em rápida evolução.

Design Gráfico Impulsionado por IA: Principais Ferramentas e Técnicas para 2025

Em 2025, a inteligência artificial (IA) está remodelando indústrias, com o design gráfico na vanguarda dessa transformação. Ferramentas de IA estão capacitando designers ao impulsionar a criatividade,

Design Gráfico Impulsionado por IA: Principais Ferramentas e Técnicas para 2025

Em 2025, a inteligência artificial (IA) está remodelando indústrias, com o design gráfico na vanguarda dessa transformação. Ferramentas de IA estão capacitando designers ao impulsionar a criatividade,

Assistentes de Compras Impulsionados por IA Transformam o Comércio Eletrônico na AWS

No ambiente acelerado do comércio eletrônico atual, os varejistas buscam elevar as experiências dos clientes e aumentar as vendas. A IA generativa oferece soluções inovadoras ao impulsionar assistente

Assistentes de Compras Impulsionados por IA Transformam o Comércio Eletrônico na AWS

No ambiente acelerado do comércio eletrônico atual, os varejistas buscam elevar as experiências dos clientes e aumentar as vendas. A IA generativa oferece soluções inovadoras ao impulsionar assistente

Bing AI vs. ChatGPT: Comparação Detalhada e Guia de Miniaturas Grátis

No campo em rápida evolução da inteligência artificial, Bing AI e ChatGPT emergem como principais concorrentes. Ambos são ferramentas robustas para gerar texto, responder perguntas e suportar diversas

Bing AI vs. ChatGPT: Comparação Detalhada e Guia de Miniaturas Grátis

No campo em rápida evolução da inteligência artificial, Bing AI e ChatGPT emergem como principais concorrentes. Ambos são ferramentas robustas para gerar texto, responder perguntas e suportar diversas