Steigerung der KI-Leistung durch präzises Denken in großen Sprachmodellen

Große Sprachmodelle (LLMs) haben die Künstliche Intelligenz (AI) revolutioniert, indem sie menschenähnliche Texte erstellen und komplexe Herausforderungen in verschiedenen Branchen bewältigen. Früher gingen Experten davon aus, dass längere Denkketten die Genauigkeit verbessern, wobei mehr Schritte zuverlässigere Ergebnisse liefern.

Eine Studie von 2025 des FAIR-Teams von Meta und der Hebräischen Universität Jerusalem stellt diese Annahme infrage. Sie zeigt, dass kürzere Denkketten die Genauigkeit von LLMs um bis zu 34,5 % steigern und gleichzeitig die Rechenkosten um 40 % senken können. Präzises Denken beschleunigt die Verarbeitung und verspricht, das Training, die Bereitstellung und die Skalierbarkeit von LLMs neu zu gestalten.

Warum präzises Denken die Effizienz von KI steigert

Traditionell wurde angenommen, dass längere Denkketten die KI-Ergebnisse verbessern, indem sie mehr Daten verarbeiten. Die Logik war einfach: Mehr Schritte bedeuteten tiefere Analysen und höhere Genauigkeit. Folglich priorisierten KI-Systeme ausgedehnte Denkprozesse, um die Leistung zu steigern.

Dieser Ansatz hat jedoch Nachteile. Längere Ketten erfordern erhebliche Rechenleistung, verlangsamen die Verarbeitung und erhöhen die Kosten, insbesondere in Echtzeitanwendungen, die schnelle Antworten erfordern. Zudem erhöhen komplexe Ketten das Fehlerrisiko, was die Effizienz und Skalierbarkeit in Branchen beeinträchtigt, die sowohl Geschwindigkeit als auch Präzision benötigen.

Die von Meta geleitete Studie zeigt diese Schwächen auf und belegt, dass kürzere Denkketten die Genauigkeit verbessern und gleichzeitig den Rechenaufwand senken. Dies ermöglicht eine schnellere Aufgabenverarbeitung ohne Einbußen bei der Zuverlässigkeit.

Diese Erkenntnisse verlagern den Fokus der KI-Entwicklung von der Maximierung der Denkschritte hin zur Prozessoptimierung. Kürzere Ketten verbessern die Effizienz, liefern zuverlässige Ergebnisse und reduzieren die Verarbeitungszeit.

Optimierung des Denkens mit dem short-m@k Framework

Die Studie stellt das short-m@k Inferenz-Framework vor, das entwickelt wurde, um mehrstufiges Denken in LLMs zu optimieren. Im Gegensatz zu traditionellen sequenziellen oder Mehrheitsabstimmungs-Methoden nutzt es parallele Verarbeitung und frühe Beendigung, um die Effizienz zu steigern und Kosten zu senken.

Im short-m@k Ansatz laufen k parallele Denkketten gleichzeitig und stoppen, sobald die ersten m Ketten abgeschlossen sind. Die endgültige Vorhersage basiert auf einer Mehrheitsabstimmung dieser frühen Ergebnisse, wodurch unnötige Berechnungen minimiert und die Genauigkeit erhalten bleibt.

Das Framework bietet zwei Varianten:

short-1@k: Wählt die erste abgeschlossene Kette aus k parallelen Versuchen, ideal für ressourcenarme, latenzempfindliche Umgebungen, die hohe Genauigkeit bei minimalem Rechenaufwand liefern.

short-3@k: Kombiniert die Ergebnisse der ersten drei abgeschlossenen Ketten, übertrifft traditionelle Methoden in Genauigkeit und Durchsatz und eignet sich für leistungsstarke, groß angelegte Umgebungen.

Das short-m@k Framework verbessert auch das Modell-Fine-Tuning. Training mit präzisen Denksequenzen beschleunigt die Konvergenz und steigert die Präzision und Ressourceneffizienz während Training und Bereitstellung.

Auswirkungen auf KI-Entwicklung und industrielle Anwendung

Kürzere Denkketten beeinflussen die Entwicklung, Bereitstellung und Nachhaltigkeit von KI-Modellen erheblich.

Im Training reduzieren präzise Ketten die Rechenkomplexität, senken Kosten und beschleunigen Updates ohne zusätzliche Infrastruktur.

Für die Bereitstellung, insbesondere in zeitkritischen Anwendungen wie Chatbots oder Handelsplattformen, verbessern kürzere Ketten die Verarbeitungsgeschwindigkeit, sodass Systeme mehr Anfragen effizient verarbeiten und unter hoher Nachfrage effektiv skalieren können.

Energiesparsamkeit ist ein weiterer Vorteil. Weniger Berechnungen während Training und Inferenz reduzieren den Energieverbrauch, senken Kosten und unterstützen Umweltziele, da Rechenzentren mit wachsendem Energiebedarf konfrontiert sind.

Insgesamt beschleunigen diese Effizienzen die KI-Entwicklung, ermöglichen eine schnellere Markteinführung von KI-Lösungen und helfen Organisationen, in einer dynamischen Technologielandschaft wettbewerbsfähig zu bleiben.

Herausforderungen bei der Einführung präzisen Denkens

Obwohl kürzere Denkketten klare Vorteile bieten, stellt die Umsetzung Herausforderungen dar.

Traditionelle KI-Systeme, die für längeres Denken ausgelegt sind, erfordern eine Überarbeitung der Modellarchitekturen, Trainingsmethoden und Optimierungsstrategien, was technisches Fachwissen und organisatorische Anpassungsfähigkeit erfordert.

Die Datenqualität und -struktur sind entscheidend. Modelle, die auf Datensätze für ausgedehntes Denken trainiert wurden, könnten bei kürzeren Pfaden scheitern. Die Kuratierung von Datensätzen für präzises, zielgerichtetes Denken ist essenziell, um die Genauigkeit zu wahren.

Skalierbarkeit ist eine weitere Hürde. Während in kontrollierten Umgebungen effektiv, erfordern groß angelegte Anwendungen wie E-Commerce oder Kundensupport eine robuste Infrastruktur, um hohe Anfragevolumina ohne Leistungseinbußen zu bewältigen.

Strategien zur Bewältigung dieser Herausforderungen umfassen:

- Einführung des short-m@k Frameworks: Nutzt parallele Verarbeitung und frühe Beendigung für ausgewogene Geschwindigkeit und Genauigkeit in Echtzeitanwendungen.

- Fokus auf präzises Denken im Training: Verwendung von Methoden, die kürzere Ketten betonen, um Ressourcen und Geschwindigkeit zu optimieren.

- Überwachung von Denkmetriken: Echtzeitüberwachung von Kettlänge und Modellleistung für fortlaufende Effizienz und Genauigkeit.

Diese Strategien ermöglichen Entwicklern, kürzere Denkketten einzuführen und schnellere, präzisere und skalierbare KI-Systeme zu schaffen, die Betriebs- und Kosteneffizienzziele erfüllen.

Das Fazit

Die Forschung zu präzisen Denkketten definiert die KI-Entwicklung neu. Kürzere Ketten verbessern Geschwindigkeit, Genauigkeit und Kosteneffizienz, was für Branchen entscheidend ist, die Leistung priorisieren.

Durch die Einführung präzisen Denkens verbessern sich KI-Systeme ohne zusätzliche Ressourcen, was eine effiziente Entwicklung und Bereitstellung ermöglicht. Dieser Ansatz positioniert KI, um vielfältige Anforderungen zu erfüllen, und hält Entwickler und Unternehmen in einer sich schnell entwickelnden Technologielandschaft wettbewerbsfähig.

Verwandter Artikel

Magi-1 Enthüllt: Bahnbrechende AI-Videogenerierungstechnologie

Entdecken Sie unsere detaillierte Analyse von Magi-1, einer innovativen AI-Plattform, die die autoregressive Videoproduktion revolutioniert. Dieser Artikel beleuchtet ihre einzigartigen Funktionen, Pr

Magi-1 Enthüllt: Bahnbrechende AI-Videogenerierungstechnologie

Entdecken Sie unsere detaillierte Analyse von Magi-1, einer innovativen AI-Plattform, die die autoregressive Videoproduktion revolutioniert. Dieser Artikel beleuchtet ihre einzigartigen Funktionen, Pr

AI-gestütztes Grafikdesign: Top-Tools und Techniken für 2025

Im Jahr 2025 verändert künstliche Intelligenz (KI) Industrien, wobei das Grafikdesign an vorderster Front dieser Transformation steht. KI-Tools befähigen Designer, indem sie Kreativität fördern, Arbei

AI-gestütztes Grafikdesign: Top-Tools und Techniken für 2025

Im Jahr 2025 verändert künstliche Intelligenz (KI) Industrien, wobei das Grafikdesign an vorderster Front dieser Transformation steht. KI-Tools befähigen Designer, indem sie Kreativität fördern, Arbei

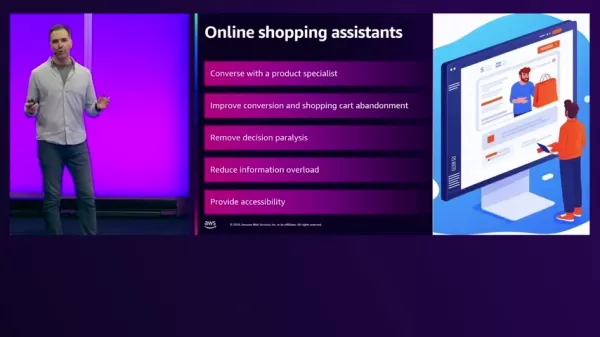

KI-gesteuerte Einkaufsassistenten revolutionieren den E-Commerce auf AWS

Im heutigen schnelllebigen E-Commerce-Umfeld streben Händler danach, Kundenerlebnisse zu verbessern und Umsätze zu steigern. Generative KI bietet innovative Lösungen, indem sie intelligente Einkaufsas

Kommentare (0)

0/200

KI-gesteuerte Einkaufsassistenten revolutionieren den E-Commerce auf AWS

Im heutigen schnelllebigen E-Commerce-Umfeld streben Händler danach, Kundenerlebnisse zu verbessern und Umsätze zu steigern. Generative KI bietet innovative Lösungen, indem sie intelligente Einkaufsas

Kommentare (0)

0/200

Große Sprachmodelle (LLMs) haben die Künstliche Intelligenz (AI) revolutioniert, indem sie menschenähnliche Texte erstellen und komplexe Herausforderungen in verschiedenen Branchen bewältigen. Früher gingen Experten davon aus, dass längere Denkketten die Genauigkeit verbessern, wobei mehr Schritte zuverlässigere Ergebnisse liefern.

Eine Studie von 2025 des FAIR-Teams von Meta und der Hebräischen Universität Jerusalem stellt diese Annahme infrage. Sie zeigt, dass kürzere Denkketten die Genauigkeit von LLMs um bis zu 34,5 % steigern und gleichzeitig die Rechenkosten um 40 % senken können. Präzises Denken beschleunigt die Verarbeitung und verspricht, das Training, die Bereitstellung und die Skalierbarkeit von LLMs neu zu gestalten.

Warum präzises Denken die Effizienz von KI steigert

Traditionell wurde angenommen, dass längere Denkketten die KI-Ergebnisse verbessern, indem sie mehr Daten verarbeiten. Die Logik war einfach: Mehr Schritte bedeuteten tiefere Analysen und höhere Genauigkeit. Folglich priorisierten KI-Systeme ausgedehnte Denkprozesse, um die Leistung zu steigern.

Dieser Ansatz hat jedoch Nachteile. Längere Ketten erfordern erhebliche Rechenleistung, verlangsamen die Verarbeitung und erhöhen die Kosten, insbesondere in Echtzeitanwendungen, die schnelle Antworten erfordern. Zudem erhöhen komplexe Ketten das Fehlerrisiko, was die Effizienz und Skalierbarkeit in Branchen beeinträchtigt, die sowohl Geschwindigkeit als auch Präzision benötigen.

Die von Meta geleitete Studie zeigt diese Schwächen auf und belegt, dass kürzere Denkketten die Genauigkeit verbessern und gleichzeitig den Rechenaufwand senken. Dies ermöglicht eine schnellere Aufgabenverarbeitung ohne Einbußen bei der Zuverlässigkeit.

Diese Erkenntnisse verlagern den Fokus der KI-Entwicklung von der Maximierung der Denkschritte hin zur Prozessoptimierung. Kürzere Ketten verbessern die Effizienz, liefern zuverlässige Ergebnisse und reduzieren die Verarbeitungszeit.

Optimierung des Denkens mit dem short-m@k Framework

Die Studie stellt das short-m@k Inferenz-Framework vor, das entwickelt wurde, um mehrstufiges Denken in LLMs zu optimieren. Im Gegensatz zu traditionellen sequenziellen oder Mehrheitsabstimmungs-Methoden nutzt es parallele Verarbeitung und frühe Beendigung, um die Effizienz zu steigern und Kosten zu senken.

Im short-m@k Ansatz laufen k parallele Denkketten gleichzeitig und stoppen, sobald die ersten m Ketten abgeschlossen sind. Die endgültige Vorhersage basiert auf einer Mehrheitsabstimmung dieser frühen Ergebnisse, wodurch unnötige Berechnungen minimiert und die Genauigkeit erhalten bleibt.

Das Framework bietet zwei Varianten:

short-1@k: Wählt die erste abgeschlossene Kette aus k parallelen Versuchen, ideal für ressourcenarme, latenzempfindliche Umgebungen, die hohe Genauigkeit bei minimalem Rechenaufwand liefern.

short-3@k: Kombiniert die Ergebnisse der ersten drei abgeschlossenen Ketten, übertrifft traditionelle Methoden in Genauigkeit und Durchsatz und eignet sich für leistungsstarke, groß angelegte Umgebungen.

Das short-m@k Framework verbessert auch das Modell-Fine-Tuning. Training mit präzisen Denksequenzen beschleunigt die Konvergenz und steigert die Präzision und Ressourceneffizienz während Training und Bereitstellung.

Auswirkungen auf KI-Entwicklung und industrielle Anwendung

Kürzere Denkketten beeinflussen die Entwicklung, Bereitstellung und Nachhaltigkeit von KI-Modellen erheblich.

Im Training reduzieren präzise Ketten die Rechenkomplexität, senken Kosten und beschleunigen Updates ohne zusätzliche Infrastruktur.

Für die Bereitstellung, insbesondere in zeitkritischen Anwendungen wie Chatbots oder Handelsplattformen, verbessern kürzere Ketten die Verarbeitungsgeschwindigkeit, sodass Systeme mehr Anfragen effizient verarbeiten und unter hoher Nachfrage effektiv skalieren können.

Energiesparsamkeit ist ein weiterer Vorteil. Weniger Berechnungen während Training und Inferenz reduzieren den Energieverbrauch, senken Kosten und unterstützen Umweltziele, da Rechenzentren mit wachsendem Energiebedarf konfrontiert sind.

Insgesamt beschleunigen diese Effizienzen die KI-Entwicklung, ermöglichen eine schnellere Markteinführung von KI-Lösungen und helfen Organisationen, in einer dynamischen Technologielandschaft wettbewerbsfähig zu bleiben.

Herausforderungen bei der Einführung präzisen Denkens

Obwohl kürzere Denkketten klare Vorteile bieten, stellt die Umsetzung Herausforderungen dar.

Traditionelle KI-Systeme, die für längeres Denken ausgelegt sind, erfordern eine Überarbeitung der Modellarchitekturen, Trainingsmethoden und Optimierungsstrategien, was technisches Fachwissen und organisatorische Anpassungsfähigkeit erfordert.

Die Datenqualität und -struktur sind entscheidend. Modelle, die auf Datensätze für ausgedehntes Denken trainiert wurden, könnten bei kürzeren Pfaden scheitern. Die Kuratierung von Datensätzen für präzises, zielgerichtetes Denken ist essenziell, um die Genauigkeit zu wahren.

Skalierbarkeit ist eine weitere Hürde. Während in kontrollierten Umgebungen effektiv, erfordern groß angelegte Anwendungen wie E-Commerce oder Kundensupport eine robuste Infrastruktur, um hohe Anfragevolumina ohne Leistungseinbußen zu bewältigen.

Strategien zur Bewältigung dieser Herausforderungen umfassen:

- Einführung des short-m@k Frameworks: Nutzt parallele Verarbeitung und frühe Beendigung für ausgewogene Geschwindigkeit und Genauigkeit in Echtzeitanwendungen.

- Fokus auf präzises Denken im Training: Verwendung von Methoden, die kürzere Ketten betonen, um Ressourcen und Geschwindigkeit zu optimieren.

- Überwachung von Denkmetriken: Echtzeitüberwachung von Kettlänge und Modellleistung für fortlaufende Effizienz und Genauigkeit.

Diese Strategien ermöglichen Entwicklern, kürzere Denkketten einzuführen und schnellere, präzisere und skalierbare KI-Systeme zu schaffen, die Betriebs- und Kosteneffizienzziele erfüllen.

Das Fazit

Die Forschung zu präzisen Denkketten definiert die KI-Entwicklung neu. Kürzere Ketten verbessern Geschwindigkeit, Genauigkeit und Kosteneffizienz, was für Branchen entscheidend ist, die Leistung priorisieren.

Durch die Einführung präzisen Denkens verbessern sich KI-Systeme ohne zusätzliche Ressourcen, was eine effiziente Entwicklung und Bereitstellung ermöglicht. Dieser Ansatz positioniert KI, um vielfältige Anforderungen zu erfüllen, und hält Entwickler und Unternehmen in einer sich schnell entwickelnden Technologielandschaft wettbewerbsfähig.

Magi-1 Enthüllt: Bahnbrechende AI-Videogenerierungstechnologie

Entdecken Sie unsere detaillierte Analyse von Magi-1, einer innovativen AI-Plattform, die die autoregressive Videoproduktion revolutioniert. Dieser Artikel beleuchtet ihre einzigartigen Funktionen, Pr

Magi-1 Enthüllt: Bahnbrechende AI-Videogenerierungstechnologie

Entdecken Sie unsere detaillierte Analyse von Magi-1, einer innovativen AI-Plattform, die die autoregressive Videoproduktion revolutioniert. Dieser Artikel beleuchtet ihre einzigartigen Funktionen, Pr

AI-gestütztes Grafikdesign: Top-Tools und Techniken für 2025

Im Jahr 2025 verändert künstliche Intelligenz (KI) Industrien, wobei das Grafikdesign an vorderster Front dieser Transformation steht. KI-Tools befähigen Designer, indem sie Kreativität fördern, Arbei

AI-gestütztes Grafikdesign: Top-Tools und Techniken für 2025

Im Jahr 2025 verändert künstliche Intelligenz (KI) Industrien, wobei das Grafikdesign an vorderster Front dieser Transformation steht. KI-Tools befähigen Designer, indem sie Kreativität fördern, Arbei

KI-gesteuerte Einkaufsassistenten revolutionieren den E-Commerce auf AWS

Im heutigen schnelllebigen E-Commerce-Umfeld streben Händler danach, Kundenerlebnisse zu verbessern und Umsätze zu steigern. Generative KI bietet innovative Lösungen, indem sie intelligente Einkaufsas

KI-gesteuerte Einkaufsassistenten revolutionieren den E-Commerce auf AWS

Im heutigen schnelllebigen E-Commerce-Umfeld streben Händler danach, Kundenerlebnisse zu verbessern und Umsätze zu steigern. Generative KI bietet innovative Lösungen, indem sie intelligente Einkaufsas