Повышение производительности ИИ с помощью лаконичного рассуждения в больших языковых моделях

Большие языковые модели (LLMs) произвели революцию в искусственном интеллекте (AI), создавая текст, похожий на человеческий, и решая сложные задачи в различных отраслях. Ранее эксперты предполагали, что длинные цепочки рассуждений повышают точность, а большее количество шагов обеспечивает надежные результаты.

Исследование 2025 года, проведенное командой FAIR от Meta и Еврейским университетом в Иерусалиме, опровергает это мнение. Оно показывает, что более короткие цепочки рассуждений могут повысить точность LLM до 34,5%, одновременно снижая вычислительные затраты на 40%. Лаконичное рассуждение ускоряет обработку, обещая изменить подходы к обучению, развертыванию и масштабированию LLM.

Почему лаконичное рассуждение повышает эффективность ИИ

Традиционно считалось, что более длинные цепочки рассуждений улучшают результаты ИИ за счет обработки большего объема данных. Логика была проста: больше шагов означало более глубокий анализ, что повышало точность. В результате системы ИИ отдавали предпочтение длинным рассуждениям для улучшения производительности.

Однако у этого подхода есть недостатки. Более длинные цепочки требуют значительных вычислительных ресурсов, замедляя обработку и увеличивая затраты, особенно в приложениях реального времени, требующих быстрых ответов. Кроме того, сложные цепочки повышают риск ошибок, снижая эффективность и масштабируемость в отраслях, где важны скорость и точность.

Исследование под руководством Meta выявило эти недостатки, показав, что более короткие цепочки рассуждений повышают точность при снижении вычислительных затрат. Это позволяет быстрее обрабатывать задачи без потери надежности.

Эти выводы смещают акцент в разработке ИИ с максимального увеличения шагов рассуждений на оптимизацию процессов. Более короткие цепочки повышают эффективность, обеспечивают надежные результаты и сокращают время обработки.

Оптимизация рассуждений с помощью фреймворка short-m@k

Исследование представляет фреймворк short-m@k, разработанный для упрощения многоступенчатых рассуждений в LLM. В отличие от традиционных последовательных методов или методов большинства голосов, он использует параллельную обработку и раннее завершение для повышения эффективности и сокращения затрат.

В подходе short-m@k k параллельных цепочек рассуждений выполняются одновременно, останавливаясь, как только завершаются первые m цепочек. Итоговое предсказание основывается на большинстве голосов из этих ранних результатов, минимизируя ненужные вычисления при сохранении точности.

Фреймворк предлагает два варианта:

short-1@k: Выбирает первую завершенную цепочку из k параллельных попыток, идеально подходит для низкоресурсных и чувствительных к задержкам настроек, обеспечивая высокую точность при минимальных вычислительных затратах.

short-3@k: Комбинирует результаты первых трех завершенных цепочек, превосходя традиционные методы по точности и пропускной способности, подходит для высокопроизводительных и крупномасштабных сред.

Фреймворк short-m@k также улучшает тонкую настройку моделей. Обучение с использованием лаконичных последовательностей рассуждений ускоряет сходимость, повышая точность выводов и эффективность ресурсов во время обучения и развертывания.

Влияние на разработку ИИ и промышленное использование

Более короткие цепочки рассуждений существенно влияют на разработку, развертывание и устойчивость моделей ИИ.

В процессе обучения лаконичные цепочки снижают вычислительную сложность, уменьшая затраты и ускоряя обновления без необходимости дополнительной инфраструктуры.

Для развертывания, особенно в чувствительных ко времени приложениях, таких как чат-боты или торговые платформы, более короткие цепочки повышают скорость обработки, позволяя системам эффективно обрабатывать больше запросов и масштабироваться при высоком спросе.

Энергоэффективность — еще одно преимущество. Меньшее количество вычислений во время обучения и выводов снижает энергопотребление, сокращая затраты и поддерживая экологические цели, поскольку центры обработки данных сталкиваются с растущими энергетическими потребностями.

В целом, эти улучшения ускоряют разработку ИИ, позволяя быстрее выводить решения на рынок, помогая организациям оставаться конкурентоспособными в динамичной технологической среде.

Решение проблем при внедрении лаконичного рассуждения

Хотя более короткие цепочки рассуждений дают очевидные преимущества, их внедрение связано с проблемами.

Традиционные системы ИИ, созданные для длинных рассуждений, требуют переработки архитектур моделей, методов обучения и стратегий оптимизации, что требует технической экспертизы и адаптивности организаций.

Качество и структура данных имеют решающее значение. Модели, обученные на наборах данных для длинных рассуждений, могут давать сбои при использовании коротких путей. Создание наборов данных для лаконичных и целенаправленных рассуждений необходимо для поддержания точности.

Масштабируемость — еще одно препятствие. Хотя подход эффективен в контролируемых условиях, крупномасштабные приложения, такие как электронная коммерция или поддержка клиентов, требуют надежной инфраструктуры для обработки больших объемов запросов без ущерба для производительности.

Стратегии решения этих проблем включают:

- Внедрение фреймворка short-m@k: Использует параллельную обработку и раннее завершение для баланса скорости и точности в приложениях реального времени.

- Акцент на лаконичное рассуждение в обучении: Использование методов, подчеркивающих более короткие цепочки для оптимизации ресурсов и скорости.

- Отслеживание метрик рассуждений: Мониторинг длины цепочек и производительности модели в реальном времени для постоянной эффективности и точности.

Эти стратегии позволяют разработчикам внедрять более короткие цепочки рассуждений, создавая более быстрые, точные и масштабируемые системы ИИ, отвечающие операционным и стоимостным целям.

Итог

Исследования лаконичных цепочек рассуждений переопределяют разработку ИИ. Более короткие цепочки повышают скорость, точность и экономическую эффективность, что критически важно для отраслей, где приоритет отдается производительности.

Внедрение лаконичного рассуждения позволяет улучшать системы ИИ без дополнительных ресурсов, обеспечивая эффективную разработку и развертывание. Этот подход позиционирует ИИ для удовлетворения разнообразных потребностей, сохраняя конкурентоспособность разработчиков и компаний в быстро развивающейся технологической среде.

Связанная статья

AI-управляемый графический дизайн: Лучшие инструменты и техники для 2025 года

В 2025 году искусственный интеллект (ИИ) перестраивает отрасли, с графическим дизайном в авангарде этой трансформации. Инструменты ИИ наделяют дизайнеров силой, повышая креативность, оптимизируя рабоч

AI-управляемый графический дизайн: Лучшие инструменты и техники для 2025 года

В 2025 году искусственный интеллект (ИИ) перестраивает отрасли, с графическим дизайном в авангарде этой трансформации. Инструменты ИИ наделяют дизайнеров силой, повышая креативность, оптимизируя рабоч

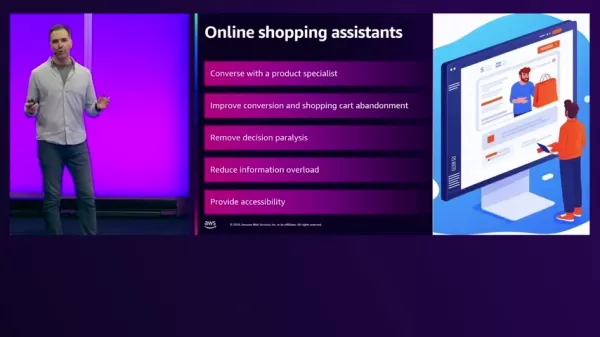

Искры, Питаемые Искусственным Интеллектом, Преобразуют Электронную Коммерцию на AWS

В современном быстро меняющемся мире электронной коммерции ритейлеры стремятся улучшить клиентский опыт и увеличить продажи. Генеративный искусственный интеллект предлагает инновационные решения, подд

Искры, Питаемые Искусственным Интеллектом, Преобразуют Электронную Коммерцию на AWS

В современном быстро меняющемся мире электронной коммерции ритейлеры стремятся улучшить клиентский опыт и увеличить продажи. Генеративный искусственный интеллект предлагает инновационные решения, подд

Bing AI против ChatGPT: Подробное сравнение и бесплатное руководство по созданию эскизов

В быстро развивающейся сфере искусственного интеллекта Bing AI и ChatGPT выделяются как ведущие конкуренты. Оба являются мощными инструментами для генерации текста, ответа на запросы и поддержки разли

Комментарии (0)

Bing AI против ChatGPT: Подробное сравнение и бесплатное руководство по созданию эскизов

В быстро развивающейся сфере искусственного интеллекта Bing AI и ChatGPT выделяются как ведущие конкуренты. Оба являются мощными инструментами для генерации текста, ответа на запросы и поддержки разли

Комментарии (0)

Большие языковые модели (LLMs) произвели революцию в искусственном интеллекте (AI), создавая текст, похожий на человеческий, и решая сложные задачи в различных отраслях. Ранее эксперты предполагали, что длинные цепочки рассуждений повышают точность, а большее количество шагов обеспечивает надежные результаты.

Исследование 2025 года, проведенное командой FAIR от Meta и Еврейским университетом в Иерусалиме, опровергает это мнение. Оно показывает, что более короткие цепочки рассуждений могут повысить точность LLM до 34,5%, одновременно снижая вычислительные затраты на 40%. Лаконичное рассуждение ускоряет обработку, обещая изменить подходы к обучению, развертыванию и масштабированию LLM.

Почему лаконичное рассуждение повышает эффективность ИИ

Традиционно считалось, что более длинные цепочки рассуждений улучшают результаты ИИ за счет обработки большего объема данных. Логика была проста: больше шагов означало более глубокий анализ, что повышало точность. В результате системы ИИ отдавали предпочтение длинным рассуждениям для улучшения производительности.

Однако у этого подхода есть недостатки. Более длинные цепочки требуют значительных вычислительных ресурсов, замедляя обработку и увеличивая затраты, особенно в приложениях реального времени, требующих быстрых ответов. Кроме того, сложные цепочки повышают риск ошибок, снижая эффективность и масштабируемость в отраслях, где важны скорость и точность.

Исследование под руководством Meta выявило эти недостатки, показав, что более короткие цепочки рассуждений повышают точность при снижении вычислительных затрат. Это позволяет быстрее обрабатывать задачи без потери надежности.

Эти выводы смещают акцент в разработке ИИ с максимального увеличения шагов рассуждений на оптимизацию процессов. Более короткие цепочки повышают эффективность, обеспечивают надежные результаты и сокращают время обработки.

Оптимизация рассуждений с помощью фреймворка short-m@k

Исследование представляет фреймворк short-m@k, разработанный для упрощения многоступенчатых рассуждений в LLM. В отличие от традиционных последовательных методов или методов большинства голосов, он использует параллельную обработку и раннее завершение для повышения эффективности и сокращения затрат.

В подходе short-m@k k параллельных цепочек рассуждений выполняются одновременно, останавливаясь, как только завершаются первые m цепочек. Итоговое предсказание основывается на большинстве голосов из этих ранних результатов, минимизируя ненужные вычисления при сохранении точности.

Фреймворк предлагает два варианта:

short-1@k: Выбирает первую завершенную цепочку из k параллельных попыток, идеально подходит для низкоресурсных и чувствительных к задержкам настроек, обеспечивая высокую точность при минимальных вычислительных затратах.

short-3@k: Комбинирует результаты первых трех завершенных цепочек, превосходя традиционные методы по точности и пропускной способности, подходит для высокопроизводительных и крупномасштабных сред.

Фреймворк short-m@k также улучшает тонкую настройку моделей. Обучение с использованием лаконичных последовательностей рассуждений ускоряет сходимость, повышая точность выводов и эффективность ресурсов во время обучения и развертывания.

Влияние на разработку ИИ и промышленное использование

Более короткие цепочки рассуждений существенно влияют на разработку, развертывание и устойчивость моделей ИИ.

В процессе обучения лаконичные цепочки снижают вычислительную сложность, уменьшая затраты и ускоряя обновления без необходимости дополнительной инфраструктуры.

Для развертывания, особенно в чувствительных ко времени приложениях, таких как чат-боты или торговые платформы, более короткие цепочки повышают скорость обработки, позволяя системам эффективно обрабатывать больше запросов и масштабироваться при высоком спросе.

Энергоэффективность — еще одно преимущество. Меньшее количество вычислений во время обучения и выводов снижает энергопотребление, сокращая затраты и поддерживая экологические цели, поскольку центры обработки данных сталкиваются с растущими энергетическими потребностями.

В целом, эти улучшения ускоряют разработку ИИ, позволяя быстрее выводить решения на рынок, помогая организациям оставаться конкурентоспособными в динамичной технологической среде.

Решение проблем при внедрении лаконичного рассуждения

Хотя более короткие цепочки рассуждений дают очевидные преимущества, их внедрение связано с проблемами.

Традиционные системы ИИ, созданные для длинных рассуждений, требуют переработки архитектур моделей, методов обучения и стратегий оптимизации, что требует технической экспертизы и адаптивности организаций.

Качество и структура данных имеют решающее значение. Модели, обученные на наборах данных для длинных рассуждений, могут давать сбои при использовании коротких путей. Создание наборов данных для лаконичных и целенаправленных рассуждений необходимо для поддержания точности.

Масштабируемость — еще одно препятствие. Хотя подход эффективен в контролируемых условиях, крупномасштабные приложения, такие как электронная коммерция или поддержка клиентов, требуют надежной инфраструктуры для обработки больших объемов запросов без ущерба для производительности.

Стратегии решения этих проблем включают:

- Внедрение фреймворка short-m@k: Использует параллельную обработку и раннее завершение для баланса скорости и точности в приложениях реального времени.

- Акцент на лаконичное рассуждение в обучении: Использование методов, подчеркивающих более короткие цепочки для оптимизации ресурсов и скорости.

- Отслеживание метрик рассуждений: Мониторинг длины цепочек и производительности модели в реальном времени для постоянной эффективности и точности.

Эти стратегии позволяют разработчикам внедрять более короткие цепочки рассуждений, создавая более быстрые, точные и масштабируемые системы ИИ, отвечающие операционным и стоимостным целям.

Итог

Исследования лаконичных цепочек рассуждений переопределяют разработку ИИ. Более короткие цепочки повышают скорость, точность и экономическую эффективность, что критически важно для отраслей, где приоритет отдается производительности.

Внедрение лаконичного рассуждения позволяет улучшать системы ИИ без дополнительных ресурсов, обеспечивая эффективную разработку и развертывание. Этот подход позиционирует ИИ для удовлетворения разнообразных потребностей, сохраняя конкурентоспособность разработчиков и компаний в быстро развивающейся технологической среде.

AI-управляемый графический дизайн: Лучшие инструменты и техники для 2025 года

В 2025 году искусственный интеллект (ИИ) перестраивает отрасли, с графическим дизайном в авангарде этой трансформации. Инструменты ИИ наделяют дизайнеров силой, повышая креативность, оптимизируя рабоч

AI-управляемый графический дизайн: Лучшие инструменты и техники для 2025 года

В 2025 году искусственный интеллект (ИИ) перестраивает отрасли, с графическим дизайном в авангарде этой трансформации. Инструменты ИИ наделяют дизайнеров силой, повышая креативность, оптимизируя рабоч

Искры, Питаемые Искусственным Интеллектом, Преобразуют Электронную Коммерцию на AWS

В современном быстро меняющемся мире электронной коммерции ритейлеры стремятся улучшить клиентский опыт и увеличить продажи. Генеративный искусственный интеллект предлагает инновационные решения, подд

Искры, Питаемые Искусственным Интеллектом, Преобразуют Электронную Коммерцию на AWS

В современном быстро меняющемся мире электронной коммерции ритейлеры стремятся улучшить клиентский опыт и увеличить продажи. Генеративный искусственный интеллект предлагает инновационные решения, подд

Bing AI против ChatGPT: Подробное сравнение и бесплатное руководство по созданию эскизов

В быстро развивающейся сфере искусственного интеллекта Bing AI и ChatGPT выделяются как ведущие конкуренты. Оба являются мощными инструментами для генерации текста, ответа на запросы и поддержки разли

Bing AI против ChatGPT: Подробное сравнение и бесплатное руководство по созданию эскизов

В быстро развивающейся сфере искусственного интеллекта Bing AI и ChatGPT выделяются как ведущие конкуренты. Оба являются мощными инструментами для генерации текста, ответа на запросы и поддержки разли