Impulsando el rendimiento de la IA con razonamiento conciso en modelos de lenguaje grandes

Los Modelos de Lenguaje Grandes (LLMs) han revolucionado la Inteligencia Artificial (IA), generando texto similar al humano y abordando desafíos complejos en diversas industrias. Anteriormente, los expertos asumían que cadenas de razonamiento extensas mejoraban la precisión, con más pasos generando resultados confiables.

Un estudio de 2025 del equipo FAIR de Meta y la Universidad Hebrea de Jerusalén desafía esta idea. Revela que cadenas de razonamiento más cortas pueden aumentar la precisión de los LLMs hasta un 34.5% mientras reducen los costos computacionales en un 40%. El razonamiento conciso acelera el procesamiento, prometiendo transformar el entrenamiento, despliegue y escalabilidad de los LLMs.

Por qué el razonamiento conciso mejora la eficiencia de la IA

Tradicionalmente, se pensaba que cadenas de razonamiento más largas mejoraban los resultados de la IA al procesar más datos. La lógica era simple: más pasos implicaban un análisis más profundo, aumentando la precisión. En consecuencia, los sistemas de IA priorizaban el razonamiento extenso para mejorar el rendimiento.

Sin embargo, este enfoque tiene desventajas. Las cadenas largas requieren un poder computacional significativo, lo que ralentiza el procesamiento y aumenta los costos, especialmente en aplicaciones en tiempo real que necesitan respuestas rápidas. Además, las cadenas complejas incrementan el riesgo de errores, reduciendo la eficiencia y escalabilidad en industrias que requieren velocidad y precisión.

El estudio liderado por Meta destaca estas fallas, mostrando que cadenas de razonamiento más cortas mejoran la precisión mientras reducen las demandas computacionales. Esto permite un procesamiento de tareas más rápido sin sacrificar confiabilidad.

Estas ideas cambian el enfoque del desarrollo de IA de maximizar los pasos de razonamiento a optimizar procesos. Las cadenas cortas mejoran la eficiencia, ofrecen resultados confiables y reducen el tiempo de procesamiento.

Optimizando el razonamiento con el marco short-m@k

El estudio presenta el marco de inferencia short-m@k, diseñado para agilizar el razonamiento de múltiples pasos en LLMs. A diferencia de los métodos tradicionales secuenciales o de votación mayoritaria, utiliza procesamiento paralelo y terminación temprana para aumentar la eficiencia y reducir costos.

En el enfoque short-m@k, k cadenas de razonamiento paralelas se ejecutan simultáneamente, deteniéndose una vez que las primeras m cadenas finalizan. La predicción final utiliza votación mayoritaria de estos resultados tempranos, minimizando cálculos innecesarios mientras se preserva la precisión.

El marco ofrece dos variantes:

short-1@k: Selecciona la primera cadena completada de k intentos paralelos, ideal para entornos sensibles a la latencia con recursos limitados, ofreciendo alta precisión con un costo computacional mínimo.

short-3@k: Combina resultados de las tres primeras cadenas completadas, superando los métodos tradicionales en precisión y rendimiento, adecuado para entornos de alto rendimiento y gran escala.

El marco short-m@k también mejora el ajuste fino del modelo. Entrenar con secuencias de razonamiento concisas acelera la convergencia, mejorando la precisión de inferencia y la eficiencia de recursos durante el entrenamiento y el despliegue.

Impacto en el desarrollo de IA y su uso en la industria

Las cadenas de razonamiento más cortas influyen significativamente en el desarrollo, despliegue y sostenibilidad de modelos de IA.

En el entrenamiento, las cadenas concisas reducen la complejidad computacional, disminuyendo costos y acelerando actualizaciones sin necesidad de infraestructura adicional.

Para el despliegue, especialmente en aplicaciones sensibles al tiempo como chatbots o plataformas de trading, las cadenas cortas mejoran la velocidad de procesamiento, permitiendo a los sistemas manejar más solicitudes de manera eficiente y escalar efectivamente bajo alta demanda.

La eficiencia energética es otra ventaja. Menos cálculos durante el entrenamiento e inferencia reducen el consumo de energía, disminuyendo costos y apoyando objetivos ambientales a medida que los centros de datos enfrentan crecientes demandas energéticas.

En general, estas eficiencias aceleran el desarrollo de IA, permitiendo una entrega al mercado más rápida de soluciones de IA, ayudando a las organizaciones a mantenerse competitivas en un panorama tecnológico dinámico.

Abordando desafíos en la adopción del razonamiento conciso

Aunque las cadenas de razonamiento más cortas ofrecen beneficios claros, su implementación presenta desafíos.

Los sistemas de IA tradicionales, diseñados para razonamiento largo, requieren reestructurar arquitecturas de modelos, métodos de entrenamiento y estrategias de optimización, exigiendo experiencia técnica y adaptabilidad organizacional.

La calidad y estructura de los datos son críticas. Los modelos entrenados en conjuntos de datos para razonamiento extenso pueden fallar con caminos más cortos. Es esencial curar conjuntos de datos para un razonamiento conciso y específico para mantener la precisión.

La escalabilidad es otro obstáculo. Aunque efectivas en entornos controlados, las aplicaciones a gran escala, como el comercio electrónico o el soporte al cliente, requieren una infraestructura robusta para manejar grandes volúmenes de solicitudes sin comprometer el rendimiento.

Estrategias para abordar estos desafíos incluyen:

- Implementar el marco short-m@k: Aprovecha el procesamiento paralelo y la terminación temprana para equilibrar velocidad y precisión en aplicaciones en tiempo real.

- Enfocarse en el razonamiento conciso en el entrenamiento: Usar métodos que prioricen cadenas cortas para optimizar recursos y velocidad.

- Monitorear métricas de razonamiento: Supervisar la longitud de las cadenas y el rendimiento del modelo en tiempo real para mantener la eficiencia y precisión.

Estas estrategias permiten a los desarrolladores adoptar cadenas de razonamiento más cortas, creando sistemas de IA más rápidos, precisos y escalables que cumplen con los objetivos operativos y de eficiencia de costos.

La conclusión

La investigación sobre cadenas de razonamiento concisas redefine el desarrollo de IA. Las cadenas cortas mejoran la velocidad, precisión y eficiencia de costos, críticas para industrias que priorizan el rendimiento.

Al adoptar el razonamiento conciso, los sistemas de IA mejoran sin recursos adicionales, permitiendo un desarrollo y despliegue eficientes. Este enfoque posiciona a la IA para satisfacer diversas necesidades, manteniendo a desarrolladores y empresas competitivos en un panorama tecnológico en rápida evolución.

Artículo relacionado

Magi-1 Revelado: Tecnología Pionera de Generación de Video por IA

Explora nuestro análisis detallado de Magi-1, una plataforma de IA innovadora que revoluciona la creación de videos autorregresivos. Este artículo profundiza en sus características únicas, estructura

Magi-1 Revelado: Tecnología Pionera de Generación de Video por IA

Explora nuestro análisis detallado de Magi-1, una plataforma de IA innovadora que revoluciona la creación de videos autorregresivos. Este artículo profundiza en sus características únicas, estructura

Diseño Gráfico Potenciado por IA: Las Mejores Herramientas y Técnicas para 2025

En 2025, la inteligencia artificial (IA) está transformando industrias, con el diseño gráfico a la vanguardia de esta revolución. Las herramientas de IA están empoderando a los diseñadores al impulsar

Diseño Gráfico Potenciado por IA: Las Mejores Herramientas y Técnicas para 2025

En 2025, la inteligencia artificial (IA) está transformando industrias, con el diseño gráfico a la vanguardia de esta revolución. Las herramientas de IA están empoderando a los diseñadores al impulsar

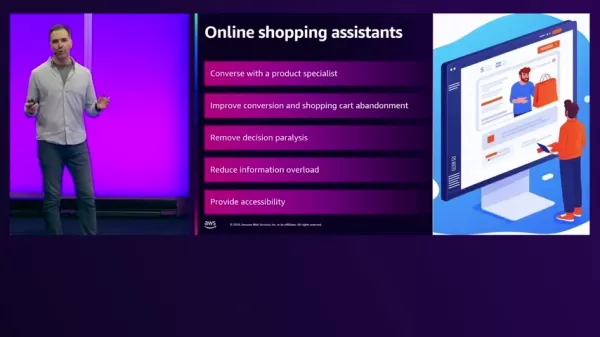

Asistentes de Compras Impulsados por IA Transforman el Comercio Electrónico en AWS

En el entorno acelerado del comercio electrónico actual, los minoristas buscan mejorar las experiencias de los clientes y aumentar las ventas. La IA generativa ofrece soluciones innovadoras al potenci

comentario (0)

0/200

Asistentes de Compras Impulsados por IA Transforman el Comercio Electrónico en AWS

En el entorno acelerado del comercio electrónico actual, los minoristas buscan mejorar las experiencias de los clientes y aumentar las ventas. La IA generativa ofrece soluciones innovadoras al potenci

comentario (0)

0/200

Los Modelos de Lenguaje Grandes (LLMs) han revolucionado la Inteligencia Artificial (IA), generando texto similar al humano y abordando desafíos complejos en diversas industrias. Anteriormente, los expertos asumían que cadenas de razonamiento extensas mejoraban la precisión, con más pasos generando resultados confiables.

Un estudio de 2025 del equipo FAIR de Meta y la Universidad Hebrea de Jerusalén desafía esta idea. Revela que cadenas de razonamiento más cortas pueden aumentar la precisión de los LLMs hasta un 34.5% mientras reducen los costos computacionales en un 40%. El razonamiento conciso acelera el procesamiento, prometiendo transformar el entrenamiento, despliegue y escalabilidad de los LLMs.

Por qué el razonamiento conciso mejora la eficiencia de la IA

Tradicionalmente, se pensaba que cadenas de razonamiento más largas mejoraban los resultados de la IA al procesar más datos. La lógica era simple: más pasos implicaban un análisis más profundo, aumentando la precisión. En consecuencia, los sistemas de IA priorizaban el razonamiento extenso para mejorar el rendimiento.

Sin embargo, este enfoque tiene desventajas. Las cadenas largas requieren un poder computacional significativo, lo que ralentiza el procesamiento y aumenta los costos, especialmente en aplicaciones en tiempo real que necesitan respuestas rápidas. Además, las cadenas complejas incrementan el riesgo de errores, reduciendo la eficiencia y escalabilidad en industrias que requieren velocidad y precisión.

El estudio liderado por Meta destaca estas fallas, mostrando que cadenas de razonamiento más cortas mejoran la precisión mientras reducen las demandas computacionales. Esto permite un procesamiento de tareas más rápido sin sacrificar confiabilidad.

Estas ideas cambian el enfoque del desarrollo de IA de maximizar los pasos de razonamiento a optimizar procesos. Las cadenas cortas mejoran la eficiencia, ofrecen resultados confiables y reducen el tiempo de procesamiento.

Optimizando el razonamiento con el marco short-m@k

El estudio presenta el marco de inferencia short-m@k, diseñado para agilizar el razonamiento de múltiples pasos en LLMs. A diferencia de los métodos tradicionales secuenciales o de votación mayoritaria, utiliza procesamiento paralelo y terminación temprana para aumentar la eficiencia y reducir costos.

En el enfoque short-m@k, k cadenas de razonamiento paralelas se ejecutan simultáneamente, deteniéndose una vez que las primeras m cadenas finalizan. La predicción final utiliza votación mayoritaria de estos resultados tempranos, minimizando cálculos innecesarios mientras se preserva la precisión.

El marco ofrece dos variantes:

short-1@k: Selecciona la primera cadena completada de k intentos paralelos, ideal para entornos sensibles a la latencia con recursos limitados, ofreciendo alta precisión con un costo computacional mínimo.

short-3@k: Combina resultados de las tres primeras cadenas completadas, superando los métodos tradicionales en precisión y rendimiento, adecuado para entornos de alto rendimiento y gran escala.

El marco short-m@k también mejora el ajuste fino del modelo. Entrenar con secuencias de razonamiento concisas acelera la convergencia, mejorando la precisión de inferencia y la eficiencia de recursos durante el entrenamiento y el despliegue.

Impacto en el desarrollo de IA y su uso en la industria

Las cadenas de razonamiento más cortas influyen significativamente en el desarrollo, despliegue y sostenibilidad de modelos de IA.

En el entrenamiento, las cadenas concisas reducen la complejidad computacional, disminuyendo costos y acelerando actualizaciones sin necesidad de infraestructura adicional.

Para el despliegue, especialmente en aplicaciones sensibles al tiempo como chatbots o plataformas de trading, las cadenas cortas mejoran la velocidad de procesamiento, permitiendo a los sistemas manejar más solicitudes de manera eficiente y escalar efectivamente bajo alta demanda.

La eficiencia energética es otra ventaja. Menos cálculos durante el entrenamiento e inferencia reducen el consumo de energía, disminuyendo costos y apoyando objetivos ambientales a medida que los centros de datos enfrentan crecientes demandas energéticas.

En general, estas eficiencias aceleran el desarrollo de IA, permitiendo una entrega al mercado más rápida de soluciones de IA, ayudando a las organizaciones a mantenerse competitivas en un panorama tecnológico dinámico.

Abordando desafíos en la adopción del razonamiento conciso

Aunque las cadenas de razonamiento más cortas ofrecen beneficios claros, su implementación presenta desafíos.

Los sistemas de IA tradicionales, diseñados para razonamiento largo, requieren reestructurar arquitecturas de modelos, métodos de entrenamiento y estrategias de optimización, exigiendo experiencia técnica y adaptabilidad organizacional.

La calidad y estructura de los datos son críticas. Los modelos entrenados en conjuntos de datos para razonamiento extenso pueden fallar con caminos más cortos. Es esencial curar conjuntos de datos para un razonamiento conciso y específico para mantener la precisión.

La escalabilidad es otro obstáculo. Aunque efectivas en entornos controlados, las aplicaciones a gran escala, como el comercio electrónico o el soporte al cliente, requieren una infraestructura robusta para manejar grandes volúmenes de solicitudes sin comprometer el rendimiento.

Estrategias para abordar estos desafíos incluyen:

- Implementar el marco short-m@k: Aprovecha el procesamiento paralelo y la terminación temprana para equilibrar velocidad y precisión en aplicaciones en tiempo real.

- Enfocarse en el razonamiento conciso en el entrenamiento: Usar métodos que prioricen cadenas cortas para optimizar recursos y velocidad.

- Monitorear métricas de razonamiento: Supervisar la longitud de las cadenas y el rendimiento del modelo en tiempo real para mantener la eficiencia y precisión.

Estas estrategias permiten a los desarrolladores adoptar cadenas de razonamiento más cortas, creando sistemas de IA más rápidos, precisos y escalables que cumplen con los objetivos operativos y de eficiencia de costos.

La conclusión

La investigación sobre cadenas de razonamiento concisas redefine el desarrollo de IA. Las cadenas cortas mejoran la velocidad, precisión y eficiencia de costos, críticas para industrias que priorizan el rendimiento.

Al adoptar el razonamiento conciso, los sistemas de IA mejoran sin recursos adicionales, permitiendo un desarrollo y despliegue eficientes. Este enfoque posiciona a la IA para satisfacer diversas necesidades, manteniendo a desarrolladores y empresas competitivos en un panorama tecnológico en rápida evolución.

Magi-1 Revelado: Tecnología Pionera de Generación de Video por IA

Explora nuestro análisis detallado de Magi-1, una plataforma de IA innovadora que revoluciona la creación de videos autorregresivos. Este artículo profundiza en sus características únicas, estructura

Magi-1 Revelado: Tecnología Pionera de Generación de Video por IA

Explora nuestro análisis detallado de Magi-1, una plataforma de IA innovadora que revoluciona la creación de videos autorregresivos. Este artículo profundiza en sus características únicas, estructura

Diseño Gráfico Potenciado por IA: Las Mejores Herramientas y Técnicas para 2025

En 2025, la inteligencia artificial (IA) está transformando industrias, con el diseño gráfico a la vanguardia de esta revolución. Las herramientas de IA están empoderando a los diseñadores al impulsar

Diseño Gráfico Potenciado por IA: Las Mejores Herramientas y Técnicas para 2025

En 2025, la inteligencia artificial (IA) está transformando industrias, con el diseño gráfico a la vanguardia de esta revolución. Las herramientas de IA están empoderando a los diseñadores al impulsar

Asistentes de Compras Impulsados por IA Transforman el Comercio Electrónico en AWS

En el entorno acelerado del comercio electrónico actual, los minoristas buscan mejorar las experiencias de los clientes y aumentar las ventas. La IA generativa ofrece soluciones innovadoras al potenci

Asistentes de Compras Impulsados por IA Transforman el Comercio Electrónico en AWS

En el entorno acelerado del comercio electrónico actual, los minoristas buscan mejorar las experiencias de los clientes y aumentar las ventas. La IA generativa ofrece soluciones innovadoras al potenci