使用簡潔推理提升AI性能在大語言模型中

大語言模型(LLMs)已革新人工智慧(AI),產生類似人類的文本並應對各行業的複雜挑戰。此前,專家認為延長推理鏈能提高準確性,更多步驟帶來可靠結果。

2025年由Meta的FAIR團隊與耶路撒冷希伯來大學進行的研究挑戰此觀念。研究顯示,較短的推理鏈可將LLM準確性提升高達34.5%,同時降低40%的計算成本。簡潔推理加速處理速度,有望重塑LLM的訓練、部署與可擴展性。

為何簡潔推理提升AI效率

傳統上,較長的推理鏈被認為通過處理更多數據來改善AI結果。邏輯簡單:更多步驟意味著更深入的分析,提升準確性。因此,AI系統優先採用延長推理以增強性能。

然而,此方法有其缺點。較長的推理鏈需要大量計算能力,減慢處理速度並增加成本,特別是在需要快速回應的實時應用中。此外,複雜的推理鏈增加錯誤風險,降低效率與可擴展性,特別在需要速度與精度的行業中。

Meta主導的研究揭示這些缺陷,顯示較短的推理鏈可提高準確性同時降低計算需求。這使得任務處理更快且不犧牲可靠性。

這些見解將AI發展的重點從最大化推理步驟轉向優化流程。較短的推理鏈提升效率,提供可靠結果並減少處理時間。

使用short-m@k框架優化推理

該研究介紹了short-m@k推理框架,旨在簡化LLM中的多步推理。與傳統的順序或多數投票方法不同,它使用並行處理與早期終止來提升效率並降低成本。

在short-m@k方法中,k個並行推理鏈同時運行,一旦前m個鏈完成即停止。最終預測使用這些早期結果的多數投票,最大限度減少不必要的計算,同時保持準確性。

該框架提供兩種變體:

short-1@k: 從k個並行嘗試中選擇第一個完成的鏈,適用於低資源、延遲敏感的環境,以最小的計算成本提供高準確性。

short-3@k: 結合前三個完成的鏈的結果,超越傳統方法在準確性和吞吐量上,適用於高性能、大規模環境。

short-m@k框架也改善模型微調。使用簡潔推理序列進行訓練可加速收斂,提升推理精度與訓練和部署期間的資源效率。

對AI發展與行業應用的影響

較短的推理鏈對AI模型的發展、部署與可持續性有顯著影響。

在訓練中,簡潔推理鏈降低計算複雜度,減少成本並加速更新,無需額外基礎設施。

在部署中,特別是在聊天機器人或交易平台等時間敏感應用中,較短的推理鏈提升處理速度,使系統能有效處理更多請求並在高需求下有效擴展。

能源效率是另一優勢。訓練和推理中的較少計算降低能耗,減少成本並支持數據中心日益增長的能源需求的環境目標。

總體而言,這些效率加速AI發展,使AI解決方案更快進入市場,幫助組織在動態技術環境中保持競爭力。

採用簡潔推理的挑戰

雖然較短的推理鏈帶來明顯好處,但實施上存在挑戰。

傳統AI系統為較長推理設計,需重新調整模型架構、訓練方法與優化策略,這需要技術專長與組織適應性。

數據質量與結構至關重要。為延長推理訓練的數據集可能在較短路徑中表現不佳。為簡潔、目標導向的推理整理數據集對於保持準確性至關重要。

可擴展性是另一障礙。雖然在受控環境中有效,但電子商務或客戶支持等大規模應用需要強大的基礎設施來管理高請求量而不損害性能。

解決這些問題的策略包括:

- 實施short-m@k框架:利用並行處理與早期終止,在實時應用中實現速度與準確性的平衡。

- 專注於訓練中的簡潔推理:使用強調較短推理鏈的方法來優化資源與速度。

- 追蹤推理指標:實時監控推理鏈長度與模型性能,以確保持續的效率與準確性。

這些策略使開發者能夠採用較短的推理鏈,創造更快、更準確且可擴展的AI系統,滿足運營與成本效率目標。

結論

關於簡潔推理鏈的研究重新定義了AI發展。較短的推理鏈提升速度、準確性與成本效率,這對優先考慮性能的行業至關重要。

通過採用簡潔推理,AI系統無需額外資源即可改善,實現高效的開發與部署。此方法使AI能滿足多樣化需求,保持開發者與公司在快速變化的技術環境中的競爭力。

相關文章

Magi-1揭幕:開創AI視頻生成技術

探索我們對Magi-1的詳細分析,這是一個革命性的自回歸視頻創作AI平台。本文深入探討其獨特功能、價格結構和性能指標。適合內容創作者、營銷人員和科技愛好者,Magi-1為視頻製作開闢了新途徑。讓我們深入了解其功能!亮點Magi-1作為領先的自回歸AI視頻模型,提供卓越的品質。支持無縫的圖像到視頻轉換。新用戶註冊後可獲得500免費點數。視頻生成每秒消耗10點數。直觀的儀表板提供提示增強和高級品質選項

Magi-1揭幕:開創AI視頻生成技術

探索我們對Magi-1的詳細分析,這是一個革命性的自回歸視頻創作AI平台。本文深入探討其獨特功能、價格結構和性能指標。適合內容創作者、營銷人員和科技愛好者,Magi-1為視頻製作開闢了新途徑。讓我們深入了解其功能!亮點Magi-1作為領先的自回歸AI視頻模型,提供卓越的品質。支持無縫的圖像到視頻轉換。新用戶註冊後可獲得500免費點數。視頻生成每秒消耗10點數。直觀的儀表板提供提示增強和高級品質選項

AI驅動的圖形設計:2025年的頂尖工具與技術

在2025年,人工智慧(AI)正在重塑各產業,圖形設計位於這場變革的前沿。AI工具通過提升創造力、優化工作流程並將效率推向新高度,賦能設計師。探索如何通過本指南,利用最佳AI工具和策略提升您的設計技能,適用於2025年的圖形設計師。關鍵要點AI通過自動化例行任務和激發新的創意想法,革新圖形設計。設計師應將AI視為增強而非取代其技能的合作夥伴。AI驅動的設計工具可在幾分鐘內創建標誌、插圖和完整網站。

AI驅動的圖形設計:2025年的頂尖工具與技術

在2025年,人工智慧(AI)正在重塑各產業,圖形設計位於這場變革的前沿。AI工具通過提升創造力、優化工作流程並將效率推向新高度,賦能設計師。探索如何通過本指南,利用最佳AI工具和策略提升您的設計技能,適用於2025年的圖形設計師。關鍵要點AI通過自動化例行任務和激發新的創意想法,革新圖形設計。設計師應將AI視為增強而非取代其技能的合作夥伴。AI驅動的設計工具可在幾分鐘內創建標誌、插圖和完整網站。

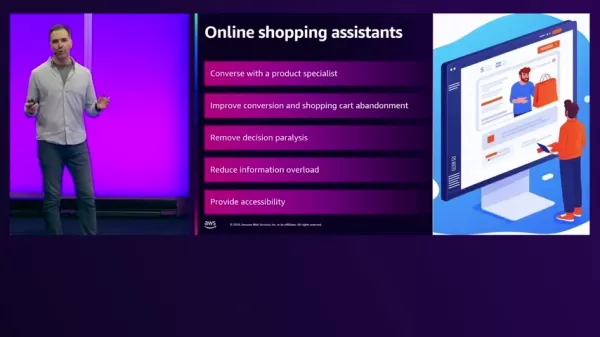

AI驅動的購物助手改變AWS上的電子商務

在當今快節奏的電子商務環境中,零售商致力於提升客戶體驗並增加銷售。生成式AI通過提供智能購物助手實現創新解決方案,這些助手能個性化互動、簡化產品發現並增強可訪問性。本文探討了線上零售的挑戰,並說明AWS如何助力開發先進的AI解決方案以克服這些挑戰,提升客戶滿意度並推動轉化。我們探討了關鍵問題、可用解決方案以及AWS生成式AI能力的展示。重點線上零售商面臨產品發現、資訊過載和決策疲勞的挑戰。AWS上

評論 (0)

0/200

AI驅動的購物助手改變AWS上的電子商務

在當今快節奏的電子商務環境中,零售商致力於提升客戶體驗並增加銷售。生成式AI通過提供智能購物助手實現創新解決方案,這些助手能個性化互動、簡化產品發現並增強可訪問性。本文探討了線上零售的挑戰,並說明AWS如何助力開發先進的AI解決方案以克服這些挑戰,提升客戶滿意度並推動轉化。我們探討了關鍵問題、可用解決方案以及AWS生成式AI能力的展示。重點線上零售商面臨產品發現、資訊過載和決策疲勞的挑戰。AWS上

評論 (0)

0/200

大語言模型(LLMs)已革新人工智慧(AI),產生類似人類的文本並應對各行業的複雜挑戰。此前,專家認為延長推理鏈能提高準確性,更多步驟帶來可靠結果。

2025年由Meta的FAIR團隊與耶路撒冷希伯來大學進行的研究挑戰此觀念。研究顯示,較短的推理鏈可將LLM準確性提升高達34.5%,同時降低40%的計算成本。簡潔推理加速處理速度,有望重塑LLM的訓練、部署與可擴展性。

為何簡潔推理提升AI效率

傳統上,較長的推理鏈被認為通過處理更多數據來改善AI結果。邏輯簡單:更多步驟意味著更深入的分析,提升準確性。因此,AI系統優先採用延長推理以增強性能。

然而,此方法有其缺點。較長的推理鏈需要大量計算能力,減慢處理速度並增加成本,特別是在需要快速回應的實時應用中。此外,複雜的推理鏈增加錯誤風險,降低效率與可擴展性,特別在需要速度與精度的行業中。

Meta主導的研究揭示這些缺陷,顯示較短的推理鏈可提高準確性同時降低計算需求。這使得任務處理更快且不犧牲可靠性。

這些見解將AI發展的重點從最大化推理步驟轉向優化流程。較短的推理鏈提升效率,提供可靠結果並減少處理時間。

使用short-m@k框架優化推理

該研究介紹了short-m@k推理框架,旨在簡化LLM中的多步推理。與傳統的順序或多數投票方法不同,它使用並行處理與早期終止來提升效率並降低成本。

在short-m@k方法中,k個並行推理鏈同時運行,一旦前m個鏈完成即停止。最終預測使用這些早期結果的多數投票,最大限度減少不必要的計算,同時保持準確性。

該框架提供兩種變體:

short-1@k: 從k個並行嘗試中選擇第一個完成的鏈,適用於低資源、延遲敏感的環境,以最小的計算成本提供高準確性。

short-3@k: 結合前三個完成的鏈的結果,超越傳統方法在準確性和吞吐量上,適用於高性能、大規模環境。

short-m@k框架也改善模型微調。使用簡潔推理序列進行訓練可加速收斂,提升推理精度與訓練和部署期間的資源效率。

對AI發展與行業應用的影響

較短的推理鏈對AI模型的發展、部署與可持續性有顯著影響。

在訓練中,簡潔推理鏈降低計算複雜度,減少成本並加速更新,無需額外基礎設施。

在部署中,特別是在聊天機器人或交易平台等時間敏感應用中,較短的推理鏈提升處理速度,使系統能有效處理更多請求並在高需求下有效擴展。

能源效率是另一優勢。訓練和推理中的較少計算降低能耗,減少成本並支持數據中心日益增長的能源需求的環境目標。

總體而言,這些效率加速AI發展,使AI解決方案更快進入市場,幫助組織在動態技術環境中保持競爭力。

採用簡潔推理的挑戰

雖然較短的推理鏈帶來明顯好處,但實施上存在挑戰。

傳統AI系統為較長推理設計,需重新調整模型架構、訓練方法與優化策略,這需要技術專長與組織適應性。

數據質量與結構至關重要。為延長推理訓練的數據集可能在較短路徑中表現不佳。為簡潔、目標導向的推理整理數據集對於保持準確性至關重要。

可擴展性是另一障礙。雖然在受控環境中有效,但電子商務或客戶支持等大規模應用需要強大的基礎設施來管理高請求量而不損害性能。

解決這些問題的策略包括:

- 實施short-m@k框架:利用並行處理與早期終止,在實時應用中實現速度與準確性的平衡。

- 專注於訓練中的簡潔推理:使用強調較短推理鏈的方法來優化資源與速度。

- 追蹤推理指標:實時監控推理鏈長度與模型性能,以確保持續的效率與準確性。

這些策略使開發者能夠採用較短的推理鏈,創造更快、更準確且可擴展的AI系統,滿足運營與成本效率目標。

結論

關於簡潔推理鏈的研究重新定義了AI發展。較短的推理鏈提升速度、準確性與成本效率,這對優先考慮性能的行業至關重要。

通過採用簡潔推理,AI系統無需額外資源即可改善,實現高效的開發與部署。此方法使AI能滿足多樣化需求,保持開發者與公司在快速變化的技術環境中的競爭力。

Magi-1揭幕:開創AI視頻生成技術

探索我們對Magi-1的詳細分析,這是一個革命性的自回歸視頻創作AI平台。本文深入探討其獨特功能、價格結構和性能指標。適合內容創作者、營銷人員和科技愛好者,Magi-1為視頻製作開闢了新途徑。讓我們深入了解其功能!亮點Magi-1作為領先的自回歸AI視頻模型,提供卓越的品質。支持無縫的圖像到視頻轉換。新用戶註冊後可獲得500免費點數。視頻生成每秒消耗10點數。直觀的儀表板提供提示增強和高級品質選項

Magi-1揭幕:開創AI視頻生成技術

探索我們對Magi-1的詳細分析,這是一個革命性的自回歸視頻創作AI平台。本文深入探討其獨特功能、價格結構和性能指標。適合內容創作者、營銷人員和科技愛好者,Magi-1為視頻製作開闢了新途徑。讓我們深入了解其功能!亮點Magi-1作為領先的自回歸AI視頻模型,提供卓越的品質。支持無縫的圖像到視頻轉換。新用戶註冊後可獲得500免費點數。視頻生成每秒消耗10點數。直觀的儀表板提供提示增強和高級品質選項

AI驅動的圖形設計:2025年的頂尖工具與技術

在2025年,人工智慧(AI)正在重塑各產業,圖形設計位於這場變革的前沿。AI工具通過提升創造力、優化工作流程並將效率推向新高度,賦能設計師。探索如何通過本指南,利用最佳AI工具和策略提升您的設計技能,適用於2025年的圖形設計師。關鍵要點AI通過自動化例行任務和激發新的創意想法,革新圖形設計。設計師應將AI視為增強而非取代其技能的合作夥伴。AI驅動的設計工具可在幾分鐘內創建標誌、插圖和完整網站。

AI驅動的圖形設計:2025年的頂尖工具與技術

在2025年,人工智慧(AI)正在重塑各產業,圖形設計位於這場變革的前沿。AI工具通過提升創造力、優化工作流程並將效率推向新高度,賦能設計師。探索如何通過本指南,利用最佳AI工具和策略提升您的設計技能,適用於2025年的圖形設計師。關鍵要點AI通過自動化例行任務和激發新的創意想法,革新圖形設計。設計師應將AI視為增強而非取代其技能的合作夥伴。AI驅動的設計工具可在幾分鐘內創建標誌、插圖和完整網站。

AI驅動的購物助手改變AWS上的電子商務

在當今快節奏的電子商務環境中,零售商致力於提升客戶體驗並增加銷售。生成式AI通過提供智能購物助手實現創新解決方案,這些助手能個性化互動、簡化產品發現並增強可訪問性。本文探討了線上零售的挑戰,並說明AWS如何助力開發先進的AI解決方案以克服這些挑戰,提升客戶滿意度並推動轉化。我們探討了關鍵問題、可用解決方案以及AWS生成式AI能力的展示。重點線上零售商面臨產品發現、資訊過載和決策疲勞的挑戰。AWS上

AI驅動的購物助手改變AWS上的電子商務

在當今快節奏的電子商務環境中,零售商致力於提升客戶體驗並增加銷售。生成式AI通過提供智能購物助手實現創新解決方案,這些助手能個性化互動、簡化產品發現並增強可訪問性。本文探討了線上零售的挑戰,並說明AWS如何助力開發先進的AI解決方案以克服這些挑戰,提升客戶滿意度並推動轉化。我們探討了關鍵問題、可用解決方案以及AWS生成式AI能力的展示。重點線上零售商面臨產品發現、資訊過載和決策疲勞的挑戰。AWS上