Der Energieverbrauch von Chatgpt ist niedriger als erwartet

ChatGPT, der Chatbot von OpenAI, ist möglicherweise nicht der Energieverschwender, für den wir ihn gehalten haben. Sein Energieverbrauch kann jedoch stark variieren, je nachdem, wie er genutzt wird und welche KI-Modelle die Fragen beantworten, so eine neue Studie.

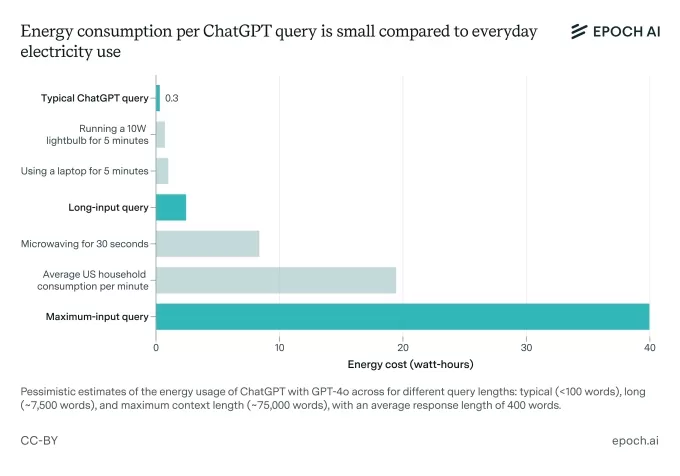

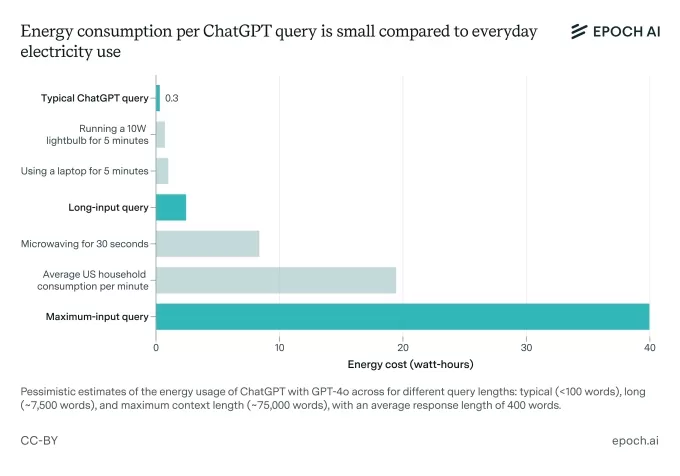

Epoch AI, eine gemeinnützige Forschungsgruppe, hat versucht herauszufinden, wie viel Energie eine typische ChatGPT-Anfrage verbraucht. Vielleicht hast du gehört, dass ChatGPT etwa 3 Wattstunden benötigt, um eine einzelne Frage zu beantworten, was zehnmal mehr ist als eine Google-Suche. Epoch hält das jedoch für etwas übertrieben.

Mit OpenAI's neuestem Standardmodell, GPT-4o, als Referenz hat Epoch herausgefunden, dass eine durchschnittliche ChatGPT-Anfrage tatsächlich etwa 0,3 Wattstunden verbraucht. Das ist weniger als das, was viele Haushaltsgeräte benötigen.

„Der Energieverbrauch ist im Vergleich zur Nutzung normaler Geräte oder zum Heizen oder Kühlen deines Hauses oder dem Fahren eines Autos wirklich keine große Sache“, sagte Joshua You, der Datenanalyst bei Epoch, der die Analyse durchgeführt hat, gegenüber TechCrunch.

Der Energieverbrauch von KI und deren Auswirkungen auf die Umwelt sind ein heißes Thema, da KI-Unternehmen ihre Rechenzentren wie verrückt erweitern wollen. Erst letzte Woche unterzeichneten über 100 Organisationen einen offenen Brief, in dem sie die KI-Industrie und Regulierungsbehörden aufforderten, sicherzustellen, dass neue KI-Rechenzentren nicht die natürlichen Ressourcen erschöpfen und Versorgungsunternehmen dazu zwingen, auf nicht erneuerbare Energiequellen zurückzugreifen.

You erzählte TechCrunch, dass seine Analyse durch veraltete Forschungsergebnisse angestoßen wurde. Er wies darauf hin, dass der Bericht, der die Schätzung von 3 Wattstunden pro Anfrage lieferte, davon ausging, dass OpenAI ältere, weniger effiziente Chips für seine Modelle verwendete.

Bildnachweis: Epoch AI „Ich habe viele öffentliche Diskussionen gesehen, die richtig erkannt haben, dass KI in den kommenden Jahren viel Energie verbrauchen wird, aber den aktuellen Energieverbrauch von KI nicht wirklich genau beschrieben haben“, sagte You. „Außerdem bemerkten einige meiner Kollegen, dass die am häufigsten genannte Schätzung von 3 Wattstunden pro Anfrage auf ziemlich alten Forschungsergebnissen basierte und auf Basis einiger grober Berechnungen zu hoch erschien.“

Natürlich ist die Schätzung von Epoch von 0,3 Wattstunden auch nur eine Schätzung. OpenAI hat die Details nicht geteilt, die für eine präzise Berechnung nötig wären.

Die Analyse berücksichtigt auch nicht die zusätzlichen Energiekosten durch ChatGPT-Funktionen wie Bildgenerierung oder die Verarbeitung langer Eingaben. You gab zu, dass „lange Eingaben“ bei ChatGPT-Anfragen – wie solche mit angehängten langen Dateien – wahrscheinlich im Vorfeld mehr Strom verbrauchen als eine typische Frage.

You sagte, er erwarte jedoch, dass der Grundenergieverbrauch von ChatGPT steigen wird.

„$$ Die $$ KI wird fortschrittlicher werden, das Training dieser KI wird wahrscheinlich viel mehr Energie erfordern, und diese zukünftige KI wird viel intensiver genutzt werden – sie wird viel mehr Aufgaben und komplexere Aufgaben bewältigen als die Art und Weise, wie Menschen ChatGPT heute nutzen“, sagte You.

Während es in letzter Zeit einige spannende Durchbrüche in der KI-Effizienz gab, wird erwartet, dass die Skala, in der KI genutzt wird, ein enormes, stromhungriges Infrastrukturwachstum antreiben wird. In den nächsten zwei Jahren könnten KI-Rechenzentren fast die gesamte Stromkapazität Kaliforniens von 2022 (68 GW) benötigen, so ein Bericht von Rand. Bis 2030 könnte das Training eines Spitzenmodells Strom im Äquivalent von acht Kernreaktoren (8 GW) benötigen, prognostizierte der Bericht.

ChatGPT allein erreicht eine Menge Menschen, und diese Zahl wächst nur, was bedeutet, dass die Anforderungen an die Server enorm sind. OpenAI plant zusammen mit mehreren Investitionspartnern, in den nächsten Jahren Milliarden für neue KI-Rechenzentrumsprojekte auszugeben.

Der Fokus von OpenAI, wie auch der der gesamten KI-Industrie, verlagert sich auf Reasoning-Modelle. Diese Modelle können mehr Aufgaben erledigen, benötigen aber mehr Rechenleistung, um zu funktionieren. Im Gegensatz zu Modellen wie GPT-4o, die Anfragen fast sofort beantworten, „denken“ Reasoning-Modelle Sekunden bis Minuten, bevor sie antworten, was mehr Rechenleistung – und damit mehr Energie – verbraucht.

„Reasoning-Modelle werden zunehmend Aufgaben übernehmen, die ältere Modelle nicht können, und mehr [Daten] erzeugen, um dies zu tun, und beides erfordert mehr Rechenzentren“, sagte You.

OpenAI hat begonnen, energieeffizientere Reasoning-Modelle wie o3-mini zu veröffentlichen. Doch es scheint derzeit unwahrscheinlich, dass diese Effizienzgewinne die gestiegenen Energieanforderungen durch den „Denkprozess“ der Reasoning-Modelle und die wachsende Nutzung von KI weltweit ausgleichen werden.

You schlug vor, dass, wenn du dir Sorgen um deinen KI-Energie-Fußabdruck machst, du Apps wie ChatGPT seltener nutzen oder Modelle wählen solltest, die weniger Rechenleistung benötigen – falls das möglich ist.

„Du könntest versuchen, kleinere KI-Modelle wie [OpenAI's] GPT-4o-mini zu nutzen“, sagte You, „und sie sparsam in einer Weise verwenden, die die Verarbeitung oder Generierung einer Menge Daten erfordert.“

Verwandter Artikel

OpenAI behebt den ChatGPT-Fehler der Überhöflichkeit und erklärt den KI-Fehler

OpenAI hat eine kürzlich vorgenommene Persönlichkeitsanpassung seines Flaggschiffmodells GPT-4o rückgängig gemacht, nachdem weit verbreitete Berichte aufgetaucht waren, wonach das KI-System übermäßig

OpenAI behebt den ChatGPT-Fehler der Überhöflichkeit und erklärt den KI-Fehler

OpenAI hat eine kürzlich vorgenommene Persönlichkeitsanpassung seines Flaggschiffmodells GPT-4o rückgängig gemacht, nachdem weit verbreitete Berichte aufgetaucht waren, wonach das KI-System übermäßig

Hao Sang teilt Startup-Einblicke bei TechCrunch Sessions: KI als Schlüsselfaktor für den Erfolg mit OpenAI

Das KI-Potenzial in marktreife Produkte verwandelnDie KI-Landschaft ist voll von APIs, Modellen und kühnen Behauptungen - aber für Startup-Gründer bleibt die entscheidende Herausforderung bestehen: Wi

Hao Sang teilt Startup-Einblicke bei TechCrunch Sessions: KI als Schlüsselfaktor für den Erfolg mit OpenAI

Das KI-Potenzial in marktreife Produkte verwandelnDie KI-Landschaft ist voll von APIs, Modellen und kühnen Behauptungen - aber für Startup-Gründer bleibt die entscheidende Herausforderung bestehen: Wi

Tech-Koalition protestiert gegen die Abkehr von OpenAIs gemeinnützigen Ursprüngen

Eine einflussreiche Koalition von Experten für künstliche Intelligenz, darunter ehemalige OpenAI-Mitarbeiter, hat erhebliche Bedenken geäußert, dass sich die Organisation von den Grundsätzen ihrer gem

Kommentare (32)

0/200

Tech-Koalition protestiert gegen die Abkehr von OpenAIs gemeinnützigen Ursprüngen

Eine einflussreiche Koalition von Experten für künstliche Intelligenz, darunter ehemalige OpenAI-Mitarbeiter, hat erhebliche Bedenken geäußert, dass sich die Organisation von den Grundsätzen ihrer gem

Kommentare (32)

0/200

![PaulHill]() PaulHill

PaulHill

16. August 2025 05:00:59 MESZ

16. August 2025 05:00:59 MESZ

Wow, ChatGPT’s energy use is lower than I thought! Still, it’s wild how much it varies by model and usage. Makes me wonder how sustainable scaling up AI will be in the long run. 🤔

0

0

![WillPerez]() WillPerez

WillPerez

15. August 2025 01:01:00 MESZ

15. August 2025 01:01:00 MESZ

Surprising to see ChatGPT's energy use isn't as bad as hyped! Still, makes me wonder how much power those massive AI models really burn through when we’re all chatting away. 🤔

0

0

![CharlesRoberts]() CharlesRoberts

CharlesRoberts

24. April 2025 10:09:19 MESZ

24. April 2025 10:09:19 MESZ

A energia usada pelo ChatGPT é surpreendentemente baixa! Pensei que fosse um devorador de energia, mas não é tão ruim assim. Ainda assim, é louco como pode variar muito dependendo do modelo e do uso. Faz você pensar no futuro da IA, né? 🤔 Continuem o bom trabalho, OpenAI!

0

0

![JasonHarris]() JasonHarris

JasonHarris

19. April 2025 13:13:39 MESZ

19. April 2025 13:13:39 MESZ

ChatGPT's energy use is surprisingly low! I was expecting it to be a power hog, but it's not that bad. Still, it's wild how much it can change depending on the model and usage. Makes you think about the future of AI, right? 🤔 Keep up the good work, OpenAI!

0

0

![AlbertRoberts]() AlbertRoberts

AlbertRoberts

16. April 2025 10:28:59 MESZ

16. April 2025 10:28:59 MESZ

ChatGPT's energy use being lower than expected is great news! But it's still wild how it varies so much. Makes you think about the future of AI and energy efficiency. Keep up the good work, OpenAI! 🔋💡

0

0

![JimmyJohnson]() JimmyJohnson

JimmyJohnson

16. April 2025 04:49:30 MESZ

16. April 2025 04:49:30 MESZ

A notícia de que o uso de energia do ChatGPT é menor do que o esperado é ótima! Mas é louco como varia tanto. Faz você pensar sobre o futuro da IA e a eficiência energética. Continue o bom trabalho, OpenAI! 🔋💡

0

0

ChatGPT, der Chatbot von OpenAI, ist möglicherweise nicht der Energieverschwender, für den wir ihn gehalten haben. Sein Energieverbrauch kann jedoch stark variieren, je nachdem, wie er genutzt wird und welche KI-Modelle die Fragen beantworten, so eine neue Studie.

Epoch AI, eine gemeinnützige Forschungsgruppe, hat versucht herauszufinden, wie viel Energie eine typische ChatGPT-Anfrage verbraucht. Vielleicht hast du gehört, dass ChatGPT etwa 3 Wattstunden benötigt, um eine einzelne Frage zu beantworten, was zehnmal mehr ist als eine Google-Suche. Epoch hält das jedoch für etwas übertrieben.

Mit OpenAI's neuestem Standardmodell, GPT-4o, als Referenz hat Epoch herausgefunden, dass eine durchschnittliche ChatGPT-Anfrage tatsächlich etwa 0,3 Wattstunden verbraucht. Das ist weniger als das, was viele Haushaltsgeräte benötigen.

„Der Energieverbrauch ist im Vergleich zur Nutzung normaler Geräte oder zum Heizen oder Kühlen deines Hauses oder dem Fahren eines Autos wirklich keine große Sache“, sagte Joshua You, der Datenanalyst bei Epoch, der die Analyse durchgeführt hat, gegenüber TechCrunch.

Der Energieverbrauch von KI und deren Auswirkungen auf die Umwelt sind ein heißes Thema, da KI-Unternehmen ihre Rechenzentren wie verrückt erweitern wollen. Erst letzte Woche unterzeichneten über 100 Organisationen einen offenen Brief, in dem sie die KI-Industrie und Regulierungsbehörden aufforderten, sicherzustellen, dass neue KI-Rechenzentren nicht die natürlichen Ressourcen erschöpfen und Versorgungsunternehmen dazu zwingen, auf nicht erneuerbare Energiequellen zurückzugreifen.

You erzählte TechCrunch, dass seine Analyse durch veraltete Forschungsergebnisse angestoßen wurde. Er wies darauf hin, dass der Bericht, der die Schätzung von 3 Wattstunden pro Anfrage lieferte, davon ausging, dass OpenAI ältere, weniger effiziente Chips für seine Modelle verwendete.

„Ich habe viele öffentliche Diskussionen gesehen, die richtig erkannt haben, dass KI in den kommenden Jahren viel Energie verbrauchen wird, aber den aktuellen Energieverbrauch von KI nicht wirklich genau beschrieben haben“, sagte You. „Außerdem bemerkten einige meiner Kollegen, dass die am häufigsten genannte Schätzung von 3 Wattstunden pro Anfrage auf ziemlich alten Forschungsergebnissen basierte und auf Basis einiger grober Berechnungen zu hoch erschien.“

Natürlich ist die Schätzung von Epoch von 0,3 Wattstunden auch nur eine Schätzung. OpenAI hat die Details nicht geteilt, die für eine präzise Berechnung nötig wären.

Die Analyse berücksichtigt auch nicht die zusätzlichen Energiekosten durch ChatGPT-Funktionen wie Bildgenerierung oder die Verarbeitung langer Eingaben. You gab zu, dass „lange Eingaben“ bei ChatGPT-Anfragen – wie solche mit angehängten langen Dateien – wahrscheinlich im Vorfeld mehr Strom verbrauchen als eine typische Frage.

You sagte, er erwarte jedoch, dass der Grundenergieverbrauch von ChatGPT steigen wird.

„$$ Die $$ KI wird fortschrittlicher werden, das Training dieser KI wird wahrscheinlich viel mehr Energie erfordern, und diese zukünftige KI wird viel intensiver genutzt werden – sie wird viel mehr Aufgaben und komplexere Aufgaben bewältigen als die Art und Weise, wie Menschen ChatGPT heute nutzen“, sagte You.

Während es in letzter Zeit einige spannende Durchbrüche in der KI-Effizienz gab, wird erwartet, dass die Skala, in der KI genutzt wird, ein enormes, stromhungriges Infrastrukturwachstum antreiben wird. In den nächsten zwei Jahren könnten KI-Rechenzentren fast die gesamte Stromkapazität Kaliforniens von 2022 (68 GW) benötigen, so ein Bericht von Rand. Bis 2030 könnte das Training eines Spitzenmodells Strom im Äquivalent von acht Kernreaktoren (8 GW) benötigen, prognostizierte der Bericht.

ChatGPT allein erreicht eine Menge Menschen, und diese Zahl wächst nur, was bedeutet, dass die Anforderungen an die Server enorm sind. OpenAI plant zusammen mit mehreren Investitionspartnern, in den nächsten Jahren Milliarden für neue KI-Rechenzentrumsprojekte auszugeben.

Der Fokus von OpenAI, wie auch der der gesamten KI-Industrie, verlagert sich auf Reasoning-Modelle. Diese Modelle können mehr Aufgaben erledigen, benötigen aber mehr Rechenleistung, um zu funktionieren. Im Gegensatz zu Modellen wie GPT-4o, die Anfragen fast sofort beantworten, „denken“ Reasoning-Modelle Sekunden bis Minuten, bevor sie antworten, was mehr Rechenleistung – und damit mehr Energie – verbraucht.

„Reasoning-Modelle werden zunehmend Aufgaben übernehmen, die ältere Modelle nicht können, und mehr [Daten] erzeugen, um dies zu tun, und beides erfordert mehr Rechenzentren“, sagte You.

OpenAI hat begonnen, energieeffizientere Reasoning-Modelle wie o3-mini zu veröffentlichen. Doch es scheint derzeit unwahrscheinlich, dass diese Effizienzgewinne die gestiegenen Energieanforderungen durch den „Denkprozess“ der Reasoning-Modelle und die wachsende Nutzung von KI weltweit ausgleichen werden.

You schlug vor, dass, wenn du dir Sorgen um deinen KI-Energie-Fußabdruck machst, du Apps wie ChatGPT seltener nutzen oder Modelle wählen solltest, die weniger Rechenleistung benötigen – falls das möglich ist.

„Du könntest versuchen, kleinere KI-Modelle wie [OpenAI's] GPT-4o-mini zu nutzen“, sagte You, „und sie sparsam in einer Weise verwenden, die die Verarbeitung oder Generierung einer Menge Daten erfordert.“

OpenAI behebt den ChatGPT-Fehler der Überhöflichkeit und erklärt den KI-Fehler

OpenAI hat eine kürzlich vorgenommene Persönlichkeitsanpassung seines Flaggschiffmodells GPT-4o rückgängig gemacht, nachdem weit verbreitete Berichte aufgetaucht waren, wonach das KI-System übermäßig

OpenAI behebt den ChatGPT-Fehler der Überhöflichkeit und erklärt den KI-Fehler

OpenAI hat eine kürzlich vorgenommene Persönlichkeitsanpassung seines Flaggschiffmodells GPT-4o rückgängig gemacht, nachdem weit verbreitete Berichte aufgetaucht waren, wonach das KI-System übermäßig

Hao Sang teilt Startup-Einblicke bei TechCrunch Sessions: KI als Schlüsselfaktor für den Erfolg mit OpenAI

Das KI-Potenzial in marktreife Produkte verwandelnDie KI-Landschaft ist voll von APIs, Modellen und kühnen Behauptungen - aber für Startup-Gründer bleibt die entscheidende Herausforderung bestehen: Wi

Hao Sang teilt Startup-Einblicke bei TechCrunch Sessions: KI als Schlüsselfaktor für den Erfolg mit OpenAI

Das KI-Potenzial in marktreife Produkte verwandelnDie KI-Landschaft ist voll von APIs, Modellen und kühnen Behauptungen - aber für Startup-Gründer bleibt die entscheidende Herausforderung bestehen: Wi

16. August 2025 05:00:59 MESZ

16. August 2025 05:00:59 MESZ

Wow, ChatGPT’s energy use is lower than I thought! Still, it’s wild how much it varies by model and usage. Makes me wonder how sustainable scaling up AI will be in the long run. 🤔

0

0

15. August 2025 01:01:00 MESZ

15. August 2025 01:01:00 MESZ

Surprising to see ChatGPT's energy use isn't as bad as hyped! Still, makes me wonder how much power those massive AI models really burn through when we’re all chatting away. 🤔

0

0

24. April 2025 10:09:19 MESZ

24. April 2025 10:09:19 MESZ

A energia usada pelo ChatGPT é surpreendentemente baixa! Pensei que fosse um devorador de energia, mas não é tão ruim assim. Ainda assim, é louco como pode variar muito dependendo do modelo e do uso. Faz você pensar no futuro da IA, né? 🤔 Continuem o bom trabalho, OpenAI!

0

0

19. April 2025 13:13:39 MESZ

19. April 2025 13:13:39 MESZ

ChatGPT's energy use is surprisingly low! I was expecting it to be a power hog, but it's not that bad. Still, it's wild how much it can change depending on the model and usage. Makes you think about the future of AI, right? 🤔 Keep up the good work, OpenAI!

0

0

16. April 2025 10:28:59 MESZ

16. April 2025 10:28:59 MESZ

ChatGPT's energy use being lower than expected is great news! But it's still wild how it varies so much. Makes you think about the future of AI and energy efficiency. Keep up the good work, OpenAI! 🔋💡

0

0

16. April 2025 04:49:30 MESZ

16. April 2025 04:49:30 MESZ

A notícia de que o uso de energia do ChatGPT é menor do que o esperado é ótima! Mas é louco como varia tanto. Faz você pensar sobre o futuro da IA e a eficiência energética. Continue o bom trabalho, OpenAI! 🔋💡

0

0