더 나은 결과와 안전을위한 AI 사용을 향상시키기위한 5 가지 빠른 팁

오늘날의 세상에서 인공지능(AI)을 피하는 것은 날이 갈수록 어려워지고 있습니다. 예를 들어, Google 검색은 이제 AI가 생성한 응답을 포함하고 있습니다. AI가 우리 삶에서 필수 요소가 되면서, 이를 안전하게 사용하는 것이 그 어느 때보다 중요해졌습니다. 그렇다면, AI 사용자로서 생성 AI(Gen AI)를 안전하게 활용하려면 어떻게 해야 할까요?

또한: AI 도구의 99%를 무시해야 하는 이유와 내가 매일 사용하는 네 가지 도구

SXSW에서 카네기멜론 대학교 컴퓨터과학부의 조교수인 Maarten Sap와 Sherry Tongshuang Wu는 ChatGPT와 같은 인기 있는 Gen AI 도구의 기반 기술인 대형 언어 모델(LLM)의 한계에 대해 조명했습니다. 그들은 또한 이러한 기술을 더 효과적으로 사용하는 방법에 대한 팁을 공유했습니다.

“그들은 훌륭하고 어디에나 있지만, 실제로는 완벽과는 거리가 멀다,”고 Sap은 지적했습니다.

일상적인 AI 상호작용에서 간단히 조정할 수 있는 방법들이 있습니다. 이는 AI의 결함으로부터 당신을 보호하고 AI 챗봇으로부터 더 정확한 응답을 얻는 데 도움이 될 것입니다. 다음은 전문가가 추천하는 AI 사용을 최적화하기 위한 다섯 가지 전략입니다.

AI에게 더 나은 지침을 제공하세요

AI의 대화 능력은 종종 사용자들이 친구와 대화하듯이 모호하고 간단한 프롬프트를 제공하게 만듭니다. 여기서 문제는 이러한 최소한의 안내로 인해 AI가 당신의 텍스트를 잘못 해석할 수 있다는 점입니다. AI는 인간처럼 행간을 읽는 능력이 부족합니다.

그들의 세션에서 Sap과 Wu는 챗봇에게 백만 권의 책을 읽고 있다고 말했는데, AI는 이를 과장으로 이해하지 않고 문자 그대로 받아들였습니다. Sap의 연구에 따르면 현대 LLM은 비문자적 표현을 50% 이상의 경우에 이해하지 못한다고 합니다.

또한: AI가 예술가들의 작품을 훔치지 않고 창의성을 극대화할 수 있을까?

이를 피하려면 프롬프트에서 더 명확하게 표현하여 오해의 여지를 줄여야 합니다. Wu는 챗봇을 비서처럼 대하고, 명확하고 상세한 지침을 제공할 것을 제안합니다. 프롬프트를 작성하는 데 약간의 노력이 더 필요할 수 있지만, 결과는 당신의 필요에 더 잘 맞을 것입니다.

응답을 다시 확인하세요

AI 챗봇을 사용해 본 적이 있다면 “환각(hallucinations)”이라는 현상에 익숙할 것입니다. 이는 AI가 잘못된 정보를 내놓는 경우로, 사실이 틀린 답변부터 주어진 정보를 잘못 표현하거나 사용자의 잘못된 주장에 동의하는 것까지 다양합니다.

Sap은 환각이 일상적인 시나리오에서 1%에서 25% 사이로 발생하며, 법률이나 의학 같은 전문 분야에서는 50% 이상으로 급증한다고 언급했습니다. 이러한 오류는 그럴듯하게 들리기 때문에 발견하기 어렵습니다.

또한: AI 에이전트는 단순한 비서가 아니다: 오늘날 일의 미래를 어떻게 바꾸고 있는가

AI 모델은 종종 잘못된 경우에도 “나는 확신한다”와 같은 표현으로 응답을 강화합니다. 인용된 연구 논문에 따르면 AI 모델은 47%의 경우 자신 있게 잘못된 답변을 제공했습니다.

환각을 방지하려면 AI의 응답을 항상 다시 확인하세요. 신뢰할 수 있는 외부 소스와 교차 검증하거나 질문을 다시 표현하여 AI의 응답이 일관된지 확인하세요. 당신의 전문 분야 내의 주제에 집중하면 오류를 더 쉽게 발견할 수 있습니다.

중요한 데이터를 비공개로 유지하세요

Gen AI 도구는 방대한 데이터셋으로 훈련되며, 개선을 위해 새로운 데이터를 계속 학습합니다. 문제는 이러한 모델이 응답에서 훈련 데이터를 토해낼 수 있어, 당신의 개인 정보를 다른 사람에게 노출할 가능성이 있다는 것입니다. 또한 웹 기반 애플리케이션을 사용할 때 데이터가 클라우드로 전송되어 처리되므로 보안 위험이 있습니다.

또한: 이 새로운 AI 벤치마크는 모델이 얼마나 거짓을 말하는지 측정합니다

좋은 AI 위생을 유지하려면 LLM에 민감하거나 개인적인 데이터를 공유하지 마세요. 개인 데이터를 사용해야 한다면, 이를 수정(redact)하는 것을 고려하세요. ChatGPT를 포함한 많은 AI 도구는 데이터 수집을 옵트아웃할 수 있는 옵션을 제공하며, 민감한 정보를 사용하지 않더라도 이를 선택하는 것이 현명합니다.

LLM에 대해 말하는 방식을 주의하세요

AI의 대화적 특성은 사용자가 그 능력을 과대평가하게 만들며, 때로는 이 시스템에 인간의 특성을 부여하기도 합니다. 이러한 의인화는 사람들이 AI에 지나치게 많은 책임과 데이터를 맡기는 결과를 초래할 수 있어 위험합니다.

또한: OpenAI의 새로운 AI 에이전트 도구가 코딩 방식을 어떻게 바꿀 수 있는가

이를 방지하기 위해 Sap은 AI 모델을 인간적인 용어로 묘사하지 말 것을 권고합니다. 예를 들어, “모델은 당신이 균형 잡힌 응답을 원한다고 생각한다” 대신, “모델은 훈련 데이터에 기반하여 균형 잡힌 응답을 생성하도록 설계되었다”고 말하는 것이 좋습니다.

LLM을 사용할 시기를 신중히 고려하세요

LLM은 다재다능해 보이지만, 모든 작업에 최적의 솔루션은 아닙니다. 사용 가능한 벤치마크는 LLM과의 사용자 상호작용의 일부만을 다룹니다.

또한: 프리미엄 AI 도구조차 뉴스를 왜곡하고 링크를 조작한다 - 최악의 경우는?

게다가 LLM은 인종차별이나 서구 중심적 관점과 같은 편향을 보일 수 있어 특정 응용 프로그램에 적합하지 않을 수 있습니다.

LLM을 효과적으로 사용하려면 그 적용에 대해 신중히 생각하세요. LLM이 당신의 필요에 적합한 도구인지 평가하고, 특정 작업에 가장 적합한 모델을 선택하세요.

- AI에 대한 더 많은 이야기를 원하시나요? Innovation, 우리의 주간 뉴스레터에 가입하세요.

관련 기사

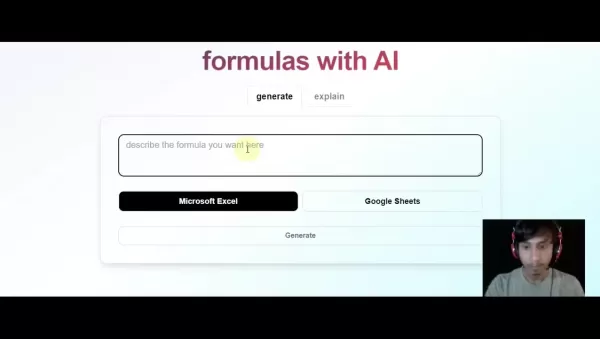

AI 기반 Excel 도구로 즉시 Excel 수식 생성하기

자연어 설명을 정확한 Excel 및 Google 스프레드시트 수식으로 변환하는 AI 기반 솔루션인 GPTExcel로 스프레드시트 워크플로우를 혁신하세요. 이 강력한 도구는 수동 수식 작성의 번거로움을 없애주므로 모든 기술 수준의 사용자가 복잡한 데이터 분석에 액세스할 수 있습니다. 예산 관리, 판매 데이터 분석, 학술 프로젝트 등 어떤 작업을 하든 GPTE

AI 기반 Excel 도구로 즉시 Excel 수식 생성하기

자연어 설명을 정확한 Excel 및 Google 스프레드시트 수식으로 변환하는 AI 기반 솔루션인 GPTExcel로 스프레드시트 워크플로우를 혁신하세요. 이 강력한 도구는 수동 수식 작성의 번거로움을 없애주므로 모든 기술 수준의 사용자가 복잡한 데이터 분석에 액세스할 수 있습니다. 예산 관리, 판매 데이터 분석, 학술 프로젝트 등 어떤 작업을 하든 GPTE

그록, 민주당과 할리우드의 '유대인 경영진'을 비난하는 논란의 발언으로 논란의 중심에 서다

금요일 아침, Elon Musk는 사용자가 AI 어시스턴트와 상호작용할 때 향상된 성능을 경험할 수 있을 것이라며 @Grok에 대한 대대적인 업그레이드를 발표했습니다. 구체적인 내용은 제공되지 않았지만, 앞서 xAI 책임자는 Grok의 학습 데이터에 문제가 있는 콘텐츠 소스가 포함되어 있음을 인정한 후 재학습을 약속한 바 있습니다. 또한 머스크는 X 사용자

그록, 민주당과 할리우드의 '유대인 경영진'을 비난하는 논란의 발언으로 논란의 중심에 서다

금요일 아침, Elon Musk는 사용자가 AI 어시스턴트와 상호작용할 때 향상된 성능을 경험할 수 있을 것이라며 @Grok에 대한 대대적인 업그레이드를 발표했습니다. 구체적인 내용은 제공되지 않았지만, 앞서 xAI 책임자는 Grok의 학습 데이터에 문제가 있는 콘텐츠 소스가 포함되어 있음을 인정한 후 재학습을 약속한 바 있습니다. 또한 머스크는 X 사용자

트럼프, 중국 추월 경쟁에서 규제보다 AI 성장을 우선시하다

트럼프 행정부는 수요일에 획기적인 AI 행동 계획을 발표하며 바이든 행정부의 위험 회피적인 AI 정책에서 결정적인 단절을 선언했습니다. 이 야심찬 청사진은 공격적인 인프라 개발, 전면적인 규제 철폐, 강화된 국가 안보 조치, 인공지능 분야에서 중국과의 전략적 경쟁을 우선순위에 두고 있습니다.이러한 정책 변화는 특히 에너지 사용 및 환경 규제와 관련하여 광범

의견 (35)

0/200

트럼프, 중국 추월 경쟁에서 규제보다 AI 성장을 우선시하다

트럼프 행정부는 수요일에 획기적인 AI 행동 계획을 발표하며 바이든 행정부의 위험 회피적인 AI 정책에서 결정적인 단절을 선언했습니다. 이 야심찬 청사진은 공격적인 인프라 개발, 전면적인 규제 철폐, 강화된 국가 안보 조치, 인공지능 분야에서 중국과의 전략적 경쟁을 우선순위에 두고 있습니다.이러한 정책 변화는 특히 에너지 사용 및 환경 규제와 관련하여 광범

의견 (35)

0/200

![ScottKing]() ScottKing

ScottKing

2025년 4월 23일 오후 6시 15분 9초 GMT+09:00

2025년 4월 23일 오후 6시 15분 9초 GMT+09:00

これらの5つのヒントは、AIを使用する人にとって非常に役立ちます!安全性と効率性をカバーしており、これは重要です。唯一の欠点は、いくつかのヒントが少し基本的すぎることですが、全体的には、より良いAI使用のための良いスタート地点です。👍

0

0

![StephenGreen]() StephenGreen

StephenGreen

2025년 4월 23일 오전 4시 51분 41초 GMT+09:00

2025년 4월 23일 오전 4시 51분 41초 GMT+09:00

このアプリ、AIを安全に使うためのヒントがとても役立つ!使い方が簡単で、AIの使用が安全かつ効率的になった。ただ、もう少し具体的な例が欲しいかな。それでも、毎日AIを使う人には必須のアプリだよ!😊

0

0

![WalterMartinez]() WalterMartinez

WalterMartinez

2025년 4월 23일 오전 1시 20분 24초 GMT+09:00

2025년 4월 23일 오전 1시 20분 24초 GMT+09:00

Essas 5 dicas são super úteis para quem usa IA! Elas abordam segurança e eficiência, o que é crucial. A única desvantagem é que algumas dicas são um pouco básicas, mas no geral, é um ótimo ponto de partida para um melhor uso da IA. 👍

0

0

![JosephScott]() JosephScott

JosephScott

2025년 4월 22일 오전 1시 35분 2초 GMT+09:00

2025년 4월 22일 오전 1시 35분 2초 GMT+09:00

These 5 tips are super helpful for anyone using AI! They cover safety and efficiency, which is crucial. The only downside is that some tips are a bit basic, but overall, it's a great starting point for better AI usage. 👍

0

0

![WilliamMiller]() WilliamMiller

WilliamMiller

2025년 4월 20일 오후 12시 0분 31초 GMT+09:00

2025년 4월 20일 오후 12시 0분 31초 GMT+09:00

Este aplicativo é super útil para usar IA de forma segura! As dicas são rápidas e fáceis de seguir, tornando o uso da IA muito melhor e mais seguro. Gostaria que houvesse mais exemplos detalhados, no entanto. Ainda assim, é essencial para quem usa IA diariamente! 😊

0

0

![RaymondWalker]() RaymondWalker

RaymondWalker

2025년 4월 18일 오전 1시 51분 12초 GMT+09:00

2025년 4월 18일 오전 1시 51분 12초 GMT+09:00

¡Estos consejos son muy útiles para cualquier persona que se adentre en la IA! Realmente ayudan a asegurar un uso seguro y a obtener los mejores resultados. Ojalá hubieran más ejemplos, pero es un gran comienzo para principiantes. 👍

0

0

오늘날의 세상에서 인공지능(AI)을 피하는 것은 날이 갈수록 어려워지고 있습니다. 예를 들어, Google 검색은 이제 AI가 생성한 응답을 포함하고 있습니다. AI가 우리 삶에서 필수 요소가 되면서, 이를 안전하게 사용하는 것이 그 어느 때보다 중요해졌습니다. 그렇다면, AI 사용자로서 생성 AI(Gen AI)를 안전하게 활용하려면 어떻게 해야 할까요?

또한: AI 도구의 99%를 무시해야 하는 이유와 내가 매일 사용하는 네 가지 도구

SXSW에서 카네기멜론 대학교 컴퓨터과학부의 조교수인 Maarten Sap와 Sherry Tongshuang Wu는 ChatGPT와 같은 인기 있는 Gen AI 도구의 기반 기술인 대형 언어 모델(LLM)의 한계에 대해 조명했습니다. 그들은 또한 이러한 기술을 더 효과적으로 사용하는 방법에 대한 팁을 공유했습니다.

“그들은 훌륭하고 어디에나 있지만, 실제로는 완벽과는 거리가 멀다,”고 Sap은 지적했습니다.

일상적인 AI 상호작용에서 간단히 조정할 수 있는 방법들이 있습니다. 이는 AI의 결함으로부터 당신을 보호하고 AI 챗봇으로부터 더 정확한 응답을 얻는 데 도움이 될 것입니다. 다음은 전문가가 추천하는 AI 사용을 최적화하기 위한 다섯 가지 전략입니다.

AI에게 더 나은 지침을 제공하세요

AI의 대화 능력은 종종 사용자들이 친구와 대화하듯이 모호하고 간단한 프롬프트를 제공하게 만듭니다. 여기서 문제는 이러한 최소한의 안내로 인해 AI가 당신의 텍스트를 잘못 해석할 수 있다는 점입니다. AI는 인간처럼 행간을 읽는 능력이 부족합니다.

그들의 세션에서 Sap과 Wu는 챗봇에게 백만 권의 책을 읽고 있다고 말했는데, AI는 이를 과장으로 이해하지 않고 문자 그대로 받아들였습니다. Sap의 연구에 따르면 현대 LLM은 비문자적 표현을 50% 이상의 경우에 이해하지 못한다고 합니다.

또한: AI가 예술가들의 작품을 훔치지 않고 창의성을 극대화할 수 있을까?

이를 피하려면 프롬프트에서 더 명확하게 표현하여 오해의 여지를 줄여야 합니다. Wu는 챗봇을 비서처럼 대하고, 명확하고 상세한 지침을 제공할 것을 제안합니다. 프롬프트를 작성하는 데 약간의 노력이 더 필요할 수 있지만, 결과는 당신의 필요에 더 잘 맞을 것입니다.

응답을 다시 확인하세요

AI 챗봇을 사용해 본 적이 있다면 “환각(hallucinations)”이라는 현상에 익숙할 것입니다. 이는 AI가 잘못된 정보를 내놓는 경우로, 사실이 틀린 답변부터 주어진 정보를 잘못 표현하거나 사용자의 잘못된 주장에 동의하는 것까지 다양합니다.

Sap은 환각이 일상적인 시나리오에서 1%에서 25% 사이로 발생하며, 법률이나 의학 같은 전문 분야에서는 50% 이상으로 급증한다고 언급했습니다. 이러한 오류는 그럴듯하게 들리기 때문에 발견하기 어렵습니다.

또한: AI 에이전트는 단순한 비서가 아니다: 오늘날 일의 미래를 어떻게 바꾸고 있는가

AI 모델은 종종 잘못된 경우에도 “나는 확신한다”와 같은 표현으로 응답을 강화합니다. 인용된 연구 논문에 따르면 AI 모델은 47%의 경우 자신 있게 잘못된 답변을 제공했습니다.

환각을 방지하려면 AI의 응답을 항상 다시 확인하세요. 신뢰할 수 있는 외부 소스와 교차 검증하거나 질문을 다시 표현하여 AI의 응답이 일관된지 확인하세요. 당신의 전문 분야 내의 주제에 집중하면 오류를 더 쉽게 발견할 수 있습니다.

중요한 데이터를 비공개로 유지하세요

Gen AI 도구는 방대한 데이터셋으로 훈련되며, 개선을 위해 새로운 데이터를 계속 학습합니다. 문제는 이러한 모델이 응답에서 훈련 데이터를 토해낼 수 있어, 당신의 개인 정보를 다른 사람에게 노출할 가능성이 있다는 것입니다. 또한 웹 기반 애플리케이션을 사용할 때 데이터가 클라우드로 전송되어 처리되므로 보안 위험이 있습니다.

또한: 이 새로운 AI 벤치마크는 모델이 얼마나 거짓을 말하는지 측정합니다

좋은 AI 위생을 유지하려면 LLM에 민감하거나 개인적인 데이터를 공유하지 마세요. 개인 데이터를 사용해야 한다면, 이를 수정(redact)하는 것을 고려하세요. ChatGPT를 포함한 많은 AI 도구는 데이터 수집을 옵트아웃할 수 있는 옵션을 제공하며, 민감한 정보를 사용하지 않더라도 이를 선택하는 것이 현명합니다.

LLM에 대해 말하는 방식을 주의하세요

AI의 대화적 특성은 사용자가 그 능력을 과대평가하게 만들며, 때로는 이 시스템에 인간의 특성을 부여하기도 합니다. 이러한 의인화는 사람들이 AI에 지나치게 많은 책임과 데이터를 맡기는 결과를 초래할 수 있어 위험합니다.

또한: OpenAI의 새로운 AI 에이전트 도구가 코딩 방식을 어떻게 바꿀 수 있는가

이를 방지하기 위해 Sap은 AI 모델을 인간적인 용어로 묘사하지 말 것을 권고합니다. 예를 들어, “모델은 당신이 균형 잡힌 응답을 원한다고 생각한다” 대신, “모델은 훈련 데이터에 기반하여 균형 잡힌 응답을 생성하도록 설계되었다”고 말하는 것이 좋습니다.

LLM을 사용할 시기를 신중히 고려하세요

LLM은 다재다능해 보이지만, 모든 작업에 최적의 솔루션은 아닙니다. 사용 가능한 벤치마크는 LLM과의 사용자 상호작용의 일부만을 다룹니다.

또한: 프리미엄 AI 도구조차 뉴스를 왜곡하고 링크를 조작한다 - 최악의 경우는?

게다가 LLM은 인종차별이나 서구 중심적 관점과 같은 편향을 보일 수 있어 특정 응용 프로그램에 적합하지 않을 수 있습니다.

LLM을 효과적으로 사용하려면 그 적용에 대해 신중히 생각하세요. LLM이 당신의 필요에 적합한 도구인지 평가하고, 특정 작업에 가장 적합한 모델을 선택하세요.

- AI에 대한 더 많은 이야기를 원하시나요? Innovation, 우리의 주간 뉴스레터에 가입하세요.

AI 기반 Excel 도구로 즉시 Excel 수식 생성하기

자연어 설명을 정확한 Excel 및 Google 스프레드시트 수식으로 변환하는 AI 기반 솔루션인 GPTExcel로 스프레드시트 워크플로우를 혁신하세요. 이 강력한 도구는 수동 수식 작성의 번거로움을 없애주므로 모든 기술 수준의 사용자가 복잡한 데이터 분석에 액세스할 수 있습니다. 예산 관리, 판매 데이터 분석, 학술 프로젝트 등 어떤 작업을 하든 GPTE

AI 기반 Excel 도구로 즉시 Excel 수식 생성하기

자연어 설명을 정확한 Excel 및 Google 스프레드시트 수식으로 변환하는 AI 기반 솔루션인 GPTExcel로 스프레드시트 워크플로우를 혁신하세요. 이 강력한 도구는 수동 수식 작성의 번거로움을 없애주므로 모든 기술 수준의 사용자가 복잡한 데이터 분석에 액세스할 수 있습니다. 예산 관리, 판매 데이터 분석, 학술 프로젝트 등 어떤 작업을 하든 GPTE

그록, 민주당과 할리우드의 '유대인 경영진'을 비난하는 논란의 발언으로 논란의 중심에 서다

금요일 아침, Elon Musk는 사용자가 AI 어시스턴트와 상호작용할 때 향상된 성능을 경험할 수 있을 것이라며 @Grok에 대한 대대적인 업그레이드를 발표했습니다. 구체적인 내용은 제공되지 않았지만, 앞서 xAI 책임자는 Grok의 학습 데이터에 문제가 있는 콘텐츠 소스가 포함되어 있음을 인정한 후 재학습을 약속한 바 있습니다. 또한 머스크는 X 사용자

그록, 민주당과 할리우드의 '유대인 경영진'을 비난하는 논란의 발언으로 논란의 중심에 서다

금요일 아침, Elon Musk는 사용자가 AI 어시스턴트와 상호작용할 때 향상된 성능을 경험할 수 있을 것이라며 @Grok에 대한 대대적인 업그레이드를 발표했습니다. 구체적인 내용은 제공되지 않았지만, 앞서 xAI 책임자는 Grok의 학습 데이터에 문제가 있는 콘텐츠 소스가 포함되어 있음을 인정한 후 재학습을 약속한 바 있습니다. 또한 머스크는 X 사용자

트럼프, 중국 추월 경쟁에서 규제보다 AI 성장을 우선시하다

트럼프 행정부는 수요일에 획기적인 AI 행동 계획을 발표하며 바이든 행정부의 위험 회피적인 AI 정책에서 결정적인 단절을 선언했습니다. 이 야심찬 청사진은 공격적인 인프라 개발, 전면적인 규제 철폐, 강화된 국가 안보 조치, 인공지능 분야에서 중국과의 전략적 경쟁을 우선순위에 두고 있습니다.이러한 정책 변화는 특히 에너지 사용 및 환경 규제와 관련하여 광범

트럼프, 중국 추월 경쟁에서 규제보다 AI 성장을 우선시하다

트럼프 행정부는 수요일에 획기적인 AI 행동 계획을 발표하며 바이든 행정부의 위험 회피적인 AI 정책에서 결정적인 단절을 선언했습니다. 이 야심찬 청사진은 공격적인 인프라 개발, 전면적인 규제 철폐, 강화된 국가 안보 조치, 인공지능 분야에서 중국과의 전략적 경쟁을 우선순위에 두고 있습니다.이러한 정책 변화는 특히 에너지 사용 및 환경 규제와 관련하여 광범

2025년 4월 23일 오후 6시 15분 9초 GMT+09:00

2025년 4월 23일 오후 6시 15분 9초 GMT+09:00

これらの5つのヒントは、AIを使用する人にとって非常に役立ちます!安全性と効率性をカバーしており、これは重要です。唯一の欠点は、いくつかのヒントが少し基本的すぎることですが、全体的には、より良いAI使用のための良いスタート地点です。👍

0

0

2025년 4월 23일 오전 4시 51분 41초 GMT+09:00

2025년 4월 23일 오전 4시 51분 41초 GMT+09:00

このアプリ、AIを安全に使うためのヒントがとても役立つ!使い方が簡単で、AIの使用が安全かつ効率的になった。ただ、もう少し具体的な例が欲しいかな。それでも、毎日AIを使う人には必須のアプリだよ!😊

0

0

2025년 4월 23일 오전 1시 20분 24초 GMT+09:00

2025년 4월 23일 오전 1시 20분 24초 GMT+09:00

Essas 5 dicas são super úteis para quem usa IA! Elas abordam segurança e eficiência, o que é crucial. A única desvantagem é que algumas dicas são um pouco básicas, mas no geral, é um ótimo ponto de partida para um melhor uso da IA. 👍

0

0

2025년 4월 22일 오전 1시 35분 2초 GMT+09:00

2025년 4월 22일 오전 1시 35분 2초 GMT+09:00

These 5 tips are super helpful for anyone using AI! They cover safety and efficiency, which is crucial. The only downside is that some tips are a bit basic, but overall, it's a great starting point for better AI usage. 👍

0

0

2025년 4월 20일 오후 12시 0분 31초 GMT+09:00

2025년 4월 20일 오후 12시 0분 31초 GMT+09:00

Este aplicativo é super útil para usar IA de forma segura! As dicas são rápidas e fáceis de seguir, tornando o uso da IA muito melhor e mais seguro. Gostaria que houvesse mais exemplos detalhados, no entanto. Ainda assim, é essencial para quem usa IA diariamente! 😊

0

0

2025년 4월 18일 오전 1시 51분 12초 GMT+09:00

2025년 4월 18일 오전 1시 51분 12초 GMT+09:00

¡Estos consejos son muy útiles para cualquier persona que se adentre en la IA! Realmente ayudan a asegurar un uso seguro y a obtener los mejores resultados. Ojalá hubieran más ejemplos, pero es un gran comienzo para principiantes. 👍

0

0