Cohere dévoile le modèle AY Vision AY de la meilleure note

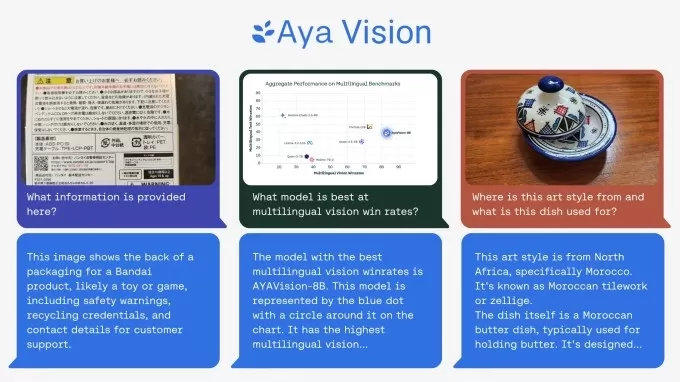

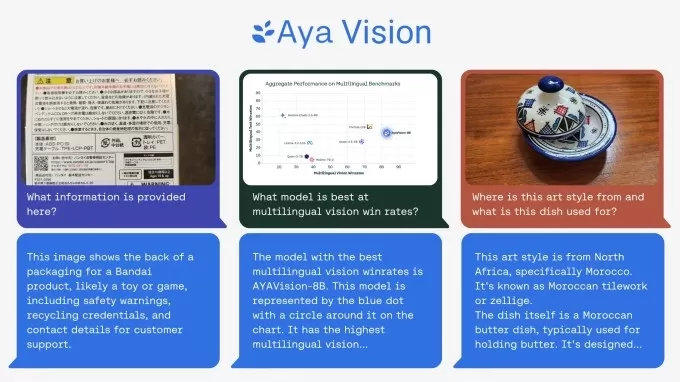

Le laboratoire de recherche à but non lucratif de Cohere vient de lancer un nouveau modèle d'IA multimodal appelé Aya Vision, et ils affirment qu'il est le meilleur de sa catégorie. Ce modèle est assez impressionnant — il peut générer des légendes d'images, répondre à des questions sur des images, traduire du texte, et même résumer du contenu dans 23 langues principales. De plus, Cohere rend Aya Vision disponible gratuitement sur WhatsApp, déclarant que c'est un grand pas vers la mise à disposition de ces avancées technologiques pour les chercheurs du monde entier.

Dans leur article de blog, Cohere a souligné que, bien que l'IA ait fait des progrès, il existe encore un écart important dans la manière dont les modèles gèrent différentes langues, surtout lorsqu'il s'agit de combiner texte et images. C'est là qu'Aya Vision intervient, visant à combler cet écart.

Aya Vision est disponible en deux versions : la plus puissante Aya Vision 32B et la plus légère Aya Vision 8B. La version 32B, selon Cohere, établit une "nouvelle frontière", surpassant des modèles deux fois plus grands, comme le Llama-3.2 90B Vision de Meta, dans certains tests de compréhension visuelle. Et la version 8B ? Elle tient tête à des modèles dix fois plus grands.

Vous pouvez récupérer les deux modèles sur Hugging Face sous une licence Creative Commons 4.0, mais il y a une condition — ils ne sont pas destinés à un usage commercial.

Cohere a entraîné Aya Vision en utilisant un mélange de datasets en anglais, qu'ils ont traduits et transformés en annotations synthétiques. Ces annotations, ou étiquettes, aident le modèle à donner un sens aux données pendant l'entraînement. Par exemple, si vous entraînez un modèle de reconnaissance d'images, vous pourriez utiliser des annotations pour marquer des objets ou ajouter des légendes décrivant ce qui se trouve dans l'image.

Le modèle Aya Vision de Cohere peut effectuer une gamme de tâches de compréhension visuelle. Crédits image : Cohere L'utilisation d'annotations synthétiques est très en vogue en ce moment, même si cela présente des inconvénients. Les grands acteurs comme OpenAI se lancent également dans l'utilisation de données synthétiques, car les données réelles deviennent plus difficiles à obtenir. Gartner estime que l'année dernière, 60 % des données utilisées pour les projets d'IA et d'analyse étaient synthétiques.Cohere affirme que l'entraînement d'Aya Vision sur des annotations synthétiques leur a permis d'utiliser moins de ressources tout en obtenant des résultats de premier ordre. Tout est question d'efficacité et de faire plus avec moins, disent-ils, ce qui est une excellente nouvelle pour les chercheurs qui n'ont pas toujours accès à de grandes ressources de calcul.

Parallèlement à Aya Vision, Cohere a publié une nouvelle suite de benchmarks appelée AyaVisionBench. Elle est conçue pour tester les compétences d'un modèle dans des tâches comme repérer les différences entre des images et transformer des captures d'écran en code.

Le monde de l'IA lutte avec ce que certains appellent une "crise d'évaluation". Les benchmarks habituels donnent un score global qui ne reflète pas vraiment la performance d'un modèle sur les tâches qui importent le plus aux utilisateurs. Cohere pense qu'AyaVisionBench peut aider à résoudre ce problème, offrant un moyen robuste et large de vérifier les compétences multilingues et multimodales d'un modèle.

Espérons qu'ils ont raison. Les chercheurs de Cohere affirment que le dataset est un benchmark solide pour tester les modèles de vision-langage dans des scénarios multilingues et réels. Ils l'ont mis à disposition de la communauté de recherche pour aider à faire avancer les évaluations multimodales multilingues.

Article connexe

Un visage étreint développe une alternative ouverte à l'outil de recherche d'Openai

Une équipe de développeurs de Hugging Face, y compris le co-fondateur et scientifique en chef Thomas Wolf, a créé ce qu'ils appellent une version "ouverte" de l'outil de recherche en profondeur d'Openai. OpenAI a introduit une recherche approfondie lors d'un événement récent, où il a été révélé que l'outil parcourait le Web pour générer des rapports de recherche

Un visage étreint développe une alternative ouverte à l'outil de recherche d'Openai

Une équipe de développeurs de Hugging Face, y compris le co-fondateur et scientifique en chef Thomas Wolf, a créé ce qu'ils appellent une version "ouverte" de l'outil de recherche en profondeur d'Openai. OpenAI a introduit une recherche approfondie lors d'un événement récent, où il a été révélé que l'outil parcourait le Web pour générer des rapports de recherche

L'application Gemini de Google ajoute des vidéos d'IA en temps réel, Deep Research et de nouvelles fonctionnalités (120 chars)

Google a dévoilé d'importantes améliorations de Gemini AI lors de sa conférence des développeurs I/O 2025, en étendant les capacités multimodales, en introduisant des modèles d'IA de nouvelle générati

L'application Gemini de Google ajoute des vidéos d'IA en temps réel, Deep Research et de nouvelles fonctionnalités (120 chars)

Google a dévoilé d'importantes améliorations de Gemini AI lors de sa conférence des développeurs I/O 2025, en étendant les capacités multimodales, en introduisant des modèles d'IA de nouvelle générati

Assort Health obtient un financement de 50 millions de dollars pour automatiser la communication avec les patients

Assort Health, une startup émergente spécialisée dans les communications automatisées avec les patients pour les cabinets spécialisés, a obtenu un financement de série B d'environ 50 millions de dolla

commentaires (43)

0/200

Assort Health obtient un financement de 50 millions de dollars pour automatiser la communication avec les patients

Assort Health, une startup émergente spécialisée dans les communications automatisées avec les patients pour les cabinets spécialisés, a obtenu un financement de série B d'environ 50 millions de dolla

commentaires (43)

0/200

![MarkRoberts]() MarkRoberts

MarkRoberts

4 septembre 2025 06:30:34 UTC+02:00

4 septembre 2025 06:30:34 UTC+02:00

¡Interesante! Aya Vision parece ser un modelo bastante completo con esas capacidades multilingües. Me pregunto qué tan bien funcionará en idiomas menos comunes, sobre todo porque menciona '23 grandes idiomas'. ¿Habrá algún soporte para lenguas indígenas o regionales en el futuro? 🌎

0

0

![KennethMartin]() KennethMartin

KennethMartin

10 août 2025 07:00:59 UTC+02:00

10 août 2025 07:00:59 UTC+02:00

This Aya Vision model sounds like a game-changer! Captioning images and translating in 23 languages? That’s some next-level tech. Can’t wait to see how it stacks up against the big players like OpenAI. 😎

0

0

![PaulKing]() PaulKing

PaulKing

31 juillet 2025 13:35:39 UTC+02:00

31 juillet 2025 13:35:39 UTC+02:00

This Aya Vision model sounds like a game-changer! Being able to handle images and 23 languages is wild—imagine using it to instantly caption my travel photos or summarize foreign articles. Curious how it stacks up against other AI models in real-world tasks. 😎

0

0

![JackMartinez]() JackMartinez

JackMartinez

21 avril 2025 03:32:08 UTC+02:00

21 avril 2025 03:32:08 UTC+02:00

Aya Vision es increíblemente útil. Lo utilizo para mis proyectos de diseño y me encanta cómo genera descripciones de imágenes. Aunque a veces se equivoca con los detalles, en general es muy preciso. ¡Lo recomiendo totalmente! 🌟

0

0

![WilliamYoung]() WilliamYoung

WilliamYoung

20 avril 2025 02:58:05 UTC+02:00

20 avril 2025 02:58:05 UTC+02:00

Aya Vision ist echt cool, aber es hat manchmal Schwierigkeiten mit der Übersetzung. Trotzdem ist es eine tolle Hilfe für meine Arbeit. Es könnte etwas schneller sein, aber insgesamt bin ich zufrieden. 👍

0

0

![StevenGonzalez]() StevenGonzalez

StevenGonzalez

19 avril 2025 20:53:55 UTC+02:00

19 avril 2025 20:53:55 UTC+02:00

아야 비전은 멋지지만 완벽하지는 않아요. 이미지 캡션은 정확하지만 번역이 때때로 틀릴 때가 있어요. 그래도 빠른 요약을 위한 좋은 도구예요! 👍

0

0

Le laboratoire de recherche à but non lucratif de Cohere vient de lancer un nouveau modèle d'IA multimodal appelé Aya Vision, et ils affirment qu'il est le meilleur de sa catégorie. Ce modèle est assez impressionnant — il peut générer des légendes d'images, répondre à des questions sur des images, traduire du texte, et même résumer du contenu dans 23 langues principales. De plus, Cohere rend Aya Vision disponible gratuitement sur WhatsApp, déclarant que c'est un grand pas vers la mise à disposition de ces avancées technologiques pour les chercheurs du monde entier.

Dans leur article de blog, Cohere a souligné que, bien que l'IA ait fait des progrès, il existe encore un écart important dans la manière dont les modèles gèrent différentes langues, surtout lorsqu'il s'agit de combiner texte et images. C'est là qu'Aya Vision intervient, visant à combler cet écart.

Aya Vision est disponible en deux versions : la plus puissante Aya Vision 32B et la plus légère Aya Vision 8B. La version 32B, selon Cohere, établit une "nouvelle frontière", surpassant des modèles deux fois plus grands, comme le Llama-3.2 90B Vision de Meta, dans certains tests de compréhension visuelle. Et la version 8B ? Elle tient tête à des modèles dix fois plus grands.

Vous pouvez récupérer les deux modèles sur Hugging Face sous une licence Creative Commons 4.0, mais il y a une condition — ils ne sont pas destinés à un usage commercial.

Cohere a entraîné Aya Vision en utilisant un mélange de datasets en anglais, qu'ils ont traduits et transformés en annotations synthétiques. Ces annotations, ou étiquettes, aident le modèle à donner un sens aux données pendant l'entraînement. Par exemple, si vous entraînez un modèle de reconnaissance d'images, vous pourriez utiliser des annotations pour marquer des objets ou ajouter des légendes décrivant ce qui se trouve dans l'image.

Cohere affirme que l'entraînement d'Aya Vision sur des annotations synthétiques leur a permis d'utiliser moins de ressources tout en obtenant des résultats de premier ordre. Tout est question d'efficacité et de faire plus avec moins, disent-ils, ce qui est une excellente nouvelle pour les chercheurs qui n'ont pas toujours accès à de grandes ressources de calcul.

Parallèlement à Aya Vision, Cohere a publié une nouvelle suite de benchmarks appelée AyaVisionBench. Elle est conçue pour tester les compétences d'un modèle dans des tâches comme repérer les différences entre des images et transformer des captures d'écran en code.

Le monde de l'IA lutte avec ce que certains appellent une "crise d'évaluation". Les benchmarks habituels donnent un score global qui ne reflète pas vraiment la performance d'un modèle sur les tâches qui importent le plus aux utilisateurs. Cohere pense qu'AyaVisionBench peut aider à résoudre ce problème, offrant un moyen robuste et large de vérifier les compétences multilingues et multimodales d'un modèle.

Espérons qu'ils ont raison. Les chercheurs de Cohere affirment que le dataset est un benchmark solide pour tester les modèles de vision-langage dans des scénarios multilingues et réels. Ils l'ont mis à disposition de la communauté de recherche pour aider à faire avancer les évaluations multimodales multilingues.

Un visage étreint développe une alternative ouverte à l'outil de recherche d'Openai

Une équipe de développeurs de Hugging Face, y compris le co-fondateur et scientifique en chef Thomas Wolf, a créé ce qu'ils appellent une version "ouverte" de l'outil de recherche en profondeur d'Openai. OpenAI a introduit une recherche approfondie lors d'un événement récent, où il a été révélé que l'outil parcourait le Web pour générer des rapports de recherche

Un visage étreint développe une alternative ouverte à l'outil de recherche d'Openai

Une équipe de développeurs de Hugging Face, y compris le co-fondateur et scientifique en chef Thomas Wolf, a créé ce qu'ils appellent une version "ouverte" de l'outil de recherche en profondeur d'Openai. OpenAI a introduit une recherche approfondie lors d'un événement récent, où il a été révélé que l'outil parcourait le Web pour générer des rapports de recherche

Assort Health obtient un financement de 50 millions de dollars pour automatiser la communication avec les patients

Assort Health, une startup émergente spécialisée dans les communications automatisées avec les patients pour les cabinets spécialisés, a obtenu un financement de série B d'environ 50 millions de dolla

Assort Health obtient un financement de 50 millions de dollars pour automatiser la communication avec les patients

Assort Health, une startup émergente spécialisée dans les communications automatisées avec les patients pour les cabinets spécialisés, a obtenu un financement de série B d'environ 50 millions de dolla

4 septembre 2025 06:30:34 UTC+02:00

4 septembre 2025 06:30:34 UTC+02:00

¡Interesante! Aya Vision parece ser un modelo bastante completo con esas capacidades multilingües. Me pregunto qué tan bien funcionará en idiomas menos comunes, sobre todo porque menciona '23 grandes idiomas'. ¿Habrá algún soporte para lenguas indígenas o regionales en el futuro? 🌎

0

0

10 août 2025 07:00:59 UTC+02:00

10 août 2025 07:00:59 UTC+02:00

This Aya Vision model sounds like a game-changer! Captioning images and translating in 23 languages? That’s some next-level tech. Can’t wait to see how it stacks up against the big players like OpenAI. 😎

0

0

31 juillet 2025 13:35:39 UTC+02:00

31 juillet 2025 13:35:39 UTC+02:00

This Aya Vision model sounds like a game-changer! Being able to handle images and 23 languages is wild—imagine using it to instantly caption my travel photos or summarize foreign articles. Curious how it stacks up against other AI models in real-world tasks. 😎

0

0

21 avril 2025 03:32:08 UTC+02:00

21 avril 2025 03:32:08 UTC+02:00

Aya Vision es increíblemente útil. Lo utilizo para mis proyectos de diseño y me encanta cómo genera descripciones de imágenes. Aunque a veces se equivoca con los detalles, en general es muy preciso. ¡Lo recomiendo totalmente! 🌟

0

0

20 avril 2025 02:58:05 UTC+02:00

20 avril 2025 02:58:05 UTC+02:00

Aya Vision ist echt cool, aber es hat manchmal Schwierigkeiten mit der Übersetzung. Trotzdem ist es eine tolle Hilfe für meine Arbeit. Es könnte etwas schneller sein, aber insgesamt bin ich zufrieden. 👍

0

0

19 avril 2025 20:53:55 UTC+02:00

19 avril 2025 20:53:55 UTC+02:00

아야 비전은 멋지지만 완벽하지는 않아요. 이미지 캡션은 정확하지만 번역이 때때로 틀릴 때가 있어요. 그래도 빠른 요약을 위한 좋은 도구예요! 👍

0

0