Coere revela o modelo Aya Vision AI com melhor classificação

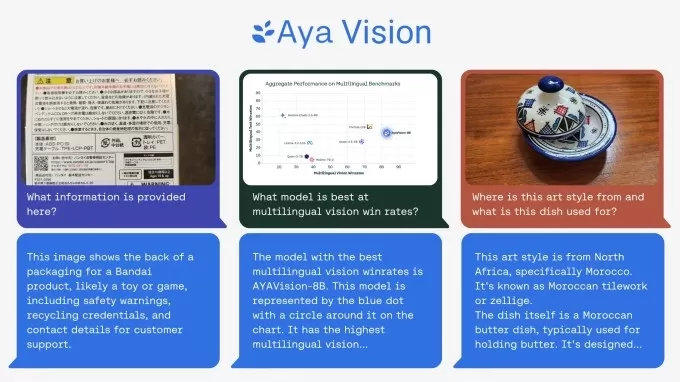

O laboratório de pesquisa sem fins lucrativos da Cohere acaba de lançar um novo modelo de IA multimodal chamado Aya Vision, e eles estão chamando-o de o melhor de sua classe. Este modelo é bastante impressionante — ele pode criar legendas para imagens, responder perguntas sobre fotos, traduzir textos e até resumir conteúdos em 23 idiomas principais. Além disso, a Cohere está disponibilizando o Aya Vision gratuitamente no WhatsApp, dizendo que é um grande passo para colocar essas inovações tecnológicas nas mãos de pesquisadores em todos os lugares.

Em seu post de blog, a Cohere destacou que, embora a IA tenha feito avanços, ainda há uma enorme lacuna na capacidade dos modelos de lidar com diferentes idiomas, especialmente quando se trata de texto e imagens juntos. É aí que o Aya Vision entra, com o objetivo de preencher essa lacuna.

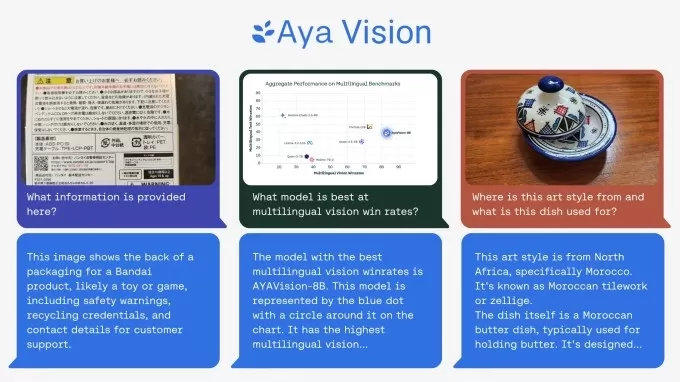

O Aya Vision vem em duas versões: a mais robusta Aya Vision 32B e a mais leve Aya Vision 8B. A versão 32B, segundo a Cohere, está estabelecendo uma "nova fronteira", superando modelos duas vezes maiores, como o Llama-3.2 90B Vision da Meta, em alguns testes de compreensão visual. E a versão 8B? Ela se mantém firme contra modelos dez vezes maiores.

Você pode obter ambos os modelos no Hugging Face sob uma licença Creative Commons 4.0, mas há uma ressalva — eles não são para uso comercial.

A Cohere treinou o Aya Vision usando uma mistura de conjuntos de dados em inglês, que eles traduziram e transformaram em anotações sintéticas. Essas anotações, ou tags, ajudam o modelo a entender os dados durante o treinamento. Por exemplo, se você está treinando um modelo de reconhecimento de imagens, pode usar anotações para marcar objetos ou adicionar legendas sobre o que está na imagem.

O modelo Aya Vision da Cohere pode realizar uma variedade de tarefas de compreensão visual. Créditos da imagem: Cohere O uso de anotações sintéticas está em alta agora, mesmo que tenha suas desvantagens. Grandes players como a OpenAI estão aderindo à onda de dados sintéticos, já que dados do mundo real estão cada vez mais difíceis de obter. A Gartner estima que, no último ano, 60% dos dados usados para projetos de IA e análises foram sintéticos.A Cohere diz que treinar o Aya Vision com anotações sintéticas permitiu que eles usassem menos recursos enquanto ainda obtinham resultados de ponta. Tudo se resume a eficiência e fazer mais com menos, dizem eles, o que é uma ótima notícia para pesquisadores que nem sempre têm acesso a grandes recursos computacionais.

Junto com o Aya Vision, a Cohere lançou uma nova suíte de benchmarks chamada AyaVisionBench. Ela foi projetada para testar as habilidades de um modelo em tarefas como identificar diferenças entre imagens e transformar capturas de tela em código.

O mundo da IA tem enfrentado o que algumas pessoas chamam de "crise de avaliação". Os benchmarks usuais fornecem uma pontuação geral que não reflete realmente o quão bem um modelo desempenha nas tarefas que mais importam para os usuários. A Cohere acredita que o AyaVisionBench pode ajudar a corrigir isso, oferecendo uma maneira rigorosa e ampla de verificar as capacidades multilíngues e multimodais de um modelo.

Tomara que eles estejam certos. Os pesquisadores da Cohere dizem que o conjunto de dados é um benchmark sólido para testar modelos de visão-linguagem em cenários multilíngues e do mundo real. Eles o disponibilizaram para a comunidade de pesquisa para ajudar a avançar as avaliações multimodais multilíngues.

Artigo relacionado

Abraço o rosto desenvolve alternativa aberta à ferramenta de pesquisa do OpenAI

Uma equipe de desenvolvedores da Hugging Face, incluindo o co-fundador e cientista-chefe Thomas Wolf, criou o que eles chamam de uma versão "aberta" da ferramenta de pesquisa profunda do OpenAI. O OpenAI introduziu pesquisas profundas em um evento recente, onde foi revelado que a ferramenta vasculha a web para gerar relatórios de pesquisa

Abraço o rosto desenvolve alternativa aberta à ferramenta de pesquisa do OpenAI

Uma equipe de desenvolvedores da Hugging Face, incluindo o co-fundador e cientista-chefe Thomas Wolf, criou o que eles chamam de uma versão "aberta" da ferramenta de pesquisa profunda do OpenAI. O OpenAI introduziu pesquisas profundas em um evento recente, onde foi revelado que a ferramenta vasculha a web para gerar relatórios de pesquisa

O Google evita vazamentos do Pixel 10 ao revelar oficialmente o smartphone antes do previsto

O Google está provocando os fãs com um vislumbre antecipado de sua próxima linha de smartphones Pixel 10, mostrando o design oficial apenas algumas semanas antes do evento de lançamento programado par

O Google evita vazamentos do Pixel 10 ao revelar oficialmente o smartphone antes do previsto

O Google está provocando os fãs com um vislumbre antecipado de sua próxima linha de smartphones Pixel 10, mostrando o design oficial apenas algumas semanas antes do evento de lançamento programado par

O aplicativo Gemini do Google adiciona vídeo com IA em tempo real, Deep Research e novos recursos (120 caracteres)

O Google revelou melhorias significativas no Gemini AI durante sua conferência de desenvolvedores I/O 2025, expandindo os recursos multimodais, introduzindo modelos de IA de última geração e fortalece

Comentários (43)

0/200

O aplicativo Gemini do Google adiciona vídeo com IA em tempo real, Deep Research e novos recursos (120 caracteres)

O Google revelou melhorias significativas no Gemini AI durante sua conferência de desenvolvedores I/O 2025, expandindo os recursos multimodais, introduzindo modelos de IA de última geração e fortalece

Comentários (43)

0/200

![MarkRoberts]() MarkRoberts

MarkRoberts

4 de Setembro de 2025 à34 05:30:34 WEST

4 de Setembro de 2025 à34 05:30:34 WEST

¡Interesante! Aya Vision parece ser un modelo bastante completo con esas capacidades multilingües. Me pregunto qué tan bien funcionará en idiomas menos comunes, sobre todo porque menciona '23 grandes idiomas'. ¿Habrá algún soporte para lenguas indígenas o regionales en el futuro? 🌎

0

0

![KennethMartin]() KennethMartin

KennethMartin

10 de Agosto de 2025 à59 06:00:59 WEST

10 de Agosto de 2025 à59 06:00:59 WEST

This Aya Vision model sounds like a game-changer! Captioning images and translating in 23 languages? That’s some next-level tech. Can’t wait to see how it stacks up against the big players like OpenAI. 😎

0

0

![PaulKing]() PaulKing

PaulKing

31 de Julho de 2025 à39 12:35:39 WEST

31 de Julho de 2025 à39 12:35:39 WEST

This Aya Vision model sounds like a game-changer! Being able to handle images and 23 languages is wild—imagine using it to instantly caption my travel photos or summarize foreign articles. Curious how it stacks up against other AI models in real-world tasks. 😎

0

0

![JackMartinez]() JackMartinez

JackMartinez

21 de Abril de 2025 à8 02:32:08 WEST

21 de Abril de 2025 à8 02:32:08 WEST

Aya Vision es increíblemente útil. Lo utilizo para mis proyectos de diseño y me encanta cómo genera descripciones de imágenes. Aunque a veces se equivoca con los detalles, en general es muy preciso. ¡Lo recomiendo totalmente! 🌟

0

0

![WilliamYoung]() WilliamYoung

WilliamYoung

20 de Abril de 2025 à5 01:58:05 WEST

20 de Abril de 2025 à5 01:58:05 WEST

Aya Vision ist echt cool, aber es hat manchmal Schwierigkeiten mit der Übersetzung. Trotzdem ist es eine tolle Hilfe für meine Arbeit. Es könnte etwas schneller sein, aber insgesamt bin ich zufrieden. 👍

0

0

![StevenGonzalez]() StevenGonzalez

StevenGonzalez

19 de Abril de 2025 à55 19:53:55 WEST

19 de Abril de 2025 à55 19:53:55 WEST

아야 비전은 멋지지만 완벽하지는 않아요. 이미지 캡션은 정확하지만 번역이 때때로 틀릴 때가 있어요. 그래도 빠른 요약을 위한 좋은 도구예요! 👍

0

0

O laboratório de pesquisa sem fins lucrativos da Cohere acaba de lançar um novo modelo de IA multimodal chamado Aya Vision, e eles estão chamando-o de o melhor de sua classe. Este modelo é bastante impressionante — ele pode criar legendas para imagens, responder perguntas sobre fotos, traduzir textos e até resumir conteúdos em 23 idiomas principais. Além disso, a Cohere está disponibilizando o Aya Vision gratuitamente no WhatsApp, dizendo que é um grande passo para colocar essas inovações tecnológicas nas mãos de pesquisadores em todos os lugares.

Em seu post de blog, a Cohere destacou que, embora a IA tenha feito avanços, ainda há uma enorme lacuna na capacidade dos modelos de lidar com diferentes idiomas, especialmente quando se trata de texto e imagens juntos. É aí que o Aya Vision entra, com o objetivo de preencher essa lacuna.

O Aya Vision vem em duas versões: a mais robusta Aya Vision 32B e a mais leve Aya Vision 8B. A versão 32B, segundo a Cohere, está estabelecendo uma "nova fronteira", superando modelos duas vezes maiores, como o Llama-3.2 90B Vision da Meta, em alguns testes de compreensão visual. E a versão 8B? Ela se mantém firme contra modelos dez vezes maiores.

Você pode obter ambos os modelos no Hugging Face sob uma licença Creative Commons 4.0, mas há uma ressalva — eles não são para uso comercial.

A Cohere treinou o Aya Vision usando uma mistura de conjuntos de dados em inglês, que eles traduziram e transformaram em anotações sintéticas. Essas anotações, ou tags, ajudam o modelo a entender os dados durante o treinamento. Por exemplo, se você está treinando um modelo de reconhecimento de imagens, pode usar anotações para marcar objetos ou adicionar legendas sobre o que está na imagem.

A Cohere diz que treinar o Aya Vision com anotações sintéticas permitiu que eles usassem menos recursos enquanto ainda obtinham resultados de ponta. Tudo se resume a eficiência e fazer mais com menos, dizem eles, o que é uma ótima notícia para pesquisadores que nem sempre têm acesso a grandes recursos computacionais.

Junto com o Aya Vision, a Cohere lançou uma nova suíte de benchmarks chamada AyaVisionBench. Ela foi projetada para testar as habilidades de um modelo em tarefas como identificar diferenças entre imagens e transformar capturas de tela em código.

O mundo da IA tem enfrentado o que algumas pessoas chamam de "crise de avaliação". Os benchmarks usuais fornecem uma pontuação geral que não reflete realmente o quão bem um modelo desempenha nas tarefas que mais importam para os usuários. A Cohere acredita que o AyaVisionBench pode ajudar a corrigir isso, oferecendo uma maneira rigorosa e ampla de verificar as capacidades multilíngues e multimodais de um modelo.

Tomara que eles estejam certos. Os pesquisadores da Cohere dizem que o conjunto de dados é um benchmark sólido para testar modelos de visão-linguagem em cenários multilíngues e do mundo real. Eles o disponibilizaram para a comunidade de pesquisa para ajudar a avançar as avaliações multimodais multilíngues.

Abraço o rosto desenvolve alternativa aberta à ferramenta de pesquisa do OpenAI

Uma equipe de desenvolvedores da Hugging Face, incluindo o co-fundador e cientista-chefe Thomas Wolf, criou o que eles chamam de uma versão "aberta" da ferramenta de pesquisa profunda do OpenAI. O OpenAI introduziu pesquisas profundas em um evento recente, onde foi revelado que a ferramenta vasculha a web para gerar relatórios de pesquisa

Abraço o rosto desenvolve alternativa aberta à ferramenta de pesquisa do OpenAI

Uma equipe de desenvolvedores da Hugging Face, incluindo o co-fundador e cientista-chefe Thomas Wolf, criou o que eles chamam de uma versão "aberta" da ferramenta de pesquisa profunda do OpenAI. O OpenAI introduziu pesquisas profundas em um evento recente, onde foi revelado que a ferramenta vasculha a web para gerar relatórios de pesquisa

O Google evita vazamentos do Pixel 10 ao revelar oficialmente o smartphone antes do previsto

O Google está provocando os fãs com um vislumbre antecipado de sua próxima linha de smartphones Pixel 10, mostrando o design oficial apenas algumas semanas antes do evento de lançamento programado par

O Google evita vazamentos do Pixel 10 ao revelar oficialmente o smartphone antes do previsto

O Google está provocando os fãs com um vislumbre antecipado de sua próxima linha de smartphones Pixel 10, mostrando o design oficial apenas algumas semanas antes do evento de lançamento programado par

4 de Setembro de 2025 à34 05:30:34 WEST

4 de Setembro de 2025 à34 05:30:34 WEST

¡Interesante! Aya Vision parece ser un modelo bastante completo con esas capacidades multilingües. Me pregunto qué tan bien funcionará en idiomas menos comunes, sobre todo porque menciona '23 grandes idiomas'. ¿Habrá algún soporte para lenguas indígenas o regionales en el futuro? 🌎

0

0

10 de Agosto de 2025 à59 06:00:59 WEST

10 de Agosto de 2025 à59 06:00:59 WEST

This Aya Vision model sounds like a game-changer! Captioning images and translating in 23 languages? That’s some next-level tech. Can’t wait to see how it stacks up against the big players like OpenAI. 😎

0

0

31 de Julho de 2025 à39 12:35:39 WEST

31 de Julho de 2025 à39 12:35:39 WEST

This Aya Vision model sounds like a game-changer! Being able to handle images and 23 languages is wild—imagine using it to instantly caption my travel photos or summarize foreign articles. Curious how it stacks up against other AI models in real-world tasks. 😎

0

0

21 de Abril de 2025 à8 02:32:08 WEST

21 de Abril de 2025 à8 02:32:08 WEST

Aya Vision es increíblemente útil. Lo utilizo para mis proyectos de diseño y me encanta cómo genera descripciones de imágenes. Aunque a veces se equivoca con los detalles, en general es muy preciso. ¡Lo recomiendo totalmente! 🌟

0

0

20 de Abril de 2025 à5 01:58:05 WEST

20 de Abril de 2025 à5 01:58:05 WEST

Aya Vision ist echt cool, aber es hat manchmal Schwierigkeiten mit der Übersetzung. Trotzdem ist es eine tolle Hilfe für meine Arbeit. Es könnte etwas schneller sein, aber insgesamt bin ich zufrieden. 👍

0

0

19 de Abril de 2025 à55 19:53:55 WEST

19 de Abril de 2025 à55 19:53:55 WEST

아야 비전은 멋지지만 완벽하지는 않아요. 이미지 캡션은 정확하지만 번역이 때때로 틀릴 때가 있어요. 그래도 빠른 요약을 위한 좋은 도구예요! 👍

0

0