Modèles de «raisonnement» AI augmente, entraînant des coûts d'analyse comparative

Les coûts croissants de l'évaluation des modèles d'IA de raisonnement

Les laboratoires d'IA comme OpenAI vantent leurs modèles d'IA avancés de "raisonnement", conçus pour résoudre des problèmes complexes étape par étape. Ces modèles, particulièrement efficaces dans des domaines comme la physique, sont en effet impressionnants. Cependant, ils s'accompagnent d'un coût élevé lorsqu'il s'agit d'évaluation, rendant difficile la vérification indépendante de leurs capacités.

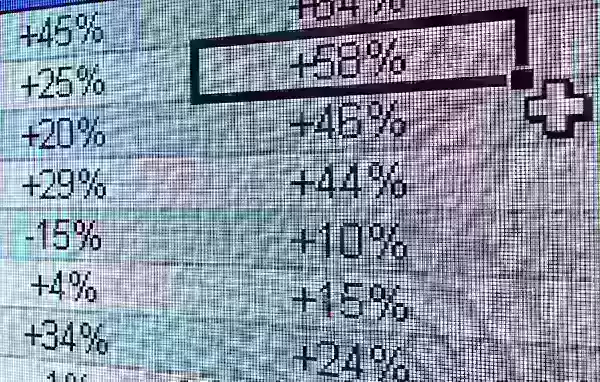

Selon les données d'Artificial Analysis, une entreprise tierce de test d'IA, le coût pour évaluer le modèle de raisonnement o1 d'OpenAI sur sept benchmarks populaires d'IA s'élève à un montant stupéfiant de 2 767,05 $. Ces benchmarks incluent MMLU-Pro, GPQA Diamond, Humanity’s Last Exam, LiveCodeBench, SciCode, AIME 2024 et MATH-500. En comparaison, l'évaluation du modèle de raisonnement "hybride" d'Anthropic, Claude 3.7 Sonnet, sur les mêmes tests a coûté 1 485,35 $, tandis que l'o3-mini-high d'OpenAI était significativement moins cher à 344,59 $.

Tous les modèles de raisonnement ne sont pas aussi coûteux à tester. Par exemple, Artificial Analysis n'a dépensé que 141,22 $ pour évaluer l'o1-mini d'OpenAI. Cependant, les coûts de ces modèles ont tendance à être élevés en moyenne. Artificial Analysis a déboursé environ 5 200 $ pour évaluer une douzaine de modèles de raisonnement, ce qui est presque le double des 2 400 $ dépensés pour analyser plus de 80 modèles non-raisonnants.

À titre de comparaison, le modèle non-raisonnant GPT-4o d'OpenAI, sorti en mai 2024, a coûté à Artificial Analysis seulement 108,85 $ à évaluer, tandis que Claude 3.6 Sonnet, le prédécesseur non-raisonnant de Claude 3.7 Sonnet, a coûté 81,41 $.

George Cameron, co-fondateur d'Artificial Analysis, a partagé avec TechCrunch que l'organisation est prête à augmenter son budget d'évaluation alors que davantage de laboratoires d'IA continuent de développer des modèles de raisonnement. "Chez Artificial Analysis, nous effectuons des centaines d'évaluations mensuelles et consacrons un budget significatif à celles-ci," a déclaré Cameron. "Nous prévoyons que ces dépenses augmenteront à mesure que les modèles sont plus fréquemment publiés."

Artificial Analysis n'est pas seule à faire face à ces coûts croissants. Ross Taylor, PDG de la startup d'IA General Reasoning, a récemment dépensé 580 $ pour évaluer Claude 3.7 Sonnet sur environ 3 700 prompts uniques. Taylor estime qu'une seule exécution de MMLU Pro, un benchmark conçu pour tester la compréhension du langage, dépasserait 1 800 $.

Taylor a souligné une préoccupation croissante dans un récent post sur X, déclarant : "Nous évoluons vers un monde où un laboratoire rapporte x% sur un benchmark où il dépense y montant de calcul, mais où les ressources pour les universitaires sont

Pourquoi les modèles de raisonnement sont-ils si coûteux à évaluer ?

La principale raison du coût élevé des tests des modèles de raisonnement est leur tendance à générer un grand nombre de tokens. Les tokens sont des unités de texte brut ; par exemple, le mot "fantastique" pourrait être décomposé en "fan", "tas" et "tique". Selon Artificial Analysis, le modèle o1 d'OpenAI a généré plus de 44 millions de tokens lors de leurs tests, ce qui est environ huit fois le nombre de tokens générés par le modèle non-raisonnant GPT-4o.

La plupart des entreprises d'IA facturent l'utilisation des modèles en fonction du nombre de tokens, ce qui s'additionne rapidement. De plus, les benchmarks modernes sont conçus pour susciter un grand nombre de tokens en incluant des questions qui impliquent des tâches complexes en plusieurs étapes. Jean-Stanislas Denain, chercheur senior chez Epoch AI, a expliqué à TechCrunch : "Les benchmarks actuels sont plus complexes même si le nombre de questions par benchmark a globalement diminué. Ils tentent souvent d'évaluer la capacité des modèles à effectuer des tâches du monde réel, telles que rédiger et exécuter du code, naviguer sur Internet et utiliser des ordinateurs."

Denain a également souligné que le coût par token pour les modèles les plus coûteux a augmenté. Par exemple, lorsque Claude 3 Opus d'Anthropic est sorti en mai 2024, il coûtait 75 $ par million de tokens de sortie. En revanche, GPT-4.5 et o1-pro d'OpenAI, lancés plus tôt cette année, coûtaient respectivement 150 $ et 600 $ par million de tokens de sortie.

Malgré l'augmentation du coût par token, Denain a noté : "Puisque les modèles se sont améliorés avec le temps, il est toujours vrai que le coût pour atteindre un niveau de performance donné a considérablement diminué au fil du temps. Mais si vous voulez évaluer les meilleurs modèles les plus grands à tout moment, vous payez toujours plus."

L'intégrité de l'évaluation

De nombreux laboratoires d'IA, y compris OpenAI, offrent un accès gratuit ou subventionné à leurs modèles à des fins d'évaluation. Cependant, cette pratique soulève des préoccupations concernant l'intégrité du processus d'évaluation. Même sans preuve de manipulation, la simple suggestion de l'implication d'un laboratoire d'IA peut jeter un doute sur l'objectivité des résultats.

Ross Taylor a exprimé cette préoccupation sur X, demandant : "D'un point de vue scientifique, si vous publiez un résultat que personne ne peut reproduire avec le même modèle, est-ce encore de la science ? (Était-ce jamais de la science, lol)"

Les coûts élevés et les biais potentiels dans l'évaluation de l'IA soulignent les défis auxquels le domaine est confronté alors qu'il s'efforce de développer et de valider des modèles de plus en plus sophistiqués.

Article connexe

Trump exempte les smartphones, les ordinateurs et les puces de la hausse des droits de douane

L'administration Trump a accordé des exclusions pour les smartphones, les ordinateurs et divers appareils électroniques des récentes augmentations tarifaires, même lorsqu'ils sont importés de Chine, s

Trump exempte les smartphones, les ordinateurs et les puces de la hausse des droits de douane

L'administration Trump a accordé des exclusions pour les smartphones, les ordinateurs et divers appareils électroniques des récentes augmentations tarifaires, même lorsqu'ils sont importés de Chine, s

L'IA réimagine Michael Jackson dans le métavers grâce à des transformations numériques stupéfiantes

L'intelligence artificielle est en train de remodeler fondamentalement notre compréhension de la créativité, du divertissement et de l'héritage culturel. Cette exploration des interprétations de Micha

L'IA réimagine Michael Jackson dans le métavers grâce à des transformations numériques stupéfiantes

L'intelligence artificielle est en train de remodeler fondamentalement notre compréhension de la créativité, du divertissement et de l'héritage culturel. Cette exploration des interprétations de Micha

La formation atténue-t-elle les effets de délestage cognitif induits par l'IA ?

Un récent article d'investigation sur Unite.ai intitulé "ChatGPT Might Be Draining Your Brain : La dette cognitive à l'ère de l'IA" a mis en lumière une recherche du MIT. Le journaliste Alex McFarland

commentaires (17)

0/200

La formation atténue-t-elle les effets de délestage cognitif induits par l'IA ?

Un récent article d'investigation sur Unite.ai intitulé "ChatGPT Might Be Draining Your Brain : La dette cognitive à l'ère de l'IA" a mis en lumière une recherche du MIT. Le journaliste Alex McFarland

commentaires (17)

0/200

![FrankJackson]() FrankJackson

FrankJackson

10 août 2025 11:01:00 UTC+02:00

10 août 2025 11:01:00 UTC+02:00

These AI reasoning models are impressive for tackling complex physics problems step by step, but the surging benchmarking costs could stifle innovation for smaller labs. 😟 Reminds me of how tech giants dominate—maybe we need more affordable alternatives?

0

0

![DouglasRodriguez]() DouglasRodriguez

DouglasRodriguez

28 juillet 2025 03:20:21 UTC+02:00

28 juillet 2025 03:20:21 UTC+02:00

These AI reasoning models sound cool, but the skyrocketing benchmarking costs are wild! 😳 Makes me wonder if smaller labs can even keep up with the big players like OpenAI.

0

0

![StevenGonzalez]() StevenGonzalez

StevenGonzalez

24 avril 2025 14:58:05 UTC+02:00

24 avril 2025 14:58:05 UTC+02:00

These AI reasoning models are impressive, but the rising costs of benchmarking are a real bummer. It's great for fields like physics, but I hope they find a way to make it more affordable. Otherwise, it's just for the big players. 😕

0

0

![JackPerez]() JackPerez

JackPerez

24 avril 2025 09:52:48 UTC+02:00

24 avril 2025 09:52:48 UTC+02:00

Esses modelos de raciocínio de IA são impressionantes, mas o aumento dos custos de benchmarking é uma decepção. É ótimo para áreas como a física, mas espero que encontrem uma maneira de torná-lo mais acessível. Caso contrário, será apenas para os grandes jogadores. 😕

0

0

![GregoryJones]() GregoryJones

GregoryJones

24 avril 2025 09:10:43 UTC+02:00

24 avril 2025 09:10:43 UTC+02:00

AI推論モデルは素晴らしいけど、ベンチマーキングのコストが上がるのは残念です。物理分野には良いけど、もっと手頃な価格になる方法を見つけてほしいです。さもないと、大手企業だけのものになってしまいますね。😕

0

0

![SamuelRoberts]() SamuelRoberts

SamuelRoberts

24 avril 2025 06:23:58 UTC+02:00

24 avril 2025 06:23:58 UTC+02:00

Esses modelos de raciocínio de IA parecem legais, mas o aumento dos custos de benchmarking? Não tanto. Será que podemos ter os benefícios sem falir? 🤔

0

0

Les coûts croissants de l'évaluation des modèles d'IA de raisonnement

Les laboratoires d'IA comme OpenAI vantent leurs modèles d'IA avancés de "raisonnement", conçus pour résoudre des problèmes complexes étape par étape. Ces modèles, particulièrement efficaces dans des domaines comme la physique, sont en effet impressionnants. Cependant, ils s'accompagnent d'un coût élevé lorsqu'il s'agit d'évaluation, rendant difficile la vérification indépendante de leurs capacités.

Selon les données d'Artificial Analysis, une entreprise tierce de test d'IA, le coût pour évaluer le modèle de raisonnement o1 d'OpenAI sur sept benchmarks populaires d'IA s'élève à un montant stupéfiant de 2 767,05 $. Ces benchmarks incluent MMLU-Pro, GPQA Diamond, Humanity’s Last Exam, LiveCodeBench, SciCode, AIME 2024 et MATH-500. En comparaison, l'évaluation du modèle de raisonnement "hybride" d'Anthropic, Claude 3.7 Sonnet, sur les mêmes tests a coûté 1 485,35 $, tandis que l'o3-mini-high d'OpenAI était significativement moins cher à 344,59 $.

Tous les modèles de raisonnement ne sont pas aussi coûteux à tester. Par exemple, Artificial Analysis n'a dépensé que 141,22 $ pour évaluer l'o1-mini d'OpenAI. Cependant, les coûts de ces modèles ont tendance à être élevés en moyenne. Artificial Analysis a déboursé environ 5 200 $ pour évaluer une douzaine de modèles de raisonnement, ce qui est presque le double des 2 400 $ dépensés pour analyser plus de 80 modèles non-raisonnants.

À titre de comparaison, le modèle non-raisonnant GPT-4o d'OpenAI, sorti en mai 2024, a coûté à Artificial Analysis seulement 108,85 $ à évaluer, tandis que Claude 3.6 Sonnet, le prédécesseur non-raisonnant de Claude 3.7 Sonnet, a coûté 81,41 $.

George Cameron, co-fondateur d'Artificial Analysis, a partagé avec TechCrunch que l'organisation est prête à augmenter son budget d'évaluation alors que davantage de laboratoires d'IA continuent de développer des modèles de raisonnement. "Chez Artificial Analysis, nous effectuons des centaines d'évaluations mensuelles et consacrons un budget significatif à celles-ci," a déclaré Cameron. "Nous prévoyons que ces dépenses augmenteront à mesure que les modèles sont plus fréquemment publiés."

Artificial Analysis n'est pas seule à faire face à ces coûts croissants. Ross Taylor, PDG de la startup d'IA General Reasoning, a récemment dépensé 580 $ pour évaluer Claude 3.7 Sonnet sur environ 3 700 prompts uniques. Taylor estime qu'une seule exécution de MMLU Pro, un benchmark conçu pour tester la compréhension du langage, dépasserait 1 800 $.

Taylor a souligné une préoccupation croissante dans un récent post sur X, déclarant : "Nous évoluons vers un monde où un laboratoire rapporte x% sur un benchmark où il dépense y montant de calcul, mais où les ressources pour les universitaires sont

Pourquoi les modèles de raisonnement sont-ils si coûteux à évaluer ?

La principale raison du coût élevé des tests des modèles de raisonnement est leur tendance à générer un grand nombre de tokens. Les tokens sont des unités de texte brut ; par exemple, le mot "fantastique" pourrait être décomposé en "fan", "tas" et "tique". Selon Artificial Analysis, le modèle o1 d'OpenAI a généré plus de 44 millions de tokens lors de leurs tests, ce qui est environ huit fois le nombre de tokens générés par le modèle non-raisonnant GPT-4o.

La plupart des entreprises d'IA facturent l'utilisation des modèles en fonction du nombre de tokens, ce qui s'additionne rapidement. De plus, les benchmarks modernes sont conçus pour susciter un grand nombre de tokens en incluant des questions qui impliquent des tâches complexes en plusieurs étapes. Jean-Stanislas Denain, chercheur senior chez Epoch AI, a expliqué à TechCrunch : "Les benchmarks actuels sont plus complexes même si le nombre de questions par benchmark a globalement diminué. Ils tentent souvent d'évaluer la capacité des modèles à effectuer des tâches du monde réel, telles que rédiger et exécuter du code, naviguer sur Internet et utiliser des ordinateurs."

Denain a également souligné que le coût par token pour les modèles les plus coûteux a augmenté. Par exemple, lorsque Claude 3 Opus d'Anthropic est sorti en mai 2024, il coûtait 75 $ par million de tokens de sortie. En revanche, GPT-4.5 et o1-pro d'OpenAI, lancés plus tôt cette année, coûtaient respectivement 150 $ et 600 $ par million de tokens de sortie.

Malgré l'augmentation du coût par token, Denain a noté : "Puisque les modèles se sont améliorés avec le temps, il est toujours vrai que le coût pour atteindre un niveau de performance donné a considérablement diminué au fil du temps. Mais si vous voulez évaluer les meilleurs modèles les plus grands à tout moment, vous payez toujours plus."

L'intégrité de l'évaluation

De nombreux laboratoires d'IA, y compris OpenAI, offrent un accès gratuit ou subventionné à leurs modèles à des fins d'évaluation. Cependant, cette pratique soulève des préoccupations concernant l'intégrité du processus d'évaluation. Même sans preuve de manipulation, la simple suggestion de l'implication d'un laboratoire d'IA peut jeter un doute sur l'objectivité des résultats.

Ross Taylor a exprimé cette préoccupation sur X, demandant : "D'un point de vue scientifique, si vous publiez un résultat que personne ne peut reproduire avec le même modèle, est-ce encore de la science ? (Était-ce jamais de la science, lol)"

Les coûts élevés et les biais potentiels dans l'évaluation de l'IA soulignent les défis auxquels le domaine est confronté alors qu'il s'efforce de développer et de valider des modèles de plus en plus sophistiqués.

Trump exempte les smartphones, les ordinateurs et les puces de la hausse des droits de douane

L'administration Trump a accordé des exclusions pour les smartphones, les ordinateurs et divers appareils électroniques des récentes augmentations tarifaires, même lorsqu'ils sont importés de Chine, s

Trump exempte les smartphones, les ordinateurs et les puces de la hausse des droits de douane

L'administration Trump a accordé des exclusions pour les smartphones, les ordinateurs et divers appareils électroniques des récentes augmentations tarifaires, même lorsqu'ils sont importés de Chine, s

L'IA réimagine Michael Jackson dans le métavers grâce à des transformations numériques stupéfiantes

L'intelligence artificielle est en train de remodeler fondamentalement notre compréhension de la créativité, du divertissement et de l'héritage culturel. Cette exploration des interprétations de Micha

L'IA réimagine Michael Jackson dans le métavers grâce à des transformations numériques stupéfiantes

L'intelligence artificielle est en train de remodeler fondamentalement notre compréhension de la créativité, du divertissement et de l'héritage culturel. Cette exploration des interprétations de Micha

La formation atténue-t-elle les effets de délestage cognitif induits par l'IA ?

Un récent article d'investigation sur Unite.ai intitulé "ChatGPT Might Be Draining Your Brain : La dette cognitive à l'ère de l'IA" a mis en lumière une recherche du MIT. Le journaliste Alex McFarland

La formation atténue-t-elle les effets de délestage cognitif induits par l'IA ?

Un récent article d'investigation sur Unite.ai intitulé "ChatGPT Might Be Draining Your Brain : La dette cognitive à l'ère de l'IA" a mis en lumière une recherche du MIT. Le journaliste Alex McFarland

10 août 2025 11:01:00 UTC+02:00

10 août 2025 11:01:00 UTC+02:00

These AI reasoning models are impressive for tackling complex physics problems step by step, but the surging benchmarking costs could stifle innovation for smaller labs. 😟 Reminds me of how tech giants dominate—maybe we need more affordable alternatives?

0

0

28 juillet 2025 03:20:21 UTC+02:00

28 juillet 2025 03:20:21 UTC+02:00

These AI reasoning models sound cool, but the skyrocketing benchmarking costs are wild! 😳 Makes me wonder if smaller labs can even keep up with the big players like OpenAI.

0

0

24 avril 2025 14:58:05 UTC+02:00

24 avril 2025 14:58:05 UTC+02:00

These AI reasoning models are impressive, but the rising costs of benchmarking are a real bummer. It's great for fields like physics, but I hope they find a way to make it more affordable. Otherwise, it's just for the big players. 😕

0

0

24 avril 2025 09:52:48 UTC+02:00

24 avril 2025 09:52:48 UTC+02:00

Esses modelos de raciocínio de IA são impressionantes, mas o aumento dos custos de benchmarking é uma decepção. É ótimo para áreas como a física, mas espero que encontrem uma maneira de torná-lo mais acessível. Caso contrário, será apenas para os grandes jogadores. 😕

0

0

24 avril 2025 09:10:43 UTC+02:00

24 avril 2025 09:10:43 UTC+02:00

AI推論モデルは素晴らしいけど、ベンチマーキングのコストが上がるのは残念です。物理分野には良いけど、もっと手頃な価格になる方法を見つけてほしいです。さもないと、大手企業だけのものになってしまいますね。😕

0

0

24 avril 2025 06:23:58 UTC+02:00

24 avril 2025 06:23:58 UTC+02:00

Esses modelos de raciocínio de IA parecem legais, mas o aumento dos custos de benchmarking? Não tanto. Será que podemos ter os benefícios sem falir? 🤔

0

0