Os modelos de 'raciocínio' da IA surgem, aumentando os custos de benchmarking

O Crescente Custo de Avaliação de Modelos de Raciocínio de IA

Laboratórios de IA como a OpenAI têm promovido seus modelos avançados de "raciocínio", projetados para abordar problemas complexos passo a passo. Esses modelos, particularmente eficazes em áreas como física, são de fato impressionantes. No entanto, eles vêm com um preço elevado quando se trata de avaliação, tornando desafiadora a verificação independente de suas capacidades.

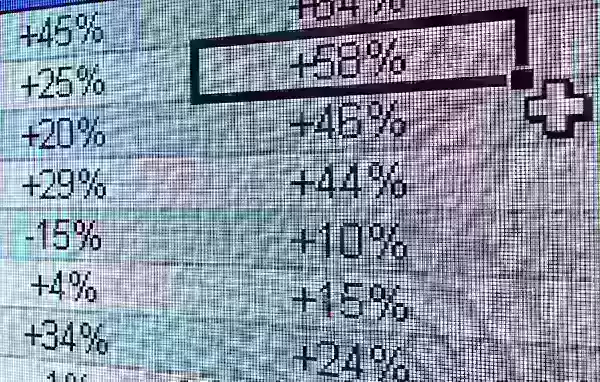

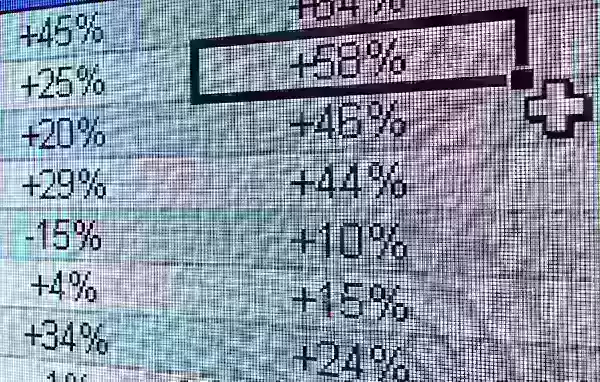

De acordo com dados da Artificial Analysis, uma empresa terceirizada de testes de IA, o custo para avaliar o modelo de raciocínio o1 da OpenAI em sete benchmarks populares de IA é impressionante: $2.767,05. Esses benchmarks incluem MMLU-Pro, GPQA Diamond, Humanity’s Last Exam, LiveCodeBench, SciCode, AIME 2024 e MATH-500. Em contrapartida, a avaliação do modelo de raciocínio "híbrido" Claude 3.7 Sonnet da Anthropic nos mesmos testes custou $1.485,35, enquanto o o3-mini-high da OpenAI foi significativamente mais barato, custando $344,59.

Nem todos os modelos de raciocínio são igualmente caros para testar. Por exemplo, a Artificial Analysis gastou apenas $141,22 avaliando o o1-mini da OpenAI. No entanto, os custos desses modelos tendem a ser altos em média. A Artificial Analysis desembolsou cerca de $5.200 para avaliar cerca de uma dúzia de modelos de raciocínio, o que é quase o dobro dos $2.400 gastos na análise de mais de 80 modelos não voltados para raciocínio.

Para comparação, o modelo não voltado para raciocínio GPT-4o da OpenAI, lançado em maio de 2024, custou à Artificial Analysis apenas $108,85 para ser avaliado, enquanto o Claude 3.6 Sonnet, antecessor não voltado para raciocínio do Claude 3.7 Sonnet, custou $81,41.

George Cameron, cofundador da Artificial Analysis, compartilhou com a TechCrunch que a organização está preparada para aumentar seu orçamento de avaliação à medida que mais laboratórios de IA continuam a desenvolver modelos de raciocínio. "Na Artificial Analysis, realizamos centenas de avaliações mensalmente e dedicamos um orçamento significativo a isso", afirmou Cameron. "Estamos planejando aumentar esse gasto à medida que os modelos são lançados com mais frequência."

A Artificial Analysis não está sozinha enfrentando esses custos crescentes. Ross Taylor, CEO da startup de IA General Reasoning, gastou recentemente $580 para avaliar o Claude 3.7 Sonnet em cerca de 3.700 prompts únicos. Taylor estima que uma única execução do MMLU Pro, um benchmark projetado para testar a compreensão de linguagem, excederia $1.800.

Taylor destacou uma preocupação crescente em um post recente no X, afirmando: "Estamos caminhando para um mundo onde um laboratório relata x% em um benchmark onde gastam y quantidade de computação, mas onde os recursos para acadêmicos são

Por Que os Modelos de Raciocínio São Tão Caros para Avaliar?

A principal razão para o alto custo de teste dos modelos de raciocínio é sua tendência a gerar um número substancial de tokens. Tokens são unidades de texto bruto; por exemplo, a palavra "fantástico" pode ser dividida em "fan", "tas" e "tic". De acordo com a Artificial Analysis, o modelo o1 da OpenAI gerou mais de 44 milhões de tokens durante seus testes, o que é aproximadamente oito vezes o número de tokens gerados pelo modelo não voltado para raciocínio GPT-4o.

A maioria das empresas de IA cobra pelo uso do modelo com base no número de tokens, o que rapidamente se acumula. Além disso, os benchmarks modernos são projetados para elicitar um alto número de tokens ao incluir perguntas que envolvem tarefas complexas e de várias etapas. Jean-Stanislas Denain, pesquisador sênior da Epoch AI, explicou à TechCrunch: "Os benchmarks de hoje são mais complexos, embora o número de perguntas por benchmark tenha diminuído no geral. Eles frequentemente tentam avaliar a capacidade dos modelos de realizar tarefas do mundo real, como escrever e executar código, navegar na internet e usar computadores."

Denain também destacou que o custo por token para os modelos mais caros tem aumentado. Por exemplo, quando o Claude 3 Opus da Anthropic foi lançado em maio de 2024, custava $75 por milhão de tokens de saída. Em contrapartida, o GPT-4.5 e o o1-pro da OpenAI, lançados no início daquele ano, custavam $150 e $600 por milhão de tokens de saída, respectivamente.

Apesar do aumento do custo por token, Denain observou: "Como os modelos melhoraram ao longo do tempo, ainda é verdade que o custo para alcançar um determinado nível de desempenho diminuiu significativamente. Mas se você deseja avaliar os melhores e maiores modelos em qualquer momento, ainda está pagando mais."

A Integridade da Avaliação

Muitos laboratórios de IA, incluindo a OpenAI, oferecem acesso gratuito ou subsidiado aos seus modelos para fins de avaliação. No entanto, essa prática levanta preocupações sobre a integridade do processo de avaliação. Mesmo sem evidências de manipulação, a mera sugestão de envolvimento de um laboratório de IA pode lançar dúvidas sobre a objetividade dos resultados.

Ross Taylor expressou essa preocupação no X, perguntando: "Do ponto de vista científico, se você publica um resultado que ninguém pode replicar com o mesmo modelo, isso ainda é ciência? (Alguma vez foi ciência, rs)"

Os altos custos e os potenciais vieses na avaliação de IA destacam os desafios enfrentados pelo campo à medida que ele se esforça para desenvolver e validar modelos cada vez mais sofisticados.

Artigo relacionado

Trump isenta smartphones, computadores e chips de aumentos de tarifas

O governo Trump concedeu exclusões para smartphones, computadores e vários dispositivos eletrônicos dos recentes aumentos de tarifas, mesmo quando importados da China, de acordo com informações da Blo

Trump isenta smartphones, computadores e chips de aumentos de tarifas

O governo Trump concedeu exclusões para smartphones, computadores e vários dispositivos eletrônicos dos recentes aumentos de tarifas, mesmo quando importados da China, de acordo com informações da Blo

A IA reimagina Michael Jackson no Metaverso com transformações digitais impressionantes

A inteligência artificial está reformulando fundamentalmente nossa compreensão da criatividade, do entretenimento e do legado cultural. Esta exploração das interpretações de Michael Jackson geradas po

A IA reimagina Michael Jackson no Metaverso com transformações digitais impressionantes

A inteligência artificial está reformulando fundamentalmente nossa compreensão da criatividade, do entretenimento e do legado cultural. Esta exploração das interpretações de Michael Jackson geradas po

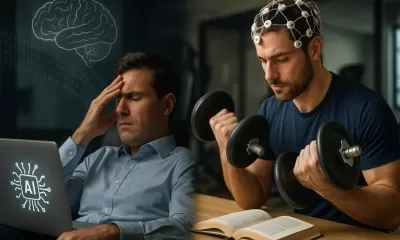

O treinamento atenua os efeitos da descarga cognitiva induzida pela IA?

Um artigo investigativo recente no Unite.ai intitulado "ChatGPT pode estar drenando seu cérebro: Cognitive Debt in the AI Era" (Dívida Cognitiva na Era da IA) esclareceu uma pesquisa do MIT sobre o as

Comentários (17)

0/200

O treinamento atenua os efeitos da descarga cognitiva induzida pela IA?

Um artigo investigativo recente no Unite.ai intitulado "ChatGPT pode estar drenando seu cérebro: Cognitive Debt in the AI Era" (Dívida Cognitiva na Era da IA) esclareceu uma pesquisa do MIT sobre o as

Comentários (17)

0/200

![FrankJackson]() FrankJackson

FrankJackson

10 de Agosto de 2025 à0 10:01:00 WEST

10 de Agosto de 2025 à0 10:01:00 WEST

These AI reasoning models are impressive for tackling complex physics problems step by step, but the surging benchmarking costs could stifle innovation for smaller labs. 😟 Reminds me of how tech giants dominate—maybe we need more affordable alternatives?

0

0

![DouglasRodriguez]() DouglasRodriguez

DouglasRodriguez

28 de Julho de 2025 à21 02:20:21 WEST

28 de Julho de 2025 à21 02:20:21 WEST

These AI reasoning models sound cool, but the skyrocketing benchmarking costs are wild! 😳 Makes me wonder if smaller labs can even keep up with the big players like OpenAI.

0

0

![StevenGonzalez]() StevenGonzalez

StevenGonzalez

24 de Abril de 2025 à5 13:58:05 WEST

24 de Abril de 2025 à5 13:58:05 WEST

These AI reasoning models are impressive, but the rising costs of benchmarking are a real bummer. It's great for fields like physics, but I hope they find a way to make it more affordable. Otherwise, it's just for the big players. 😕

0

0

![JackPerez]() JackPerez

JackPerez

24 de Abril de 2025 à48 08:52:48 WEST

24 de Abril de 2025 à48 08:52:48 WEST

Esses modelos de raciocínio de IA são impressionantes, mas o aumento dos custos de benchmarking é uma decepção. É ótimo para áreas como a física, mas espero que encontrem uma maneira de torná-lo mais acessível. Caso contrário, será apenas para os grandes jogadores. 😕

0

0

![GregoryJones]() GregoryJones

GregoryJones

24 de Abril de 2025 à43 08:10:43 WEST

24 de Abril de 2025 à43 08:10:43 WEST

AI推論モデルは素晴らしいけど、ベンチマーキングのコストが上がるのは残念です。物理分野には良いけど、もっと手頃な価格になる方法を見つけてほしいです。さもないと、大手企業だけのものになってしまいますね。😕

0

0

![SamuelRoberts]() SamuelRoberts

SamuelRoberts

24 de Abril de 2025 à58 05:23:58 WEST

24 de Abril de 2025 à58 05:23:58 WEST

Esses modelos de raciocínio de IA parecem legais, mas o aumento dos custos de benchmarking? Não tanto. Será que podemos ter os benefícios sem falir? 🤔

0

0

O Crescente Custo de Avaliação de Modelos de Raciocínio de IA

Laboratórios de IA como a OpenAI têm promovido seus modelos avançados de "raciocínio", projetados para abordar problemas complexos passo a passo. Esses modelos, particularmente eficazes em áreas como física, são de fato impressionantes. No entanto, eles vêm com um preço elevado quando se trata de avaliação, tornando desafiadora a verificação independente de suas capacidades.

De acordo com dados da Artificial Analysis, uma empresa terceirizada de testes de IA, o custo para avaliar o modelo de raciocínio o1 da OpenAI em sete benchmarks populares de IA é impressionante: $2.767,05. Esses benchmarks incluem MMLU-Pro, GPQA Diamond, Humanity’s Last Exam, LiveCodeBench, SciCode, AIME 2024 e MATH-500. Em contrapartida, a avaliação do modelo de raciocínio "híbrido" Claude 3.7 Sonnet da Anthropic nos mesmos testes custou $1.485,35, enquanto o o3-mini-high da OpenAI foi significativamente mais barato, custando $344,59.

Nem todos os modelos de raciocínio são igualmente caros para testar. Por exemplo, a Artificial Analysis gastou apenas $141,22 avaliando o o1-mini da OpenAI. No entanto, os custos desses modelos tendem a ser altos em média. A Artificial Analysis desembolsou cerca de $5.200 para avaliar cerca de uma dúzia de modelos de raciocínio, o que é quase o dobro dos $2.400 gastos na análise de mais de 80 modelos não voltados para raciocínio.

Para comparação, o modelo não voltado para raciocínio GPT-4o da OpenAI, lançado em maio de 2024, custou à Artificial Analysis apenas $108,85 para ser avaliado, enquanto o Claude 3.6 Sonnet, antecessor não voltado para raciocínio do Claude 3.7 Sonnet, custou $81,41.

George Cameron, cofundador da Artificial Analysis, compartilhou com a TechCrunch que a organização está preparada para aumentar seu orçamento de avaliação à medida que mais laboratórios de IA continuam a desenvolver modelos de raciocínio. "Na Artificial Analysis, realizamos centenas de avaliações mensalmente e dedicamos um orçamento significativo a isso", afirmou Cameron. "Estamos planejando aumentar esse gasto à medida que os modelos são lançados com mais frequência."

A Artificial Analysis não está sozinha enfrentando esses custos crescentes. Ross Taylor, CEO da startup de IA General Reasoning, gastou recentemente $580 para avaliar o Claude 3.7 Sonnet em cerca de 3.700 prompts únicos. Taylor estima que uma única execução do MMLU Pro, um benchmark projetado para testar a compreensão de linguagem, excederia $1.800.

Taylor destacou uma preocupação crescente em um post recente no X, afirmando: "Estamos caminhando para um mundo onde um laboratório relata x% em um benchmark onde gastam y quantidade de computação, mas onde os recursos para acadêmicos são

Por Que os Modelos de Raciocínio São Tão Caros para Avaliar?

A principal razão para o alto custo de teste dos modelos de raciocínio é sua tendência a gerar um número substancial de tokens. Tokens são unidades de texto bruto; por exemplo, a palavra "fantástico" pode ser dividida em "fan", "tas" e "tic". De acordo com a Artificial Analysis, o modelo o1 da OpenAI gerou mais de 44 milhões de tokens durante seus testes, o que é aproximadamente oito vezes o número de tokens gerados pelo modelo não voltado para raciocínio GPT-4o.

A maioria das empresas de IA cobra pelo uso do modelo com base no número de tokens, o que rapidamente se acumula. Além disso, os benchmarks modernos são projetados para elicitar um alto número de tokens ao incluir perguntas que envolvem tarefas complexas e de várias etapas. Jean-Stanislas Denain, pesquisador sênior da Epoch AI, explicou à TechCrunch: "Os benchmarks de hoje são mais complexos, embora o número de perguntas por benchmark tenha diminuído no geral. Eles frequentemente tentam avaliar a capacidade dos modelos de realizar tarefas do mundo real, como escrever e executar código, navegar na internet e usar computadores."

Denain também destacou que o custo por token para os modelos mais caros tem aumentado. Por exemplo, quando o Claude 3 Opus da Anthropic foi lançado em maio de 2024, custava $75 por milhão de tokens de saída. Em contrapartida, o GPT-4.5 e o o1-pro da OpenAI, lançados no início daquele ano, custavam $150 e $600 por milhão de tokens de saída, respectivamente.

Apesar do aumento do custo por token, Denain observou: "Como os modelos melhoraram ao longo do tempo, ainda é verdade que o custo para alcançar um determinado nível de desempenho diminuiu significativamente. Mas se você deseja avaliar os melhores e maiores modelos em qualquer momento, ainda está pagando mais."

A Integridade da Avaliação

Muitos laboratórios de IA, incluindo a OpenAI, oferecem acesso gratuito ou subsidiado aos seus modelos para fins de avaliação. No entanto, essa prática levanta preocupações sobre a integridade do processo de avaliação. Mesmo sem evidências de manipulação, a mera sugestão de envolvimento de um laboratório de IA pode lançar dúvidas sobre a objetividade dos resultados.

Ross Taylor expressou essa preocupação no X, perguntando: "Do ponto de vista científico, se você publica um resultado que ninguém pode replicar com o mesmo modelo, isso ainda é ciência? (Alguma vez foi ciência, rs)"

Os altos custos e os potenciais vieses na avaliação de IA destacam os desafios enfrentados pelo campo à medida que ele se esforça para desenvolver e validar modelos cada vez mais sofisticados.

Trump isenta smartphones, computadores e chips de aumentos de tarifas

O governo Trump concedeu exclusões para smartphones, computadores e vários dispositivos eletrônicos dos recentes aumentos de tarifas, mesmo quando importados da China, de acordo com informações da Blo

Trump isenta smartphones, computadores e chips de aumentos de tarifas

O governo Trump concedeu exclusões para smartphones, computadores e vários dispositivos eletrônicos dos recentes aumentos de tarifas, mesmo quando importados da China, de acordo com informações da Blo

A IA reimagina Michael Jackson no Metaverso com transformações digitais impressionantes

A inteligência artificial está reformulando fundamentalmente nossa compreensão da criatividade, do entretenimento e do legado cultural. Esta exploração das interpretações de Michael Jackson geradas po

A IA reimagina Michael Jackson no Metaverso com transformações digitais impressionantes

A inteligência artificial está reformulando fundamentalmente nossa compreensão da criatividade, do entretenimento e do legado cultural. Esta exploração das interpretações de Michael Jackson geradas po

O treinamento atenua os efeitos da descarga cognitiva induzida pela IA?

Um artigo investigativo recente no Unite.ai intitulado "ChatGPT pode estar drenando seu cérebro: Cognitive Debt in the AI Era" (Dívida Cognitiva na Era da IA) esclareceu uma pesquisa do MIT sobre o as

O treinamento atenua os efeitos da descarga cognitiva induzida pela IA?

Um artigo investigativo recente no Unite.ai intitulado "ChatGPT pode estar drenando seu cérebro: Cognitive Debt in the AI Era" (Dívida Cognitiva na Era da IA) esclareceu uma pesquisa do MIT sobre o as

10 de Agosto de 2025 à0 10:01:00 WEST

10 de Agosto de 2025 à0 10:01:00 WEST

These AI reasoning models are impressive for tackling complex physics problems step by step, but the surging benchmarking costs could stifle innovation for smaller labs. 😟 Reminds me of how tech giants dominate—maybe we need more affordable alternatives?

0

0

28 de Julho de 2025 à21 02:20:21 WEST

28 de Julho de 2025 à21 02:20:21 WEST

These AI reasoning models sound cool, but the skyrocketing benchmarking costs are wild! 😳 Makes me wonder if smaller labs can even keep up with the big players like OpenAI.

0

0

24 de Abril de 2025 à5 13:58:05 WEST

24 de Abril de 2025 à5 13:58:05 WEST

These AI reasoning models are impressive, but the rising costs of benchmarking are a real bummer. It's great for fields like physics, but I hope they find a way to make it more affordable. Otherwise, it's just for the big players. 😕

0

0

24 de Abril de 2025 à48 08:52:48 WEST

24 de Abril de 2025 à48 08:52:48 WEST

Esses modelos de raciocínio de IA são impressionantes, mas o aumento dos custos de benchmarking é uma decepção. É ótimo para áreas como a física, mas espero que encontrem uma maneira de torná-lo mais acessível. Caso contrário, será apenas para os grandes jogadores. 😕

0

0

24 de Abril de 2025 à43 08:10:43 WEST

24 de Abril de 2025 à43 08:10:43 WEST

AI推論モデルは素晴らしいけど、ベンチマーキングのコストが上がるのは残念です。物理分野には良いけど、もっと手頃な価格になる方法を見つけてほしいです。さもないと、大手企業だけのものになってしまいますね。😕

0

0

24 de Abril de 2025 à58 05:23:58 WEST

24 de Abril de 2025 à58 05:23:58 WEST

Esses modelos de raciocínio de IA parecem legais, mas o aumento dos custos de benchmarking? Não tanto. Será que podemos ter os benefícios sem falir? 🤔

0

0