KI -Argumentationsmodelle steigen und steigen die Benchmarking -Kosten an

Die steigenden Kosten für das Benchmarking von KI-Reasoning-Modellen

KI-Labore wie OpenAI haben ihre fortschrittlichen „Reasoning“-KI-Modelle beworben, die darauf ausgelegt sind, komplexe Probleme Schritt für Schritt zu lösen. Diese Modelle, die insbesondere in Bereichen wie der Physik effektiv sind, sind in der Tat beeindruckend. Allerdings sind sie mit einem hohen Preis verbunden, wenn es um das Benchmarking geht, was eine unabhängige Überprüfung ihrer Fähigkeiten erschwert.

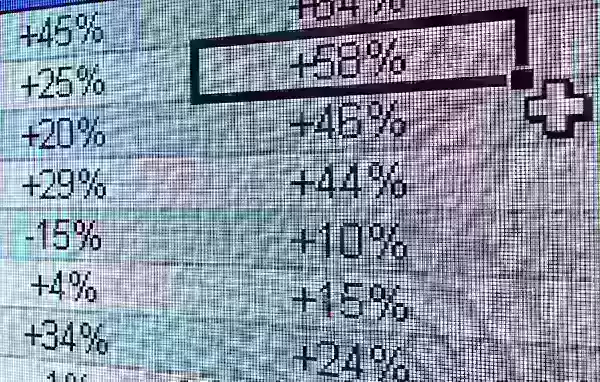

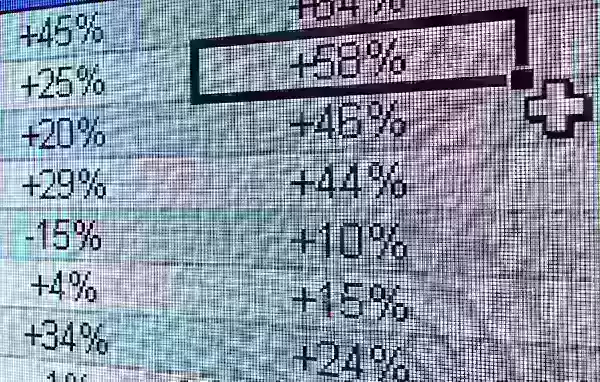

Laut Daten von Artificial Analysis, einem unabhängigen KI-Testunternehmen, belaufen sich die Kosten für die Bewertung des o1-Reasoning-Modells von OpenAI über sieben populäre KI-Benchmarks auf erstaunliche 2.767,05 $. Diese Benchmarks umfassen MMLU-Pro, GPQA Diamond, Humanity’s Last Exam, LiveCodeBench, SciCode, AIME 2024 und MATH-500. Im Vergleich dazu kostete das Benchmarking des „hybriden“ Reasoning-Modells Claude 3.7 Sonnet von Anthropic bei denselben Tests 1.485,35 $, während OpenAIs o3-mini-high deutlich günstiger war mit 344,59 $.

Nicht alle Reasoning-Modelle sind gleich teuer zu testen. Zum Beispiel gab Artificial Analysis nur 141,22 $ aus, um OpenAIs o1-mini zu bewerten. Allerdings sind die Kosten für diese Modelle im Durchschnitt hoch. Artificial Analysis hat rund 5.200 $ ausgegeben, um etwa ein Dutzend Reasoning-Modelle zu bewerten, was fast das Doppelte der 2.400 $ ist, die für die Analyse von über 80 Nicht-Reasoning-Modellen ausgegeben wurden.

Zum Vergleich kostete das Nicht-Reasoning-Modell GPT-4o von OpenAI, das im Mai 2024 veröffentlicht wurde, Artificial Analysis nur 108,85 $ für die Bewertung, während Claude 3.6 Sonnet, der Nicht-Reasoning-Vorgänger von Claude 3.7 Sonnet, 81,41 $ kostete.

George Cameron, Mitbegründer von Artificial Analysis, teilte TechCrunch mit, dass die Organisation bereit ist, ihr Benchmarking-Budget zu erhöhen, da immer mehr KI-Labore Reasoning-Modelle entwickeln. „Bei Artificial Analysis führen wir monatlich Hunderte von Bewertungen durch und widmen diesen einen erheblichen Budgetanteil“, erklärte Cameron. „Wir planen, diese Ausgaben zu erhöhen, da Modelle häufiger veröffentlicht werden.“

Artificial Analysis ist nicht allein mit diesen steigenden Kosten konfrontiert. Ross Taylor, CEO des KI-Startups General Reasoning, gab kürzlich 580 $ aus, um Claude 3.7 Sonnet an etwa 3.700 einzigartigen Prompts zu bewerten. Taylor schätzt, dass eine einzige Durchführung von MMLU Pro, einem Benchmark zur Überprüfung des Sprachverständnisses, über 1.800 $ kosten würde.

Taylor betonte in einem kürzlichen Beitrag auf X eine wachsende Besorgnis: „Wir bewegen uns auf eine Welt zu, in der ein Labor x% bei einem Benchmark meldet, bei dem sie y Rechenleistung ausgeben, aber die Ressourcen für Akademiker

Warum sind Reasoning-Modelle so teuer im Benchmarking?

Der Hauptgrund für die hohen Kosten beim Testen von Reasoning-Modellen ist ihre Tendenz, eine erhebliche Anzahl von Token zu generieren. Token sind Einheiten von Rohtext; zum Beispiel könnte das Wort „fantastisch“ in „fan“, „tas“ und „tic“ zerlegt werden. Laut Artificial Analysis generierte das o1-Modell von OpenAI während ihrer Tests über 44 Millionen Token, was ungefähr das Achtfache der Token-Anzahl ist, die vom Nicht-Reasoning-Modell GPT-4o generiert wurde.

Die meisten KI-Unternehmen berechnen die Modellnutzung basierend auf der Anzahl der Token, was sich schnell summiert. Zudem sind moderne Benchmarks darauf ausgelegt, eine hohe Anzahl von Token hervorzurufen, indem sie Fragen enthalten, die komplexe, mehrstufige Aufgaben beinhalten. Jean-Stanislas Denain, ein leitender Forscher bei Epoch AI, erklärte TechCrunch: „Die heutigen Benchmarks sind komplexer, obwohl die Anzahl der Fragen pro Benchmark insgesamt abgenommen hat. Sie versuchen oft, die Fähigkeit von Modellen zu bewerten, reale Aufgaben wie das Schreiben und Ausführen von Code, das Surfen im Internet und die Nutzung von Computern durchzuführen.“

Denain wies auch darauf hin, dass die Kosten pro Token für die teuersten Modelle gestiegen sind. Zum Beispiel kostete Anthropics Claude 3 Opus bei seiner Veröffentlichung im Mai 2024 75 $ pro Million Ausgabe-Token. Im Gegensatz dazu kosteten OpenAIs GPT-4.5 und o1-pro, die früher im selben Jahr auf den Markt kamen, jeweils 150 $ und 600 $ pro Million Ausgabe-Token.

Trotz der steigenden Kosten pro Token stellte Denain fest: „Da die Modelle mit der Zeit besser geworden sind, ist es immer noch wahr, dass die Kosten, um ein bestimmtes Leistungsniveau zu erreichen, im Laufe der Zeit stark gesunken sind. Aber wenn Sie die besten größten Modelle zu einem bestimmten Zeitpunkt bewerten wollen, zahlen Sie immer noch mehr.“

Die Integrität des Benchmarkings

Viele KI-Labore, einschließlich OpenAI, bieten kostenlosen oder subventionierten Zugang zu ihren Modellen für Benchmarking-Zwecke an. Diese Praxis wirft jedoch Bedenken hinsichtlich der Integrität des Bewertungsprozesses auf. Selbst ohne Beweise für Manipulation kann der bloße Hinweis auf die Beteiligung eines KI-Labors Zweifel an der Objektivität der Ergebnisse aufwerfen.

Ross Taylor äußerte diese Besorgnis auf X und fragte: „Aus wissenschaftlicher Sicht, wenn Sie ein Ergebnis veröffentlichen, das niemand mit demselben Modell replizieren kann, ist das überhaupt noch Wissenschaft? (War es jemals Wissenschaft, lol)“

Die hohen Kosten und potenziellen Verzerrungen beim KI-Benchmarking unterstreichen die Herausforderungen, denen sich das Feld gegenübersieht, während es bestrebt ist, immer ausgefeiltere Modelle zu entwickeln und zu validieren.

Verwandter Artikel

USA verhängen Sanktionen gegen ausländische Beamte wegen Social-Media-Vorschriften

USA stellen sich gegen globale Regelungen für digitale InhalteDas US-Außenministerium hat diese Woche eine scharfe diplomatische Rüge gegen die europäische Politik zur Kontrolle digitaler Inhalte au

USA verhängen Sanktionen gegen ausländische Beamte wegen Social-Media-Vorschriften

USA stellen sich gegen globale Regelungen für digitale InhalteDas US-Außenministerium hat diese Woche eine scharfe diplomatische Rüge gegen die europäische Politik zur Kontrolle digitaler Inhalte au

Ultimativer Leitfaden für KI-gestützte YouTube-Videozusammenfassungen

In unserer informationsreichen digitalen Landschaft sind KI-gestützte YouTube-Videozusammenfassungen für den effizienten Konsum von Inhalten unverzichtbar geworden. Dieser ausführliche Leitfaden zeigt

Ultimativer Leitfaden für KI-gestützte YouTube-Videozusammenfassungen

In unserer informationsreichen digitalen Landschaft sind KI-gestützte YouTube-Videozusammenfassungen für den effizienten Konsum von Inhalten unverzichtbar geworden. Dieser ausführliche Leitfaden zeigt

Atlassian erwirbt The Browser Company für 610 Millionen Dollar, um Entwickler-Tools zu verbessern

Atlassian, der führende Anbieter von Unternehmensproduktivitätssoftware, hat Pläne zur Übernahme des innovativen Browser-Entwicklers The Browser Company im Rahmen einer bar bezahlten Transaktion im We

Kommentare (17)

0/200

Atlassian erwirbt The Browser Company für 610 Millionen Dollar, um Entwickler-Tools zu verbessern

Atlassian, der führende Anbieter von Unternehmensproduktivitätssoftware, hat Pläne zur Übernahme des innovativen Browser-Entwicklers The Browser Company im Rahmen einer bar bezahlten Transaktion im We

Kommentare (17)

0/200

![FrankJackson]() FrankJackson

FrankJackson

10. August 2025 11:01:00 MESZ

10. August 2025 11:01:00 MESZ

These AI reasoning models are impressive for tackling complex physics problems step by step, but the surging benchmarking costs could stifle innovation for smaller labs. 😟 Reminds me of how tech giants dominate—maybe we need more affordable alternatives?

0

0

![DouglasRodriguez]() DouglasRodriguez

DouglasRodriguez

28. Juli 2025 03:20:21 MESZ

28. Juli 2025 03:20:21 MESZ

These AI reasoning models sound cool, but the skyrocketing benchmarking costs are wild! 😳 Makes me wonder if smaller labs can even keep up with the big players like OpenAI.

0

0

![StevenGonzalez]() StevenGonzalez

StevenGonzalez

24. April 2025 14:58:05 MESZ

24. April 2025 14:58:05 MESZ

These AI reasoning models are impressive, but the rising costs of benchmarking are a real bummer. It's great for fields like physics, but I hope they find a way to make it more affordable. Otherwise, it's just for the big players. 😕

0

0

![JackPerez]() JackPerez

JackPerez

24. April 2025 09:52:48 MESZ

24. April 2025 09:52:48 MESZ

Esses modelos de raciocínio de IA são impressionantes, mas o aumento dos custos de benchmarking é uma decepção. É ótimo para áreas como a física, mas espero que encontrem uma maneira de torná-lo mais acessível. Caso contrário, será apenas para os grandes jogadores. 😕

0

0

![GregoryJones]() GregoryJones

GregoryJones

24. April 2025 09:10:43 MESZ

24. April 2025 09:10:43 MESZ

AI推論モデルは素晴らしいけど、ベンチマーキングのコストが上がるのは残念です。物理分野には良いけど、もっと手頃な価格になる方法を見つけてほしいです。さもないと、大手企業だけのものになってしまいますね。😕

0

0

![SamuelRoberts]() SamuelRoberts

SamuelRoberts

24. April 2025 06:23:58 MESZ

24. April 2025 06:23:58 MESZ

Esses modelos de raciocínio de IA parecem legais, mas o aumento dos custos de benchmarking? Não tanto. Será que podemos ter os benefícios sem falir? 🤔

0

0

Die steigenden Kosten für das Benchmarking von KI-Reasoning-Modellen

KI-Labore wie OpenAI haben ihre fortschrittlichen „Reasoning“-KI-Modelle beworben, die darauf ausgelegt sind, komplexe Probleme Schritt für Schritt zu lösen. Diese Modelle, die insbesondere in Bereichen wie der Physik effektiv sind, sind in der Tat beeindruckend. Allerdings sind sie mit einem hohen Preis verbunden, wenn es um das Benchmarking geht, was eine unabhängige Überprüfung ihrer Fähigkeiten erschwert.

Laut Daten von Artificial Analysis, einem unabhängigen KI-Testunternehmen, belaufen sich die Kosten für die Bewertung des o1-Reasoning-Modells von OpenAI über sieben populäre KI-Benchmarks auf erstaunliche 2.767,05 $. Diese Benchmarks umfassen MMLU-Pro, GPQA Diamond, Humanity’s Last Exam, LiveCodeBench, SciCode, AIME 2024 und MATH-500. Im Vergleich dazu kostete das Benchmarking des „hybriden“ Reasoning-Modells Claude 3.7 Sonnet von Anthropic bei denselben Tests 1.485,35 $, während OpenAIs o3-mini-high deutlich günstiger war mit 344,59 $.

Nicht alle Reasoning-Modelle sind gleich teuer zu testen. Zum Beispiel gab Artificial Analysis nur 141,22 $ aus, um OpenAIs o1-mini zu bewerten. Allerdings sind die Kosten für diese Modelle im Durchschnitt hoch. Artificial Analysis hat rund 5.200 $ ausgegeben, um etwa ein Dutzend Reasoning-Modelle zu bewerten, was fast das Doppelte der 2.400 $ ist, die für die Analyse von über 80 Nicht-Reasoning-Modellen ausgegeben wurden.

Zum Vergleich kostete das Nicht-Reasoning-Modell GPT-4o von OpenAI, das im Mai 2024 veröffentlicht wurde, Artificial Analysis nur 108,85 $ für die Bewertung, während Claude 3.6 Sonnet, der Nicht-Reasoning-Vorgänger von Claude 3.7 Sonnet, 81,41 $ kostete.

George Cameron, Mitbegründer von Artificial Analysis, teilte TechCrunch mit, dass die Organisation bereit ist, ihr Benchmarking-Budget zu erhöhen, da immer mehr KI-Labore Reasoning-Modelle entwickeln. „Bei Artificial Analysis führen wir monatlich Hunderte von Bewertungen durch und widmen diesen einen erheblichen Budgetanteil“, erklärte Cameron. „Wir planen, diese Ausgaben zu erhöhen, da Modelle häufiger veröffentlicht werden.“

Artificial Analysis ist nicht allein mit diesen steigenden Kosten konfrontiert. Ross Taylor, CEO des KI-Startups General Reasoning, gab kürzlich 580 $ aus, um Claude 3.7 Sonnet an etwa 3.700 einzigartigen Prompts zu bewerten. Taylor schätzt, dass eine einzige Durchführung von MMLU Pro, einem Benchmark zur Überprüfung des Sprachverständnisses, über 1.800 $ kosten würde.

Taylor betonte in einem kürzlichen Beitrag auf X eine wachsende Besorgnis: „Wir bewegen uns auf eine Welt zu, in der ein Labor x% bei einem Benchmark meldet, bei dem sie y Rechenleistung ausgeben, aber die Ressourcen für Akademiker

Warum sind Reasoning-Modelle so teuer im Benchmarking?

Der Hauptgrund für die hohen Kosten beim Testen von Reasoning-Modellen ist ihre Tendenz, eine erhebliche Anzahl von Token zu generieren. Token sind Einheiten von Rohtext; zum Beispiel könnte das Wort „fantastisch“ in „fan“, „tas“ und „tic“ zerlegt werden. Laut Artificial Analysis generierte das o1-Modell von OpenAI während ihrer Tests über 44 Millionen Token, was ungefähr das Achtfache der Token-Anzahl ist, die vom Nicht-Reasoning-Modell GPT-4o generiert wurde.

Die meisten KI-Unternehmen berechnen die Modellnutzung basierend auf der Anzahl der Token, was sich schnell summiert. Zudem sind moderne Benchmarks darauf ausgelegt, eine hohe Anzahl von Token hervorzurufen, indem sie Fragen enthalten, die komplexe, mehrstufige Aufgaben beinhalten. Jean-Stanislas Denain, ein leitender Forscher bei Epoch AI, erklärte TechCrunch: „Die heutigen Benchmarks sind komplexer, obwohl die Anzahl der Fragen pro Benchmark insgesamt abgenommen hat. Sie versuchen oft, die Fähigkeit von Modellen zu bewerten, reale Aufgaben wie das Schreiben und Ausführen von Code, das Surfen im Internet und die Nutzung von Computern durchzuführen.“

Denain wies auch darauf hin, dass die Kosten pro Token für die teuersten Modelle gestiegen sind. Zum Beispiel kostete Anthropics Claude 3 Opus bei seiner Veröffentlichung im Mai 2024 75 $ pro Million Ausgabe-Token. Im Gegensatz dazu kosteten OpenAIs GPT-4.5 und o1-pro, die früher im selben Jahr auf den Markt kamen, jeweils 150 $ und 600 $ pro Million Ausgabe-Token.

Trotz der steigenden Kosten pro Token stellte Denain fest: „Da die Modelle mit der Zeit besser geworden sind, ist es immer noch wahr, dass die Kosten, um ein bestimmtes Leistungsniveau zu erreichen, im Laufe der Zeit stark gesunken sind. Aber wenn Sie die besten größten Modelle zu einem bestimmten Zeitpunkt bewerten wollen, zahlen Sie immer noch mehr.“

Die Integrität des Benchmarkings

Viele KI-Labore, einschließlich OpenAI, bieten kostenlosen oder subventionierten Zugang zu ihren Modellen für Benchmarking-Zwecke an. Diese Praxis wirft jedoch Bedenken hinsichtlich der Integrität des Bewertungsprozesses auf. Selbst ohne Beweise für Manipulation kann der bloße Hinweis auf die Beteiligung eines KI-Labors Zweifel an der Objektivität der Ergebnisse aufwerfen.

Ross Taylor äußerte diese Besorgnis auf X und fragte: „Aus wissenschaftlicher Sicht, wenn Sie ein Ergebnis veröffentlichen, das niemand mit demselben Modell replizieren kann, ist das überhaupt noch Wissenschaft? (War es jemals Wissenschaft, lol)“

Die hohen Kosten und potenziellen Verzerrungen beim KI-Benchmarking unterstreichen die Herausforderungen, denen sich das Feld gegenübersieht, während es bestrebt ist, immer ausgefeiltere Modelle zu entwickeln und zu validieren.

USA verhängen Sanktionen gegen ausländische Beamte wegen Social-Media-Vorschriften

USA stellen sich gegen globale Regelungen für digitale InhalteDas US-Außenministerium hat diese Woche eine scharfe diplomatische Rüge gegen die europäische Politik zur Kontrolle digitaler Inhalte au

USA verhängen Sanktionen gegen ausländische Beamte wegen Social-Media-Vorschriften

USA stellen sich gegen globale Regelungen für digitale InhalteDas US-Außenministerium hat diese Woche eine scharfe diplomatische Rüge gegen die europäische Politik zur Kontrolle digitaler Inhalte au

Ultimativer Leitfaden für KI-gestützte YouTube-Videozusammenfassungen

In unserer informationsreichen digitalen Landschaft sind KI-gestützte YouTube-Videozusammenfassungen für den effizienten Konsum von Inhalten unverzichtbar geworden. Dieser ausführliche Leitfaden zeigt

Ultimativer Leitfaden für KI-gestützte YouTube-Videozusammenfassungen

In unserer informationsreichen digitalen Landschaft sind KI-gestützte YouTube-Videozusammenfassungen für den effizienten Konsum von Inhalten unverzichtbar geworden. Dieser ausführliche Leitfaden zeigt

Atlassian erwirbt The Browser Company für 610 Millionen Dollar, um Entwickler-Tools zu verbessern

Atlassian, der führende Anbieter von Unternehmensproduktivitätssoftware, hat Pläne zur Übernahme des innovativen Browser-Entwicklers The Browser Company im Rahmen einer bar bezahlten Transaktion im We

Atlassian erwirbt The Browser Company für 610 Millionen Dollar, um Entwickler-Tools zu verbessern

Atlassian, der führende Anbieter von Unternehmensproduktivitätssoftware, hat Pläne zur Übernahme des innovativen Browser-Entwicklers The Browser Company im Rahmen einer bar bezahlten Transaktion im We

10. August 2025 11:01:00 MESZ

10. August 2025 11:01:00 MESZ

These AI reasoning models are impressive for tackling complex physics problems step by step, but the surging benchmarking costs could stifle innovation for smaller labs. 😟 Reminds me of how tech giants dominate—maybe we need more affordable alternatives?

0

0

28. Juli 2025 03:20:21 MESZ

28. Juli 2025 03:20:21 MESZ

These AI reasoning models sound cool, but the skyrocketing benchmarking costs are wild! 😳 Makes me wonder if smaller labs can even keep up with the big players like OpenAI.

0

0

24. April 2025 14:58:05 MESZ

24. April 2025 14:58:05 MESZ

These AI reasoning models are impressive, but the rising costs of benchmarking are a real bummer. It's great for fields like physics, but I hope they find a way to make it more affordable. Otherwise, it's just for the big players. 😕

0

0

24. April 2025 09:52:48 MESZ

24. April 2025 09:52:48 MESZ

Esses modelos de raciocínio de IA são impressionantes, mas o aumento dos custos de benchmarking é uma decepção. É ótimo para áreas como a física, mas espero que encontrem uma maneira de torná-lo mais acessível. Caso contrário, será apenas para os grandes jogadores. 😕

0

0

24. April 2025 09:10:43 MESZ

24. April 2025 09:10:43 MESZ

AI推論モデルは素晴らしいけど、ベンチマーキングのコストが上がるのは残念です。物理分野には良いけど、もっと手頃な価格になる方法を見つけてほしいです。さもないと、大手企業だけのものになってしまいますね。😕

0

0

24. April 2025 06:23:58 MESZ

24. April 2025 06:23:58 MESZ

Esses modelos de raciocínio de IA parecem legais, mas o aumento dos custos de benchmarking? Não tanto. Será que podemos ter os benefícios sem falir? 🤔

0

0