人工智能“推理”模型激增,推动了基准成本

人工智能推理模型基准测试成本的上升

像OpenAI这样的人工智能实验室一直在宣传其先进的“推理”人工智能模型,这些模型旨在逐步解决复杂问题。这些模型在物理学等领域尤其有效,确实令人印象深刻。然而,在基准测试方面,它们的成本极高,这使得独立验证其能力变得具有挑战性。

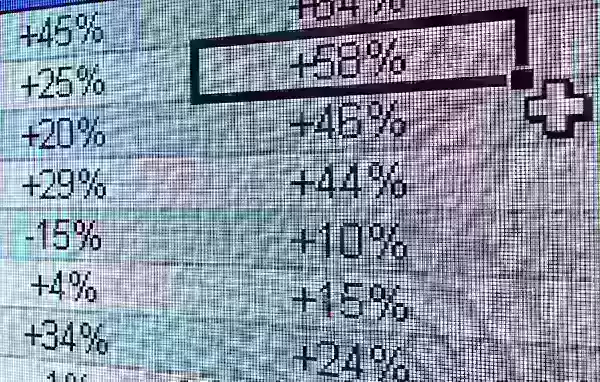

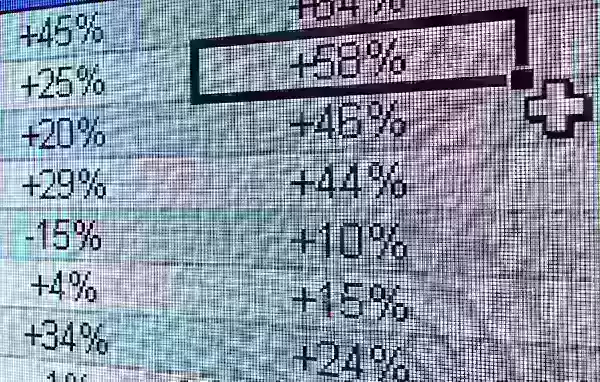

根据第三方人工智能测试公司Artificial Analysis的数据,评估OpenAI的o1推理模型在七个热门人工智能基准测试中的成本高达2767.05美元。这些基准测试包括MMLU-Pro、GPQA Diamond、Humanity’s Last Exam、LiveCodeBench、SciCode、AIME 2024和MATH-500。相比之下,测试Anthropic的“混合”推理模型Claude 3.7 Sonnet在相同测试中的成本为1485.35美元,而OpenAI的o3-mini-high则显著便宜,仅为344.59美元。

并非所有推理模型的测试成本都同样高昂。例如,Artificial Analysis仅花费141.22美元评估OpenAI的o1-mini。然而,这些模型的测试成本平均较高。Artificial Analysis为评估大约十二个推理模型花费了约5200美元,这几乎是分析超过80个非推理模型所花费的2400美元的两倍。

相比之下,OpenAI于2024年5月发布的非推理GPT-4o模型,Artificial Analysis仅花费108.85美元进行评估,而Claude 3.6 Sonnet(Claude 3.7 Sonnet的非推理前身)成本为81.41美元。

Artificial Analysis的联合创始人George Cameron在接受TechCrunch采访时表示,该组织准备随着更多人工智能实验室继续开发推理模型而增加其基准测试预算。Cameron表示:“在Artificial Analysis,我们每月进行数百次评估,并为此投入了大量预算。我们计划随着模型更频繁发布而增加这部分支出。”

Artificial Analysis并非唯一面临这些成本上升的公司。人工智能初创公司General Reasoning的首席执行官Ross Taylor最近花费580美元在约3700个独特提示上评估Claude 3.7 Sonnet。Taylor估计,仅运行一次MMLU Pro(一个旨在测试语言理解能力的基准测试)就将超过1800美元。

Taylor在X上最近的一篇帖子中强调了一个日益增长的担忧,他表示:“我们正在走向一个世界,实验室报告某个基准测试的x%成绩,他们花费了y数量的计算资源,但学术界的资源远远少于y。没有人能够重现这些结果。”

为什么推理模型的基准测试成本如此高昂?

测试推理模型成本高的主要原因是它们倾向于生成大量令牌。令牌是原始文本的单位;例如,单词“fantastic”可能被分解为“fan”、“tas”和“tic”。据Artificial Analysis称,OpenAI的o1模型在测试中生成了超过4400万个令牌,约为非推理GPT-4o模型生成令牌数的八倍。

大多数人工智能公司根据令牌数量收费,这很快就会累积。此外,现代基准测试通过包含涉及复杂多步骤任务的问题,设计为诱导生成大量令牌。Epoch AI的资深研究员Jean-Stanislas Denain向TechCrunch解释说:“今天的基准测试更加复杂,尽管每个基准测试的问题数量总体减少。它们通常试图评估模型执行现实世界任务的能力,例如编写和执行代码、浏览互联网和使用计算机。”

Denain还指出,最昂贵模型的每令牌成本一直在上升。例如,Anthropic的Claude 3 Opus于2024年5月发布时,每百万输出令牌的成本为75美元。相比之下,OpenAI的GPT-4.5和o1-pro在同年早些时候发布时,每百万输出令牌的成本分别为150美元和600美元。

尽管每令牌成本不断增加,Denain指出:“由于模型随时间变得更好,达到特定性能水平的成本仍然大幅下降。但如果你想在任何时间点评估最好的最大模型,你仍然需要支付更多。”

基准测试的完整性

许多人工智能实验室,包括OpenAI,为基准测试目的提供免费或补贴的模型访问。然而,这种做法引发了对评估过程完整性的担忧。即使没有证据显示存在操纵,仅仅人工智能实验室参与的暗示就可能让人对结果的客观性产生怀疑。

Ross Taylor在X上表达了这一担忧,他问道:“从科学的角度来看,如果你发布了一个无人能用相同模型重现的结果,这还是科学吗?(它曾经是科学吗,哈哈)”

人工智能基准测试的高成本和潜在偏见凸显了该领域在开发和验证日益复杂的模型时面临的挑战。

相关文章

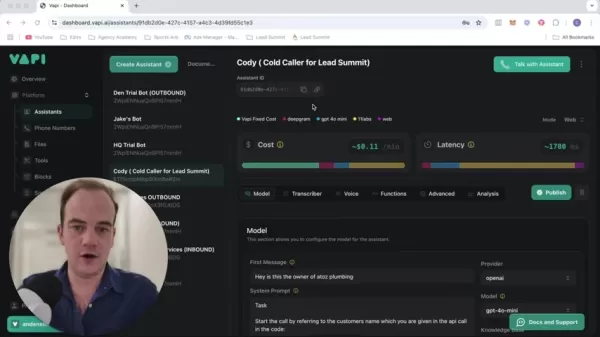

改变您的销售策略:由 Vapi 支持的人工智能冷呼叫技术

现代企业以闪电般的速度运作,需要创新的解决方案来保持竞争力。想象一下,使用人工智能驱动的冷呼叫系统,同时与数十个潜在客户进行接触,并全天候自主运行,从而彻底改变公司的外联工作。像 Vapi 这样的平台使这一转变成为可能,它使您能够构建可进行自然对话的定制拨号器,同时将您的团队解放出来从事高价值的工作。本综合指南揭示了如何实施尖端的人工智能呼叫技术,以实现大规模的个性化推广、显著提高潜在客户生成率,

改变您的销售策略:由 Vapi 支持的人工智能冷呼叫技术

现代企业以闪电般的速度运作,需要创新的解决方案来保持竞争力。想象一下,使用人工智能驱动的冷呼叫系统,同时与数十个潜在客户进行接触,并全天候自主运行,从而彻底改变公司的外联工作。像 Vapi 这样的平台使这一转变成为可能,它使您能够构建可进行自然对话的定制拨号器,同时将您的团队解放出来从事高价值的工作。本综合指南揭示了如何实施尖端的人工智能呼叫技术,以实现大规模的个性化推广、显著提高潜在客户生成率,

创建教育信息图表的最佳人工智能工具 - 设计技巧与技术

在当今数字驱动的教育环境中,信息图表已成为一种变革性的交流媒介,它能将复杂的信息转换成具有视觉吸引力、易于理解的格式。人工智能技术正在彻底改变教育工作者制作这些可视化学习辅助工具的方式,使所有人都能获得专业级的设计,同时大幅缩短制作时间。本讲座将深入探讨 ChatGPT 等尖端人工智能解决方案,这些解决方案通过简化工作流程、创意自动化和智能设计辅助,使教师和内容创作者能够制作出引人入胜的教育信息图

创建教育信息图表的最佳人工智能工具 - 设计技巧与技术

在当今数字驱动的教育环境中,信息图表已成为一种变革性的交流媒介,它能将复杂的信息转换成具有视觉吸引力、易于理解的格式。人工智能技术正在彻底改变教育工作者制作这些可视化学习辅助工具的方式,使所有人都能获得专业级的设计,同时大幅缩短制作时间。本讲座将深入探讨 ChatGPT 等尖端人工智能解决方案,这些解决方案通过简化工作流程、创意自动化和智能设计辅助,使教师和内容创作者能够制作出引人入胜的教育信息图

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在竞争激烈的数码摄影领域,图像清晰度仍然是最重要的。各种技术水平的摄影师都要面对数码噪点的问题,这些噪点影响了原本出色的拍摄效果。Topaz DeNoise AI 是一种先进的解决方案,它利用人工智能解决降噪问题,同时保留关键细节。本深度评论将探讨这款创新软件如何在 2025 年改变您的摄影工作流程,研究其主要功能、实际应用和工作流程集成。要点Topaz DeNoise AI 利用人工智能有效消除

评论 (17)

0/200

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在竞争激烈的数码摄影领域,图像清晰度仍然是最重要的。各种技术水平的摄影师都要面对数码噪点的问题,这些噪点影响了原本出色的拍摄效果。Topaz DeNoise AI 是一种先进的解决方案,它利用人工智能解决降噪问题,同时保留关键细节。本深度评论将探讨这款创新软件如何在 2025 年改变您的摄影工作流程,研究其主要功能、实际应用和工作流程集成。要点Topaz DeNoise AI 利用人工智能有效消除

评论 (17)

0/200

![FrankJackson]() FrankJackson

FrankJackson

2025-08-10 17:01:00

2025-08-10 17:01:00

These AI reasoning models are impressive for tackling complex physics problems step by step, but the surging benchmarking costs could stifle innovation for smaller labs. 😟 Reminds me of how tech giants dominate—maybe we need more affordable alternatives?

0

0

![DouglasRodriguez]() DouglasRodriguez

DouglasRodriguez

2025-07-28 09:20:21

2025-07-28 09:20:21

These AI reasoning models sound cool, but the skyrocketing benchmarking costs are wild! 😳 Makes me wonder if smaller labs can even keep up with the big players like OpenAI.

0

0

![StevenGonzalez]() StevenGonzalez

StevenGonzalez

2025-04-24 20:58:05

2025-04-24 20:58:05

These AI reasoning models are impressive, but the rising costs of benchmarking are a real bummer. It's great for fields like physics, but I hope they find a way to make it more affordable. Otherwise, it's just for the big players. 😕

0

0

![JackPerez]() JackPerez

JackPerez

2025-04-24 15:52:48

2025-04-24 15:52:48

Esses modelos de raciocínio de IA são impressionantes, mas o aumento dos custos de benchmarking é uma decepção. É ótimo para áreas como a física, mas espero que encontrem uma maneira de torná-lo mais acessível. Caso contrário, será apenas para os grandes jogadores. 😕

0

0

![GregoryJones]() GregoryJones

GregoryJones

2025-04-24 15:10:43

2025-04-24 15:10:43

AI推論モデルは素晴らしいけど、ベンチマーキングのコストが上がるのは残念です。物理分野には良いけど、もっと手頃な価格になる方法を見つけてほしいです。さもないと、大手企業だけのものになってしまいますね。😕

0

0

![SamuelRoberts]() SamuelRoberts

SamuelRoberts

2025-04-24 12:23:58

2025-04-24 12:23:58

Esses modelos de raciocínio de IA parecem legais, mas o aumento dos custos de benchmarking? Não tanto. Será que podemos ter os benefícios sem falir? 🤔

0

0

人工智能推理模型基准测试成本的上升

像OpenAI这样的人工智能实验室一直在宣传其先进的“推理”人工智能模型,这些模型旨在逐步解决复杂问题。这些模型在物理学等领域尤其有效,确实令人印象深刻。然而,在基准测试方面,它们的成本极高,这使得独立验证其能力变得具有挑战性。

根据第三方人工智能测试公司Artificial Analysis的数据,评估OpenAI的o1推理模型在七个热门人工智能基准测试中的成本高达2767.05美元。这些基准测试包括MMLU-Pro、GPQA Diamond、Humanity’s Last Exam、LiveCodeBench、SciCode、AIME 2024和MATH-500。相比之下,测试Anthropic的“混合”推理模型Claude 3.7 Sonnet在相同测试中的成本为1485.35美元,而OpenAI的o3-mini-high则显著便宜,仅为344.59美元。

并非所有推理模型的测试成本都同样高昂。例如,Artificial Analysis仅花费141.22美元评估OpenAI的o1-mini。然而,这些模型的测试成本平均较高。Artificial Analysis为评估大约十二个推理模型花费了约5200美元,这几乎是分析超过80个非推理模型所花费的2400美元的两倍。

相比之下,OpenAI于2024年5月发布的非推理GPT-4o模型,Artificial Analysis仅花费108.85美元进行评估,而Claude 3.6 Sonnet(Claude 3.7 Sonnet的非推理前身)成本为81.41美元。

Artificial Analysis的联合创始人George Cameron在接受TechCrunch采访时表示,该组织准备随着更多人工智能实验室继续开发推理模型而增加其基准测试预算。Cameron表示:“在Artificial Analysis,我们每月进行数百次评估,并为此投入了大量预算。我们计划随着模型更频繁发布而增加这部分支出。”

Artificial Analysis并非唯一面临这些成本上升的公司。人工智能初创公司General Reasoning的首席执行官Ross Taylor最近花费580美元在约3700个独特提示上评估Claude 3.7 Sonnet。Taylor估计,仅运行一次MMLU Pro(一个旨在测试语言理解能力的基准测试)就将超过1800美元。

Taylor在X上最近的一篇帖子中强调了一个日益增长的担忧,他表示:“我们正在走向一个世界,实验室报告某个基准测试的x%成绩,他们花费了y数量的计算资源,但学术界的资源远远少于y。没有人能够重现这些结果。”

为什么推理模型的基准测试成本如此高昂?

测试推理模型成本高的主要原因是它们倾向于生成大量令牌。令牌是原始文本的单位;例如,单词“fantastic”可能被分解为“fan”、“tas”和“tic”。据Artificial Analysis称,OpenAI的o1模型在测试中生成了超过4400万个令牌,约为非推理GPT-4o模型生成令牌数的八倍。

大多数人工智能公司根据令牌数量收费,这很快就会累积。此外,现代基准测试通过包含涉及复杂多步骤任务的问题,设计为诱导生成大量令牌。Epoch AI的资深研究员Jean-Stanislas Denain向TechCrunch解释说:“今天的基准测试更加复杂,尽管每个基准测试的问题数量总体减少。它们通常试图评估模型执行现实世界任务的能力,例如编写和执行代码、浏览互联网和使用计算机。”

Denain还指出,最昂贵模型的每令牌成本一直在上升。例如,Anthropic的Claude 3 Opus于2024年5月发布时,每百万输出令牌的成本为75美元。相比之下,OpenAI的GPT-4.5和o1-pro在同年早些时候发布时,每百万输出令牌的成本分别为150美元和600美元。

尽管每令牌成本不断增加,Denain指出:“由于模型随时间变得更好,达到特定性能水平的成本仍然大幅下降。但如果你想在任何时间点评估最好的最大模型,你仍然需要支付更多。”

基准测试的完整性

许多人工智能实验室,包括OpenAI,为基准测试目的提供免费或补贴的模型访问。然而,这种做法引发了对评估过程完整性的担忧。即使没有证据显示存在操纵,仅仅人工智能实验室参与的暗示就可能让人对结果的客观性产生怀疑。

Ross Taylor在X上表达了这一担忧,他问道:“从科学的角度来看,如果你发布了一个无人能用相同模型重现的结果,这还是科学吗?(它曾经是科学吗,哈哈)”

人工智能基准测试的高成本和潜在偏见凸显了该领域在开发和验证日益复杂的模型时面临的挑战。

改变您的销售策略:由 Vapi 支持的人工智能冷呼叫技术

现代企业以闪电般的速度运作,需要创新的解决方案来保持竞争力。想象一下,使用人工智能驱动的冷呼叫系统,同时与数十个潜在客户进行接触,并全天候自主运行,从而彻底改变公司的外联工作。像 Vapi 这样的平台使这一转变成为可能,它使您能够构建可进行自然对话的定制拨号器,同时将您的团队解放出来从事高价值的工作。本综合指南揭示了如何实施尖端的人工智能呼叫技术,以实现大规模的个性化推广、显著提高潜在客户生成率,

改变您的销售策略:由 Vapi 支持的人工智能冷呼叫技术

现代企业以闪电般的速度运作,需要创新的解决方案来保持竞争力。想象一下,使用人工智能驱动的冷呼叫系统,同时与数十个潜在客户进行接触,并全天候自主运行,从而彻底改变公司的外联工作。像 Vapi 这样的平台使这一转变成为可能,它使您能够构建可进行自然对话的定制拨号器,同时将您的团队解放出来从事高价值的工作。本综合指南揭示了如何实施尖端的人工智能呼叫技术,以实现大规模的个性化推广、显著提高潜在客户生成率,

创建教育信息图表的最佳人工智能工具 - 设计技巧与技术

在当今数字驱动的教育环境中,信息图表已成为一种变革性的交流媒介,它能将复杂的信息转换成具有视觉吸引力、易于理解的格式。人工智能技术正在彻底改变教育工作者制作这些可视化学习辅助工具的方式,使所有人都能获得专业级的设计,同时大幅缩短制作时间。本讲座将深入探讨 ChatGPT 等尖端人工智能解决方案,这些解决方案通过简化工作流程、创意自动化和智能设计辅助,使教师和内容创作者能够制作出引人入胜的教育信息图

创建教育信息图表的最佳人工智能工具 - 设计技巧与技术

在当今数字驱动的教育环境中,信息图表已成为一种变革性的交流媒介,它能将复杂的信息转换成具有视觉吸引力、易于理解的格式。人工智能技术正在彻底改变教育工作者制作这些可视化学习辅助工具的方式,使所有人都能获得专业级的设计,同时大幅缩短制作时间。本讲座将深入探讨 ChatGPT 等尖端人工智能解决方案,这些解决方案通过简化工作流程、创意自动化和智能设计辅助,使教师和内容创作者能够制作出引人入胜的教育信息图

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在竞争激烈的数码摄影领域,图像清晰度仍然是最重要的。各种技术水平的摄影师都要面对数码噪点的问题,这些噪点影响了原本出色的拍摄效果。Topaz DeNoise AI 是一种先进的解决方案,它利用人工智能解决降噪问题,同时保留关键细节。本深度评论将探讨这款创新软件如何在 2025 年改变您的摄影工作流程,研究其主要功能、实际应用和工作流程集成。要点Topaz DeNoise AI 利用人工智能有效消除

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在竞争激烈的数码摄影领域,图像清晰度仍然是最重要的。各种技术水平的摄影师都要面对数码噪点的问题,这些噪点影响了原本出色的拍摄效果。Topaz DeNoise AI 是一种先进的解决方案,它利用人工智能解决降噪问题,同时保留关键细节。本深度评论将探讨这款创新软件如何在 2025 年改变您的摄影工作流程,研究其主要功能、实际应用和工作流程集成。要点Topaz DeNoise AI 利用人工智能有效消除

2025-08-10 17:01:00

2025-08-10 17:01:00

These AI reasoning models are impressive for tackling complex physics problems step by step, but the surging benchmarking costs could stifle innovation for smaller labs. 😟 Reminds me of how tech giants dominate—maybe we need more affordable alternatives?

0

0

2025-07-28 09:20:21

2025-07-28 09:20:21

These AI reasoning models sound cool, but the skyrocketing benchmarking costs are wild! 😳 Makes me wonder if smaller labs can even keep up with the big players like OpenAI.

0

0

2025-04-24 20:58:05

2025-04-24 20:58:05

These AI reasoning models are impressive, but the rising costs of benchmarking are a real bummer. It's great for fields like physics, but I hope they find a way to make it more affordable. Otherwise, it's just for the big players. 😕

0

0

2025-04-24 15:52:48

2025-04-24 15:52:48

Esses modelos de raciocínio de IA são impressionantes, mas o aumento dos custos de benchmarking é uma decepção. É ótimo para áreas como a física, mas espero que encontrem uma maneira de torná-lo mais acessível. Caso contrário, será apenas para os grandes jogadores. 😕

0

0

2025-04-24 15:10:43

2025-04-24 15:10:43

AI推論モデルは素晴らしいけど、ベンチマーキングのコストが上がるのは残念です。物理分野には良いけど、もっと手頃な価格になる方法を見つけてほしいです。さもないと、大手企業だけのものになってしまいますね。😕

0

0

2025-04-24 12:23:58

2025-04-24 12:23:58

Esses modelos de raciocínio de IA parecem legais, mas o aumento dos custos de benchmarking? Não tanto. Será que podemos ter os benefícios sem falir? 🤔

0

0