AI '추론'모델이 급증하여 벤치마킹 비용을 증가시킵니다

AI 추론 모델 벤치마킹 비용의 상승

OpenAI와 같은 AI 연구소들은 복잡한 문제를 단계적으로 해결하도록 설계된 고급 "추론" AI 모델을 자랑해 왔습니다. 특히 물리학과 같은 분야에서 효과적인 이러한 모델들은 인상적입니다. 그러나 벤치마킹 비용이 상당히 높아 독립적인 능력 검증이 어려운 과제를 안고 있습니다.

제3자 AI 테스트 회사인 Artificial Analysis의 데이터에 따르면, OpenAI의 o1 추론 모델을 7개의 인기 AI 벤치마크에서 평가하는 데 드는 비용은 놀랍게도 $2,767.05입니다. 이러한 벤치마크에는 MMLU-Pro, GPQA Diamond, Humanity’s Last Exam, LiveCodeBench, SciCode, AIME 2024, MATH-500이 포함됩니다. 반면, Anthropic의 "하이브리드" 추론 모델인 Claude 3.7 Sonnet은 동일한 테스트에서 $1,485.35의 비용이 들었으며, OpenAI의 o3-mini-high는 $344.59로 훨씬 저렴했습니다.

모든 추론 모델의 테스트 비용이 동일하게 높은 것은 아닙니다. 예를 들어, Artificial Analysis는 OpenAI의 o1-mini를 평가하는 데 $141.22만을 지출했습니다. 그러나 이러한 모델들의 평균 테스트 비용은 대체로 높습니다. Artificial Analysis는 약 12개의 추론 모델을 평가하는 데 약 $5,200를 지출했으며, 이는 80개 이상의 비추론 모델을 분석하는 데 지출한 $2,400의 거의 두 배에 달합니다.

비교를 위해, 2024년 5월에 출시된 OpenAI의 비추론 GPT-4o 모델은 Artificial Analysis가 평가하는 데 $108.85만 들었으며, Claude 3.7 Sonnet의 비추론 전신인 Claude 3.6 Sonnet은 $81.41의 비용이 들었습니다.

Artificial Analysis의 공동 설립자인 George Cameron은 TechCrunch와의 인터뷰에서, 더 많은 AI 연구소들이 추론 모델을 개발함에 따라 벤치마킹 예산을 늘릴 준비가 되어 있다고 밝혔습니다. Cameron은 "Artificial Analysis에서는 매달 수백 건의 평가를 진행하며 이에 상당한 예산을 투입하고 있습니다."라고 말했습니다. "모델이 더 자주 출시됨에 따라 이 지출이 증가할 계획입니다."

Artificial Analysis만 이러한 비용 증가에 직면한 것은 아닙니다. AI 스타트업 General Reasoning의 CEO인 Ross Taylor는 최근 Claude 3.7 Sonnet을 약 3,700개의 고유 프롬프트로 평가하는 데 $580를 지출했습니다. Taylor는 언어 이해도를 테스트하도록 설계된 벤치마크인 MMLU Pro의 단일 실행 비용이 $1,800를 초과할 것으로 추정합니다.

Taylor는 최근 X에 게시한 글에서 증가하는 우려를 강조하며, "우리는 연구소가 x%의 벤치마크 결과를 보고하지만, 학계의 자원이 y보다 훨씬 적은 세계로 이동하고 있습니다. 아무도 그 결과를 재현할 수 없을 것입니다."라고 말했습니다.

추론 모델 벤치마킹 비용이 높은 이유는?

추론 모델 테스트 비용이 높은 주된 이유는 이들이 상당한 수의 토큰을 생성하는 경향이 있기 때문입니다. 토큰은 원시 텍스트의 단위로, 예를 들어 "fantastic"이라는 단어는 "fan," "tas," "tic"으로 나뉠 수 있습니다. Artificial Analysis에 따르면, OpenAI의 o1 모델은 테스트 중 4,400만 개 이상의 토큰을 생성했으며, 이는 비추론 GPT-4o 모델이 생성한 토큰 수의 약 8배입니다.

대부분의 AI 회사들은 토큰 수에 따라 모델 사용 요금을 부과하며, 이는 빠르게 누적됩니다. 또한, 현대 벤치마크는 복잡한 다단계 작업을 포함하는 질문을 통해 많은 토큰을 유도하도록 설계되었습니다. Epoch AI의 선임 연구원인 Jean-Stanislas Denain은 TechCrunch에 "오늘날의 벤치마크는 질문 수가 전반적으로 줄어들었음에도 불구하고 더 복잡합니다. 이들은 종종 모델이 코드 작성 및 실행, 인터넷 브라우징, 컴퓨터 사용과 같은 실제 작업을 수행하는 능력을 평가하려고 합니다."라고 설명했습니다.

Denain은 또한 가장 비싼 모델의 토큰당 비용이 상승하고 있다고 지적했습니다. 예를 들어, 2024년 5월에 출시된 Anthropic의 Claude 3 Opus는 출력 토큰 백만 개당 $75였습니다. 반면, 같은 해 초에 출시된 OpenAI의 GPT-4.5와 o1-pro는 각각 출력 토큰 백만 개당 $150와 $600였습니다.

토큰당 비용이 증가함에도 불구하고, Denain은 "모델이 시간이 지남에 따라 개선됨에 따라 주어진 성능 수준에 도달하는 비용은 크게 감소했습니다. 하지만 특정 시점에서 최고의 대형 모델을 평가하려면 여전히 더 많은 비용을 지불해야 합니다."라고 언급했습니다.

벤치마킹의 무결성

OpenAI를 포함한 많은 AI 연구소들은 벤치마킹 목적으로 모델에 대한 무료 또는 보조금 지원 액세스를 제공합니다. 그러나 이러한 관행은 평가 프로세스의 무결성에 대한 우려를 불러일으킵니다. 조작의 증거가 없더라도, AI 연구소의 개입 가능성만으로도 결과의 객관성에 의문이 제기될 수 있습니다.

Ross Taylor는 X에서 이러한 우려를 표하며, "과학적 관점에서, 아무도 동일한 모델로 재현할 수 없는 결과를 발표한다면, 그것이 과연 과학일까요? (과연 과학이었던 적이 있었나요, lol)"라고 물었습니다.

AI 벤치마킹의 높은 비용과 잠재적 편향은 점점 더 정교한 모델을 개발하고 검증하려는 분야가 직면한 도전을 강조합니다.

관련 기사

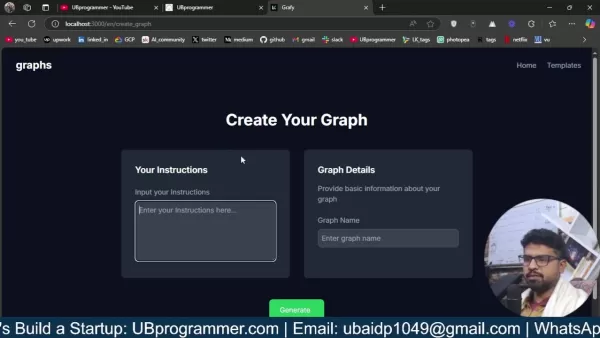

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

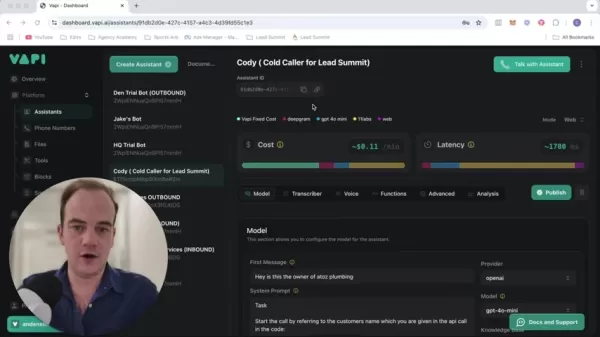

영업 전략을 혁신하세요: Vapi 기반의 AI 콜드 콜 기술

현대의 비즈니스는 빠른 속도로 운영되며 경쟁력을 유지하기 위해 혁신적인 솔루션을 요구합니다. 연중무휴 24시간 자율적으로 운영되는 AI 기반 콜드 콜 시스템을 통해 수십 명의 잠재 고객과 동시에 소통하며 대행사의 홍보 활동을 혁신하는 모습을 상상해 보세요. Vapi와 같은 플랫폼은 이러한 혁신을 가능하게 하여 자연스러운 대화를 수행하는 맞춤형 다이얼러를 구

영업 전략을 혁신하세요: Vapi 기반의 AI 콜드 콜 기술

현대의 비즈니스는 빠른 속도로 운영되며 경쟁력을 유지하기 위해 혁신적인 솔루션을 요구합니다. 연중무휴 24시간 자율적으로 운영되는 AI 기반 콜드 콜 시스템을 통해 수십 명의 잠재 고객과 동시에 소통하며 대행사의 홍보 활동을 혁신하는 모습을 상상해 보세요. Vapi와 같은 플랫폼은 이러한 혁신을 가능하게 하여 자연스러운 대화를 수행하는 맞춤형 다이얼러를 구

교육용 인포그래픽 제작을 위한 최고의 AI 도구 - 디자인 팁 및 기술

오늘날의 디지털 중심 교육 환경에서 인포그래픽은 복잡한 정보를 시각적으로 매력적이고 이해하기 쉬운 형식으로 변환하는 혁신적인 커뮤니케이션 매체로 부상했습니다. AI 기술은 교육자가 이러한 시각적 학습 보조 자료를 제작하는 방식을 혁신하여 누구나 전문가 수준의 디자인을 이용할 수 있게 하는 동시에 제작 시간을 획기적으로 단축하고 있습니다. 이 탐구에서는 간소

의견 (17)

0/200

교육용 인포그래픽 제작을 위한 최고의 AI 도구 - 디자인 팁 및 기술

오늘날의 디지털 중심 교육 환경에서 인포그래픽은 복잡한 정보를 시각적으로 매력적이고 이해하기 쉬운 형식으로 변환하는 혁신적인 커뮤니케이션 매체로 부상했습니다. AI 기술은 교육자가 이러한 시각적 학습 보조 자료를 제작하는 방식을 혁신하여 누구나 전문가 수준의 디자인을 이용할 수 있게 하는 동시에 제작 시간을 획기적으로 단축하고 있습니다. 이 탐구에서는 간소

의견 (17)

0/200

![FrankJackson]() FrankJackson

FrankJackson

2025년 8월 10일 오후 6시 1분 0초 GMT+09:00

2025년 8월 10일 오후 6시 1분 0초 GMT+09:00

These AI reasoning models are impressive for tackling complex physics problems step by step, but the surging benchmarking costs could stifle innovation for smaller labs. 😟 Reminds me of how tech giants dominate—maybe we need more affordable alternatives?

0

0

![DouglasRodriguez]() DouglasRodriguez

DouglasRodriguez

2025년 7월 28일 오전 10시 20분 21초 GMT+09:00

2025년 7월 28일 오전 10시 20분 21초 GMT+09:00

These AI reasoning models sound cool, but the skyrocketing benchmarking costs are wild! 😳 Makes me wonder if smaller labs can even keep up with the big players like OpenAI.

0

0

![StevenGonzalez]() StevenGonzalez

StevenGonzalez

2025년 4월 24일 오후 9시 58분 5초 GMT+09:00

2025년 4월 24일 오후 9시 58분 5초 GMT+09:00

These AI reasoning models are impressive, but the rising costs of benchmarking are a real bummer. It's great for fields like physics, but I hope they find a way to make it more affordable. Otherwise, it's just for the big players. 😕

0

0

![JackPerez]() JackPerez

JackPerez

2025년 4월 24일 오후 4시 52분 48초 GMT+09:00

2025년 4월 24일 오후 4시 52분 48초 GMT+09:00

Esses modelos de raciocínio de IA são impressionantes, mas o aumento dos custos de benchmarking é uma decepção. É ótimo para áreas como a física, mas espero que encontrem uma maneira de torná-lo mais acessível. Caso contrário, será apenas para os grandes jogadores. 😕

0

0

![GregoryJones]() GregoryJones

GregoryJones

2025년 4월 24일 오후 4시 10분 43초 GMT+09:00

2025년 4월 24일 오후 4시 10분 43초 GMT+09:00

AI推論モデルは素晴らしいけど、ベンチマーキングのコストが上がるのは残念です。物理分野には良いけど、もっと手頃な価格になる方法を見つけてほしいです。さもないと、大手企業だけのものになってしまいますね。😕

0

0

![SamuelRoberts]() SamuelRoberts

SamuelRoberts

2025년 4월 24일 오후 1시 23분 58초 GMT+09:00

2025년 4월 24일 오후 1시 23분 58초 GMT+09:00

Esses modelos de raciocínio de IA parecem legais, mas o aumento dos custos de benchmarking? Não tanto. Será que podemos ter os benefícios sem falir? 🤔

0

0

AI 추론 모델 벤치마킹 비용의 상승

OpenAI와 같은 AI 연구소들은 복잡한 문제를 단계적으로 해결하도록 설계된 고급 "추론" AI 모델을 자랑해 왔습니다. 특히 물리학과 같은 분야에서 효과적인 이러한 모델들은 인상적입니다. 그러나 벤치마킹 비용이 상당히 높아 독립적인 능력 검증이 어려운 과제를 안고 있습니다.

제3자 AI 테스트 회사인 Artificial Analysis의 데이터에 따르면, OpenAI의 o1 추론 모델을 7개의 인기 AI 벤치마크에서 평가하는 데 드는 비용은 놀랍게도 $2,767.05입니다. 이러한 벤치마크에는 MMLU-Pro, GPQA Diamond, Humanity’s Last Exam, LiveCodeBench, SciCode, AIME 2024, MATH-500이 포함됩니다. 반면, Anthropic의 "하이브리드" 추론 모델인 Claude 3.7 Sonnet은 동일한 테스트에서 $1,485.35의 비용이 들었으며, OpenAI의 o3-mini-high는 $344.59로 훨씬 저렴했습니다.

모든 추론 모델의 테스트 비용이 동일하게 높은 것은 아닙니다. 예를 들어, Artificial Analysis는 OpenAI의 o1-mini를 평가하는 데 $141.22만을 지출했습니다. 그러나 이러한 모델들의 평균 테스트 비용은 대체로 높습니다. Artificial Analysis는 약 12개의 추론 모델을 평가하는 데 약 $5,200를 지출했으며, 이는 80개 이상의 비추론 모델을 분석하는 데 지출한 $2,400의 거의 두 배에 달합니다.

비교를 위해, 2024년 5월에 출시된 OpenAI의 비추론 GPT-4o 모델은 Artificial Analysis가 평가하는 데 $108.85만 들었으며, Claude 3.7 Sonnet의 비추론 전신인 Claude 3.6 Sonnet은 $81.41의 비용이 들었습니다.

Artificial Analysis의 공동 설립자인 George Cameron은 TechCrunch와의 인터뷰에서, 더 많은 AI 연구소들이 추론 모델을 개발함에 따라 벤치마킹 예산을 늘릴 준비가 되어 있다고 밝혔습니다. Cameron은 "Artificial Analysis에서는 매달 수백 건의 평가를 진행하며 이에 상당한 예산을 투입하고 있습니다."라고 말했습니다. "모델이 더 자주 출시됨에 따라 이 지출이 증가할 계획입니다."

Artificial Analysis만 이러한 비용 증가에 직면한 것은 아닙니다. AI 스타트업 General Reasoning의 CEO인 Ross Taylor는 최근 Claude 3.7 Sonnet을 약 3,700개의 고유 프롬프트로 평가하는 데 $580를 지출했습니다. Taylor는 언어 이해도를 테스트하도록 설계된 벤치마크인 MMLU Pro의 단일 실행 비용이 $1,800를 초과할 것으로 추정합니다.

Taylor는 최근 X에 게시한 글에서 증가하는 우려를 강조하며, "우리는 연구소가 x%의 벤치마크 결과를 보고하지만, 학계의 자원이 y보다 훨씬 적은 세계로 이동하고 있습니다. 아무도 그 결과를 재현할 수 없을 것입니다."라고 말했습니다.

추론 모델 벤치마킹 비용이 높은 이유는?

추론 모델 테스트 비용이 높은 주된 이유는 이들이 상당한 수의 토큰을 생성하는 경향이 있기 때문입니다. 토큰은 원시 텍스트의 단위로, 예를 들어 "fantastic"이라는 단어는 "fan," "tas," "tic"으로 나뉠 수 있습니다. Artificial Analysis에 따르면, OpenAI의 o1 모델은 테스트 중 4,400만 개 이상의 토큰을 생성했으며, 이는 비추론 GPT-4o 모델이 생성한 토큰 수의 약 8배입니다.

대부분의 AI 회사들은 토큰 수에 따라 모델 사용 요금을 부과하며, 이는 빠르게 누적됩니다. 또한, 현대 벤치마크는 복잡한 다단계 작업을 포함하는 질문을 통해 많은 토큰을 유도하도록 설계되었습니다. Epoch AI의 선임 연구원인 Jean-Stanislas Denain은 TechCrunch에 "오늘날의 벤치마크는 질문 수가 전반적으로 줄어들었음에도 불구하고 더 복잡합니다. 이들은 종종 모델이 코드 작성 및 실행, 인터넷 브라우징, 컴퓨터 사용과 같은 실제 작업을 수행하는 능력을 평가하려고 합니다."라고 설명했습니다.

Denain은 또한 가장 비싼 모델의 토큰당 비용이 상승하고 있다고 지적했습니다. 예를 들어, 2024년 5월에 출시된 Anthropic의 Claude 3 Opus는 출력 토큰 백만 개당 $75였습니다. 반면, 같은 해 초에 출시된 OpenAI의 GPT-4.5와 o1-pro는 각각 출력 토큰 백만 개당 $150와 $600였습니다.

토큰당 비용이 증가함에도 불구하고, Denain은 "모델이 시간이 지남에 따라 개선됨에 따라 주어진 성능 수준에 도달하는 비용은 크게 감소했습니다. 하지만 특정 시점에서 최고의 대형 모델을 평가하려면 여전히 더 많은 비용을 지불해야 합니다."라고 언급했습니다.

벤치마킹의 무결성

OpenAI를 포함한 많은 AI 연구소들은 벤치마킹 목적으로 모델에 대한 무료 또는 보조금 지원 액세스를 제공합니다. 그러나 이러한 관행은 평가 프로세스의 무결성에 대한 우려를 불러일으킵니다. 조작의 증거가 없더라도, AI 연구소의 개입 가능성만으로도 결과의 객관성에 의문이 제기될 수 있습니다.

Ross Taylor는 X에서 이러한 우려를 표하며, "과학적 관점에서, 아무도 동일한 모델로 재현할 수 없는 결과를 발표한다면, 그것이 과연 과학일까요? (과연 과학이었던 적이 있었나요, lol)"라고 물었습니다.

AI 벤치마킹의 높은 비용과 잠재적 편향은 점점 더 정교한 모델을 개발하고 검증하려는 분야가 직면한 도전을 강조합니다.

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

영업 전략을 혁신하세요: Vapi 기반의 AI 콜드 콜 기술

현대의 비즈니스는 빠른 속도로 운영되며 경쟁력을 유지하기 위해 혁신적인 솔루션을 요구합니다. 연중무휴 24시간 자율적으로 운영되는 AI 기반 콜드 콜 시스템을 통해 수십 명의 잠재 고객과 동시에 소통하며 대행사의 홍보 활동을 혁신하는 모습을 상상해 보세요. Vapi와 같은 플랫폼은 이러한 혁신을 가능하게 하여 자연스러운 대화를 수행하는 맞춤형 다이얼러를 구

영업 전략을 혁신하세요: Vapi 기반의 AI 콜드 콜 기술

현대의 비즈니스는 빠른 속도로 운영되며 경쟁력을 유지하기 위해 혁신적인 솔루션을 요구합니다. 연중무휴 24시간 자율적으로 운영되는 AI 기반 콜드 콜 시스템을 통해 수십 명의 잠재 고객과 동시에 소통하며 대행사의 홍보 활동을 혁신하는 모습을 상상해 보세요. Vapi와 같은 플랫폼은 이러한 혁신을 가능하게 하여 자연스러운 대화를 수행하는 맞춤형 다이얼러를 구

교육용 인포그래픽 제작을 위한 최고의 AI 도구 - 디자인 팁 및 기술

오늘날의 디지털 중심 교육 환경에서 인포그래픽은 복잡한 정보를 시각적으로 매력적이고 이해하기 쉬운 형식으로 변환하는 혁신적인 커뮤니케이션 매체로 부상했습니다. AI 기술은 교육자가 이러한 시각적 학습 보조 자료를 제작하는 방식을 혁신하여 누구나 전문가 수준의 디자인을 이용할 수 있게 하는 동시에 제작 시간을 획기적으로 단축하고 있습니다. 이 탐구에서는 간소

교육용 인포그래픽 제작을 위한 최고의 AI 도구 - 디자인 팁 및 기술

오늘날의 디지털 중심 교육 환경에서 인포그래픽은 복잡한 정보를 시각적으로 매력적이고 이해하기 쉬운 형식으로 변환하는 혁신적인 커뮤니케이션 매체로 부상했습니다. AI 기술은 교육자가 이러한 시각적 학습 보조 자료를 제작하는 방식을 혁신하여 누구나 전문가 수준의 디자인을 이용할 수 있게 하는 동시에 제작 시간을 획기적으로 단축하고 있습니다. 이 탐구에서는 간소

2025년 8월 10일 오후 6시 1분 0초 GMT+09:00

2025년 8월 10일 오후 6시 1분 0초 GMT+09:00

These AI reasoning models are impressive for tackling complex physics problems step by step, but the surging benchmarking costs could stifle innovation for smaller labs. 😟 Reminds me of how tech giants dominate—maybe we need more affordable alternatives?

0

0

2025년 7월 28일 오전 10시 20분 21초 GMT+09:00

2025년 7월 28일 오전 10시 20분 21초 GMT+09:00

These AI reasoning models sound cool, but the skyrocketing benchmarking costs are wild! 😳 Makes me wonder if smaller labs can even keep up with the big players like OpenAI.

0

0

2025년 4월 24일 오후 9시 58분 5초 GMT+09:00

2025년 4월 24일 오후 9시 58분 5초 GMT+09:00

These AI reasoning models are impressive, but the rising costs of benchmarking are a real bummer. It's great for fields like physics, but I hope they find a way to make it more affordable. Otherwise, it's just for the big players. 😕

0

0

2025년 4월 24일 오후 4시 52분 48초 GMT+09:00

2025년 4월 24일 오후 4시 52분 48초 GMT+09:00

Esses modelos de raciocínio de IA são impressionantes, mas o aumento dos custos de benchmarking é uma decepção. É ótimo para áreas como a física, mas espero que encontrem uma maneira de torná-lo mais acessível. Caso contrário, será apenas para os grandes jogadores. 😕

0

0

2025년 4월 24일 오후 4시 10분 43초 GMT+09:00

2025년 4월 24일 오후 4시 10분 43초 GMT+09:00

AI推論モデルは素晴らしいけど、ベンチマーキングのコストが上がるのは残念です。物理分野には良いけど、もっと手頃な価格になる方法を見つけてほしいです。さもないと、大手企業だけのものになってしまいますね。😕

0

0

2025년 4월 24일 오후 1시 23분 58초 GMT+09:00

2025년 4월 24일 오후 1시 23분 58초 GMT+09:00

Esses modelos de raciocínio de IA parecem legais, mas o aumento dos custos de benchmarking? Não tanto. Será que podemos ter os benefícios sem falir? 🤔

0

0