OpenAI actualiza sus modelos de transcripción y generación de voz de voz

OpenAI está lanzando nuevos modelos de IA para transcripción y generación de voz a través de su API, prometiendo mejoras significativas respecto a sus versiones anteriores. Estas actualizaciones forman parte de la visión más amplia de OpenAI, conocida como "agéntica", que se centra en crear sistemas autónomos capaces de realizar tareas de manera independiente para los usuarios. Aunque el término "agente" puede ser debatido, el jefe de producto de OpenAI, Olivier Godement, lo considera como un chatbot que puede interactuar con los clientes de una empresa.

"Vamos a ver cada vez más agentes surgir en los próximos meses," compartió Godement con TechCrunch durante una sesión informativa. "El objetivo principal es ayudar a los clientes y desarrolladores a utilizar agentes que sean útiles, accesibles y precisos."

El último modelo de texto a voz de OpenAI, denominado "gpt-4o-mini-tts," no solo busca producir un habla más realista y matizada, sino que también es más adaptable que sus predecesores. Los desarrolladores ahora pueden guiar al modelo utilizando comandos en lenguaje natural, como "habla como un científico loco" o "usa una voz serena, como un maestro de mindfulness." Este nivel de control permite una experiencia de voz más personalizada.

Aquí hay una muestra de una voz gastada al estilo "true crime":

Y aquí hay un ejemplo de una voz femenina "profesional":

Jeff Harris, miembro del equipo de productos de OpenAI, enfatizó a TechCrunch que el objetivo es permitir a los desarrolladores personalizar tanto la "experiencia" como el "contexto" de la voz. "En diversos escenarios, no quieres una voz monótona," explicó Harris. "Por ejemplo, en un entorno de soporte al cliente donde la voz necesita sonar apologética por un error, puedes infundir esa emoción en la voz. Creemos firmemente que los desarrolladores y usuarios quieren controlar no solo el contenido, sino también la manera de hablar."

Pasando a las nuevas ofertas de voz a texto de OpenAI, "gpt-4o-transcribe" y "gpt-4o-mini-transcribe," estos modelos están destinados a reemplazar el modelo de transcripción obsoleto Whisper. Entrenados con una amplia variedad de datos de audio de alta calidad, afirman manejar mejor el habla con acentos y variada, incluso en entornos ruidosos. Además, estos modelos son menos propensos a "alucinaciones," un problema donde Whisper a veces inventaba palabras o pasajes completos, añadiendo inexactitudes como comentarios raciales o tratamientos médicos ficticios a las transcripciones.

"Estos modelos muestran una mejora significativa respecto a Whisper en este aspecto," señaló Harris. "Garantizar la precisión del modelo es crucial para una experiencia de voz confiable, y por precisión, nos referimos a que los modelos capturan correctamente las palabras habladas sin añadir contenido no expresado."

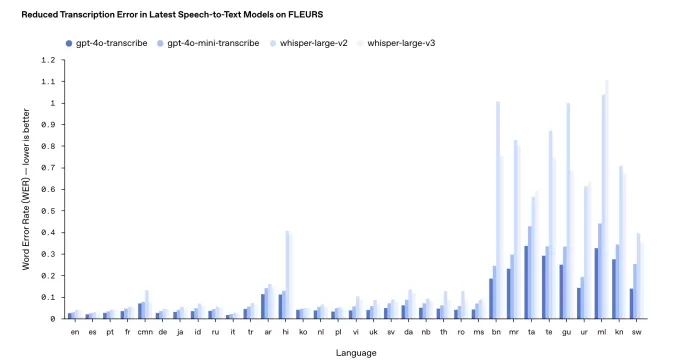

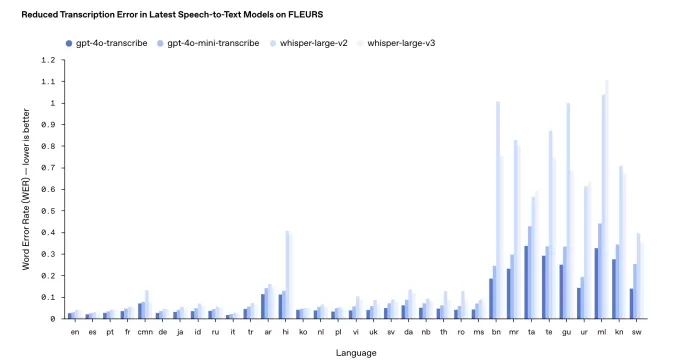

Sin embargo, el rendimiento puede variar entre idiomas. Los puntos de referencia internos de OpenAI indican que gpt-4o-transcribe, el más preciso de los dos, tiene una "tasa de error de palabras" cercana al 30% para idiomas índicos y dravídicos como tamil, telugu, malayalam y kannada. Esto sugiere que aproximadamente tres de cada diez palabras podrían diferir de una transcripción humana en estos idiomas.

Los resultados de las pruebas de referencia de transcripción de OpenAI. Créditos de la imagen: OpenAI En un cambio respecto a su práctica habitual, OpenAI no hará que estos nuevos modelos de transcripción estén disponibles gratuitamente. Históricamente, lanzaron nuevas versiones de Whisper bajo una licencia MIT para uso comercial. Harris señaló que gpt-4o-transcribe y gpt-4o-mini-transcribe son significativamente más grandes que Whisper, lo que los hace inadecuados para un lanzamiento abierto.

"Estos modelos son demasiado grandes para ejecutarse en una laptop típica como podía hacer Whisper," añadió Harris. "Cuando lanzamos modelos abiertamente, queremos hacerlo de manera reflexiva, asegurándonos de que estén adaptados a necesidades específicas. Vemos los dispositivos de los usuarios finales como un área principal para modelos de código abierto."

Actualizado el 20 de marzo de 2025, 11:54 a.m. PT para aclarar el lenguaje en torno a la tasa de error de palabras y actualizar el gráfico de resultados de referencia con una versión más reciente.

Artículo relacionado

Una organización sin ánimo de lucro aprovecha los agentes de IA para impulsar la recaudación de fondos benéficos

Mientras las grandes corporaciones tecnológicas promueven los "agentes" de IA como potenciadores de la productividad para las empresas, una organización sin ánimo de lucro está demostrando su potencia

Una organización sin ánimo de lucro aprovecha los agentes de IA para impulsar la recaudación de fondos benéficos

Mientras las grandes corporaciones tecnológicas promueven los "agentes" de IA como potenciadores de la productividad para las empresas, una organización sin ánimo de lucro está demostrando su potencia

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

ChatGPT integra Google Drive y Dropbox para acceder a los archivos

ChatGPT mejora la productividad con nuevas funciones empresarialesOpenAI ha presentado dos nuevas y potentes funciones que transforman ChatGPT en una completa herramienta de productividad empresaria

comentario (32)

0/200

ChatGPT integra Google Drive y Dropbox para acceder a los archivos

ChatGPT mejora la productividad con nuevas funciones empresarialesOpenAI ha presentado dos nuevas y potentes funciones que transforman ChatGPT en una completa herramienta de productividad empresaria

comentario (32)

0/200

![FrankMartínez]() FrankMartínez

FrankMartínez

19 de agosto de 2025 10:01:39 GMT+02:00

19 de agosto de 2025 10:01:39 GMT+02:00

The new OpenAI models sound like a game-changer for voice tech! Can't wait to see how devs use this to make apps talk smoother than ever. 😎

0

0

![BenHernández]() BenHernández

BenHernández

23 de julio de 2025 10:50:48 GMT+02:00

23 de julio de 2025 10:50:48 GMT+02:00

Wow, OpenAI's new transcription and voice models sound like a game-changer! I'm curious how these 'agentic' systems will stack up against real-world tasks. Could they finally nail natural-sounding convos? 🤔

0

0

![GeorgeTaylor]() GeorgeTaylor

GeorgeTaylor

20 de abril de 2025 21:57:07 GMT+02:00

20 de abril de 2025 21:57:07 GMT+02:00

Os novos modelos de transcrição e geração de voz da OpenAI são um divisor de águas! Estou usando no meu podcast e as melhorias são impressionantes. O único ponto negativo? São um pouco caros, mas se você puder pagar, vale cada centavo! 🎙️💸

0

0

![GregoryAllen]() GregoryAllen

GregoryAllen

17 de abril de 2025 06:50:37 GMT+02:00

17 de abril de 2025 06:50:37 GMT+02:00

OpenAI's new transcription and voice models are a game changer! I've been using them for my podcast and the improvements are night and day. The only downside? They're a bit pricey, but if you can swing it, they're worth every penny! 🎙️💸

0

0

![StevenAllen]() StevenAllen

StevenAllen

17 de abril de 2025 06:38:26 GMT+02:00

17 de abril de 2025 06:38:26 GMT+02:00

OpenAI의 새로운 음성 인식 및 음성 생성 모델은 정말 혁신적이에요! 제 팟캐스트에서 사용 중인데, 개선이 눈에 띄어요. 단점은 조금 비싸다는 건데, 감당할 수 있다면 그만한 가치가 있어요! 🎙️💸

0

0

![NicholasClark]() NicholasClark

NicholasClark

16 de abril de 2025 07:54:41 GMT+02:00

16 de abril de 2025 07:54:41 GMT+02:00

OpenAIの新しい音声認識と音声生成モデルは革命的です!ポッドキャストで使っていますが、改善が劇的です。唯一の欠点は少し高価なことですが、払えるならその価値は十分にあります!🎙️💸

0

0

OpenAI está lanzando nuevos modelos de IA para transcripción y generación de voz a través de su API, prometiendo mejoras significativas respecto a sus versiones anteriores. Estas actualizaciones forman parte de la visión más amplia de OpenAI, conocida como "agéntica", que se centra en crear sistemas autónomos capaces de realizar tareas de manera independiente para los usuarios. Aunque el término "agente" puede ser debatido, el jefe de producto de OpenAI, Olivier Godement, lo considera como un chatbot que puede interactuar con los clientes de una empresa.

"Vamos a ver cada vez más agentes surgir en los próximos meses," compartió Godement con TechCrunch durante una sesión informativa. "El objetivo principal es ayudar a los clientes y desarrolladores a utilizar agentes que sean útiles, accesibles y precisos."

El último modelo de texto a voz de OpenAI, denominado "gpt-4o-mini-tts," no solo busca producir un habla más realista y matizada, sino que también es más adaptable que sus predecesores. Los desarrolladores ahora pueden guiar al modelo utilizando comandos en lenguaje natural, como "habla como un científico loco" o "usa una voz serena, como un maestro de mindfulness." Este nivel de control permite una experiencia de voz más personalizada.

Aquí hay una muestra de una voz gastada al estilo "true crime":

Y aquí hay un ejemplo de una voz femenina "profesional":

Jeff Harris, miembro del equipo de productos de OpenAI, enfatizó a TechCrunch que el objetivo es permitir a los desarrolladores personalizar tanto la "experiencia" como el "contexto" de la voz. "En diversos escenarios, no quieres una voz monótona," explicó Harris. "Por ejemplo, en un entorno de soporte al cliente donde la voz necesita sonar apologética por un error, puedes infundir esa emoción en la voz. Creemos firmemente que los desarrolladores y usuarios quieren controlar no solo el contenido, sino también la manera de hablar."

Pasando a las nuevas ofertas de voz a texto de OpenAI, "gpt-4o-transcribe" y "gpt-4o-mini-transcribe," estos modelos están destinados a reemplazar el modelo de transcripción obsoleto Whisper. Entrenados con una amplia variedad de datos de audio de alta calidad, afirman manejar mejor el habla con acentos y variada, incluso en entornos ruidosos. Además, estos modelos son menos propensos a "alucinaciones," un problema donde Whisper a veces inventaba palabras o pasajes completos, añadiendo inexactitudes como comentarios raciales o tratamientos médicos ficticios a las transcripciones.

"Estos modelos muestran una mejora significativa respecto a Whisper en este aspecto," señaló Harris. "Garantizar la precisión del modelo es crucial para una experiencia de voz confiable, y por precisión, nos referimos a que los modelos capturan correctamente las palabras habladas sin añadir contenido no expresado."

Sin embargo, el rendimiento puede variar entre idiomas. Los puntos de referencia internos de OpenAI indican que gpt-4o-transcribe, el más preciso de los dos, tiene una "tasa de error de palabras" cercana al 30% para idiomas índicos y dravídicos como tamil, telugu, malayalam y kannada. Esto sugiere que aproximadamente tres de cada diez palabras podrían diferir de una transcripción humana en estos idiomas.

En un cambio respecto a su práctica habitual, OpenAI no hará que estos nuevos modelos de transcripción estén disponibles gratuitamente. Históricamente, lanzaron nuevas versiones de Whisper bajo una licencia MIT para uso comercial. Harris señaló que gpt-4o-transcribe y gpt-4o-mini-transcribe son significativamente más grandes que Whisper, lo que los hace inadecuados para un lanzamiento abierto.

"Estos modelos son demasiado grandes para ejecutarse en una laptop típica como podía hacer Whisper," añadió Harris. "Cuando lanzamos modelos abiertamente, queremos hacerlo de manera reflexiva, asegurándonos de que estén adaptados a necesidades específicas. Vemos los dispositivos de los usuarios finales como un área principal para modelos de código abierto."

Actualizado el 20 de marzo de 2025, 11:54 a.m. PT para aclarar el lenguaje en torno a la tasa de error de palabras y actualizar el gráfico de resultados de referencia con una versión más reciente.

Una organización sin ánimo de lucro aprovecha los agentes de IA para impulsar la recaudación de fondos benéficos

Mientras las grandes corporaciones tecnológicas promueven los "agentes" de IA como potenciadores de la productividad para las empresas, una organización sin ánimo de lucro está demostrando su potencia

Una organización sin ánimo de lucro aprovecha los agentes de IA para impulsar la recaudación de fondos benéficos

Mientras las grandes corporaciones tecnológicas promueven los "agentes" de IA como potenciadores de la productividad para las empresas, una organización sin ánimo de lucro está demostrando su potencia

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

ChatGPT integra Google Drive y Dropbox para acceder a los archivos

ChatGPT mejora la productividad con nuevas funciones empresarialesOpenAI ha presentado dos nuevas y potentes funciones que transforman ChatGPT en una completa herramienta de productividad empresaria

ChatGPT integra Google Drive y Dropbox para acceder a los archivos

ChatGPT mejora la productividad con nuevas funciones empresarialesOpenAI ha presentado dos nuevas y potentes funciones que transforman ChatGPT en una completa herramienta de productividad empresaria

19 de agosto de 2025 10:01:39 GMT+02:00

19 de agosto de 2025 10:01:39 GMT+02:00

The new OpenAI models sound like a game-changer for voice tech! Can't wait to see how devs use this to make apps talk smoother than ever. 😎

0

0

23 de julio de 2025 10:50:48 GMT+02:00

23 de julio de 2025 10:50:48 GMT+02:00

Wow, OpenAI's new transcription and voice models sound like a game-changer! I'm curious how these 'agentic' systems will stack up against real-world tasks. Could they finally nail natural-sounding convos? 🤔

0

0

20 de abril de 2025 21:57:07 GMT+02:00

20 de abril de 2025 21:57:07 GMT+02:00

Os novos modelos de transcrição e geração de voz da OpenAI são um divisor de águas! Estou usando no meu podcast e as melhorias são impressionantes. O único ponto negativo? São um pouco caros, mas se você puder pagar, vale cada centavo! 🎙️💸

0

0

17 de abril de 2025 06:50:37 GMT+02:00

17 de abril de 2025 06:50:37 GMT+02:00

OpenAI's new transcription and voice models are a game changer! I've been using them for my podcast and the improvements are night and day. The only downside? They're a bit pricey, but if you can swing it, they're worth every penny! 🎙️💸

0

0

17 de abril de 2025 06:38:26 GMT+02:00

17 de abril de 2025 06:38:26 GMT+02:00

OpenAI의 새로운 음성 인식 및 음성 생성 모델은 정말 혁신적이에요! 제 팟캐스트에서 사용 중인데, 개선이 눈에 띄어요. 단점은 조금 비싸다는 건데, 감당할 수 있다면 그만한 가치가 있어요! 🎙️💸

0

0

16 de abril de 2025 07:54:41 GMT+02:00

16 de abril de 2025 07:54:41 GMT+02:00

OpenAIの新しい音声認識と音声生成モデルは革命的です!ポッドキャストで使っていますが、改善が劇的です。唯一の欠点は少し高価なことですが、払えるならその価値は十分にあります!🎙️💸

0

0