OpenAI verbessert seine Transkriptions- und Sprach-generierende KI-Modelle

OpenAI führt neue KI-Modelle für Transkription und Sprachgenerierung über seine API ein und verspricht erhebliche Verbesserungen gegenüber den früheren Versionen. Diese Updates sind Teil der umfassenderen „agentischen“ Vision von OpenAI, die darauf abzielt, autonome Systeme zu schaffen, die Aufgaben unabhängig für Nutzer ausführen können. Während der Begriff „Agent“ diskutiert werden kann, sieht Olivier Godement, Leiter der Produktabteilung bei OpenAI, ihn als Chatbot, der mit den Kunden eines Unternehmens interagieren kann.

„Wir werden in den kommenden Monaten immer mehr Agenten sehen“, teilte Godement TechCrunch während eines Briefings mit. „Das übergeordnete Ziel ist es, Kunden und Entwicklern zu helfen, Agenten zu nutzen, die nützlich, zugänglich und präzise sind.“

Das neueste Text-to-Speech-Modell von OpenAI, genannt „gpt-4o-mini-tts“, zielt nicht nur darauf ab, lebensechtere und nuanciertere Sprache zu erzeugen, sondern ist auch anpassungsfähiger als seine Vorgänger. Entwickler können das Modell nun mit natürlichen Sprachbefehlen steuern, wie z. B. „sprich wie ein verrückter Wissenschaftler“ oder „verwende eine ruhige Stimme, wie ein Achtsamkeitslehrer“. Dieses Maß an Kontrolle ermöglicht eine personalisiertere Spracherfahrung.

Hier ist ein Beispiel für eine „True-Crime-Stil“-Stimme, die verwittert klingt:

Und hier ist ein Beispiel für eine weibliche „professionelle“ Stimme:

Jeff Harris, Mitglied des Produktteams von OpenAI, betonte gegenüber TechCrunch, dass das Ziel darin besteht, Entwicklern die Anpassung sowohl der Sprach-„Erfahrung“ als auch des „Kontexts“ zu ermöglichen. „In verschiedenen Szenarien möchte man keine monotone Stimme“, erklärte Harris. „Zum Beispiel in einer Kundensupport-Situation, in der die Stimme reumütig klingen soll, wenn ein Fehler passiert ist, kann man diese Emotion in die Stimme einfließen lassen. Wir sind fest davon überzeugt, dass Entwickler und Nutzer nicht nur den Inhalt, sondern auch die Art der Sprache kontrollieren möchten.“

In Bezug auf die neuen Speech-to-Text-Angebote von OpenAI, „gpt-4o-transcribe“ und „gpt-4o-mini-transcribe“, sollen diese Modelle das veraltete Whisper-Transkriptionsmodell ersetzen. Sie wurden mit einer vielfältigen Auswahl an hochwertigen Audiodaten trainiert und sollen akzentuierte und abwechslungsreiche Sprache besser verarbeiten, selbst in lauten Umgebungen. Zudem sind diese Modelle weniger anfällig für „Halluzinationen“, ein Problem, bei dem Whisper manchmal Wörter oder ganze Passagen erfand und Ungenauigkeiten wie rassistische Kommentare oder fiktive medizinische Behandlungen in Transkripte einfügte.

„Diese Modelle zeigen in dieser Hinsicht deutliche Verbesserungen gegenüber Whisper“, bemerkte Harris. „Die Genauigkeit des Modells ist entscheidend für eine zuverlässige Spracherfahrung, und mit Genauigkeit meinen wir, dass die Modelle die gesprochenen Wörter korrekt erfassen, ohne nicht gesprochene Inhalte hinzuzufügen.“

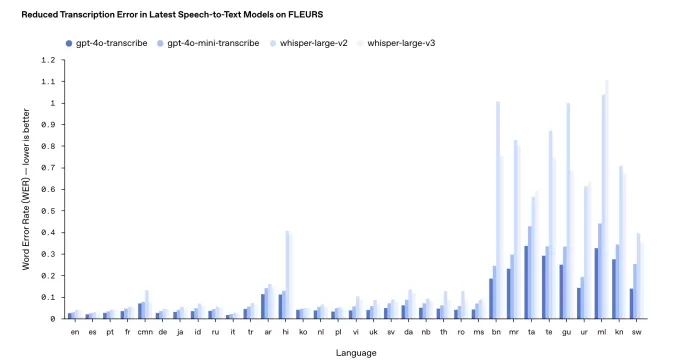

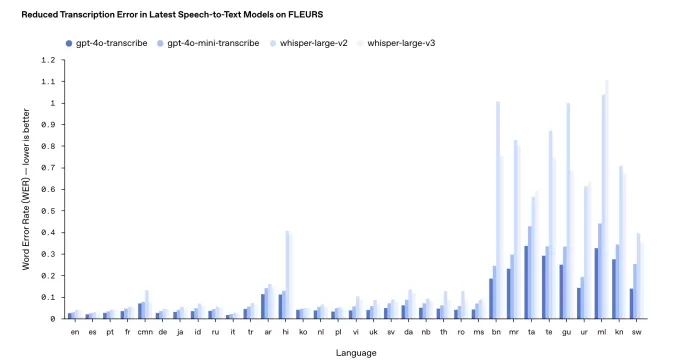

Die Leistung kann jedoch je nach Sprache variieren. Interne Benchmarks von OpenAI zeigen, dass gpt-4o-transcribe, das präzisere der beiden Modelle, eine „Wortfehlerrate“ von fast 30 % für indische und dravidische Sprachen wie Tamil, Telugu, Malayalam und Kannada aufweist. Dies deutet darauf hin, dass etwa drei von zehn Wörtern in diesen Sprachen von einer menschlichen Transkription abweichen könnten.

Die Ergebnisse aus dem OpenAI Transkriptions-Benchmarking. Bildnachweis: OpenAI Entgegen ihrer üblichen Praxis wird OpenAI diese neuen Transkriptionsmodelle nicht kostenlos zur Verfügung stellen. Historisch gesehen wurden neue Whisper-Versionen unter einer MIT-Lizenz für kommerzielle Nutzung freigegeben. Harris wies darauf hin, dass gpt-4o-transcribe und gpt-4o-mini-transcribe deutlich größer als Whisper sind, was sie für eine offene Freigabe ungeeignet macht.

„Diese Modelle sind zu groß, um auf einem typischen Laptop wie Whisper ausgeführt zu werden“, fügte Harris hinzu. „Wenn wir Modelle offen freigeben, wollen wir dies durchdacht tun und sicherstellen, dass sie für spezifische Bedürfnisse zugeschnitten sind. Wir sehen Endnutzergeräte als einen Hauptanwendungsbereich für Open-Source-Modelle.“

Aktualisiert am 20. März 2025, 11:54 Uhr PT, um die Formulierung zur Wortfehlerrate zu präzisieren und das Benchmark-Ergebnisdiagramm mit einer neueren Version zu aktualisieren.

Verwandter Artikel

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

ChatGPT fügt Google Drive und Dropbox Integration für Dateizugriff hinzu

ChatGPT steigert die Produktivität mit neuen UnternehmensfunktionenOpenAI hat zwei leistungsstarke neue Funktionen vorgestellt, die ChatGPT zu einem umfassenden Produktivitätswerkzeug für Unternehme

Kommentare (32)

0/200

ChatGPT fügt Google Drive und Dropbox Integration für Dateizugriff hinzu

ChatGPT steigert die Produktivität mit neuen UnternehmensfunktionenOpenAI hat zwei leistungsstarke neue Funktionen vorgestellt, die ChatGPT zu einem umfassenden Produktivitätswerkzeug für Unternehme

Kommentare (32)

0/200

![FrankMartínez]() FrankMartínez

FrankMartínez

19. August 2025 10:01:39 MESZ

19. August 2025 10:01:39 MESZ

The new OpenAI models sound like a game-changer for voice tech! Can't wait to see how devs use this to make apps talk smoother than ever. 😎

0

0

![BenHernández]() BenHernández

BenHernández

23. Juli 2025 10:50:48 MESZ

23. Juli 2025 10:50:48 MESZ

Wow, OpenAI's new transcription and voice models sound like a game-changer! I'm curious how these 'agentic' systems will stack up against real-world tasks. Could they finally nail natural-sounding convos? 🤔

0

0

![GeorgeTaylor]() GeorgeTaylor

GeorgeTaylor

20. April 2025 21:57:07 MESZ

20. April 2025 21:57:07 MESZ

Os novos modelos de transcrição e geração de voz da OpenAI são um divisor de águas! Estou usando no meu podcast e as melhorias são impressionantes. O único ponto negativo? São um pouco caros, mas se você puder pagar, vale cada centavo! 🎙️💸

0

0

![GregoryAllen]() GregoryAllen

GregoryAllen

17. April 2025 06:50:37 MESZ

17. April 2025 06:50:37 MESZ

OpenAI's new transcription and voice models are a game changer! I've been using them for my podcast and the improvements are night and day. The only downside? They're a bit pricey, but if you can swing it, they're worth every penny! 🎙️💸

0

0

![StevenAllen]() StevenAllen

StevenAllen

17. April 2025 06:38:26 MESZ

17. April 2025 06:38:26 MESZ

OpenAI의 새로운 음성 인식 및 음성 생성 모델은 정말 혁신적이에요! 제 팟캐스트에서 사용 중인데, 개선이 눈에 띄어요. 단점은 조금 비싸다는 건데, 감당할 수 있다면 그만한 가치가 있어요! 🎙️💸

0

0

![NicholasClark]() NicholasClark

NicholasClark

16. April 2025 07:54:41 MESZ

16. April 2025 07:54:41 MESZ

OpenAIの新しい音声認識と音声生成モデルは革命的です!ポッドキャストで使っていますが、改善が劇的です。唯一の欠点は少し高価なことですが、払えるならその価値は十分にあります!🎙️💸

0

0

OpenAI führt neue KI-Modelle für Transkription und Sprachgenerierung über seine API ein und verspricht erhebliche Verbesserungen gegenüber den früheren Versionen. Diese Updates sind Teil der umfassenderen „agentischen“ Vision von OpenAI, die darauf abzielt, autonome Systeme zu schaffen, die Aufgaben unabhängig für Nutzer ausführen können. Während der Begriff „Agent“ diskutiert werden kann, sieht Olivier Godement, Leiter der Produktabteilung bei OpenAI, ihn als Chatbot, der mit den Kunden eines Unternehmens interagieren kann.

„Wir werden in den kommenden Monaten immer mehr Agenten sehen“, teilte Godement TechCrunch während eines Briefings mit. „Das übergeordnete Ziel ist es, Kunden und Entwicklern zu helfen, Agenten zu nutzen, die nützlich, zugänglich und präzise sind.“

Das neueste Text-to-Speech-Modell von OpenAI, genannt „gpt-4o-mini-tts“, zielt nicht nur darauf ab, lebensechtere und nuanciertere Sprache zu erzeugen, sondern ist auch anpassungsfähiger als seine Vorgänger. Entwickler können das Modell nun mit natürlichen Sprachbefehlen steuern, wie z. B. „sprich wie ein verrückter Wissenschaftler“ oder „verwende eine ruhige Stimme, wie ein Achtsamkeitslehrer“. Dieses Maß an Kontrolle ermöglicht eine personalisiertere Spracherfahrung.

Hier ist ein Beispiel für eine „True-Crime-Stil“-Stimme, die verwittert klingt:

Und hier ist ein Beispiel für eine weibliche „professionelle“ Stimme:

Jeff Harris, Mitglied des Produktteams von OpenAI, betonte gegenüber TechCrunch, dass das Ziel darin besteht, Entwicklern die Anpassung sowohl der Sprach-„Erfahrung“ als auch des „Kontexts“ zu ermöglichen. „In verschiedenen Szenarien möchte man keine monotone Stimme“, erklärte Harris. „Zum Beispiel in einer Kundensupport-Situation, in der die Stimme reumütig klingen soll, wenn ein Fehler passiert ist, kann man diese Emotion in die Stimme einfließen lassen. Wir sind fest davon überzeugt, dass Entwickler und Nutzer nicht nur den Inhalt, sondern auch die Art der Sprache kontrollieren möchten.“

In Bezug auf die neuen Speech-to-Text-Angebote von OpenAI, „gpt-4o-transcribe“ und „gpt-4o-mini-transcribe“, sollen diese Modelle das veraltete Whisper-Transkriptionsmodell ersetzen. Sie wurden mit einer vielfältigen Auswahl an hochwertigen Audiodaten trainiert und sollen akzentuierte und abwechslungsreiche Sprache besser verarbeiten, selbst in lauten Umgebungen. Zudem sind diese Modelle weniger anfällig für „Halluzinationen“, ein Problem, bei dem Whisper manchmal Wörter oder ganze Passagen erfand und Ungenauigkeiten wie rassistische Kommentare oder fiktive medizinische Behandlungen in Transkripte einfügte.

„Diese Modelle zeigen in dieser Hinsicht deutliche Verbesserungen gegenüber Whisper“, bemerkte Harris. „Die Genauigkeit des Modells ist entscheidend für eine zuverlässige Spracherfahrung, und mit Genauigkeit meinen wir, dass die Modelle die gesprochenen Wörter korrekt erfassen, ohne nicht gesprochene Inhalte hinzuzufügen.“

Die Leistung kann jedoch je nach Sprache variieren. Interne Benchmarks von OpenAI zeigen, dass gpt-4o-transcribe, das präzisere der beiden Modelle, eine „Wortfehlerrate“ von fast 30 % für indische und dravidische Sprachen wie Tamil, Telugu, Malayalam und Kannada aufweist. Dies deutet darauf hin, dass etwa drei von zehn Wörtern in diesen Sprachen von einer menschlichen Transkription abweichen könnten.

Entgegen ihrer üblichen Praxis wird OpenAI diese neuen Transkriptionsmodelle nicht kostenlos zur Verfügung stellen. Historisch gesehen wurden neue Whisper-Versionen unter einer MIT-Lizenz für kommerzielle Nutzung freigegeben. Harris wies darauf hin, dass gpt-4o-transcribe und gpt-4o-mini-transcribe deutlich größer als Whisper sind, was sie für eine offene Freigabe ungeeignet macht.

„Diese Modelle sind zu groß, um auf einem typischen Laptop wie Whisper ausgeführt zu werden“, fügte Harris hinzu. „Wenn wir Modelle offen freigeben, wollen wir dies durchdacht tun und sicherstellen, dass sie für spezifische Bedürfnisse zugeschnitten sind. Wir sehen Endnutzergeräte als einen Hauptanwendungsbereich für Open-Source-Modelle.“

Aktualisiert am 20. März 2025, 11:54 Uhr PT, um die Formulierung zur Wortfehlerrate zu präzisieren und das Benchmark-Ergebnisdiagramm mit einer neueren Version zu aktualisieren.

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

ChatGPT fügt Google Drive und Dropbox Integration für Dateizugriff hinzu

ChatGPT steigert die Produktivität mit neuen UnternehmensfunktionenOpenAI hat zwei leistungsstarke neue Funktionen vorgestellt, die ChatGPT zu einem umfassenden Produktivitätswerkzeug für Unternehme

ChatGPT fügt Google Drive und Dropbox Integration für Dateizugriff hinzu

ChatGPT steigert die Produktivität mit neuen UnternehmensfunktionenOpenAI hat zwei leistungsstarke neue Funktionen vorgestellt, die ChatGPT zu einem umfassenden Produktivitätswerkzeug für Unternehme

19. August 2025 10:01:39 MESZ

19. August 2025 10:01:39 MESZ

The new OpenAI models sound like a game-changer for voice tech! Can't wait to see how devs use this to make apps talk smoother than ever. 😎

0

0

23. Juli 2025 10:50:48 MESZ

23. Juli 2025 10:50:48 MESZ

Wow, OpenAI's new transcription and voice models sound like a game-changer! I'm curious how these 'agentic' systems will stack up against real-world tasks. Could they finally nail natural-sounding convos? 🤔

0

0

20. April 2025 21:57:07 MESZ

20. April 2025 21:57:07 MESZ

Os novos modelos de transcrição e geração de voz da OpenAI são um divisor de águas! Estou usando no meu podcast e as melhorias são impressionantes. O único ponto negativo? São um pouco caros, mas se você puder pagar, vale cada centavo! 🎙️💸

0

0

17. April 2025 06:50:37 MESZ

17. April 2025 06:50:37 MESZ

OpenAI's new transcription and voice models are a game changer! I've been using them for my podcast and the improvements are night and day. The only downside? They're a bit pricey, but if you can swing it, they're worth every penny! 🎙️💸

0

0

17. April 2025 06:38:26 MESZ

17. April 2025 06:38:26 MESZ

OpenAI의 새로운 음성 인식 및 음성 생성 모델은 정말 혁신적이에요! 제 팟캐스트에서 사용 중인데, 개선이 눈에 띄어요. 단점은 조금 비싸다는 건데, 감당할 수 있다면 그만한 가치가 있어요! 🎙️💸

0

0

16. April 2025 07:54:41 MESZ

16. April 2025 07:54:41 MESZ

OpenAIの新しい音声認識と音声生成モデルは革命的です!ポッドキャストで使っていますが、改善が劇的です。唯一の欠点は少し高価なことですが、払えるならその価値は十分にあります!🎙️💸

0

0