OpenAai atualiza seus modelos de AI de transcrição e geração de voz

OpenAI está lançando novos modelos de IA para transcrição e geração de voz por meio de sua API, prometendo melhorias significativas em relação às versões anteriores. Essas atualizações fazem parte da visão mais ampla de "agentic" da OpenAI, que se concentra na criação de sistemas autônomos capazes de realizar tarefas de forma independente para os usuários. Embora o termo "agente" possa ser debatido, o chefe de produto da OpenAI, Olivier Godement, o enxerga como um chatbot que pode interagir com os clientes de uma empresa.

"Veremos cada vez mais agentes surgirem nos próximos meses," compartilhou Godement com a TechCrunch durante uma entrevista. "O objetivo principal é ajudar clientes e desenvolvedores a utilizarem agentes que sejam úteis, acessíveis e precisos."

O mais recente modelo de texto para fala da OpenAI, chamado "gpt-4o-mini-tts," não apenas busca produzir uma fala mais realista e matizada, mas também é mais adaptável que seus antecessores. Os desenvolvedores agora podem guiar o modelo usando comandos em linguagem natural, como "fale como um cientista louco" ou "use uma voz serena, como um professor de mindfulness." Esse nível de controle permite uma experiência de voz mais personalizada.

Aqui está uma amostra de uma voz "estilo true crime", envelhecida:

E aqui está um exemplo de uma voz feminina "profissional":

Jeff Harris, membro da equipe de produtos da OpenAI, enfatizou à TechCrunch que o objetivo é permitir que os desenvolvedores personalizem tanto a "experiência" quanto o "contexto" da voz. "Em vários cenários, você não quer uma voz monótona," explicou Harris. "Por exemplo, em um ambiente de suporte ao cliente, onde a voz precisa soar apologética por um erro, você pode infundir essa emoção na voz. Acreditamos fortemente que desenvolvedores e usuários querem controlar não apenas o conteúdo, mas também a maneira de falar."

Passando para as novas ofertas de fala para texto da OpenAI, "gpt-4o-transcribe" e "gpt-4o-mini-transcribe," esses modelos estão prontos para substituir o modelo de transcrição Whisper, já ultrapassado. Treinados em uma ampla gama de dados de áudio de alta qualidade, eles afirmam lidar melhor com fala acentuada e variada, mesmo em ambientes ruidosos. Além disso, esses modelos são menos propensos a "alucinações," um problema em que o Whisper às vezes inventava palavras ou passagens inteiras, adicionando imprecisões como comentários raciais ou tratamentos médicos fictícios às transcrições.

"Esses modelos mostram uma melhoria significativa em relação ao Whisper nesse aspecto," observou Harris. "Garantir a precisão do modelo é crucial para uma experiência de voz confiável, e por precisão, queremos dizer que os modelos capturam corretamente as palavras faladas sem adicionar conteúdo não expressado."

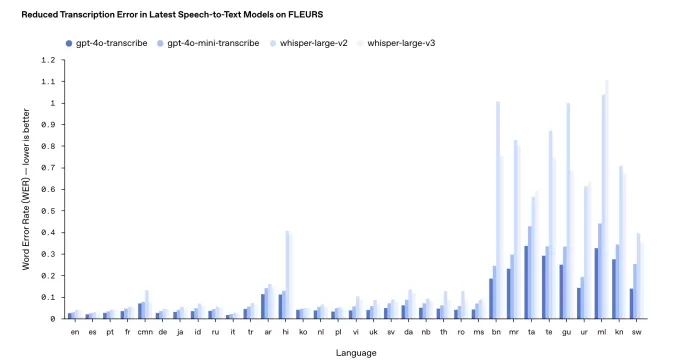

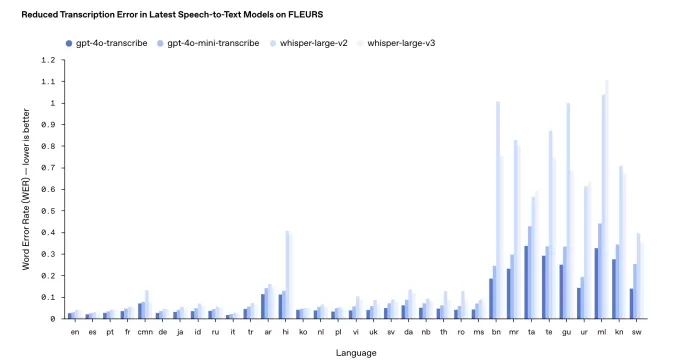

No entanto, o desempenho pode variar entre idiomas. Os benchmarks internos da OpenAI indicam que o gpt-4o-transcribe, o mais preciso dos dois, tem uma "taxa de erro de palavras" próxima de 30% para idiomas indianos e dravídicos como tâmil, telugu, malaiala e canarês. Isso sugere que cerca de três em cada dez palavras podem diferir de uma transcrição humana nesses idiomas.

Os resultados do benchmarking de transcrição da OpenAI. Créditos da imagem: OpenAI Diferentemente da prática usual, a OpenAI não disponibilizará esses novos modelos de transcrição gratuitamente. Historicamente, eles lançaram novas versões do Whisper sob uma licença MIT para uso comercial. Harris destacou que o gpt-4o-transcribe e o gpt-4o-mini-transcribe são significativamente maiores que o Whisper, tornando-os inadequados para um lançamento aberto.

"Esses modelos são muito grandes para rodar em um laptop comum como o Whisper podia," acrescentou Harris. "Quando lançamos modelos abertamente, queremos fazê-lo de forma pensada, garantindo que sejam adaptados para necessidades específicas. Vemos dispositivos de usuários finais como uma área principal para modelos de código aberto."

Atualizado em 20 de março de 2025, às 11:54 da manhã PT para esclarecer a linguagem sobre a taxa de erro de palavras e atualizar o gráfico de resultados de benchmark com uma versão mais recente.

Artigo relacionado

Organização sem fins lucrativos utiliza agentes de IA para aumentar os esforços de arrecadação de fundos para instituições de caridade

Enquanto as grandes corporações de tecnologia promovem "agentes" de IA como impulsionadores de produtividade para as empresas, uma organização sem fins lucrativos está demonstrando seu potencial para

Organização sem fins lucrativos utiliza agentes de IA para aumentar os esforços de arrecadação de fundos para instituições de caridade

Enquanto as grandes corporações de tecnologia promovem "agentes" de IA como impulsionadores de produtividade para as empresas, uma organização sem fins lucrativos está demonstrando seu potencial para

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

ChatGPT adiciona integração com Google Drive e Dropbox para acesso a arquivos

ChatGPT aumenta a produtividade com novos recursos empresariaisA OpenAI revelou dois novos recursos poderosos que transformam o ChatGPT em uma ferramenta abrangente de produtividade empresarial: doc

Comentários (32)

0/200

ChatGPT adiciona integração com Google Drive e Dropbox para acesso a arquivos

ChatGPT aumenta a produtividade com novos recursos empresariaisA OpenAI revelou dois novos recursos poderosos que transformam o ChatGPT em uma ferramenta abrangente de produtividade empresarial: doc

Comentários (32)

0/200

![FrankMartínez]() FrankMartínez

FrankMartínez

19 de Agosto de 2025 à39 09:01:39 WEST

19 de Agosto de 2025 à39 09:01:39 WEST

The new OpenAI models sound like a game-changer for voice tech! Can't wait to see how devs use this to make apps talk smoother than ever. 😎

0

0

![BenHernández]() BenHernández

BenHernández

23 de Julho de 2025 à48 09:50:48 WEST

23 de Julho de 2025 à48 09:50:48 WEST

Wow, OpenAI's new transcription and voice models sound like a game-changer! I'm curious how these 'agentic' systems will stack up against real-world tasks. Could they finally nail natural-sounding convos? 🤔

0

0

![GeorgeTaylor]() GeorgeTaylor

GeorgeTaylor

20 de Abril de 2025 à7 20:57:07 WEST

20 de Abril de 2025 à7 20:57:07 WEST

Os novos modelos de transcrição e geração de voz da OpenAI são um divisor de águas! Estou usando no meu podcast e as melhorias são impressionantes. O único ponto negativo? São um pouco caros, mas se você puder pagar, vale cada centavo! 🎙️💸

0

0

![GregoryAllen]() GregoryAllen

GregoryAllen

17 de Abril de 2025 à37 05:50:37 WEST

17 de Abril de 2025 à37 05:50:37 WEST

OpenAI's new transcription and voice models are a game changer! I've been using them for my podcast and the improvements are night and day. The only downside? They're a bit pricey, but if you can swing it, they're worth every penny! 🎙️💸

0

0

![StevenAllen]() StevenAllen

StevenAllen

17 de Abril de 2025 à26 05:38:26 WEST

17 de Abril de 2025 à26 05:38:26 WEST

OpenAI의 새로운 음성 인식 및 음성 생성 모델은 정말 혁신적이에요! 제 팟캐스트에서 사용 중인데, 개선이 눈에 띄어요. 단점은 조금 비싸다는 건데, 감당할 수 있다면 그만한 가치가 있어요! 🎙️💸

0

0

![NicholasClark]() NicholasClark

NicholasClark

16 de Abril de 2025 à41 06:54:41 WEST

16 de Abril de 2025 à41 06:54:41 WEST

OpenAIの新しい音声認識と音声生成モデルは革命的です!ポッドキャストで使っていますが、改善が劇的です。唯一の欠点は少し高価なことですが、払えるならその価値は十分にあります!🎙️💸

0

0

OpenAI está lançando novos modelos de IA para transcrição e geração de voz por meio de sua API, prometendo melhorias significativas em relação às versões anteriores. Essas atualizações fazem parte da visão mais ampla de "agentic" da OpenAI, que se concentra na criação de sistemas autônomos capazes de realizar tarefas de forma independente para os usuários. Embora o termo "agente" possa ser debatido, o chefe de produto da OpenAI, Olivier Godement, o enxerga como um chatbot que pode interagir com os clientes de uma empresa.

"Veremos cada vez mais agentes surgirem nos próximos meses," compartilhou Godement com a TechCrunch durante uma entrevista. "O objetivo principal é ajudar clientes e desenvolvedores a utilizarem agentes que sejam úteis, acessíveis e precisos."

O mais recente modelo de texto para fala da OpenAI, chamado "gpt-4o-mini-tts," não apenas busca produzir uma fala mais realista e matizada, mas também é mais adaptável que seus antecessores. Os desenvolvedores agora podem guiar o modelo usando comandos em linguagem natural, como "fale como um cientista louco" ou "use uma voz serena, como um professor de mindfulness." Esse nível de controle permite uma experiência de voz mais personalizada.

Aqui está uma amostra de uma voz "estilo true crime", envelhecida:

E aqui está um exemplo de uma voz feminina "profissional":

Jeff Harris, membro da equipe de produtos da OpenAI, enfatizou à TechCrunch que o objetivo é permitir que os desenvolvedores personalizem tanto a "experiência" quanto o "contexto" da voz. "Em vários cenários, você não quer uma voz monótona," explicou Harris. "Por exemplo, em um ambiente de suporte ao cliente, onde a voz precisa soar apologética por um erro, você pode infundir essa emoção na voz. Acreditamos fortemente que desenvolvedores e usuários querem controlar não apenas o conteúdo, mas também a maneira de falar."

Passando para as novas ofertas de fala para texto da OpenAI, "gpt-4o-transcribe" e "gpt-4o-mini-transcribe," esses modelos estão prontos para substituir o modelo de transcrição Whisper, já ultrapassado. Treinados em uma ampla gama de dados de áudio de alta qualidade, eles afirmam lidar melhor com fala acentuada e variada, mesmo em ambientes ruidosos. Além disso, esses modelos são menos propensos a "alucinações," um problema em que o Whisper às vezes inventava palavras ou passagens inteiras, adicionando imprecisões como comentários raciais ou tratamentos médicos fictícios às transcrições.

"Esses modelos mostram uma melhoria significativa em relação ao Whisper nesse aspecto," observou Harris. "Garantir a precisão do modelo é crucial para uma experiência de voz confiável, e por precisão, queremos dizer que os modelos capturam corretamente as palavras faladas sem adicionar conteúdo não expressado."

No entanto, o desempenho pode variar entre idiomas. Os benchmarks internos da OpenAI indicam que o gpt-4o-transcribe, o mais preciso dos dois, tem uma "taxa de erro de palavras" próxima de 30% para idiomas indianos e dravídicos como tâmil, telugu, malaiala e canarês. Isso sugere que cerca de três em cada dez palavras podem diferir de uma transcrição humana nesses idiomas.

Diferentemente da prática usual, a OpenAI não disponibilizará esses novos modelos de transcrição gratuitamente. Historicamente, eles lançaram novas versões do Whisper sob uma licença MIT para uso comercial. Harris destacou que o gpt-4o-transcribe e o gpt-4o-mini-transcribe são significativamente maiores que o Whisper, tornando-os inadequados para um lançamento aberto.

"Esses modelos são muito grandes para rodar em um laptop comum como o Whisper podia," acrescentou Harris. "Quando lançamos modelos abertamente, queremos fazê-lo de forma pensada, garantindo que sejam adaptados para necessidades específicas. Vemos dispositivos de usuários finais como uma área principal para modelos de código aberto."

Atualizado em 20 de março de 2025, às 11:54 da manhã PT para esclarecer a linguagem sobre a taxa de erro de palavras e atualizar o gráfico de resultados de benchmark com uma versão mais recente.

Organização sem fins lucrativos utiliza agentes de IA para aumentar os esforços de arrecadação de fundos para instituições de caridade

Enquanto as grandes corporações de tecnologia promovem "agentes" de IA como impulsionadores de produtividade para as empresas, uma organização sem fins lucrativos está demonstrando seu potencial para

Organização sem fins lucrativos utiliza agentes de IA para aumentar os esforços de arrecadação de fundos para instituições de caridade

Enquanto as grandes corporações de tecnologia promovem "agentes" de IA como impulsionadores de produtividade para as empresas, uma organização sem fins lucrativos está demonstrando seu potencial para

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

ChatGPT adiciona integração com Google Drive e Dropbox para acesso a arquivos

ChatGPT aumenta a produtividade com novos recursos empresariaisA OpenAI revelou dois novos recursos poderosos que transformam o ChatGPT em uma ferramenta abrangente de produtividade empresarial: doc

ChatGPT adiciona integração com Google Drive e Dropbox para acesso a arquivos

ChatGPT aumenta a produtividade com novos recursos empresariaisA OpenAI revelou dois novos recursos poderosos que transformam o ChatGPT em uma ferramenta abrangente de produtividade empresarial: doc

19 de Agosto de 2025 à39 09:01:39 WEST

19 de Agosto de 2025 à39 09:01:39 WEST

The new OpenAI models sound like a game-changer for voice tech! Can't wait to see how devs use this to make apps talk smoother than ever. 😎

0

0

23 de Julho de 2025 à48 09:50:48 WEST

23 de Julho de 2025 à48 09:50:48 WEST

Wow, OpenAI's new transcription and voice models sound like a game-changer! I'm curious how these 'agentic' systems will stack up against real-world tasks. Could they finally nail natural-sounding convos? 🤔

0

0

20 de Abril de 2025 à7 20:57:07 WEST

20 de Abril de 2025 à7 20:57:07 WEST

Os novos modelos de transcrição e geração de voz da OpenAI são um divisor de águas! Estou usando no meu podcast e as melhorias são impressionantes. O único ponto negativo? São um pouco caros, mas se você puder pagar, vale cada centavo! 🎙️💸

0

0

17 de Abril de 2025 à37 05:50:37 WEST

17 de Abril de 2025 à37 05:50:37 WEST

OpenAI's new transcription and voice models are a game changer! I've been using them for my podcast and the improvements are night and day. The only downside? They're a bit pricey, but if you can swing it, they're worth every penny! 🎙️💸

0

0

17 de Abril de 2025 à26 05:38:26 WEST

17 de Abril de 2025 à26 05:38:26 WEST

OpenAI의 새로운 음성 인식 및 음성 생성 모델은 정말 혁신적이에요! 제 팟캐스트에서 사용 중인데, 개선이 눈에 띄어요. 단점은 조금 비싸다는 건데, 감당할 수 있다면 그만한 가치가 있어요! 🎙️💸

0

0

16 de Abril de 2025 à41 06:54:41 WEST

16 de Abril de 2025 à41 06:54:41 WEST

OpenAIの新しい音声認識と音声生成モデルは革命的です!ポッドキャストで使っていますが、改善が劇的です。唯一の欠点は少し高価なことですが、払えるならその価値は十分にあります!🎙️💸

0

0