OpenAI модернизирует свою транскрипционную и генерирующую игенерирующую модели искусственного интеллекта

OpenAI выпускает новые модели ИИ для транскрипции и генерации голоса через свой API, обещающие значительные улучшения по сравнению с предыдущими версиями. Эти обновления являются частью более широкой "агентной" концепции OpenAI, которая сосредоточена на создании автономных систем, способных выполнять задачи самостоятельно для пользователей. Хотя термин "агент" может быть предметом споров, руководитель отдела продуктов OpenAI Оливье Годеман рассматривает его как чат-бота, который может взаимодействовать с клиентами бизнеса.

"В ближайшие месяцы мы увидим появление все большего числа агентов," — поделился Годеман с TechCrunch во время брифинга. "Главная цель — помочь клиентам и разработчикам использовать агентов, которые будут полезны, доступны и точны."

Новейшая модель преобразования текста в речь от OpenAI, названная "gpt-4o-mini-tts," не только стремится создавать более реалистичную и нюансированную речь, но и является более адаптивной, чем ее предшественники. Разработчики теперь могут управлять моделью с помощью команд на естественном языке, таких как "говори как безумный ученый" или "используй спокойный голос, как у учителя медитации." Этот уровень контроля позволяет создавать более персонализированный голосовой опыт.

Вот пример голоса в стиле "true crime", с хрипотцой:

А вот пример женского "профессионального" голоса:

Джефф Харрис, член команды по продуктам OpenAI, подчеркнул в разговоре с TechCrunch, что цель — позволить разработчикам настраивать как голосовой "опыт", так и "контекст". "В разных сценариях вам не нужен монотонный голос," — пояснил Харрис. "Например, в ситуации поддержки клиентов, где голос должен звучать извиняющимся за ошибку, вы можете вложить эту эмоцию в голос. Мы твердо убеждены, что разработчики и пользователи хотят контролировать не только содержание, но и манеру речи."

Переходя к новым предложениям OpenAI по преобразованию речи в текст, модели "gpt-4o-transcribe" и "gpt-4o-mini-transcribe" призваны заменить устаревшую модель транскрипции Whisper. Обученные на разнообразном массиве высококачественных аудиоданных, они, как утверждается, лучше справляются с акцентированной и разнообразной речью, даже в шумных условиях. Кроме того, эти модели менее подвержены "галлюцинациям", проблеме, при которой Whisper иногда придумывал слова или целые отрывки, добавляя неточности, такие как расовые комментарии или вымышленные медицинские процедуры в транскрипты.

"Эти модели показывают значительное улучшение по сравнению с Whisper в этом отношении," — отметил Харрис. "Обеспечение точности модели крайне важно для надежного голосового опыта, и под точностью мы подразумеваем, что модели корректно улавливают произнесенные слова, не добавляя непроизнесенного содержания."

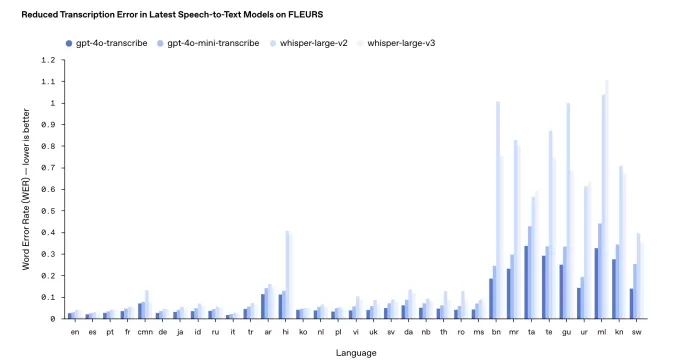

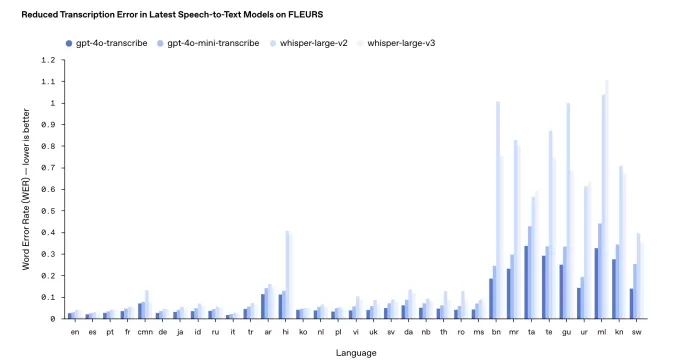

Однако производительность может варьироваться в зависимости от языка. Внутренние тесты OpenAI показывают, что gpt-4o-transcribe, более точная из двух моделей, имеет "уровень ошибок слов" около 30% для индийских и дравидийских языков, таких как тамильский, телугу, малаялам и каннада. Это означает, что примерно три из каждых десяти слов могут отличаться от человеческой транскрипции на этих языках.

Результаты тестирования транскрипции OpenAI. Источник изображения: OpenAI В отличие от своей обычной практики, OpenAI не будет предоставлять эти новые модели транскрипции бесплатно. Исторически они выпускали новые версии Whisper под лицензией MIT для коммерческого использования. Харрис отметил, что gpt-4o-transcribe и gpt-4o-mini-transcribe значительно крупнее, чем Whisper, что делает их неподходящими для открытого выпуска.

"Эти модели слишком велики, чтобы работать на обычном ноутбуке, как это мог делать Whisper," — добавил Харрис. "Когда мы открыто выпускаем модели, мы хотим делать это продуманно, обеспечивая их адаптацию под конкретные нужды. Мы рассматриваем устройства конечных пользователей как основную область для моделей с открытым исходным кодом."

Обновлено 20 марта 2025 года, 11:54 по тихоокеанскому времени, чтобы уточнить формулировку относительно уровня ошибок слов и обновить график результатов тестирования на более новую версию.

Связанная статья

Некоммерческая организация использует агентов искусственного интеллекта для повышения эффективности сбора средств на благотворительность

В то время как крупные технологические корпорации продвигают "агентов" искусственного интеллекта как средства повышения производительности бизнеса, одна некоммерческая организация демонстрирует их пот

Некоммерческая организация использует агентов искусственного интеллекта для повышения эффективности сбора средств на благотворительность

В то время как крупные технологические корпорации продвигают "агентов" искусственного интеллекта как средства повышения производительности бизнеса, одна некоммерческая организация демонстрирует их пот

Ведущие лаборатории искусственного интеллекта предупреждают, что человечество теряет понимание систем ИИ

В беспрецедентной демонстрации единства исследователи из OpenAI, Google DeepMind, Anthropic и Meta отложили в сторону конкурентные разногласия, чтобы выступить с коллективным предупреждением об ответс

Ведущие лаборатории искусственного интеллекта предупреждают, что человечество теряет понимание систем ИИ

В беспрецедентной демонстрации единства исследователи из OpenAI, Google DeepMind, Anthropic и Meta отложили в сторону конкурентные разногласия, чтобы выступить с коллективным предупреждением об ответс

ChatGPT добавляет интеграцию с Google Drive и Dropbox для доступа к файлам

ChatGPT повышает продуктивность благодаря новым корпоративным функциямКомпания OpenAI представила две новые мощные функции, превращающие ChatGPT в комплексный инструмент повышения производительности

Комментарии (32)

ChatGPT добавляет интеграцию с Google Drive и Dropbox для доступа к файлам

ChatGPT повышает продуктивность благодаря новым корпоративным функциямКомпания OpenAI представила две новые мощные функции, превращающие ChatGPT в комплексный инструмент повышения производительности

Комментарии (32)

![FrankMartínez]() FrankMartínez

FrankMartínez

19 августа 2025 г., 11:01:39 GMT+03:00

19 августа 2025 г., 11:01:39 GMT+03:00

The new OpenAI models sound like a game-changer for voice tech! Can't wait to see how devs use this to make apps talk smoother than ever. 😎

0

0

![BenHernández]() BenHernández

BenHernández

23 июля 2025 г., 11:50:48 GMT+03:00

23 июля 2025 г., 11:50:48 GMT+03:00

Wow, OpenAI's new transcription and voice models sound like a game-changer! I'm curious how these 'agentic' systems will stack up against real-world tasks. Could they finally nail natural-sounding convos? 🤔

0

0

![GeorgeTaylor]() GeorgeTaylor

GeorgeTaylor

20 апреля 2025 г., 22:57:07 GMT+03:00

20 апреля 2025 г., 22:57:07 GMT+03:00

Os novos modelos de transcrição e geração de voz da OpenAI são um divisor de águas! Estou usando no meu podcast e as melhorias são impressionantes. O único ponto negativo? São um pouco caros, mas se você puder pagar, vale cada centavo! 🎙️💸

0

0

![GregoryAllen]() GregoryAllen

GregoryAllen

17 апреля 2025 г., 7:50:37 GMT+03:00

17 апреля 2025 г., 7:50:37 GMT+03:00

OpenAI's new transcription and voice models are a game changer! I've been using them for my podcast and the improvements are night and day. The only downside? They're a bit pricey, but if you can swing it, they're worth every penny! 🎙️💸

0

0

![StevenAllen]() StevenAllen

StevenAllen

17 апреля 2025 г., 7:38:26 GMT+03:00

17 апреля 2025 г., 7:38:26 GMT+03:00

OpenAI의 새로운 음성 인식 및 음성 생성 모델은 정말 혁신적이에요! 제 팟캐스트에서 사용 중인데, 개선이 눈에 띄어요. 단점은 조금 비싸다는 건데, 감당할 수 있다면 그만한 가치가 있어요! 🎙️💸

0

0

![NicholasClark]() NicholasClark

NicholasClark

16 апреля 2025 г., 8:54:41 GMT+03:00

16 апреля 2025 г., 8:54:41 GMT+03:00

OpenAIの新しい音声認識と音声生成モデルは革命的です!ポッドキャストで使っていますが、改善が劇的です。唯一の欠点は少し高価なことですが、払えるならその価値は十分にあります!🎙️💸

0

0

OpenAI выпускает новые модели ИИ для транскрипции и генерации голоса через свой API, обещающие значительные улучшения по сравнению с предыдущими версиями. Эти обновления являются частью более широкой "агентной" концепции OpenAI, которая сосредоточена на создании автономных систем, способных выполнять задачи самостоятельно для пользователей. Хотя термин "агент" может быть предметом споров, руководитель отдела продуктов OpenAI Оливье Годеман рассматривает его как чат-бота, который может взаимодействовать с клиентами бизнеса.

"В ближайшие месяцы мы увидим появление все большего числа агентов," — поделился Годеман с TechCrunch во время брифинга. "Главная цель — помочь клиентам и разработчикам использовать агентов, которые будут полезны, доступны и точны."

Новейшая модель преобразования текста в речь от OpenAI, названная "gpt-4o-mini-tts," не только стремится создавать более реалистичную и нюансированную речь, но и является более адаптивной, чем ее предшественники. Разработчики теперь могут управлять моделью с помощью команд на естественном языке, таких как "говори как безумный ученый" или "используй спокойный голос, как у учителя медитации." Этот уровень контроля позволяет создавать более персонализированный голосовой опыт.

Вот пример голоса в стиле "true crime", с хрипотцой:

А вот пример женского "профессионального" голоса:

Джефф Харрис, член команды по продуктам OpenAI, подчеркнул в разговоре с TechCrunch, что цель — позволить разработчикам настраивать как голосовой "опыт", так и "контекст". "В разных сценариях вам не нужен монотонный голос," — пояснил Харрис. "Например, в ситуации поддержки клиентов, где голос должен звучать извиняющимся за ошибку, вы можете вложить эту эмоцию в голос. Мы твердо убеждены, что разработчики и пользователи хотят контролировать не только содержание, но и манеру речи."

Переходя к новым предложениям OpenAI по преобразованию речи в текст, модели "gpt-4o-transcribe" и "gpt-4o-mini-transcribe" призваны заменить устаревшую модель транскрипции Whisper. Обученные на разнообразном массиве высококачественных аудиоданных, они, как утверждается, лучше справляются с акцентированной и разнообразной речью, даже в шумных условиях. Кроме того, эти модели менее подвержены "галлюцинациям", проблеме, при которой Whisper иногда придумывал слова или целые отрывки, добавляя неточности, такие как расовые комментарии или вымышленные медицинские процедуры в транскрипты.

"Эти модели показывают значительное улучшение по сравнению с Whisper в этом отношении," — отметил Харрис. "Обеспечение точности модели крайне важно для надежного голосового опыта, и под точностью мы подразумеваем, что модели корректно улавливают произнесенные слова, не добавляя непроизнесенного содержания."

Однако производительность может варьироваться в зависимости от языка. Внутренние тесты OpenAI показывают, что gpt-4o-transcribe, более точная из двух моделей, имеет "уровень ошибок слов" около 30% для индийских и дравидийских языков, таких как тамильский, телугу, малаялам и каннада. Это означает, что примерно три из каждых десяти слов могут отличаться от человеческой транскрипции на этих языках.

В отличие от своей обычной практики, OpenAI не будет предоставлять эти новые модели транскрипции бесплатно. Исторически они выпускали новые версии Whisper под лицензией MIT для коммерческого использования. Харрис отметил, что gpt-4o-transcribe и gpt-4o-mini-transcribe значительно крупнее, чем Whisper, что делает их неподходящими для открытого выпуска.

"Эти модели слишком велики, чтобы работать на обычном ноутбуке, как это мог делать Whisper," — добавил Харрис. "Когда мы открыто выпускаем модели, мы хотим делать это продуманно, обеспечивая их адаптацию под конкретные нужды. Мы рассматриваем устройства конечных пользователей как основную область для моделей с открытым исходным кодом."

Обновлено 20 марта 2025 года, 11:54 по тихоокеанскому времени, чтобы уточнить формулировку относительно уровня ошибок слов и обновить график результатов тестирования на более новую версию.

Некоммерческая организация использует агентов искусственного интеллекта для повышения эффективности сбора средств на благотворительность

В то время как крупные технологические корпорации продвигают "агентов" искусственного интеллекта как средства повышения производительности бизнеса, одна некоммерческая организация демонстрирует их пот

Некоммерческая организация использует агентов искусственного интеллекта для повышения эффективности сбора средств на благотворительность

В то время как крупные технологические корпорации продвигают "агентов" искусственного интеллекта как средства повышения производительности бизнеса, одна некоммерческая организация демонстрирует их пот

Ведущие лаборатории искусственного интеллекта предупреждают, что человечество теряет понимание систем ИИ

В беспрецедентной демонстрации единства исследователи из OpenAI, Google DeepMind, Anthropic и Meta отложили в сторону конкурентные разногласия, чтобы выступить с коллективным предупреждением об ответс

Ведущие лаборатории искусственного интеллекта предупреждают, что человечество теряет понимание систем ИИ

В беспрецедентной демонстрации единства исследователи из OpenAI, Google DeepMind, Anthropic и Meta отложили в сторону конкурентные разногласия, чтобы выступить с коллективным предупреждением об ответс

ChatGPT добавляет интеграцию с Google Drive и Dropbox для доступа к файлам

ChatGPT повышает продуктивность благодаря новым корпоративным функциямКомпания OpenAI представила две новые мощные функции, превращающие ChatGPT в комплексный инструмент повышения производительности

ChatGPT добавляет интеграцию с Google Drive и Dropbox для доступа к файлам

ChatGPT повышает продуктивность благодаря новым корпоративным функциямКомпания OpenAI представила две новые мощные функции, превращающие ChatGPT в комплексный инструмент повышения производительности

19 августа 2025 г., 11:01:39 GMT+03:00

19 августа 2025 г., 11:01:39 GMT+03:00

The new OpenAI models sound like a game-changer for voice tech! Can't wait to see how devs use this to make apps talk smoother than ever. 😎

0

0

23 июля 2025 г., 11:50:48 GMT+03:00

23 июля 2025 г., 11:50:48 GMT+03:00

Wow, OpenAI's new transcription and voice models sound like a game-changer! I'm curious how these 'agentic' systems will stack up against real-world tasks. Could they finally nail natural-sounding convos? 🤔

0

0

20 апреля 2025 г., 22:57:07 GMT+03:00

20 апреля 2025 г., 22:57:07 GMT+03:00

Os novos modelos de transcrição e geração de voz da OpenAI são um divisor de águas! Estou usando no meu podcast e as melhorias são impressionantes. O único ponto negativo? São um pouco caros, mas se você puder pagar, vale cada centavo! 🎙️💸

0

0

17 апреля 2025 г., 7:50:37 GMT+03:00

17 апреля 2025 г., 7:50:37 GMT+03:00

OpenAI's new transcription and voice models are a game changer! I've been using them for my podcast and the improvements are night and day. The only downside? They're a bit pricey, but if you can swing it, they're worth every penny! 🎙️💸

0

0

17 апреля 2025 г., 7:38:26 GMT+03:00

17 апреля 2025 г., 7:38:26 GMT+03:00

OpenAI의 새로운 음성 인식 및 음성 생성 모델은 정말 혁신적이에요! 제 팟캐스트에서 사용 중인데, 개선이 눈에 띄어요. 단점은 조금 비싸다는 건데, 감당할 수 있다면 그만한 가치가 있어요! 🎙️💸

0

0

16 апреля 2025 г., 8:54:41 GMT+03:00

16 апреля 2025 г., 8:54:41 GMT+03:00

OpenAIの新しい音声認識と音声生成モデルは革命的です!ポッドキャストで使っていますが、改善が劇的です。唯一の欠点は少し高価なことですが、払えるならその価値は十分にあります!🎙️💸

0

0