Meta AI konkurriert nicht mit Lama, Gemini und Chatgpt im Codierungstest

Wie gut schreiben KI-Tools Code?

In den letzten etwa einem Jahr habe ich mehrere große Sprachmodelle getestet, um zu sehen, wie effektiv sie grundlegende Programmieraufgaben bewältigen. Die Idee hinter diesen Tests ist einfach: Wenn sie die Grundlagen nicht meistern, werden sie bei komplexeren Aufgaben kaum hilfreich sein. Aber wenn sie bei diesen grundlegenden Herausforderungen gut abschneiden, könnten sie wertvolle Verbündete für Entwickler werden, die Zeit sparen wollen.

Um eine Basislinie zu etablieren, habe ich vier verschiedene Tests verwendet. Diese reichen von einfachen Programmieraufgaben bis hin zu Debugging-Übungen, die tieferes Verständnis von Frameworks wie WordPress erfordern. Lassen Sie uns in jeden Test eintauchen und vergleichen, wie das neue KI-Tool von Meta im Vergleich zu anderen abschneidet.

Test 1: Erstellen eines WordPress-Plugins

Das Erstellen eines WordPress-Plugins erfordert Webentwicklung mit PHP innerhalb des WordPress-Ökosystems. Es erfordert auch etwas UI-Design. Wenn ein KI-Chatbot dies schafft, könnte er ein nützlicher Assistent für Webentwickler sein.

Ergebnisse:

- Meta AI: Angemessene Benutzeroberfläche, aber fehlerhafte Funktionalität.

- Meta Code Llama: Komplettes Versagen.

- Google Gemini Advanced: Gute Benutzeroberfläche, fehlerhafte Funktionalität.

- ChatGPT: Saubere Benutzeroberfläche und funktionale Ausgabe.

Hier ist ein visueller Vergleich:

(Hinweis: Ersetzen Sie "/path-to-image/" durch den tatsächlichen Pfad zur Bilddatei.)

(Hinweis: Ersetzen Sie "/path-to-image/" durch den tatsächlichen Pfad zur Bilddatei.)

ChatGPT lieferte eine sauberere Benutzeroberfläche und platzierte den „Randomize“-Button logischer. Beim Ausführen des Plugins stürzte Meta AI jedoch ab und zeigte den gefürchteten „White Screen of Death“.

Test 2: Umschreiben einer String-Funktion

Dieser Test bewertet die Fähigkeit einer KI, Utility-Funktionen zu verbessern. Erfolg hier deutet auf potenzielle Unterstützung für Entwickler hin, während Misserfolg Verbesserungsbedarf anzeigt.

Ergebnisse:

- Meta AI: Gescheitert aufgrund falscher Wertkorrekturen, schlechter Handhabung von Zahlen mit mehreren Dezimalstellen und Formatierungsproblemen.

- Meta Code Llama: Erfolgreich.

- Google Gemini Advanced: Gescheitert.

- ChatGPT: Erfolgreich.

Während Meta AI bei dieser scheinbar einfachen Aufgabe stolperte, glänzte Meta Code Llama und zeigte seine Fähigkeiten. ChatGPT schnitt ebenfalls bewundernswert ab.

Test 3: Finden eines lästigen Fehlers

Hier geht es nicht um das Schreiben von Code, sondern um die Diagnose von Problemen. Erfolg erfordert tiefes Wissen über WordPress-APIs und die Interaktionen zwischen verschiedenen Teilen des Codes.

Ergebnisse:

- Meta AI: Mit Bravour bestanden, erkannte das Problem und schlug eine effizienzsteigernde Anpassung vor.

- Meta Code Llama: Gescheitert.

- Google Gemini Advanced: Gescheitert.

- ChatGPT: Bestanden.

Überraschenderweise glänzte Meta AI hier trotz früherer Schwierigkeiten und zeigte ihr Potenzial, aber auch Inkonsistenzen in ihren Antworten.

Test 4: Schreiben eines Skripts

Dieser Test bewertet das Wissen über spezialisierte Tools wie Keyboard Maestro und AppleScript. Beide sind relativ nischig, repräsentieren aber ein breiteres Spektrum an Programmierfähigkeiten.

Ergebnisse:

- Meta AI: Konnte keine Daten von Keyboard Maestro abrufen.

- Meta Code Llama: Dasselbe Versagen.

- Google Gemini Advanced: Erfolgreich.

- ChatGPT: Erfolgreich.

Gemini und ChatGPT zeigten Kompetenz mit diesen Tools, während die Angebote von Meta hinterherhinkten.

Gesamtergebnisse

Modell Erfolgsquote Meta AI 1/4 Meta Code Llama 1/4 Google Gemini 1/4 ChatGPT 4/4

Basierend auf meiner sechsmonatigen Erfahrung mit ChatGPT für Programmierprojekte bin ich weiterhin von seiner Zuverlässigkeit überzeugt. Andere Modelle können seine Konsistenz und Effektivität noch nicht erreichen. Während Meta AI Momente der Brillanz zeigte, lässt ihre Gesamtleistung viel zu wünschen übrig.

Haben Sie mit diesen Tools experimentiert? Teilen Sie Ihre Gedanken in den Kommentaren unten!

Verwandter Artikel

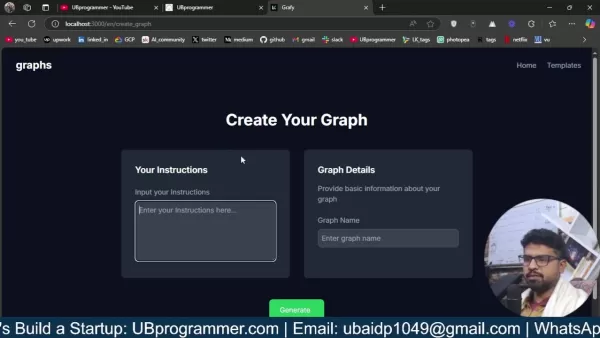

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

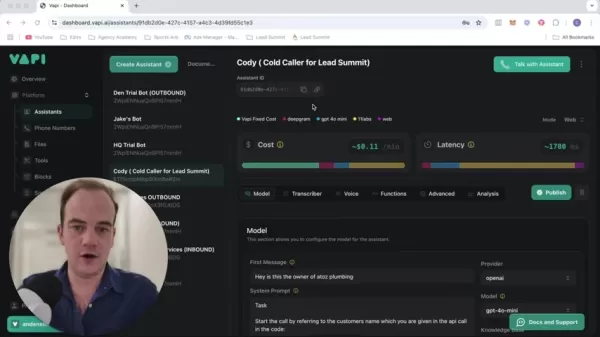

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Kommentare (5)

0/200

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Kommentare (5)

0/200

![BillyWilson]() BillyWilson

BillyWilson

30. September 2025 10:30:37 MESZ

30. September 2025 10:30:37 MESZ

Meta AI 코딩 테스트 결과는 참 실망스럽네요 😅 다른 경쟁사들보다 확실히 뒤처지는 모습인데... 그래도 아직 초기 단계니까 차차 나아지지 않을까요? 물론 빠르게 따라잡아야 하지만 말이죠!

0

0

![ChristopherTaylor]() ChristopherTaylor

ChristopherTaylor

12. August 2025 17:00:59 MESZ

12. August 2025 17:00:59 MESZ

¡Qué decepción con Meta AI! No me esperaba que fallara tan estrepitosamente en las pruebas de programación. Si no puede con lo básico, ¿cómo va a competir con los grandes como Gemini o ChatGPT? 🤔

0

0

![PaulHarris]() PaulHarris

PaulHarris

1. August 2025 15:47:34 MESZ

1. August 2025 15:47:34 MESZ

Meta AI's coding skills are lagging behind? Ouch, that’s a rough one! 😅 Llama and Gemini are eating its lunch. Maybe it’s time for Meta to rethink their AI game plan.

0

0

![MarkGonzalez]() MarkGonzalez

MarkGonzalez

28. Juli 2025 03:20:02 MESZ

28. Juli 2025 03:20:02 MESZ

Meta AI's coding skills seem underwhelming compared to Llama and others. 😕 I was hoping for a stronger contender in the AI coding space, but it looks like they’ve got some catching up to do. Anyone else tried using it for coding yet?

0

0

![TerryRoberts]() TerryRoberts

TerryRoberts

22. Juli 2025 03:25:03 MESZ

22. Juli 2025 03:25:03 MESZ

This article's take on Meta AI flopping in coding tests is wild! 😅 I mean, with all the hype around AI, you'd think they'd at least nail the basics. Makes me wonder if we're overhyping these models or if Meta's just lagging behind. Anyone else skeptical about AI coding tools now?

0

0

Wie gut schreiben KI-Tools Code?

In den letzten etwa einem Jahr habe ich mehrere große Sprachmodelle getestet, um zu sehen, wie effektiv sie grundlegende Programmieraufgaben bewältigen. Die Idee hinter diesen Tests ist einfach: Wenn sie die Grundlagen nicht meistern, werden sie bei komplexeren Aufgaben kaum hilfreich sein. Aber wenn sie bei diesen grundlegenden Herausforderungen gut abschneiden, könnten sie wertvolle Verbündete für Entwickler werden, die Zeit sparen wollen.

Um eine Basislinie zu etablieren, habe ich vier verschiedene Tests verwendet. Diese reichen von einfachen Programmieraufgaben bis hin zu Debugging-Übungen, die tieferes Verständnis von Frameworks wie WordPress erfordern. Lassen Sie uns in jeden Test eintauchen und vergleichen, wie das neue KI-Tool von Meta im Vergleich zu anderen abschneidet.

Test 1: Erstellen eines WordPress-Plugins

Das Erstellen eines WordPress-Plugins erfordert Webentwicklung mit PHP innerhalb des WordPress-Ökosystems. Es erfordert auch etwas UI-Design. Wenn ein KI-Chatbot dies schafft, könnte er ein nützlicher Assistent für Webentwickler sein.

Ergebnisse:

- Meta AI: Angemessene Benutzeroberfläche, aber fehlerhafte Funktionalität.

- Meta Code Llama: Komplettes Versagen.

- Google Gemini Advanced: Gute Benutzeroberfläche, fehlerhafte Funktionalität.

- ChatGPT: Saubere Benutzeroberfläche und funktionale Ausgabe.

Hier ist ein visueller Vergleich:

(Hinweis: Ersetzen Sie "/path-to-image/" durch den tatsächlichen Pfad zur Bilddatei.)

(Hinweis: Ersetzen Sie "/path-to-image/" durch den tatsächlichen Pfad zur Bilddatei.)

ChatGPT lieferte eine sauberere Benutzeroberfläche und platzierte den „Randomize“-Button logischer. Beim Ausführen des Plugins stürzte Meta AI jedoch ab und zeigte den gefürchteten „White Screen of Death“.

Test 2: Umschreiben einer String-Funktion

Dieser Test bewertet die Fähigkeit einer KI, Utility-Funktionen zu verbessern. Erfolg hier deutet auf potenzielle Unterstützung für Entwickler hin, während Misserfolg Verbesserungsbedarf anzeigt.

Ergebnisse:

- Meta AI: Gescheitert aufgrund falscher Wertkorrekturen, schlechter Handhabung von Zahlen mit mehreren Dezimalstellen und Formatierungsproblemen.

- Meta Code Llama: Erfolgreich.

- Google Gemini Advanced: Gescheitert.

- ChatGPT: Erfolgreich.

Während Meta AI bei dieser scheinbar einfachen Aufgabe stolperte, glänzte Meta Code Llama und zeigte seine Fähigkeiten. ChatGPT schnitt ebenfalls bewundernswert ab.

Test 3: Finden eines lästigen Fehlers

Hier geht es nicht um das Schreiben von Code, sondern um die Diagnose von Problemen. Erfolg erfordert tiefes Wissen über WordPress-APIs und die Interaktionen zwischen verschiedenen Teilen des Codes.

Ergebnisse:

- Meta AI: Mit Bravour bestanden, erkannte das Problem und schlug eine effizienzsteigernde Anpassung vor.

- Meta Code Llama: Gescheitert.

- Google Gemini Advanced: Gescheitert.

- ChatGPT: Bestanden.

Überraschenderweise glänzte Meta AI hier trotz früherer Schwierigkeiten und zeigte ihr Potenzial, aber auch Inkonsistenzen in ihren Antworten.

Test 4: Schreiben eines Skripts

Dieser Test bewertet das Wissen über spezialisierte Tools wie Keyboard Maestro und AppleScript. Beide sind relativ nischig, repräsentieren aber ein breiteres Spektrum an Programmierfähigkeiten.

Ergebnisse:

- Meta AI: Konnte keine Daten von Keyboard Maestro abrufen.

- Meta Code Llama: Dasselbe Versagen.

- Google Gemini Advanced: Erfolgreich.

- ChatGPT: Erfolgreich.

Gemini und ChatGPT zeigten Kompetenz mit diesen Tools, während die Angebote von Meta hinterherhinkten.

Gesamtergebnisse

| Modell | Erfolgsquote |

|---|---|

| Meta AI | 1/4 |

| Meta Code Llama | 1/4 |

| Google Gemini | 1/4 |

| ChatGPT | 4/4 |

Basierend auf meiner sechsmonatigen Erfahrung mit ChatGPT für Programmierprojekte bin ich weiterhin von seiner Zuverlässigkeit überzeugt. Andere Modelle können seine Konsistenz und Effektivität noch nicht erreichen. Während Meta AI Momente der Brillanz zeigte, lässt ihre Gesamtleistung viel zu wünschen übrig.

Haben Sie mit diesen Tools experimentiert? Teilen Sie Ihre Gedanken in den Kommentaren unten!

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

30. September 2025 10:30:37 MESZ

30. September 2025 10:30:37 MESZ

Meta AI 코딩 테스트 결과는 참 실망스럽네요 😅 다른 경쟁사들보다 확실히 뒤처지는 모습인데... 그래도 아직 초기 단계니까 차차 나아지지 않을까요? 물론 빠르게 따라잡아야 하지만 말이죠!

0

0

12. August 2025 17:00:59 MESZ

12. August 2025 17:00:59 MESZ

¡Qué decepción con Meta AI! No me esperaba que fallara tan estrepitosamente en las pruebas de programación. Si no puede con lo básico, ¿cómo va a competir con los grandes como Gemini o ChatGPT? 🤔

0

0

1. August 2025 15:47:34 MESZ

1. August 2025 15:47:34 MESZ

Meta AI's coding skills are lagging behind? Ouch, that’s a rough one! 😅 Llama and Gemini are eating its lunch. Maybe it’s time for Meta to rethink their AI game plan.

0

0

28. Juli 2025 03:20:02 MESZ

28. Juli 2025 03:20:02 MESZ

Meta AI's coding skills seem underwhelming compared to Llama and others. 😕 I was hoping for a stronger contender in the AI coding space, but it looks like they’ve got some catching up to do. Anyone else tried using it for coding yet?

0

0

22. Juli 2025 03:25:03 MESZ

22. Juli 2025 03:25:03 MESZ

This article's take on Meta AI flopping in coding tests is wild! 😅 I mean, with all the hype around AI, you'd think they'd at least nail the basics. Makes me wonder if we're overhyping these models or if Meta's just lagging behind. Anyone else skeptical about AI coding tools now?

0

0