Fortschritt von KI-Modellen zur Schlussfolgerung könnte bis 2026 stagnieren, legt Epoch AI-Studie nahe

Eine Studie von Epoch AI, einem gemeinnützigen Forschungsinstitut für KI, deutet darauf hin, dass der KI-Sektor bald vor Herausforderungen stehen könnte, um signifikante Leistungsverbesserungen bei KI-Modellen zur Schlussfolgerung zu erzielen. Der Bericht prognostiziert, dass die Fortschritte bei diesen Modellen im nächsten Jahr nachlassen könnten.

Fortgeschrittene Modelle zur Schlussfolgerung, wie OpenAI’s o3, haben kürzlich bemerkenswerte Verbesserungen in KI-Benchmarks erzielt, insbesondere bei Mathematik- und Programmieraufgaben. Diese Modelle nutzen erhöhte Rechenleistung, um die Leistung zu steigern, was jedoch oft längere Verarbeitungszeiten im Vergleich zu traditionellen Modellen zur Folge hat.

Modelle zur Schlussfolgerung werden zunächst durch das Training eines Standardmodells mit riesigen Datensätzen erstellt, gefolgt von verstärkendem Lernen, das dem Modell Rückmeldungen gibt, um seine Problemlösungsfähigkeiten zu verfeinern.

Laut Epoch haben führende KI-Labore wie OpenAI bisher nicht intensiv Rechenressourcen für die Phase des verstärkenden Lernens bei der Entwicklung von Modellen zur Schlussfolgerung genutzt.

Dieser Trend ändert sich. OpenAI gab bekannt, dass etwa zehnmal mehr Rechenleistung für das Training von o3 im Vergleich zu seinem Vorgänger, o1, verwendet wurde, wobei Epoch suggeriert, dass der Großteil davon für verstärkendes Lernen aufgewendet wurde. Der OpenAI-Forscher Dan Roberts deutete kürzlich an, dass das Unternehmen plant, verstärkendes Lernen weiter zu priorisieren und möglicherweise noch mehr Rechenressourcen als für das anfängliche Modelltraining einzusetzen.

Epoch weist jedoch darauf hin, dass es eine Grenze gibt, wie viel Rechenleistung für verstärkendes Lernen eingesetzt werden kann.

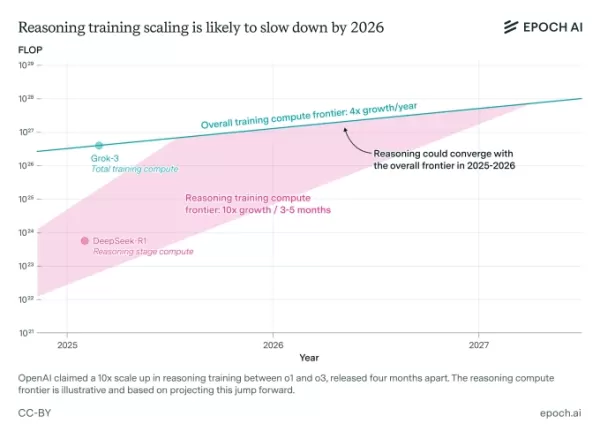

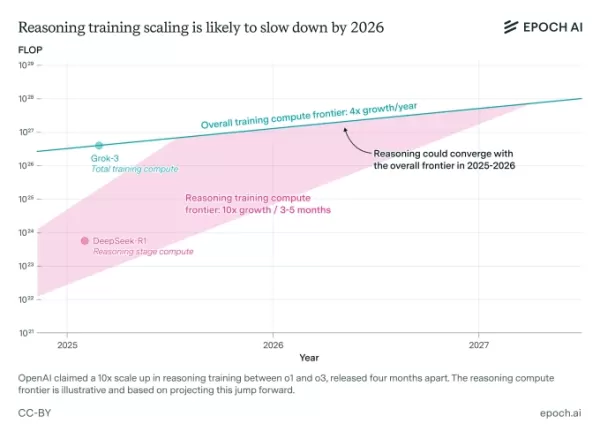

Eine Studie von Epoch AI legt nahe, dass die Skalierung des Trainings für Modelle zur Schlussfolgerung bald an Grenzen stoßen könnte. Bildnachweis: Epoch AI Josh You, Analyst bei Epoch und Autor der Studie, bemerkt, dass die Leistungsgewinne durch das Training standardmäßiger KI-Modelle derzeit jährlich vervierfachen, während die Gewinne durch verstärkendes Lernen alle drei bis fünf Monate verzehnfachen. Er prognostiziert, dass der Fortschritt bei Modellen zur Schlussfolgerung bis 2026 wahrscheinlich mit den allgemeinen KI-Fortschritten übereinstimmen wird.

Präsentation bei TechCrunch Sessions: AI

Sichern Sie sich Ihren Platz bei TC Sessions: AI, um Ihre Innovationen über 1.200 Entscheidungsträgern zu präsentieren, ohne Ihr Budget zu sprengen. Verfügbar bis 9. Mai oder solange Plätze verfügbar sind.

Präsentation bei TechCrunch Sessions: AI

Sichern Sie sich Ihren Platz bei TC Sessions: AI, um Ihre Innovationen über 1.200 Entscheidungsträgern zu präsentieren, ohne Ihr Budget zu sprengen. Verfügbar bis 9. Mai oder solange Plätze verfügbar sind.

Berkeley, CA | 5. Juni JETZT BUCHENDie Studie von Epoch stützt sich auf bestimmte Annahmen und bezieht öffentliche Aussagen von Führungskräften der KI-Branche ein. Sie hebt auch hervor, dass die Skalierung von Modellen zur Schlussfolgerung über rechentechnische Grenzen hinaus auf Hindernisse stoßen könnte, wie hohe Forschungskosten.

„Laufende Forschungskosten könnten die Skalierbarkeit von Modellen zur Schlussfolgerung einschränken“, erklärt You. „Da schnelle rechentechnische Skalierung ein Schlüsselfaktor für ihren Fortschritt ist, verdient dies besondere Aufmerksamkeit.“

Jegliche Anzeichen dafür, dass Modelle zur Schlussfolgerung bald an eine Leistungsgrenze stoßen könnten, könnten in der KI-Branche Besorgnis erregen, die stark in ihre Entwicklung investiert hat. Forschungsergebnisse deuten bereits darauf hin, dass diese Modelle trotz ihrer hohen Betriebskosten erhebliche Mängel aufweisen, einschließlich einer höheren Neigung, im Vergleich zu einigen traditionellen Modellen ungenaue Ergebnisse zu liefern.

Verwandter Artikel

Renommierter KI -Experte enthüllt ein kontroverses Startup

Hin und wieder kommt ein Startup aus dem Silicon Valley mit einem Leitbild ein, das so ausgefallen ist, dass es schwer zu sagen ist, ob es echt ist oder sich nur über die Branche lustig macht. Geben Sie Mechanize ein, ein neues Unternehmen unter der Leitung des renommierten KI -Forschers Tamay Beiroglu, das nach ihr die Debatte über X ausgelöst hat

Renommierter KI -Experte enthüllt ein kontroverses Startup

Hin und wieder kommt ein Startup aus dem Silicon Valley mit einem Leitbild ein, das so ausgefallen ist, dass es schwer zu sagen ist, ob es echt ist oder sich nur über die Branche lustig macht. Geben Sie Mechanize ein, ein neues Unternehmen unter der Leitung des renommierten KI -Forschers Tamay Beiroglu, das nach ihr die Debatte über X ausgelöst hat

Der Energieverbrauch von Chatgpt ist niedriger als erwartet

Chatgpt, der Chatbot von Openai, ist vielleicht nicht der Energie -Guzzler, von dem wir dachten, er sei es. Sein Energieverbrauch kann jedoch je nach der Verwendung und welchen KI -Modellen laut einer neuen Studie die Fragen beantworten.

Der Energieverbrauch von Chatgpt ist niedriger als erwartet

Chatgpt, der Chatbot von Openai, ist vielleicht nicht der Energie -Guzzler, von dem wir dachten, er sei es. Sein Energieverbrauch kann jedoch je nach der Verwendung und welchen KI -Modellen laut einer neuen Studie die Fragen beantworten.

Stärke durch Glaube finden: Seine friedliche Kraft erforschen

Inmitten des Chaos und des Drucks des modernen Lebens ist es wichtig, innere Ruhe und dauerhafte Widerstandsfähigkeit zu finden. Der Glaube ist für zahllose Menschen eine feste Säule - er bietet Orien

Kommentare (5)

0/200

Stärke durch Glaube finden: Seine friedliche Kraft erforschen

Inmitten des Chaos und des Drucks des modernen Lebens ist es wichtig, innere Ruhe und dauerhafte Widerstandsfähigkeit zu finden. Der Glaube ist für zahllose Menschen eine feste Säule - er bietet Orien

Kommentare (5)

0/200

![PeterPerez]() PeterPerez

PeterPerez

26. August 2025 07:25:25 MESZ

26. August 2025 07:25:25 MESZ

Mind-blowing study! If AI reasoning hits a wall by 2026, what’s next? Kinda scary to think we might be maxing out so soon. 😬

0

0

![RyanGonzalez]() RyanGonzalez

RyanGonzalez

23. August 2025 19:01:22 MESZ

23. August 2025 19:01:22 MESZ

This AI plateau talk is wild! If reasoning models hit a wall by 2026, what’s next? Kinda feels like we’re racing to the moon but might run out of fuel. 😅 Curious if this’ll push devs to get creative or just lean harder on hardware.

0

0

![AvaPhillips]() AvaPhillips

AvaPhillips

20. August 2025 11:01:15 MESZ

20. August 2025 11:01:15 MESZ

This AI plateau talk is wild! 🤯 Feels like we’re hitting a tech ceiling already. Wonder if it’s a real limit or just a pause before the next big leap?

0

0

![EricMiller]() EricMiller

EricMiller

20. August 2025 09:01:19 MESZ

20. August 2025 09:01:19 MESZ

Wow, AI progress hitting a plateau by 2026? That’s wild! I thought we’d keep zooming toward super-smart machines, but maybe it’s time for a new breakthrough to shake things up. 🧠

0

0

![BenGarcía]() BenGarcía

BenGarcía

5. August 2025 11:00:59 MESZ

5. August 2025 11:00:59 MESZ

This article's got me thinking—AI progress might hit a wall by 2026? That's wild! I wonder if companies will pivot to new tech or just keep pushing the same models. 🤔

0

0

Eine Studie von Epoch AI, einem gemeinnützigen Forschungsinstitut für KI, deutet darauf hin, dass der KI-Sektor bald vor Herausforderungen stehen könnte, um signifikante Leistungsverbesserungen bei KI-Modellen zur Schlussfolgerung zu erzielen. Der Bericht prognostiziert, dass die Fortschritte bei diesen Modellen im nächsten Jahr nachlassen könnten.

Fortgeschrittene Modelle zur Schlussfolgerung, wie OpenAI’s o3, haben kürzlich bemerkenswerte Verbesserungen in KI-Benchmarks erzielt, insbesondere bei Mathematik- und Programmieraufgaben. Diese Modelle nutzen erhöhte Rechenleistung, um die Leistung zu steigern, was jedoch oft längere Verarbeitungszeiten im Vergleich zu traditionellen Modellen zur Folge hat.

Modelle zur Schlussfolgerung werden zunächst durch das Training eines Standardmodells mit riesigen Datensätzen erstellt, gefolgt von verstärkendem Lernen, das dem Modell Rückmeldungen gibt, um seine Problemlösungsfähigkeiten zu verfeinern.

Laut Epoch haben führende KI-Labore wie OpenAI bisher nicht intensiv Rechenressourcen für die Phase des verstärkenden Lernens bei der Entwicklung von Modellen zur Schlussfolgerung genutzt.

Dieser Trend ändert sich. OpenAI gab bekannt, dass etwa zehnmal mehr Rechenleistung für das Training von o3 im Vergleich zu seinem Vorgänger, o1, verwendet wurde, wobei Epoch suggeriert, dass der Großteil davon für verstärkendes Lernen aufgewendet wurde. Der OpenAI-Forscher Dan Roberts deutete kürzlich an, dass das Unternehmen plant, verstärkendes Lernen weiter zu priorisieren und möglicherweise noch mehr Rechenressourcen als für das anfängliche Modelltraining einzusetzen.

Epoch weist jedoch darauf hin, dass es eine Grenze gibt, wie viel Rechenleistung für verstärkendes Lernen eingesetzt werden kann.

Josh You, Analyst bei Epoch und Autor der Studie, bemerkt, dass die Leistungsgewinne durch das Training standardmäßiger KI-Modelle derzeit jährlich vervierfachen, während die Gewinne durch verstärkendes Lernen alle drei bis fünf Monate verzehnfachen. Er prognostiziert, dass der Fortschritt bei Modellen zur Schlussfolgerung bis 2026 wahrscheinlich mit den allgemeinen KI-Fortschritten übereinstimmen wird.

Präsentation bei TechCrunch Sessions: AI

Sichern Sie sich Ihren Platz bei TC Sessions: AI, um Ihre Innovationen über 1.200 Entscheidungsträgern zu präsentieren, ohne Ihr Budget zu sprengen. Verfügbar bis 9. Mai oder solange Plätze verfügbar sind.

Präsentation bei TechCrunch Sessions: AI

Sichern Sie sich Ihren Platz bei TC Sessions: AI, um Ihre Innovationen über 1.200 Entscheidungsträgern zu präsentieren, ohne Ihr Budget zu sprengen. Verfügbar bis 9. Mai oder solange Plätze verfügbar sind.

Berkeley, CA | 5. Juni JETZT BUCHENDie Studie von Epoch stützt sich auf bestimmte Annahmen und bezieht öffentliche Aussagen von Führungskräften der KI-Branche ein. Sie hebt auch hervor, dass die Skalierung von Modellen zur Schlussfolgerung über rechentechnische Grenzen hinaus auf Hindernisse stoßen könnte, wie hohe Forschungskosten.

„Laufende Forschungskosten könnten die Skalierbarkeit von Modellen zur Schlussfolgerung einschränken“, erklärt You. „Da schnelle rechentechnische Skalierung ein Schlüsselfaktor für ihren Fortschritt ist, verdient dies besondere Aufmerksamkeit.“

Jegliche Anzeichen dafür, dass Modelle zur Schlussfolgerung bald an eine Leistungsgrenze stoßen könnten, könnten in der KI-Branche Besorgnis erregen, die stark in ihre Entwicklung investiert hat. Forschungsergebnisse deuten bereits darauf hin, dass diese Modelle trotz ihrer hohen Betriebskosten erhebliche Mängel aufweisen, einschließlich einer höheren Neigung, im Vergleich zu einigen traditionellen Modellen ungenaue Ergebnisse zu liefern.

Renommierter KI -Experte enthüllt ein kontroverses Startup

Hin und wieder kommt ein Startup aus dem Silicon Valley mit einem Leitbild ein, das so ausgefallen ist, dass es schwer zu sagen ist, ob es echt ist oder sich nur über die Branche lustig macht. Geben Sie Mechanize ein, ein neues Unternehmen unter der Leitung des renommierten KI -Forschers Tamay Beiroglu, das nach ihr die Debatte über X ausgelöst hat

Renommierter KI -Experte enthüllt ein kontroverses Startup

Hin und wieder kommt ein Startup aus dem Silicon Valley mit einem Leitbild ein, das so ausgefallen ist, dass es schwer zu sagen ist, ob es echt ist oder sich nur über die Branche lustig macht. Geben Sie Mechanize ein, ein neues Unternehmen unter der Leitung des renommierten KI -Forschers Tamay Beiroglu, das nach ihr die Debatte über X ausgelöst hat

Der Energieverbrauch von Chatgpt ist niedriger als erwartet

Chatgpt, der Chatbot von Openai, ist vielleicht nicht der Energie -Guzzler, von dem wir dachten, er sei es. Sein Energieverbrauch kann jedoch je nach der Verwendung und welchen KI -Modellen laut einer neuen Studie die Fragen beantworten.

Der Energieverbrauch von Chatgpt ist niedriger als erwartet

Chatgpt, der Chatbot von Openai, ist vielleicht nicht der Energie -Guzzler, von dem wir dachten, er sei es. Sein Energieverbrauch kann jedoch je nach der Verwendung und welchen KI -Modellen laut einer neuen Studie die Fragen beantworten.

Stärke durch Glaube finden: Seine friedliche Kraft erforschen

Inmitten des Chaos und des Drucks des modernen Lebens ist es wichtig, innere Ruhe und dauerhafte Widerstandsfähigkeit zu finden. Der Glaube ist für zahllose Menschen eine feste Säule - er bietet Orien

Stärke durch Glaube finden: Seine friedliche Kraft erforschen

Inmitten des Chaos und des Drucks des modernen Lebens ist es wichtig, innere Ruhe und dauerhafte Widerstandsfähigkeit zu finden. Der Glaube ist für zahllose Menschen eine feste Säule - er bietet Orien

26. August 2025 07:25:25 MESZ

26. August 2025 07:25:25 MESZ

Mind-blowing study! If AI reasoning hits a wall by 2026, what’s next? Kinda scary to think we might be maxing out so soon. 😬

0

0

23. August 2025 19:01:22 MESZ

23. August 2025 19:01:22 MESZ

This AI plateau talk is wild! If reasoning models hit a wall by 2026, what’s next? Kinda feels like we’re racing to the moon but might run out of fuel. 😅 Curious if this’ll push devs to get creative or just lean harder on hardware.

0

0

20. August 2025 11:01:15 MESZ

20. August 2025 11:01:15 MESZ

This AI plateau talk is wild! 🤯 Feels like we’re hitting a tech ceiling already. Wonder if it’s a real limit or just a pause before the next big leap?

0

0

20. August 2025 09:01:19 MESZ

20. August 2025 09:01:19 MESZ

Wow, AI progress hitting a plateau by 2026? That’s wild! I thought we’d keep zooming toward super-smart machines, but maybe it’s time for a new breakthrough to shake things up. 🧠

0

0

5. August 2025 11:00:59 MESZ

5. August 2025 11:00:59 MESZ

This article's got me thinking—AI progress might hit a wall by 2026? That's wild! I wonder if companies will pivot to new tech or just keep pushing the same models. 🤔

0

0