Progrès des modèles de raisonnement en IA pourrait stagner d'ici 2026, selon une étude d'Epoch AI

Une étude d'Epoch AI, un institut de recherche sur l'IA à but non lucratif, indique que le secteur de l'IA pourrait bientôt rencontrer des défis pour obtenir des améliorations significatives des performances des modèles de raisonnement en IA. Le rapport prévoit que les avancées de ces modèles pourraient ralentir au cours de l'année prochaine.

Les modèles de raisonnement avancés, tels que l'o3 d'OpenAI, ont récemment entraîné des améliorations notables dans les benchmarks d'IA, en particulier dans les tâches de mathématiques et de codage. Ces modèles exploitent une puissance de calcul accrue pour améliorer leurs performances, bien que cela entraîne souvent des temps de traitement plus longs par rapport aux modèles traditionnels.

Les modèles de raisonnement sont créés en entraînant d'abord un modèle standard sur de vastes ensembles de données, suivi d'un apprentissage par renforcement, qui fournit au modèle des retours pour affiner ses capacités de résolution de problèmes.

Selon Epoch, les principaux laboratoires d'IA comme OpenAI n'ont pas encore utilisé massivement les ressources de calcul pour la phase d'apprentissage par renforcement du développement des modèles de raisonnement.

Cette tendance évolue. OpenAI a révélé qu'il a utilisé environ dix fois plus de puissance de calcul pour entraîner l'o3 par rapport à son prédécesseur, l'o1, Epoch suggérant que la majeure partie de celle-ci a été allouée à l'apprentissage par renforcement. Le chercheur d'OpenAI, Dan Roberts, a récemment indiqué que l'entreprise prévoit de prioriser davantage l'apprentissage par renforcement, en utilisant potentiellement encore plus de ressources de calcul que pour l'entraînement initial du modèle.

Cependant, Epoch note qu'il existe une limite à la quantité de puissance de calcul qui peut être appliquée à l'apprentissage par renforcement.

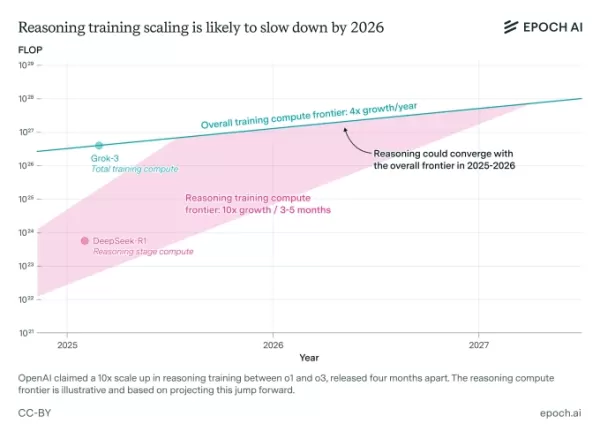

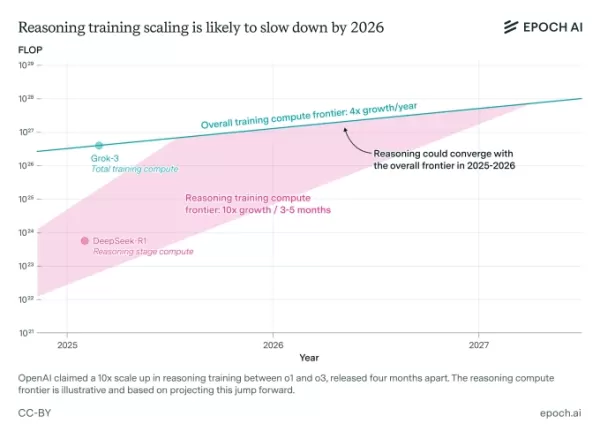

Une étude d'Epoch AI suggère que la mise à l'échelle de l'entraînement pour les modèles de raisonnement pourrait bientôt rencontrer des limitations. Crédits image : Epoch AI Josh You, analyste chez Epoch et auteur de l'étude, note que les gains de performance des entraînements de modèles d'IA standards quadruplent actuellement chaque année, tandis que les gains de l'apprentissage par renforcement augmentent de dix fois tous les trois à cinq mois. Il prévoit que les progrès des modèles de raisonnement s'aligneront probablement sur les avancées globales de l'IA d'ici 2026.

Présentation à TechCrunch Sessions : AI

Réservez votre place à TC Sessions : AI pour présenter vos innovations à plus de 1 200 décideurs sans vous ruiner. Disponible jusqu'au 9 mai ou jusqu'à épuisement des places.

Présentation à TechCrunch Sessions : AI

Réservez votre place à TC Sessions : AI pour présenter vos innovations à plus de 1 200 décideurs sans vous ruiner. Disponible jusqu'au 9 mai ou jusqu'à épuisement des places.

Berkeley, CA | 5 juin RÉSERVEZ MAINTENANTL'étude d'Epoch repose sur certaines hypothèses et intègre des déclarations publiques des leaders de l'industrie de l'IA. Elle souligne également que la mise à l'échelle des modèles de raisonnement pourrait rencontrer des obstacles au-delà des limites de calcul, tels que des coûts de recherche élevés.

« Les coûts de recherche continus pourraient limiter l'évolutivité des modèles de raisonnement », explique You. « Puisque la mise à l'échelle rapide du calcul est un facteur clé de leur progrès, cela mérite une attention particulière. »

Tout signe indiquant que les modèles de raisonnement pourraient atteindre un plafond de performance prochainement pourrait susciter des inquiétudes dans l'industrie de l'IA, qui a fortement investi dans leur développement. Les recherches indiquent déjà que ces modèles, malgré leurs coûts opérationnels élevés, présentent des défauts notables, y compris une plus grande tendance à produire des résultats inexacts par rapport à certains modèles traditionnels.

Article connexe

Un expert de l'IA renommé dévoile la startup controversée visant à remplacer la main-d'œuvre mondiale

De temps en temps, une startup de la Silicon Valley s'accompagne d'un énoncé de mission si bizarre qu'il est difficile de dire s'il est authentique ou simplement se moquer de l'industrie. Entrez Mechanize, une nouvelle entreprise dirigée par le célèbre chercheur d'IA Tamay Besiroglu, qui a déclenché un débat sur X après

Un expert de l'IA renommé dévoile la startup controversée visant à remplacer la main-d'œuvre mondiale

De temps en temps, une startup de la Silicon Valley s'accompagne d'un énoncé de mission si bizarre qu'il est difficile de dire s'il est authentique ou simplement se moquer de l'industrie. Entrez Mechanize, une nouvelle entreprise dirigée par le célèbre chercheur d'IA Tamay Besiroglu, qui a déclenché un débat sur X après

La consommation d'énergie de Chatgpt est plus faible que prévu

Chatgpt, le chatbot d'Openai, n'est peut-être pas le Guzzler d'énergie que nous pensions. Mais, sa consommation d'énergie peut varier beaucoup en fonction de la façon dont il est utilisé et des modèles d'IA répondent aux questions, selon une nouvelle étude.

La consommation d'énergie de Chatgpt est plus faible que prévu

Chatgpt, le chatbot d'Openai, n'est peut-être pas le Guzzler d'énergie que nous pensions. Mais, sa consommation d'énergie peut varier beaucoup en fonction de la façon dont il est utilisé et des modèles d'IA répondent aux questions, selon une nouvelle étude.

Amazon franchit le cap de la robotique avec 1 million de robots déployés et dévoile un nouveau modèle d'IA générative

Voici le contenu HTML correctement réécrit, avec toutes les balises préservées :La main-d'œuvre robotisée d'Amazon franchit une étape historique Après 13 ans de déploiement de la robotique dans son ré

commentaires (5)

0/200

Amazon franchit le cap de la robotique avec 1 million de robots déployés et dévoile un nouveau modèle d'IA générative

Voici le contenu HTML correctement réécrit, avec toutes les balises préservées :La main-d'œuvre robotisée d'Amazon franchit une étape historique Après 13 ans de déploiement de la robotique dans son ré

commentaires (5)

0/200

![PeterPerez]() PeterPerez

PeterPerez

26 août 2025 07:25:25 UTC+02:00

26 août 2025 07:25:25 UTC+02:00

Mind-blowing study! If AI reasoning hits a wall by 2026, what’s next? Kinda scary to think we might be maxing out so soon. 😬

0

0

![RyanGonzalez]() RyanGonzalez

RyanGonzalez

23 août 2025 19:01:22 UTC+02:00

23 août 2025 19:01:22 UTC+02:00

This AI plateau talk is wild! If reasoning models hit a wall by 2026, what’s next? Kinda feels like we’re racing to the moon but might run out of fuel. 😅 Curious if this’ll push devs to get creative or just lean harder on hardware.

0

0

![AvaPhillips]() AvaPhillips

AvaPhillips

20 août 2025 11:01:15 UTC+02:00

20 août 2025 11:01:15 UTC+02:00

This AI plateau talk is wild! 🤯 Feels like we’re hitting a tech ceiling already. Wonder if it’s a real limit or just a pause before the next big leap?

0

0

![EricMiller]() EricMiller

EricMiller

20 août 2025 09:01:19 UTC+02:00

20 août 2025 09:01:19 UTC+02:00

Wow, AI progress hitting a plateau by 2026? That’s wild! I thought we’d keep zooming toward super-smart machines, but maybe it’s time for a new breakthrough to shake things up. 🧠

0

0

![BenGarcía]() BenGarcía

BenGarcía

5 août 2025 11:00:59 UTC+02:00

5 août 2025 11:00:59 UTC+02:00

This article's got me thinking—AI progress might hit a wall by 2026? That's wild! I wonder if companies will pivot to new tech or just keep pushing the same models. 🤔

0

0

Une étude d'Epoch AI, un institut de recherche sur l'IA à but non lucratif, indique que le secteur de l'IA pourrait bientôt rencontrer des défis pour obtenir des améliorations significatives des performances des modèles de raisonnement en IA. Le rapport prévoit que les avancées de ces modèles pourraient ralentir au cours de l'année prochaine.

Les modèles de raisonnement avancés, tels que l'o3 d'OpenAI, ont récemment entraîné des améliorations notables dans les benchmarks d'IA, en particulier dans les tâches de mathématiques et de codage. Ces modèles exploitent une puissance de calcul accrue pour améliorer leurs performances, bien que cela entraîne souvent des temps de traitement plus longs par rapport aux modèles traditionnels.

Les modèles de raisonnement sont créés en entraînant d'abord un modèle standard sur de vastes ensembles de données, suivi d'un apprentissage par renforcement, qui fournit au modèle des retours pour affiner ses capacités de résolution de problèmes.

Selon Epoch, les principaux laboratoires d'IA comme OpenAI n'ont pas encore utilisé massivement les ressources de calcul pour la phase d'apprentissage par renforcement du développement des modèles de raisonnement.

Cette tendance évolue. OpenAI a révélé qu'il a utilisé environ dix fois plus de puissance de calcul pour entraîner l'o3 par rapport à son prédécesseur, l'o1, Epoch suggérant que la majeure partie de celle-ci a été allouée à l'apprentissage par renforcement. Le chercheur d'OpenAI, Dan Roberts, a récemment indiqué que l'entreprise prévoit de prioriser davantage l'apprentissage par renforcement, en utilisant potentiellement encore plus de ressources de calcul que pour l'entraînement initial du modèle.

Cependant, Epoch note qu'il existe une limite à la quantité de puissance de calcul qui peut être appliquée à l'apprentissage par renforcement.

Josh You, analyste chez Epoch et auteur de l'étude, note que les gains de performance des entraînements de modèles d'IA standards quadruplent actuellement chaque année, tandis que les gains de l'apprentissage par renforcement augmentent de dix fois tous les trois à cinq mois. Il prévoit que les progrès des modèles de raisonnement s'aligneront probablement sur les avancées globales de l'IA d'ici 2026.

Présentation à TechCrunch Sessions : AI

Réservez votre place à TC Sessions : AI pour présenter vos innovations à plus de 1 200 décideurs sans vous ruiner. Disponible jusqu'au 9 mai ou jusqu'à épuisement des places.

Présentation à TechCrunch Sessions : AI

Réservez votre place à TC Sessions : AI pour présenter vos innovations à plus de 1 200 décideurs sans vous ruiner. Disponible jusqu'au 9 mai ou jusqu'à épuisement des places.

Berkeley, CA | 5 juin RÉSERVEZ MAINTENANTL'étude d'Epoch repose sur certaines hypothèses et intègre des déclarations publiques des leaders de l'industrie de l'IA. Elle souligne également que la mise à l'échelle des modèles de raisonnement pourrait rencontrer des obstacles au-delà des limites de calcul, tels que des coûts de recherche élevés.

« Les coûts de recherche continus pourraient limiter l'évolutivité des modèles de raisonnement », explique You. « Puisque la mise à l'échelle rapide du calcul est un facteur clé de leur progrès, cela mérite une attention particulière. »

Tout signe indiquant que les modèles de raisonnement pourraient atteindre un plafond de performance prochainement pourrait susciter des inquiétudes dans l'industrie de l'IA, qui a fortement investi dans leur développement. Les recherches indiquent déjà que ces modèles, malgré leurs coûts opérationnels élevés, présentent des défauts notables, y compris une plus grande tendance à produire des résultats inexacts par rapport à certains modèles traditionnels.

Un expert de l'IA renommé dévoile la startup controversée visant à remplacer la main-d'œuvre mondiale

De temps en temps, une startup de la Silicon Valley s'accompagne d'un énoncé de mission si bizarre qu'il est difficile de dire s'il est authentique ou simplement se moquer de l'industrie. Entrez Mechanize, une nouvelle entreprise dirigée par le célèbre chercheur d'IA Tamay Besiroglu, qui a déclenché un débat sur X après

Un expert de l'IA renommé dévoile la startup controversée visant à remplacer la main-d'œuvre mondiale

De temps en temps, une startup de la Silicon Valley s'accompagne d'un énoncé de mission si bizarre qu'il est difficile de dire s'il est authentique ou simplement se moquer de l'industrie. Entrez Mechanize, une nouvelle entreprise dirigée par le célèbre chercheur d'IA Tamay Besiroglu, qui a déclenché un débat sur X après

La consommation d'énergie de Chatgpt est plus faible que prévu

Chatgpt, le chatbot d'Openai, n'est peut-être pas le Guzzler d'énergie que nous pensions. Mais, sa consommation d'énergie peut varier beaucoup en fonction de la façon dont il est utilisé et des modèles d'IA répondent aux questions, selon une nouvelle étude.

La consommation d'énergie de Chatgpt est plus faible que prévu

Chatgpt, le chatbot d'Openai, n'est peut-être pas le Guzzler d'énergie que nous pensions. Mais, sa consommation d'énergie peut varier beaucoup en fonction de la façon dont il est utilisé et des modèles d'IA répondent aux questions, selon une nouvelle étude.

26 août 2025 07:25:25 UTC+02:00

26 août 2025 07:25:25 UTC+02:00

Mind-blowing study! If AI reasoning hits a wall by 2026, what’s next? Kinda scary to think we might be maxing out so soon. 😬

0

0

23 août 2025 19:01:22 UTC+02:00

23 août 2025 19:01:22 UTC+02:00

This AI plateau talk is wild! If reasoning models hit a wall by 2026, what’s next? Kinda feels like we’re racing to the moon but might run out of fuel. 😅 Curious if this’ll push devs to get creative or just lean harder on hardware.

0

0

20 août 2025 11:01:15 UTC+02:00

20 août 2025 11:01:15 UTC+02:00

This AI plateau talk is wild! 🤯 Feels like we’re hitting a tech ceiling already. Wonder if it’s a real limit or just a pause before the next big leap?

0

0

20 août 2025 09:01:19 UTC+02:00

20 août 2025 09:01:19 UTC+02:00

Wow, AI progress hitting a plateau by 2026? That’s wild! I thought we’d keep zooming toward super-smart machines, but maybe it’s time for a new breakthrough to shake things up. 🧠

0

0

5 août 2025 11:00:59 UTC+02:00

5 août 2025 11:00:59 UTC+02:00

This article's got me thinking—AI progress might hit a wall by 2026? That's wild! I wonder if companies will pivot to new tech or just keep pushing the same models. 🤔

0

0