Progresso do Modelo de Raciocínio de IA Pode Estagnar até 2026, Sugere Estudo da Epoch AI

Um estudo da Epoch AI, um instituto de pesquisa de IA sem fins lucrativos, indica que o setor de IA pode em breve enfrentar desafios para alcançar melhorias significativas de desempenho em modelos de raciocínio de IA. O relatório prevê que os avanços nesses modelos podem desacelerar no próximo ano.

Modelos de raciocínio avançados, como o o3 da OpenAI, impulsionaram recentemente melhorias notáveis em benchmarks de IA, particularmente em tarefas de matemática e codificação. Esses modelos utilizam maior poder computacional para melhorar o desempenho, embora isso muitas vezes resulte em tempos de processamento mais longos em comparação com modelos tradicionais.

Modelos de raciocínio são criados inicialmente treinando um modelo padrão em vastos conjuntos de dados, seguido por aprendizado por reforço, que fornece ao modelo feedback para refinar suas capacidades de resolução de problemas.

De acordo com a Epoch, laboratórios de IA líderes como a OpenAI ainda não utilizaram intensivamente recursos computacionais para a fase de aprendizado por reforço no desenvolvimento de modelos de raciocínio.

Essa tendência está mudando. A OpenAI revelou que usou aproximadamente dez vezes mais poder computacional para treinar o o3 em comparação com seu antecessor, o1, com a Epoch sugerindo que a maior parte disso foi alocada para aprendizado por reforço. O pesquisador da OpenAI, Dan Roberts, indicou recentemente que a empresa planeja priorizar ainda mais o aprendizado por reforço, potencialmente usando ainda mais recursos computacionais do que para o treinamento inicial do modelo.

No entanto, a Epoch observa que há um limite para quanto poder computacional pode ser aplicado ao aprendizado por reforço.

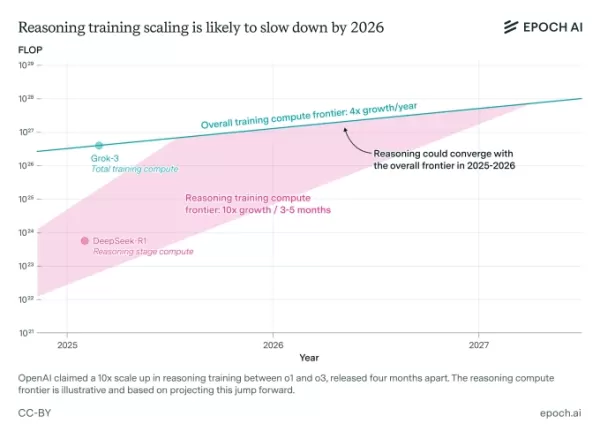

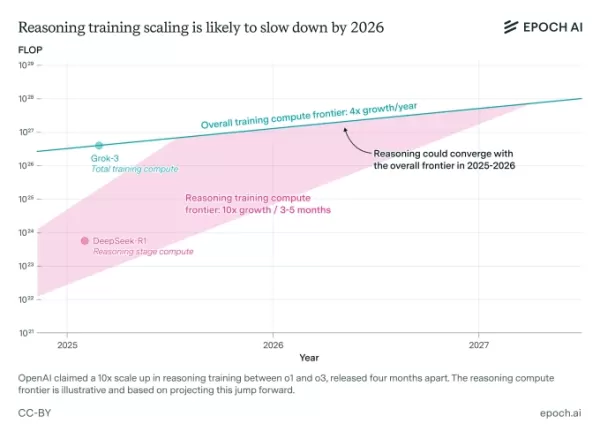

Um estudo da Epoch AI sugere que a escalabilidade do treinamento para modelos de raciocínio pode em breve enfrentar limitações. Créditos da imagem: Epoch AI Josh You, analista da Epoch e autor do estudo, observa que os ganhos de desempenho do treinamento de modelos de IA padrão estão atualmente quadruplicando anualmente, enquanto os ganhos do aprendizado por reforço estão aumentando dez vezes a cada três a cinco meses. Ele prevê que o progresso dos modelos de raciocínio provavelmente se alinhará com os avanços gerais de IA até 2026.

Apresentação nas Sessões TechCrunch: AI

Reserve seu espaço nas Sessões TC: AI para apresentar suas inovações a mais de 1.200 tomadores de decisão sem gastar muito. Disponível até 9 de maio ou enquanto houver vagas.

Apresentação nas Sessões TechCrunch: AI

Reserve seu espaço nas Sessões TC: AI para apresentar suas inovações a mais de 1.200 tomadores de decisão sem gastar muito. Disponível até 9 de maio ou enquanto houver vagas.

Berkeley, CA | 5 de junho RESERVE AGORAO estudo da Epoch baseia-se em certas suposições e incorpora declarações públicas de líderes da indústria de IA. Ele também destaca que a escalabilidade de modelos de raciocínio pode enfrentar obstáculos além dos limites computacionais, como altos custos indiretos de pesquisa.

“Os custos contínuos de pesquisa podem limitar a escalabilidade dos modelos de raciocínio,” explica You. “Como a escalabilidade computacional rápida é um fator chave em seu progresso, isso merece atenção especial.”

Quaisquer sinais de que os modelos de raciocínio podem atingir um teto de desempenho em breve podem levantar preocupações na indústria de IA, que investiu pesadamente em seu desenvolvimento. Pesquisas já indicam que esses modelos, apesar de seus altos custos operacionais, têm falhas notáveis, incluindo uma maior tendência a produzir resultados imprecisos em comparação com alguns modelos tradicionais.

Artigo relacionado

O renomado especialista em IA revela uma startup controversa que visa substituir a força de trabalho global

De vez em quando, uma startup do Vale do Silício vem junto com uma declaração de missão tão estranha que é difícil dizer se é genuíno ou apenas zombando da indústria. Entre Mechanize, um novo empreendimento liderado pelo renomado pesquisador de IA Tamay Besiroglu, que provocou bastante o debate sobre X depois dele

O renomado especialista em IA revela uma startup controversa que visa substituir a força de trabalho global

De vez em quando, uma startup do Vale do Silício vem junto com uma declaração de missão tão estranha que é difícil dizer se é genuíno ou apenas zombando da indústria. Entre Mechanize, um novo empreendimento liderado pelo renomado pesquisador de IA Tamay Besiroglu, que provocou bastante o debate sobre X depois dele

Uso de energia do ChatGPT mais baixo do que o esperado

Chatgpt, o chatbot do Openai, pode não ser o consundor de energia que pensamos que era. Porém, seu uso de energia pode variar muito, dependendo de como é usado e quais modelos de IA estão respondendo às perguntas, de acordo com um novo estudo. EPOCH AI, um grupo de pesquisa sem fins lucrativos, fez uma rachadura em descobrir quanto JUI

Uso de energia do ChatGPT mais baixo do que o esperado

Chatgpt, o chatbot do Openai, pode não ser o consundor de energia que pensamos que era. Porém, seu uso de energia pode variar muito, dependendo de como é usado e quais modelos de IA estão respondendo às perguntas, de acordo com um novo estudo. EPOCH AI, um grupo de pesquisa sem fins lucrativos, fez uma rachadura em descobrir quanto JUI

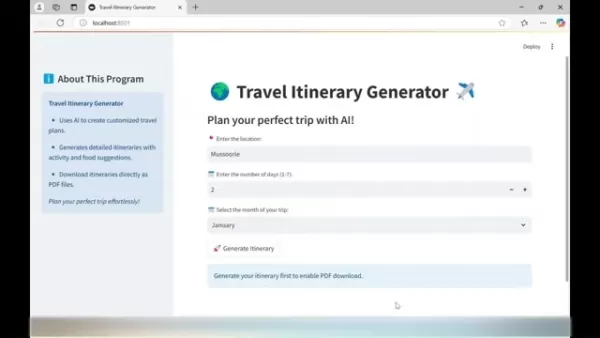

O gerador de itinerários de viagem com tecnologia de IA ajuda a planejar a viagem perfeita

O planejamento de viagens inesquecíveis acaba de ficar mais simples com a tecnologia de IA de ponta. O Gerador de Itinerários de Viagem revoluciona o planejamento das férias ao criar guias de viagem p

Comentários (5)

0/200

O gerador de itinerários de viagem com tecnologia de IA ajuda a planejar a viagem perfeita

O planejamento de viagens inesquecíveis acaba de ficar mais simples com a tecnologia de IA de ponta. O Gerador de Itinerários de Viagem revoluciona o planejamento das férias ao criar guias de viagem p

Comentários (5)

0/200

![PeterPerez]() PeterPerez

PeterPerez

26 de Agosto de 2025 à25 06:25:25 WEST

26 de Agosto de 2025 à25 06:25:25 WEST

Mind-blowing study! If AI reasoning hits a wall by 2026, what’s next? Kinda scary to think we might be maxing out so soon. 😬

0

0

![RyanGonzalez]() RyanGonzalez

RyanGonzalez

23 de Agosto de 2025 à22 18:01:22 WEST

23 de Agosto de 2025 à22 18:01:22 WEST

This AI plateau talk is wild! If reasoning models hit a wall by 2026, what’s next? Kinda feels like we’re racing to the moon but might run out of fuel. 😅 Curious if this’ll push devs to get creative or just lean harder on hardware.

0

0

![AvaPhillips]() AvaPhillips

AvaPhillips

20 de Agosto de 2025 à15 10:01:15 WEST

20 de Agosto de 2025 à15 10:01:15 WEST

This AI plateau talk is wild! 🤯 Feels like we’re hitting a tech ceiling already. Wonder if it’s a real limit or just a pause before the next big leap?

0

0

![EricMiller]() EricMiller

EricMiller

20 de Agosto de 2025 à19 08:01:19 WEST

20 de Agosto de 2025 à19 08:01:19 WEST

Wow, AI progress hitting a plateau by 2026? That’s wild! I thought we’d keep zooming toward super-smart machines, but maybe it’s time for a new breakthrough to shake things up. 🧠

0

0

![BenGarcía]() BenGarcía

BenGarcía

5 de Agosto de 2025 à59 10:00:59 WEST

5 de Agosto de 2025 à59 10:00:59 WEST

This article's got me thinking—AI progress might hit a wall by 2026? That's wild! I wonder if companies will pivot to new tech or just keep pushing the same models. 🤔

0

0

Um estudo da Epoch AI, um instituto de pesquisa de IA sem fins lucrativos, indica que o setor de IA pode em breve enfrentar desafios para alcançar melhorias significativas de desempenho em modelos de raciocínio de IA. O relatório prevê que os avanços nesses modelos podem desacelerar no próximo ano.

Modelos de raciocínio avançados, como o o3 da OpenAI, impulsionaram recentemente melhorias notáveis em benchmarks de IA, particularmente em tarefas de matemática e codificação. Esses modelos utilizam maior poder computacional para melhorar o desempenho, embora isso muitas vezes resulte em tempos de processamento mais longos em comparação com modelos tradicionais.

Modelos de raciocínio são criados inicialmente treinando um modelo padrão em vastos conjuntos de dados, seguido por aprendizado por reforço, que fornece ao modelo feedback para refinar suas capacidades de resolução de problemas.

De acordo com a Epoch, laboratórios de IA líderes como a OpenAI ainda não utilizaram intensivamente recursos computacionais para a fase de aprendizado por reforço no desenvolvimento de modelos de raciocínio.

Essa tendência está mudando. A OpenAI revelou que usou aproximadamente dez vezes mais poder computacional para treinar o o3 em comparação com seu antecessor, o1, com a Epoch sugerindo que a maior parte disso foi alocada para aprendizado por reforço. O pesquisador da OpenAI, Dan Roberts, indicou recentemente que a empresa planeja priorizar ainda mais o aprendizado por reforço, potencialmente usando ainda mais recursos computacionais do que para o treinamento inicial do modelo.

No entanto, a Epoch observa que há um limite para quanto poder computacional pode ser aplicado ao aprendizado por reforço.

Josh You, analista da Epoch e autor do estudo, observa que os ganhos de desempenho do treinamento de modelos de IA padrão estão atualmente quadruplicando anualmente, enquanto os ganhos do aprendizado por reforço estão aumentando dez vezes a cada três a cinco meses. Ele prevê que o progresso dos modelos de raciocínio provavelmente se alinhará com os avanços gerais de IA até 2026.

Apresentação nas Sessões TechCrunch: AI

Reserve seu espaço nas Sessões TC: AI para apresentar suas inovações a mais de 1.200 tomadores de decisão sem gastar muito. Disponível até 9 de maio ou enquanto houver vagas.

Apresentação nas Sessões TechCrunch: AI

Reserve seu espaço nas Sessões TC: AI para apresentar suas inovações a mais de 1.200 tomadores de decisão sem gastar muito. Disponível até 9 de maio ou enquanto houver vagas.

Berkeley, CA | 5 de junho RESERVE AGORAO estudo da Epoch baseia-se em certas suposições e incorpora declarações públicas de líderes da indústria de IA. Ele também destaca que a escalabilidade de modelos de raciocínio pode enfrentar obstáculos além dos limites computacionais, como altos custos indiretos de pesquisa.

“Os custos contínuos de pesquisa podem limitar a escalabilidade dos modelos de raciocínio,” explica You. “Como a escalabilidade computacional rápida é um fator chave em seu progresso, isso merece atenção especial.”

Quaisquer sinais de que os modelos de raciocínio podem atingir um teto de desempenho em breve podem levantar preocupações na indústria de IA, que investiu pesadamente em seu desenvolvimento. Pesquisas já indicam que esses modelos, apesar de seus altos custos operacionais, têm falhas notáveis, incluindo uma maior tendência a produzir resultados imprecisos em comparação com alguns modelos tradicionais.

O renomado especialista em IA revela uma startup controversa que visa substituir a força de trabalho global

De vez em quando, uma startup do Vale do Silício vem junto com uma declaração de missão tão estranha que é difícil dizer se é genuíno ou apenas zombando da indústria. Entre Mechanize, um novo empreendimento liderado pelo renomado pesquisador de IA Tamay Besiroglu, que provocou bastante o debate sobre X depois dele

O renomado especialista em IA revela uma startup controversa que visa substituir a força de trabalho global

De vez em quando, uma startup do Vale do Silício vem junto com uma declaração de missão tão estranha que é difícil dizer se é genuíno ou apenas zombando da indústria. Entre Mechanize, um novo empreendimento liderado pelo renomado pesquisador de IA Tamay Besiroglu, que provocou bastante o debate sobre X depois dele

Uso de energia do ChatGPT mais baixo do que o esperado

Chatgpt, o chatbot do Openai, pode não ser o consundor de energia que pensamos que era. Porém, seu uso de energia pode variar muito, dependendo de como é usado e quais modelos de IA estão respondendo às perguntas, de acordo com um novo estudo. EPOCH AI, um grupo de pesquisa sem fins lucrativos, fez uma rachadura em descobrir quanto JUI

Uso de energia do ChatGPT mais baixo do que o esperado

Chatgpt, o chatbot do Openai, pode não ser o consundor de energia que pensamos que era. Porém, seu uso de energia pode variar muito, dependendo de como é usado e quais modelos de IA estão respondendo às perguntas, de acordo com um novo estudo. EPOCH AI, um grupo de pesquisa sem fins lucrativos, fez uma rachadura em descobrir quanto JUI

O gerador de itinerários de viagem com tecnologia de IA ajuda a planejar a viagem perfeita

O planejamento de viagens inesquecíveis acaba de ficar mais simples com a tecnologia de IA de ponta. O Gerador de Itinerários de Viagem revoluciona o planejamento das férias ao criar guias de viagem p

O gerador de itinerários de viagem com tecnologia de IA ajuda a planejar a viagem perfeita

O planejamento de viagens inesquecíveis acaba de ficar mais simples com a tecnologia de IA de ponta. O Gerador de Itinerários de Viagem revoluciona o planejamento das férias ao criar guias de viagem p

26 de Agosto de 2025 à25 06:25:25 WEST

26 de Agosto de 2025 à25 06:25:25 WEST

Mind-blowing study! If AI reasoning hits a wall by 2026, what’s next? Kinda scary to think we might be maxing out so soon. 😬

0

0

23 de Agosto de 2025 à22 18:01:22 WEST

23 de Agosto de 2025 à22 18:01:22 WEST

This AI plateau talk is wild! If reasoning models hit a wall by 2026, what’s next? Kinda feels like we’re racing to the moon but might run out of fuel. 😅 Curious if this’ll push devs to get creative or just lean harder on hardware.

0

0

20 de Agosto de 2025 à15 10:01:15 WEST

20 de Agosto de 2025 à15 10:01:15 WEST

This AI plateau talk is wild! 🤯 Feels like we’re hitting a tech ceiling already. Wonder if it’s a real limit or just a pause before the next big leap?

0

0

20 de Agosto de 2025 à19 08:01:19 WEST

20 de Agosto de 2025 à19 08:01:19 WEST

Wow, AI progress hitting a plateau by 2026? That’s wild! I thought we’d keep zooming toward super-smart machines, but maybe it’s time for a new breakthrough to shake things up. 🧠

0

0

5 de Agosto de 2025 à59 10:00:59 WEST

5 de Agosto de 2025 à59 10:00:59 WEST

This article's got me thinking—AI progress might hit a wall by 2026? That's wild! I wonder if companies will pivot to new tech or just keep pushing the same models. 🤔

0

0