एआई स्टार्टअप्स ने पीआर रणनीति के रूप में सहकर्मी समीक्षा का उपयोग करने के लिए आलोचना की

इस वर्ष के ICLR सम्मेलन में AI-जनरेटेड अध्ययनों के उपयोग को लेकर शैक्षणिक जगत में तूफान खड़ा हो रहा है, जो कृत्रिम बुद्धिमत्ता पर केंद्रित एक प्रमुख आयोजन है। तीन AI प्रयोगशालाएँ, Sakana, Intology, और Autoscience, ने ICLR कार्यशालाओं में AI-जनरेटेड अध्ययन जमा करके विवाद पैदा किया है।

Sakana ने एक पारदर्शी दृष्टिकोण अपनाया, ICLR नेताओं को सूचित किया और उनके AI-जनरेटेड पेपर्स जमा करने से पहले सहकर्मी समीक्षकों से सहमति प्राप्त की। हालांकि, Intology और Autoscience ने ऐसा नहीं किया, TechCrunch को एक ICLR प्रवक्ता ने पुष्टि की कि उन्होंने बिना पूर्व सूचना के अपने अध्ययन जमा किए।

शैक्षणिक समुदाय ने सोशल मीडिया पर मुखर होकर प्रतिक्रिया दी है, कई लोग Intology और Autoscience की सहकर्मी समीक्षा प्रक्रिया का दुरुपयोग करने के लिए आलोचना कर रहे हैं। UC San Diego के सहायक प्रोफेसर प्रिथ्वीराज अम्मानब्रोलु ने X पर अपनी निराशा व्यक्त की, जिसमें उन्होंने समीक्षकों से सहमति की कमी को उजागर किया, जो अपना समय और प्रयास मुफ्त में देते हैं। उन्होंने इन अध्ययनों को उत्पन्न करने में AI के उपयोग के बारे में संपादकों को पूर्ण प्रकटीकरण की मांग की।

सहकर्मी समीक्षा पहले से ही एक कठिन कार्य है, हाल के Nature सर्वेक्षण के अनुसार 40% शिक्षाविद एक एकल अध्ययन की समीक्षा करने में दो से चार घंटे खर्च करते हैं। पिछले साल NeurIPS सम्मेलन में जमा किए गए 17,491 पेपर्स में 41% की वृद्धि के साथ कार्यभार बढ़ रहा है।

शैक्षणिक क्षेत्र में AI-जनरेटेड सामग्री का मुद्दा नया नहीं है, अनुमान के अनुसार 2023 में AI सम्मेलनों में जमा किए गए 6.5% से 16.9% पेपर्स में सिंथेटिक टेक्स्ट शामिल था। हालांकि, सहकर्मी समीक्षा का उपयोग AI तकनीक को बेंचमार्क करने और प्रचारित करने के साधन के रूप में हाल का विकास है।

Intology ने X पर अपने AI-जनरेटेड पेपर्स के लिए सर्वसम्मति से सकारात्मक समीक्षाएँ प्राप्त करने का दावा किया, यहाँ तक कि कार्यशाला समीक्षकों के "चतुर विचारों" की प्रशंसा करने वाले उद्धरण भी दिए। यह आत्म-प्रचार शिक्षाविदों को अच्छा नहीं लगा।

मैरीलैंड विश्वविद्यालय में पोस्टडॉक्टोरल फेलो अश्विनी पांडा ने समीक्षकों की सहमति के बिना AI-जनरेटेड पेपर्स जमा करने के लिए मानव समीक्षकों के प्रति सम्मान की कमी की आलोचना की। पांडा ने उल्लेख किया कि Sakana ने उनकी ICLR कार्यशाला से संपर्क किया था, लेकिन उन्होंने भाग लेने से इनकार कर दिया, समीक्षकों के समय और अधिकारों के सम्मान के महत्व पर जोर दिया।

शोधकर्ताओं के बीच AI-जनरेटेड पेपर्स के मूल्य के बारे में संदेह व्यापक है। Sakana ने स्वीकार किया कि उनके AI ने "शर्मनाक" उद्धरण त्रुटियाँ कीं और उनके तीन जमा किए गए पेपर्स में से केवल एक ही सम्मेलन के मानकों को पूरा करता। पारदर्शिता की दिशा में एक कदम में, Sakana ने अपने पेपर को ICLR से वापस ले लिया।

AI स्टार्टअप Pleias के सह-संस्थापक अलेक्जेंडर डोरिया ने एक "नियंत्रित कंपनी/सार्वजनिक एजेंसी" की आवश्यकता का सुझाव दिया जो AI-जनरेटेड अध्ययनों का भुगतान, उच्च-गुणवत्ता मूल्यांकन करे। उन्होंने तर्क दिया कि शोधकर्ताओं को उनके समय के लिए पूरी तरह से मुआवजा दिया जाना चाहिए और शैक्षणिक क्षेत्र को AI मूल्यांकन के लिए मुफ्त संसाधन के रूप में उपयोग नहीं किया जाना चाहिए।

संबंधित लेख

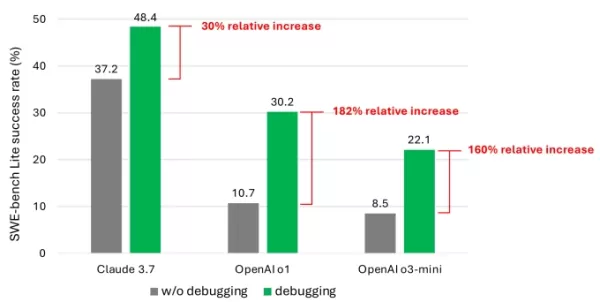

Microsoft Study Reveals AI Models' Limitations in Software Debugging

OpenAI, Anthropic और अन्य प्रमुख AI लैब्स के AI मॉडल कोडिंग कार्यों के लिए तेजी से उपयोग किए जा रहे हैं। Google CEO Sundar Pichai ने अक्टूबर में नोट किया कि AI कंपनी में 25% नए कोड जनरेट करता है, जबकि

Microsoft Study Reveals AI Models' Limitations in Software Debugging

OpenAI, Anthropic और अन्य प्रमुख AI लैब्स के AI मॉडल कोडिंग कार्यों के लिए तेजी से उपयोग किए जा रहे हैं। Google CEO Sundar Pichai ने अक्टूबर में नोट किया कि AI कंपनी में 25% नए कोड जनरेट करता है, जबकि

AI-चालित समाधान वैश्विक कार्बन उत्सर्जन को काफी हद तक कम कर सकते हैं

लंदन स्कूल ऑफ इकोनॉमिक्स और सिस्टमिक के एक हालिया अध्ययन से पता चलता है कि कृत्रिम बुद्धिमत्ता (AI) आधुनिक सुविधाओं को त्यागे बिना वैश्विक कार्बन उत्सर्जन को काफी हद तक कम कर सकती है, जिससे AI जलवायु

AI-चालित समाधान वैश्विक कार्बन उत्सर्जन को काफी हद तक कम कर सकते हैं

लंदन स्कूल ऑफ इकोनॉमिक्स और सिस्टमिक के एक हालिया अध्ययन से पता चलता है कि कृत्रिम बुद्धिमत्ता (AI) आधुनिक सुविधाओं को त्यागे बिना वैश्विक कार्बन उत्सर्जन को काफी हद तक कम कर सकती है, जिससे AI जलवायु

नई अध्ययन से पता चलता है कि LLM वास्तव में कितना डेटा याद करते हैं

AI मॉडल वास्तव में कितना याद करते हैं? नया शोध आश्चर्यजनक जानकारी देता हैहम सभी जानते हैं कि बड़े भाषा मॉडल (LLM) जैसे ChatGPT, Claude, और Gemini को किताबों, वेबसाइटों, कोड और यहां तक कि चित्रों और ऑड

सूचना (31)

0/200

नई अध्ययन से पता चलता है कि LLM वास्तव में कितना डेटा याद करते हैं

AI मॉडल वास्तव में कितना याद करते हैं? नया शोध आश्चर्यजनक जानकारी देता हैहम सभी जानते हैं कि बड़े भाषा मॉडल (LLM) जैसे ChatGPT, Claude, और Gemini को किताबों, वेबसाइटों, कोड और यहां तक कि चित्रों और ऑड

सूचना (31)

0/200

![JuanEvans]() JuanEvans

JuanEvans

22 जुलाई 2025 6:55:03 पूर्वाह्न IST

22 जुलाई 2025 6:55:03 पूर्वाह्न IST

It's wild how AI startups are turning peer review into a PR stunt! 😅 Sakana and others submitting AI-generated studies to ICLR is bold, but it feels like they're more focused on headlines than real science. Anyone else think this could backfire big time?

0

0

![LawrenceMiller]() LawrenceMiller

LawrenceMiller

14 अप्रैल 2025 3:59:12 अपराह्न IST

14 अप्रैल 2025 3:59:12 अपराह्न IST

Я в замешательстве по поводу этих исследований, созданных ИИ, на ICLR. С одной стороны, круто, что ИИ может генерировать исследования, но использовать это для PR? Это кажется немного неправильным. Это расширяет границы, но не уверен, что это лучший способ.

0

0

![AlbertAllen]() AlbertAllen

AlbertAllen

13 अप्रैल 2025 8:15:33 अपराह्न IST

13 अप्रैल 2025 8:15:33 अपराह्न IST

I'm kinda torn about these AI startups using peer review as a PR move. On one hand, it's clever marketing, but on the other, it feels like they're gaming the system. I mean, if the studies are legit, why not just say so? Feels a bit shady to me.

0

0

![JackMartin]() JackMartin

JackMartin

13 अप्रैल 2025 4:18:53 अपराह्न IST

13 अप्रैल 2025 4:18:53 अपराह्न IST

ICLRでのAI生成の研究論文について、複雑な気持ちです。AIが研究を生成できるのは面白いけど、PRに利用するのは少し違和感があります。境界を押し広げる試みではあるけど、必ずしも最良の方法とは言えないかもしれませんね。

0

0

![JonathanKing]() JonathanKing

JonathanKing

13 अप्रैल 2025 1:28:51 अपराह्न IST

13 अप्रैल 2025 1:28:51 अपराह्न IST

Estoy dividido sobre estas startups de IA que usan la revisión por pares como una táctica de relaciones públicas. Por un lado, es un marketing inteligente, pero por otro, parece que están jugando con el sistema. Si los estudios son legítimos, ¿por qué no decirlo simplemente? Me parece un poco turbio.

0

0

![BillyThomas]() BillyThomas

BillyThomas

13 अप्रैल 2025 12:00:32 पूर्वाह्न IST

13 अप्रैल 2025 12:00:32 पूर्वाह्न IST

Me siento dividido con lo de los estudios generados por IA en ICLR. Por un lado, es genial que la IA pueda producir investigación, pero usarlo para relaciones públicas, no sé, me parece un poco fuera de lugar. Está empujando límites, pero no estoy seguro de que sea de la mejor manera.

0

0

इस वर्ष के ICLR सम्मेलन में AI-जनरेटेड अध्ययनों के उपयोग को लेकर शैक्षणिक जगत में तूफान खड़ा हो रहा है, जो कृत्रिम बुद्धिमत्ता पर केंद्रित एक प्रमुख आयोजन है। तीन AI प्रयोगशालाएँ, Sakana, Intology, और Autoscience, ने ICLR कार्यशालाओं में AI-जनरेटेड अध्ययन जमा करके विवाद पैदा किया है।

Sakana ने एक पारदर्शी दृष्टिकोण अपनाया, ICLR नेताओं को सूचित किया और उनके AI-जनरेटेड पेपर्स जमा करने से पहले सहकर्मी समीक्षकों से सहमति प्राप्त की। हालांकि, Intology और Autoscience ने ऐसा नहीं किया, TechCrunch को एक ICLR प्रवक्ता ने पुष्टि की कि उन्होंने बिना पूर्व सूचना के अपने अध्ययन जमा किए।

शैक्षणिक समुदाय ने सोशल मीडिया पर मुखर होकर प्रतिक्रिया दी है, कई लोग Intology और Autoscience की सहकर्मी समीक्षा प्रक्रिया का दुरुपयोग करने के लिए आलोचना कर रहे हैं। UC San Diego के सहायक प्रोफेसर प्रिथ्वीराज अम्मानब्रोलु ने X पर अपनी निराशा व्यक्त की, जिसमें उन्होंने समीक्षकों से सहमति की कमी को उजागर किया, जो अपना समय और प्रयास मुफ्त में देते हैं। उन्होंने इन अध्ययनों को उत्पन्न करने में AI के उपयोग के बारे में संपादकों को पूर्ण प्रकटीकरण की मांग की।

सहकर्मी समीक्षा पहले से ही एक कठिन कार्य है, हाल के Nature सर्वेक्षण के अनुसार 40% शिक्षाविद एक एकल अध्ययन की समीक्षा करने में दो से चार घंटे खर्च करते हैं। पिछले साल NeurIPS सम्मेलन में जमा किए गए 17,491 पेपर्स में 41% की वृद्धि के साथ कार्यभार बढ़ रहा है।

शैक्षणिक क्षेत्र में AI-जनरेटेड सामग्री का मुद्दा नया नहीं है, अनुमान के अनुसार 2023 में AI सम्मेलनों में जमा किए गए 6.5% से 16.9% पेपर्स में सिंथेटिक टेक्स्ट शामिल था। हालांकि, सहकर्मी समीक्षा का उपयोग AI तकनीक को बेंचमार्क करने और प्रचारित करने के साधन के रूप में हाल का विकास है।

Intology ने X पर अपने AI-जनरेटेड पेपर्स के लिए सर्वसम्मति से सकारात्मक समीक्षाएँ प्राप्त करने का दावा किया, यहाँ तक कि कार्यशाला समीक्षकों के "चतुर विचारों" की प्रशंसा करने वाले उद्धरण भी दिए। यह आत्म-प्रचार शिक्षाविदों को अच्छा नहीं लगा।

मैरीलैंड विश्वविद्यालय में पोस्टडॉक्टोरल फेलो अश्विनी पांडा ने समीक्षकों की सहमति के बिना AI-जनरेटेड पेपर्स जमा करने के लिए मानव समीक्षकों के प्रति सम्मान की कमी की आलोचना की। पांडा ने उल्लेख किया कि Sakana ने उनकी ICLR कार्यशाला से संपर्क किया था, लेकिन उन्होंने भाग लेने से इनकार कर दिया, समीक्षकों के समय और अधिकारों के सम्मान के महत्व पर जोर दिया।

शोधकर्ताओं के बीच AI-जनरेटेड पेपर्स के मूल्य के बारे में संदेह व्यापक है। Sakana ने स्वीकार किया कि उनके AI ने "शर्मनाक" उद्धरण त्रुटियाँ कीं और उनके तीन जमा किए गए पेपर्स में से केवल एक ही सम्मेलन के मानकों को पूरा करता। पारदर्शिता की दिशा में एक कदम में, Sakana ने अपने पेपर को ICLR से वापस ले लिया।

AI स्टार्टअप Pleias के सह-संस्थापक अलेक्जेंडर डोरिया ने एक "नियंत्रित कंपनी/सार्वजनिक एजेंसी" की आवश्यकता का सुझाव दिया जो AI-जनरेटेड अध्ययनों का भुगतान, उच्च-गुणवत्ता मूल्यांकन करे। उन्होंने तर्क दिया कि शोधकर्ताओं को उनके समय के लिए पूरी तरह से मुआवजा दिया जाना चाहिए और शैक्षणिक क्षेत्र को AI मूल्यांकन के लिए मुफ्त संसाधन के रूप में उपयोग नहीं किया जाना चाहिए।

Microsoft Study Reveals AI Models' Limitations in Software Debugging

OpenAI, Anthropic और अन्य प्रमुख AI लैब्स के AI मॉडल कोडिंग कार्यों के लिए तेजी से उपयोग किए जा रहे हैं। Google CEO Sundar Pichai ने अक्टूबर में नोट किया कि AI कंपनी में 25% नए कोड जनरेट करता है, जबकि

Microsoft Study Reveals AI Models' Limitations in Software Debugging

OpenAI, Anthropic और अन्य प्रमुख AI लैब्स के AI मॉडल कोडिंग कार्यों के लिए तेजी से उपयोग किए जा रहे हैं। Google CEO Sundar Pichai ने अक्टूबर में नोट किया कि AI कंपनी में 25% नए कोड जनरेट करता है, जबकि

नई अध्ययन से पता चलता है कि LLM वास्तव में कितना डेटा याद करते हैं

AI मॉडल वास्तव में कितना याद करते हैं? नया शोध आश्चर्यजनक जानकारी देता हैहम सभी जानते हैं कि बड़े भाषा मॉडल (LLM) जैसे ChatGPT, Claude, और Gemini को किताबों, वेबसाइटों, कोड और यहां तक कि चित्रों और ऑड

नई अध्ययन से पता चलता है कि LLM वास्तव में कितना डेटा याद करते हैं

AI मॉडल वास्तव में कितना याद करते हैं? नया शोध आश्चर्यजनक जानकारी देता हैहम सभी जानते हैं कि बड़े भाषा मॉडल (LLM) जैसे ChatGPT, Claude, और Gemini को किताबों, वेबसाइटों, कोड और यहां तक कि चित्रों और ऑड

22 जुलाई 2025 6:55:03 पूर्वाह्न IST

22 जुलाई 2025 6:55:03 पूर्वाह्न IST

It's wild how AI startups are turning peer review into a PR stunt! 😅 Sakana and others submitting AI-generated studies to ICLR is bold, but it feels like they're more focused on headlines than real science. Anyone else think this could backfire big time?

0

0

14 अप्रैल 2025 3:59:12 अपराह्न IST

14 अप्रैल 2025 3:59:12 अपराह्न IST

Я в замешательстве по поводу этих исследований, созданных ИИ, на ICLR. С одной стороны, круто, что ИИ может генерировать исследования, но использовать это для PR? Это кажется немного неправильным. Это расширяет границы, но не уверен, что это лучший способ.

0

0

13 अप्रैल 2025 8:15:33 अपराह्न IST

13 अप्रैल 2025 8:15:33 अपराह्न IST

I'm kinda torn about these AI startups using peer review as a PR move. On one hand, it's clever marketing, but on the other, it feels like they're gaming the system. I mean, if the studies are legit, why not just say so? Feels a bit shady to me.

0

0

13 अप्रैल 2025 4:18:53 अपराह्न IST

13 अप्रैल 2025 4:18:53 अपराह्न IST

ICLRでのAI生成の研究論文について、複雑な気持ちです。AIが研究を生成できるのは面白いけど、PRに利用するのは少し違和感があります。境界を押し広げる試みではあるけど、必ずしも最良の方法とは言えないかもしれませんね。

0

0

13 अप्रैल 2025 1:28:51 अपराह्न IST

13 अप्रैल 2025 1:28:51 अपराह्न IST

Estoy dividido sobre estas startups de IA que usan la revisión por pares como una táctica de relaciones públicas. Por un lado, es un marketing inteligente, pero por otro, parece que están jugando con el sistema. Si los estudios son legítimos, ¿por qué no decirlo simplemente? Me parece un poco turbio.

0

0

13 अप्रैल 2025 12:00:32 पूर्वाह्न IST

13 अप्रैल 2025 12:00:32 पूर्वाह्न IST

Me siento dividido con lo de los estudios generados por IA en ICLR. Por un lado, es genial que la IA pueda producir investigación, pero usarlo para relaciones públicas, no sé, me parece un poco fuera de lugar. Está empujando límites, pero no estoy seguro de que sea de la mejor manera.

0

0