Các công ty khởi nghiệp AI bị chỉ trích vì sử dụng đánh giá ngang hàng làm chiến thuật PR

Một cơn bão đang nổi lên trong giới học thuật về việc sử dụng các nghiên cứu do AI tạo ra tại hội nghị ICLR năm nay, một sự kiện lớn tập trung vào trí tuệ nhân tạo. Ba phòng thí nghiệm AI, Sakana, Intology và Autoscience, đã gây tranh cãi khi nộp các nghiên cứu do AI tạo ra cho các hội thảo của ICLR.

Sakana đã áp dụng cách tiếp cận minh bạch, thông báo cho các lãnh đạo ICLR và nhận được sự đồng ý từ các nhà đánh giá ngang hàng trước khi nộp các bài báo do AI tạo ra. Tuy nhiên, Intology và Autoscience không làm như vậy, nộp các nghiên cứu của họ mà không thông báo trước, theo xác nhận của một phát ngôn viên ICLR với TechCrunch.

Cộng đồng học thuật đã lên tiếng mạnh mẽ trên mạng xã hội, với nhiều người chỉ trích Intology và Autoscience vì lạm dụng quy trình đánh giá ngang hàng. Prithviraj Ammanabrolu, một trợ lý giáo sư tại UC San Diego, đã bày tỏ sự thất vọng trên X, nhấn mạnh việc thiếu sự đồng ý từ các nhà đánh giá, những người dành thời gian và công sức miễn phí. Ông kêu gọi công khai đầy đủ với các biên tập viên về việc sử dụng AI trong việc tạo ra các nghiên cứu này.

Đánh giá ngang hàng vốn đã là một nhiệm vụ đòi hỏi nhiều công sức, với một cuộc khảo sát gần đây của Nature cho thấy 40% các học giả dành từ hai đến bốn giờ để đánh giá một nghiên cứu duy nhất. Khối lượng công việc đang tăng lên, như được chứng minh bởi sự gia tăng 41% số bài nộp cho hội nghị NeurIPS năm ngoái, tổng cộng 17.491 bài báo.

Vấn đề nội dung do AI tạo ra trong giới học thuật không phải là mới, với ước tính cho thấy từ 6,5% đến 16,9% các bài báo nộp cho các hội nghị AI trong năm 2023 chứa văn bản tổng hợp. Tuy nhiên, việc sử dụng đánh giá ngang hàng như một phương tiện để đo lường và quảng bá công nghệ AI là một phát triển gần đây hơn.

Intology tự hào trên X về việc nhận được các đánh giá tích cực nhất trí cho các bài báo do AI tạo ra, thậm chí trích dẫn các nhà đánh giá hội thảo ca ngợi “những ý tưởng thông minh” trong một trong các nghiên cứu của họ. Việc tự quảng bá này không được giới học thuật đón nhận tích cực.

Ashwinee Panda, một nghiên cứu sinh sau tiến sĩ tại Đại học Maryland, chỉ trích việc thiếu tôn trọng đối với các nhà đánh giá con người khi nộp các bài báo do AI tạo ra mà không có sự đồng ý của họ. Panda lưu ý rằng Sakana đã tiếp cận hội thảo của cô tại ICLR, nhưng cô từ chối tham gia, nhấn mạnh tầm quan trọng của việc tôn trọng thời gian và quyền lợi của các nhà đánh giá.

Sự hoài nghi về giá trị của các bài báo do AI tạo ra rất phổ biến trong giới nghiên cứu. Sakana thừa nhận rằng AI của họ đã mắc “những lỗi trích dẫn đáng xấu hổ” và chỉ một trong ba bài báo nộp của họ đáp ứng được tiêu chuẩn của hội nghị. Để hướng tới sự minh bạch, Sakana đã rút bài báo của họ khỏi ICLR.

Alexander Doria, đồng sáng lập startup AI Pleias, đề xuất cần có một “công ty/ cơ quan công cộng được quy định” để tiến hành các đánh giá chất lượng cao có trả phí cho các nghiên cứu do AI tạo ra. Ông lập luận rằng các nhà nghiên cứu nên được bồi thường đầy đủ cho thời gian của họ và học thuật không nên bị sử dụng như một nguồn lực miễn phí cho các đánh giá AI.

Bài viết liên quan

Nghiên cứu của Microsoft tiết lộ giới hạn của các mô hình AI trong việc gỡ lỗi phần mềm

Các mô hình AI từ OpenAI, Anthropic và các phòng thí nghiệm AI hàng đầu khác ngày càng được sử dụng cho các nhiệm vụ lập trình. Giám đốc điều hành Google Sundar Pichai đã lưu ý vào tháng 10 rằng AI tạ

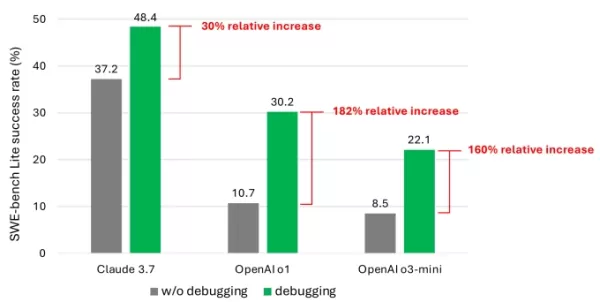

Nghiên cứu của Microsoft tiết lộ giới hạn của các mô hình AI trong việc gỡ lỗi phần mềm

Các mô hình AI từ OpenAI, Anthropic và các phòng thí nghiệm AI hàng đầu khác ngày càng được sử dụng cho các nhiệm vụ lập trình. Giám đốc điều hành Google Sundar Pichai đã lưu ý vào tháng 10 rằng AI tạ

Giải pháp được hỗ trợ bởi AI có thể giảm đáng kể lượng phát thải carbon toàn cầu

Một nghiên cứu gần đây của Trường Kinh tế London và Systemiq cho thấy trí tuệ nhân tạo có thể giảm đáng kể lượng phát thải carbon toàn cầu mà không làm mất đi các tiện nghi hiện đại, định vị AI như mộ

Giải pháp được hỗ trợ bởi AI có thể giảm đáng kể lượng phát thải carbon toàn cầu

Một nghiên cứu gần đây của Trường Kinh tế London và Systemiq cho thấy trí tuệ nhân tạo có thể giảm đáng kể lượng phát thải carbon toàn cầu mà không làm mất đi các tiện nghi hiện đại, định vị AI như mộ

Nghiên Cứu Mới Tiết Lộ Lượng Dữ Liệu LLMs Thực Sự Ghi Nhớ

AI Ghi Nhớ Bao Nhiêu? Nghiên Cứu Mới Tiết Lộ Những Hiểu Biết Bất NgờChúng ta đều biết rằng các mô hình ngôn ngữ lớn (LLMs) như ChatGPT, Claude, và Gemini được huấn luyện trên các tập dữ liệu khổng lồ—

Nhận xét (31)

0/200

Nghiên Cứu Mới Tiết Lộ Lượng Dữ Liệu LLMs Thực Sự Ghi Nhớ

AI Ghi Nhớ Bao Nhiêu? Nghiên Cứu Mới Tiết Lộ Những Hiểu Biết Bất NgờChúng ta đều biết rằng các mô hình ngôn ngữ lớn (LLMs) như ChatGPT, Claude, và Gemini được huấn luyện trên các tập dữ liệu khổng lồ—

Nhận xét (31)

0/200

![JuanEvans]() JuanEvans

JuanEvans

08:25:03 GMT+07:00 Ngày 22 tháng 7 năm 2025

08:25:03 GMT+07:00 Ngày 22 tháng 7 năm 2025

It's wild how AI startups are turning peer review into a PR stunt! 😅 Sakana and others submitting AI-generated studies to ICLR is bold, but it feels like they're more focused on headlines than real science. Anyone else think this could backfire big time?

0

0

![LawrenceMiller]() LawrenceMiller

LawrenceMiller

17:29:12 GMT+07:00 Ngày 14 tháng 4 năm 2025

17:29:12 GMT+07:00 Ngày 14 tháng 4 năm 2025

Я в замешательстве по поводу этих исследований, созданных ИИ, на ICLR. С одной стороны, круто, что ИИ может генерировать исследования, но использовать это для PR? Это кажется немного неправильным. Это расширяет границы, но не уверен, что это лучший способ.

0

0

![AlbertAllen]() AlbertAllen

AlbertAllen

21:45:33 GMT+07:00 Ngày 13 tháng 4 năm 2025

21:45:33 GMT+07:00 Ngày 13 tháng 4 năm 2025

I'm kinda torn about these AI startups using peer review as a PR move. On one hand, it's clever marketing, but on the other, it feels like they're gaming the system. I mean, if the studies are legit, why not just say so? Feels a bit shady to me.

0

0

![JackMartin]() JackMartin

JackMartin

17:48:53 GMT+07:00 Ngày 13 tháng 4 năm 2025

17:48:53 GMT+07:00 Ngày 13 tháng 4 năm 2025

ICLRでのAI生成の研究論文について、複雑な気持ちです。AIが研究を生成できるのは面白いけど、PRに利用するのは少し違和感があります。境界を押し広げる試みではあるけど、必ずしも最良の方法とは言えないかもしれませんね。

0

0

![JonathanKing]() JonathanKing

JonathanKing

14:58:51 GMT+07:00 Ngày 13 tháng 4 năm 2025

14:58:51 GMT+07:00 Ngày 13 tháng 4 năm 2025

Estoy dividido sobre estas startups de IA que usan la revisión por pares como una táctica de relaciones públicas. Por un lado, es un marketing inteligente, pero por otro, parece que están jugando con el sistema. Si los estudios son legítimos, ¿por qué no decirlo simplemente? Me parece un poco turbio.

0

0

![BillyThomas]() BillyThomas

BillyThomas

01:30:32 GMT+07:00 Ngày 13 tháng 4 năm 2025

01:30:32 GMT+07:00 Ngày 13 tháng 4 năm 2025

Me siento dividido con lo de los estudios generados por IA en ICLR. Por un lado, es genial que la IA pueda producir investigación, pero usarlo para relaciones públicas, no sé, me parece un poco fuera de lugar. Está empujando límites, pero no estoy seguro de que sea de la mejor manera.

0

0

Một cơn bão đang nổi lên trong giới học thuật về việc sử dụng các nghiên cứu do AI tạo ra tại hội nghị ICLR năm nay, một sự kiện lớn tập trung vào trí tuệ nhân tạo. Ba phòng thí nghiệm AI, Sakana, Intology và Autoscience, đã gây tranh cãi khi nộp các nghiên cứu do AI tạo ra cho các hội thảo của ICLR.

Sakana đã áp dụng cách tiếp cận minh bạch, thông báo cho các lãnh đạo ICLR và nhận được sự đồng ý từ các nhà đánh giá ngang hàng trước khi nộp các bài báo do AI tạo ra. Tuy nhiên, Intology và Autoscience không làm như vậy, nộp các nghiên cứu của họ mà không thông báo trước, theo xác nhận của một phát ngôn viên ICLR với TechCrunch.

Cộng đồng học thuật đã lên tiếng mạnh mẽ trên mạng xã hội, với nhiều người chỉ trích Intology và Autoscience vì lạm dụng quy trình đánh giá ngang hàng. Prithviraj Ammanabrolu, một trợ lý giáo sư tại UC San Diego, đã bày tỏ sự thất vọng trên X, nhấn mạnh việc thiếu sự đồng ý từ các nhà đánh giá, những người dành thời gian và công sức miễn phí. Ông kêu gọi công khai đầy đủ với các biên tập viên về việc sử dụng AI trong việc tạo ra các nghiên cứu này.

Đánh giá ngang hàng vốn đã là một nhiệm vụ đòi hỏi nhiều công sức, với một cuộc khảo sát gần đây của Nature cho thấy 40% các học giả dành từ hai đến bốn giờ để đánh giá một nghiên cứu duy nhất. Khối lượng công việc đang tăng lên, như được chứng minh bởi sự gia tăng 41% số bài nộp cho hội nghị NeurIPS năm ngoái, tổng cộng 17.491 bài báo.

Vấn đề nội dung do AI tạo ra trong giới học thuật không phải là mới, với ước tính cho thấy từ 6,5% đến 16,9% các bài báo nộp cho các hội nghị AI trong năm 2023 chứa văn bản tổng hợp. Tuy nhiên, việc sử dụng đánh giá ngang hàng như một phương tiện để đo lường và quảng bá công nghệ AI là một phát triển gần đây hơn.

Intology tự hào trên X về việc nhận được các đánh giá tích cực nhất trí cho các bài báo do AI tạo ra, thậm chí trích dẫn các nhà đánh giá hội thảo ca ngợi “những ý tưởng thông minh” trong một trong các nghiên cứu của họ. Việc tự quảng bá này không được giới học thuật đón nhận tích cực.

Ashwinee Panda, một nghiên cứu sinh sau tiến sĩ tại Đại học Maryland, chỉ trích việc thiếu tôn trọng đối với các nhà đánh giá con người khi nộp các bài báo do AI tạo ra mà không có sự đồng ý của họ. Panda lưu ý rằng Sakana đã tiếp cận hội thảo của cô tại ICLR, nhưng cô từ chối tham gia, nhấn mạnh tầm quan trọng của việc tôn trọng thời gian và quyền lợi của các nhà đánh giá.

Sự hoài nghi về giá trị của các bài báo do AI tạo ra rất phổ biến trong giới nghiên cứu. Sakana thừa nhận rằng AI của họ đã mắc “những lỗi trích dẫn đáng xấu hổ” và chỉ một trong ba bài báo nộp của họ đáp ứng được tiêu chuẩn của hội nghị. Để hướng tới sự minh bạch, Sakana đã rút bài báo của họ khỏi ICLR.

Alexander Doria, đồng sáng lập startup AI Pleias, đề xuất cần có một “công ty/ cơ quan công cộng được quy định” để tiến hành các đánh giá chất lượng cao có trả phí cho các nghiên cứu do AI tạo ra. Ông lập luận rằng các nhà nghiên cứu nên được bồi thường đầy đủ cho thời gian của họ và học thuật không nên bị sử dụng như một nguồn lực miễn phí cho các đánh giá AI.

Nghiên cứu của Microsoft tiết lộ giới hạn của các mô hình AI trong việc gỡ lỗi phần mềm

Các mô hình AI từ OpenAI, Anthropic và các phòng thí nghiệm AI hàng đầu khác ngày càng được sử dụng cho các nhiệm vụ lập trình. Giám đốc điều hành Google Sundar Pichai đã lưu ý vào tháng 10 rằng AI tạ

Nghiên cứu của Microsoft tiết lộ giới hạn của các mô hình AI trong việc gỡ lỗi phần mềm

Các mô hình AI từ OpenAI, Anthropic và các phòng thí nghiệm AI hàng đầu khác ngày càng được sử dụng cho các nhiệm vụ lập trình. Giám đốc điều hành Google Sundar Pichai đã lưu ý vào tháng 10 rằng AI tạ

Nghiên Cứu Mới Tiết Lộ Lượng Dữ Liệu LLMs Thực Sự Ghi Nhớ

AI Ghi Nhớ Bao Nhiêu? Nghiên Cứu Mới Tiết Lộ Những Hiểu Biết Bất NgờChúng ta đều biết rằng các mô hình ngôn ngữ lớn (LLMs) như ChatGPT, Claude, và Gemini được huấn luyện trên các tập dữ liệu khổng lồ—

Nghiên Cứu Mới Tiết Lộ Lượng Dữ Liệu LLMs Thực Sự Ghi Nhớ

AI Ghi Nhớ Bao Nhiêu? Nghiên Cứu Mới Tiết Lộ Những Hiểu Biết Bất NgờChúng ta đều biết rằng các mô hình ngôn ngữ lớn (LLMs) như ChatGPT, Claude, và Gemini được huấn luyện trên các tập dữ liệu khổng lồ—

08:25:03 GMT+07:00 Ngày 22 tháng 7 năm 2025

08:25:03 GMT+07:00 Ngày 22 tháng 7 năm 2025

It's wild how AI startups are turning peer review into a PR stunt! 😅 Sakana and others submitting AI-generated studies to ICLR is bold, but it feels like they're more focused on headlines than real science. Anyone else think this could backfire big time?

0

0

17:29:12 GMT+07:00 Ngày 14 tháng 4 năm 2025

17:29:12 GMT+07:00 Ngày 14 tháng 4 năm 2025

Я в замешательстве по поводу этих исследований, созданных ИИ, на ICLR. С одной стороны, круто, что ИИ может генерировать исследования, но использовать это для PR? Это кажется немного неправильным. Это расширяет границы, но не уверен, что это лучший способ.

0

0

21:45:33 GMT+07:00 Ngày 13 tháng 4 năm 2025

21:45:33 GMT+07:00 Ngày 13 tháng 4 năm 2025

I'm kinda torn about these AI startups using peer review as a PR move. On one hand, it's clever marketing, but on the other, it feels like they're gaming the system. I mean, if the studies are legit, why not just say so? Feels a bit shady to me.

0

0

17:48:53 GMT+07:00 Ngày 13 tháng 4 năm 2025

17:48:53 GMT+07:00 Ngày 13 tháng 4 năm 2025

ICLRでのAI生成の研究論文について、複雑な気持ちです。AIが研究を生成できるのは面白いけど、PRに利用するのは少し違和感があります。境界を押し広げる試みではあるけど、必ずしも最良の方法とは言えないかもしれませんね。

0

0

14:58:51 GMT+07:00 Ngày 13 tháng 4 năm 2025

14:58:51 GMT+07:00 Ngày 13 tháng 4 năm 2025

Estoy dividido sobre estas startups de IA que usan la revisión por pares como una táctica de relaciones públicas. Por un lado, es un marketing inteligente, pero por otro, parece que están jugando con el sistema. Si los estudios son legítimos, ¿por qué no decirlo simplemente? Me parece un poco turbio.

0

0

01:30:32 GMT+07:00 Ngày 13 tháng 4 năm 2025

01:30:32 GMT+07:00 Ngày 13 tháng 4 năm 2025

Me siento dividido con lo de los estudios generados por IA en ICLR. Por un lado, es genial que la IA pueda producir investigación, pero usarlo para relaciones públicas, no sé, me parece un poco fuera de lugar. Está empujando límites, pero no estoy seguro de que sea de la mejor manera.

0

0