Percée dans la technologie de mémoire AI : Architecture Titans

Le monde de l'intelligence artificielle est en constante évolution, avec des chercheurs travaillant sans relâche pour repousser les limites de ce que l'IA peut accomplir, en particulier avec les grands modèles de langage (LLMs). L'un des principaux obstacles auxquels ces modèles sont confrontés est leur fenêtre de contexte limitée, qui les conduit souvent à "oublier" les parties antérieures d'une conversation ou d'un document. Mais il y a une lueur d'espoir à l'horizon — l'architecture Titans de Google pourrait bien être la solution à ce problème de mémoire courte dans l'IA.

Points clés

- Les modèles d'IA traditionnels peinent souvent avec la mémoire à court terme, ce qui limite leur fenêtre de contexte.

- L'architecture Titans de Google introduit un système de mémoire double pour affronter directement cette limitation.

- Titans utilise des modules de mémoire à court et à long terme pour améliorer les performances.

- La mémoire à long terme de Titans peut gérer des longueurs de contexte de plus de deux millions de jetons.

- Titans permet une mise à l'échelle linéaire, réduisant les coûts computationnels liés à la mise à l'échelle quadratique des transformers.

- L'architecture montre un grand potentiel dans les tâches nécessitant l'analyse de dépendances à longue portée, comme la génomique.

Comprendre les limites de la mémoire à court terme dans l'IA

Le problème de la fenêtre de contexte

L'un des domaines clés où l'IA doit améliorer ses performances est la contrainte de la mémoire à court terme. Dans le monde des modèles d'IA, en particulier les grands modèles de langage (LLMs), cette limitation se manifeste par une fenêtre de contexte finie. Considérez cela comme la capacité d'attention de l'IA — une fois qu'elle est pleine, les informations plus anciennes sont repoussées, rendant difficile pour l'IA de maintenir la cohérence et de comprendre les dépendances à longue portée. Ce goulot d'étranglement de la mémoire à court terme affecte plusieurs applications de l'IA, telles que :

- Conversations prolongées : Maintenir une conversation cohérente sur plusieurs tours devient un défi, car l'IA peut perdre la trace des sujets et références antérieurs.

- Analyse de documents : Traiter des documents longs, comme des livres ou des articles de recherche, est difficile car l'IA peine à se souvenir des informations du début lorsqu'elle arrive à la fin.

- Génération de code : Dans les tâches de codage, l'IA peut oublier les fonctions ou variables définies précédemment, entraînant des erreurs et des inefficacités.

Surmonter cette limitation est crucial pour créer des modèles d'IA plus fiables et capables de gérer des tâches complexes, c'est pourquoi des avancées comme Titans sont si excitantes.

La complexité quadratique de l'auto-attention

Les architectures basées sur les transformers traditionnels, qui alimentent de nombreux LLMs modernes, reposent fortement sur un mécanisme appelé auto-attention. L'auto-attention est révolutionnaire, mais elle entraîne un coût computationnel élevé. En termes mathématiques, l'auto-attention a une complexité quadratique. Cela signifie que les ressources computationnelles nécessaires augmentent de manière quadratique avec la longueur de la séquence d'entrée. Si vous doublez la longueur de l'entrée, le calcul devient quatre fois plus coûteux. Ce problème d'évolutivité devient un obstacle majeur lorsqu'il s'agit de longues séquences.

Par exemple, traiter une séquence de 1 000 jetons peut être gérable, mais passer à 10 000 jetons augmente la charge computationnelle d'un facteur de 100. Cela devient rapidement prohibitif, même avec le matériel le plus puissant. En conséquence, les modèles basés sur les transformers actuels sont souvent limités à des fenêtres de contexte relativement courtes, ce qui entrave leur capacité à capturer efficacement les dépendances à longue portée. L'exploration de nouvelles architectures comme Titans, qui peuvent atténuer cette complexité, est cruciale pour les avancées futures dans l'IA.

Titans : Permettre l'analyse des dépendances à longue portée

Déverrouiller de nouvelles capacités d'IA

La capacité de Titans à gérer des fenêtres de contexte plus longues et à atteindre une mise à l'échelle linéaire ouvre une variété de nouvelles applications d'IA qui étaient auparavant irréalisables. Un domaine notable est l'analyse des dépendances à longue portée, où les relations entre des éléments séparés par de grandes distances dans une séquence sont cruciales.

Quelques exemples d'analyse des dépendances à longue portée incluent :

- Génomique : Comprendre les relations entre les gènes dans un génome. Les gènes peuvent interagir les uns avec les autres même lorsqu'ils sont situés loin sur le brin d'ADN. L'architecture Titans est bien adaptée pour capturer ces relations complexes.

- Modélisation financière : Analyser les tendances et dépendances à long terme sur les marchés financiers. Les données financières présentent souvent des modèles et des boucles de rétroaction à long terme qui nécessitent de prendre en compte des données sur des périodes prolongées.

- Sciences du climat : Modéliser des systèmes climatiques complexes et prédire les changements à long terme. Les modèles climatiques doivent prendre en compte les interactions entre différents composants du système terrestre sur de nombreuses années.

Dans chacun de ces domaines, la capacité à capturer les dépendances à longue portée est essentielle pour faire des prédictions précises et obtenir des informations précieuses. L'architecture Titans fournit un outil puissant pour relever ces défis, permettant à l'IA de s'attaquer à des problèmes auparavant hors de sa portée.

Comment utiliser l'architecture Titans pour le développement d'IA

Tirer parti des systèmes de mémoire doubles

Pour utiliser efficacement l'architecture Titans, les développeurs d'IA doivent comprendre comment tirer parti de son système de mémoire double. Cela implique :

- Conception des données d'entrée : Préparer vos données d'entrée pour maximiser les avantages de la séparation entre mémoire à court et à long terme.

- Équilibrage de l'allocation de mémoire : Considérer soigneusement combien de mémoire allouer aux modules à court et à long terme. Cela dépendra de la tâche spécifique et de la longueur des séquences d'entrée.

- Optimisation de la récupération de mémoire : Ajuster finement le mécanisme de récupération de mémoire pour garantir que les informations pertinentes sont accessibles efficacement depuis le module de mémoire à long terme.

- Adaptation des modèles existants : Adapter les modèles basés sur les transformers existants pour intégrer l'architecture Titans.

- Expérimentation et évaluation : Expérimenter et évaluer minutieusement les performances de votre modèle basé sur Titans sur une variété de tâches.

En maîtrisant ces techniques, les développeurs d'IA peuvent exploiter tout le potentiel de l'architecture Titans et construire des systèmes d'IA plus puissants et performants.

Avantages et inconvénients de l'architecture Titans

Avantages

- Meilleure gestion des dépendances à longue portée.

- Mise à l'échelle linéaire réduisant les coûts computationnels.

- Système de mémoire double imitant le fonctionnement du cerveau humain.

- Potentiel pour de nouvelles applications d'IA.

Inconvénients

- Complexité architecturale accrue.

- Nécessite une allocation et une optimisation minutieuses de la récupération de mémoire.

- Encore à un stade précoce de développement.

Questions fréquemment posées sur l'architecture Titans

Qu'est-ce que l'architecture Titans ?

L'architecture Titans est une nouvelle approche de la gestion de la mémoire dans l'IA développée par Google. Elle utilise un système de mémoire double, composé de modules de mémoire à court et à long terme, pour améliorer la gestion des dépendances à longue portée et réduire les coûts computationnels dans les grands modèles de langage.

En quoi l'architecture Titans diffère-t-elle des transformers traditionnels ?

Les transformers traditionnels reposent sur l'auto-attention, qui a une complexité quadratique et peine avec les longues séquences. L'architecture Titans atteint une mise à l'échelle linéaire en séparant la mémoire à court et à long terme, permettant de gérer des séquences plus longues plus efficacement.

Quelles sont les applications potentielles de l'architecture Titans ?

L'architecture Titans a des applications potentielles dans les domaines nécessitant une analyse des dépendances à longue portée, comme la génomique, la modélisation financière et les sciences du climat. Elle peut également améliorer les performances des modèles d'IA dans les conversations prolongées, l'analyse de documents et la génération de code.

Quels sont les défis de l'utilisation de l'architecture Titans ?

Les défis de l'utilisation de l'architecture Titans incluent sa complexité architecturale accrue, la nécessité d'une allocation et d'une optimisation minutieuses de la récupération de mémoire, et son stade de développement relativement précoce.

Questions connexes sur la mémoire et l'architecture de l'IA

Comment fonctionne le mécanisme d'attention dans les transformers ?

Le mécanisme d'attention est un composant crucial des modèles de transformers, leur permettant de se concentrer sur les parties pertinentes de la séquence d'entrée lors du traitement des informations. En essence, il attribue un poids à chaque mot (ou jeton) dans la séquence d'entrée, indiquant son importance par rapport aux autres mots de la séquence. Examinons comment fonctionne le mécanisme d'attention dans les transformers :

Embarquement d'entrée : Chaque mot ou jeton de la séquence d'entrée est initialement converti en une représentation vectorielle à travers des couches d'embarquement. Ces embarquements servent d'entrée au mécanisme d'attention.

Requête, clé et valeur : Les embarquements d'entrée sont transformés en trois vecteurs distincts : les vecteurs de Requête (Q), Clé (K) et Valeur (V). Ces transformations sont effectuées via des transformations linéaires ou des matrices de poids apprises. Mathématiquement :

(Q = text{Entrée} cdot W_Q)

(K = text{Entrée} cdot W_K)

(V = text{Entrée} cdot W_V)

Ici, (W_Q), (W_K) et (W_V) sont les matrices de poids apprises pour la Requête, la Clé et la Valeur, respectivement.

Calcul des poids d'attention : Les poids d'attention indiquent le degré de pertinence entre chaque paire de mots dans la séquence d'entrée. Ces poids sont calculés en prenant le produit scalaire du vecteur de Requête avec chaque vecteur de Clé. Les scores résultants sont ensuite réduits par la racine carrée de la dimension des vecteurs de Clé pour stabiliser l'entraînement. Cette mise à l'échelle empêche les produits scalaires de devenir excessivement grands, ce qui peut conduire à des gradients évanescents pendant l'entraînement.

Normalisation Softmax : Les produits scalaires mis à l'échelle sont passés à travers une fonction softmax pour les normaliser en une distribution de probabilité sur la séquence d'entrée. Cette normalisation garantit que les poids d'attention s'additionnent à 1, les rendant plus faciles à interpréter et à entraîner.

Somme pondérée : Enfin, les vecteurs de Valeur sont pondérés par leurs poids d'attention correspondants. Cette somme pondérée représente la sortie du mécanisme d'attention, qui capture les informations pertinentes de l'ensemble de la séquence d'entrée.

Le mécanisme d'attention permet aux transformers de gérer efficacement les données séquentielles, de capturer les dépendances à longue portée et d'atteindre des performances de pointe dans diverses tâches de traitement du langage naturel. En pondérant dynamiquement l'importance des différentes parties de la séquence d'entrée, le mécanisme d'attention permet au modèle de se concentrer sur les informations les plus pertinentes, conduisant à des performances améliorées.

Article connexe

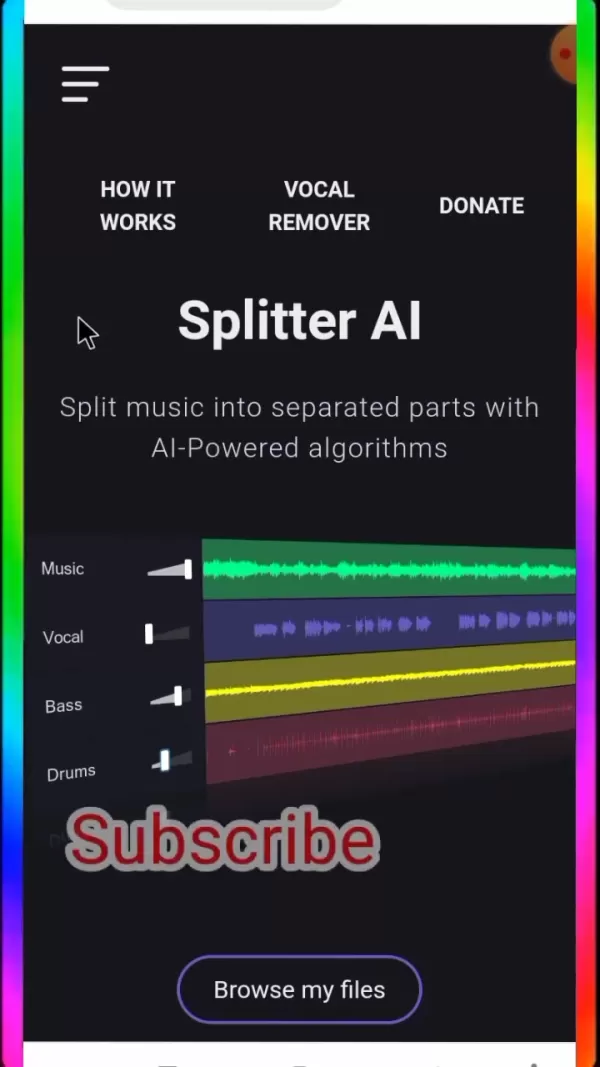

Guide ultime pour l'isolation des pistes vocales et musicales avec Splitter AI

Pour les mélomanes, les artistes en herbe et les professionnels de l'audio, Splitter AI offre des capacités révolutionnaires qui transforment la façon dont vous travaillez avec le son. Cette explorati

Guide ultime pour l'isolation des pistes vocales et musicales avec Splitter AI

Pour les mélomanes, les artistes en herbe et les professionnels de l'audio, Splitter AI offre des capacités révolutionnaires qui transforment la façon dont vous travaillez avec le son. Cette explorati

OpenAI corrige le bogue de l'excès de politesse de ChatGPT et explique la faille de l'IA

OpenAI a annulé un ajustement récent de la personnalité de son modèle phare GPT-4o après l'apparition de nombreux rapports indiquant que le système d'IA faisait preuve d'une agréabilité excessive, y c

OpenAI corrige le bogue de l'excès de politesse de ChatGPT et explique la faille de l'IA

OpenAI a annulé un ajustement récent de la personnalité de son modèle phare GPT-4o après l'apparition de nombreux rapports indiquant que le système d'IA faisait preuve d'une agréabilité excessive, y c

Piclumen AI propose la création gratuite d'œuvres d'art par l'IA en 2025

Dans le monde en pleine mutation de la création de contenu numérique, Piclumen AI s'impose comme une solution entièrement gratuite de génération d'images par l'IA. Cette plateforme innovante permet au

commentaires (4)

0/200

Piclumen AI propose la création gratuite d'œuvres d'art par l'IA en 2025

Dans le monde en pleine mutation de la création de contenu numérique, Piclumen AI s'impose comme une solution entièrement gratuite de génération d'images par l'IA. Cette plateforme innovante permet au

commentaires (4)

0/200

![JoseDavis]() JoseDavis

JoseDavis

10 septembre 2025 04:30:37 UTC+02:00

10 septembre 2025 04:30:37 UTC+02:00

Cette histoire de 'mémoire' des IA me fait toujours sourire. Quand mon chat oublie où il a caché ses jouets, c'est mignon. Quand une IA oublie ce qu'elle vient de lire, ça coûte des millions en R&D... Ironique, non? 😅

0

0

![BenLewis]() BenLewis

BenLewis

10 août 2025 15:00:59 UTC+02:00

10 août 2025 15:00:59 UTC+02:00

This Titans Architecture sounds like a game-changer for AI memory! 🤯 Curious if it'll really solve the context window issue or just hype. Anyone tried it yet?

0

0

![WillieAdams]() WillieAdams

WillieAdams

1 août 2025 15:47:34 UTC+02:00

1 août 2025 15:47:34 UTC+02:00

Wow, this Titans Architecture sounds like a game-changer for AI memory! Can't wait to see how it tackles the context window issue. 🤯

0

0

![LiamCarter]() LiamCarter

LiamCarter

22 juillet 2025 09:35:51 UTC+02:00

22 juillet 2025 09:35:51 UTC+02:00

Wow, this Titans Architecture sounds like a game-changer for AI memory! I'm curious how it'll handle massive datasets without forgetting the plot. 😄 Could this finally make LLMs smarter than my goldfish?

0

0

Le monde de l'intelligence artificielle est en constante évolution, avec des chercheurs travaillant sans relâche pour repousser les limites de ce que l'IA peut accomplir, en particulier avec les grands modèles de langage (LLMs). L'un des principaux obstacles auxquels ces modèles sont confrontés est leur fenêtre de contexte limitée, qui les conduit souvent à "oublier" les parties antérieures d'une conversation ou d'un document. Mais il y a une lueur d'espoir à l'horizon — l'architecture Titans de Google pourrait bien être la solution à ce problème de mémoire courte dans l'IA.

Points clés

- Les modèles d'IA traditionnels peinent souvent avec la mémoire à court terme, ce qui limite leur fenêtre de contexte.

- L'architecture Titans de Google introduit un système de mémoire double pour affronter directement cette limitation.

- Titans utilise des modules de mémoire à court et à long terme pour améliorer les performances.

- La mémoire à long terme de Titans peut gérer des longueurs de contexte de plus de deux millions de jetons.

- Titans permet une mise à l'échelle linéaire, réduisant les coûts computationnels liés à la mise à l'échelle quadratique des transformers.

- L'architecture montre un grand potentiel dans les tâches nécessitant l'analyse de dépendances à longue portée, comme la génomique.

Comprendre les limites de la mémoire à court terme dans l'IA

Le problème de la fenêtre de contexte

L'un des domaines clés où l'IA doit améliorer ses performances est la contrainte de la mémoire à court terme. Dans le monde des modèles d'IA, en particulier les grands modèles de langage (LLMs), cette limitation se manifeste par une fenêtre de contexte finie. Considérez cela comme la capacité d'attention de l'IA — une fois qu'elle est pleine, les informations plus anciennes sont repoussées, rendant difficile pour l'IA de maintenir la cohérence et de comprendre les dépendances à longue portée. Ce goulot d'étranglement de la mémoire à court terme affecte plusieurs applications de l'IA, telles que :

- Conversations prolongées : Maintenir une conversation cohérente sur plusieurs tours devient un défi, car l'IA peut perdre la trace des sujets et références antérieurs.

- Analyse de documents : Traiter des documents longs, comme des livres ou des articles de recherche, est difficile car l'IA peine à se souvenir des informations du début lorsqu'elle arrive à la fin.

- Génération de code : Dans les tâches de codage, l'IA peut oublier les fonctions ou variables définies précédemment, entraînant des erreurs et des inefficacités.

Surmonter cette limitation est crucial pour créer des modèles d'IA plus fiables et capables de gérer des tâches complexes, c'est pourquoi des avancées comme Titans sont si excitantes.

La complexité quadratique de l'auto-attention

Les architectures basées sur les transformers traditionnels, qui alimentent de nombreux LLMs modernes, reposent fortement sur un mécanisme appelé auto-attention. L'auto-attention est révolutionnaire, mais elle entraîne un coût computationnel élevé. En termes mathématiques, l'auto-attention a une complexité quadratique. Cela signifie que les ressources computationnelles nécessaires augmentent de manière quadratique avec la longueur de la séquence d'entrée. Si vous doublez la longueur de l'entrée, le calcul devient quatre fois plus coûteux. Ce problème d'évolutivité devient un obstacle majeur lorsqu'il s'agit de longues séquences.

Par exemple, traiter une séquence de 1 000 jetons peut être gérable, mais passer à 10 000 jetons augmente la charge computationnelle d'un facteur de 100. Cela devient rapidement prohibitif, même avec le matériel le plus puissant. En conséquence, les modèles basés sur les transformers actuels sont souvent limités à des fenêtres de contexte relativement courtes, ce qui entrave leur capacité à capturer efficacement les dépendances à longue portée. L'exploration de nouvelles architectures comme Titans, qui peuvent atténuer cette complexité, est cruciale pour les avancées futures dans l'IA.

Titans : Permettre l'analyse des dépendances à longue portée

Déverrouiller de nouvelles capacités d'IA

La capacité de Titans à gérer des fenêtres de contexte plus longues et à atteindre une mise à l'échelle linéaire ouvre une variété de nouvelles applications d'IA qui étaient auparavant irréalisables. Un domaine notable est l'analyse des dépendances à longue portée, où les relations entre des éléments séparés par de grandes distances dans une séquence sont cruciales.

Quelques exemples d'analyse des dépendances à longue portée incluent :

- Génomique : Comprendre les relations entre les gènes dans un génome. Les gènes peuvent interagir les uns avec les autres même lorsqu'ils sont situés loin sur le brin d'ADN. L'architecture Titans est bien adaptée pour capturer ces relations complexes.

- Modélisation financière : Analyser les tendances et dépendances à long terme sur les marchés financiers. Les données financières présentent souvent des modèles et des boucles de rétroaction à long terme qui nécessitent de prendre en compte des données sur des périodes prolongées.

- Sciences du climat : Modéliser des systèmes climatiques complexes et prédire les changements à long terme. Les modèles climatiques doivent prendre en compte les interactions entre différents composants du système terrestre sur de nombreuses années.

Dans chacun de ces domaines, la capacité à capturer les dépendances à longue portée est essentielle pour faire des prédictions précises et obtenir des informations précieuses. L'architecture Titans fournit un outil puissant pour relever ces défis, permettant à l'IA de s'attaquer à des problèmes auparavant hors de sa portée.

Comment utiliser l'architecture Titans pour le développement d'IA

Tirer parti des systèmes de mémoire doubles

Pour utiliser efficacement l'architecture Titans, les développeurs d'IA doivent comprendre comment tirer parti de son système de mémoire double. Cela implique :

- Conception des données d'entrée : Préparer vos données d'entrée pour maximiser les avantages de la séparation entre mémoire à court et à long terme.

- Équilibrage de l'allocation de mémoire : Considérer soigneusement combien de mémoire allouer aux modules à court et à long terme. Cela dépendra de la tâche spécifique et de la longueur des séquences d'entrée.

- Optimisation de la récupération de mémoire : Ajuster finement le mécanisme de récupération de mémoire pour garantir que les informations pertinentes sont accessibles efficacement depuis le module de mémoire à long terme.

- Adaptation des modèles existants : Adapter les modèles basés sur les transformers existants pour intégrer l'architecture Titans.

- Expérimentation et évaluation : Expérimenter et évaluer minutieusement les performances de votre modèle basé sur Titans sur une variété de tâches.

En maîtrisant ces techniques, les développeurs d'IA peuvent exploiter tout le potentiel de l'architecture Titans et construire des systèmes d'IA plus puissants et performants.

Avantages et inconvénients de l'architecture Titans

Avantages

- Meilleure gestion des dépendances à longue portée.

- Mise à l'échelle linéaire réduisant les coûts computationnels.

- Système de mémoire double imitant le fonctionnement du cerveau humain.

- Potentiel pour de nouvelles applications d'IA.

Inconvénients

- Complexité architecturale accrue.

- Nécessite une allocation et une optimisation minutieuses de la récupération de mémoire.

- Encore à un stade précoce de développement.

Questions fréquemment posées sur l'architecture Titans

Qu'est-ce que l'architecture Titans ?

L'architecture Titans est une nouvelle approche de la gestion de la mémoire dans l'IA développée par Google. Elle utilise un système de mémoire double, composé de modules de mémoire à court et à long terme, pour améliorer la gestion des dépendances à longue portée et réduire les coûts computationnels dans les grands modèles de langage.

En quoi l'architecture Titans diffère-t-elle des transformers traditionnels ?

Les transformers traditionnels reposent sur l'auto-attention, qui a une complexité quadratique et peine avec les longues séquences. L'architecture Titans atteint une mise à l'échelle linéaire en séparant la mémoire à court et à long terme, permettant de gérer des séquences plus longues plus efficacement.

Quelles sont les applications potentielles de l'architecture Titans ?

L'architecture Titans a des applications potentielles dans les domaines nécessitant une analyse des dépendances à longue portée, comme la génomique, la modélisation financière et les sciences du climat. Elle peut également améliorer les performances des modèles d'IA dans les conversations prolongées, l'analyse de documents et la génération de code.

Quels sont les défis de l'utilisation de l'architecture Titans ?

Les défis de l'utilisation de l'architecture Titans incluent sa complexité architecturale accrue, la nécessité d'une allocation et d'une optimisation minutieuses de la récupération de mémoire, et son stade de développement relativement précoce.

Questions connexes sur la mémoire et l'architecture de l'IA

Comment fonctionne le mécanisme d'attention dans les transformers ?

Le mécanisme d'attention est un composant crucial des modèles de transformers, leur permettant de se concentrer sur les parties pertinentes de la séquence d'entrée lors du traitement des informations. En essence, il attribue un poids à chaque mot (ou jeton) dans la séquence d'entrée, indiquant son importance par rapport aux autres mots de la séquence. Examinons comment fonctionne le mécanisme d'attention dans les transformers :

Embarquement d'entrée : Chaque mot ou jeton de la séquence d'entrée est initialement converti en une représentation vectorielle à travers des couches d'embarquement. Ces embarquements servent d'entrée au mécanisme d'attention.

Requête, clé et valeur : Les embarquements d'entrée sont transformés en trois vecteurs distincts : les vecteurs de Requête (Q), Clé (K) et Valeur (V). Ces transformations sont effectuées via des transformations linéaires ou des matrices de poids apprises. Mathématiquement :

(Q = text{Entrée} cdot W_Q)

(K = text{Entrée} cdot W_K)

(V = text{Entrée} cdot W_V)

Ici, (W_Q), (W_K) et (W_V) sont les matrices de poids apprises pour la Requête, la Clé et la Valeur, respectivement.

Calcul des poids d'attention : Les poids d'attention indiquent le degré de pertinence entre chaque paire de mots dans la séquence d'entrée. Ces poids sont calculés en prenant le produit scalaire du vecteur de Requête avec chaque vecteur de Clé. Les scores résultants sont ensuite réduits par la racine carrée de la dimension des vecteurs de Clé pour stabiliser l'entraînement. Cette mise à l'échelle empêche les produits scalaires de devenir excessivement grands, ce qui peut conduire à des gradients évanescents pendant l'entraînement.

Normalisation Softmax : Les produits scalaires mis à l'échelle sont passés à travers une fonction softmax pour les normaliser en une distribution de probabilité sur la séquence d'entrée. Cette normalisation garantit que les poids d'attention s'additionnent à 1, les rendant plus faciles à interpréter et à entraîner.

Somme pondérée : Enfin, les vecteurs de Valeur sont pondérés par leurs poids d'attention correspondants. Cette somme pondérée représente la sortie du mécanisme d'attention, qui capture les informations pertinentes de l'ensemble de la séquence d'entrée.

Le mécanisme d'attention permet aux transformers de gérer efficacement les données séquentielles, de capturer les dépendances à longue portée et d'atteindre des performances de pointe dans diverses tâches de traitement du langage naturel. En pondérant dynamiquement l'importance des différentes parties de la séquence d'entrée, le mécanisme d'attention permet au modèle de se concentrer sur les informations les plus pertinentes, conduisant à des performances améliorées.

Guide ultime pour l'isolation des pistes vocales et musicales avec Splitter AI

Pour les mélomanes, les artistes en herbe et les professionnels de l'audio, Splitter AI offre des capacités révolutionnaires qui transforment la façon dont vous travaillez avec le son. Cette explorati

Guide ultime pour l'isolation des pistes vocales et musicales avec Splitter AI

Pour les mélomanes, les artistes en herbe et les professionnels de l'audio, Splitter AI offre des capacités révolutionnaires qui transforment la façon dont vous travaillez avec le son. Cette explorati

OpenAI corrige le bogue de l'excès de politesse de ChatGPT et explique la faille de l'IA

OpenAI a annulé un ajustement récent de la personnalité de son modèle phare GPT-4o après l'apparition de nombreux rapports indiquant que le système d'IA faisait preuve d'une agréabilité excessive, y c

OpenAI corrige le bogue de l'excès de politesse de ChatGPT et explique la faille de l'IA

OpenAI a annulé un ajustement récent de la personnalité de son modèle phare GPT-4o après l'apparition de nombreux rapports indiquant que le système d'IA faisait preuve d'une agréabilité excessive, y c

Piclumen AI propose la création gratuite d'œuvres d'art par l'IA en 2025

Dans le monde en pleine mutation de la création de contenu numérique, Piclumen AI s'impose comme une solution entièrement gratuite de génération d'images par l'IA. Cette plateforme innovante permet au

Piclumen AI propose la création gratuite d'œuvres d'art par l'IA en 2025

Dans le monde en pleine mutation de la création de contenu numérique, Piclumen AI s'impose comme une solution entièrement gratuite de génération d'images par l'IA. Cette plateforme innovante permet au

10 septembre 2025 04:30:37 UTC+02:00

10 septembre 2025 04:30:37 UTC+02:00

Cette histoire de 'mémoire' des IA me fait toujours sourire. Quand mon chat oublie où il a caché ses jouets, c'est mignon. Quand une IA oublie ce qu'elle vient de lire, ça coûte des millions en R&D... Ironique, non? 😅

0

0

10 août 2025 15:00:59 UTC+02:00

10 août 2025 15:00:59 UTC+02:00

This Titans Architecture sounds like a game-changer for AI memory! 🤯 Curious if it'll really solve the context window issue or just hype. Anyone tried it yet?

0

0

1 août 2025 15:47:34 UTC+02:00

1 août 2025 15:47:34 UTC+02:00

Wow, this Titans Architecture sounds like a game-changer for AI memory! Can't wait to see how it tackles the context window issue. 🤯

0

0

22 juillet 2025 09:35:51 UTC+02:00

22 juillet 2025 09:35:51 UTC+02:00

Wow, this Titans Architecture sounds like a game-changer for AI memory! I'm curious how it'll handle massive datasets without forgetting the plot. 😄 Could this finally make LLMs smarter than my goldfish?

0

0