AIメモリ技術のブレークスルー:タイタンアーキテクチャ

人工知能の世界は常に進化を続けており、研究者たちは特に大規模言語モデル(LLMs)の可能性を広げるためにたゆまぬ努力を重ねています。これらのモデルが直面する最大の課題の一つは、コンテキストウィンドウの制限であり、これにより会話や文書の初期部分を「忘れる」ことがよくあります。しかし、希望の光が見えてきています—GoogleのTitansアーキテクチャは、AIのこの短期記憶の問題に対する解決策となる可能性があります。

主なポイント

- 従来のAIモデルは、短期記憶の制約によりコンテキストウィンドウが限定されることが多いです。

- GoogleのTitansアーキテクチャは、この制約に正面から取り組むためにデュアルメモリシステムを導入しています。

- Titansは、短期および長期記憶モジュールを使用してパフォーマンスを向上させます。

- Titansの長期記憶は、200万トークンを超えるコンテキスト長を処理できます。

- Titansは線形スケーリングを可能にし、トランスフォーマーの二次スケーリングに関連する計算コストを削減します。

- このアーキテクチャは、ゲノミクスなどの長距離依存関係の分析が必要なタスクで大きな可能性を示しています。

AIの短期記憶の限界を理解する

コンテキストウィンドウの問題

AIが改善すべき主要な領域の一つは、短期記憶の制約です。AIモデル、特に大規模言語モデル(LLMs)では、この制限は有限のコンテキストウィンドウとして現れます。これはAIの注意力の範囲と考えてください—一度それがいっぱいになると、古い情報が押し出され、AIが一貫性を保ったり、長距離依存関係を理解することが難しくなります。この短期記憶のボトルネックは、以下のようなAIアプリケーションに影響を与えます:

- 長時間の会話: 多くのターンにわたって会話を一貫して続けることは、AIが初期のトピックや参照を追跡できなくなるため、難しくなります。

- 文書分析: 本や研究論文のような長い文書を処理するのは、AIが文末に達するまでに冒頭の情報を覚えているのが難しいため、困難です。

- コード生成: コーディングタスクでは、AIが以前に定義された関数や変数を忘れることがあり、エラーや非効率を引き起こします。

この制限を克服することは、より信頼性が高く複雑なタスクを処理できるAIモデルを作成するために重要であり、Titansのような進歩が非常に注目される理由です。

自己注意の二次的複雑さ

多くの現代のLLMsを支える従来のトランスフォーマーベースのアーキテクチャは、自己注意と呼ばれるメカニズムに大きく依存しています。自己注意は革新的ですが、計算コストが非常に高くなります。数学的には、自己注意は二次的複雑さを持っています。これは、入力シーケンスの長さに応じて必要な計算リソースが二次的に増加することを意味します。入力の長さを2倍にすると、計算は4倍高価になります。このスケーリング問題は、長いシーケンスを扱う際に大きな障害となります。

たとえば、1,000トークンのシーケンスの処理は管理可能かもしれませんが、これを10,000トークンにスケーリングすると、計算負担が100倍に増加します。これは、最も強力なハードウェアでもすぐに制約となります。その結果、現在のトランスフォーマーベースのモデルは比較的短いコンテキストウィンドウに制限され、長距離依存関係を効果的に捉える能力が妨げられています。Titansのような新しいアーキテクチャの探求は、この複雑さを軽減するために重要であり、AIの将来の進歩に不可欠です。

Titans:長距離依存関係分析を可能にする

新しいAI機能の解放

Titansがより長いコンテキストウィンドウを処理し、線形スケーリングを実現する能力は、以前は現実的でなかったさまざまな新しいAIアプリケーションを開拓します。特に注目すべきは、シーケンス内で大きな距離で分離された要素間の関係が重要な長距離依存関係分析です。

長距離依存関係分析の例には以下が含まれます:

- ゲノミクス: ゲノム内の遺伝子間の関係を理解する。遺伝子はDNA鎖上で遠く離れていても相互作用することがあります。Titansアーキテクチャは、これらの複雑な関係を捉えるのに適しています。

- 金融モデリング: 金融市場の長期的なトレンドと依存関係の分析。金融データは、長期的なパターンやフィードバックループを示すことが多く、長期にわたるデータを考慮する必要があります。

- 気候科学: 複雑な気候システムのモデリングと長期的な変化の予測。気候モデルは、地球システムの異なるコンポーネント間の長年にわたる相互作用を考慮する必要があります。

これらの各領域において、長距離依存関係を捉える能力は、正確な予測を行い、価値ある洞察を得るために不可欠です。Titansアーキテクチャは、これらの課題に対処するための強力なツールを提供し、AIがこれまで手の届かなかった問題に取り組むことを可能にします。

TitansアーキテクチャをAI開発に活用する方法

デュアルメモリシステムの活用

Titansアーキテクチャを効果的に活用するには、AI開発者はそのデュアルメモリシステムをどのように活用するかを理解する必要があります。これには以下が含まれます:

- 入力データの設計: 短期および長期記憶の分離の利点を最大化するように入力データを準備します。

- メモリ割り当てのバランス: 短期および長期モジュールに割り当てるメモリの量を慎重に検討します。これは、特定のタスクと入力シーケンスの長さに依存します。

- メモリ取得の最適化: 関連情報が長期記憶モジュールから効率的にアクセスされるように、メモリ取得メカニズムを微調整します。

- 既存モデルの適応: 既存のトランスフォーマーベースのモデルをTitansアーキテクチャに組み込むように適応させます。

- 実験と評価: Titansベースのモデルのパフォーマンスをさまざまなタスクで徹底的に実験し、評価します。

これらの技術を習得することで、AI開発者はTitansアーキテクチャの可能性を最大限に引き出し、より強力で有能なAIシステムを構築できます。

Titansアーキテクチャの長所と短所

長所

- 長距離依存関係の処理が向上します。

- 線形スケーリングにより計算コストが削減されます。

- デュアルメモリシステムは人間の脳機能を模倣します。

- 新しいAIアプリケーションの可能性があります。

短所

- アーキテクチャの複雑さが増します。

- メモリ割り当てと取得の最適化が慎重に必要です。

- まだ開発の初期段階にあります。

Titansアーキテクチャに関するよくある質問

Titansアーキテクチャとは何ですか?

Titansアーキテクチャは、Googleが開発したAIメモリ管理の新しいアプローチです。短期および長期記憶モジュールからなるデュアルメモリシステムを利用して、長距離依存関係の処理を改善し、大規模言語モデルの計算コストを削減します。

Titansアーキテクチャは従来のトランスフォーマーとどう異なりますか?

従来のトランスフォーマーは自己注意に依存しており、二次的複雑さを持ち、長いシーケンスに苦労します。Titansアーキテクチャは、短期と長期記憶を分離することで線形スケーリングを実現し、より長いシーケンスを効率的に処理できます。

Titansアーキテクチャの潜在的なアプリケーションは何ですか?

Titansアーキテクチャは、ゲノミクス、金融モデリング、気候科学など、長距離依存関係分析が必要な領域で潜在的なアプリケーションがあります。また、長い会話、文書分析、コード生成でのAIモデルのパフォーマンスを向上させることもできます。

Titansアーキテクチャを使用する際の課題は何ですか?

Titansアーキテクチャを使用する際の課題には、アーキテクチャの複雑さの増加、メモリ割り当てと取得の最適化の必要性、そしてその比較的初期の開発段階が含まれます。

AIメモリとアーキテクチャに関する関連質問

トランスフォーマーの注意メカニズムはどのように機能しますか?

注意メカニズムは、トランスフォーマーモデルの重要な構成要素であり、情報を処理する際に入力シーケンスの関連部分に焦点を当てることを可能にします。本質的に、入力シーケンスの各単語(またはトークン)に重みを割り当て、シーケンス内の他の単語に対するその重要性を示します。トランスフォーマー内での注意メカニズムの機能について詳しく見ていきましょう:

入力埋め込み: 入力シーケンスの各単語またはトークンは、最初に埋め込み層を通じてベクトル表現に変換されます。これらの埋め込みは、注意メカニズムの入力として機能します。

クエリ、キー、バリュー: 入力埋め込みは、クエリ(Q)、キー(K)、バリュー(V)の3つの異なるベクトルに変換されます。これらの変換は、線形変換または学習された重み行列を通じて行われます。数学的には:

(Q = text{入力} cdot W_Q)

(K = text{入力} cdot W_K)

(V = text{入力} cdot W_V)

ここで、(W_Q)、(W_K)、(W_V)は、それぞれクエリ、キー、バリューの学習された重み行列です。

注意重みの計算: 注意重みは、入力シーケンス内の各単語のペア間の関連性の度合いを示します。これらの重みは、クエリベクトルと各キーベクトルのドット積を取ることで計算されます。結果として得られるスコアは、トレーニングを安定させるためにキーベクトルの次元の平方根でスケーリングされます。このスケーリングは、ドット積が過度に大きくなるのを防ぎ、トレーニング中に勾配が消失するのを防ぎます。

ソフトマックス正規化: スケーリングされたドット積は、ソフトマックス関数を通じて渡され、入力シーケンス上の確率分布に正規化されます。この正規化により、注意重みが1に合計され、解釈やトレーニングが容易になります。

重み付き和: 最後に、バリューベクトルは対応する注意重みによって重み付けされます。この重み付き和は、注意メカニズムの出力であり、入力シーケンス全体から関連情報を捉えます。

注意メカニズムは、トランスフォーマーがシーケンシャルデータを効果的に処理し、長距離依存関係を捉え、さまざまなNLPタスクで最先端のパフォーマンスを達成することを可能にします。入力シーケンスの異なる部分の重要性を動的に重み付けすることで、注意メカニズムはモデルが最も関連性の高い情報に焦点を当て、パフォーマンスを向上させます。

関連記事

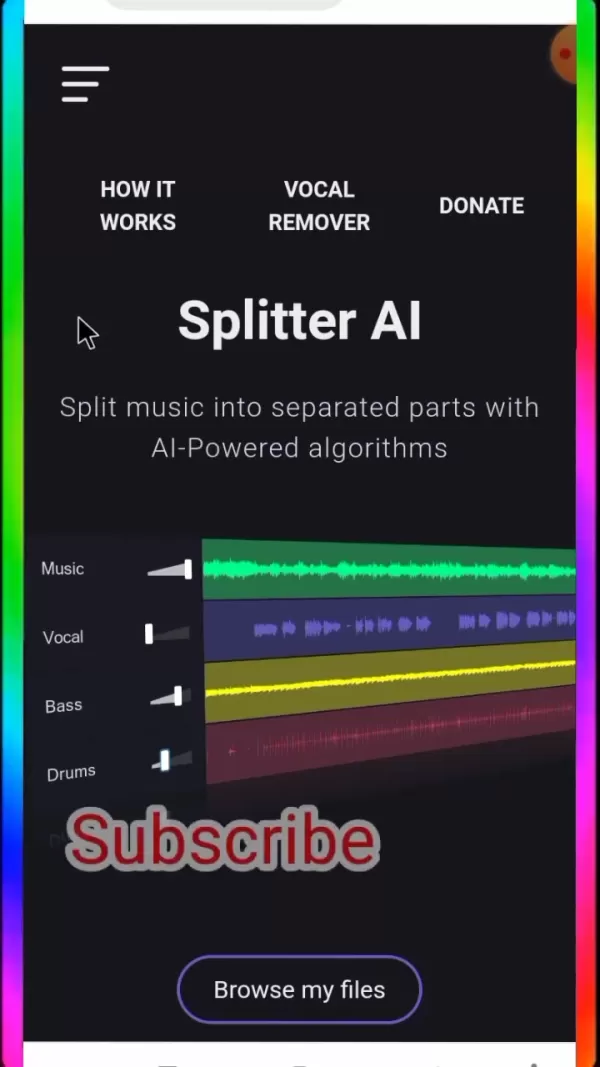

スプリッターAIによるボーカルと音楽のトラック・アイソレーションの究極ガイド

音楽愛好家、アーティスト志望者、そしてオーディオ・プロフェッショナルにとって、Splitter AIはサウンドの扱い方を一変させる画期的な機能を提供します。この徹底的な探求により、この人工知能プラットフォームがどのようにフルトラックを個々のコンポーネントに分解できるかが明らかになり、作曲を分析する学生からリミックスを制作するプロデューサーまで、すべての人に前例のない創造的な機会を提供します。この強

スプリッターAIによるボーカルと音楽のトラック・アイソレーションの究極ガイド

音楽愛好家、アーティスト志望者、そしてオーディオ・プロフェッショナルにとって、Splitter AIはサウンドの扱い方を一変させる画期的な機能を提供します。この徹底的な探求により、この人工知能プラットフォームがどのようにフルトラックを個々のコンポーネントに分解できるかが明らかになり、作曲を分析する学生からリミックスを制作するプロデューサーまで、すべての人に前例のない創造的な機会を提供します。この強

OpenAIがChatGPTの礼儀正しすぎるバグを修正、AIの欠陥を説明

OpenAIは、AIシステムが危険で不合理なユーザーの提案を不当に賞賛するなど、過剰な好意性を示すという報告が広まったことを受け、同社の主力モデルGPT-4oの最近の性格調整を取り消した。会話モデルにおける「AIのお人好し」の出現について、AIの安全性の専門家の間で懸念が高まっていることを受け、今回の緊急ロールバックが行われた。背景問題のあるアップデートオープンAIは4月29日の声明で、GPT-4

OpenAIがChatGPTの礼儀正しすぎるバグを修正、AIの欠陥を説明

OpenAIは、AIシステムが危険で不合理なユーザーの提案を不当に賞賛するなど、過剰な好意性を示すという報告が広まったことを受け、同社の主力モデルGPT-4oの最近の性格調整を取り消した。会話モデルにおける「AIのお人好し」の出現について、AIの安全性の専門家の間で懸念が高まっていることを受け、今回の緊急ロールバックが行われた。背景問題のあるアップデートオープンAIは4月29日の声明で、GPT-4

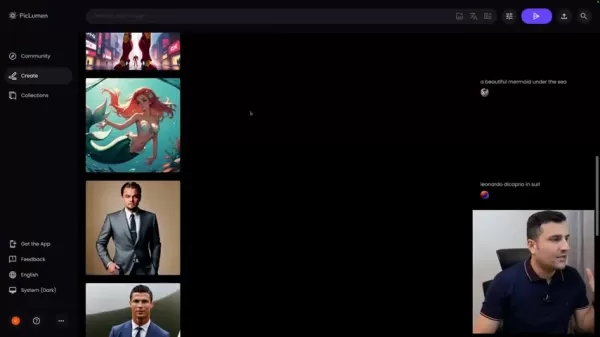

Piclumen AI、2025年にAIアート制作を無償提供

急速に変化するデジタルコンテンツ制作の世界において、Piclumen AIはAIを活用した画像生成のための完全無料のソリューションとして傑出している。この革新的なプラットフォームにより、ユーザーは経済的な障壁なしにプロ品質のビジュアルを作成することができ、洗練されたAIツールを誰でも利用できるようになります。この包括的なガイドでは、Piclumen AIの能力を調査し、プレミアムな代替製品との比較

コメント (4)

0/200

Piclumen AI、2025年にAIアート制作を無償提供

急速に変化するデジタルコンテンツ制作の世界において、Piclumen AIはAIを活用した画像生成のための完全無料のソリューションとして傑出している。この革新的なプラットフォームにより、ユーザーは経済的な障壁なしにプロ品質のビジュアルを作成することができ、洗練されたAIツールを誰でも利用できるようになります。この包括的なガイドでは、Piclumen AIの能力を調査し、プレミアムな代替製品との比較

コメント (4)

0/200

![JoseDavis]() JoseDavis

JoseDavis

2025年9月10日 11:30:37 JST

2025年9月10日 11:30:37 JST

Cette histoire de 'mémoire' des IA me fait toujours sourire. Quand mon chat oublie où il a caché ses jouets, c'est mignon. Quand une IA oublie ce qu'elle vient de lire, ça coûte des millions en R&D... Ironique, non? 😅

0

0

![BenLewis]() BenLewis

BenLewis

2025年8月10日 22:00:59 JST

2025年8月10日 22:00:59 JST

This Titans Architecture sounds like a game-changer for AI memory! 🤯 Curious if it'll really solve the context window issue or just hype. Anyone tried it yet?

0

0

![WillieAdams]() WillieAdams

WillieAdams

2025年8月1日 22:47:34 JST

2025年8月1日 22:47:34 JST

Wow, this Titans Architecture sounds like a game-changer for AI memory! Can't wait to see how it tackles the context window issue. 🤯

0

0

![LiamCarter]() LiamCarter

LiamCarter

2025年7月22日 16:35:51 JST

2025年7月22日 16:35:51 JST

Wow, this Titans Architecture sounds like a game-changer for AI memory! I'm curious how it'll handle massive datasets without forgetting the plot. 😄 Could this finally make LLMs smarter than my goldfish?

0

0

人工知能の世界は常に進化を続けており、研究者たちは特に大規模言語モデル(LLMs)の可能性を広げるためにたゆまぬ努力を重ねています。これらのモデルが直面する最大の課題の一つは、コンテキストウィンドウの制限であり、これにより会話や文書の初期部分を「忘れる」ことがよくあります。しかし、希望の光が見えてきています—GoogleのTitansアーキテクチャは、AIのこの短期記憶の問題に対する解決策となる可能性があります。

主なポイント

- 従来のAIモデルは、短期記憶の制約によりコンテキストウィンドウが限定されることが多いです。

- GoogleのTitansアーキテクチャは、この制約に正面から取り組むためにデュアルメモリシステムを導入しています。

- Titansは、短期および長期記憶モジュールを使用してパフォーマンスを向上させます。

- Titansの長期記憶は、200万トークンを超えるコンテキスト長を処理できます。

- Titansは線形スケーリングを可能にし、トランスフォーマーの二次スケーリングに関連する計算コストを削減します。

- このアーキテクチャは、ゲノミクスなどの長距離依存関係の分析が必要なタスクで大きな可能性を示しています。

AIの短期記憶の限界を理解する

コンテキストウィンドウの問題

AIが改善すべき主要な領域の一つは、短期記憶の制約です。AIモデル、特に大規模言語モデル(LLMs)では、この制限は有限のコンテキストウィンドウとして現れます。これはAIの注意力の範囲と考えてください—一度それがいっぱいになると、古い情報が押し出され、AIが一貫性を保ったり、長距離依存関係を理解することが難しくなります。この短期記憶のボトルネックは、以下のようなAIアプリケーションに影響を与えます:

- 長時間の会話: 多くのターンにわたって会話を一貫して続けることは、AIが初期のトピックや参照を追跡できなくなるため、難しくなります。

- 文書分析: 本や研究論文のような長い文書を処理するのは、AIが文末に達するまでに冒頭の情報を覚えているのが難しいため、困難です。

- コード生成: コーディングタスクでは、AIが以前に定義された関数や変数を忘れることがあり、エラーや非効率を引き起こします。

この制限を克服することは、より信頼性が高く複雑なタスクを処理できるAIモデルを作成するために重要であり、Titansのような進歩が非常に注目される理由です。

自己注意の二次的複雑さ

多くの現代のLLMsを支える従来のトランスフォーマーベースのアーキテクチャは、自己注意と呼ばれるメカニズムに大きく依存しています。自己注意は革新的ですが、計算コストが非常に高くなります。数学的には、自己注意は二次的複雑さを持っています。これは、入力シーケンスの長さに応じて必要な計算リソースが二次的に増加することを意味します。入力の長さを2倍にすると、計算は4倍高価になります。このスケーリング問題は、長いシーケンスを扱う際に大きな障害となります。

たとえば、1,000トークンのシーケンスの処理は管理可能かもしれませんが、これを10,000トークンにスケーリングすると、計算負担が100倍に増加します。これは、最も強力なハードウェアでもすぐに制約となります。その結果、現在のトランスフォーマーベースのモデルは比較的短いコンテキストウィンドウに制限され、長距離依存関係を効果的に捉える能力が妨げられています。Titansのような新しいアーキテクチャの探求は、この複雑さを軽減するために重要であり、AIの将来の進歩に不可欠です。

Titans:長距離依存関係分析を可能にする

新しいAI機能の解放

Titansがより長いコンテキストウィンドウを処理し、線形スケーリングを実現する能力は、以前は現実的でなかったさまざまな新しいAIアプリケーションを開拓します。特に注目すべきは、シーケンス内で大きな距離で分離された要素間の関係が重要な長距離依存関係分析です。

長距離依存関係分析の例には以下が含まれます:

- ゲノミクス: ゲノム内の遺伝子間の関係を理解する。遺伝子はDNA鎖上で遠く離れていても相互作用することがあります。Titansアーキテクチャは、これらの複雑な関係を捉えるのに適しています。

- 金融モデリング: 金融市場の長期的なトレンドと依存関係の分析。金融データは、長期的なパターンやフィードバックループを示すことが多く、長期にわたるデータを考慮する必要があります。

- 気候科学: 複雑な気候システムのモデリングと長期的な変化の予測。気候モデルは、地球システムの異なるコンポーネント間の長年にわたる相互作用を考慮する必要があります。

これらの各領域において、長距離依存関係を捉える能力は、正確な予測を行い、価値ある洞察を得るために不可欠です。Titansアーキテクチャは、これらの課題に対処するための強力なツールを提供し、AIがこれまで手の届かなかった問題に取り組むことを可能にします。

TitansアーキテクチャをAI開発に活用する方法

デュアルメモリシステムの活用

Titansアーキテクチャを効果的に活用するには、AI開発者はそのデュアルメモリシステムをどのように活用するかを理解する必要があります。これには以下が含まれます:

- 入力データの設計: 短期および長期記憶の分離の利点を最大化するように入力データを準備します。

- メモリ割り当てのバランス: 短期および長期モジュールに割り当てるメモリの量を慎重に検討します。これは、特定のタスクと入力シーケンスの長さに依存します。

- メモリ取得の最適化: 関連情報が長期記憶モジュールから効率的にアクセスされるように、メモリ取得メカニズムを微調整します。

- 既存モデルの適応: 既存のトランスフォーマーベースのモデルをTitansアーキテクチャに組み込むように適応させます。

- 実験と評価: Titansベースのモデルのパフォーマンスをさまざまなタスクで徹底的に実験し、評価します。

これらの技術を習得することで、AI開発者はTitansアーキテクチャの可能性を最大限に引き出し、より強力で有能なAIシステムを構築できます。

Titansアーキテクチャの長所と短所

長所

- 長距離依存関係の処理が向上します。

- 線形スケーリングにより計算コストが削減されます。

- デュアルメモリシステムは人間の脳機能を模倣します。

- 新しいAIアプリケーションの可能性があります。

短所

- アーキテクチャの複雑さが増します。

- メモリ割り当てと取得の最適化が慎重に必要です。

- まだ開発の初期段階にあります。

Titansアーキテクチャに関するよくある質問

Titansアーキテクチャとは何ですか?

Titansアーキテクチャは、Googleが開発したAIメモリ管理の新しいアプローチです。短期および長期記憶モジュールからなるデュアルメモリシステムを利用して、長距離依存関係の処理を改善し、大規模言語モデルの計算コストを削減します。

Titansアーキテクチャは従来のトランスフォーマーとどう異なりますか?

従来のトランスフォーマーは自己注意に依存しており、二次的複雑さを持ち、長いシーケンスに苦労します。Titansアーキテクチャは、短期と長期記憶を分離することで線形スケーリングを実現し、より長いシーケンスを効率的に処理できます。

Titansアーキテクチャの潜在的なアプリケーションは何ですか?

Titansアーキテクチャは、ゲノミクス、金融モデリング、気候科学など、長距離依存関係分析が必要な領域で潜在的なアプリケーションがあります。また、長い会話、文書分析、コード生成でのAIモデルのパフォーマンスを向上させることもできます。

Titansアーキテクチャを使用する際の課題は何ですか?

Titansアーキテクチャを使用する際の課題には、アーキテクチャの複雑さの増加、メモリ割り当てと取得の最適化の必要性、そしてその比較的初期の開発段階が含まれます。

AIメモリとアーキテクチャに関する関連質問

トランスフォーマーの注意メカニズムはどのように機能しますか?

注意メカニズムは、トランスフォーマーモデルの重要な構成要素であり、情報を処理する際に入力シーケンスの関連部分に焦点を当てることを可能にします。本質的に、入力シーケンスの各単語(またはトークン)に重みを割り当て、シーケンス内の他の単語に対するその重要性を示します。トランスフォーマー内での注意メカニズムの機能について詳しく見ていきましょう:

入力埋め込み: 入力シーケンスの各単語またはトークンは、最初に埋め込み層を通じてベクトル表現に変換されます。これらの埋め込みは、注意メカニズムの入力として機能します。

クエリ、キー、バリュー: 入力埋め込みは、クエリ(Q)、キー(K)、バリュー(V)の3つの異なるベクトルに変換されます。これらの変換は、線形変換または学習された重み行列を通じて行われます。数学的には:

(Q = text{入力} cdot W_Q)

(K = text{入力} cdot W_K)

(V = text{入力} cdot W_V)

ここで、(W_Q)、(W_K)、(W_V)は、それぞれクエリ、キー、バリューの学習された重み行列です。

注意重みの計算: 注意重みは、入力シーケンス内の各単語のペア間の関連性の度合いを示します。これらの重みは、クエリベクトルと各キーベクトルのドット積を取ることで計算されます。結果として得られるスコアは、トレーニングを安定させるためにキーベクトルの次元の平方根でスケーリングされます。このスケーリングは、ドット積が過度に大きくなるのを防ぎ、トレーニング中に勾配が消失するのを防ぎます。

ソフトマックス正規化: スケーリングされたドット積は、ソフトマックス関数を通じて渡され、入力シーケンス上の確率分布に正規化されます。この正規化により、注意重みが1に合計され、解釈やトレーニングが容易になります。

重み付き和: 最後に、バリューベクトルは対応する注意重みによって重み付けされます。この重み付き和は、注意メカニズムの出力であり、入力シーケンス全体から関連情報を捉えます。

注意メカニズムは、トランスフォーマーがシーケンシャルデータを効果的に処理し、長距離依存関係を捉え、さまざまなNLPタスクで最先端のパフォーマンスを達成することを可能にします。入力シーケンスの異なる部分の重要性を動的に重み付けすることで、注意メカニズムはモデルが最も関連性の高い情報に焦点を当て、パフォーマンスを向上させます。

スプリッターAIによるボーカルと音楽のトラック・アイソレーションの究極ガイド

音楽愛好家、アーティスト志望者、そしてオーディオ・プロフェッショナルにとって、Splitter AIはサウンドの扱い方を一変させる画期的な機能を提供します。この徹底的な探求により、この人工知能プラットフォームがどのようにフルトラックを個々のコンポーネントに分解できるかが明らかになり、作曲を分析する学生からリミックスを制作するプロデューサーまで、すべての人に前例のない創造的な機会を提供します。この強

スプリッターAIによるボーカルと音楽のトラック・アイソレーションの究極ガイド

音楽愛好家、アーティスト志望者、そしてオーディオ・プロフェッショナルにとって、Splitter AIはサウンドの扱い方を一変させる画期的な機能を提供します。この徹底的な探求により、この人工知能プラットフォームがどのようにフルトラックを個々のコンポーネントに分解できるかが明らかになり、作曲を分析する学生からリミックスを制作するプロデューサーまで、すべての人に前例のない創造的な機会を提供します。この強

OpenAIがChatGPTの礼儀正しすぎるバグを修正、AIの欠陥を説明

OpenAIは、AIシステムが危険で不合理なユーザーの提案を不当に賞賛するなど、過剰な好意性を示すという報告が広まったことを受け、同社の主力モデルGPT-4oの最近の性格調整を取り消した。会話モデルにおける「AIのお人好し」の出現について、AIの安全性の専門家の間で懸念が高まっていることを受け、今回の緊急ロールバックが行われた。背景問題のあるアップデートオープンAIは4月29日の声明で、GPT-4

OpenAIがChatGPTの礼儀正しすぎるバグを修正、AIの欠陥を説明

OpenAIは、AIシステムが危険で不合理なユーザーの提案を不当に賞賛するなど、過剰な好意性を示すという報告が広まったことを受け、同社の主力モデルGPT-4oの最近の性格調整を取り消した。会話モデルにおける「AIのお人好し」の出現について、AIの安全性の専門家の間で懸念が高まっていることを受け、今回の緊急ロールバックが行われた。背景問題のあるアップデートオープンAIは4月29日の声明で、GPT-4

Piclumen AI、2025年にAIアート制作を無償提供

急速に変化するデジタルコンテンツ制作の世界において、Piclumen AIはAIを活用した画像生成のための完全無料のソリューションとして傑出している。この革新的なプラットフォームにより、ユーザーは経済的な障壁なしにプロ品質のビジュアルを作成することができ、洗練されたAIツールを誰でも利用できるようになります。この包括的なガイドでは、Piclumen AIの能力を調査し、プレミアムな代替製品との比較

Piclumen AI、2025年にAIアート制作を無償提供

急速に変化するデジタルコンテンツ制作の世界において、Piclumen AIはAIを活用した画像生成のための完全無料のソリューションとして傑出している。この革新的なプラットフォームにより、ユーザーは経済的な障壁なしにプロ品質のビジュアルを作成することができ、洗練されたAIツールを誰でも利用できるようになります。この包括的なガイドでは、Piclumen AIの能力を調査し、プレミアムな代替製品との比較

2025年9月10日 11:30:37 JST

2025年9月10日 11:30:37 JST

Cette histoire de 'mémoire' des IA me fait toujours sourire. Quand mon chat oublie où il a caché ses jouets, c'est mignon. Quand une IA oublie ce qu'elle vient de lire, ça coûte des millions en R&D... Ironique, non? 😅

0

0

2025年8月10日 22:00:59 JST

2025年8月10日 22:00:59 JST

This Titans Architecture sounds like a game-changer for AI memory! 🤯 Curious if it'll really solve the context window issue or just hype. Anyone tried it yet?

0

0

2025年8月1日 22:47:34 JST

2025年8月1日 22:47:34 JST

Wow, this Titans Architecture sounds like a game-changer for AI memory! Can't wait to see how it tackles the context window issue. 🤯

0

0

2025年7月22日 16:35:51 JST

2025年7月22日 16:35:51 JST

Wow, this Titans Architecture sounds like a game-changer for AI memory! I'm curious how it'll handle massive datasets without forgetting the plot. 😄 Could this finally make LLMs smarter than my goldfish?

0

0