Avance en Tecnología de Memoria AI: Arquitectura Titans

El mundo de la Inteligencia Artificial está siempre en movimiento, con investigadores trabajando incansablemente para ampliar los límites de lo que la IA puede hacer, especialmente con modelos de lenguaje de gran escala (LLMs). Uno de los mayores obstáculos que enfrentan estos modelos es su ventana de contexto limitada, lo que a menudo lleva a que "olviden" partes anteriores de una conversación o documento. Pero hay un rayo de esperanza en el horizonte: la arquitectura Titans de Google podría ser la solución a este problema de memoria corta en la IA.

Puntos Clave

- Los modelos de IA tradicionales a menudo tienen dificultades con la memoria a corto plazo, lo que limita su ventana de contexto.

- La arquitectura Titans de Google introduce un sistema de memoria dual para abordar esta limitación de frente.

- Titans utiliza módulos de memoria a corto y largo plazo para mejorar el rendimiento.

- La memoria a largo plazo en Titans puede manejar longitudes de contexto de más de dos millones de tokens.

- Titans permite un escalado lineal, lo que reduce los costos computacionales asociados con el escalado cuadrático en transformadores.

- La arquitectura muestra un gran potencial en tareas que requieren analizar dependencias de largo alcance, como la genómica.

Entendiendo los Límites de la Memoria a Corto Plazo en la IA

El Problema de la Ventana de Contexto

Una de las áreas clave donde la IA necesita mejorar es la restricción de la memoria a corto plazo. En el mundo de los modelos de IA, especialmente los Modelos de Lenguaje de Gran Escala (LLMs), esta limitación se manifiesta como una ventana de contexto finita. Piénsalo como el alcance de atención de la IA: una vez que está llena, la información más antigua se desplaza, lo que dificulta que la IA mantenga la coherencia y comprenda dependencias de largo alcance. Esta bottleneck de memoria a corto plazo afecta varias aplicaciones de IA, como:

- Conversaciones Extendidas: Mantener una conversación coherente durante muchos turnos se vuelve un desafío, ya que la IA podría perder la pista de temas y referencias anteriores.

- Análisis de Documentos: Procesar documentos largos, como libros o artículos de investigación, es difícil porque la IA tiene problemas para recordar la información del inicio cuando llega al final.

- Generación de Código: En tareas de codificación, la IA podría olvidar funciones o variables definidas previamente, lo que lleva a errores e ineficiencias.

Superar esta limitación es crucial para crear modelos de IA más confiables y capaces de manejar tareas complejas, por lo que avances como Titans son tan emocionantes.

La Complejidad Cuadrática de la Autoatención

Las arquitecturas basadas en transformadores tradicionales, que impulsan muchos LLMs modernos, dependen en gran medida de un mecanismo llamado autoatención. La autoatención es revolucionaria, pero tiene un costo computacional elevado. En términos matemáticos, la autoatención tiene una complejidad cuadrática. Esto significa que los recursos computacionales necesarios aumentan cuadráticamente con la longitud de la secuencia de entrada. Si duplicas la longitud de la entrada, el cálculo se vuelve cuatro veces más costoso. Este problema de escalado se convierte en un obstáculo importante cuando se trata de secuencias largas.

Por ejemplo, procesar una secuencia de 1,000 tokens puede ser manejable, pero escalar esto a 10,000 tokens aumenta la carga computacional en un factor de 100. Esto se vuelve rápidamente prohibitivo, incluso con el hardware más potente. Como resultado, los modelos basados en transformadores actuales están a menudo limitados a ventanas de contexto relativamente cortas, lo que dificulta su capacidad para capturar dependencias de largo alcance de manera efectiva. La exploración de arquitecturas novedosas como Titans, que pueden mitigar esta complejidad, es crítica para futuros avances en IA.

Titans: Habilitando el Análisis de Dependencias de Largo Alcance

Desbloqueando Nuevas Capacidades de IA

La capacidad de Titans para manejar ventanas de contexto más largas y lograr un escalado lineal abre una variedad de nuevas aplicaciones de IA que antes eran impracticables. Un área notable es el análisis de dependencias de largo alcance, donde las relaciones entre elementos separados por grandes distancias en una secuencia son críticas.

Algunos ejemplos de análisis de dependencias de largo alcance incluyen:

- Genómica: Comprender las relaciones entre genes dentro de un genoma. Los genes pueden interactuar entre sí incluso cuando están ubicados muy separados en la cadena de ADN. La arquitectura Titans está bien adaptada para capturar estas relaciones complejas.

- Modelado Financiero: Analizar tendencias y dependencias a largo plazo en los mercados financieros. Los datos financieros a menudo exhiben patrones y bucles de retroalimentación a largo plazo que requieren considerar datos de períodos extendidos.

- Ciencia del Clima: Modelar sistemas climáticos complejos y predecir cambios a largo plazo. Los modelos climáticos deben tener en cuenta las interacciones entre diferentes componentes del sistema terrestre durante muchos años.

En cada una de estas áreas, la capacidad para capturar dependencias de largo alcance es esencial para hacer predicciones precisas y obtener información valiosa. La arquitectura Titans proporciona una herramienta poderosa para abordar estos desafíos, permitiendo a la IA abordar problemas que antes estaban fuera de su alcance.

Cómo Usar la Arquitectura Titans para el Desarrollo de IA

Aprovechando los Sistemas de Memoria Dual

Para utilizar eficazmente la arquitectura Titans, los desarrolladores de IA necesitan entender cómo aprovechar su sistema de memoria dual. Esto implica:

- Diseñar Datos de Entrada: Preparar tus datos de entrada para maximizar los beneficios de la separación de memoria a corto y largo plazo.

- Equilibrar la Asignación de Memoria: Considerar cuidadosamente cuánto asignar a los módulos de memoria a corto y largo plazo. Esto dependerá de la tarea específica y de la longitud de las secuencias de entrada.

- Optimizar la Recuperación de Memoria: Ajustar el mecanismo de recuperación de memoria para asegurar que la información relevante se acceda eficientemente desde el módulo de memoria a largo plazo.

- Adaptar Modelos Existentes: Adaptar modelos basados en transformadores existentes para incorporar la arquitectura Titans.

- Experimentar y Evaluar: Experimentar y evaluar exhaustivamente el rendimiento de tu modelo basado en Titans en una variedad de tareas.

Al dominar estas técnicas, los desarrolladores de IA pueden desbloquear todo el potencial de la arquitectura Titans y construir sistemas de IA más potentes y capaces.

Ventajas y Desventajas de la Arquitectura Titans

Ventajas

- Mejor manejo de dependencias de largo alcance.

- El escalado lineal reduce los costos computacionales.

- El sistema de memoria dual refleja la función del cerebro humano.

- Potencial para nuevas aplicaciones de IA.

Desventajas

- Mayor complejidad arquitectónica.

- Requiere una asignación y optimización cuidadosa de la recuperación de memoria.

- Todavía está en etapas iniciales de desarrollo.

Preguntas Frecuentes Sobre la Arquitectura Titans

¿Qué es la arquitectura Titans?

La arquitectura Titans es un enfoque novedoso para la gestión de memoria en IA desarrollado por Google. Utiliza un sistema de memoria dual, compuesto por módulos de memoria a corto y largo plazo, para mejorar el manejo de dependencias de largo alcance y reducir los costos computacionales en modelos de lenguaje de gran escala.

¿En qué se diferencia la arquitectura Titans de los transformadores tradicionales?

Los transformadores tradicionales dependen de la autoatención, que tiene una complejidad cuadrática y tiene dificultades con secuencias largas. La arquitectura Titans logra un escalado lineal al separar la memoria a corto y largo plazo, lo que le permite manejar secuencias más largas de manera más eficiente.

¿Cuáles son las aplicaciones potenciales de la arquitectura Titans?

La arquitectura Titans tiene aplicaciones potenciales en áreas que requieren análisis de dependencias de largo alcance, como la genómica, el modelado financiero y la ciencia del clima. También puede mejorar el rendimiento de los modelos de IA en conversaciones extendidas, análisis de documentos y generación de código.

¿Cuáles son los desafíos de usar la arquitectura Titans?

Los desafíos de usar la arquitectura Titans incluyen su mayor complejidad arquitectónica, la necesidad de una asignación y optimización cuidadosa de la recuperación de memoria, y su etapa de desarrollo relativamente temprana.

Preguntas Relacionadas Sobre la Memoria y Arquitectura de IA

¿Cómo funciona el mecanismo de atención en los Transformadores?

El mecanismo de atención es un componente crucial de los modelos de transformadores, que les permite centrarse en partes relevantes de la secuencia de entrada al procesar información. En esencia, asigna un peso a cada palabra (o token) en la secuencia de entrada, indicando su importancia con respecto a otras palabras en la secuencia. Profundicemos en cómo funciona el mecanismo de atención dentro de los transformadores:

Incrustación de Entrada: Cada palabra o token de la secuencia de entrada se convierte inicialmente en una representación vectorial a través de capas de incrustación. Estas incrustaciones sirven como entrada al mecanismo de atención.

Consulta, Clave y Valor: Las incrustaciones de entrada se transforman en tres vectores distintos: los vectores de Consulta (Q), Clave (K) y Valor (V). Estas transformaciones se realizan a través de transformaciones lineales o matrices de pesos aprendidas. Matemáticamente:

(Q = text{Entrada} cdot W_Q)

(K = text{Entrada} cdot W_K)

(V = text{Entrada} cdot W_V)

Aquí, (W_Q), (W_K) y (W_V) son las matrices de pesos aprendidas para la Consulta, Clave y Valor, respectivamente.

Cálculo de Pesos de Atención: Los pesos de atención indican el grado de relevancia entre cada par de palabras en la secuencia de entrada. Estos pesos se calculan tomando el producto punto del vector de Consulta con cada vector de Clave. Los puntajes resultantes se escalan dividiendo por la raíz cuadrada de la dimensión de los vectores de Clave para estabilizar el entrenamiento. Este escalado evita que los productos punto se vuelvan excesivamente grandes, lo que puede llevar a gradientes que desaparecen durante el entrenamiento.

Normalización Softmax: Los productos punto escalados se pasan a través de una función softmax para normalizarlos en una distribución de probabilidad sobre la secuencia de entrada. Esta normalización asegura que los pesos de atención sumen 1, lo que los hace más fáciles de interpretar y entrenar.

Suma Ponderada: Finalmente, los vectores de Valor se ponderan por sus pesos de atención correspondientes. Esta suma ponderada representa la salida del mecanismo de atención, que captura la información relevante de toda la secuencia de entrada.

El mecanismo de atención permite a los Transformadores manejar datos secuenciales de manera efectiva, capturar dependencias de largo alcance y lograr un rendimiento de vanguardia en diversas tareas de PNL. Al pesar dinámicamente la importancia de diferentes partes de la secuencia de entrada, el mecanismo de atención permite al modelo centrarse en la información más relevante, lo que lleva a un rendimiento mejorado.

Artículo relacionado

Los PowerToys de Microsoft introducirán dos importantes funciones de Windows que se echan en falta

Los usuarios de Windows que han anhelado el cambio automático de modo luz/oscuridad o una forma más fácil de resolver los conflictos de atajos de teclado pronto verán cumplidos sus deseos a través de

Los PowerToys de Microsoft introducirán dos importantes funciones de Windows que se echan en falta

Los usuarios de Windows que han anhelado el cambio automático de modo luz/oscuridad o una forma más fácil de resolver los conflictos de atajos de teclado pronto verán cumplidos sus deseos a través de

Las fotos de Joytika generadas por IA celebran la belleza y la estética del sur de la India

Adéntrese en una revolución artística en la que Joytika, la querida actriz del cine del sur de la India, cobra vida a través de la generación de imágenes de IA de última generación. Este viaje visual

Las fotos de Joytika generadas por IA celebran la belleza y la estética del sur de la India

Adéntrese en una revolución artística en la que Joytika, la querida actriz del cine del sur de la India, cobra vida a través de la generación de imágenes de IA de última generación. Este viaje visual

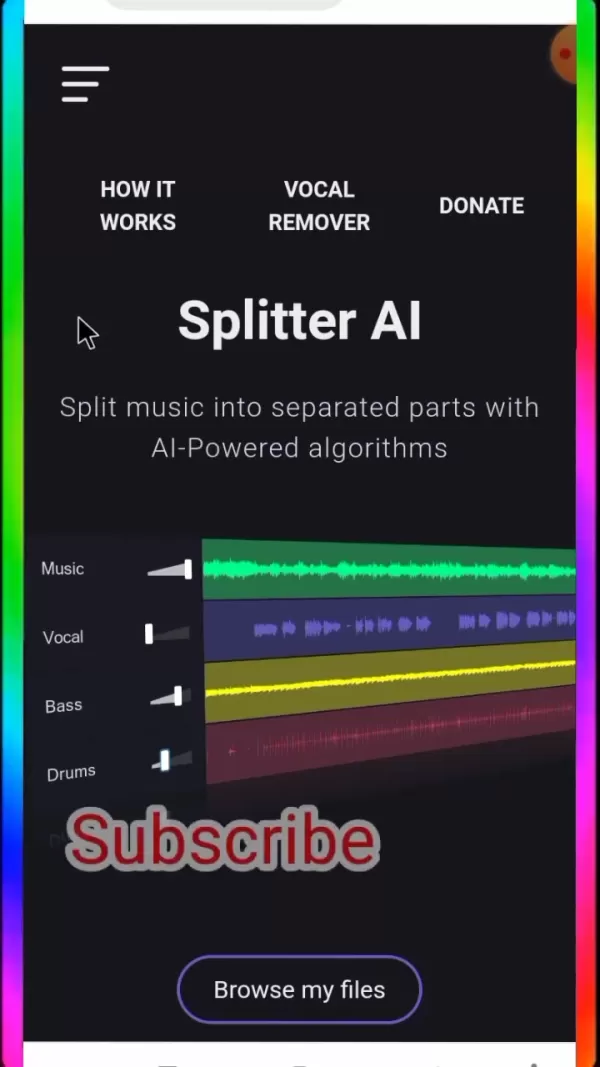

Guía definitiva para el aislamiento de pistas vocales y musicales con Splitter AI

Para los amantes de la música, los aspirantes a artistas y los profesionales del audio por igual, Splitter AI ofrece capacidades revolucionarias para transformar la forma de trabajar con el sonido. Es

comentario (4)

0/200

Guía definitiva para el aislamiento de pistas vocales y musicales con Splitter AI

Para los amantes de la música, los aspirantes a artistas y los profesionales del audio por igual, Splitter AI ofrece capacidades revolucionarias para transformar la forma de trabajar con el sonido. Es

comentario (4)

0/200

![JoseDavis]() JoseDavis

JoseDavis

10 de septiembre de 2025 04:30:37 GMT+02:00

10 de septiembre de 2025 04:30:37 GMT+02:00

Cette histoire de 'mémoire' des IA me fait toujours sourire. Quand mon chat oublie où il a caché ses jouets, c'est mignon. Quand une IA oublie ce qu'elle vient de lire, ça coûte des millions en R&D... Ironique, non? 😅

0

0

![BenLewis]() BenLewis

BenLewis

10 de agosto de 2025 15:00:59 GMT+02:00

10 de agosto de 2025 15:00:59 GMT+02:00

This Titans Architecture sounds like a game-changer for AI memory! 🤯 Curious if it'll really solve the context window issue or just hype. Anyone tried it yet?

0

0

![WillieAdams]() WillieAdams

WillieAdams

1 de agosto de 2025 15:47:34 GMT+02:00

1 de agosto de 2025 15:47:34 GMT+02:00

Wow, this Titans Architecture sounds like a game-changer for AI memory! Can't wait to see how it tackles the context window issue. 🤯

0

0

![LiamCarter]() LiamCarter

LiamCarter

22 de julio de 2025 09:35:51 GMT+02:00

22 de julio de 2025 09:35:51 GMT+02:00

Wow, this Titans Architecture sounds like a game-changer for AI memory! I'm curious how it'll handle massive datasets without forgetting the plot. 😄 Could this finally make LLMs smarter than my goldfish?

0

0

El mundo de la Inteligencia Artificial está siempre en movimiento, con investigadores trabajando incansablemente para ampliar los límites de lo que la IA puede hacer, especialmente con modelos de lenguaje de gran escala (LLMs). Uno de los mayores obstáculos que enfrentan estos modelos es su ventana de contexto limitada, lo que a menudo lleva a que "olviden" partes anteriores de una conversación o documento. Pero hay un rayo de esperanza en el horizonte: la arquitectura Titans de Google podría ser la solución a este problema de memoria corta en la IA.

Puntos Clave

- Los modelos de IA tradicionales a menudo tienen dificultades con la memoria a corto plazo, lo que limita su ventana de contexto.

- La arquitectura Titans de Google introduce un sistema de memoria dual para abordar esta limitación de frente.

- Titans utiliza módulos de memoria a corto y largo plazo para mejorar el rendimiento.

- La memoria a largo plazo en Titans puede manejar longitudes de contexto de más de dos millones de tokens.

- Titans permite un escalado lineal, lo que reduce los costos computacionales asociados con el escalado cuadrático en transformadores.

- La arquitectura muestra un gran potencial en tareas que requieren analizar dependencias de largo alcance, como la genómica.

Entendiendo los Límites de la Memoria a Corto Plazo en la IA

El Problema de la Ventana de Contexto

Una de las áreas clave donde la IA necesita mejorar es la restricción de la memoria a corto plazo. En el mundo de los modelos de IA, especialmente los Modelos de Lenguaje de Gran Escala (LLMs), esta limitación se manifiesta como una ventana de contexto finita. Piénsalo como el alcance de atención de la IA: una vez que está llena, la información más antigua se desplaza, lo que dificulta que la IA mantenga la coherencia y comprenda dependencias de largo alcance. Esta bottleneck de memoria a corto plazo afecta varias aplicaciones de IA, como:

- Conversaciones Extendidas: Mantener una conversación coherente durante muchos turnos se vuelve un desafío, ya que la IA podría perder la pista de temas y referencias anteriores.

- Análisis de Documentos: Procesar documentos largos, como libros o artículos de investigación, es difícil porque la IA tiene problemas para recordar la información del inicio cuando llega al final.

- Generación de Código: En tareas de codificación, la IA podría olvidar funciones o variables definidas previamente, lo que lleva a errores e ineficiencias.

Superar esta limitación es crucial para crear modelos de IA más confiables y capaces de manejar tareas complejas, por lo que avances como Titans son tan emocionantes.

La Complejidad Cuadrática de la Autoatención

Las arquitecturas basadas en transformadores tradicionales, que impulsan muchos LLMs modernos, dependen en gran medida de un mecanismo llamado autoatención. La autoatención es revolucionaria, pero tiene un costo computacional elevado. En términos matemáticos, la autoatención tiene una complejidad cuadrática. Esto significa que los recursos computacionales necesarios aumentan cuadráticamente con la longitud de la secuencia de entrada. Si duplicas la longitud de la entrada, el cálculo se vuelve cuatro veces más costoso. Este problema de escalado se convierte en un obstáculo importante cuando se trata de secuencias largas.

Por ejemplo, procesar una secuencia de 1,000 tokens puede ser manejable, pero escalar esto a 10,000 tokens aumenta la carga computacional en un factor de 100. Esto se vuelve rápidamente prohibitivo, incluso con el hardware más potente. Como resultado, los modelos basados en transformadores actuales están a menudo limitados a ventanas de contexto relativamente cortas, lo que dificulta su capacidad para capturar dependencias de largo alcance de manera efectiva. La exploración de arquitecturas novedosas como Titans, que pueden mitigar esta complejidad, es crítica para futuros avances en IA.

Titans: Habilitando el Análisis de Dependencias de Largo Alcance

Desbloqueando Nuevas Capacidades de IA

La capacidad de Titans para manejar ventanas de contexto más largas y lograr un escalado lineal abre una variedad de nuevas aplicaciones de IA que antes eran impracticables. Un área notable es el análisis de dependencias de largo alcance, donde las relaciones entre elementos separados por grandes distancias en una secuencia son críticas.

Algunos ejemplos de análisis de dependencias de largo alcance incluyen:

- Genómica: Comprender las relaciones entre genes dentro de un genoma. Los genes pueden interactuar entre sí incluso cuando están ubicados muy separados en la cadena de ADN. La arquitectura Titans está bien adaptada para capturar estas relaciones complejas.

- Modelado Financiero: Analizar tendencias y dependencias a largo plazo en los mercados financieros. Los datos financieros a menudo exhiben patrones y bucles de retroalimentación a largo plazo que requieren considerar datos de períodos extendidos.

- Ciencia del Clima: Modelar sistemas climáticos complejos y predecir cambios a largo plazo. Los modelos climáticos deben tener en cuenta las interacciones entre diferentes componentes del sistema terrestre durante muchos años.

En cada una de estas áreas, la capacidad para capturar dependencias de largo alcance es esencial para hacer predicciones precisas y obtener información valiosa. La arquitectura Titans proporciona una herramienta poderosa para abordar estos desafíos, permitiendo a la IA abordar problemas que antes estaban fuera de su alcance.

Cómo Usar la Arquitectura Titans para el Desarrollo de IA

Aprovechando los Sistemas de Memoria Dual

Para utilizar eficazmente la arquitectura Titans, los desarrolladores de IA necesitan entender cómo aprovechar su sistema de memoria dual. Esto implica:

- Diseñar Datos de Entrada: Preparar tus datos de entrada para maximizar los beneficios de la separación de memoria a corto y largo plazo.

- Equilibrar la Asignación de Memoria: Considerar cuidadosamente cuánto asignar a los módulos de memoria a corto y largo plazo. Esto dependerá de la tarea específica y de la longitud de las secuencias de entrada.

- Optimizar la Recuperación de Memoria: Ajustar el mecanismo de recuperación de memoria para asegurar que la información relevante se acceda eficientemente desde el módulo de memoria a largo plazo.

- Adaptar Modelos Existentes: Adaptar modelos basados en transformadores existentes para incorporar la arquitectura Titans.

- Experimentar y Evaluar: Experimentar y evaluar exhaustivamente el rendimiento de tu modelo basado en Titans en una variedad de tareas.

Al dominar estas técnicas, los desarrolladores de IA pueden desbloquear todo el potencial de la arquitectura Titans y construir sistemas de IA más potentes y capaces.

Ventajas y Desventajas de la Arquitectura Titans

Ventajas

- Mejor manejo de dependencias de largo alcance.

- El escalado lineal reduce los costos computacionales.

- El sistema de memoria dual refleja la función del cerebro humano.

- Potencial para nuevas aplicaciones de IA.

Desventajas

- Mayor complejidad arquitectónica.

- Requiere una asignación y optimización cuidadosa de la recuperación de memoria.

- Todavía está en etapas iniciales de desarrollo.

Preguntas Frecuentes Sobre la Arquitectura Titans

¿Qué es la arquitectura Titans?

La arquitectura Titans es un enfoque novedoso para la gestión de memoria en IA desarrollado por Google. Utiliza un sistema de memoria dual, compuesto por módulos de memoria a corto y largo plazo, para mejorar el manejo de dependencias de largo alcance y reducir los costos computacionales en modelos de lenguaje de gran escala.

¿En qué se diferencia la arquitectura Titans de los transformadores tradicionales?

Los transformadores tradicionales dependen de la autoatención, que tiene una complejidad cuadrática y tiene dificultades con secuencias largas. La arquitectura Titans logra un escalado lineal al separar la memoria a corto y largo plazo, lo que le permite manejar secuencias más largas de manera más eficiente.

¿Cuáles son las aplicaciones potenciales de la arquitectura Titans?

La arquitectura Titans tiene aplicaciones potenciales en áreas que requieren análisis de dependencias de largo alcance, como la genómica, el modelado financiero y la ciencia del clima. También puede mejorar el rendimiento de los modelos de IA en conversaciones extendidas, análisis de documentos y generación de código.

¿Cuáles son los desafíos de usar la arquitectura Titans?

Los desafíos de usar la arquitectura Titans incluyen su mayor complejidad arquitectónica, la necesidad de una asignación y optimización cuidadosa de la recuperación de memoria, y su etapa de desarrollo relativamente temprana.

Preguntas Relacionadas Sobre la Memoria y Arquitectura de IA

¿Cómo funciona el mecanismo de atención en los Transformadores?

El mecanismo de atención es un componente crucial de los modelos de transformadores, que les permite centrarse en partes relevantes de la secuencia de entrada al procesar información. En esencia, asigna un peso a cada palabra (o token) en la secuencia de entrada, indicando su importancia con respecto a otras palabras en la secuencia. Profundicemos en cómo funciona el mecanismo de atención dentro de los transformadores:

Incrustación de Entrada: Cada palabra o token de la secuencia de entrada se convierte inicialmente en una representación vectorial a través de capas de incrustación. Estas incrustaciones sirven como entrada al mecanismo de atención.

Consulta, Clave y Valor: Las incrustaciones de entrada se transforman en tres vectores distintos: los vectores de Consulta (Q), Clave (K) y Valor (V). Estas transformaciones se realizan a través de transformaciones lineales o matrices de pesos aprendidas. Matemáticamente:

(Q = text{Entrada} cdot W_Q)

(K = text{Entrada} cdot W_K)

(V = text{Entrada} cdot W_V)

Aquí, (W_Q), (W_K) y (W_V) son las matrices de pesos aprendidas para la Consulta, Clave y Valor, respectivamente.

Cálculo de Pesos de Atención: Los pesos de atención indican el grado de relevancia entre cada par de palabras en la secuencia de entrada. Estos pesos se calculan tomando el producto punto del vector de Consulta con cada vector de Clave. Los puntajes resultantes se escalan dividiendo por la raíz cuadrada de la dimensión de los vectores de Clave para estabilizar el entrenamiento. Este escalado evita que los productos punto se vuelvan excesivamente grandes, lo que puede llevar a gradientes que desaparecen durante el entrenamiento.

Normalización Softmax: Los productos punto escalados se pasan a través de una función softmax para normalizarlos en una distribución de probabilidad sobre la secuencia de entrada. Esta normalización asegura que los pesos de atención sumen 1, lo que los hace más fáciles de interpretar y entrenar.

Suma Ponderada: Finalmente, los vectores de Valor se ponderan por sus pesos de atención correspondientes. Esta suma ponderada representa la salida del mecanismo de atención, que captura la información relevante de toda la secuencia de entrada.

El mecanismo de atención permite a los Transformadores manejar datos secuenciales de manera efectiva, capturar dependencias de largo alcance y lograr un rendimiento de vanguardia en diversas tareas de PNL. Al pesar dinámicamente la importancia de diferentes partes de la secuencia de entrada, el mecanismo de atención permite al modelo centrarse en la información más relevante, lo que lleva a un rendimiento mejorado.

Los PowerToys de Microsoft introducirán dos importantes funciones de Windows que se echan en falta

Los usuarios de Windows que han anhelado el cambio automático de modo luz/oscuridad o una forma más fácil de resolver los conflictos de atajos de teclado pronto verán cumplidos sus deseos a través de

Los PowerToys de Microsoft introducirán dos importantes funciones de Windows que se echan en falta

Los usuarios de Windows que han anhelado el cambio automático de modo luz/oscuridad o una forma más fácil de resolver los conflictos de atajos de teclado pronto verán cumplidos sus deseos a través de

Las fotos de Joytika generadas por IA celebran la belleza y la estética del sur de la India

Adéntrese en una revolución artística en la que Joytika, la querida actriz del cine del sur de la India, cobra vida a través de la generación de imágenes de IA de última generación. Este viaje visual

Las fotos de Joytika generadas por IA celebran la belleza y la estética del sur de la India

Adéntrese en una revolución artística en la que Joytika, la querida actriz del cine del sur de la India, cobra vida a través de la generación de imágenes de IA de última generación. Este viaje visual

Guía definitiva para el aislamiento de pistas vocales y musicales con Splitter AI

Para los amantes de la música, los aspirantes a artistas y los profesionales del audio por igual, Splitter AI ofrece capacidades revolucionarias para transformar la forma de trabajar con el sonido. Es

Guía definitiva para el aislamiento de pistas vocales y musicales con Splitter AI

Para los amantes de la música, los aspirantes a artistas y los profesionales del audio por igual, Splitter AI ofrece capacidades revolucionarias para transformar la forma de trabajar con el sonido. Es

10 de septiembre de 2025 04:30:37 GMT+02:00

10 de septiembre de 2025 04:30:37 GMT+02:00

Cette histoire de 'mémoire' des IA me fait toujours sourire. Quand mon chat oublie où il a caché ses jouets, c'est mignon. Quand une IA oublie ce qu'elle vient de lire, ça coûte des millions en R&D... Ironique, non? 😅

0

0

10 de agosto de 2025 15:00:59 GMT+02:00

10 de agosto de 2025 15:00:59 GMT+02:00

This Titans Architecture sounds like a game-changer for AI memory! 🤯 Curious if it'll really solve the context window issue or just hype. Anyone tried it yet?

0

0

1 de agosto de 2025 15:47:34 GMT+02:00

1 de agosto de 2025 15:47:34 GMT+02:00

Wow, this Titans Architecture sounds like a game-changer for AI memory! Can't wait to see how it tackles the context window issue. 🤯

0

0

22 de julio de 2025 09:35:51 GMT+02:00

22 de julio de 2025 09:35:51 GMT+02:00

Wow, this Titans Architecture sounds like a game-changer for AI memory! I'm curious how it'll handle massive datasets without forgetting the plot. 😄 Could this finally make LLMs smarter than my goldfish?

0

0