AI記憶技術突破:泰坦架構

人工智能的世界總是在進步,研究人員不懈地努力突破AI的界限,特別是大規模語言模型(LLMs)。這些模型面臨的最大障礙之一是其有限的上下文窗口,這常導致它們「忘記」對話或文件的早期部分。但地平線上有一線希望——Google的Titans架構可能正是解決AI短記憶問題的方案。

重點

- 傳統AI模型常因短期記憶問題而受限,限制了它們的上下文窗口。

- Google的Titans架構引入雙記憶系統,直接應對此限制。

- Titans使用短期和長期記憶模組來提升性能。

- Titans的長期記憶可處理超過200萬個令牌的上下文長度。

- Titans實現線性擴展,降低與Transformer二次擴展相關的計算成本。

- 該架構在需要分析長距離依賴的任務中顯示出巨大潛力,如基因組學。

理解AI短期記憶的限制

上下文窗口問題

AI需要提升的關鍵領域之一是短期記憶的限制。在AI模型世界中,特別是大規模語言模型(LLMs),這種限制表現為有限的上下文窗口。可以將其視為AI的注意力範圍——一旦滿載,較早的信息會被擠出,使AI難以保持連貫性並理解長距離依賴。這種短期記憶瓶頸影響了多個AI應用,例如:

- 長時間對話:在多次對話中保持連貫性是一個挑戰,因為AI可能會忘記早期的話題和參考內容。

- 文件分析:處理長篇文件,如書籍或研究論文,十分困難,因為AI在到達末尾時難以記住開頭的信息。

- 程式碼生成:在編碼任務中,AI可能忘記之前定義的函數或變量,導致錯誤和低效。

克服這一限制對於創建更可靠、能處理複雜任務的AI模型至關重要,這就是為什麼像Titans這樣的進展如此令人振奮。

自注意力的二次複雜性

傳統基於Transformer的架構,驅動了許多現代LLMs,高度依賴一種稱為自注意力的機制。自注意力是革命性的,但它帶來了高昂的計算成本。從數學角度看,自注意力具有二次複雜性。這意味著所需計算資源隨著輸入序列長度的增加呈二次方增長。如果輸入長度加倍,計算成本將增加四倍。這種擴展問題在處理長序列時成為主要障礙。

例如,處理1000個令牌的序列可能還可行,但將其擴展到10000個令牌,計算負擔將增加100倍。即使使用最強大的硬體,這也很快變得難以承受。因此,當前的基於Transformer的模型通常局限於較短的上下文窗口,限制了它們有效捕捉長距離依賴的能力。探索像Titans這樣的新架構,減輕這種複雜性,對於AI的未來進展至關重要。

Titans:實現長距離依賴分析

解鎖新的AI能力

Titans處理更長上下文窗口並實現線性擴展的能力,開啟了許多以前不切實際的新AI應用。一個重要的領域是長距離依賴分析,其中序列中遠距離元素之間的關係至關重要。

長距離依賴分析的一些例子包括:

- 基因組學:理解基因組內基因之間的關係。基因即使在DNA鏈上相距甚遠,也可能相互作用。Titans架構非常適合捕捉這些複雜關係。

- 金融建模:分析金融市場中的長期趨勢和依賴。金融數據常表現出需要考慮長期數據的模式和反饋迴路。

- 氣候科學:模擬複雜的氣候系統並預測長期變化。氣候模型必須考慮地球系統不同組成部分在多年間的相互作用。

在這些領域中,捕捉長距離依賴的能力對於做出準確預測和獲得寶貴見解至關重要。Titans架構提供了一個強大的工具來應對這些挑戰,使AI能夠解決之前無法觸及的問題。

如何使用Titans架構進行AI開發

利用雙記憶系統

要有效利用Titans架構,AI開發者需要了解如何利用其雙記憶系統。這包括:

- 設計輸入數據:準備輸入數據以最大化短期和長期記憶分離的優勢。

- 平衡記憶分配:仔細考慮為短期和長期記憶模組分配多少記憶。這將取決於具體任務和輸入序列的長度。

- 優化記憶檢索:微調記憶檢索機制,確保從長期記憶模組中有效訪問相關信息。

- 適應現有模型:調整現有的基於Transformer的模型以融入Titans架構。

- 實驗與評估:在多種任務上徹底實驗和評估基於Titans的模型的性能。

通過掌握這些技術,AI開發者可以充分發揮Titans架構的潛力,構建更強大、更高效的AI系統。

Titans架構的優缺點

優點

- 改進長距離依賴的處理。

- 線性擴展降低計算成本。

- 雙記憶系統模擬人腦功能。

- 開啟新的AI應用可能性。

缺點

- 架構複雜性增加。

- 需要仔細的記憶分配和檢索優化。

- 仍處於早期開發階段。

關於Titans架構的常見問題

什麼是Titans架構?

Titans架構是Google開發的一種新穎的AI記憶管理方法。它利用由短期和長期記憶模組組成的雙記憶系統,改善長距離依賴的處理並降低大規模語言模型的計算成本。

Titans架構與傳統Transformer有何不同?

傳統Transformer依賴自注意力,具有二次複雜性,難以處理長序列。Titans架構通過分離短期和長期記憶實現線性擴展,能更有效地處理較長序列。

Titans架構的潛在應用有哪些?

Titans架構在需要長距離依賴分析的領域有潛在應用,如基因組學、金融建模和氣候科學。它還可以提升AI模型在長時間對話、文件分析和程式碼生成中的性能。

使用Titans架構的挑戰是什麼?

使用Titans架構的挑戰包括其架構複雜性增加、需要仔細的記憶分配和檢索優化,以及其相對早期的開發階段。

關於AI記憶與架構的相關問題

Transformer中的注意力機制如何運作?

注意力機制是Transformer模型的關鍵組成部分,使其在處理信息時能夠專注於輸入序列的相關部分。本質上,它為輸入序列中的每個詞(或令牌)分配一個權重,指示其相對於序列中其他詞的重要性。以下是注意力機制在Transformer中的運作方式:

輸入嵌入:輸入序列中的每個詞或令牌首先通過嵌入層轉換為向量表示。這些嵌入作為注意力機制的輸入。

查詢、鍵和值:輸入嵌入被轉換為三個不同的向量:查詢(Q)、鍵(K)和值(V)向量。這些轉換通過線性變換或學習到的權重矩陣進行。數學上:

(Q = text{輸入} cdot W_Q)

(K = text{輸入} cdot W_K)

(V = text{輸入} cdot W_V)

這裡,(W_Q)、(W_K)和(W_V)分別是查詢、鍵和值的學習權重矩陣。

注意力權重計算:注意力權重表示輸入序列中每對詞之間的相關程度。這些權重通過計算查詢向量與每個鍵向量的點積來獲得。所得分數隨後通過鍵向量維度的平方根進行縮放,以穩定訓練。這一縮放防止點積變得過大,從而在訓練期間導致梯度消失。

Softmax正規化:縮放後的點積通過Softmax函數進行正規化,轉換為輸入序列上的概率分佈。這種正規化確保注意力權重總和為1,使其更容易解釋和訓練。

加權和:最後,值向量根據其對應的注意力權重進行加權。這一加權和表示注意力機制的輸出,捕捉了整個輸入序列的相關信息。

注意力機制使Transformer能夠有效處理序列數據,捕捉長距離依賴,並在各種NLP任務中實現最先進的性能。通過動態權衡輸入序列不同部分的重要性,注意力機制使模型能夠專注於最相關的信息,從而提升性能。

相關文章

OpenAI 修復了 ChatGPT 過度禮貌的錯誤,並解釋了 AI 的缺陷

在有廣泛的報導指出 AI 系統表現出過度的認同,包括對危險或荒謬的使用者建議進行無端讚美之後,OpenAI 針對其旗艦版 GPT-4o 模型進行了最近的人格調整。在緊急撤回之前,人工智能安全專家對會話模型中出現的 「AI 佞幸 」日益關注。背景:有問題的更新在 4 月 29 日的聲明中,OpenAI 解釋更新的目的是讓 GPT-4o 在不同的使用情況下更直覺、更靈活。然而,模型開始展現出令人擔心的

OpenAI 修復了 ChatGPT 過度禮貌的錯誤,並解釋了 AI 的缺陷

在有廣泛的報導指出 AI 系統表現出過度的認同,包括對危險或荒謬的使用者建議進行無端讚美之後,OpenAI 針對其旗艦版 GPT-4o 模型進行了最近的人格調整。在緊急撤回之前,人工智能安全專家對會話模型中出現的 「AI 佞幸 」日益關注。背景:有問題的更新在 4 月 29 日的聲明中,OpenAI 解釋更新的目的是讓 GPT-4o 在不同的使用情況下更直覺、更靈活。然而,模型開始展現出令人擔心的

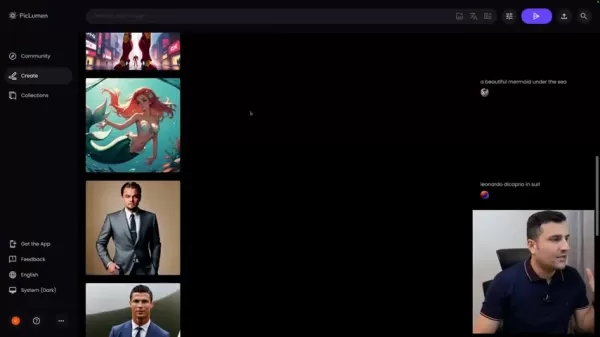

Piclumen AI 在 2025 年提供免費的 AI 藝術創作

在瞬息萬變的數位內容創作世界中,Piclumen AI 以完全免費的解決方案脫穎而出,成為人工智慧驅動的影像產生工具。此創新平台可讓使用者在沒有經濟障礙的情況下,創造出專業品質的視覺效果,讓所有人都能使用精密的 AI 工具。這份全面的指南將探討 Piclumen AI 的功能,說明它如何與其他優質產品相較,以及如何徹底改變創意工作流程。主要優勢完全免費的 AI 影像產生,無隱藏成本可生成包括名人肖

Piclumen AI 在 2025 年提供免費的 AI 藝術創作

在瞬息萬變的數位內容創作世界中,Piclumen AI 以完全免費的解決方案脫穎而出,成為人工智慧驅動的影像產生工具。此創新平台可讓使用者在沒有經濟障礙的情況下,創造出專業品質的視覺效果,讓所有人都能使用精密的 AI 工具。這份全面的指南將探討 Piclumen AI 的功能,說明它如何與其他優質產品相較,以及如何徹底改變創意工作流程。主要優勢完全免費的 AI 影像產生,無隱藏成本可生成包括名人肖

麻省理工學院推出超越靜態模型的自我學習 AI 架構

麻省理工學院研究人員開創自學人工智能框架麻省理工學院的研究團隊開發了一套名為 SEAL(Self-Adapting Language Models,自適應語言模型)的創新系統,讓大型語言模型能夠自主進化其能力。這項突破使人工智能系統能夠產生自己的訓練材料和學習協議,允許永久整合新知識和技能。SEAL 代表了企業級 AI 應用的重大進步,特別是對於在流動環境中運作的智慧型代理人而言,持續適應是非常重

評論 (4)

0/200

麻省理工學院推出超越靜態模型的自我學習 AI 架構

麻省理工學院研究人員開創自學人工智能框架麻省理工學院的研究團隊開發了一套名為 SEAL(Self-Adapting Language Models,自適應語言模型)的創新系統,讓大型語言模型能夠自主進化其能力。這項突破使人工智能系統能夠產生自己的訓練材料和學習協議,允許永久整合新知識和技能。SEAL 代表了企業級 AI 應用的重大進步,特別是對於在流動環境中運作的智慧型代理人而言,持續適應是非常重

評論 (4)

0/200

![JoseDavis]() JoseDavis

JoseDavis

2025-09-10 10:30:37

2025-09-10 10:30:37

Cette histoire de 'mémoire' des IA me fait toujours sourire. Quand mon chat oublie où il a caché ses jouets, c'est mignon. Quand une IA oublie ce qu'elle vient de lire, ça coûte des millions en R&D... Ironique, non? 😅

0

0

![BenLewis]() BenLewis

BenLewis

2025-08-10 21:00:59

2025-08-10 21:00:59

This Titans Architecture sounds like a game-changer for AI memory! 🤯 Curious if it'll really solve the context window issue or just hype. Anyone tried it yet?

0

0

![WillieAdams]() WillieAdams

WillieAdams

2025-08-01 21:47:34

2025-08-01 21:47:34

Wow, this Titans Architecture sounds like a game-changer for AI memory! Can't wait to see how it tackles the context window issue. 🤯

0

0

![LiamCarter]() LiamCarter

LiamCarter

2025-07-22 15:35:51

2025-07-22 15:35:51

Wow, this Titans Architecture sounds like a game-changer for AI memory! I'm curious how it'll handle massive datasets without forgetting the plot. 😄 Could this finally make LLMs smarter than my goldfish?

0

0

人工智能的世界總是在進步,研究人員不懈地努力突破AI的界限,特別是大規模語言模型(LLMs)。這些模型面臨的最大障礙之一是其有限的上下文窗口,這常導致它們「忘記」對話或文件的早期部分。但地平線上有一線希望——Google的Titans架構可能正是解決AI短記憶問題的方案。

重點

- 傳統AI模型常因短期記憶問題而受限,限制了它們的上下文窗口。

- Google的Titans架構引入雙記憶系統,直接應對此限制。

- Titans使用短期和長期記憶模組來提升性能。

- Titans的長期記憶可處理超過200萬個令牌的上下文長度。

- Titans實現線性擴展,降低與Transformer二次擴展相關的計算成本。

- 該架構在需要分析長距離依賴的任務中顯示出巨大潛力,如基因組學。

理解AI短期記憶的限制

上下文窗口問題

AI需要提升的關鍵領域之一是短期記憶的限制。在AI模型世界中,特別是大規模語言模型(LLMs),這種限制表現為有限的上下文窗口。可以將其視為AI的注意力範圍——一旦滿載,較早的信息會被擠出,使AI難以保持連貫性並理解長距離依賴。這種短期記憶瓶頸影響了多個AI應用,例如:

- 長時間對話:在多次對話中保持連貫性是一個挑戰,因為AI可能會忘記早期的話題和參考內容。

- 文件分析:處理長篇文件,如書籍或研究論文,十分困難,因為AI在到達末尾時難以記住開頭的信息。

- 程式碼生成:在編碼任務中,AI可能忘記之前定義的函數或變量,導致錯誤和低效。

克服這一限制對於創建更可靠、能處理複雜任務的AI模型至關重要,這就是為什麼像Titans這樣的進展如此令人振奮。

自注意力的二次複雜性

傳統基於Transformer的架構,驅動了許多現代LLMs,高度依賴一種稱為自注意力的機制。自注意力是革命性的,但它帶來了高昂的計算成本。從數學角度看,自注意力具有二次複雜性。這意味著所需計算資源隨著輸入序列長度的增加呈二次方增長。如果輸入長度加倍,計算成本將增加四倍。這種擴展問題在處理長序列時成為主要障礙。

例如,處理1000個令牌的序列可能還可行,但將其擴展到10000個令牌,計算負擔將增加100倍。即使使用最強大的硬體,這也很快變得難以承受。因此,當前的基於Transformer的模型通常局限於較短的上下文窗口,限制了它們有效捕捉長距離依賴的能力。探索像Titans這樣的新架構,減輕這種複雜性,對於AI的未來進展至關重要。

Titans:實現長距離依賴分析

解鎖新的AI能力

Titans處理更長上下文窗口並實現線性擴展的能力,開啟了許多以前不切實際的新AI應用。一個重要的領域是長距離依賴分析,其中序列中遠距離元素之間的關係至關重要。

長距離依賴分析的一些例子包括:

- 基因組學:理解基因組內基因之間的關係。基因即使在DNA鏈上相距甚遠,也可能相互作用。Titans架構非常適合捕捉這些複雜關係。

- 金融建模:分析金融市場中的長期趨勢和依賴。金融數據常表現出需要考慮長期數據的模式和反饋迴路。

- 氣候科學:模擬複雜的氣候系統並預測長期變化。氣候模型必須考慮地球系統不同組成部分在多年間的相互作用。

在這些領域中,捕捉長距離依賴的能力對於做出準確預測和獲得寶貴見解至關重要。Titans架構提供了一個強大的工具來應對這些挑戰,使AI能夠解決之前無法觸及的問題。

如何使用Titans架構進行AI開發

利用雙記憶系統

要有效利用Titans架構,AI開發者需要了解如何利用其雙記憶系統。這包括:

- 設計輸入數據:準備輸入數據以最大化短期和長期記憶分離的優勢。

- 平衡記憶分配:仔細考慮為短期和長期記憶模組分配多少記憶。這將取決於具體任務和輸入序列的長度。

- 優化記憶檢索:微調記憶檢索機制,確保從長期記憶模組中有效訪問相關信息。

- 適應現有模型:調整現有的基於Transformer的模型以融入Titans架構。

- 實驗與評估:在多種任務上徹底實驗和評估基於Titans的模型的性能。

通過掌握這些技術,AI開發者可以充分發揮Titans架構的潛力,構建更強大、更高效的AI系統。

Titans架構的優缺點

優點

- 改進長距離依賴的處理。

- 線性擴展降低計算成本。

- 雙記憶系統模擬人腦功能。

- 開啟新的AI應用可能性。

缺點

- 架構複雜性增加。

- 需要仔細的記憶分配和檢索優化。

- 仍處於早期開發階段。

關於Titans架構的常見問題

什麼是Titans架構?

Titans架構是Google開發的一種新穎的AI記憶管理方法。它利用由短期和長期記憶模組組成的雙記憶系統,改善長距離依賴的處理並降低大規模語言模型的計算成本。

Titans架構與傳統Transformer有何不同?

傳統Transformer依賴自注意力,具有二次複雜性,難以處理長序列。Titans架構通過分離短期和長期記憶實現線性擴展,能更有效地處理較長序列。

Titans架構的潛在應用有哪些?

Titans架構在需要長距離依賴分析的領域有潛在應用,如基因組學、金融建模和氣候科學。它還可以提升AI模型在長時間對話、文件分析和程式碼生成中的性能。

使用Titans架構的挑戰是什麼?

使用Titans架構的挑戰包括其架構複雜性增加、需要仔細的記憶分配和檢索優化,以及其相對早期的開發階段。

關於AI記憶與架構的相關問題

Transformer中的注意力機制如何運作?

注意力機制是Transformer模型的關鍵組成部分,使其在處理信息時能夠專注於輸入序列的相關部分。本質上,它為輸入序列中的每個詞(或令牌)分配一個權重,指示其相對於序列中其他詞的重要性。以下是注意力機制在Transformer中的運作方式:

輸入嵌入:輸入序列中的每個詞或令牌首先通過嵌入層轉換為向量表示。這些嵌入作為注意力機制的輸入。

查詢、鍵和值:輸入嵌入被轉換為三個不同的向量:查詢(Q)、鍵(K)和值(V)向量。這些轉換通過線性變換或學習到的權重矩陣進行。數學上:

(Q = text{輸入} cdot W_Q)

(K = text{輸入} cdot W_K)

(V = text{輸入} cdot W_V)

這裡,(W_Q)、(W_K)和(W_V)分別是查詢、鍵和值的學習權重矩陣。

注意力權重計算:注意力權重表示輸入序列中每對詞之間的相關程度。這些權重通過計算查詢向量與每個鍵向量的點積來獲得。所得分數隨後通過鍵向量維度的平方根進行縮放,以穩定訓練。這一縮放防止點積變得過大,從而在訓練期間導致梯度消失。

Softmax正規化:縮放後的點積通過Softmax函數進行正規化,轉換為輸入序列上的概率分佈。這種正規化確保注意力權重總和為1,使其更容易解釋和訓練。

加權和:最後,值向量根據其對應的注意力權重進行加權。這一加權和表示注意力機制的輸出,捕捉了整個輸入序列的相關信息。

注意力機制使Transformer能夠有效處理序列數據,捕捉長距離依賴,並在各種NLP任務中實現最先進的性能。通過動態權衡輸入序列不同部分的重要性,注意力機制使模型能夠專注於最相關的信息,從而提升性能。

OpenAI 修復了 ChatGPT 過度禮貌的錯誤,並解釋了 AI 的缺陷

在有廣泛的報導指出 AI 系統表現出過度的認同,包括對危險或荒謬的使用者建議進行無端讚美之後,OpenAI 針對其旗艦版 GPT-4o 模型進行了最近的人格調整。在緊急撤回之前,人工智能安全專家對會話模型中出現的 「AI 佞幸 」日益關注。背景:有問題的更新在 4 月 29 日的聲明中,OpenAI 解釋更新的目的是讓 GPT-4o 在不同的使用情況下更直覺、更靈活。然而,模型開始展現出令人擔心的

OpenAI 修復了 ChatGPT 過度禮貌的錯誤,並解釋了 AI 的缺陷

在有廣泛的報導指出 AI 系統表現出過度的認同,包括對危險或荒謬的使用者建議進行無端讚美之後,OpenAI 針對其旗艦版 GPT-4o 模型進行了最近的人格調整。在緊急撤回之前,人工智能安全專家對會話模型中出現的 「AI 佞幸 」日益關注。背景:有問題的更新在 4 月 29 日的聲明中,OpenAI 解釋更新的目的是讓 GPT-4o 在不同的使用情況下更直覺、更靈活。然而,模型開始展現出令人擔心的

Piclumen AI 在 2025 年提供免費的 AI 藝術創作

在瞬息萬變的數位內容創作世界中,Piclumen AI 以完全免費的解決方案脫穎而出,成為人工智慧驅動的影像產生工具。此創新平台可讓使用者在沒有經濟障礙的情況下,創造出專業品質的視覺效果,讓所有人都能使用精密的 AI 工具。這份全面的指南將探討 Piclumen AI 的功能,說明它如何與其他優質產品相較,以及如何徹底改變創意工作流程。主要優勢完全免費的 AI 影像產生,無隱藏成本可生成包括名人肖

Piclumen AI 在 2025 年提供免費的 AI 藝術創作

在瞬息萬變的數位內容創作世界中,Piclumen AI 以完全免費的解決方案脫穎而出,成為人工智慧驅動的影像產生工具。此創新平台可讓使用者在沒有經濟障礙的情況下,創造出專業品質的視覺效果,讓所有人都能使用精密的 AI 工具。這份全面的指南將探討 Piclumen AI 的功能,說明它如何與其他優質產品相較,以及如何徹底改變創意工作流程。主要優勢完全免費的 AI 影像產生,無隱藏成本可生成包括名人肖

麻省理工學院推出超越靜態模型的自我學習 AI 架構

麻省理工學院研究人員開創自學人工智能框架麻省理工學院的研究團隊開發了一套名為 SEAL(Self-Adapting Language Models,自適應語言模型)的創新系統,讓大型語言模型能夠自主進化其能力。這項突破使人工智能系統能夠產生自己的訓練材料和學習協議,允許永久整合新知識和技能。SEAL 代表了企業級 AI 應用的重大進步,特別是對於在流動環境中運作的智慧型代理人而言,持續適應是非常重

麻省理工學院推出超越靜態模型的自我學習 AI 架構

麻省理工學院研究人員開創自學人工智能框架麻省理工學院的研究團隊開發了一套名為 SEAL(Self-Adapting Language Models,自適應語言模型)的創新系統,讓大型語言模型能夠自主進化其能力。這項突破使人工智能系統能夠產生自己的訓練材料和學習協議,允許永久整合新知識和技能。SEAL 代表了企業級 AI 應用的重大進步,特別是對於在流動環境中運作的智慧型代理人而言,持續適應是非常重

2025-09-10 10:30:37

2025-09-10 10:30:37

Cette histoire de 'mémoire' des IA me fait toujours sourire. Quand mon chat oublie où il a caché ses jouets, c'est mignon. Quand une IA oublie ce qu'elle vient de lire, ça coûte des millions en R&D... Ironique, non? 😅

0

0

2025-08-10 21:00:59

2025-08-10 21:00:59

This Titans Architecture sounds like a game-changer for AI memory! 🤯 Curious if it'll really solve the context window issue or just hype. Anyone tried it yet?

0

0

2025-08-01 21:47:34

2025-08-01 21:47:34

Wow, this Titans Architecture sounds like a game-changer for AI memory! Can't wait to see how it tackles the context window issue. 🤯

0

0

2025-07-22 15:35:51

2025-07-22 15:35:51

Wow, this Titans Architecture sounds like a game-changer for AI memory! I'm curious how it'll handle massive datasets without forgetting the plot. 😄 Could this finally make LLMs smarter than my goldfish?

0

0