AI内存技术突破:泰坦架构

人工智能世界始终在发展,研究人员不懈努力推动AI能力边界,尤其是大型语言模型(LLMs)。这些模型面临的最大障碍之一是有限的上下文窗口,常导致“遗忘”对话或文档的早期部分。但希望正在浮现——谷歌的Titans架构可能是解决AI短期记忆问题的方案。

关键点

- 传统AI模型常因短期记忆问题受限,限制了上下文窗口。

- 谷歌的Titans架构引入双记忆系统,直接应对这一限制。

- Titans使用短期和长期记忆模块提升性能。

- Titans的长期记忆可处理超过200万个令牌的上下文长度。

- Titans实现线性扩展,降低与transformer二次扩展相关的计算成本。

- 该架构在需要分析长距离依赖的任务中显示出巨大潜力,如基因组学。

理解AI短期记忆的限制

上下文窗口问题

AI需改进的关键领域之一是短期记忆的限制。在AI模型尤其是大型语言模型(LLMs)中,这一限制表现为有限的上下文窗口。可以将其视为AI的注意力跨度——一旦满了,早期信息被挤出,使AI难以保持连贯性并理解长距离依赖。这种短期记忆瓶颈影响多种AI应用,如:

- 长对话: 在多轮对话中保持连贯性成为挑战,AI可能丢失早期话题和引用。

- 文档分析: 处理长文档(如书籍或研究论文)很困难,因为AI在到达文档末尾时难以记住开头信息。

- 代码生成: 在编码任务中,AI可能忘记之前定义的函数或变量,导致错误和低效。

克服这一限制对于创建更可靠、能处理复杂任务的AI模型至关重要,因此Titans等进展令人兴奋。

自注意力的二次复杂性

传统基于transformer的架构(许多现代LLMs的核心)高度依赖自注意力机制。自注意力具有革命性,但计算成本高昂。数学上,自注意力具有二次复杂性。这意味着计算资源需求随输入序列长度呈二次增长。输入长度翻倍,计算成本增加四倍。这一扩展问题在处理长序列时成为主要障碍。

例如,处理1000个令牌的序列可能可行,但扩展到10000个令牌,计算负担增加100倍。即使使用最强大的硬件,这也很快变得不可行。因此,当前基于transformer的模型通常限于较短的上下文窗口,阻碍其有效捕捉长距离依赖。探索像Titans这样的新型架构(可缓解这种复杂性)对AI未来发展至关重要。

Titans:实现长距离依赖分析

解锁新的AI能力

Titans处理更长上下文窗口并实现线性扩展的能力,开启了之前不切实际的多种新AI应用。一个显著领域是长距离依赖分析,其中序列中相距较远的元素之间的关系至关重要。

长距离依赖分析的示例包括:

- 基因组学: 理解基因组内基因之间的关系。基因即使在DNA链上相距较远也能相互作用。Titans架构非常适合捕捉这些复杂关系。

- 金融建模: 分析金融市场的长期趋势和依赖。金融数据常呈现需要考虑长期数据的模式和反馈循环。

- 气候科学: 建模复杂气候系统并预测长期变化。气候模型必须考虑地球系统各组成部分在多年间的相互作用。

在这些领域中,捕捉长距离依赖对于准确预测和获得有价值的见解至关重要。Titans架构为应对这些挑战提供了强大工具,使AI能够处理之前无法企及的问题。

如何使用Titans架构进行AI开发

利用双记忆系统

要有效利用Titans架构,AI开发者需了解如何利用其双记忆系统。这包括:

- 设计输入数据: 准备输入数据以最大化短期和长期记忆分离的好处。

- 平衡内存分配: 仔细考虑为短期和长期模块分配多少内存,具体取决于任务和输入序列长度。

- 优化内存检索: 微调内存检索机制,确保从长期记忆模块高效访问相关信息。

- 适配现有模型: 调整现有基于transformer的模型以融入Titans架构。

- 实验与评估: 在多种任务上彻底实验和评估基于Titans的模型性能。

通过掌握这些技术,AI开发者可充分发挥Titans架构的潜力,构建更强大、更高效的AI系统。

Titans架构的优缺点

优点

- 改进长距离依赖处理。

- 线性扩展降低计算成本。

- 双记忆系统模仿人脑功能。

- 开启新的AI应用潜力。

缺点

- 架构复杂性增加。

- 需要仔细的内存分配和检索优化。

- 仍处于早期开发阶段。

关于Titans架构的常见问题

什么是Titans架构?

Titans架构是谷歌开发的一种新型AI内存管理方法。它利用由短期和长期记忆模块组成的双记忆系统,改善长距离依赖处理并降低大型语言模型的计算成本。

Titans架构与传统transformer有何不同?

传统transformer依赖自注意力,具二次复杂性,难以处理长序列。Titans架构通过分离短期和长期记忆实现线性扩展,能更高效地处理更长序列。

Titans架构的潜在应用有哪些?

Titans架构在需要长距离依赖分析的领域有潜力,如基因组学、金融建模和气候科学。它还能提升AI在长对话、文档分析和代码生成中的性能。

使用Titans架构的挑战是什么?

使用Titans架构的挑战包括架构复杂性增加、需要仔细的内存分配和检索优化,以及其尚处于早期开发阶段。

关于AI内存和架构的相关问题

Transformer中的注意力机制如何工作?

注意力机制是transformer模型的关键组成部分,使其在处理信息时能专注于输入序列的相关部分。本质上,它为输入序列中的每个词(或令牌)分配权重,指示其与其他词的相关重要性。以下是注意力机制在transformer中的工作原理:

输入嵌入: 输入序列中的每个词或令牌通过嵌入层转换为向量表示。这些嵌入作为注意力机制的输入。

查询、键和值: 输入嵌入被转换为三个不同向量:查询(Q)、键(K)和值(V)向量。这些转换通过线性变换或学习权重矩阵完成。数学上:

(Q = text{输入} cdot W_Q)

(K = text{输入} cdot W_K)

(V = text{输入} cdot W_V)

其中,(W_Q)、(W_K)和(W_V)分别是查询、键和值的学习权重矩阵。

注意力权重计算: 注意力权重表示输入序列中每对词的相关程度。通过查询向量与每个键向量点积计算这些权重。所得分数通过键向量维度的平方根缩放,以稳定训练。这防止点积过大,导致训练中梯度消失。

Softmax归一化: 缩放后的点积通过softmax函数归一化为输入序列上的概率分布。这种归一化确保注意力权重总和为1,便于解释和训练。

加权和: 最后,值向量按其对应的注意力权重加权求和。此加权和表示注意力机制的输出,捕捉整个输入序列的相关信息。

注意力机制使Transformer能有效处理序列数据,捕捉长距离依赖,并在多种NLP任务中实现最先进的性能。通过动态加权输入序列不同部分的重要性,注意力机制使模型专注于最相关信息,从而提升性能。

相关文章

OpenAI 修复 ChatGPT 过度礼貌错误,解释人工智能缺陷

OpenAI 最近对其旗舰模型 GPT-4o 进行了性格调整,因为有广泛报道称,该人工智能系统表现出过度的顺从,包括对危险或荒谬的用户建议进行无端赞美。人工智能安全专家对对话模型中出现的 "人工智能谄媚 "现象的担忧与日俱增,在此之前,OpenAI 紧急撤销了这一调整。背景:有问题的更新OpenAI 在 4 月 29 日的声明中解释说,更新的目的是让 GPT-4o 在不同的使用情况下更加直观、反应

OpenAI 修复 ChatGPT 过度礼貌错误,解释人工智能缺陷

OpenAI 最近对其旗舰模型 GPT-4o 进行了性格调整,因为有广泛报道称,该人工智能系统表现出过度的顺从,包括对危险或荒谬的用户建议进行无端赞美。人工智能安全专家对对话模型中出现的 "人工智能谄媚 "现象的担忧与日俱增,在此之前,OpenAI 紧急撤销了这一调整。背景:有问题的更新OpenAI 在 4 月 29 日的声明中解释说,更新的目的是让 GPT-4o 在不同的使用情况下更加直观、反应

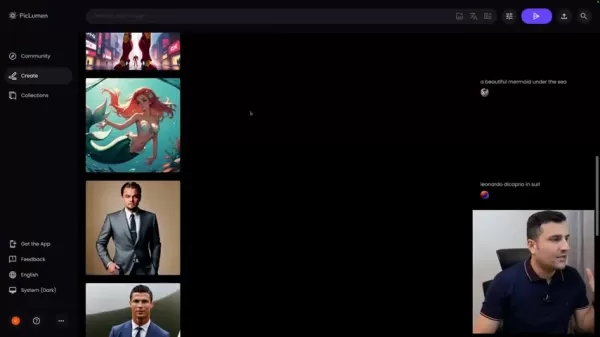

Piclumen AI 在 2025 年提供免费人工智能艺术创作服务

在瞬息万变的数字内容创作领域,Piclumen AI 成为了人工智能图像生成方面的一个杰出的完全免费解决方案。这一创新平台使用户能够在没有经济障碍的情况下创建专业品质的视觉效果,让所有人都能使用复杂的人工智能工具。本综合指南探讨了 Piclumen AI 的功能,展示了它与其他高级产品的比较,以及如何彻底改变创意工作流程。主要优势完全免费的 AI 图像生成,无任何隐藏费用生成包括名人肖像在内的各种

Piclumen AI 在 2025 年提供免费人工智能艺术创作服务

在瞬息万变的数字内容创作领域,Piclumen AI 成为了人工智能图像生成方面的一个杰出的完全免费解决方案。这一创新平台使用户能够在没有经济障碍的情况下创建专业品质的视觉效果,让所有人都能使用复杂的人工智能工具。本综合指南探讨了 Piclumen AI 的功能,展示了它与其他高级产品的比较,以及如何彻底改变创意工作流程。主要优势完全免费的 AI 图像生成,无任何隐藏费用生成包括名人肖像在内的各种

麻省理工学院推出超越静态模型的自学习人工智能框架

麻省理工学院研究人员首创自学习人工智能框架麻省理工学院的一个团队开发出了一种名为 SEAL(自适应语言模型)的创新系统,它能让大型语言模型自主进化其能力。这一突破使人工智能系统能够生成自己的培训材料和学习协议,从而永久性地整合新知识和新技能。SEAL 代表着企业人工智能应用的重大进步,特别是对于在流动环境中运行的智能代理来说,持续适应至关重要。该框架解决了当前 LLM 技术的一个根本性局限--除了

评论 (4)

0/200

麻省理工学院推出超越静态模型的自学习人工智能框架

麻省理工学院研究人员首创自学习人工智能框架麻省理工学院的一个团队开发出了一种名为 SEAL(自适应语言模型)的创新系统,它能让大型语言模型自主进化其能力。这一突破使人工智能系统能够生成自己的培训材料和学习协议,从而永久性地整合新知识和新技能。SEAL 代表着企业人工智能应用的重大进步,特别是对于在流动环境中运行的智能代理来说,持续适应至关重要。该框架解决了当前 LLM 技术的一个根本性局限--除了

评论 (4)

0/200

![JoseDavis]() JoseDavis

JoseDavis

2025-09-10 10:30:37

2025-09-10 10:30:37

Cette histoire de 'mémoire' des IA me fait toujours sourire. Quand mon chat oublie où il a caché ses jouets, c'est mignon. Quand une IA oublie ce qu'elle vient de lire, ça coûte des millions en R&D... Ironique, non? 😅

0

0

![BenLewis]() BenLewis

BenLewis

2025-08-10 21:00:59

2025-08-10 21:00:59

This Titans Architecture sounds like a game-changer for AI memory! 🤯 Curious if it'll really solve the context window issue or just hype. Anyone tried it yet?

0

0

![WillieAdams]() WillieAdams

WillieAdams

2025-08-01 21:47:34

2025-08-01 21:47:34

Wow, this Titans Architecture sounds like a game-changer for AI memory! Can't wait to see how it tackles the context window issue. 🤯

0

0

![LiamCarter]() LiamCarter

LiamCarter

2025-07-22 15:35:51

2025-07-22 15:35:51

Wow, this Titans Architecture sounds like a game-changer for AI memory! I'm curious how it'll handle massive datasets without forgetting the plot. 😄 Could this finally make LLMs smarter than my goldfish?

0

0

人工智能世界始终在发展,研究人员不懈努力推动AI能力边界,尤其是大型语言模型(LLMs)。这些模型面临的最大障碍之一是有限的上下文窗口,常导致“遗忘”对话或文档的早期部分。但希望正在浮现——谷歌的Titans架构可能是解决AI短期记忆问题的方案。

关键点

- 传统AI模型常因短期记忆问题受限,限制了上下文窗口。

- 谷歌的Titans架构引入双记忆系统,直接应对这一限制。

- Titans使用短期和长期记忆模块提升性能。

- Titans的长期记忆可处理超过200万个令牌的上下文长度。

- Titans实现线性扩展,降低与transformer二次扩展相关的计算成本。

- 该架构在需要分析长距离依赖的任务中显示出巨大潜力,如基因组学。

理解AI短期记忆的限制

上下文窗口问题

AI需改进的关键领域之一是短期记忆的限制。在AI模型尤其是大型语言模型(LLMs)中,这一限制表现为有限的上下文窗口。可以将其视为AI的注意力跨度——一旦满了,早期信息被挤出,使AI难以保持连贯性并理解长距离依赖。这种短期记忆瓶颈影响多种AI应用,如:

- 长对话: 在多轮对话中保持连贯性成为挑战,AI可能丢失早期话题和引用。

- 文档分析: 处理长文档(如书籍或研究论文)很困难,因为AI在到达文档末尾时难以记住开头信息。

- 代码生成: 在编码任务中,AI可能忘记之前定义的函数或变量,导致错误和低效。

克服这一限制对于创建更可靠、能处理复杂任务的AI模型至关重要,因此Titans等进展令人兴奋。

自注意力的二次复杂性

传统基于transformer的架构(许多现代LLMs的核心)高度依赖自注意力机制。自注意力具有革命性,但计算成本高昂。数学上,自注意力具有二次复杂性。这意味着计算资源需求随输入序列长度呈二次增长。输入长度翻倍,计算成本增加四倍。这一扩展问题在处理长序列时成为主要障碍。

例如,处理1000个令牌的序列可能可行,但扩展到10000个令牌,计算负担增加100倍。即使使用最强大的硬件,这也很快变得不可行。因此,当前基于transformer的模型通常限于较短的上下文窗口,阻碍其有效捕捉长距离依赖。探索像Titans这样的新型架构(可缓解这种复杂性)对AI未来发展至关重要。

Titans:实现长距离依赖分析

解锁新的AI能力

Titans处理更长上下文窗口并实现线性扩展的能力,开启了之前不切实际的多种新AI应用。一个显著领域是长距离依赖分析,其中序列中相距较远的元素之间的关系至关重要。

长距离依赖分析的示例包括:

- 基因组学: 理解基因组内基因之间的关系。基因即使在DNA链上相距较远也能相互作用。Titans架构非常适合捕捉这些复杂关系。

- 金融建模: 分析金融市场的长期趋势和依赖。金融数据常呈现需要考虑长期数据的模式和反馈循环。

- 气候科学: 建模复杂气候系统并预测长期变化。气候模型必须考虑地球系统各组成部分在多年间的相互作用。

在这些领域中,捕捉长距离依赖对于准确预测和获得有价值的见解至关重要。Titans架构为应对这些挑战提供了强大工具,使AI能够处理之前无法企及的问题。

如何使用Titans架构进行AI开发

利用双记忆系统

要有效利用Titans架构,AI开发者需了解如何利用其双记忆系统。这包括:

- 设计输入数据: 准备输入数据以最大化短期和长期记忆分离的好处。

- 平衡内存分配: 仔细考虑为短期和长期模块分配多少内存,具体取决于任务和输入序列长度。

- 优化内存检索: 微调内存检索机制,确保从长期记忆模块高效访问相关信息。

- 适配现有模型: 调整现有基于transformer的模型以融入Titans架构。

- 实验与评估: 在多种任务上彻底实验和评估基于Titans的模型性能。

通过掌握这些技术,AI开发者可充分发挥Titans架构的潜力,构建更强大、更高效的AI系统。

Titans架构的优缺点

优点

- 改进长距离依赖处理。

- 线性扩展降低计算成本。

- 双记忆系统模仿人脑功能。

- 开启新的AI应用潜力。

缺点

- 架构复杂性增加。

- 需要仔细的内存分配和检索优化。

- 仍处于早期开发阶段。

关于Titans架构的常见问题

什么是Titans架构?

Titans架构是谷歌开发的一种新型AI内存管理方法。它利用由短期和长期记忆模块组成的双记忆系统,改善长距离依赖处理并降低大型语言模型的计算成本。

Titans架构与传统transformer有何不同?

传统transformer依赖自注意力,具二次复杂性,难以处理长序列。Titans架构通过分离短期和长期记忆实现线性扩展,能更高效地处理更长序列。

Titans架构的潜在应用有哪些?

Titans架构在需要长距离依赖分析的领域有潜力,如基因组学、金融建模和气候科学。它还能提升AI在长对话、文档分析和代码生成中的性能。

使用Titans架构的挑战是什么?

使用Titans架构的挑战包括架构复杂性增加、需要仔细的内存分配和检索优化,以及其尚处于早期开发阶段。

关于AI内存和架构的相关问题

Transformer中的注意力机制如何工作?

注意力机制是transformer模型的关键组成部分,使其在处理信息时能专注于输入序列的相关部分。本质上,它为输入序列中的每个词(或令牌)分配权重,指示其与其他词的相关重要性。以下是注意力机制在transformer中的工作原理:

输入嵌入: 输入序列中的每个词或令牌通过嵌入层转换为向量表示。这些嵌入作为注意力机制的输入。

查询、键和值: 输入嵌入被转换为三个不同向量:查询(Q)、键(K)和值(V)向量。这些转换通过线性变换或学习权重矩阵完成。数学上:

(Q = text{输入} cdot W_Q)

(K = text{输入} cdot W_K)

(V = text{输入} cdot W_V)

其中,(W_Q)、(W_K)和(W_V)分别是查询、键和值的学习权重矩阵。

注意力权重计算: 注意力权重表示输入序列中每对词的相关程度。通过查询向量与每个键向量点积计算这些权重。所得分数通过键向量维度的平方根缩放,以稳定训练。这防止点积过大,导致训练中梯度消失。

Softmax归一化: 缩放后的点积通过softmax函数归一化为输入序列上的概率分布。这种归一化确保注意力权重总和为1,便于解释和训练。

加权和: 最后,值向量按其对应的注意力权重加权求和。此加权和表示注意力机制的输出,捕捉整个输入序列的相关信息。

注意力机制使Transformer能有效处理序列数据,捕捉长距离依赖,并在多种NLP任务中实现最先进的性能。通过动态加权输入序列不同部分的重要性,注意力机制使模型专注于最相关信息,从而提升性能。

OpenAI 修复 ChatGPT 过度礼貌错误,解释人工智能缺陷

OpenAI 最近对其旗舰模型 GPT-4o 进行了性格调整,因为有广泛报道称,该人工智能系统表现出过度的顺从,包括对危险或荒谬的用户建议进行无端赞美。人工智能安全专家对对话模型中出现的 "人工智能谄媚 "现象的担忧与日俱增,在此之前,OpenAI 紧急撤销了这一调整。背景:有问题的更新OpenAI 在 4 月 29 日的声明中解释说,更新的目的是让 GPT-4o 在不同的使用情况下更加直观、反应

OpenAI 修复 ChatGPT 过度礼貌错误,解释人工智能缺陷

OpenAI 最近对其旗舰模型 GPT-4o 进行了性格调整,因为有广泛报道称,该人工智能系统表现出过度的顺从,包括对危险或荒谬的用户建议进行无端赞美。人工智能安全专家对对话模型中出现的 "人工智能谄媚 "现象的担忧与日俱增,在此之前,OpenAI 紧急撤销了这一调整。背景:有问题的更新OpenAI 在 4 月 29 日的声明中解释说,更新的目的是让 GPT-4o 在不同的使用情况下更加直观、反应

Piclumen AI 在 2025 年提供免费人工智能艺术创作服务

在瞬息万变的数字内容创作领域,Piclumen AI 成为了人工智能图像生成方面的一个杰出的完全免费解决方案。这一创新平台使用户能够在没有经济障碍的情况下创建专业品质的视觉效果,让所有人都能使用复杂的人工智能工具。本综合指南探讨了 Piclumen AI 的功能,展示了它与其他高级产品的比较,以及如何彻底改变创意工作流程。主要优势完全免费的 AI 图像生成,无任何隐藏费用生成包括名人肖像在内的各种

Piclumen AI 在 2025 年提供免费人工智能艺术创作服务

在瞬息万变的数字内容创作领域,Piclumen AI 成为了人工智能图像生成方面的一个杰出的完全免费解决方案。这一创新平台使用户能够在没有经济障碍的情况下创建专业品质的视觉效果,让所有人都能使用复杂的人工智能工具。本综合指南探讨了 Piclumen AI 的功能,展示了它与其他高级产品的比较,以及如何彻底改变创意工作流程。主要优势完全免费的 AI 图像生成,无任何隐藏费用生成包括名人肖像在内的各种

麻省理工学院推出超越静态模型的自学习人工智能框架

麻省理工学院研究人员首创自学习人工智能框架麻省理工学院的一个团队开发出了一种名为 SEAL(自适应语言模型)的创新系统,它能让大型语言模型自主进化其能力。这一突破使人工智能系统能够生成自己的培训材料和学习协议,从而永久性地整合新知识和新技能。SEAL 代表着企业人工智能应用的重大进步,特别是对于在流动环境中运行的智能代理来说,持续适应至关重要。该框架解决了当前 LLM 技术的一个根本性局限--除了

麻省理工学院推出超越静态模型的自学习人工智能框架

麻省理工学院研究人员首创自学习人工智能框架麻省理工学院的一个团队开发出了一种名为 SEAL(自适应语言模型)的创新系统,它能让大型语言模型自主进化其能力。这一突破使人工智能系统能够生成自己的培训材料和学习协议,从而永久性地整合新知识和新技能。SEAL 代表着企业人工智能应用的重大进步,特别是对于在流动环境中运行的智能代理来说,持续适应至关重要。该框架解决了当前 LLM 技术的一个根本性局限--除了

2025-09-10 10:30:37

2025-09-10 10:30:37

Cette histoire de 'mémoire' des IA me fait toujours sourire. Quand mon chat oublie où il a caché ses jouets, c'est mignon. Quand une IA oublie ce qu'elle vient de lire, ça coûte des millions en R&D... Ironique, non? 😅

0

0

2025-08-10 21:00:59

2025-08-10 21:00:59

This Titans Architecture sounds like a game-changer for AI memory! 🤯 Curious if it'll really solve the context window issue or just hype. Anyone tried it yet?

0

0

2025-08-01 21:47:34

2025-08-01 21:47:34

Wow, this Titans Architecture sounds like a game-changer for AI memory! Can't wait to see how it tackles the context window issue. 🤯

0

0

2025-07-22 15:35:51

2025-07-22 15:35:51

Wow, this Titans Architecture sounds like a game-changer for AI memory! I'm curious how it'll handle massive datasets without forgetting the plot. 😄 Could this finally make LLMs smarter than my goldfish?

0

0