Le mode vocal d'Openai se déroule maintenant à tous les abonnés Chatgpt - priorité donnée aux utilisateurs premium

Le mode vocal avancé très attendu d'OpenAI, mis en avant lors de leur événement de lancement printanier, est enfin sorti de la phase alpha et est désormais accessible à tous les utilisateurs de ChatGPT Plus et Team. Cette mise à jour excitante a été annoncée par OpenAI mardi, marquant le début d'un déploiement progressif qui promet de transformer l'expérience d'interaction vocale.

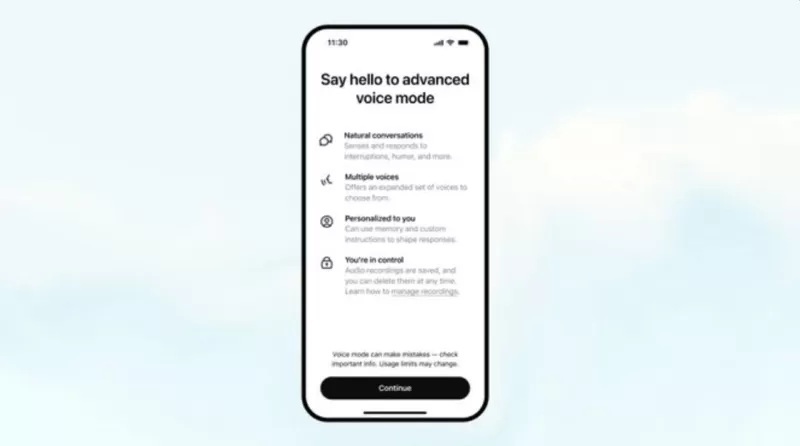

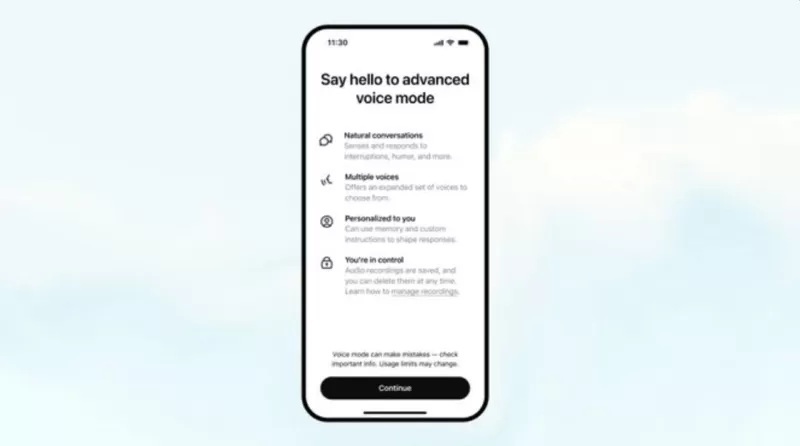

Le mode vocal avancé introduit un assistant vocal plus intelligent, capable d'être interrompu et de répondre aux émotions des utilisateurs, améliorant ainsi la fluidité des conversations. Parallèlement, OpenAI déploie cinq nouvelles voix — Arbor, Maple, Sol, Spruce et Vale — disponibles à la fois en mode vocal standard et avancé. Ces ajouts sont conçus pour offrir une interaction plus personnalisée et engageante.

Le mode vocal avancé est déployé pour tous les utilisateurs Plus et Team dans l'application ChatGPT au cours de la semaine.

Pendant que vous attendiez patiemment, nous avons ajouté des instructions personnalisées, une mémoire, cinq nouvelles voix et des accents améliorés.

Il peut aussi dire « Désolé, je suis en retard » dans plus de 50 langues. pic.twitter.com/APOqqhXtDg

— OpenAI (@OpenAI) 24 septembre 2024

Le déploiement se concentrera initialement sur les utilisateurs de ChatGPT Plus et Team, avec des plans pour étendre l'accès aux niveaux Enterprise et Edu la semaine prochaine. Les utilisateurs recevront une notification via un message contextuel à côté de l'option de mode vocal dans l'interface de ChatGPT, indiquant leur accès à cette fonctionnalité.

Depuis la version alpha en juillet, OpenAI a travaillé dur pour affiner le mode vocal avancé. Les améliorations incluent des accents optimisés dans les langues étrangères et des vitesses de conversation plus fluides. Visuellement, le mode présente désormais une sphère bleue animée, ajoutant une touche de fraîcheur à l'interface.

Pour personnaliser davantage l'expérience, le mode vocal avancé intègre désormais des instructions personnalisées et une mémoire. Ces fonctionnalités permettent à l'assistant vocal de prendre en compte des critères spécifiques à l'utilisateur, offrant des réponses plus pertinentes et personnalisées.

Cependant, une limitation persiste depuis la version alpha : les utilisateurs ne pourront pas utiliser les capacités multimodales du mode vocal, telles que l'assistance au contenu de l'écran ou l'utilisation de la caméra du téléphone pour des réponses contextuelles, comme démontré dans la vidéo ci-dessous.

OpenAI a pris des mesures approfondies pour garantir la sécurité des capacités vocales, en les testant avec plus de 100 testeurs externes spécialisés dans 45 langues. En août, l'entreprise a publié sa carte système GPT-4o, un rapport détaillé sur la sécurité du LLM basé sur des évaluations des risques, des tests externes spécialisés, et plus encore, incluant des évaluations du mode vocal avancé.

Pour accéder au mode vocal avancé, vous pouvez souscrire à ChatGPT Plus pour 20 $ par mois. Cet abonnement donne non seulement accès à la nouvelle fonctionnalité vocale, mais offre également des avantages supplémentaires tels que l'analyse avancée des données, la génération illimitée d'images, cinq fois plus de messages pour GPT-4o, et la possibilité de créer des GPT personnalisés.

Fait intéressant, juste une semaine après qu'OpenAI a dévoilé le mode vocal avancé en mai, Google a introduit une fonctionnalité similaire appelée Gemini Live. Cet assistant vocal conversationnel, alimenté par des LLM, vise à améliorer la fluidité et la compréhension des conversations. Plus tôt ce mois-ci, Google a rendu Gemini Live disponible gratuitement pour tous les utilisateurs Android, offrant une alternative pour ceux intéressés par une technologie d'assistant vocal similaire sans avoir besoin d'un abonnement payant.

Article connexe

Apple dévoile une stratégie audacieuse sur trois ans pour l'iPhone afin de renouveler sa gamme de produits

Apple semble sur le point de présenter un iPhone Air révolutionnaire le mois prochain, marquant une rupture significative avec la tendance récente de l'entreprise à procéder à des mises à jour incréme

Apple dévoile une stratégie audacieuse sur trois ans pour l'iPhone afin de renouveler sa gamme de produits

Apple semble sur le point de présenter un iPhone Air révolutionnaire le mois prochain, marquant une rupture significative avec la tendance récente de l'entreprise à procéder à des mises à jour incréme

Pourquoi la plupart des rédacteurs de contenu pour l'IA échouent - et les meilleures alternatives à utiliser

Dans l'environnement concurrentiel actuel du marketing numérique, l'intelligence artificielle est devenue une composante essentielle des stratégies de référencement efficaces. Cependant, de nombreuses

Pourquoi la plupart des rédacteurs de contenu pour l'IA échouent - et les meilleures alternatives à utiliser

Dans l'environnement concurrentiel actuel du marketing numérique, l'intelligence artificielle est devenue une composante essentielle des stratégies de référencement efficaces. Cependant, de nombreuses

Créer des modèles 3D à partir d'images simples avec Python AI en quelques étapes simples

La possibilité de transformer des images 2D en modèles 3D ouvre des perspectives considérables dans de nombreux secteurs d'activité. Ce guide examine comment les puissantes capacités d'IA et de traite

commentaires (24)

0/200

Créer des modèles 3D à partir d'images simples avec Python AI en quelques étapes simples

La possibilité de transformer des images 2D en modèles 3D ouvre des perspectives considérables dans de nombreux secteurs d'activité. Ce guide examine comment les puissantes capacités d'IA et de traite

commentaires (24)

0/200

![FredAllen]() FredAllen

FredAllen

21 septembre 2025 06:30:31 UTC+02:00

21 septembre 2025 06:30:31 UTC+02:00

¡Por fin! Llevaba semanas esperando probar el modo de voz avanzado de ChatGPT 😍 Aunque no soy usuario premium, espero que llegue pronto a mi cuenta. ¿Alguien ya lo ha probado? ¿Vale la pena la espera o es mejor seguir usando otras alternativas como Gemini?

0

0

![StevenGonzalez]() StevenGonzalez

StevenGonzalez

12 septembre 2025 22:30:34 UTC+02:00

12 septembre 2025 22:30:34 UTC+02:00

오늘 보이스 모드 테스트 해봤는데, 목소리가 너무 자연스러워서 놀랐어요! 😲 근데 프리미엄 유저에게 우선 배포한다니... 무료 사용자들은 언제쯤 쓸 수 있을지 궁금하네요. 가격 인상 얘기도 있는데 걱정돼요.

0

0

![NicholasThomas]() NicholasThomas

NicholasThomas

23 juillet 2025 10:50:48 UTC+02:00

23 juillet 2025 10:50:48 UTC+02:00

Wow, voice mode for all ChatGPT subscribers? That's a game-changer! Can't wait to try it out and see how it stacks up against other AI assistants. 😎

0

0

![JackMitchell]() JackMitchell

JackMitchell

23 juillet 2025 06:59:29 UTC+02:00

23 juillet 2025 06:59:29 UTC+02:00

Wow, voice mode for all ChatGPT subscribers is a game-changer! I’m stoked to try it out, but I wonder how it stacks up against other AI voice assistants. Anyone tested it yet? 😎

0

0

![GregoryRoberts]() GregoryRoberts

GregoryRoberts

15 avril 2025 11:55:52 UTC+02:00

15 avril 2025 11:55:52 UTC+02:00

Finally got access to the voice mode on ChatGPT! It’s super cool and works surprisingly well. A bit pricey for non-premium users though 😅

0

0

![WalterWalker]() WalterWalker

WalterWalker

15 avril 2025 11:11:46 UTC+02:00

15 avril 2025 11:11:46 UTC+02:00

OpenAIのVoice Modeを試してみました!結構クールですが、もっと速くなるといいですね。声が自然なのが大きなプラスです。プレミアムユーザーなので早めにアクセスできましたが、完璧になる前にもう少し磨きが必要だと思います。それでも、正しい方向への一歩ですね!🎤

0

0

Le mode vocal avancé très attendu d'OpenAI, mis en avant lors de leur événement de lancement printanier, est enfin sorti de la phase alpha et est désormais accessible à tous les utilisateurs de ChatGPT Plus et Team. Cette mise à jour excitante a été annoncée par OpenAI mardi, marquant le début d'un déploiement progressif qui promet de transformer l'expérience d'interaction vocale.

Le mode vocal avancé introduit un assistant vocal plus intelligent, capable d'être interrompu et de répondre aux émotions des utilisateurs, améliorant ainsi la fluidité des conversations. Parallèlement, OpenAI déploie cinq nouvelles voix — Arbor, Maple, Sol, Spruce et Vale — disponibles à la fois en mode vocal standard et avancé. Ces ajouts sont conçus pour offrir une interaction plus personnalisée et engageante.

Le mode vocal avancé est déployé pour tous les utilisateurs Plus et Team dans l'application ChatGPT au cours de la semaine.

Pendant que vous attendiez patiemment, nous avons ajouté des instructions personnalisées, une mémoire, cinq nouvelles voix et des accents améliorés.

Il peut aussi dire « Désolé, je suis en retard » dans plus de 50 langues. pic.twitter.com/APOqqhXtDg— OpenAI (@OpenAI) 24 septembre 2024

Le déploiement se concentrera initialement sur les utilisateurs de ChatGPT Plus et Team, avec des plans pour étendre l'accès aux niveaux Enterprise et Edu la semaine prochaine. Les utilisateurs recevront une notification via un message contextuel à côté de l'option de mode vocal dans l'interface de ChatGPT, indiquant leur accès à cette fonctionnalité.

Depuis la version alpha en juillet, OpenAI a travaillé dur pour affiner le mode vocal avancé. Les améliorations incluent des accents optimisés dans les langues étrangères et des vitesses de conversation plus fluides. Visuellement, le mode présente désormais une sphère bleue animée, ajoutant une touche de fraîcheur à l'interface.

Pour personnaliser davantage l'expérience, le mode vocal avancé intègre désormais des instructions personnalisées et une mémoire. Ces fonctionnalités permettent à l'assistant vocal de prendre en compte des critères spécifiques à l'utilisateur, offrant des réponses plus pertinentes et personnalisées.

Cependant, une limitation persiste depuis la version alpha : les utilisateurs ne pourront pas utiliser les capacités multimodales du mode vocal, telles que l'assistance au contenu de l'écran ou l'utilisation de la caméra du téléphone pour des réponses contextuelles, comme démontré dans la vidéo ci-dessous.

OpenAI a pris des mesures approfondies pour garantir la sécurité des capacités vocales, en les testant avec plus de 100 testeurs externes spécialisés dans 45 langues. En août, l'entreprise a publié sa carte système GPT-4o, un rapport détaillé sur la sécurité du LLM basé sur des évaluations des risques, des tests externes spécialisés, et plus encore, incluant des évaluations du mode vocal avancé.Pour accéder au mode vocal avancé, vous pouvez souscrire à ChatGPT Plus pour 20 $ par mois. Cet abonnement donne non seulement accès à la nouvelle fonctionnalité vocale, mais offre également des avantages supplémentaires tels que l'analyse avancée des données, la génération illimitée d'images, cinq fois plus de messages pour GPT-4o, et la possibilité de créer des GPT personnalisés.

Fait intéressant, juste une semaine après qu'OpenAI a dévoilé le mode vocal avancé en mai, Google a introduit une fonctionnalité similaire appelée Gemini Live. Cet assistant vocal conversationnel, alimenté par des LLM, vise à améliorer la fluidité et la compréhension des conversations. Plus tôt ce mois-ci, Google a rendu Gemini Live disponible gratuitement pour tous les utilisateurs Android, offrant une alternative pour ceux intéressés par une technologie d'assistant vocal similaire sans avoir besoin d'un abonnement payant.

Apple dévoile une stratégie audacieuse sur trois ans pour l'iPhone afin de renouveler sa gamme de produits

Apple semble sur le point de présenter un iPhone Air révolutionnaire le mois prochain, marquant une rupture significative avec la tendance récente de l'entreprise à procéder à des mises à jour incréme

Apple dévoile une stratégie audacieuse sur trois ans pour l'iPhone afin de renouveler sa gamme de produits

Apple semble sur le point de présenter un iPhone Air révolutionnaire le mois prochain, marquant une rupture significative avec la tendance récente de l'entreprise à procéder à des mises à jour incréme

Pourquoi la plupart des rédacteurs de contenu pour l'IA échouent - et les meilleures alternatives à utiliser

Dans l'environnement concurrentiel actuel du marketing numérique, l'intelligence artificielle est devenue une composante essentielle des stratégies de référencement efficaces. Cependant, de nombreuses

Pourquoi la plupart des rédacteurs de contenu pour l'IA échouent - et les meilleures alternatives à utiliser

Dans l'environnement concurrentiel actuel du marketing numérique, l'intelligence artificielle est devenue une composante essentielle des stratégies de référencement efficaces. Cependant, de nombreuses

Créer des modèles 3D à partir d'images simples avec Python AI en quelques étapes simples

La possibilité de transformer des images 2D en modèles 3D ouvre des perspectives considérables dans de nombreux secteurs d'activité. Ce guide examine comment les puissantes capacités d'IA et de traite

Créer des modèles 3D à partir d'images simples avec Python AI en quelques étapes simples

La possibilité de transformer des images 2D en modèles 3D ouvre des perspectives considérables dans de nombreux secteurs d'activité. Ce guide examine comment les puissantes capacités d'IA et de traite

21 septembre 2025 06:30:31 UTC+02:00

21 septembre 2025 06:30:31 UTC+02:00

¡Por fin! Llevaba semanas esperando probar el modo de voz avanzado de ChatGPT 😍 Aunque no soy usuario premium, espero que llegue pronto a mi cuenta. ¿Alguien ya lo ha probado? ¿Vale la pena la espera o es mejor seguir usando otras alternativas como Gemini?

0

0

12 septembre 2025 22:30:34 UTC+02:00

12 septembre 2025 22:30:34 UTC+02:00

오늘 보이스 모드 테스트 해봤는데, 목소리가 너무 자연스러워서 놀랐어요! 😲 근데 프리미엄 유저에게 우선 배포한다니... 무료 사용자들은 언제쯤 쓸 수 있을지 궁금하네요. 가격 인상 얘기도 있는데 걱정돼요.

0

0

23 juillet 2025 10:50:48 UTC+02:00

23 juillet 2025 10:50:48 UTC+02:00

Wow, voice mode for all ChatGPT subscribers? That's a game-changer! Can't wait to try it out and see how it stacks up against other AI assistants. 😎

0

0

23 juillet 2025 06:59:29 UTC+02:00

23 juillet 2025 06:59:29 UTC+02:00

Wow, voice mode for all ChatGPT subscribers is a game-changer! I’m stoked to try it out, but I wonder how it stacks up against other AI voice assistants. Anyone tested it yet? 😎

0

0

15 avril 2025 11:55:52 UTC+02:00

15 avril 2025 11:55:52 UTC+02:00

Finally got access to the voice mode on ChatGPT! It’s super cool and works surprisingly well. A bit pricey for non-premium users though 😅

0

0

15 avril 2025 11:11:46 UTC+02:00

15 avril 2025 11:11:46 UTC+02:00

OpenAIのVoice Modeを試してみました!結構クールですが、もっと速くなるといいですね。声が自然なのが大きなプラスです。プレミアムユーザーなので早めにアクセスできましたが、完璧になる前にもう少し磨きが必要だと思います。それでも、正しい方向への一歩ですね!🎤

0

0