Der Sprachmodus von OpenAI, der jetzt an alle Chatgpt -Abonnenten gilt - Priorität für Premium -Nutzer

htmlOpenAIs lang erwarteter fortschrittlicher Sprachmodus, der während ihres Frühjahrs-Launch-Events hervorgehoben wurde, hat endlich die Alpha-Phase verlassen und ist nun für alle ChatGPT Plus- und Team-Nutzer zugänglich. Diese aufregende Aktualisierung wurde am Dienstag von OpenAI angekündigt und markiert den Beginn einer schrittweisen Einführung, die das Erlebnis der Sprachinteraktion transformieren verspricht.

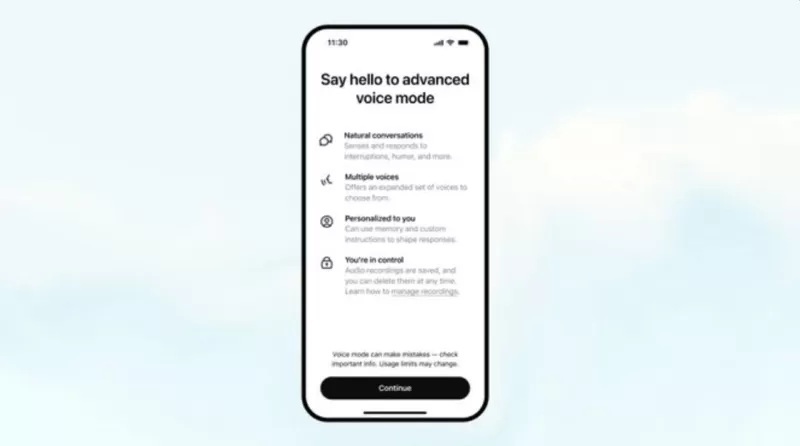

Der fortschrittliche Sprachmodus führt einen intelligenteren Sprachassistenten ein, der unterbrochen werden kann und auf die Emotionen der Nutzer reagiert, was den Gesprächsfluss verbessert. Parallel dazu führt OpenAI fünf neue Stimmen ein – Arbor, Maple, Sol, Spruce und Vale –, die sowohl im Standard- als auch im fortschrittlichen Sprachmodus verfügbar sind. Diese Ergänzungen sollen eine persönlichere und ansprechendere Interaktion ermöglichen.

> Der fortschrittliche Sprachmodus wird im Laufe der Woche für alle Plus- und Team-Nutzer in der ChatGPT-App ausgerollt.

> Während ihr geduldig gewartet habt, haben wir benutzerdefinierte Anweisungen, Gedächtnis, fünf neue Stimmen und verbesserte Akzente hinzugefügt.

> Er kann auch „Entschuldigung, ich bin spät dran“ in über 50 Sprachen sagen. pic.twitter.com/APOqqhXtDg

>

> — OpenAI (@OpenAI) 24. September 2024

Die Einführung konzentriert sich zunächst auf ChatGPT Plus- und Team-Nutzer, mit Plänen, den Zugang in der nächsten Woche auf Enterprise- und Edu-Stufen auszudehnen. Nutzer erhalten eine Benachrichtigung über eine Pop-up-Nachricht neben der Sprachmodus-Option in der ChatGPT-Oberfläche, die ihren Zugang zu dieser Funktion anzeigt.

Seit der Alpha-Veröffentlichung im Juli hat OpenAI intensiv daran gearbeitet, den fortschrittlichen Sprachmodus zu verfeinern. Verbesserungen umfassen verbesserte Akzente in Fremdsprachen und flüssigere Gesprächsgeschwindigkeiten. Visuell verfügt der Modus nun über eine animierte blaue Kugel, die der Benutzeroberfläche eine frische Note verleiht.

Um das Erlebnis weiter zu personalisieren, integriert der fortschrittliche Sprachmodus nun benutzerdefinierte Anweisungen und Gedächtnis. Diese Funktionen ermöglichen es dem Sprachassistenten, nutzerspezifische Kriterien zu berücksichtigen, was zu relevanteren und personalisierten Antworten führt.

Eine Einschränkung aus der Alpha-Version bleibt jedoch bestehen: Nutzer können die multimodalen Fähigkeiten des Sprachmodus, wie die Unterstützung bei Bildschirminhalten oder die Nutzung der Telefonkamera für kontextbezogene Antworten, wie im folgenden Video gezeigt, nicht nutzen.

Um den fortschrittlichen Sprachmodus zu nutzen, können Sie ChatGPT Plus für 20 US-Dollar pro Monat abonnieren. Dieses Abonnement gewährt nicht nur Zugang zur neuen Sprachfunktion, sondern bietet auch zusätzliche Vorteile wie fortschrittliche Datenanalyse, unbegrenzte Bildgenerierung, fünfmal mehr Nachrichten für GPT-4o und die Möglichkeit, benutzerdefinierte GPTs zu erstellen.

Interessanterweise hat Google nur eine Woche nach der Vorstellung des fortschrittlichen Sprachmodus von OpenAI im Mai eine ähnliche Funktion namens Gemini Live eingeführt. Dieser konversationelle Sprachassistent, der von LLMs unterstützt wird, zielt darauf ab, den Gesprächsfluss und das Verständnis zu verbessern. Anfang dieses Monats machte Google Gemini Live kostenlos für alle Android-Nutzer verfügbar und bietet damit eine Alternative für diejenigen, die an ähnlicher Sprachassistenten-Technologie interessiert sind, ohne ein kostenpflichtiges Abonnement abschließen zu müssen.

Verwandter Artikel

Apple stellt kühne 3-Jahres-Strategie für die Erneuerung der iPhone-Produktlinie vor

Apple scheint bereit zu sein, im nächsten Monat ein revolutionäres iPhone Air vorzustellen, was eine deutliche Abkehr vom bisherigen Muster der inkrementellen Updates des Unternehmens darstellt. Diese

Apple stellt kühne 3-Jahres-Strategie für die Erneuerung der iPhone-Produktlinie vor

Apple scheint bereit zu sein, im nächsten Monat ein revolutionäres iPhone Air vorzustellen, was eine deutliche Abkehr vom bisherigen Muster der inkrementellen Updates des Unternehmens darstellt. Diese

Warum die meisten AI SEO Content Writers scheitern - und die besten Alternativen zu verwenden

In der heutigen wettbewerbsintensiven digitalen Marketingumgebung ist künstliche Intelligenz ein wesentlicher Bestandteil effektiver SEO-Strategien geworden. Viele Unternehmen stellen jedoch fest, das

Warum die meisten AI SEO Content Writers scheitern - und die besten Alternativen zu verwenden

In der heutigen wettbewerbsintensiven digitalen Marketingumgebung ist künstliche Intelligenz ein wesentlicher Bestandteil effektiver SEO-Strategien geworden. Viele Unternehmen stellen jedoch fest, das

Erstellen von 3D-Modellen aus einzelnen Bildern mit Python AI in einfachen Schritten

Die Fähigkeit, 2D-Bilder in 3D-Modelle umzuwandeln, birgt ein enormes Potenzial für zahlreiche Branchen. In diesem Leitfaden wird untersucht, wie die leistungsstarken KI- und 3D-Verarbeitungsfunktione

Kommentare (24)

0/200

Erstellen von 3D-Modellen aus einzelnen Bildern mit Python AI in einfachen Schritten

Die Fähigkeit, 2D-Bilder in 3D-Modelle umzuwandeln, birgt ein enormes Potenzial für zahlreiche Branchen. In diesem Leitfaden wird untersucht, wie die leistungsstarken KI- und 3D-Verarbeitungsfunktione

Kommentare (24)

0/200

![FredAllen]() FredAllen

FredAllen

21. September 2025 06:30:31 MESZ

21. September 2025 06:30:31 MESZ

¡Por fin! Llevaba semanas esperando probar el modo de voz avanzado de ChatGPT 😍 Aunque no soy usuario premium, espero que llegue pronto a mi cuenta. ¿Alguien ya lo ha probado? ¿Vale la pena la espera o es mejor seguir usando otras alternativas como Gemini?

0

0

![StevenGonzalez]() StevenGonzalez

StevenGonzalez

12. September 2025 22:30:34 MESZ

12. September 2025 22:30:34 MESZ

오늘 보이스 모드 테스트 해봤는데, 목소리가 너무 자연스러워서 놀랐어요! 😲 근데 프리미엄 유저에게 우선 배포한다니... 무료 사용자들은 언제쯤 쓸 수 있을지 궁금하네요. 가격 인상 얘기도 있는데 걱정돼요.

0

0

![NicholasThomas]() NicholasThomas

NicholasThomas

23. Juli 2025 10:50:48 MESZ

23. Juli 2025 10:50:48 MESZ

Wow, voice mode for all ChatGPT subscribers? That's a game-changer! Can't wait to try it out and see how it stacks up against other AI assistants. 😎

0

0

![JackMitchell]() JackMitchell

JackMitchell

23. Juli 2025 06:59:29 MESZ

23. Juli 2025 06:59:29 MESZ

Wow, voice mode for all ChatGPT subscribers is a game-changer! I’m stoked to try it out, but I wonder how it stacks up against other AI voice assistants. Anyone tested it yet? 😎

0

0

![GregoryRoberts]() GregoryRoberts

GregoryRoberts

15. April 2025 11:55:52 MESZ

15. April 2025 11:55:52 MESZ

Finally got access to the voice mode on ChatGPT! It’s super cool and works surprisingly well. A bit pricey for non-premium users though 😅

0

0

![WalterWalker]() WalterWalker

WalterWalker

15. April 2025 11:11:46 MESZ

15. April 2025 11:11:46 MESZ

OpenAIのVoice Modeを試してみました!結構クールですが、もっと速くなるといいですね。声が自然なのが大きなプラスです。プレミアムユーザーなので早めにアクセスできましたが、完璧になる前にもう少し磨きが必要だと思います。それでも、正しい方向への一歩ですね!🎤

0

0

OpenAIs lang erwarteter fortschrittlicher Sprachmodus, der während ihres Frühjahrs-Launch-Events hervorgehoben wurde, hat endlich die Alpha-Phase verlassen und ist nun für alle ChatGPT Plus- und Team-Nutzer zugänglich. Diese aufregende Aktualisierung wurde am Dienstag von OpenAI angekündigt und markiert den Beginn einer schrittweisen Einführung, die das Erlebnis der Sprachinteraktion transformieren verspricht.

Der fortschrittliche Sprachmodus führt einen intelligenteren Sprachassistenten ein, der unterbrochen werden kann und auf die Emotionen der Nutzer reagiert, was den Gesprächsfluss verbessert. Parallel dazu führt OpenAI fünf neue Stimmen ein – Arbor, Maple, Sol, Spruce und Vale –, die sowohl im Standard- als auch im fortschrittlichen Sprachmodus verfügbar sind. Diese Ergänzungen sollen eine persönlichere und ansprechendere Interaktion ermöglichen.

> Der fortschrittliche Sprachmodus wird im Laufe der Woche für alle Plus- und Team-Nutzer in der ChatGPT-App ausgerollt.

> Während ihr geduldig gewartet habt, haben wir benutzerdefinierte Anweisungen, Gedächtnis, fünf neue Stimmen und verbesserte Akzente hinzugefügt.

> Er kann auch „Entschuldigung, ich bin spät dran“ in über 50 Sprachen sagen. pic.twitter.com/APOqqhXtDg

>

> — OpenAI (@OpenAI) 24. September 2024

Die Einführung konzentriert sich zunächst auf ChatGPT Plus- und Team-Nutzer, mit Plänen, den Zugang in der nächsten Woche auf Enterprise- und Edu-Stufen auszudehnen. Nutzer erhalten eine Benachrichtigung über eine Pop-up-Nachricht neben der Sprachmodus-Option in der ChatGPT-Oberfläche, die ihren Zugang zu dieser Funktion anzeigt.

Seit der Alpha-Veröffentlichung im Juli hat OpenAI intensiv daran gearbeitet, den fortschrittlichen Sprachmodus zu verfeinern. Verbesserungen umfassen verbesserte Akzente in Fremdsprachen und flüssigere Gesprächsgeschwindigkeiten. Visuell verfügt der Modus nun über eine animierte blaue Kugel, die der Benutzeroberfläche eine frische Note verleiht.

Um das Erlebnis weiter zu personalisieren, integriert der fortschrittliche Sprachmodus nun benutzerdefinierte Anweisungen und Gedächtnis. Diese Funktionen ermöglichen es dem Sprachassistenten, nutzerspezifische Kriterien zu berücksichtigen, was zu relevanteren und personalisierten Antworten führt.

Eine Einschränkung aus der Alpha-Version bleibt jedoch bestehen: Nutzer können die multimodalen Fähigkeiten des Sprachmodus, wie die Unterstützung bei Bildschirminhalten oder die Nutzung der Telefonkamera für kontextbezogene Antworten, wie im folgenden Video gezeigt, nicht nutzen.

Um den fortschrittlichen Sprachmodus zu nutzen, können Sie ChatGPT Plus für 20 US-Dollar pro Monat abonnieren. Dieses Abonnement gewährt nicht nur Zugang zur neuen Sprachfunktion, sondern bietet auch zusätzliche Vorteile wie fortschrittliche Datenanalyse, unbegrenzte Bildgenerierung, fünfmal mehr Nachrichten für GPT-4o und die Möglichkeit, benutzerdefinierte GPTs zu erstellen.

Interessanterweise hat Google nur eine Woche nach der Vorstellung des fortschrittlichen Sprachmodus von OpenAI im Mai eine ähnliche Funktion namens Gemini Live eingeführt. Dieser konversationelle Sprachassistent, der von LLMs unterstützt wird, zielt darauf ab, den Gesprächsfluss und das Verständnis zu verbessern. Anfang dieses Monats machte Google Gemini Live kostenlos für alle Android-Nutzer verfügbar und bietet damit eine Alternative für diejenigen, die an ähnlicher Sprachassistenten-Technologie interessiert sind, ohne ein kostenpflichtiges Abonnement abschließen zu müssen. Apple stellt kühne 3-Jahres-Strategie für die Erneuerung der iPhone-Produktlinie vor

Apple scheint bereit zu sein, im nächsten Monat ein revolutionäres iPhone Air vorzustellen, was eine deutliche Abkehr vom bisherigen Muster der inkrementellen Updates des Unternehmens darstellt. Diese

Apple stellt kühne 3-Jahres-Strategie für die Erneuerung der iPhone-Produktlinie vor

Apple scheint bereit zu sein, im nächsten Monat ein revolutionäres iPhone Air vorzustellen, was eine deutliche Abkehr vom bisherigen Muster der inkrementellen Updates des Unternehmens darstellt. Diese

Warum die meisten AI SEO Content Writers scheitern - und die besten Alternativen zu verwenden

In der heutigen wettbewerbsintensiven digitalen Marketingumgebung ist künstliche Intelligenz ein wesentlicher Bestandteil effektiver SEO-Strategien geworden. Viele Unternehmen stellen jedoch fest, das

Warum die meisten AI SEO Content Writers scheitern - und die besten Alternativen zu verwenden

In der heutigen wettbewerbsintensiven digitalen Marketingumgebung ist künstliche Intelligenz ein wesentlicher Bestandteil effektiver SEO-Strategien geworden. Viele Unternehmen stellen jedoch fest, das

Erstellen von 3D-Modellen aus einzelnen Bildern mit Python AI in einfachen Schritten

Die Fähigkeit, 2D-Bilder in 3D-Modelle umzuwandeln, birgt ein enormes Potenzial für zahlreiche Branchen. In diesem Leitfaden wird untersucht, wie die leistungsstarken KI- und 3D-Verarbeitungsfunktione

Erstellen von 3D-Modellen aus einzelnen Bildern mit Python AI in einfachen Schritten

Die Fähigkeit, 2D-Bilder in 3D-Modelle umzuwandeln, birgt ein enormes Potenzial für zahlreiche Branchen. In diesem Leitfaden wird untersucht, wie die leistungsstarken KI- und 3D-Verarbeitungsfunktione

21. September 2025 06:30:31 MESZ

21. September 2025 06:30:31 MESZ

¡Por fin! Llevaba semanas esperando probar el modo de voz avanzado de ChatGPT 😍 Aunque no soy usuario premium, espero que llegue pronto a mi cuenta. ¿Alguien ya lo ha probado? ¿Vale la pena la espera o es mejor seguir usando otras alternativas como Gemini?

0

0

12. September 2025 22:30:34 MESZ

12. September 2025 22:30:34 MESZ

오늘 보이스 모드 테스트 해봤는데, 목소리가 너무 자연스러워서 놀랐어요! 😲 근데 프리미엄 유저에게 우선 배포한다니... 무료 사용자들은 언제쯤 쓸 수 있을지 궁금하네요. 가격 인상 얘기도 있는데 걱정돼요.

0

0

23. Juli 2025 10:50:48 MESZ

23. Juli 2025 10:50:48 MESZ

Wow, voice mode for all ChatGPT subscribers? That's a game-changer! Can't wait to try it out and see how it stacks up against other AI assistants. 😎

0

0

23. Juli 2025 06:59:29 MESZ

23. Juli 2025 06:59:29 MESZ

Wow, voice mode for all ChatGPT subscribers is a game-changer! I’m stoked to try it out, but I wonder how it stacks up against other AI voice assistants. Anyone tested it yet? 😎

0

0

15. April 2025 11:55:52 MESZ

15. April 2025 11:55:52 MESZ

Finally got access to the voice mode on ChatGPT! It’s super cool and works surprisingly well. A bit pricey for non-premium users though 😅

0

0

15. April 2025 11:11:46 MESZ

15. April 2025 11:11:46 MESZ

OpenAIのVoice Modeを試してみました!結構クールですが、もっと速くなるといいですね。声が自然なのが大きなプラスです。プレミアムユーザーなので早めにアクセスできましたが、完璧になる前にもう少し磨きが必要だと思います。それでも、正しい方向への一歩ですね!🎤

0

0