AI World: Concevoir avec une intimité à l'esprit

L'intelligence artificielle a le pouvoir de transformer tout, de nos routines quotidiennes aux avancées médicales révolutionnaires. Cependant, pour exploiter pleinement le potentiel de l'IA, nous devons aborder son développement en mettant la responsabilité au premier plan.

C'est pourquoi la discussion autour de l'IA générative et de la confidentialité est si cruciale. Nous sommes impatients de contribuer à cette conversation avec des idées issues de l'avant-garde de l'innovation et de notre engagement profond avec les régulateurs et autres experts.

Dans notre nouveau document de travail sur les politiques intitulé "IA générative et confidentialité", nous plaidons pour que les produits d'IA intègrent dès le départ des protections qui privilégient la sécurité et la confidentialité des utilisateurs. Nous proposons également des stratégies politiques qui abordent les problèmes de confidentialité tout en permettant à l'IA de prospérer et de bénéficier à la société.

Confidentialité par conception dans l'IA

L'IA promet de grands avantages pour les individus et la société, mais elle peut aussi amplifier les défis existants et en introduire de nouveaux, comme l'ont montré nos recherches et celles d'autres.

Il en va de même pour la confidentialité. Il est essentiel d'intégrer des protections qui garantissent la transparence et le contrôle, et atténuent les risques comme la divulgation non intentionnelle d'informations personnelles.

Cela nécessite un cadre solide, de la phase de développement à celle du déploiement, ancré dans des principes éprouvés par le temps. Toute organisation développant des outils d'IA devrait avoir une stratégie claire en matière de confidentialité.

Notre approche est façonnée par des pratiques de protection des données de longue date, nos principes de confidentialité et de sécurité, nos pratiques d'IA responsable et nos principes d'IA. Cela signifie que nous mettons en place des garanties robustes en matière de confidentialité et des techniques de minimisation des données, offrons de la transparence sur nos pratiques de données, et fournissons des contrôles permettant aux utilisateurs de prendre des décisions éclairées et de gérer leurs informations.

Focus sur les applications de l'IA pour réduire efficacement les risques

En appliquant les principes de confidentialité établis à l'IA générative, des questions importantes se posent.

Par exemple, comment pratiquer la minimisation des données lors de l'entraînement de modèles sur de vastes quantités de données ? Quelles sont les meilleures façons d'offrir une transparence significative pour des modèles complexes qui répondent aux préoccupations individuelles ? Et comment créer des expériences adaptées à l'âge qui bénéficient aux adolescents dans un monde alimenté par l'IA ?

Notre document propose quelques réflexions initiales sur ces sujets, en se concentrant sur deux phases clés du développement des modèles :

- Entraînement et développement

- Applications orientées utilisateur

Pendant l'entraînement et le développement, les données personnelles comme les noms ou les détails biographiques constituent une partie petite mais cruciale des données d'entraînement. Les modèles utilisent ces données pour comprendre comment le langage capture des concepts abstraits sur les relations humaines et le monde qui nous entoure.

Ces modèles ne sont pas des "bases de données" et ne sont pas destinés à identifier des individus. En fait, inclure des données personnelles peut aider à réduire les biais — par exemple, en comprenant mieux les noms de diverses cultures — et améliorer la précision et les performances des modèles.

Au niveau de l'application, le risque de préjudices liés à la confidentialité, comme les fuites de données, augmente, mais les opportunités de mettre en œuvre des garanties plus efficaces croissent également. Des fonctionnalités comme les filtres de sortie et la suppression automatique deviennent vitales ici.

Prioriser ces garanties au niveau de l'application est non seulement pratique, mais, selon nous, la voie la plus efficace à suivre.

Atteindre la confidentialité par l'innovation

Bien que le dialogue actuel sur la confidentialité de l'IA se concentre beaucoup sur l'atténuation des risques — et à juste titre, compte tenu de l'importance de renforcer la confiance dans l'IA — l'IA générative a également le potentiel d'améliorer la confidentialité des utilisateurs. Nous devons saisir ces opportunités également.

L'IA générative aide déjà les organisations à analyser les retours sur la confidentialité de grandes bases d'utilisateurs et à repérer les problèmes de conformité. Elle ouvre la voie à de nouvelles stratégies de défense cybernétique. Les technologies améliorant la confidentialité, telles que les données synthétiques et la confidentialité différentielle, nous montrent comment fournir de plus grands avantages sociétaux sans compromettre les informations personnelles. Les politiques publiques et les normes de l'industrie devraient encourager — et non entraver par inadvertance — ces développements positifs.

Le besoin de travailler ensemble

Les lois sur la confidentialité sont conçues pour être adaptables, proportionnées et neutres technologiquement — des qualités qui les ont rendues robustes et durables au fil du temps.

Les mêmes principes s'appliquent à l'ère de l'IA, alors que nous nous efforçons d'équilibrer de solides protections de la confidentialité avec d'autres droits fondamentaux et objectifs sociaux.

La voie à suivre nécessitera une coopération au sein de la communauté de la confidentialité, et Google s'engage à collaborer avec d'autres pour s'assurer que l'IA générative profite à la société de manière responsable.

Vous pouvez lire notre document de travail sur les politiques concernant l'IA générative et la confidentialité [ici](lien vers le document).

Article connexe

"Explorer la sécurité et l'éthique de l'IA : Les points de vue des experts de Databricks et d'ElevenLabs"

Alors que l'IA générative devient de plus en plus abordable et répandue, les considérations éthiques et les mesures de sécurité occupent le devant de la scène. Artemis Seaford, responsable de la séc

"Explorer la sécurité et l'éthique de l'IA : Les points de vue des experts de Databricks et d'ElevenLabs"

Alors que l'IA générative devient de plus en plus abordable et répandue, les considérations éthiques et les mesures de sécurité occupent le devant de la scène. Artemis Seaford, responsable de la séc

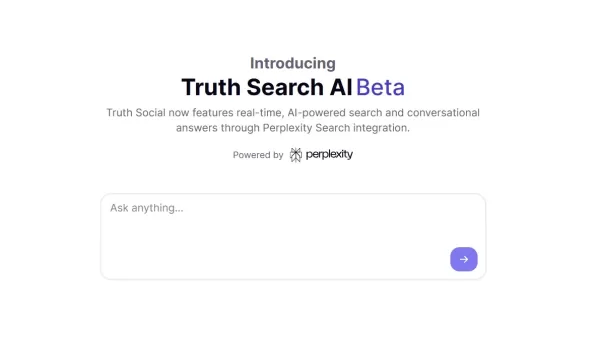

Le nouveau moteur de recherche AI de Truth Social favorise largement Fox News dans les résultats

La plateforme de médias sociaux de Trump introduit une fonction de recherche alimentée par l'IA avec un penchant apparent pour les médias conservateursLancement d'une fonction de recherche exclusive b

Le nouveau moteur de recherche AI de Truth Social favorise largement Fox News dans les résultats

La plateforme de médias sociaux de Trump introduit une fonction de recherche alimentée par l'IA avec un penchant apparent pour les médias conservateursLancement d'une fonction de recherche exclusive b

ChatGPT ajoute l'intégration de Google Drive et Dropbox pour l'accès aux fichiers

ChatGPT améliore la productivité avec de nouvelles fonctionnalités d'entrepriseOpenAI a dévoilé deux nouvelles fonctionnalités puissantes qui transforment ChatGPT en un outil de productivité complet

commentaires (46)

0/200

ChatGPT ajoute l'intégration de Google Drive et Dropbox pour l'accès aux fichiers

ChatGPT améliore la productivité avec de nouvelles fonctionnalités d'entrepriseOpenAI a dévoilé deux nouvelles fonctionnalités puissantes qui transforment ChatGPT en un outil de productivité complet

commentaires (46)

0/200

![JosephScott]() JosephScott

JosephScott

25 août 2025 13:01:04 UTC+02:00

25 août 2025 13:01:04 UTC+02:00

This article really opened my eyes to how crucial privacy is in AI development! It's wild to think about the balance between innovation and protecting our data. 😮 What’s next for ensuring AI doesn’t overstep boundaries?

0

0

![WillGarcía]() WillGarcía

WillGarcía

25 avril 2025 10:48:58 UTC+02:00

25 avril 2025 10:48:58 UTC+02:00

AI Worldはプライバシーを考慮した設計が素晴らしいですね。倫理的な開発に焦点を当てるのは新鮮ですが、インターフェースが少し使いづらい時があります。全体的に、責任あるAIの使用に向けた一歩だと思います!👍

0

0

![NicholasClark]() NicholasClark

NicholasClark

21 avril 2025 08:17:58 UTC+02:00

21 avril 2025 08:17:58 UTC+02:00

AI Worldはプライバシーに関する点で本当に的を射ているね。責任あるAI開発に焦点を当てるのは新鮮だ。ただ、プライバシー機能が時々少し制限が厳しすぎることがある。でも、正しい方向への一歩だよ!👍

0

0

![WillieJones]() WillieJones

WillieJones

18 avril 2025 21:40:31 UTC+02:00

18 avril 2025 21:40:31 UTC+02:00

AI World realmente da en el clavo con la privacidad. Es refrescante ver un enfoque en el desarrollo responsable de la IA. Pero a veces, las características de privacidad pueden ser un poco demasiado restrictivas. Aún así, es un paso en la dirección correcta! 👍

0

0

![AlbertThomas]() AlbertThomas

AlbertThomas

18 avril 2025 10:31:45 UTC+02:00

18 avril 2025 10:31:45 UTC+02:00

AI World은 정말로 프라이버시에 대해 핵심을 찌르고 있어요. 책임 있는 AI 개발에 초점을 맞추는 것이 새롭네요. 하지만 때때로 프라이버시 기능이 너무 제한적일 수 있어요. 그래도 올바른 방향으로의 한 걸음이에요! 👍

0

0

![LawrenceScott]() LawrenceScott

LawrenceScott

18 avril 2025 04:01:15 UTC+02:00

18 avril 2025 04:01:15 UTC+02:00

AI World really hits the nail on the head with privacy. It's refreshing to see a focus on responsible AI development. But sometimes, the privacy features can be a bit too restrictive. Still, it's a step in the right direction! 👍

0

0

L'intelligence artificielle a le pouvoir de transformer tout, de nos routines quotidiennes aux avancées médicales révolutionnaires. Cependant, pour exploiter pleinement le potentiel de l'IA, nous devons aborder son développement en mettant la responsabilité au premier plan.

C'est pourquoi la discussion autour de l'IA générative et de la confidentialité est si cruciale. Nous sommes impatients de contribuer à cette conversation avec des idées issues de l'avant-garde de l'innovation et de notre engagement profond avec les régulateurs et autres experts.

Dans notre nouveau document de travail sur les politiques intitulé "IA générative et confidentialité", nous plaidons pour que les produits d'IA intègrent dès le départ des protections qui privilégient la sécurité et la confidentialité des utilisateurs. Nous proposons également des stratégies politiques qui abordent les problèmes de confidentialité tout en permettant à l'IA de prospérer et de bénéficier à la société.

Confidentialité par conception dans l'IA

L'IA promet de grands avantages pour les individus et la société, mais elle peut aussi amplifier les défis existants et en introduire de nouveaux, comme l'ont montré nos recherches et celles d'autres.

Il en va de même pour la confidentialité. Il est essentiel d'intégrer des protections qui garantissent la transparence et le contrôle, et atténuent les risques comme la divulgation non intentionnelle d'informations personnelles.

Cela nécessite un cadre solide, de la phase de développement à celle du déploiement, ancré dans des principes éprouvés par le temps. Toute organisation développant des outils d'IA devrait avoir une stratégie claire en matière de confidentialité.

Notre approche est façonnée par des pratiques de protection des données de longue date, nos principes de confidentialité et de sécurité, nos pratiques d'IA responsable et nos principes d'IA. Cela signifie que nous mettons en place des garanties robustes en matière de confidentialité et des techniques de minimisation des données, offrons de la transparence sur nos pratiques de données, et fournissons des contrôles permettant aux utilisateurs de prendre des décisions éclairées et de gérer leurs informations.

Focus sur les applications de l'IA pour réduire efficacement les risques

En appliquant les principes de confidentialité établis à l'IA générative, des questions importantes se posent.

Par exemple, comment pratiquer la minimisation des données lors de l'entraînement de modèles sur de vastes quantités de données ? Quelles sont les meilleures façons d'offrir une transparence significative pour des modèles complexes qui répondent aux préoccupations individuelles ? Et comment créer des expériences adaptées à l'âge qui bénéficient aux adolescents dans un monde alimenté par l'IA ?

Notre document propose quelques réflexions initiales sur ces sujets, en se concentrant sur deux phases clés du développement des modèles :

- Entraînement et développement

- Applications orientées utilisateur

Pendant l'entraînement et le développement, les données personnelles comme les noms ou les détails biographiques constituent une partie petite mais cruciale des données d'entraînement. Les modèles utilisent ces données pour comprendre comment le langage capture des concepts abstraits sur les relations humaines et le monde qui nous entoure.

Ces modèles ne sont pas des "bases de données" et ne sont pas destinés à identifier des individus. En fait, inclure des données personnelles peut aider à réduire les biais — par exemple, en comprenant mieux les noms de diverses cultures — et améliorer la précision et les performances des modèles.

Au niveau de l'application, le risque de préjudices liés à la confidentialité, comme les fuites de données, augmente, mais les opportunités de mettre en œuvre des garanties plus efficaces croissent également. Des fonctionnalités comme les filtres de sortie et la suppression automatique deviennent vitales ici.

Prioriser ces garanties au niveau de l'application est non seulement pratique, mais, selon nous, la voie la plus efficace à suivre.

Atteindre la confidentialité par l'innovation

Bien que le dialogue actuel sur la confidentialité de l'IA se concentre beaucoup sur l'atténuation des risques — et à juste titre, compte tenu de l'importance de renforcer la confiance dans l'IA — l'IA générative a également le potentiel d'améliorer la confidentialité des utilisateurs. Nous devons saisir ces opportunités également.

L'IA générative aide déjà les organisations à analyser les retours sur la confidentialité de grandes bases d'utilisateurs et à repérer les problèmes de conformité. Elle ouvre la voie à de nouvelles stratégies de défense cybernétique. Les technologies améliorant la confidentialité, telles que les données synthétiques et la confidentialité différentielle, nous montrent comment fournir de plus grands avantages sociétaux sans compromettre les informations personnelles. Les politiques publiques et les normes de l'industrie devraient encourager — et non entraver par inadvertance — ces développements positifs.

Le besoin de travailler ensemble

Les lois sur la confidentialité sont conçues pour être adaptables, proportionnées et neutres technologiquement — des qualités qui les ont rendues robustes et durables au fil du temps.

Les mêmes principes s'appliquent à l'ère de l'IA, alors que nous nous efforçons d'équilibrer de solides protections de la confidentialité avec d'autres droits fondamentaux et objectifs sociaux.

La voie à suivre nécessitera une coopération au sein de la communauté de la confidentialité, et Google s'engage à collaborer avec d'autres pour s'assurer que l'IA générative profite à la société de manière responsable.

Vous pouvez lire notre document de travail sur les politiques concernant l'IA générative et la confidentialité [ici](lien vers le document).

"Explorer la sécurité et l'éthique de l'IA : Les points de vue des experts de Databricks et d'ElevenLabs"

Alors que l'IA générative devient de plus en plus abordable et répandue, les considérations éthiques et les mesures de sécurité occupent le devant de la scène. Artemis Seaford, responsable de la séc

"Explorer la sécurité et l'éthique de l'IA : Les points de vue des experts de Databricks et d'ElevenLabs"

Alors que l'IA générative devient de plus en plus abordable et répandue, les considérations éthiques et les mesures de sécurité occupent le devant de la scène. Artemis Seaford, responsable de la séc

Le nouveau moteur de recherche AI de Truth Social favorise largement Fox News dans les résultats

La plateforme de médias sociaux de Trump introduit une fonction de recherche alimentée par l'IA avec un penchant apparent pour les médias conservateursLancement d'une fonction de recherche exclusive b

Le nouveau moteur de recherche AI de Truth Social favorise largement Fox News dans les résultats

La plateforme de médias sociaux de Trump introduit une fonction de recherche alimentée par l'IA avec un penchant apparent pour les médias conservateursLancement d'une fonction de recherche exclusive b

ChatGPT ajoute l'intégration de Google Drive et Dropbox pour l'accès aux fichiers

ChatGPT améliore la productivité avec de nouvelles fonctionnalités d'entrepriseOpenAI a dévoilé deux nouvelles fonctionnalités puissantes qui transforment ChatGPT en un outil de productivité complet

ChatGPT ajoute l'intégration de Google Drive et Dropbox pour l'accès aux fichiers

ChatGPT améliore la productivité avec de nouvelles fonctionnalités d'entrepriseOpenAI a dévoilé deux nouvelles fonctionnalités puissantes qui transforment ChatGPT en un outil de productivité complet

25 août 2025 13:01:04 UTC+02:00

25 août 2025 13:01:04 UTC+02:00

This article really opened my eyes to how crucial privacy is in AI development! It's wild to think about the balance between innovation and protecting our data. 😮 What’s next for ensuring AI doesn’t overstep boundaries?

0

0

25 avril 2025 10:48:58 UTC+02:00

25 avril 2025 10:48:58 UTC+02:00

AI Worldはプライバシーを考慮した設計が素晴らしいですね。倫理的な開発に焦点を当てるのは新鮮ですが、インターフェースが少し使いづらい時があります。全体的に、責任あるAIの使用に向けた一歩だと思います!👍

0

0

21 avril 2025 08:17:58 UTC+02:00

21 avril 2025 08:17:58 UTC+02:00

AI Worldはプライバシーに関する点で本当に的を射ているね。責任あるAI開発に焦点を当てるのは新鮮だ。ただ、プライバシー機能が時々少し制限が厳しすぎることがある。でも、正しい方向への一歩だよ!👍

0

0

18 avril 2025 21:40:31 UTC+02:00

18 avril 2025 21:40:31 UTC+02:00

AI World realmente da en el clavo con la privacidad. Es refrescante ver un enfoque en el desarrollo responsable de la IA. Pero a veces, las características de privacidad pueden ser un poco demasiado restrictivas. Aún así, es un paso en la dirección correcta! 👍

0

0

18 avril 2025 10:31:45 UTC+02:00

18 avril 2025 10:31:45 UTC+02:00

AI World은 정말로 프라이버시에 대해 핵심을 찌르고 있어요. 책임 있는 AI 개발에 초점을 맞추는 것이 새롭네요. 하지만 때때로 프라이버시 기능이 너무 제한적일 수 있어요. 그래도 올바른 방향으로의 한 걸음이에요! 👍

0

0

18 avril 2025 04:01:15 UTC+02:00

18 avril 2025 04:01:15 UTC+02:00

AI World really hits the nail on the head with privacy. It's refreshing to see a focus on responsible AI development. But sometimes, the privacy features can be a bit too restrictive. Still, it's a step in the right direction! 👍

0

0