AI世界:考慮隱私的設計

人工智能有能力改變從我們日常生活的例行公事到突破性醫療進展的一切。然而,要真正發揮人工智能的潛力,我們必須以責任為優先來進行其發展。

這就是為什麼關於生成式人工智能與隱私的討論如此重要的原因。我們渴望以創新前沿的見解以及我們與監管機構和其他專家的深入參與,為這場對話做出貢獻。

在我們標題為「生成式人工智能與隱私」的新政策工作文件中,我們主張人工智能產品應內建保護措施,從一開始就優先考慮用戶安全和隱私。我們還提出了應對隱私問題的政策策略,同時仍允許人工智能蓬勃發展並造福社會。

人工智能中的隱私設計

人工智能為個人和社會帶來了巨大益處的承諾,但正如我們和其他人的研究所示,它也可能放大現有挑戰並引入新的挑戰。

隱私問題也是如此。必須融入確保透明度和控制的保護措施,並減輕諸如個人信息意外洩露等風險。

這需要從開發階段到部署階段建立一個堅實的框架,植根於經過時間考驗的原則。任何開發人工智能工具的組織都應具備清晰的隱私策略。

我們的做法受到長期數據保護實踐、我們的隱私與安全原則、負責任人工智能實踐以及我們的AI原則的塑造。這意味著我們實施了強大的隱私保護措施和數據最小化技術,提供了關於我們數據實踐的透明度,並提供控制措施,讓用戶能夠做出明智的決定並管理他們的信息。

專注於人工智能應用以有效降低風險

當我們將既定的隱私原則應用於生成式人工智能時,有一些重要問題需要考慮。

例如,在對大量數據進行模型訓練時,我們如何實踐數據最小化?對於解決個人問題的複雜模型,什麼是提供有意義透明度的最佳方式?以及我們如何在人工智能驅動的世界中創造適合青少年年齡的體驗?

我們的論文對這些主題提供了一些初步想法,專注於模型開發的兩個關鍵階段:

- 訓練與開發

- 面向用戶的應用

在訓練與開發過程中,個人數據如姓名或傳記細節僅構成訓練數據的一小部分但至關重要。模型使用這些數據來理解語言如何捕捉關於人際關係和周圍世界的抽象概念。

這些模型不是「數據庫」,也不是用來識別個人的。事實上,包含個人數據可以幫助減少偏見——例如,通過更好地理解來自不同文化的姓名——並提高模型的準確性和性能。

在應用層面上,數據洩露等隱私危害的風險增加,但實施更有效保護措施的機會也隨之增加。諸如輸出過濾器和自動刪除等功能在此變得至關重要。

在應用層面上優先考慮這些保護措施不僅實際可行,我們相信,也是最有效的方式。

通過創新實現隱私

雖然當今人工智能隱私對話大多聚焦於風險緩解——這是正確的,因為建立對人工智能的信任至關重要——生成式人工智能也有增強用戶隱私的潛力。我們也應該抓住這些機會。

生成式人工智能已經在幫助組織分析來自大量用戶群的隱私反饋並發現合規問題。它正在為新的網絡防禦策略鋪平道路。隱私增強技術,如合成數據和差分隱私,正在展示如何在不損害個人信息的情況下提供更大的社會效益。公共政策和行業標準應鼓勵——而不是無意中阻礙——這些積極的發展。

共同努力的需要

隱私法律被設計為適應性強、適度且技術中立——這些特質使它們長期以來堅韌且持久。

在人工智能時代,這些原則同樣適用,因為我們努力在強大的隱私保護與其他基本權利和社會目標之間取得平衡。

前方的道路需要隱私社群的合作,Google 致力於與他人合作,確保生成式人工智能以負責任的方式造福社會。

您可以在[此處](link to paper)閱讀我們的生成式人工智能與隱私政策工作文件。

相關文章

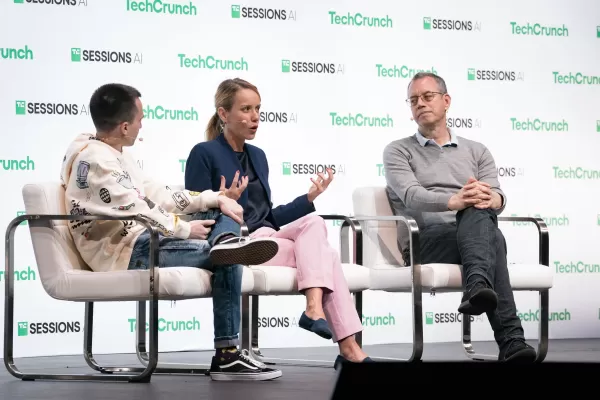

"探索 AI 安全與道德:Databricks 和 ElevenLabs 專家的見解"

隨著創造性人工智能的價格越來越低廉,普及程度越來越高,道德考量和安全措施也成為了中心議題。ElevenLabs 的 AI 安全主管 Artemis Seaford 和 Databricks 的共同創造者 Ion Stoica 參與了 TechCrunch 的 AI 記者 Kyle Wiggers 的深入對談,探討當今 AI 領域中迫切的倫理困境。他們的對談探討了從合成媒體驗證到道德實踐準則

"探索 AI 安全與道德:Databricks 和 ElevenLabs 專家的見解"

隨著創造性人工智能的價格越來越低廉,普及程度越來越高,道德考量和安全措施也成為了中心議題。ElevenLabs 的 AI 安全主管 Artemis Seaford 和 Databricks 的共同創造者 Ion Stoica 參與了 TechCrunch 的 AI 記者 Kyle Wiggers 的深入對談,探討當今 AI 領域中迫切的倫理困境。他們的對談探討了從合成媒體驗證到道德實踐準則

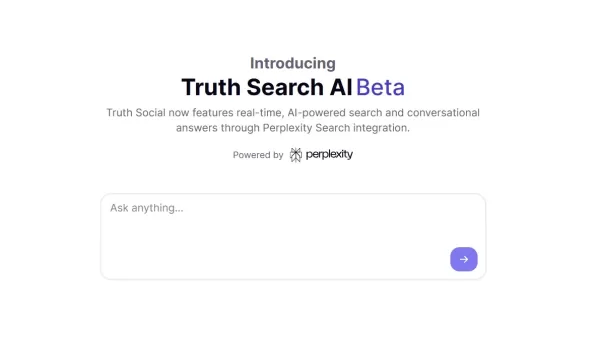

Truth Social 的新 AI 搜尋引擎在搜尋結果中非常傾向於福克斯新聞

川普的社交媒體平台推出 AI 驅動的搜尋功能,明顯傾向保守媒體獨家推出 AI 搜尋功能Truth Social 是唐納德-川普 (Donald Trump) 所創立的社交媒體平台,該平台已推出新的人工智慧搜尋工具,稱為 Truth Search AI。這項功能是與 AI 創業公司 Perplexity 合作開發,目前在網頁版上運作,並計劃在不久後整合行動應用程式。保守派媒體的主導地位獨立測試顯示,

Truth Social 的新 AI 搜尋引擎在搜尋結果中非常傾向於福克斯新聞

川普的社交媒體平台推出 AI 驅動的搜尋功能,明顯傾向保守媒體獨家推出 AI 搜尋功能Truth Social 是唐納德-川普 (Donald Trump) 所創立的社交媒體平台,該平台已推出新的人工智慧搜尋工具,稱為 Truth Search AI。這項功能是與 AI 創業公司 Perplexity 合作開發,目前在網頁版上運作,並計劃在不久後整合行動應用程式。保守派媒體的主導地位獨立測試顯示,

ChatGPT 新增 Google Drive 和 Dropbox 整合功能以存取檔案

ChatGPT 利用新的企業功能增強生產力OpenAI 發表了兩項強大的新功能,將 ChatGPT 轉型為全面的企業生產力工具:自動化會議記錄和無縫雲儲存整合。革命性的錄音功能新推出的 「記錄模式 」可自動轉錄和分析以下內容:重要的商務會議有創意的腦力激盪會議 個人思考過程此優質功能目前為 ChatGPT 團隊訂閱者專屬 (每位使用者每月 $25),可提供:精確、有時

評論 (46)

0/200

ChatGPT 新增 Google Drive 和 Dropbox 整合功能以存取檔案

ChatGPT 利用新的企業功能增強生產力OpenAI 發表了兩項強大的新功能,將 ChatGPT 轉型為全面的企業生產力工具:自動化會議記錄和無縫雲儲存整合。革命性的錄音功能新推出的 「記錄模式 」可自動轉錄和分析以下內容:重要的商務會議有創意的腦力激盪會議 個人思考過程此優質功能目前為 ChatGPT 團隊訂閱者專屬 (每位使用者每月 $25),可提供:精確、有時

評論 (46)

0/200

![JosephScott]() JosephScott

JosephScott

2025-08-25 19:01:04

2025-08-25 19:01:04

This article really opened my eyes to how crucial privacy is in AI development! It's wild to think about the balance between innovation and protecting our data. 😮 What’s next for ensuring AI doesn’t overstep boundaries?

0

0

![WillGarcía]() WillGarcía

WillGarcía

2025-04-25 16:48:58

2025-04-25 16:48:58

AI Worldはプライバシーを考慮した設計が素晴らしいですね。倫理的な開発に焦点を当てるのは新鮮ですが、インターフェースが少し使いづらい時があります。全体的に、責任あるAIの使用に向けた一歩だと思います!👍

0

0

![NicholasClark]() NicholasClark

NicholasClark

2025-04-21 14:17:58

2025-04-21 14:17:58

AI Worldはプライバシーに関する点で本当に的を射ているね。責任あるAI開発に焦点を当てるのは新鮮だ。ただ、プライバシー機能が時々少し制限が厳しすぎることがある。でも、正しい方向への一歩だよ!👍

0

0

![WillieJones]() WillieJones

WillieJones

2025-04-19 03:40:31

2025-04-19 03:40:31

AI World realmente da en el clavo con la privacidad. Es refrescante ver un enfoque en el desarrollo responsable de la IA. Pero a veces, las características de privacidad pueden ser un poco demasiado restrictivas. Aún así, es un paso en la dirección correcta! 👍

0

0

![AlbertThomas]() AlbertThomas

AlbertThomas

2025-04-18 16:31:45

2025-04-18 16:31:45

AI World은 정말로 프라이버시에 대해 핵심을 찌르고 있어요. 책임 있는 AI 개발에 초점을 맞추는 것이 새롭네요. 하지만 때때로 프라이버시 기능이 너무 제한적일 수 있어요. 그래도 올바른 방향으로의 한 걸음이에요! 👍

0

0

![LawrenceScott]() LawrenceScott

LawrenceScott

2025-04-18 10:01:15

2025-04-18 10:01:15

AI World really hits the nail on the head with privacy. It's refreshing to see a focus on responsible AI development. But sometimes, the privacy features can be a bit too restrictive. Still, it's a step in the right direction! 👍

0

0

人工智能有能力改變從我們日常生活的例行公事到突破性醫療進展的一切。然而,要真正發揮人工智能的潛力,我們必須以責任為優先來進行其發展。

這就是為什麼關於生成式人工智能與隱私的討論如此重要的原因。我們渴望以創新前沿的見解以及我們與監管機構和其他專家的深入參與,為這場對話做出貢獻。

在我們標題為「生成式人工智能與隱私」的新政策工作文件中,我們主張人工智能產品應內建保護措施,從一開始就優先考慮用戶安全和隱私。我們還提出了應對隱私問題的政策策略,同時仍允許人工智能蓬勃發展並造福社會。

人工智能中的隱私設計

人工智能為個人和社會帶來了巨大益處的承諾,但正如我們和其他人的研究所示,它也可能放大現有挑戰並引入新的挑戰。

隱私問題也是如此。必須融入確保透明度和控制的保護措施,並減輕諸如個人信息意外洩露等風險。

這需要從開發階段到部署階段建立一個堅實的框架,植根於經過時間考驗的原則。任何開發人工智能工具的組織都應具備清晰的隱私策略。

我們的做法受到長期數據保護實踐、我們的隱私與安全原則、負責任人工智能實踐以及我們的AI原則的塑造。這意味著我們實施了強大的隱私保護措施和數據最小化技術,提供了關於我們數據實踐的透明度,並提供控制措施,讓用戶能夠做出明智的決定並管理他們的信息。

專注於人工智能應用以有效降低風險

當我們將既定的隱私原則應用於生成式人工智能時,有一些重要問題需要考慮。

例如,在對大量數據進行模型訓練時,我們如何實踐數據最小化?對於解決個人問題的複雜模型,什麼是提供有意義透明度的最佳方式?以及我們如何在人工智能驅動的世界中創造適合青少年年齡的體驗?

我們的論文對這些主題提供了一些初步想法,專注於模型開發的兩個關鍵階段:

- 訓練與開發

- 面向用戶的應用

在訓練與開發過程中,個人數據如姓名或傳記細節僅構成訓練數據的一小部分但至關重要。模型使用這些數據來理解語言如何捕捉關於人際關係和周圍世界的抽象概念。

這些模型不是「數據庫」,也不是用來識別個人的。事實上,包含個人數據可以幫助減少偏見——例如,通過更好地理解來自不同文化的姓名——並提高模型的準確性和性能。

在應用層面上,數據洩露等隱私危害的風險增加,但實施更有效保護措施的機會也隨之增加。諸如輸出過濾器和自動刪除等功能在此變得至關重要。

在應用層面上優先考慮這些保護措施不僅實際可行,我們相信,也是最有效的方式。

通過創新實現隱私

雖然當今人工智能隱私對話大多聚焦於風險緩解——這是正確的,因為建立對人工智能的信任至關重要——生成式人工智能也有增強用戶隱私的潛力。我們也應該抓住這些機會。

生成式人工智能已經在幫助組織分析來自大量用戶群的隱私反饋並發現合規問題。它正在為新的網絡防禦策略鋪平道路。隱私增強技術,如合成數據和差分隱私,正在展示如何在不損害個人信息的情況下提供更大的社會效益。公共政策和行業標準應鼓勵——而不是無意中阻礙——這些積極的發展。

共同努力的需要

隱私法律被設計為適應性強、適度且技術中立——這些特質使它們長期以來堅韌且持久。

在人工智能時代,這些原則同樣適用,因為我們努力在強大的隱私保護與其他基本權利和社會目標之間取得平衡。

前方的道路需要隱私社群的合作,Google 致力於與他人合作,確保生成式人工智能以負責任的方式造福社會。

您可以在[此處](link to paper)閱讀我們的生成式人工智能與隱私政策工作文件。

"探索 AI 安全與道德:Databricks 和 ElevenLabs 專家的見解"

隨著創造性人工智能的價格越來越低廉,普及程度越來越高,道德考量和安全措施也成為了中心議題。ElevenLabs 的 AI 安全主管 Artemis Seaford 和 Databricks 的共同創造者 Ion Stoica 參與了 TechCrunch 的 AI 記者 Kyle Wiggers 的深入對談,探討當今 AI 領域中迫切的倫理困境。他們的對談探討了從合成媒體驗證到道德實踐準則

"探索 AI 安全與道德:Databricks 和 ElevenLabs 專家的見解"

隨著創造性人工智能的價格越來越低廉,普及程度越來越高,道德考量和安全措施也成為了中心議題。ElevenLabs 的 AI 安全主管 Artemis Seaford 和 Databricks 的共同創造者 Ion Stoica 參與了 TechCrunch 的 AI 記者 Kyle Wiggers 的深入對談,探討當今 AI 領域中迫切的倫理困境。他們的對談探討了從合成媒體驗證到道德實踐準則

Truth Social 的新 AI 搜尋引擎在搜尋結果中非常傾向於福克斯新聞

川普的社交媒體平台推出 AI 驅動的搜尋功能,明顯傾向保守媒體獨家推出 AI 搜尋功能Truth Social 是唐納德-川普 (Donald Trump) 所創立的社交媒體平台,該平台已推出新的人工智慧搜尋工具,稱為 Truth Search AI。這項功能是與 AI 創業公司 Perplexity 合作開發,目前在網頁版上運作,並計劃在不久後整合行動應用程式。保守派媒體的主導地位獨立測試顯示,

Truth Social 的新 AI 搜尋引擎在搜尋結果中非常傾向於福克斯新聞

川普的社交媒體平台推出 AI 驅動的搜尋功能,明顯傾向保守媒體獨家推出 AI 搜尋功能Truth Social 是唐納德-川普 (Donald Trump) 所創立的社交媒體平台,該平台已推出新的人工智慧搜尋工具,稱為 Truth Search AI。這項功能是與 AI 創業公司 Perplexity 合作開發,目前在網頁版上運作,並計劃在不久後整合行動應用程式。保守派媒體的主導地位獨立測試顯示,

ChatGPT 新增 Google Drive 和 Dropbox 整合功能以存取檔案

ChatGPT 利用新的企業功能增強生產力OpenAI 發表了兩項強大的新功能,將 ChatGPT 轉型為全面的企業生產力工具:自動化會議記錄和無縫雲儲存整合。革命性的錄音功能新推出的 「記錄模式 」可自動轉錄和分析以下內容:重要的商務會議有創意的腦力激盪會議 個人思考過程此優質功能目前為 ChatGPT 團隊訂閱者專屬 (每位使用者每月 $25),可提供:精確、有時

ChatGPT 新增 Google Drive 和 Dropbox 整合功能以存取檔案

ChatGPT 利用新的企業功能增強生產力OpenAI 發表了兩項強大的新功能,將 ChatGPT 轉型為全面的企業生產力工具:自動化會議記錄和無縫雲儲存整合。革命性的錄音功能新推出的 「記錄模式 」可自動轉錄和分析以下內容:重要的商務會議有創意的腦力激盪會議 個人思考過程此優質功能目前為 ChatGPT 團隊訂閱者專屬 (每位使用者每月 $25),可提供:精確、有時

2025-08-25 19:01:04

2025-08-25 19:01:04

This article really opened my eyes to how crucial privacy is in AI development! It's wild to think about the balance between innovation and protecting our data. 😮 What’s next for ensuring AI doesn’t overstep boundaries?

0

0

2025-04-25 16:48:58

2025-04-25 16:48:58

AI Worldはプライバシーを考慮した設計が素晴らしいですね。倫理的な開発に焦点を当てるのは新鮮ですが、インターフェースが少し使いづらい時があります。全体的に、責任あるAIの使用に向けた一歩だと思います!👍

0

0

2025-04-21 14:17:58

2025-04-21 14:17:58

AI Worldはプライバシーに関する点で本当に的を射ているね。責任あるAI開発に焦点を当てるのは新鮮だ。ただ、プライバシー機能が時々少し制限が厳しすぎることがある。でも、正しい方向への一歩だよ!👍

0

0

2025-04-19 03:40:31

2025-04-19 03:40:31

AI World realmente da en el clavo con la privacidad. Es refrescante ver un enfoque en el desarrollo responsable de la IA. Pero a veces, las características de privacidad pueden ser un poco demasiado restrictivas. Aún así, es un paso en la dirección correcta! 👍

0

0

2025-04-18 16:31:45

2025-04-18 16:31:45

AI World은 정말로 프라이버시에 대해 핵심을 찌르고 있어요. 책임 있는 AI 개발에 초점을 맞추는 것이 새롭네요. 하지만 때때로 프라이버시 기능이 너무 제한적일 수 있어요. 그래도 올바른 방향으로의 한 걸음이에요! 👍

0

0

2025-04-18 10:01:15

2025-04-18 10:01:15

AI World really hits the nail on the head with privacy. It's refreshing to see a focus on responsible AI development. But sometimes, the privacy features can be a bit too restrictive. Still, it's a step in the right direction! 👍

0

0