Мир ИИ: проектирование с учетом конфиденциальности

Искусственный интеллект способен преобразовать всё — от повседневных дел до прорывных медицинских достижений. Однако, чтобы полностью реализовать потенциал ИИ, мы должны подходить к его разработке с приоритетом ответственности.

Поэтому обсуждение генеративного ИИ и конфиденциальности так важно. Мы стремимся внести свой вклад в эту дискуссию, опираясь на передовые инновации и глубокое взаимодействие с регуляторами и другими экспертами.

В нашей новой рабочей статье по политике под названием «Генеративный ИИ и конфиденциальность» мы выступаем за то, чтобы продукты ИИ включали встроенные механизмы защиты, которые с самого начала ставят в приоритет безопасность и конфиденциальность пользователей. Мы также предлагаем стратегии политики, которые решают проблемы конфиденциальности, позволяя ИИ процветать и приносить пользу обществу.

Конфиденциальность по умолчанию в ИИ

ИИ обещает большие преимущества для отдельных людей и общества, но он также может усиливать существующие проблемы и создавать новые, как показали наши исследования и исследования других.

То же касается конфиденциальности. Необходимо внедрять механизмы защиты, обеспечивающие прозрачность и контроль, а также снижающие риски, такие как непреднамеренное раскрытие личной информации.

Это требует прочной основы от стадии разработки до внедрения, основанной на проверенных временем принципах. Любая организация, разрабатывающая инструменты ИИ, должна иметь четкую стратегию конфиденциальности.

Наш подход сформирован на основе многолетних практик защиты данных, наших принципов конфиденциальности и безопасности, практик ответственного ИИ и наших принципов ИИ. Это означает, что мы внедряем надежные меры защиты конфиденциальности и методы минимизации данных, обеспечиваем прозрачность в отношении наших практик работы с данными и предоставляем инструменты управления, позволяющие пользователям принимать осознанные решения и управлять своей информацией.

Фокус на применении ИИ для эффективного снижения рисков

Применяя устоявшиеся принципы конфиденциальности к генеративному ИИ, необходимо учитывать важные вопросы.

Например, как практиковать минимизацию данных при обучении моделей на огромных объемах данных? Какие лучшие способы обеспечить значимую прозрачность для сложных моделей, учитывающих индивидуальные запросы? И как создать подходящие для возраста решения, которые приносят пользу подросткам в мире, управляемом ИИ?

Наша статья предлагает первоначальные мысли по этим темам, сосредотачиваясь на двух ключевых фазах разработки моделей:

- Обучение и разработка

- Приложения, ориентированные на пользователей

На этапе обучения и разработки личные данные, такие как имена или биографические детали, составляют небольшую, но важную часть обучающих данных. Модели используют эти данные, чтобы понять, как язык отражает абстрактные концепции человеческих отношений и окружающего мира.

Эти модели не являются «базами данных» и не предназначены для идентификации людей. Фактически, включение личных данных может помочь уменьшить предвзятость — например, лучше понимая имена из разных культур — и повысить точность и производительность модели.

На уровне приложений риск утечки данных возрастает, но также появляются возможности для внедрения более эффективных мер защиты. Функции, такие как фильтры вывода и автоматическое удаление, становятся здесь жизненно важными.

Приоритет этих мер защиты на уровне приложений не только практичен, но, как мы считаем, является наиболее эффективным путем вперед.

Достижение конфиденциальности через инновации

Хотя большая часть сегодняшнего диалога о конфиденциальности ИИ сосредоточена на снижении рисков — и это правильно, учитывая важность укрепления доверия к ИИ, — генеративный ИИ также имеет потенциал для усиления конфиденциальности пользователей. Мы должны использовать эти возможности.

Генеративный ИИ уже помогает организациям анализировать отзывы о конфиденциальности от больших пользовательских баз и выявлять проблемы соответствия. Он прокладывает путь для новых стратегий киберзащиты. Технологии, повышающие конфиденциальность, такие как синтетические данные и дифференциальная конфиденциальность, показывают, как обеспечить большие общественные выгоды без ущерба для личной информации. Государственные политики и отраслевые стандарты должны поощрять — и не препятствовать — эти позитивные изменения.

Необходимость совместной работы

Законы о конфиденциальности разработаны так, чтобы быть адаптивными, пропорциональными и технологически нейтральными — качества, которые сделали их надежными и долговечными.

Те же принципы применимы в эпоху ИИ, поскольку мы стремимся сбалансировать надежную защиту конфиденциальности с другими основополагающими правами и общественными целями.

Впереди потребуется сотрудничество сообщества конфиденциальности, и Google стремится работать с другими, чтобы обеспечить ответственное использование генеративного ИИ на благо общества.

Вы можете прочитать нашу рабочую статью по политике о генеративном ИИ и конфиденциальности [здесь](link to paper).

Связанная статья

"Исследование безопасности и этики ИИ: Эксперты Databricks и ElevenLabs"

По мере того как генеративный ИИ становится все более доступным и распространенным, этические соображения и меры безопасности выходят на первый план. Руководитель отдела безопасности ИИ компании Ele

"Исследование безопасности и этики ИИ: Эксперты Databricks и ElevenLabs"

По мере того как генеративный ИИ становится все более доступным и распространенным, этические соображения и меры безопасности выходят на первый план. Руководитель отдела безопасности ИИ компании Ele

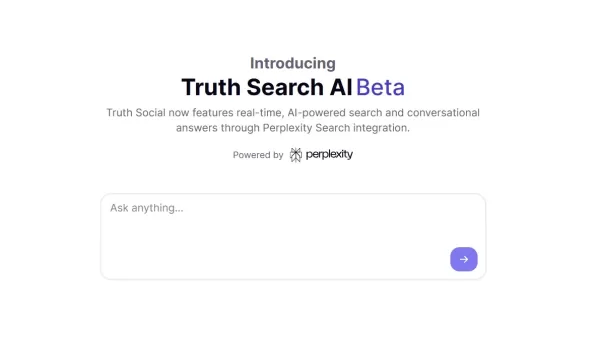

Новая поисковая система Truth Social с искусственным интеллектом отдает предпочтение Fox News в результатах поиска

Социальная медиаплатформа Трампа вводит функцию поиска на основе искусственного интеллекта с явным уклоном в консервативные СМИЭксклюзивная функция поиска с помощью искусственного интеллекта запущенаT

Новая поисковая система Truth Social с искусственным интеллектом отдает предпочтение Fox News в результатах поиска

Социальная медиаплатформа Трампа вводит функцию поиска на основе искусственного интеллекта с явным уклоном в консервативные СМИЭксклюзивная функция поиска с помощью искусственного интеллекта запущенаT

ChatGPT добавляет интеграцию с Google Drive и Dropbox для доступа к файлам

ChatGPT повышает продуктивность благодаря новым корпоративным функциямКомпания OpenAI представила две новые мощные функции, превращающие ChatGPT в комплексный инструмент повышения производительности

Комментарии (46)

ChatGPT добавляет интеграцию с Google Drive и Dropbox для доступа к файлам

ChatGPT повышает продуктивность благодаря новым корпоративным функциямКомпания OpenAI представила две новые мощные функции, превращающие ChatGPT в комплексный инструмент повышения производительности

Комментарии (46)

![JosephScott]() JosephScott

JosephScott

25 августа 2025 г., 14:01:04 GMT+03:00

25 августа 2025 г., 14:01:04 GMT+03:00

This article really opened my eyes to how crucial privacy is in AI development! It's wild to think about the balance between innovation and protecting our data. 😮 What’s next for ensuring AI doesn’t overstep boundaries?

0

0

![WillGarcía]() WillGarcía

WillGarcía

25 апреля 2025 г., 11:48:58 GMT+03:00

25 апреля 2025 г., 11:48:58 GMT+03:00

AI Worldはプライバシーを考慮した設計が素晴らしいですね。倫理的な開発に焦点を当てるのは新鮮ですが、インターフェースが少し使いづらい時があります。全体的に、責任あるAIの使用に向けた一歩だと思います!👍

0

0

![NicholasClark]() NicholasClark

NicholasClark

21 апреля 2025 г., 9:17:58 GMT+03:00

21 апреля 2025 г., 9:17:58 GMT+03:00

AI Worldはプライバシーに関する点で本当に的を射ているね。責任あるAI開発に焦点を当てるのは新鮮だ。ただ、プライバシー機能が時々少し制限が厳しすぎることがある。でも、正しい方向への一歩だよ!👍

0

0

![WillieJones]() WillieJones

WillieJones

18 апреля 2025 г., 22:40:31 GMT+03:00

18 апреля 2025 г., 22:40:31 GMT+03:00

AI World realmente da en el clavo con la privacidad. Es refrescante ver un enfoque en el desarrollo responsable de la IA. Pero a veces, las características de privacidad pueden ser un poco demasiado restrictivas. Aún así, es un paso en la dirección correcta! 👍

0

0

![AlbertThomas]() AlbertThomas

AlbertThomas

18 апреля 2025 г., 11:31:45 GMT+03:00

18 апреля 2025 г., 11:31:45 GMT+03:00

AI World은 정말로 프라이버시에 대해 핵심을 찌르고 있어요. 책임 있는 AI 개발에 초점을 맞추는 것이 새롭네요. 하지만 때때로 프라이버시 기능이 너무 제한적일 수 있어요. 그래도 올바른 방향으로의 한 걸음이에요! 👍

0

0

![LawrenceScott]() LawrenceScott

LawrenceScott

18 апреля 2025 г., 5:01:15 GMT+03:00

18 апреля 2025 г., 5:01:15 GMT+03:00

AI World really hits the nail on the head with privacy. It's refreshing to see a focus on responsible AI development. But sometimes, the privacy features can be a bit too restrictive. Still, it's a step in the right direction! 👍

0

0

Искусственный интеллект способен преобразовать всё — от повседневных дел до прорывных медицинских достижений. Однако, чтобы полностью реализовать потенциал ИИ, мы должны подходить к его разработке с приоритетом ответственности.

Поэтому обсуждение генеративного ИИ и конфиденциальности так важно. Мы стремимся внести свой вклад в эту дискуссию, опираясь на передовые инновации и глубокое взаимодействие с регуляторами и другими экспертами.

В нашей новой рабочей статье по политике под названием «Генеративный ИИ и конфиденциальность» мы выступаем за то, чтобы продукты ИИ включали встроенные механизмы защиты, которые с самого начала ставят в приоритет безопасность и конфиденциальность пользователей. Мы также предлагаем стратегии политики, которые решают проблемы конфиденциальности, позволяя ИИ процветать и приносить пользу обществу.

Конфиденциальность по умолчанию в ИИ

ИИ обещает большие преимущества для отдельных людей и общества, но он также может усиливать существующие проблемы и создавать новые, как показали наши исследования и исследования других.

То же касается конфиденциальности. Необходимо внедрять механизмы защиты, обеспечивающие прозрачность и контроль, а также снижающие риски, такие как непреднамеренное раскрытие личной информации.

Это требует прочной основы от стадии разработки до внедрения, основанной на проверенных временем принципах. Любая организация, разрабатывающая инструменты ИИ, должна иметь четкую стратегию конфиденциальности.

Наш подход сформирован на основе многолетних практик защиты данных, наших принципов конфиденциальности и безопасности, практик ответственного ИИ и наших принципов ИИ. Это означает, что мы внедряем надежные меры защиты конфиденциальности и методы минимизации данных, обеспечиваем прозрачность в отношении наших практик работы с данными и предоставляем инструменты управления, позволяющие пользователям принимать осознанные решения и управлять своей информацией.

Фокус на применении ИИ для эффективного снижения рисков

Применяя устоявшиеся принципы конфиденциальности к генеративному ИИ, необходимо учитывать важные вопросы.

Например, как практиковать минимизацию данных при обучении моделей на огромных объемах данных? Какие лучшие способы обеспечить значимую прозрачность для сложных моделей, учитывающих индивидуальные запросы? И как создать подходящие для возраста решения, которые приносят пользу подросткам в мире, управляемом ИИ?

Наша статья предлагает первоначальные мысли по этим темам, сосредотачиваясь на двух ключевых фазах разработки моделей:

- Обучение и разработка

- Приложения, ориентированные на пользователей

На этапе обучения и разработки личные данные, такие как имена или биографические детали, составляют небольшую, но важную часть обучающих данных. Модели используют эти данные, чтобы понять, как язык отражает абстрактные концепции человеческих отношений и окружающего мира.

Эти модели не являются «базами данных» и не предназначены для идентификации людей. Фактически, включение личных данных может помочь уменьшить предвзятость — например, лучше понимая имена из разных культур — и повысить точность и производительность модели.

На уровне приложений риск утечки данных возрастает, но также появляются возможности для внедрения более эффективных мер защиты. Функции, такие как фильтры вывода и автоматическое удаление, становятся здесь жизненно важными.

Приоритет этих мер защиты на уровне приложений не только практичен, но, как мы считаем, является наиболее эффективным путем вперед.

Достижение конфиденциальности через инновации

Хотя большая часть сегодняшнего диалога о конфиденциальности ИИ сосредоточена на снижении рисков — и это правильно, учитывая важность укрепления доверия к ИИ, — генеративный ИИ также имеет потенциал для усиления конфиденциальности пользователей. Мы должны использовать эти возможности.

Генеративный ИИ уже помогает организациям анализировать отзывы о конфиденциальности от больших пользовательских баз и выявлять проблемы соответствия. Он прокладывает путь для новых стратегий киберзащиты. Технологии, повышающие конфиденциальность, такие как синтетические данные и дифференциальная конфиденциальность, показывают, как обеспечить большие общественные выгоды без ущерба для личной информации. Государственные политики и отраслевые стандарты должны поощрять — и не препятствовать — эти позитивные изменения.

Необходимость совместной работы

Законы о конфиденциальности разработаны так, чтобы быть адаптивными, пропорциональными и технологически нейтральными — качества, которые сделали их надежными и долговечными.

Те же принципы применимы в эпоху ИИ, поскольку мы стремимся сбалансировать надежную защиту конфиденциальности с другими основополагающими правами и общественными целями.

Впереди потребуется сотрудничество сообщества конфиденциальности, и Google стремится работать с другими, чтобы обеспечить ответственное использование генеративного ИИ на благо общества.

Вы можете прочитать нашу рабочую статью по политике о генеративном ИИ и конфиденциальности [здесь](link to paper).

"Исследование безопасности и этики ИИ: Эксперты Databricks и ElevenLabs"

По мере того как генеративный ИИ становится все более доступным и распространенным, этические соображения и меры безопасности выходят на первый план. Руководитель отдела безопасности ИИ компании Ele

"Исследование безопасности и этики ИИ: Эксперты Databricks и ElevenLabs"

По мере того как генеративный ИИ становится все более доступным и распространенным, этические соображения и меры безопасности выходят на первый план. Руководитель отдела безопасности ИИ компании Ele

Новая поисковая система Truth Social с искусственным интеллектом отдает предпочтение Fox News в результатах поиска

Социальная медиаплатформа Трампа вводит функцию поиска на основе искусственного интеллекта с явным уклоном в консервативные СМИЭксклюзивная функция поиска с помощью искусственного интеллекта запущенаT

Новая поисковая система Truth Social с искусственным интеллектом отдает предпочтение Fox News в результатах поиска

Социальная медиаплатформа Трампа вводит функцию поиска на основе искусственного интеллекта с явным уклоном в консервативные СМИЭксклюзивная функция поиска с помощью искусственного интеллекта запущенаT

ChatGPT добавляет интеграцию с Google Drive и Dropbox для доступа к файлам

ChatGPT повышает продуктивность благодаря новым корпоративным функциямКомпания OpenAI представила две новые мощные функции, превращающие ChatGPT в комплексный инструмент повышения производительности

ChatGPT добавляет интеграцию с Google Drive и Dropbox для доступа к файлам

ChatGPT повышает продуктивность благодаря новым корпоративным функциямКомпания OpenAI представила две новые мощные функции, превращающие ChatGPT в комплексный инструмент повышения производительности

25 августа 2025 г., 14:01:04 GMT+03:00

25 августа 2025 г., 14:01:04 GMT+03:00

This article really opened my eyes to how crucial privacy is in AI development! It's wild to think about the balance between innovation and protecting our data. 😮 What’s next for ensuring AI doesn’t overstep boundaries?

0

0

25 апреля 2025 г., 11:48:58 GMT+03:00

25 апреля 2025 г., 11:48:58 GMT+03:00

AI Worldはプライバシーを考慮した設計が素晴らしいですね。倫理的な開発に焦点を当てるのは新鮮ですが、インターフェースが少し使いづらい時があります。全体的に、責任あるAIの使用に向けた一歩だと思います!👍

0

0

21 апреля 2025 г., 9:17:58 GMT+03:00

21 апреля 2025 г., 9:17:58 GMT+03:00

AI Worldはプライバシーに関する点で本当に的を射ているね。責任あるAI開発に焦点を当てるのは新鮮だ。ただ、プライバシー機能が時々少し制限が厳しすぎることがある。でも、正しい方向への一歩だよ!👍

0

0

18 апреля 2025 г., 22:40:31 GMT+03:00

18 апреля 2025 г., 22:40:31 GMT+03:00

AI World realmente da en el clavo con la privacidad. Es refrescante ver un enfoque en el desarrollo responsable de la IA. Pero a veces, las características de privacidad pueden ser un poco demasiado restrictivas. Aún así, es un paso en la dirección correcta! 👍

0

0

18 апреля 2025 г., 11:31:45 GMT+03:00

18 апреля 2025 г., 11:31:45 GMT+03:00

AI World은 정말로 프라이버시에 대해 핵심을 찌르고 있어요. 책임 있는 AI 개발에 초점을 맞추는 것이 새롭네요. 하지만 때때로 프라이버시 기능이 너무 제한적일 수 있어요. 그래도 올바른 방향으로의 한 걸음이에요! 👍

0

0

18 апреля 2025 г., 5:01:15 GMT+03:00

18 апреля 2025 г., 5:01:15 GMT+03:00

AI World really hits the nail on the head with privacy. It's refreshing to see a focus on responsible AI development. But sometimes, the privacy features can be a bit too restrictive. Still, it's a step in the right direction! 👍

0

0