New Wave Tech mejora las emociones de Android para una mayor naturalidad

Si alguna vez has conversado con un androide que parece sorprendentemente humano, es posible que hayas sentido que algo estaba "mal". Esta sensación inquietante va más allá de la mera apariencia; está profundamente relacionada con cómo los robots transmiten emociones y mantienen esos estados emocionales. En esencia, se trata de su deficiencia para imitar capacidades emocionales similares a las humanas.

Los androides actuales son hábiles para imitar expresiones faciales individuales, pero el verdadero desafío está en crear transiciones suaves y mantener una consistencia emocional. Los sistemas tradicionales a menudo dependen de expresiones predefinidas, lo que puede sentirse como hojear un libro de imágenes estáticas en lugar de un flujo natural de emociones. Esta rigidez puede provocar una desconexión entre lo que vemos y lo que parece una expresión emocional genuina.

Esto se vuelve especialmente notable durante interacciones más largas. Un androide puede mostrar una sonrisa perfecta en un momento, pero luego luchar para cambiar de manera fluida a otra expresión, recordándonos que estamos tratando con una máquina en lugar de un ser con emociones reales.

Una solución basada en ondas

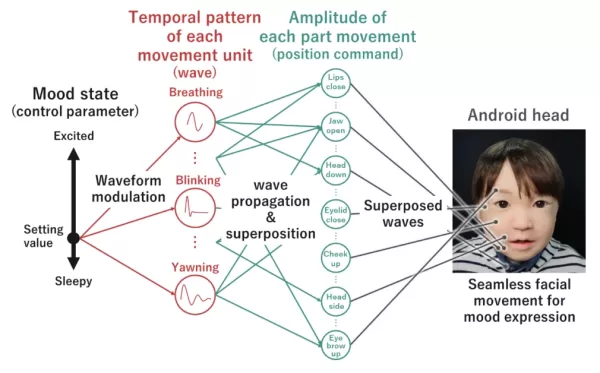

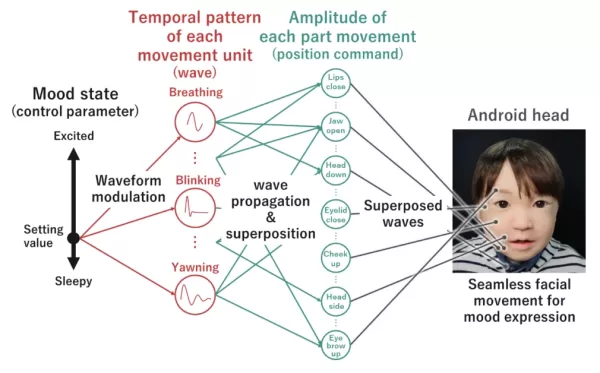

La investigación innovadora de la Universidad de Osaka presenta una nueva perspectiva sobre cómo los androides deben expresar emociones. En lugar de ver las expresiones faciales como acciones separadas, esta nueva tecnología las considera como ondas de movimiento interconectadas que barren naturalmente el rostro de un androide.

Piensa en ello como una sinfonía donde varios instrumentos se combinan para crear armonía. Este sistema fusiona diferentes movimientos faciales —desde la respiración sutil hasta los parpadeos— en un todo cohesivo. Cada movimiento se representa como una onda que puede ajustarse y combinarse con otras en tiempo real.

La innovación aquí es la naturaleza dinámica de este enfoque. Al generar expresiones de manera orgánica a través de la superposición de estas ondas de movimiento, se crea un aspecto más fluido y natural, eliminando esas transiciones robóticas que pueden romper la ilusión de una expresión emocional auténtica.

El avance técnico clave es lo que los investigadores denominan "modulación de forma de onda". Esta característica permite que el estado interno del androide afecte directamente cómo se manifiestan estas ondas de expresión, fomentando un vínculo más genuino entre las emociones programadas del robot y sus expresiones físicas.

Inteligencia emocional en tiempo real

Considera el desafío de hacer que un robot parezca somnoliento. No se trata solo de párpados caídos; implica coordinar numerosos movimientos sutiles que los humanos reconocen instintivamente como signos de fatiga. Este nuevo sistema aborda esta complejidad a través de un enfoque ingenioso para la coordinación de movimientos.

Capacidades de expresión dinámica

La tecnología orquesta nueve tipos fundamentales de movimientos coordinados asociados con diversos estados de activación: respiración, parpadeo espontáneo, movimientos oculares erráticos, cabeceo por sueño, sacudidas de cabeza, reflejo de succión, nistagmo pendular, balanceo lateral de la cabeza y bostezos.

Cada movimiento está gobernado por una "onda decreciente", un patrón matemático que dicta cómo evoluciona el movimiento con el tiempo. Estas ondas se ajustan meticulosamente utilizando cinco parámetros clave:

- Amplitud: controla la intensidad del movimiento

- Relación de amortiguación: determina qué tan rápido se desvanece el movimiento

- Longitud de onda: establece el tiempo del movimiento

- Centro de oscilación: establece el punto neutro del movimiento

- Período de reactivación: dicta con qué frecuencia se repite el movimiento

Reflejo del estado interno

La característica destacada de este sistema es su capacidad para vincular estos movimientos al estado de activación interno del robot. Cuando el sistema señala alta activación (como excitación), ciertos parámetros de la onda se ajustan automáticamente —por ejemplo, la respiración se vuelve más frecuente y pronunciada. En un estado de baja activación (como somnolencia), podrías observar bostezos más lentos y pronunciados y cabeceos ocasionales.

Esto se logra a través de módulos de "gestión temporal" y "gestión postural". El módulo temporal dicta cuándo ocurren los movimientos, mientras que el módulo postural asegura que todos los componentes faciales trabajen en armonía.

Hisashi Ishihara, el autor principal de esta investigación y Profesor Asociado en el Departamento de Ingeniería Mecánica, Escuela de Graduados de Ingeniería, Universidad de Osaka, explica: "En lugar de crear movimientos superficiales, el desarrollo adicional de un sistema en el que las emociones internas se reflejen en cada detalle de las acciones de un androide podría llevar a la creación de androides percibidos como si tuvieran un corazón."

Mejora en las transiciones

A diferencia de los sistemas tradicionales que cambian entre expresiones pregrabadas, este enfoque asegura transiciones suaves al ajustar continuamente estos parámetros de onda. Los movimientos se coordinan a través de una red sofisticada que asegura que las acciones faciales trabajen juntas de manera natural, muy parecido a cómo los movimientos faciales de un humano se coordinan inconscientemente.

El equipo de investigación demostró esto a través de experimentos que muestran cómo el sistema podía transmitir eficazmente diferentes niveles de activación mientras mantenía expresiones de apariencia natural.

Implicaciones futuras

El desarrollo de este sistema de expresión emocional basado en ondas abre posibilidades emocionantes para la interacción humano-robot y podría integrarse potencialmente con tecnologías como Embodied AI. Mientras que los androides actuales a menudo evocan una sensación de incomodidad durante interacciones prolongadas, esta tecnología podría ayudar a cerrar el valle inquietante —ese espacio inquietante donde los robots parecen casi, pero no del todo, humanos.

El avance crucial está en crear una presencia emocional de sensación genuina. Al generar expresiones fluidas y apropiadas al contexto que se alineen con los estados internos, los androides podrían volverse más efectivos en roles que requieren inteligencia emocional y conexión humana.

Koichi Osuka, el autor principal y Profesor en el Departamento de Ingeniería Mecánica de la Universidad de Osaka, señala que esta tecnología "podría enriquecer enormemente la comunicación emocional entre humanos y robots." Imagina compañeros de atención médica expresando preocupación adecuada, robots educativos mostrando entusiasmo, o robots de servicio transmitiendo una atención de apariencia genuina.

La investigación muestra resultados particularmente prometedores en la expresión de diferentes niveles de activación —desde la excitación de alta energía hasta la somnolencia de baja energía. Esta capacidad podría ser vital en escenarios donde los robots necesitan:

- Transmitir niveles de alerta durante interacciones a largo plazo

- Expresar niveles de energía apropiados en entornos terapéuticos

- Coincidir su estado emocional con el contexto social

- Mantener consistencia emocional durante conversaciones prolongadas

La capacidad del sistema para generar transiciones naturales entre estados lo hace especialmente valioso para aplicaciones que requieren interacción humano-robot sostenida.

Al tratar la expresión emocional como un fenómeno fluido basado en ondas en lugar de una serie de estados preprogramados, la tecnología abre muchas nuevas posibilidades para crear robots que puedan interactuar con humanos de maneras emocionalmente significativas. Los próximos pasos del equipo de investigación se centrarán en expandir el rango emocional del sistema y refinar aún más su capacidad para transmitir estados emocionales sutiles, influyendo en cómo pensaremos e interactuaremos con los androides en nuestra vida diaria.

Artículo relacionado

Hugging Face Lanza Pedidos Anticipados para Robots de Escritorio Reachy Mini

Hugging Face invita a los desarrolladores a explorar su última innovación en robótica.La plataforma de IA anunció el miércoles que ahora acepta pedidos anticipados para sus robots de escritorio Reachy

Hugging Face Lanza Pedidos Anticipados para Robots de Escritorio Reachy Mini

Hugging Face invita a los desarrolladores a explorar su última innovación en robótica.La plataforma de IA anunció el miércoles que ahora acepta pedidos anticipados para sus robots de escritorio Reachy

Nvidia impulsa la robótica humanoide con apoyo en la nube

Nvidia avanza a toda velocidad en el ámbito de la robótica humanoide y no se contiene. En la feria Computex 2025 en Taiwán, revelaron una serie de innovaciones que están destinadas

Nvidia impulsa la robótica humanoide con apoyo en la nube

Nvidia avanza a toda velocidad en el ámbito de la robótica humanoide y no se contiene. En la feria Computex 2025 en Taiwán, revelaron una serie de innovaciones que están destinadas

Top 5 robots autónomos para sitios de construcción en abril de 2025

La industria de la construcción está experimentando una notable transformación, impulsada por el surgimiento de la robótica y la automatización. Con el mercado global de robots de construcción proyectados para alcanzar los $ 3.5 mil millones para 2030, estas innovaciones están revolucionando la seguridad y la eficiencia en los sitios de trabajo. De la pila autónoma D

comentario (6)

0/200

Top 5 robots autónomos para sitios de construcción en abril de 2025

La industria de la construcción está experimentando una notable transformación, impulsada por el surgimiento de la robótica y la automatización. Con el mercado global de robots de construcción proyectados para alcanzar los $ 3.5 mil millones para 2030, estas innovaciones están revolucionando la seguridad y la eficiencia en los sitios de trabajo. De la pila autónoma D

comentario (6)

0/200

![RogerRodriguez]() RogerRodriguez

RogerRodriguez

28 de julio de 2025 03:18:39 GMT+02:00

28 de julio de 2025 03:18:39 GMT+02:00

This article about android emotions is wild! It’s creepy how close they’re getting to human-like vibes, but I wonder if we’re ready for robots that can fake feelings this well. 😅 What’s next, a robot therapist?

0

0

![JerryMoore]() JerryMoore

JerryMoore

23 de abril de 2025 17:33:32 GMT+02:00

23 de abril de 2025 17:33:32 GMT+02:00

뉴 웨이브 테크의 안드로이드 감정 표현은 흥미롭지만, 여전히 어색함이 느껴져요. 자연스러움에 가까워지고 있지만, 아직 갈 길이 멀어요. 계속 노력하세요! 🤖😑

0

0

![JasonMartin]() JasonMartin

JasonMartin

23 de abril de 2025 03:26:44 GMT+02:00

23 de abril de 2025 03:26:44 GMT+02:00

O trabalho da New Wave Tech nas emoções dos androides é interessante, mas ainda parece um pouco estranho. Eles estão se aproximando da naturalidade, mas ainda há um longo caminho a percorrer. Continuem tentando, pessoal! 🤖😒

0

0

![WalterAnderson]() WalterAnderson

WalterAnderson

22 de abril de 2025 17:23:09 GMT+02:00

22 de abril de 2025 17:23:09 GMT+02:00

New Wave Tech's work on android emotions is interesting, but it still feels a bit off. They're getting closer to naturalness, but there's still a way to go. Keep pushing, guys! 🤖😕

0

0

![RobertMartin]() RobertMartin

RobertMartin

22 de abril de 2025 12:44:01 GMT+02:00

22 de abril de 2025 12:44:01 GMT+02:00

ニューウェーブテックのアンドロイドの感情表現は面白いけど、まだ違和感があるね。自然さに近づいてるけど、まだ道のりは長い。頑張って!🤖😐

0

0

![CharlesYoung]() CharlesYoung

CharlesYoung

22 de abril de 2025 03:11:23 GMT+02:00

22 de abril de 2025 03:11:23 GMT+02:00

El trabajo de New Wave Tech en las emociones de los androides es interesante, pero todavía se siente un poco raro. Están acercándose a la naturalidad, pero aún les falta. ¡Sigan adelante, chicos! 🤖😕

0

0

Si alguna vez has conversado con un androide que parece sorprendentemente humano, es posible que hayas sentido que algo estaba "mal". Esta sensación inquietante va más allá de la mera apariencia; está profundamente relacionada con cómo los robots transmiten emociones y mantienen esos estados emocionales. En esencia, se trata de su deficiencia para imitar capacidades emocionales similares a las humanas.

Los androides actuales son hábiles para imitar expresiones faciales individuales, pero el verdadero desafío está en crear transiciones suaves y mantener una consistencia emocional. Los sistemas tradicionales a menudo dependen de expresiones predefinidas, lo que puede sentirse como hojear un libro de imágenes estáticas en lugar de un flujo natural de emociones. Esta rigidez puede provocar una desconexión entre lo que vemos y lo que parece una expresión emocional genuina.

Esto se vuelve especialmente notable durante interacciones más largas. Un androide puede mostrar una sonrisa perfecta en un momento, pero luego luchar para cambiar de manera fluida a otra expresión, recordándonos que estamos tratando con una máquina en lugar de un ser con emociones reales.

Una solución basada en ondas

La investigación innovadora de la Universidad de Osaka presenta una nueva perspectiva sobre cómo los androides deben expresar emociones. En lugar de ver las expresiones faciales como acciones separadas, esta nueva tecnología las considera como ondas de movimiento interconectadas que barren naturalmente el rostro de un androide.

Piensa en ello como una sinfonía donde varios instrumentos se combinan para crear armonía. Este sistema fusiona diferentes movimientos faciales —desde la respiración sutil hasta los parpadeos— en un todo cohesivo. Cada movimiento se representa como una onda que puede ajustarse y combinarse con otras en tiempo real.

La innovación aquí es la naturaleza dinámica de este enfoque. Al generar expresiones de manera orgánica a través de la superposición de estas ondas de movimiento, se crea un aspecto más fluido y natural, eliminando esas transiciones robóticas que pueden romper la ilusión de una expresión emocional auténtica.

El avance técnico clave es lo que los investigadores denominan "modulación de forma de onda". Esta característica permite que el estado interno del androide afecte directamente cómo se manifiestan estas ondas de expresión, fomentando un vínculo más genuino entre las emociones programadas del robot y sus expresiones físicas.

Inteligencia emocional en tiempo real

Considera el desafío de hacer que un robot parezca somnoliento. No se trata solo de párpados caídos; implica coordinar numerosos movimientos sutiles que los humanos reconocen instintivamente como signos de fatiga. Este nuevo sistema aborda esta complejidad a través de un enfoque ingenioso para la coordinación de movimientos.

Capacidades de expresión dinámica

La tecnología orquesta nueve tipos fundamentales de movimientos coordinados asociados con diversos estados de activación: respiración, parpadeo espontáneo, movimientos oculares erráticos, cabeceo por sueño, sacudidas de cabeza, reflejo de succión, nistagmo pendular, balanceo lateral de la cabeza y bostezos.

Cada movimiento está gobernado por una "onda decreciente", un patrón matemático que dicta cómo evoluciona el movimiento con el tiempo. Estas ondas se ajustan meticulosamente utilizando cinco parámetros clave:

- Amplitud: controla la intensidad del movimiento

- Relación de amortiguación: determina qué tan rápido se desvanece el movimiento

- Longitud de onda: establece el tiempo del movimiento

- Centro de oscilación: establece el punto neutro del movimiento

- Período de reactivación: dicta con qué frecuencia se repite el movimiento

Reflejo del estado interno

La característica destacada de este sistema es su capacidad para vincular estos movimientos al estado de activación interno del robot. Cuando el sistema señala alta activación (como excitación), ciertos parámetros de la onda se ajustan automáticamente —por ejemplo, la respiración se vuelve más frecuente y pronunciada. En un estado de baja activación (como somnolencia), podrías observar bostezos más lentos y pronunciados y cabeceos ocasionales.

Esto se logra a través de módulos de "gestión temporal" y "gestión postural". El módulo temporal dicta cuándo ocurren los movimientos, mientras que el módulo postural asegura que todos los componentes faciales trabajen en armonía.

Hisashi Ishihara, el autor principal de esta investigación y Profesor Asociado en el Departamento de Ingeniería Mecánica, Escuela de Graduados de Ingeniería, Universidad de Osaka, explica: "En lugar de crear movimientos superficiales, el desarrollo adicional de un sistema en el que las emociones internas se reflejen en cada detalle de las acciones de un androide podría llevar a la creación de androides percibidos como si tuvieran un corazón."

Mejora en las transiciones

A diferencia de los sistemas tradicionales que cambian entre expresiones pregrabadas, este enfoque asegura transiciones suaves al ajustar continuamente estos parámetros de onda. Los movimientos se coordinan a través de una red sofisticada que asegura que las acciones faciales trabajen juntas de manera natural, muy parecido a cómo los movimientos faciales de un humano se coordinan inconscientemente.

El equipo de investigación demostró esto a través de experimentos que muestran cómo el sistema podía transmitir eficazmente diferentes niveles de activación mientras mantenía expresiones de apariencia natural.

Implicaciones futuras

El desarrollo de este sistema de expresión emocional basado en ondas abre posibilidades emocionantes para la interacción humano-robot y podría integrarse potencialmente con tecnologías como Embodied AI. Mientras que los androides actuales a menudo evocan una sensación de incomodidad durante interacciones prolongadas, esta tecnología podría ayudar a cerrar el valle inquietante —ese espacio inquietante donde los robots parecen casi, pero no del todo, humanos.

El avance crucial está en crear una presencia emocional de sensación genuina. Al generar expresiones fluidas y apropiadas al contexto que se alineen con los estados internos, los androides podrían volverse más efectivos en roles que requieren inteligencia emocional y conexión humana.

Koichi Osuka, el autor principal y Profesor en el Departamento de Ingeniería Mecánica de la Universidad de Osaka, señala que esta tecnología "podría enriquecer enormemente la comunicación emocional entre humanos y robots." Imagina compañeros de atención médica expresando preocupación adecuada, robots educativos mostrando entusiasmo, o robots de servicio transmitiendo una atención de apariencia genuina.

La investigación muestra resultados particularmente prometedores en la expresión de diferentes niveles de activación —desde la excitación de alta energía hasta la somnolencia de baja energía. Esta capacidad podría ser vital en escenarios donde los robots necesitan:

- Transmitir niveles de alerta durante interacciones a largo plazo

- Expresar niveles de energía apropiados en entornos terapéuticos

- Coincidir su estado emocional con el contexto social

- Mantener consistencia emocional durante conversaciones prolongadas

La capacidad del sistema para generar transiciones naturales entre estados lo hace especialmente valioso para aplicaciones que requieren interacción humano-robot sostenida.

Al tratar la expresión emocional como un fenómeno fluido basado en ondas en lugar de una serie de estados preprogramados, la tecnología abre muchas nuevas posibilidades para crear robots que puedan interactuar con humanos de maneras emocionalmente significativas. Los próximos pasos del equipo de investigación se centrarán en expandir el rango emocional del sistema y refinar aún más su capacidad para transmitir estados emocionales sutiles, influyendo en cómo pensaremos e interactuaremos con los androides en nuestra vida diaria.

Hugging Face Lanza Pedidos Anticipados para Robots de Escritorio Reachy Mini

Hugging Face invita a los desarrolladores a explorar su última innovación en robótica.La plataforma de IA anunció el miércoles que ahora acepta pedidos anticipados para sus robots de escritorio Reachy

Hugging Face Lanza Pedidos Anticipados para Robots de Escritorio Reachy Mini

Hugging Face invita a los desarrolladores a explorar su última innovación en robótica.La plataforma de IA anunció el miércoles que ahora acepta pedidos anticipados para sus robots de escritorio Reachy

Nvidia impulsa la robótica humanoide con apoyo en la nube

Nvidia avanza a toda velocidad en el ámbito de la robótica humanoide y no se contiene. En la feria Computex 2025 en Taiwán, revelaron una serie de innovaciones que están destinadas

Nvidia impulsa la robótica humanoide con apoyo en la nube

Nvidia avanza a toda velocidad en el ámbito de la robótica humanoide y no se contiene. En la feria Computex 2025 en Taiwán, revelaron una serie de innovaciones que están destinadas

Top 5 robots autónomos para sitios de construcción en abril de 2025

La industria de la construcción está experimentando una notable transformación, impulsada por el surgimiento de la robótica y la automatización. Con el mercado global de robots de construcción proyectados para alcanzar los $ 3.5 mil millones para 2030, estas innovaciones están revolucionando la seguridad y la eficiencia en los sitios de trabajo. De la pila autónoma D

Top 5 robots autónomos para sitios de construcción en abril de 2025

La industria de la construcción está experimentando una notable transformación, impulsada por el surgimiento de la robótica y la automatización. Con el mercado global de robots de construcción proyectados para alcanzar los $ 3.5 mil millones para 2030, estas innovaciones están revolucionando la seguridad y la eficiencia en los sitios de trabajo. De la pila autónoma D

28 de julio de 2025 03:18:39 GMT+02:00

28 de julio de 2025 03:18:39 GMT+02:00

This article about android emotions is wild! It’s creepy how close they’re getting to human-like vibes, but I wonder if we’re ready for robots that can fake feelings this well. 😅 What’s next, a robot therapist?

0

0

23 de abril de 2025 17:33:32 GMT+02:00

23 de abril de 2025 17:33:32 GMT+02:00

뉴 웨이브 테크의 안드로이드 감정 표현은 흥미롭지만, 여전히 어색함이 느껴져요. 자연스러움에 가까워지고 있지만, 아직 갈 길이 멀어요. 계속 노력하세요! 🤖😑

0

0

23 de abril de 2025 03:26:44 GMT+02:00

23 de abril de 2025 03:26:44 GMT+02:00

O trabalho da New Wave Tech nas emoções dos androides é interessante, mas ainda parece um pouco estranho. Eles estão se aproximando da naturalidade, mas ainda há um longo caminho a percorrer. Continuem tentando, pessoal! 🤖😒

0

0

22 de abril de 2025 17:23:09 GMT+02:00

22 de abril de 2025 17:23:09 GMT+02:00

New Wave Tech's work on android emotions is interesting, but it still feels a bit off. They're getting closer to naturalness, but there's still a way to go. Keep pushing, guys! 🤖😕

0

0

22 de abril de 2025 12:44:01 GMT+02:00

22 de abril de 2025 12:44:01 GMT+02:00

ニューウェーブテックのアンドロイドの感情表現は面白いけど、まだ違和感があるね。自然さに近づいてるけど、まだ道のりは長い。頑張って!🤖😐

0

0

22 de abril de 2025 03:11:23 GMT+02:00

22 de abril de 2025 03:11:23 GMT+02:00

El trabajo de New Wave Tech en las emociones de los androides es interesante, pero todavía se siente un poco raro. Están acercándose a la naturalidad, pero aún les falta. ¡Sigan adelante, chicos! 🤖😕

0

0