Crear modelos 3D a partir de imágenes individuales con Python AI en sencillos pasos

La capacidad de transformar imágenes 2D en modelos 3D abre un enorme potencial en múltiples sectores. Esta guía examina cómo las potentes capacidades de procesamiento de IA y 3D de Python permiten la creación de mallas 3D detalladas a partir de imágenes individuales. Descubra las tecnologías de vanguardia y los flujos de trabajo prácticos que lo hacen posible.

Aspectos destacados

Transformación potenciada por IA: Convierta imágenes planas en modelos 3D totalmente realistas utilizando técnicas de aprendizaje profundo.

Ecosistema Python: Aproveche las bibliotecas especializadas para generar modelos 3D sin problemas.

Flujo de trabajo integral: Siga un proceso probado de seis etapas desde la imagen hasta la malla.

Fuentes de imágenes flexibles: Utilice fotos existentes o cree imágenes personalizadas con generadores de IA.

Integración avanzada: Combínelo con Stable Diffusion para obtener posibilidades creativas ilimitadas.

Aplicaciones intersectoriales: Aplique estas técnicas a juegos, arquitectura, diseño de productos y mucho más.

Creación de activos 3D con Python AI

Introducción a la generación de mallas 3D a partir de imágenes 2D

La convergencia del aprendizaje profundo y el procesamiento 3D ha revolucionado la creación de contenidos digitales. Las técnicas modernas ahora permiten convertir fotografías ordinarias en activos 3D completamente texturizados, abriendo nuevas posibilidades creativas en múltiples industrias. Este avance democratiza el modelado 3D, haciendo accesible la creación de activos de nivel profesional sin necesidad de equipos especializados.

La comprensión de la tecnología subyacente revela tres componentes críticos que permiten esta transformación:

- Las redes neuronales de estimación de profundidad analizan las señales visuales para determinar las relaciones espaciales dentro de las imágenes 2D.

- El procesamiento de nubes de puntos convierte los datos de profundidad en coordenadas espaciales que forman la estructura del modelo.

- Los algoritmos de reconstrucción de mallas conectan de forma inteligente estos puntos en superficies continuas.

Python sirve como la plataforma ideal para implementar este flujo de trabajo, proporcionando:

- Potentes marcos de aprendizaje profundo como PyTorch para entrenar redes neuronales

- Computación numérica avanzada a través de NumPy y SciPy

- Procesamiento 3D especializado a través de Open3D para la salida final del modelo

Flujo de trabajo central para la generación 3D

El proceso de conversión de imagen a 3D sigue una metodología estructurada de seis pasos:

- Configuración del entorno: Configuración del ecosistema de desarrollo Python con las bibliotecas de procesamiento 3D y de IA necesarias

- Adquisición de imágenes de origen: Captura o generación de datos 2D de alta calidad mediante cámaras o sistemas de conversión de texto a imagen de IA.

- Optimización de la imagen: Mejora y preparación de la imagen de origen para obtener la máxima precisión en la estimación de la profundidad

- Cálculo de profundidad: Empleo de redes neuronales entrenadas para derivar información espacial de la entrada 2D

- Cartografía espacial: Convertir los datos de profundidad en una representación de nube de puntos 3D

- Construcción de malla final: Generar superficies texturizadas entre puntos para completar el modelo

Bibliotecas esenciales de Python

Cinco bibliotecas clave forman la base de la generación de mallas 3D basada en Python:

Biblioteca Función principal Función principal PyTorch Estructura de red neuronal Entrenamiento acelerado en la GPU, gráficos de cálculo dinámicos TorchVision Soporte de visión por computador Modelos preentrenados, transformaciones de imágenes NumPy Cálculo numérico Operaciones eficientes con matrices, álgebra lineal Open3D Procesamiento 3D Manipulación de nubes de puntos, reconstrucción de mallas SciPy Computación científica Algoritmos avanzados, funciones de optimización

Desglose detallado del proceso

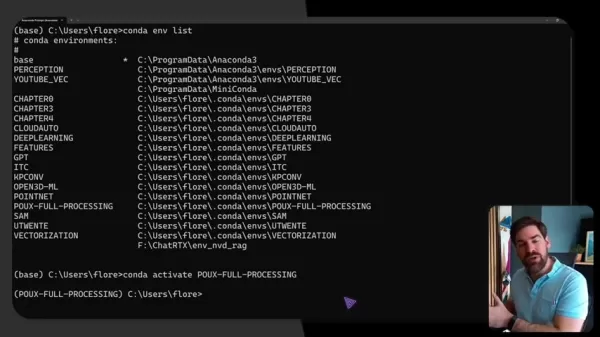

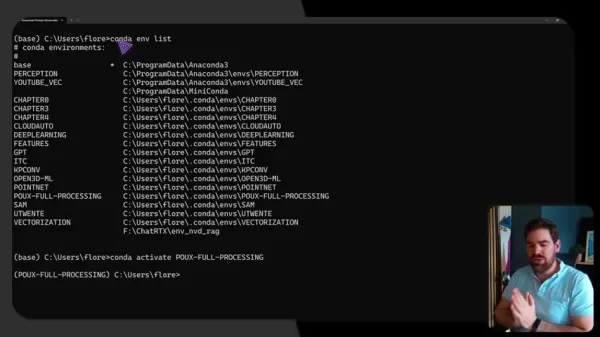

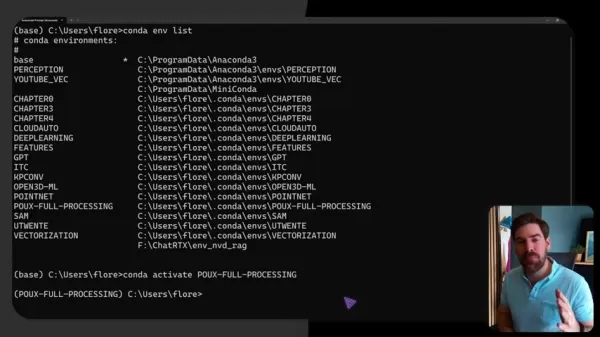

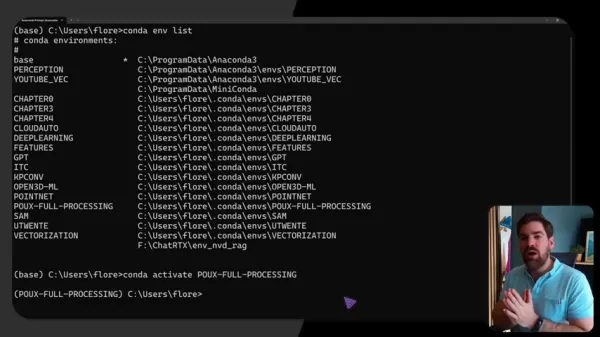

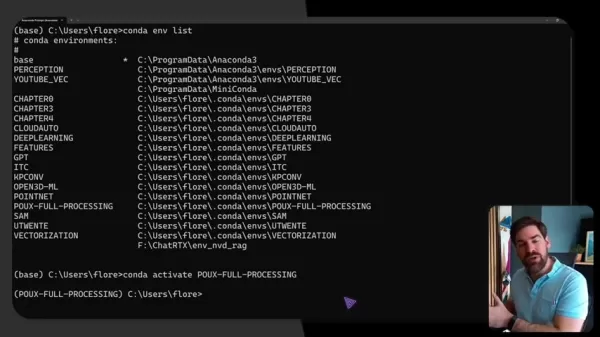

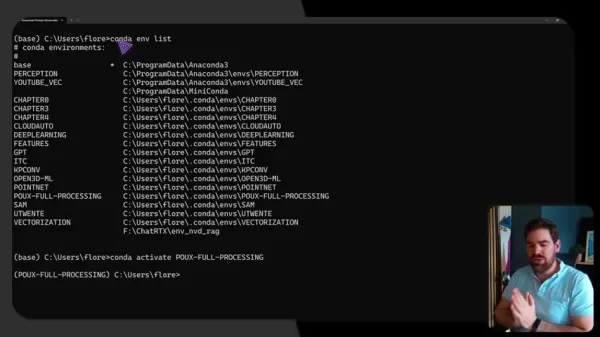

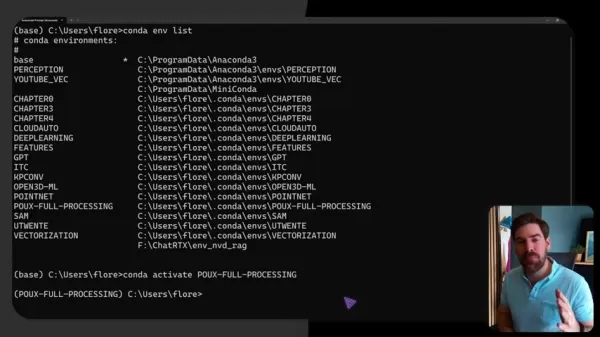

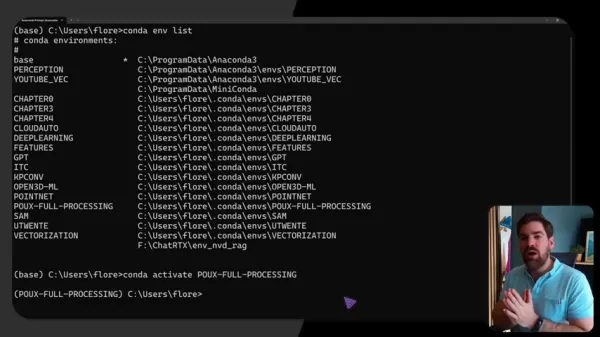

Configuración del entorno

Una configuración adecuada garantiza un funcionamiento sin problemas gracias a la gestión del entorno basada en Conda:

conda create -n 3dgen python=3.9 conda activate 3dgen pip install torch torchvision open3d numpy scipy

Proceso de imágenes

La optimización de las imágenes de origen implica múltiples etapas de mejora:

- Normalización de la resolución a los requisitos de entrada de la red neuronal

- Normalización de la luz para una estimación coherente de la profundidad

- Mejora del contraste para acentuar los detalles estructurales

- Reducción del ruido para una reconstrucción geométrica limpia

- Nitidez de las características para mejorar la detección de bordes

Tecnología de estimación de la profundidad

Las modernas redes neuronales analizan diversas señales visuales de profundidad:

- Comparación del tamaño relativo del objeto

- Análisis de gradientes de textura

- Relaciones de oclusión

- Interpretación de la perspectiva atmosférica

- Patrones de sombreado e iluminación

Generación de nubes de puntos

La creación de coordenadas espaciales implica una proyección sofisticada:

- Calibración de parámetros intrínsecos de la cámara

- Transformación del sistema de coordenadas 2D a 3D

- Optimización de la densidad de puntos

- Filtrado de valores atípicos

- Reducción del ruido espacial

Técnicas de construcción de mallas

La generación del modelo final emplea la reconstrucción avanzada de superficies

- Reconstrucción de superficies de Poisson para mallas lisas

- Pivotaje de bolas para crear topologías eficientes

- Marching cubes para renderizado volumétrico

- Simplificación de mallas para optimizar el rendimiento

- Desenvoltura UV para mapeado de texturas

IA e integración avanzada

Implementación de difusión estable

La integración de IA generativa amplía las posibilidades creativas:

- Ingeniería de indicaciones de texto para las características de imagen deseadas

- Selección de modelos basada en requisitos de estilo artístico

- Optimización de parámetros para obtener resultados de calidad

- Procesamiento por lotes para el perfeccionamiento iterativo

- Alineación de los resultados con las especificaciones del conducto 3D

Arquitecturas de redes neuronales

La elección del modelo de IA influye en la calidad de la reconstrucción:

- Estimadores de profundidad monocular basados en CNN

- Arquitecturas de transformadores para el contexto global

- Modelos híbridos que combinan varios enfoques

- Mecanismos de atención para preservar los detalles

- Procesamiento multiescala para un análisis exhaustivo

Guía práctica de implementación

Requisitos del sistema

Una configuración óptima del hardware garantiza un funcionamiento sin problemas:

Componente Mínimo Recomendado GPU 4 GB VRAM 8GB+ VRAM (NVIDIA RTX) RAM 16GB MÁS DE 32 GB Almacenamiento 256GB SSD 1TB NVMe SO Windows/Linux Linux para producción

Aplicaciones industriales

Casos de uso transformadores en todos los sectores:

- Juegos: Creación rápida de entornos y personajes

- Arquitectura: Modelado de las condiciones existentes a partir de fotografías del emplazamiento

- Diseño de productos: Visualización de conceptos a partir de bocetos

- Comercio electrónico: vistas de productos en 3D a partir de imágenes de productos estándar

- Patrimonio cultural: Conservación de artefactos mediante gemelos digitales

PREGUNTAS FRECUENTES

¿Qué hardware se necesita para un procesamiento eficiente?

Una GPU NVIDIA dedicada con al menos 8 GB de VRAM acelera significativamente el cálculo, aunque algunas operaciones básicas pueden ejecutarse en CPUs capaces con la RAM adecuada.

¿Cómo puedo mejorar la calidad de la malla a partir de imágenes complejas?

La fusión de varias imágenes, las sugerencias manuales de profundidad y las técnicas de refinamiento posteriores al procesamiento pueden mejorar los resultados a partir de imágenes de origen con poco contraste o sin textura.

¿Existen alternativas comerciales a las herramientas de código abierto?

Varias plataformas SaaS ofrecen servicios de generación 3D basados en web, aunque con menos personalización que las soluciones basadas en Python y costes de suscripción continuos.

¿Qué formatos de archivo admiten los modelos 3D de salida?

El proceso suele generar formatos estándar del sector, como OBJ, STL, PLY y glTF, para lograr la máxima compatibilidad de software.

Artículo relacionado

Por qué fracasan la mayoría de los redactores de contenidos SEO con IA - y las mejores alternativas a utilizar

En el competitivo entorno actual del marketing digital, la inteligencia artificial se ha convertido en un componente esencial de las estrategias eficaces de SEO. Sin embargo, muchas empresas descubren

Por qué fracasan la mayoría de los redactores de contenidos SEO con IA - y las mejores alternativas a utilizar

En el competitivo entorno actual del marketing digital, la inteligencia artificial se ha convertido en un componente esencial de las estrategias eficaces de SEO. Sin embargo, muchas empresas descubren

La tecnología de chat en directo basada en IA revela un gran avance en la identificación en tiempo real

La integración de la inteligencia artificial en la comunicación por vídeo en directo está revolucionando la forma en que analizamos y comprendemos nuestro entorno en tiempo real. Esta tecnología de va

La tecnología de chat en directo basada en IA revela un gran avance en la identificación en tiempo real

La integración de la inteligencia artificial en la comunicación por vídeo en directo está revolucionando la forma en que analizamos y comprendemos nuestro entorno en tiempo real. Esta tecnología de va

Scale AI se asegura una importante inversión en Meta en medio de la salida del CEO Alexandr Wang

Scale AI, empresa líder en el etiquetado de datos, ha conseguido una financiación sustancial de Meta con una valoración de 29.000 millones de dólares, al tiempo que anuncia una importante transición d

comentario (0)

0/200

Scale AI se asegura una importante inversión en Meta en medio de la salida del CEO Alexandr Wang

Scale AI, empresa líder en el etiquetado de datos, ha conseguido una financiación sustancial de Meta con una valoración de 29.000 millones de dólares, al tiempo que anuncia una importante transición d

comentario (0)

0/200

La capacidad de transformar imágenes 2D en modelos 3D abre un enorme potencial en múltiples sectores. Esta guía examina cómo las potentes capacidades de procesamiento de IA y 3D de Python permiten la creación de mallas 3D detalladas a partir de imágenes individuales. Descubra las tecnologías de vanguardia y los flujos de trabajo prácticos que lo hacen posible.

Aspectos destacados

Transformación potenciada por IA: Convierta imágenes planas en modelos 3D totalmente realistas utilizando técnicas de aprendizaje profundo.

Ecosistema Python: Aproveche las bibliotecas especializadas para generar modelos 3D sin problemas.

Flujo de trabajo integral: Siga un proceso probado de seis etapas desde la imagen hasta la malla.

Fuentes de imágenes flexibles: Utilice fotos existentes o cree imágenes personalizadas con generadores de IA.

Integración avanzada: Combínelo con Stable Diffusion para obtener posibilidades creativas ilimitadas.

Aplicaciones intersectoriales: Aplique estas técnicas a juegos, arquitectura, diseño de productos y mucho más.

Creación de activos 3D con Python AI

Introducción a la generación de mallas 3D a partir de imágenes 2D

La convergencia del aprendizaje profundo y el procesamiento 3D ha revolucionado la creación de contenidos digitales. Las técnicas modernas ahora permiten convertir fotografías ordinarias en activos 3D completamente texturizados, abriendo nuevas posibilidades creativas en múltiples industrias. Este avance democratiza el modelado 3D, haciendo accesible la creación de activos de nivel profesional sin necesidad de equipos especializados.

La comprensión de la tecnología subyacente revela tres componentes críticos que permiten esta transformación:

- Las redes neuronales de estimación de profundidad analizan las señales visuales para determinar las relaciones espaciales dentro de las imágenes 2D.

- El procesamiento de nubes de puntos convierte los datos de profundidad en coordenadas espaciales que forman la estructura del modelo.

- Los algoritmos de reconstrucción de mallas conectan de forma inteligente estos puntos en superficies continuas.

Python sirve como la plataforma ideal para implementar este flujo de trabajo, proporcionando:

- Potentes marcos de aprendizaje profundo como PyTorch para entrenar redes neuronales

- Computación numérica avanzada a través de NumPy y SciPy

- Procesamiento 3D especializado a través de Open3D para la salida final del modelo

Flujo de trabajo central para la generación 3D

El proceso de conversión de imagen a 3D sigue una metodología estructurada de seis pasos:

- Configuración del entorno: Configuración del ecosistema de desarrollo Python con las bibliotecas de procesamiento 3D y de IA necesarias

- Adquisición de imágenes de origen: Captura o generación de datos 2D de alta calidad mediante cámaras o sistemas de conversión de texto a imagen de IA.

- Optimización de la imagen: Mejora y preparación de la imagen de origen para obtener la máxima precisión en la estimación de la profundidad

- Cálculo de profundidad: Empleo de redes neuronales entrenadas para derivar información espacial de la entrada 2D

- Cartografía espacial: Convertir los datos de profundidad en una representación de nube de puntos 3D

- Construcción de malla final: Generar superficies texturizadas entre puntos para completar el modelo

Bibliotecas esenciales de Python

Cinco bibliotecas clave forman la base de la generación de mallas 3D basada en Python:

| Biblioteca | Función principal | Función principal |

|---|---|---|

| PyTorch | Estructura de red neuronal | Entrenamiento acelerado en la GPU, gráficos de cálculo dinámicos |

| TorchVision | Soporte de visión por computador | Modelos preentrenados, transformaciones de imágenes |

| NumPy | Cálculo numérico | Operaciones eficientes con matrices, álgebra lineal |

| Open3D | Procesamiento 3D | Manipulación de nubes de puntos, reconstrucción de mallas |

| SciPy | Computación científica | Algoritmos avanzados, funciones de optimización |

Desglose detallado del proceso

Configuración del entorno

Una configuración adecuada garantiza un funcionamiento sin problemas gracias a la gestión del entorno basada en Conda:

conda create -n 3dgen python=3.9 conda activate 3dgen pip install torch torchvision open3d numpy scipy

Proceso de imágenes

La optimización de las imágenes de origen implica múltiples etapas de mejora:

- Normalización de la resolución a los requisitos de entrada de la red neuronal

- Normalización de la luz para una estimación coherente de la profundidad

- Mejora del contraste para acentuar los detalles estructurales

- Reducción del ruido para una reconstrucción geométrica limpia

- Nitidez de las características para mejorar la detección de bordes

Tecnología de estimación de la profundidad

Las modernas redes neuronales analizan diversas señales visuales de profundidad:

- Comparación del tamaño relativo del objeto

- Análisis de gradientes de textura

- Relaciones de oclusión

- Interpretación de la perspectiva atmosférica

- Patrones de sombreado e iluminación

Generación de nubes de puntos

La creación de coordenadas espaciales implica una proyección sofisticada:

- Calibración de parámetros intrínsecos de la cámara

- Transformación del sistema de coordenadas 2D a 3D

- Optimización de la densidad de puntos

- Filtrado de valores atípicos

- Reducción del ruido espacial

Técnicas de construcción de mallas

La generación del modelo final emplea la reconstrucción avanzada de superficies

- Reconstrucción de superficies de Poisson para mallas lisas

- Pivotaje de bolas para crear topologías eficientes

- Marching cubes para renderizado volumétrico

- Simplificación de mallas para optimizar el rendimiento

- Desenvoltura UV para mapeado de texturas

IA e integración avanzada

Implementación de difusión estable

La integración de IA generativa amplía las posibilidades creativas:

- Ingeniería de indicaciones de texto para las características de imagen deseadas

- Selección de modelos basada en requisitos de estilo artístico

- Optimización de parámetros para obtener resultados de calidad

- Procesamiento por lotes para el perfeccionamiento iterativo

- Alineación de los resultados con las especificaciones del conducto 3D

Arquitecturas de redes neuronales

La elección del modelo de IA influye en la calidad de la reconstrucción:

- Estimadores de profundidad monocular basados en CNN

- Arquitecturas de transformadores para el contexto global

- Modelos híbridos que combinan varios enfoques

- Mecanismos de atención para preservar los detalles

- Procesamiento multiescala para un análisis exhaustivo

Guía práctica de implementación

Requisitos del sistema

Una configuración óptima del hardware garantiza un funcionamiento sin problemas:

| Componente | Mínimo | Recomendado |

|---|---|---|

| GPU | 4 GB VRAM | 8GB+ VRAM (NVIDIA RTX) |

| RAM | 16GB | MÁS DE 32 GB |

| Almacenamiento | 256GB SSD | 1TB NVMe |

| SO | Windows/Linux | Linux para producción |

Aplicaciones industriales

Casos de uso transformadores en todos los sectores:

- Juegos: Creación rápida de entornos y personajes

- Arquitectura: Modelado de las condiciones existentes a partir de fotografías del emplazamiento

- Diseño de productos: Visualización de conceptos a partir de bocetos

- Comercio electrónico: vistas de productos en 3D a partir de imágenes de productos estándar

- Patrimonio cultural: Conservación de artefactos mediante gemelos digitales

PREGUNTAS FRECUENTES

¿Qué hardware se necesita para un procesamiento eficiente?

Una GPU NVIDIA dedicada con al menos 8 GB de VRAM acelera significativamente el cálculo, aunque algunas operaciones básicas pueden ejecutarse en CPUs capaces con la RAM adecuada.

¿Cómo puedo mejorar la calidad de la malla a partir de imágenes complejas?

La fusión de varias imágenes, las sugerencias manuales de profundidad y las técnicas de refinamiento posteriores al procesamiento pueden mejorar los resultados a partir de imágenes de origen con poco contraste o sin textura.

¿Existen alternativas comerciales a las herramientas de código abierto?

Varias plataformas SaaS ofrecen servicios de generación 3D basados en web, aunque con menos personalización que las soluciones basadas en Python y costes de suscripción continuos.

¿Qué formatos de archivo admiten los modelos 3D de salida?

El proceso suele generar formatos estándar del sector, como OBJ, STL, PLY y glTF, para lograr la máxima compatibilidad de software.

Por qué fracasan la mayoría de los redactores de contenidos SEO con IA - y las mejores alternativas a utilizar

En el competitivo entorno actual del marketing digital, la inteligencia artificial se ha convertido en un componente esencial de las estrategias eficaces de SEO. Sin embargo, muchas empresas descubren

Por qué fracasan la mayoría de los redactores de contenidos SEO con IA - y las mejores alternativas a utilizar

En el competitivo entorno actual del marketing digital, la inteligencia artificial se ha convertido en un componente esencial de las estrategias eficaces de SEO. Sin embargo, muchas empresas descubren

La tecnología de chat en directo basada en IA revela un gran avance en la identificación en tiempo real

La integración de la inteligencia artificial en la comunicación por vídeo en directo está revolucionando la forma en que analizamos y comprendemos nuestro entorno en tiempo real. Esta tecnología de va

La tecnología de chat en directo basada en IA revela un gran avance en la identificación en tiempo real

La integración de la inteligencia artificial en la comunicación por vídeo en directo está revolucionando la forma en que analizamos y comprendemos nuestro entorno en tiempo real. Esta tecnología de va

Scale AI se asegura una importante inversión en Meta en medio de la salida del CEO Alexandr Wang

Scale AI, empresa líder en el etiquetado de datos, ha conseguido una financiación sustancial de Meta con una valoración de 29.000 millones de dólares, al tiempo que anuncia una importante transición d

Scale AI se asegura una importante inversión en Meta en medio de la salida del CEO Alexandr Wang

Scale AI, empresa líder en el etiquetado de datos, ha conseguido una financiación sustancial de Meta con una valoración de 29.000 millones de dólares, al tiempo que anuncia una importante transición d