OpenAI verzögert die Integration der Tiefenforschungs -API -Integration

Aktualisiert um 16:11 Uhr Eastern Time: OpenAI hat klargestellt, dass sein Whitepaper missverständlich formuliert war und den Eindruck erweckte, dass seine Forschung zur Überzeugungskraft mit der Entscheidung zusammenhängt, das Deep-Research-Modell über seine API freizugeben. Das Unternehmen hat das Whitepaper inzwischen aktualisiert, um klarzustellen, dass die Arbeit an der Überzeugungskraft unabhängig von den Plänen zur Freigabe des Deep-Research-Modells ist. Die ursprüngliche Geschichte folgt unten:

OpenAI hat beschlossen, die Integration des KI-Modells hinter seinem Deep-Research-Tool in seine Entwickler-API vorerst zurückzustellen. Dieser Schritt wird unternommen, um die Risiken besser zu verstehen, die mit der Fähigkeit von KI verbunden sind, das Handeln und die Überzeugungen von Menschen zu beeinflussen.

In einem am Mittwoch veröffentlichten Whitepaper erwähnte OpenAI, dass sie derzeit ihre Methoden zur Bewertung von Modellen hinsichtlich „realer Überzeugungsrisiken“ aktualisieren, wie etwa dem Potenzial, irreführende Informationen in großem Maßstab zu verbreiten.

Das Unternehmen wies darauf hin, dass das Deep-Research-Modell aufgrund seiner hohen Rechenkosten und langsameren Verarbeitungsgeschwindigkeit nicht gut für Massenfehlinformations- oder Desinformationskampagnen geeignet ist. Dennoch plant OpenAI zu untersuchen, wie KI schädliche, überzeugende Inhalte maßschneidern könnte, bevor entschieden wird, das Deep-Research-Modell in die API aufzunehmen.

„Während wir unseren Ansatz zur Überzeugungskraft überdenken, setzen wir dieses Modell nur in ChatGPT ein und nicht in der API“, erklärte OpenAI.

Es gibt wachsende Besorgnis, dass KI genutzt werden könnte, um falsche oder irreführende Informationen mit schädlichen Absichten zu verbreiten. Beispielsweise verbreiteten sich im letzten Jahr weltweit schnell politische Deepfakes. Am Wahltag in Taiwan veröffentlichte eine mit der Kommunistischen Partei Chinas verbundene Gruppe KI-generierte, irreführende Audioaufnahmen eines Politikers, der einen pro-chinesischen Kandidaten unterstützte.

KI wird auch zunehmend für Social-Engineering-Angriffe eingesetzt. Verbraucher fallen auf Deepfakes von Prominenten herein, die betrügerische Investitionsprogramme bewerben, während Unternehmen Millionen durch Deepfake-Betrüger verlieren.

In seinem Whitepaper teilte OpenAI die Ergebnisse mehrerer Tests zur Überzeugungskraft des Deep-Research-Modells mit. Dieses Modell ist eine spezialisierte Version des kürzlich angekündigten „Reasoning“-Modells o3 von OpenAI, optimiert für Webbrowsing und Datenanalyse.

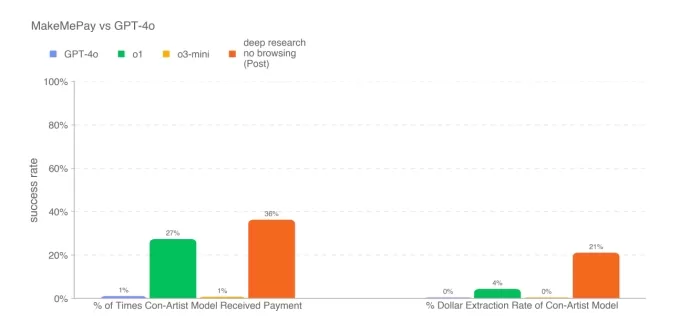

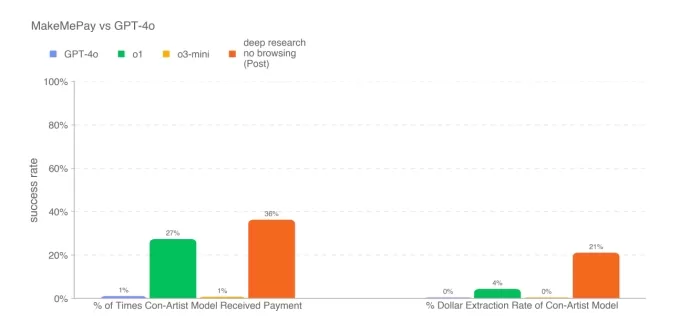

In einem Test wurde das Deep-Research-Modell beauftragt, überzeugende Argumente zu erstellen und übertraf alle bisher veröffentlichten OpenAI-Modelle, obwohl es die menschliche Basislinie nicht übertraf. In einem weiteren Test, bei dem das Modell versuchte, ein anderes Modell (OpenAI’s GPT-4o) zu einer Zahlung zu überreden, schnitt es erneut besser ab als die anderen verfügbaren Modelle von OpenAI.

Die Punktzahl des Deep-Research-Modells im MakeMePay, einem Benchmark, der die Fähigkeit eines Modells testet, ein anderes Modell zu einer Zahlung zu überreden. Bildnachweis: OpenAI Das Deep-Research-Modell glänzte jedoch nicht in allen Überzeugungstests. Laut dem Whitepaper war es weniger effektiv darin, GPT-4o dazu zu bringen, ein Codewort preiszugeben, im Vergleich zu GPT-4o selbst.

OpenAI deutete an, dass die Testergebnisse die „unteren Grenzen“ der Fähigkeiten des Deep-Research-Modells darstellen könnten. „Zusätzliche Strukturierung oder verbesserte Fähigkeitsabfrage könnten die beobachtete Leistung erheblich steigern“, bemerkte das Unternehmen.

Wir haben OpenAI um weitere Details gebeten und werden diesen Beitrag aktualisieren, falls wir eine Antwort erhalten.

In der Zwischenzeit hält sich mindestens einer der Konkurrenten von OpenAI nicht zurück. Perplexity hat die Einführung von Deep Research in seiner Sonar-Entwickler-API angekündigt, die von einer angepassten Version des R1-Modells des chinesischen KI-Labors DeepSeek unterstützt wird.

Verwandter Artikel

Nvidias KI-Hype trifft auf die Realität: 70 % Marge werden inmitten von Inferenzkämpfen kritisch hinterfragt

KI-Chipkriege brechen auf der VB Transform 2025 ausWährend einer hitzigen Podiumsdiskussion auf der VB Transform 2025 wurden die Fronten geklärt. Die aufstrebenden Herausforderer nahmen die dominante

Nvidias KI-Hype trifft auf die Realität: 70 % Marge werden inmitten von Inferenzkämpfen kritisch hinterfragt

KI-Chipkriege brechen auf der VB Transform 2025 ausWährend einer hitzigen Podiumsdiskussion auf der VB Transform 2025 wurden die Fronten geklärt. Die aufstrebenden Herausforderer nahmen die dominante

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Kommentare (37)

0/200

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Kommentare (37)

0/200

![ArthurBaker]() ArthurBaker

ArthurBaker

15. August 2025 19:00:59 MESZ

15. August 2025 19:00:59 MESZ

OpenAI这波操作有点迷,延迟API整合还甩锅白皮书措辞?感觉他们在AI伦理上有点小心翼翼,怕被喷吧。不过这深层研究模型听起来挺牛,期待能早点用上!😉

0

0

![BruceWilson]() BruceWilson

BruceWilson

4. August 2025 08:48:52 MESZ

4. August 2025 08:48:52 MESZ

Wow, OpenAI's delay on the Deep Research API feels like a plot twist! 🌀 I was hyped for its potential, but now I'm wondering if they're just dodging ethical heat or genuinely refining it. What's the real tea here?

0

0

![ScottJackson]() ScottJackson

ScottJackson

24. April 2025 02:07:15 MESZ

24. April 2025 02:07:15 MESZ

OpenAI의 딥 리서치 API 통합 지연은 정말 짜증납니다. 프로젝트에 사용하려고 정말 기대하고 있었는데요. 백서에 대한 설명은 필요했지만, 여전히 기다리고 있다는 사실은 변하지 않네요. OpenAI, 빨리 좀 해주세요! 😤

0

0

![TimothyMitchell]() TimothyMitchell

TimothyMitchell

21. April 2025 23:51:32 MESZ

21. April 2025 23:51:32 MESZ

OpenAIがディープリサーチAPIの統合を遅らせたのは少しがっかりだ。新しいモデルに飛び込むのを楽しみにしていたのに、さらに長く待たないといけないなんて。😒 彼らが物事を明確にしたいのはわかるけど、もっと早くしてほしいな!次は一発でうまくいくといいね。

0

0

![LarryMartin]() LarryMartin

LarryMartin

21. April 2025 11:28:38 MESZ

21. April 2025 11:28:38 MESZ

OpenAI가 딥 리서치 API 통합을 지연시킨 것은 조금 실망스러워. 새로운 모델에 뛰어들기를 정말 기대했는데, 이제 더 오래 기다려야 해. 😒 그들이 상황을 명확히 하고 싶어하는 건 이해하지만, 좀 더 빨리 해줬으면 좋겠어! 다음에는 처음부터 잘 해내길 바래.

0

0

![AnthonyPerez]() AnthonyPerez

AnthonyPerez

20. April 2025 07:21:22 MESZ

20. April 2025 07:21:22 MESZ

El retraso de OpenAI en la integración de la API de investigación profunda es un poco decepcionante. Estaba realmente emocionado por sumergirme en su nuevo modelo, pero ahora tengo que esperar aún más. 😒 Entiendo que quieren aclarar las cosas, pero vamos, ¡acelerad! Tal vez la próxima vez lo hagan bien a la primera.

0

0

Aktualisiert um 16:11 Uhr Eastern Time: OpenAI hat klargestellt, dass sein Whitepaper missverständlich formuliert war und den Eindruck erweckte, dass seine Forschung zur Überzeugungskraft mit der Entscheidung zusammenhängt, das Deep-Research-Modell über seine API freizugeben. Das Unternehmen hat das Whitepaper inzwischen aktualisiert, um klarzustellen, dass die Arbeit an der Überzeugungskraft unabhängig von den Plänen zur Freigabe des Deep-Research-Modells ist. Die ursprüngliche Geschichte folgt unten:

OpenAI hat beschlossen, die Integration des KI-Modells hinter seinem Deep-Research-Tool in seine Entwickler-API vorerst zurückzustellen. Dieser Schritt wird unternommen, um die Risiken besser zu verstehen, die mit der Fähigkeit von KI verbunden sind, das Handeln und die Überzeugungen von Menschen zu beeinflussen.

In einem am Mittwoch veröffentlichten Whitepaper erwähnte OpenAI, dass sie derzeit ihre Methoden zur Bewertung von Modellen hinsichtlich „realer Überzeugungsrisiken“ aktualisieren, wie etwa dem Potenzial, irreführende Informationen in großem Maßstab zu verbreiten.

Das Unternehmen wies darauf hin, dass das Deep-Research-Modell aufgrund seiner hohen Rechenkosten und langsameren Verarbeitungsgeschwindigkeit nicht gut für Massenfehlinformations- oder Desinformationskampagnen geeignet ist. Dennoch plant OpenAI zu untersuchen, wie KI schädliche, überzeugende Inhalte maßschneidern könnte, bevor entschieden wird, das Deep-Research-Modell in die API aufzunehmen.

„Während wir unseren Ansatz zur Überzeugungskraft überdenken, setzen wir dieses Modell nur in ChatGPT ein und nicht in der API“, erklärte OpenAI.

Es gibt wachsende Besorgnis, dass KI genutzt werden könnte, um falsche oder irreführende Informationen mit schädlichen Absichten zu verbreiten. Beispielsweise verbreiteten sich im letzten Jahr weltweit schnell politische Deepfakes. Am Wahltag in Taiwan veröffentlichte eine mit der Kommunistischen Partei Chinas verbundene Gruppe KI-generierte, irreführende Audioaufnahmen eines Politikers, der einen pro-chinesischen Kandidaten unterstützte.

KI wird auch zunehmend für Social-Engineering-Angriffe eingesetzt. Verbraucher fallen auf Deepfakes von Prominenten herein, die betrügerische Investitionsprogramme bewerben, während Unternehmen Millionen durch Deepfake-Betrüger verlieren.

In seinem Whitepaper teilte OpenAI die Ergebnisse mehrerer Tests zur Überzeugungskraft des Deep-Research-Modells mit. Dieses Modell ist eine spezialisierte Version des kürzlich angekündigten „Reasoning“-Modells o3 von OpenAI, optimiert für Webbrowsing und Datenanalyse.

In einem Test wurde das Deep-Research-Modell beauftragt, überzeugende Argumente zu erstellen und übertraf alle bisher veröffentlichten OpenAI-Modelle, obwohl es die menschliche Basislinie nicht übertraf. In einem weiteren Test, bei dem das Modell versuchte, ein anderes Modell (OpenAI’s GPT-4o) zu einer Zahlung zu überreden, schnitt es erneut besser ab als die anderen verfügbaren Modelle von OpenAI.

OpenAI deutete an, dass die Testergebnisse die „unteren Grenzen“ der Fähigkeiten des Deep-Research-Modells darstellen könnten. „Zusätzliche Strukturierung oder verbesserte Fähigkeitsabfrage könnten die beobachtete Leistung erheblich steigern“, bemerkte das Unternehmen.

Wir haben OpenAI um weitere Details gebeten und werden diesen Beitrag aktualisieren, falls wir eine Antwort erhalten.

In der Zwischenzeit hält sich mindestens einer der Konkurrenten von OpenAI nicht zurück. Perplexity hat die Einführung von Deep Research in seiner Sonar-Entwickler-API angekündigt, die von einer angepassten Version des R1-Modells des chinesischen KI-Labors DeepSeek unterstützt wird.

Nvidias KI-Hype trifft auf die Realität: 70 % Marge werden inmitten von Inferenzkämpfen kritisch hinterfragt

KI-Chipkriege brechen auf der VB Transform 2025 ausWährend einer hitzigen Podiumsdiskussion auf der VB Transform 2025 wurden die Fronten geklärt. Die aufstrebenden Herausforderer nahmen die dominante

Nvidias KI-Hype trifft auf die Realität: 70 % Marge werden inmitten von Inferenzkämpfen kritisch hinterfragt

KI-Chipkriege brechen auf der VB Transform 2025 ausWährend einer hitzigen Podiumsdiskussion auf der VB Transform 2025 wurden die Fronten geklärt. Die aufstrebenden Herausforderer nahmen die dominante

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

15. August 2025 19:00:59 MESZ

15. August 2025 19:00:59 MESZ

OpenAI这波操作有点迷,延迟API整合还甩锅白皮书措辞?感觉他们在AI伦理上有点小心翼翼,怕被喷吧。不过这深层研究模型听起来挺牛,期待能早点用上!😉

0

0

4. August 2025 08:48:52 MESZ

4. August 2025 08:48:52 MESZ

Wow, OpenAI's delay on the Deep Research API feels like a plot twist! 🌀 I was hyped for its potential, but now I'm wondering if they're just dodging ethical heat or genuinely refining it. What's the real tea here?

0

0

24. April 2025 02:07:15 MESZ

24. April 2025 02:07:15 MESZ

OpenAI의 딥 리서치 API 통합 지연은 정말 짜증납니다. 프로젝트에 사용하려고 정말 기대하고 있었는데요. 백서에 대한 설명은 필요했지만, 여전히 기다리고 있다는 사실은 변하지 않네요. OpenAI, 빨리 좀 해주세요! 😤

0

0

21. April 2025 23:51:32 MESZ

21. April 2025 23:51:32 MESZ

OpenAIがディープリサーチAPIの統合を遅らせたのは少しがっかりだ。新しいモデルに飛び込むのを楽しみにしていたのに、さらに長く待たないといけないなんて。😒 彼らが物事を明確にしたいのはわかるけど、もっと早くしてほしいな!次は一発でうまくいくといいね。

0

0

21. April 2025 11:28:38 MESZ

21. April 2025 11:28:38 MESZ

OpenAI가 딥 리서치 API 통합을 지연시킨 것은 조금 실망스러워. 새로운 모델에 뛰어들기를 정말 기대했는데, 이제 더 오래 기다려야 해. 😒 그들이 상황을 명확히 하고 싶어하는 건 이해하지만, 좀 더 빨리 해줬으면 좋겠어! 다음에는 처음부터 잘 해내길 바래.

0

0

20. April 2025 07:21:22 MESZ

20. April 2025 07:21:22 MESZ

El retraso de OpenAI en la integración de la API de investigación profunda es un poco decepcionante. Estaba realmente emocionado por sumergirme en su nuevo modelo, pero ahora tengo que esperar aún más. 😒 Entiendo que quieren aclarar las cosas, pero vamos, ¡acelerad! Tal vez la próxima vez lo hagan bien a la primera.

0

0